t0nAr1sm

Appleを知る。楽しむ。それが「となりずむ」

Appleの新研究、LLMによる音声+IMUの行動推定が想像以上に高精度

✅この記事では、Appleが公開した新しい研究「Using LLMs for Late Multimodal Sensor Fusion for Activity Recognition」を整理します。音と動きのセンサー情報だけから、どこまで人の行動が分かるのかを、なるべくやさしくひもといていきます。

- 今回のポイントまとめ

- LLMに渡すのは“生センサー”ではなく、その要約

- Ego4Dと12種類のアクティビティ

- ゼロショット&ワンショットでどこまで当たるのか

- Appleが見ているのは“センサーとAIの距離”を近づけること

- 注目したいポイント

- ひとこと:センサーとLLMの“距離感”を測る論文

- まとめ:音と動きから“今の自分”を言語化するための一歩

どうも、となりです。

Apple Intelligenceの文脈では「iPhoneやApple Watchが、持ち主の“今の状況”をどこまで理解できるのか」がよく話題になりますよね。今回の論文はまさにそのど真ん中で、マイクやモーションセンサーから得られる情報を、大規模言語モデル(LLM)でうまく組み合わせて解釈するという内容になっています。

ポイントは、LLMに直接“生の音声やセンサー値”を食べさせるのではなく、あくまで別モデルが生成したテキスト説明やラベルを材料にしているところです。つまり、いろいろなモデルを束ねる「まとめ役」としてLLMを使っているわけですね。

今回のポイントまとめ

まずは、9to5Macが紹介した内容を中心に、ざっくり要点を並べておきます。

- Apple研究者が「Using LLMs for Late Multimodal Sensor Fusion for Activity Recognition」という論文を公開。

- 音声とモーション(加速度・ジャイロ)という2種類のセンサー情報を、LLMで“あとから統合”して活動を認識する手法を提案。

- ベースとなるデータは、日常生活を1人称視点で撮影した大規模データセット「Ego4D」から抽出。

- 掃除・料理・読書・PC作業・スポーツなど12種類のアクティビティを分類する実験で、LLMは「ゼロショット/ワンショット」でも偶然よりかなり高い精度を達成。

- LLMが受け取るのは生の音声ではなく、音声モデルが作ったテキストキャプションと、IMU(加速度+ジャイロ)モデルの予測ラベル。

- あらかじめ12個の候補ラベルを与える「選択式」と、自由回答に近い「オープンな質問」の両方で性能を検証。

- Appleは論文とあわせて、利用したデータ区間のIDやプロンプトなどの追加資料も公開し、再現研究をしやすい形にしている。

ざっくりいうと、Appleは「センサーの生データそのものを巨大モデルに全部任せる」のではなく、複数モデルの結果をLLMで賢く束ねる方向性を探っている、というわけです。これは、すでにまとめているApple Intelligenceの設計思想とも通じるところがあると感じます。

LLMに渡すのは“生センサー”ではなく、その要約

今回の論文のキーワードは「Late Multimodal Sensor Fusion(後段でのマルチモーダル融合)」です。通常、マルチモーダルAIというと、画像・音声・テキストなど異なる情報を、共通の特徴空間にマッピングしてから学習させるイメージが強いですよね。

この研究では少し発想を変えて、音声とIMUのそれぞれを専用の軽量モデルでいったん処理し、その“結果”だけをLLMに渡す構造になっています。具体的には、次のような流れです。

- 音声 → オーディオモデルが短いテキストキャプション(例:「フライパンの上でジュージュー音がしている」など)とラベルを出す。

- IMU → 加速度・ジャイロデータから、動きの種類(走る・持ち上げる・座る など)を予測するモデルがラベルを出す。

- これらのテキスト情報を、LLMにプロンプトとしてまとめて渡し、「この人はいま何をしている?」と質問する。

LLMは、テキストとして渡された複数の手がかりを読み解きながら、「食器を洗っている」「パソコンを使っている」といった活動ラベルを出力します。つまり、LLMにとっては「センサー」もまたテキスト情報の一種として扱われているわけです。

Ego4Dと12種類のアクティビティ

研究チームは、Metaなどが公開している大規模1人称視点データセット「Ego4D」から、日常生活に近いシーンだけを取り出して実験用のサブセットを作りました。対象になったのは、次の12種類のアクティビティです。

- 掃除機がけ

- 料理

- 洗濯

- 食事

- バスケットボール

- サッカー

- ペットと遊ぶ

- 本を読む

- コンピュータを使う

- 食器洗い

- テレビを見る

- 筋トレ・ウェイトトレーニング

どれも「家の中」や「身近な運動」が中心で、Apple WatchやiPhoneがいま重点を置いているヘルスケア・フィットネス分野を連想させるラインナップですよね。1サンプルあたり20秒のデータを使い、その短い時間の中から、音と動きの組み合わせだけで何をしているのかを当てにいく、というわけです。

ゼロショット&ワンショットでどこまで当たるのか

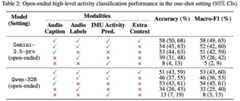

この研究が面白いのは、LLMに対してほぼタスク固有の学習をさせていない点です。研究チームは、GoogleのGemini 2.5 ProやQwen 32Bといった既存のLLMに対して、次のような条件で性能を比べています。

- ゼロショット:12種類の活動名をリストで与えるだけで、個別の例示はしない。

- ワンショット:それぞれの活動について、「こういうセンサー説明のときはこのラベル」といった具体例を1つずつだけ追加。

- クローズドセット:あらかじめ12個の選択肢を提示し、その中から選ばせる。

- オープンセット:選択肢リストを与えず、自由なテキストで活動名を答えさせる。

結果として、どの条件でも「完全にランダムに当てるよりもかなり高いF1スコア」が出ており、とくにワンショット+複数モダリティの組み合わせでは精度がぐっと上がったと報告されています。たった1つの例示でも、LLMにとっては「活動名とセンサー説明の対応関係」を学ぶうえで大きなヒントになる、ということですね。

また、音声だけ・IMUだけよりも、両方の情報を組み合わせたときの方が安定して高い性能になっており、「観察手段が違うセンサーの出力をLLMで束ねる」という発想が現実的に役立つことが示されています。

Appleが見ているのは“センサーとAIの距離”を近づけること

では、この研究はAppleの製品にどうつながりそうでしょうか。論文自体はあくまで基礎研究ですが、Appleが最近力を入れているApple Intelligenceのオンデバイス処理を思い出すと、いくつかイメージが湧いてきます。

たとえば、iPhoneやApple Watchはすでに非常に多くのセンサーを持っており、ヘルスケア分野では血圧の兆候を推定するような研究も進んでいます(関連記事:Apple Watchの高血圧通知の噂)。こうしたセンサー由来の情報を、デバイス上のLLMが状況に応じて解釈してくれれば、単なる「歩数」や「心拍数」の羅列ではなく、「今日はかなり激しい運動をした」「いつもと違う疲れ方をしている」といった文脈を、より柔らかく理解できるようになるかもしれません。

重要なのは、今回の研究がプライバシーにも配慮した構造にしやすいことです。生の音声をそのまま大規模モデルに渡すのではなく、オンデバイスのオーディオモデルが生成した短い説明文や、IMUモデルの分類ラベルだけを使えば、扱うデータはかなり抽象化されます。これは、ストレージや通信負荷の観点からも、すでに整理している「Apple Intelligenceのローカルモデル連携」の方向性と相性が良さそうです。

注目したいポイント

① 「後段で束ねる」マルチモーダルは、現実的な落としどころ

マルチモーダルAIというと、どうしても「巨大な一枚岩モデル」をイメージしがちですが、実運用ではセンサーごとに開発チームも更新サイクルも違います。今回の「Late Fusion」方式は、そこにLLMを“アダプター”として差し込むイメージで、現実のプロダクトに落とし込みやすい考え方だと感じました。

たとえば、将来的にAppleがNeurIPSなどで披露する研究群(先日まとめたMLXやFastVLMのデモ)とも組み合わせれば、センサーごとに最適化された小さなモデルをMLXで回しつつ、その出力をLLMが束ねる──という構成も見えてきます。

② 「音声そのものを見ない」ことの意味

ユーザーからすると、「マイクで拾った音や周囲の様子から行動を推定される」と聞くと、どうしても身構えてしまいますよね。ただ、今回の研究では、LLM側はあくまで「音声モデルが作ったテキスト要約」にだけ触れています。これは、将来的にAppleがプライバシー重視の設計をするときのヒントにもなりそうです。

もちろん、テキスト要約でもプライバシーに配慮する必要はありますが、「生データを集めず、デバイス上で要約してから扱う」という考え方は、Appleがこれまで掲げてきたプライバシー方針とも一致しています。どこまで要約すれば安心と実用のバランスが取れるのか──この辺りは今後の議論ポイントになりそうです。

③ ヘルスケアと“文脈リッチな通知”への応用

現在でも、Apple Watchのワークアウト検出や睡眠分析はかなり高度ですが、それでも「今の自分の状態をそのまま言語化してくれる」レベルにはまだ届いていません。今回のようなセンサー×LLMの組み合わせが進めば、将来的には「最近は座りっぱなしの時間が多い」「ストレスの溜まり方がいつもと違う」といった形で、より状況に寄り添ったフィードバックが届く可能性があります。

一方で、「どこまで推定してよいのか」という線引きも重要です。ユーザー側の許可設定や、完全オンデバイスでの処理など、プロダクト化する際には慎重な設計が求められるはずです。Appleがどういうバランスを取ってくるのか、今後のApple Intelligenceやヘルス機能のアップデートを追ううえで注目しておきたいところですね。

ひとこと:センサーとLLMの“距離感”を測る論文

今回の研究は、「LLMをセンサー解析の主役にする」というよりも、「すでにあるセンサーモデルの上に、LLMという通訳を重ねると何が見えてくるか」を静かに探った内容だと感じました。ゼロショット/ワンショットというライトな条件でもきちんと手応えが得られているのは、今後のApple製品にとっても大きなヒントになりそうです。

Appleが実際のデバイスでどこまで踏み込んでくるかはまだ分かりませんが、「センサーの世界」と「言語モデルの世界」をどう橋渡しするかというテーマは、これから数年のApple AI戦略を考えるうえで、ひとつ重要な軸になっていきそうです。

まとめ:音と動きから“今の自分”を言語化するための一歩

- Appleの新論文は、音声とIMUセンサーの情報をLLMで後段統合し、人の活動を推定する手法を検証したもの。

- 日常生活に近い12種類のアクティビティを対象に、ゼロショット/ワンショットでも偶然を大きく上回る精度を確認。

- LLMが扱うのは生データではなく、音声モデルやIMUモデルが生成したテキスト要約やラベルで、プライバシー配慮の設計とも相性がよさそう。

- Apple Intelligenceやヘルスケア機能と組み合わせれば、「センサー値のグラフ」ではなく「今の状態を言葉で教えてくれる」世界に近づくかもしれない。

- 一方で、どこまで推定するのがユーザーにとって心地よいのかという線引きも含めて、今後の設計・議論が重要になりそうだと感じる。

センサーの世界と言語の世界が少しずつ混ざり合っていくとき、私たちの「自分の状態のとらえ方」も変わっていきます。あなたは、音と動きだけから自分の行動をかなり正確に言い当ててくるデバイスを、どこまで歓迎できそうでしょうか?

ではまた!

Source: 9to5Mac

整備済み 更新情報

公式ページ- 読み込み中…

※Apple公式整備済製品の更新情報を自動取得しています

- iPhone (349)

- AirTag (9)

- Apple TV・HomePod (46)

- Apple Watch (50)

- iPad (73)

- AirPods (35)

- Mac (115)

- Studio Display (10)

- Vision (35)

- Apple Glass (11)

- Siri (31)

- Apple Intelligence (60)

- アプリ・サービス (67)

- スマートホーム (15)

- Apple Wallet (5)

- Apple Music (12)

- CarPlay (8)

- Apple Store (9)

- OS / ソフトウェア/ファームウェア/セキュリティ (186)

- Android (28)

- アップデート (31)

- テスト・検証 (21)

- 分解・改造 (15)

- デバイス設計・技術分析 (107)

- Apple製造・サプライチェーン (43)

- キャリア・通信 (16)

- アクセサリ・周辺機器 (33)

- トラブル/不具合・バグ (46)

- Tips・使い方・設定 (8)

- 噂・リーク情報 (258)

- 完全保存版 (5)

- まとめ (37)

- コラム・雑記・業界分析 (75)

- 疑問・考察 (33)

- レビュー (15)

- デザイン (32)

- 経営・人物 (45)

- エピソード (4)

- 特許・研究・規制ウォッチ (22)

- Apple月次まとめ (2)