WO2024232503A1 - Wearable device for moving virtual object using gesture, and method therefor - Google Patents

Wearable device for moving virtual object using gesture, and method thereforDownload PDFInfo

- Publication number

- WO2024232503A1 WO2024232503A1PCT/KR2024/001240KR2024001240WWO2024232503A1WO 2024232503 A1WO2024232503 A1WO 2024232503A1KR 2024001240 WKR2024001240 WKR 2024001240WWO 2024232503 A1WO2024232503 A1WO 2024232503A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- fov

- wearable device

- virtual object

- hand

- body part

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0484—Interaction techniques based on graphical user interfaces [GUI] for the control of specific functions or operations, e.g. selecting or manipulating an object, an image or a displayed text element, setting a parameter value or selecting a range

- G06F3/04842—Selection of displayed objects or displayed text elements

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

Definitions

- the present disclosurerelates to a wearable device and method for moving a virtual object using gestures.

- the electronic devicesare being developed that provide augmented reality (AR) services that display computer-generated information in conjunction with external objects in the real world.

- the electronic devicesmay be wearable devices that can be worn by a user.

- the electronic devicesmay be AR glasses and/or a head-mounted device (HMD).

- HMDhead-mounted device

- a wearable devicemay include a camera, a display, and at least one processor including a processing circuit.

- the at least one processormay be configured, individually and/or collectively, to identify a body part within a field-of-view (FoV) of the camera while displaying a virtual object within a virtual space via the display.

- the at least one processormay be configured, individually and/or collectively, to control the display to display the virtual object moving along a path of the body part moving within the FoV based on identifying the body part in a designated pose for movement of the virtual object.

- FoVfield-of-view

- the at least one processormay be configured, individually and/or collectively, to control the display to display the virtual object at a second location within the virtual space corresponding to the first location based on identifying, using the camera, that the body part is moving out of the FoV through a first location of an edge of the FoV while moving the virtual object along the path.

- At least one processormay be configured, individually and/or collectively, to control the display to display the virtual object, based on identifying the body part of the designated pose that has moved into the FoV, from the second location and moving along the path of the body part within the FoV.

- a method of a wearable devicemay include an operation of identifying a body part within a field-of-view (FoV) of a camera of the wearable device based on a video acquired from a camera of the wearable device while displaying a virtual object within a virtual space through a display of the wearable device.

- the methodmay include an operation of displaying the virtual object moving along a path of the body part moving within the FoV based on the identification of the body part in a specified posture for movement of the virtual object.

- the methodmay include an operation of displaying the virtual object at a second location within the virtual space corresponding to the first location based on the identification, from the video, that the body part is moving out of the FoV through a first location of an edge of the FoV within a state of moving the virtual object along the path.

- the methodmay include an action of displaying the virtual object, which is moved from the second location and moves along a path of the body part within the FoV, based on identifying the body part of the specified posture that has moved into the FoV after displaying the virtual object at the second location.

- a wearable devicemay include a camera, a display, and at least one processor including a processing circuit.

- the at least one processormay be configured, individually and/or collectively, to identify a body part that moves into a field-of-view (FoV) of the camera at a first timing based on the camera.

- the at least one processormay be configured, individually and/or collectively, to identify, based on identifying that a pose of the body part that moved into the FoV at the first timing corresponds to a designated pose, at least one virtual object that was associated with the body part at a second timing prior to the first timing.

- the at least one processormay be configured, individually and/or collectively, to control the display to display the at least one virtual object based on a position of the body part within the FoV within the display.

- a method of a wearable devicemay include an operation of identifying a body part that moves into a FoV of a camera of the wearable device at a first timing based on a camera of the wearable device.

- the methodmay include an operation of identifying at least one virtual object that was connected to the body part at a second timing prior to the first timing based on identifying that a posture of the body part that moved into the FoV at the first timing corresponds to a designated posture.

- the methodmay include an operation of displaying at least one virtual object within a display of the wearable device based on a position of the body part within the FoV.

- FIGS. 1A and 1Billustrate examples of screens displayed through a display of a wearable device, according to one embodiment

- FIG. 2illustrates an exemplary configuration of a block diagram of a wearable device according to one embodiment

- FIG. 3is a flowchart illustrating exemplary operations of a wearable device according to one embodiment

- FIG. 4is a diagram illustrating exemplary operations performed by a wearable device to identify a body part

- FIG. 5is a diagram illustrating exemplary operations performed by a wearable device to obtain information about a body part

- FIGS. 6A, 6B and 6Care diagrams illustrating exemplary operations of a wearable device performed based on movement of a body part

- FIGS. 7A, 7B and 7Care diagrams illustrating exemplary operations of a wearable device performed based on movement of a body part

- FIG. 8is a flowchart illustrating exemplary operations of a wearable device according to one embodiment

- FIGS. 9A, 9B and 9Care diagrams illustrating exemplary operations of a wearable device performed based on movements of body parts

- FIG. 10is a diagram illustrating exemplary operations of a wearable device performed based on movements of body parts

- FIGS. 11A, 11B and 11Care diagrams illustrating exemplary operations of a wearable device performed based on movements of body parts

- FIGS. 12A and 12Bare diagrams illustrating exemplary operations of a wearable device performed based on movements of body parts

- FIGS. 13A, 13B and 13Care diagrams illustrating exemplary operations of a wearable device performed based on movements of body parts

- FIGS. 14a, 14b and 14care diagrams illustrating different states of a screen displayed by a wearable device based on the position of a body part with respect to the field-of-view (FoV) of a camera;

- FIG. 15is a flowchart illustrating exemplary operations of a wearable device according to one embodiment

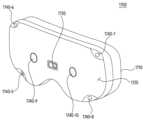

- FIG. 16Ais a perspective view of an exemplary wearable device, according to one embodiment

- FIG. 16bis a perspective view illustrating one or more hardware elements positioned within a wearable device according to one embodiment.

- FIGS. 17A and 17Bare perspective views illustrating an example of an exterior appearance of a wearable device according to one embodiment.

- Expressions such as “first”, “second”, “first” or “second”can modify the corresponding components, regardless of order or importance, and are only used to distinguish one component from another and do not limit the corresponding components.

- a certain (e.g., a first) componentis "(functionally or communicatively) connected” or “connected” to another (e.g., a second) component

- said certain componentmay be directly connected to said other component, or may be connected through another component (e.g., a third component).

- moduleincludes a unit composed of hardware, and may be used interchangeably with terms such as component, circuit, etc.

- a modulemay be an integrally composed component, or a minimum unit or part thereof that performs one or more functions.

- a modulemay be composed of an application-specific integrated circuit (ASIC).

- ASICapplication-specific integrated circuit

- FIGS. 1A and 1Bare diagrams of examples of screens displayed through a display of a wearable device (101), according to one embodiment.

- the wearable device (101)may include a head-mounted display (HMD) wearable on the head of a user (110).

- HMDhead-mounted display

- FIG. 2An example of one or more hardware elements included in the wearable device (101) is described as a non-limiting example with reference to FIG. 2.

- FIGS. 16A and 16B and/or 17A and 17Bis described in more detail with reference to FIGS. 16A and 16B and/or 17A and 17B.

- the wearable device (101)may be referred to as an electronic device (e.g., the electronic device (101-1) of FIGS. 7A to 7C).

- the electronic devicemay be combined with an accessory to be attached to a user's head to form an HMD.

- the wearable device (101)may display the real world, display a virtual world, or display both the real world and the virtual world together.

- a wearable device (101)may perform functions related to video see-through (VST) and/or virtual reality (VR).

- VSTvideo see-through

- VRvirtual reality

- the wearable device (101)may include a housing that covers the eyes of the user (110).

- the wearable device (101)may include a display disposed on a first side of the housing facing the eyes.

- the wearable device (101)may include a camera disposed on a second side opposite to the first side. Using the camera, the wearable device (101) may acquire images and/or videos representing ambient light.

- the wearable device (101)can output the image and/or video within the display disposed on the first surface, so that the user (110) can recognize the ambient light through the display.

- a displaying area (or active area) of the display disposed on the first surfacecan be formed by one or more pixels included in the display.

- the wearable device (101)can synthesize a virtual object into the image and/or video output through the display, so that the user (110) can recognize the virtual object together with a real object recognized by the ambient light.

- the wearable device (101)may perform functions related to augmented reality (AR) and/or mixed reality (MR).

- ARaugmented reality

- MRmixed reality

- the wearable device (101)may include at least one lens positioned adjacent to an eye of the user (110).

- the wearable device (101)may combine ambient light passing through the lens with light emitted from a display of the wearable device (101).

- a display area of the displaymay be formed within the lens through which the ambient light passes. Since the wearable device (101) combines the ambient light and the light emitted from the display, the user (110) can see an image that is a mixture of a real object recognized by the ambient light and a virtual object formed by the light emitted from the display.

- XRextended reality

- a wearable device (101)may identify a body part, such as a hand (112), based on one or more cameras (e.g., a 3D camera) and/or sensors (e.g., a depth sensor, a proximity sensor, a time-of-flight (ToF) sensor).

- the wearable device (101)may identify a body part included in an external space that is sensible (e.g., able to be sensed) by the one or more cameras and/or sensors, using data from the one or more cameras and/or sensors.

- the wearable device (101)can identify a hand (112) within a field-of-view (FoV) (120) of a camera positioned toward a direction (df) (e.g., a front direction of the wearable device (101).

- the FoVmay, for example, refer to an external space detectable by the camera.

- the wearable device (101) identifying the hand (112)may include an operation of identifying at least one of a pose of the hand (112) within the FoV (120), a position of the hand (112) within the FoV (120), and/or a type of gesture corresponding to the pose, based on an image and/or video of the camera.

- FIGS. 4 and 5An example of an operation of the wearable device (101) performed to identify the hand (112) is described in more detail with reference to FIGS. 4 and 5. Below, the operation of the wearable device (101) for identifying the hand (112) of the user (110) is described, but the present disclosure is not limited thereto.

- the screen (130)may include a display area in which a virtual space, a real world, a mixed reality, or an extended reality is displayed through the display of the wearable device (101).

- the wearable device (101)may display a three-dimensional virtual space surrounding an avatar of a user (110) having an arbitrary shape such as a sphere, a hemisphere, or a cylinder, with the avatar of the user (110) as the center point.

- the screen (130)may be an area currently being displayed through the display of the wearable device (101) in the virtual space.

- the wearable device (101)may display an area or an external space different from the area currently being displayed in the virtual space. That is, the external space is an area included in the virtual space, and at least a part of the external space may include an area different from the area currently being displayed.

- the wearable device (101)may display one or more virtual objects to the user (110). Referring to FIGS. 1A and 1B , a virtual object (140) having a shape of a three-dimensional cylinder is exemplarily illustrated, but the present disclosure is not limited thereto.

- the virtual object (140) displayed within the screen (130)may include, for example, a window provided by a software application (e.g., a web browser and/or a gallery) executed by the wearable device (101).

- the windowmay have a two-dimensional rectangular shape, such as, for example, an activity of an Android operating system and/or, for example, a window (or a pop-up window) of a Windows operating system.

- the virtual object (140)may include a two-dimensional and/or three-dimensional widget (e.g., a weather widget) provided by the software application.

- the present disclosureis not limited thereto, and the virtual object (140) may include any graphical object that may be displayed within the screen (130).

- the wearable device (101)can substantially simultaneously display images including virtual objects (140) positioned at different locations on each of the two eyes of the user (110).

- the difference (or distance) between the locations of the virtual objects (140) commonly included in the imagescan be referred to as binocular parallax.

- the wearable device (101)can adjust the distance perception of the virtual object (140) recognized by the user (110) wearing the wearable device (101). For example, the larger the binocular parallax of the virtual object (140), the more the user (110) viewing the virtual object (140) through the screen (130) can recognize that the virtual object (140) is positioned at a closer distance from the user (110).

- the wearable device (101)may identify a body part (e.g., a hand (112)) within the FoV (120) of the camera of the wearable device (101) while displaying a virtual object (140) through the display. Based on identifying the body part within the FoV (120), the wearable device (101) may identify a posture of the body part and/or a position of the body part within the FoV (120). Based on the posture and/or the position, the wearable device (101) may change the display of the virtual object (140) displayed on the screen (130). For example, based on identifying a body part in a specified posture for movement of the virtual object (140), the wearable device (101) may display the virtual object (140) moving along a path of the body part moving within the FoV (120).

- a body parte.g., a hand (112)

- the wearable device (101)may identify a posture of the body part and/or a position of the body part within the FoV (120). Based on the posture and/or the position

- the wearable device (101)can identify a posture of a hand (112) included in the FoV (120) of the camera using a camera.

- the wearable device (101)can identify a posture of the hand (112) corresponding to a pinch gesture.

- the present disclosureis not limited thereto, and the posture of the hand (112) corresponding to the pinch gesture can be identified based on the thumb and the index finger having a ring shape.

- the wearable device (101)can identify an input indicating a movement of a virtual object (140) based on the posture of a body part (e.g., the hand (112)). For example, based on identifying a hand (112) having a posture of a pinch gesture as illustrated in FIGS. 1A and 1B, the wearable device (101) can identify the input. For example, based on identifying that a position (pf1) of the hand (112) having the posture of the pinch gesture within the FoV (120) corresponds to a position (pv1) of a virtual object (140) within the screen (130), for example, within the virtual space, the wearable device (101) can identify the input. For example, a designated posture for moving the virtual object (140) may include the posture of the hand (112) as illustrated in FIGS. 1A and 1B.

- the wearable device (101)in response to an input that is identified based on a hand (112) of a pinch gesture and indicates movement of a virtual object (140), the wearable device (101) can move the virtual object (140) along the path (114) of the hand (112). Referring to FIGS. 1A and 1B, the wearable device (101) can move the virtual object (140) within the screen (130) along the path (141) corresponding to the path (114) of the hand (112).

- a wearable device (101) that identifies a hand (112) moving from a position (pf1) to a position (pf2) within the FoV (120) along a path (114)can move a virtual object (140) from a position (pv1) to a position (pv2) within a screen (130), for example, within a virtual space.

- the path (114) of the hand (112)is illustrated as if it were on a two-dimensional plane for convenience, but each of the positions (pf1), (pf2), (pf3), (pf4), (pf5), and (pf6) on the path (114) may have three-dimensional coordinate values (x, y, z).

- the format (for example, two-dimensional coordinates or three-dimensional coordinates) of the positions (pf1 to pf6) on the path (114)may be determined depending on the format (for example, two-dimensional plane or three-dimensional space) displayed on the screen (130).

- the screen (130)is a virtual space

- the path (114) or positions (pf1 to pf6) of the hand (112)may have three-dimensional coordinate values, and the position of the object (140) in the virtual space may be displayed depending on the path (114) of the hand (112).

- the wearable device (101)may display a virtual object (142) representing the hand (112).

- the virtual object (142)may be referred to as an avatar of the user (110).

- the virtual object (142)may have a shape corresponding to the posture of the hand (112) and may be displayed based on a position in the virtual space corresponding to the position of the hand (112).

- a virtual object (142) having a shape of being held with a pinch gesture or being held by a hand in the virtual spaceis exemplarily illustrated.

- a shape of a pointer, a ray, a stick, or various toolsmay be displayed.

- the range (e.g., FoV (120)) over which the wearable device (101) can detect a body part using one or more cameras and/or sensorsmay be finite.

- the range (or area) over which the user (110) can move his/her hand (112)may be different from the FoV (120) of the camera of the wearable device (101).

- the hand (112) moving along the path (114)may move out of the FoV (120) at a location (pf3) of the edge of the FoV (120).

- the wearable device (101)can identify, by using a camera, that a body part (e.g., a hand (112)) is moved out of the FoV (120) through a position (pf3) of an edge of the FoV (120). Based on identifying that a body part (e.g., a hand (112)) is moved out of the FoV (120) through a position (pf3) of an edge of the FoV (120), the wearable device (101) can display a virtual object (140) at a position (pv3) of a display corresponding to the position (pf3).

- a body parte.g., a hand (112)

- the wearable device (101)can display a virtual object (140) at a position (pv3) of a display corresponding to the position (pf3).

- the wearable device (101)may at least temporarily cease using the camera to identify the position and/or pose of the hand (112).

- the wearable device (101)may display a virtual object (140) based on the last position within the FoV (120) at which the hand (112) was identified.

- the wearable device (101)can display a virtual object (140) at a location (pv3) within the screen (130) corresponding to the last location (pf3) within the FoV (120) that identified the hand (112). For example, while the hand (112) moves along the path (114) from a location (pf3) at the edge of the FoV (120) to a location (pf4) outside the FoV (120), the wearable device (101) can maintain the location of the virtual object (140) within the screen (130) at the location (pv3).

- the wearable device (101)can, based on identifying the hand (112) moving into the FoV (120), re-execute a function that was being executed prior to stopping tracking of the hand (112).

- the wearable device (101)can, based on identifying the hand (112) moving into the FoV (120), re-execute a function that was being executed prior to stopping tracking of the hand (112).

- the wearable device (101) that identifies the hand (112) moving into the FoV (120) via the location (pf5) of the edge of the FoV (120) along the path (114)can re-execute a function (e.g., a function of moving a virtual object (140) based on the path (114) of the hand (112)) that was being executed by the hand (112) prior to it moving out of the FoV (120) via the location (pf3). Since the above function is executed again, the wearable device (101) can compensate for unintentional interruption of the function caused by the hand (112) moving out of the FoV (120).

- a functione.g., a function of moving a virtual object (140) based on the path (114) of the hand (112)

- the wearable device (101)may identify a body part (e.g., hand (112)) in a specified posture (e.g., posture of a pinch gesture) that has moved into the FoV (120), and display a virtual object (140) that has moved from the location (pv3) and has moved along the path (114) of the body part within the FoV (120).

- a body parte.g., hand (112)

- a specified posturee.g., posture of a pinch gesture

- the wearable device (101) that has identified a hand (112) having a posture of a pinch gesture that has moved into the FoV (120)may change the location (pv3) of the virtual object (140) within the screen (130) based on the path (114) of the hand (112).

- a wearable device (101) that identifies a hand (112) moving from a position (pf5) at the edge of the FoV (120) along a path (114) to a position (pf6) within the FoV (120)can move a virtual object (140) from a position (pv5) corresponding to the position (pf5) to a position (pv6) within the screen (130) along the path (114).

- the posture of the hand (112)can change from a pinch gesture to another posture (e.g., a posture with all fingers spread out) different from the pinch gesture at a location (pf4) outside the FoV (120).

- another posturee.g., a posture with all fingers spread out

- the wearable device (101)can identify the different posture of the hand (112).

- the wearable device (101)can not change the virtual object (140) displayed according to the location (pv3) of the hand (112) before it is moved out of the FoV (120) according to the location of the hand (112).

- the wearable device (101)can independently display a virtual object (142) (e.g., an avatar representing the hand of the user (110)) that moves from a position (pv5) within the screen (130) corresponding to the position (pf5) to a position (pv6) within the screen (130) corresponding to the position (pf6).

- a virtual objecte.g., an avatar representing the hand of the user (110)

- the wearable device (101)can identify a gesture of a user (110) that is performed independently of a range detectable by a camera and/or sensor of the wearable device (101) (e.g., FoV (120)).

- the gesturecan include a gesture performed by a hand (112) moving along a path (114).

- the wearable device (101) that identifies a path (114) of a hand (112) that is discontinuously recognized as moving out of the FoV (120)can continuously execute a function (e.g., a function of moving a virtual object (140)) that was performed by the hand (112) based on whether the posture of the hand (112) is maintained in a designated posture.

- a functione.g., a function of moving a virtual object (140)

- FIG. 2is a block diagram illustrating an exemplary configuration of a wearable device (101) according to one embodiment.

- the wearable device (101) of FIGS. 1A and 1Bmay be an example of the wearable device (101) described with reference to FIG. 2.

- the wearable device (101)may include at least one of a processor (210) (e.g., including processing circuitry), a memory (215), a display (220), a camera (225), a sensor (230), and/or communication circuitry (240).

- the processor (210), the memory (215), the display (220), the camera (225), the sensor (230), and the communication circuitry (240)may be electronically and/or operably coupled with each other by electronic components, such as a communication bus (202).

- operably coupled hardwaremay refer to a direct connection, or an indirect connection established between the hardwares, wired or wireless, such that a second hardware is controlled by a first hardware among the hardwares.

- the present disclosureis not limited thereto, and some of the hardware of FIG. 2 (e.g., at least a portion of the processor (210), the memory (215), and the communication circuit (240)) may be included in a single integrated circuit, such as a system on a chip (SoC).

- SoCsystem on a chip

- the type and/or number of hardware included in the wearable device (101)is not limited to that illustrated in FIG. 2.

- the wearable device (101)may include only some of the hardware illustrated in FIG. 2.

- the processor (210) of the wearable device (101)may include hardware for processing data based on one or more instructions.

- the hardware for processing datamay include, for example, an arithmetic and logic unit (ALU), a floating point unit (FPU), a field programmable gate array (FPGA), a central processing unit (CPU), and/or an application processor (AP).

- ALUarithmetic and logic unit

- FPUfloating point unit

- FPGAfield programmable gate array

- CPUcentral processing unit

- APapplication processor

- the processor (210)may have a structure of a single-core processor, or may have a structure of a multi-core processor, such as a dual core, a quad core, or a hexa core.

- the processor (210) according to one embodiment of the present disclosuremay include various processing circuits, and/or a plurality of processors.

- processormay encompass various processing circuitry, including at least one processor, wherein one or more of the at least one processors may be individually and/or collectively configured, in a distributed manner, to perform the various functions described herein.

- processorwhen “processor,” “at least one processor,” and “one or more processors” are described as being configured to perform several functions, these terms may cover, by way of non-limiting example, situations where one processor performs some of the recited functions, other processor(s) perform other of the recited functions, and may also cover situations where a single processor performs all of the recited functions.

- the at least one processormay encompass a combination of processors, e.g., in a distributed manner, that perform the various functions recited/disclosed.

- the at least one processormay execute program instructions to accomplish or perform the various functions.

- the memory (215) of the wearable device (101)may include hardware for storing data and/or instructions input and/or output to the processor (210) of the wearable device (101).

- the memory (215)may include, for example, volatile memory, such as random-access memory (RAM), and/or non-volatile memory, such as read-only memory (ROM).

- volatile memorysuch as random-access memory (RAM)

- ROMread-only memory

- the volatile memorymay include, for example, at least one of dynamic RAM (DRAM), static RAM (SRAM), Cache RAM, and pseudo SRAM (PSRAM).

- the non-volatile memorymay include, for example, at least one of programmable ROM (PROM), erasable PROM (EPROM), electrically erasable PROM (EEPROM), flash memory, a hard disk, a compact disc, a solid state drive (SSD), and an embedded multi media card (eMMC).

- PROMprogrammable ROM

- EPROMerasable PROM

- EEPROMelectrically erasable PROM

- flash memorya hard disk, a compact disc, a solid state drive (SSD), and an embedded multi media card (eMMC).

- SSDsolid state drive

- eMMCembedded multi media card

- the display (220) of the wearable device (101)presents visualized information (e.g., the screen (130) of FIGS. 1A-1B, FIGS. 4, FIGS. 5, FIGS. 6A-6C, FIGS. 7A-7C, FIGS. 9A-9C, FIGS. 10, FIGS. 11A-11C, FIGS. 12A-12B, FIGS. 13A-13C, FIGS. 14A-14C) to a user (e.g., the screen (130) of FIGS. 1A-1B, FIGS. 4, FIGS. 5, the screen (620) of FIGS. 6A-6C, the screen (720) of FIGS. 7A-7C, the screen (920) of FIGS. 9A-9C, the screen (1020) of FIGS.

- visualized informatione.g., the screen (130) of FIGS. 1A-1B, FIGS. 4, FIGS. 5, FIGS. 6A-6C, FIGS. 7A-7C, FIGS. 9A-9C, the screen (1020) of FIGS.

- the display (220)can output a screen (1120), a screen (1220) of FIGS. 12A to 12B, a screen (1320) of FIGS. 13A to 13C, and a screen (1410) of FIGS. 14A to 14C).

- the display (220)can be controlled by a processor (210) including a circuit such as a GPU (graphic processing unit) to output visualized information to a user.

- the display (220)can include a flexible display, a flat panel display (FPD), and/or electronic paper.

- the flexible displaycan have a structure that is deformable by an external force.

- the FPDcan include a liquid crystal display (LCD), a plasma display panel (PDP), and/or one or more light emitting diodes (LEDs).

- the LEDscan include organic LEDs (OLEDs).

- the display (220) of FIG. 2may include at least one display (1650, 1750), which will be described in more detail with reference to FIGS. 16a and 16b, and/or FIGS. 17a and 17b.

- the camera (225) of the wearable device (101)may include one or more optical sensors (e.g., a charged coupled device (CCD) sensor, a complementary metal oxide semiconductor (CMOS) sensor) that generate electrical signals representing the color and/or brightness of light.

- the plurality of optical sensors included in the camera (225)may be arranged in the form of a two-dimensional array.

- the camera (225)may acquire electrical signals of each of the plurality of optical sensors substantially simultaneously to generate two-dimensional frame data corresponding to light reaching the optical sensors of the two-dimensional array.

- photographic data captured using the camera (225)may refer to, for example, one (a) two-dimensional frame data acquired from the camera (225).

- video data captured using the camera (225)may refer to, for example, a sequence of a plurality of two-dimensional frame data acquired from the camera (225) according to a frame rate.

- the camera (225)may be positioned toward the direction in which the camera (225) receives light, and may further include a flash light for outputting light toward the direction.

- a sensor (230) of a wearable device (101)may generate electrical information that may be processed by a processor (210) and/or a memory (215) of the wearable device (101) from non-electronic information related to the wearable device (101).

- the informationmay be referred to as sensor data.

- the sensor (230)may include a global positioning system (GPS) sensor, an image sensor, an ambient light sensor, and/or a time-of-flight (ToF) sensor for detecting a geographic location of the wearable device (101), and an inertial measurement unit (IMU) for detecting a physical motion of the wearable device (101).

- the IMUmay include at least one of an acceleration sensor, a gyro sensor, and a gravity sensor.

- the processor (210) of the wearable device (101)can identify the motion of the wearable device (101) based on six degrees of freedom (DoF).

- the motion of the wearable device (101) based on six degrees of freedomcan include translation and rotation (e.g., roll, pitch, and yaw) of the wearable device (101) along three axes (e.g., x-axis, y-axis, and z-axis) that are perpendicular to each other.

- the communication circuit (240) of the wearable device (101)may include hardware components for supporting transmission and/or reception of electrical signals between the wearable device (101) and an external electronic device (e.g., a remote controller (242)).

- the communication circuit (240)may include, for example, at least one of a modem (MODEM), an antenna, and an optic/electronic (O/E) converter.

- the communication circuit (240)may support transmission and/or reception of electrical signals based on various types of protocols, such as Ethernet, a local area network (LAN), a wide area network (WAN), wireless fidelity (WiFi), Bluetooth, Bluetooth low energy (BLE), ZigBee, long term evolution (LTE), 5G NR (new radio), and/or 6G.

- a wearable device (101)may receive a signal for executing at least one function supported by the wearable device (101) from a remote controller (242) connected via a communication circuit (240).

- the remote controller (242)may include one or more buttons, a joystick, and/or a touch sensor for receiving a user input.

- the processor (210) of the wearable device (101)may execute the at least one function.

- the wearable device (101)may include output means for outputting information in a form other than a visualized form.

- the wearable device (101)may include a speaker for outputting an acoustic signal.

- the wearable device (101)may include a motor for providing haptic feedback based on vibration.

- one or more instructions (or commands) representing operations and/or actions to be performed on data by a processor (210) of the wearable device (101)may be stored in the memory (215) of the wearable device (101).

- a set of one or more instructionsmay be referred to as a program, firmware, an operating system, a process, a routine, a sub-routine, and/or an application.

- an applicationwhen installed in an electronic device (e.g., the wearable device (101)), it may refer to, for example, that one or more instructions provided in the form of an application are stored in the memory (215), and that the one or more applications are stored in a format executable by the processor of the electronic device (e.g., a file having an extension specified by the operating system of the wearable device (101)).

- the wearable device (101)may execute one or more instructions stored in the memory (215) to perform the operations of, for example, FIG. 3, FIG. 8, and/or FIG. 15.

- programs installed in the wearable device (101)may be classified into one of different layers, including an application layer (260), a framework layer (270), and/or a hardware abstraction layer (HAL) (250), based on a target.

- programse.g., drivers

- the hardwaree.g., display (220), camera (225), sensor (230), and/or communication circuit (240)

- the hardware abstraction layer250.

- programs designed to target at least one of the hardware abstraction layer (250) and/or the application layer (260)may be classified.

- Programs classified into the framework layer (270)may provide an executable API (application programming interface) based on other programs.

- programs designed to target a usermay be classified within the application layer (260).

- a program classified into the application layer (260)may include at least one of an application (261) for a VR-based game, an application (262) for playing and/or streaming a video, an application (263) for viewing media content (e.g., images and/or videos) of a memory (215), or an application (264) for a call connection.

- the present disclosureis not limited thereto.

- a program classified into the application layer (260)may cause execution of a function supported by programs classified into the framework layer (270) based on a call of an API.

- the processor (210)may process information related to the gaze of a user wearing the wearable device (101) based on the execution of the gaze tracker (271) in the framework layer (270). For example, the processor (210) may obtain an image including the user's eye from a first camera positioned toward the user's eye while the wearable device is worn by the user. Based on the position and/or direction of the pupil included in the image, the processor (210) may identify the direction of the user's gaze.

- the processor (210)may identify a motion of a designated body part including a hand based on the execution of a gesture tracker (272) within the framework layer (270). For example, the processor (210) may obtain an image and/or video including the body part from a second camera. Based on the motion and/or posture of the designated body part represented by the image and/or video, the processor (210) may identify a gesture performed by the designated body part.

- the processor (210)may identify the motion of the wearable device (101) based on the execution of the motion tracker (273) within the framework layer (270). Within a state where the wearable device (101) is worn by a user, the motion of the wearable device (101) may be related to the motion of the user's head. For example, the processor (210) may identify an orientation of the wearable device (101) that substantially coincides with the orientation of the head. The processor (210) may identify the motion of the wearable device (101) based on sensor data of a sensor (230) including an IMU.

- the processor (210)may obtain information about an external space including a wearable device (101) based on execution of an external space recognizer (274) in a framework layer (270).

- the information about the external spacemay include a shape and/or a position of one or more external objects (e.g., a wall structure) included in the external space.

- the information about the external spacemay include a positional relationship of one or more external objects with respect to the wearable device (101).

- the processor (210) of the wearable device (101)may obtain or generate the information representing the external space in three dimensions.

- the processor (210)may perform rendering for a virtual space based on the execution of the virtual space manager (275) in the framework layer (270). With the virtual space manager (275) executed, the processor (210) may identify a virtual space including at least one virtual object provided from at least one software application in the application layer (260). In one embodiment, based on the external space recognizer (274) and/or the virtual space manager (275), the processor (210) may identify a virtual space mapped to the external space. The processor (210) may determine a reference position in the virtual space based on a position and/or direction of the wearable device (101) in the external space, which is identified based on data of the sensor (230).

- the reference positionmay correspond to a position of the wearable device (101) in the virtual space.

- the processor (210)may perform simultaneous localization and mapping (SLAM) to recognize external space and the location of the wearable device (101) within the external space based on the reference position. Based on the SLAM, the processor (210) may generate or obtain a virtual space including information about the external space.

- SLAMsimultaneous localization and mapping

- the processor (210) of the wearable device (101)may identify a body part (e.g., a hand (112) of FIGS. 1A and 1B) of a user wearing the wearable device (101) using the camera (225). Even if the body part moves out of the FoV (e.g., the FoV (120) of FIGS. 1A and 1B) of the camera (225), the processor (210) may re-execute a function that was executed before the body part moved out of the FoV based on the posture of the body part moved into the FoV.

- a body parte.g., a hand (112) of FIGS. 1A and 1B

- the processor (210)may re-execute a function that was executed before the body part moved out of the FoV based on the posture of the body part moved into the FoV.

- the processor (210)may execute a function corresponding to the posture of the body part moved into the FoV based on a state in which the function was executed based on the body part before it was moved out of the FoV.

- the processor (210)in a state where a virtual object displayed on the display (220) is moved by a body part in a specified posture, even if the body part is moved out of the FoV, the processor (210) can move the virtual object again based on the body part that is moved back into the FoV.

- the processor (210)in a state where the size of the virtual object is adjusted by one or more body parts, even if the one or more body parts are moved out of the FoV, the processor (210) can adjust the size of the virtual object again based on the one or more body parts that are moved back into the FoV.

- the processor (210)can re-display a virtual object that was hidden by a body part that was moved out of the FoV, based on the posture of the body part that is moved into the FoV.

- FIG. 3is a flowchart illustrating exemplary operations of a wearable device according to one embodiment.

- the wearable device (101) of FIGS. 1A and 1B, FIG. 2, and/or the processor (210) of FIG. 2may perform the operations described with reference to FIG. 3.

- a processor of a wearable devicemay change a position of a virtual object displayed in a display based on identifying a gesture indicating movement of a virtual object using a camera.

- the camera of operation (310)may include the camera (225) of FIG. 2.

- the processor of the wearable devicemay identify the gesture of operation (310) using a depth sensor included in the wearable device.

- the processorcan identify a body part (e.g., a hand (112) of FIGS. 1A and 1B) moving within a FoV of a camera (e.g., a FoV (120) of FIGS. 1A and 1B) using images and/or videos acquired from the camera.

- the processorcan perform object recognition on the images and/or videos to identify the body part.

- the processorcan identify a visual object corresponding to the body part within the images and/or videos based on the object recognition.

- the processorBased on a pose of the body part identified based on the visual object (e.g., the pose of the pinch gesture illustrated in FIGS. 1A and 1B), the processor can identify the gesture of the operation (310).

- the present disclosureis not limited thereto, and the processor can identify the gesture of the operation (310) based on a software application executed by the processor.

- a gesture indicating movement of a virtual objectmay correspond to a posture defined by the software application.

- a processor that identifies a gesture indicating movement of a virtual object of an action (310)can change a location of a virtual object (e.g., a virtual object (140) of FIGS. 1A-1B) within a screen displayed on a display (e.g., a screen (130) of FIGS. 1A-1B).

- the processorcan change the location of the virtual object within the virtual space based on the gesture of the action (310).

- the processorcan change the location of the virtual object within the display based on a location within the FoV of a body part that performs the gesture of the action (310). The relationship between the FoV of the camera and the screen displayed on the display is described in more detail with reference to FIG. 4.

- a processor of a wearable devicemay identify whether a body part performing a gesture moves out of the FoV of a camera. Before the body part moves out of the FoV, or while the body part is moving within the FoV (320-No), the processor may change the position of the virtual object based on operation (310). While the body part is moving within the FoV, the processor may change the position of the virtual object based on a path (e.g., path (114) of FIG. 1A) of the body part performing the gesture of operation (310). While moving the virtual object (140) of FIG. 1A based on operation (310), the processor may move the virtual object (140) along the path (141).

- a pathe.g., path (114) of FIG. 1A

- the processor of the wearable devicemay perform operation (330).

- the processormay set a position of a virtual object in the virtual space based on a first position of the body part identified by the camera in the FoV.

- the processormay determine a position of the virtual object based on the first position of the body part in the FoV before it was moved out of the FoV.

- the processormay place the virtual object at a position in the virtual space corresponding to the first position. For example, a virtual object that was being moved in the display and/or virtual space based on operation (310) may be placed at the first position of the body part last identified by the camera based on operation (330).

- the processorcan set the position of the virtual object in the virtual space based on the relative positional relationship between the wearable device and the first position. For example, the processor can set the position of the virtual object in the virtual space based on the positional relationship between the first position and the wearable device at the time when the body part is moved out of the FoV. In the example, when a user wearing the wearable device moves, the processor can move the virtual object in the virtual space using the positional relationship. In the example, the user who sees the virtual object moved in the virtual space according to the positional relationship can recognize that the virtual object follows the user. For example, the position of the virtual object set based on the operation (330) can be interlocked with the position of the wearable device.

- the processormay obtain information about the external space using the camera.

- the processor of the wearable devicemay identify a body part moving into the FoV of the camera. Before identifying the body part within the FoV (340-No), or if the body part is not identified within the FoV, the processor may maintain the position of the virtual object within the virtual space set based on the operation (330). Based on identifying the body part moving into the FoV of the camera (340-Yes), the processor may perform the operation (350). For example, when the hand (112) of FIG. 1A moves from the position (pf5) of the edge of the FoV (120) into the FoV (120), the processor may perform the operation (350).

- a processor of a wearable devicemay identify a gesture indicating movement of a virtual object based on a body part moved into the FoV. For example, the processor may identify whether the identified body part using a camera corresponds to (or matches) a body part that was moved into the FoV box. For example, the processor may identify whether a posture of the body part moved into the FoV corresponds to the gesture of operation (310). If the gesture of operation (350) is not identified (350-No), or prior to identifying the gesture of operation (350), the processor may perform operation (360). For example, if the posture of the body part moved into the FoV does not correspond to the gesture of operation (310), the processor may perform operation (360). Based on identifying a gesture of action (350) from a body part moved into the FoV (350-example), the processor can perform an action (370).

- the processorcan perform an action (370).

- a processor of a wearable devicemay determine a location of a virtual object in a virtual space based on a first location.

- the processormay determine a last location of the virtual object that was changed based on operation (310) as the location of the virtual object.

- the processormay determine a location of the virtual object in a virtual space independently of a body part moved into the FoV based on identifying a gesture that is different from the gesture of operation (350).

- the processorwhich placed the virtual object at the first location linked to the location of the wearable device based on operation (330), may perform operation (360) to disable the linkage between the location of the virtual object in a virtual space based on the first location and the location of the wearable device. For example, based on operation (360), the processor may set the location of the virtual object in a virtual space to coordinate values corresponding to the first location in the virtual space.

- a processor of a wearable devicemay display a virtual object within a display based on a second location within the FoV of a body part moved into the FoV.

- the processormay resume changing the location of the virtual object based on the second location, similar to operation (310).

- the processormay move a virtual object positioned at a location within the virtual space corresponding to the first location to the second location of the body part moved into the FoV.

- the processor changing the location of the virtual object based on operation (370)may be performed similar to operation (310).

- the processor of the wearable devicecan identify, based on the re-entry of the body part into the FoV, whether the first posture (or the first gesture) of the body part corresponds to a second posture (or the second gesture) of the body part that was identified prior to the re-entry. If the first posture corresponds to the second posture, the processor can re-execute a function that was executed based on the second posture (e.g., a function of changing the position of the virtual object of the operation (310)). For example, the processor can re-execute the function that was interrupted due to a mismatch between the range of motion of the body part and the FoV.

- a function that was executed based on the second posturee.g., a function of changing the position of the virtual object of the operation (310).

- the processorcan re-execute the function that was interrupted due to a mismatch between the range of motion of the body part and the FoV.

- exemplary operations of a wearable device for identifying gestures performed by a body partsuch as operations (310, 340, 350) of FIG. 3, are described in more detail with reference to FIG. 4 and/or FIG. 5.

- FIG. 4is a diagram illustrating exemplary operations performed by a wearable device (101) to identify a body part.

- the wearable device (101) of FIGS. 1A and 1B, FIG. 2, and/or the processor (210) of FIG. 2may perform the operations described with reference to FIG. 4.

- the operations of the wearable device (101) described with reference to FIG. 4may be related to at least one of the operations of FIG. 3.

- an exemplary state (401) of a wearable device (101) that identifies a body part (e.g., a hand (112)) within a FoV (120)is illustrated.

- the wearable device (101)can identify a body part (e.g., a hand (112)) within the FoV (120).

- the wearable device (101)can identify a portion (410) corresponding to the hand (112) within the image acquired from the camera.

- the wearable device (101)can identify a gesture performed by the hand (112) using the portion (410) of the image corresponding to the hand (112).

- the wearable device (101)can identify the posture of the hand (112) based on one or more feature points included in the portion (410).

- the present disclosureis not limited thereto, and the wearable device (101) can identify the posture of the hand (112) using a neural network trained to identify the hand (112).

- the neural networkcan have a structure based on, for example, a convolutional neural network (CNN), without limitation.

- portions (411, 412, 413) of images corresponding to hands (112) in different posturesare exemplarily illustrated.

- the wearable device (101)can identify a pinch gesture indicated by the thumb and index finger of the hand (112) connected in a ring shape.

- the wearable device (101)can identify a pointing gesture indicated by the spread index finger and folded other fingers.

- the wearable device (101)can identify a clenched gesture indicated by five folded fingers.

- the wearable device (101) that identifies a hand (112) within the FoV (120)can execute a function corresponding to a gesture of the hand (112).

- the functioncan include a function for moving a virtual object (e.g., a virtual object (140) of FIGS. 1A to 1B) as described with reference to FIGS. 1A to 1B.

- a pair of a gesture of the hand (112) and a function matching the gesturecan be set by a software application executed by the wearable device (101).

- the wearable device (101)can execute a function for moving a virtual object.

- the wearable device (101), while executing a function for moving a virtual object,can adjust the position of the virtual object based on a reference point of a body part (e.g., a hand (112)) within the FoV (120).

- the wearable device (101) that has identified an image including a portion (411)can adjust the position of the virtual object based on the positions (a1) of the fingertips of the hands (112) that are in contact with each other within the image.

- the wearable device (101) that has identified an image including a portion (412)can adjust the position of the virtual object based on the positions (a2) of the fingertips of the spread fingers within the image.

- the wearable device (101) that has identified an image including a portion (413)can adjust the position of the virtual object based on the positions (a3) within the image corresponding to the center of the hand (112).

- the wearable device (101)may display a screen (130) based on AR, VR and/or VST.

- the size of the screen (130) displayed through the display of the wearable device (101)may be controlled by a software application executed by a processor of the wearable device (101) (e.g., the processor (210) of FIG. 2).

- the size of the screen (130)may be controlled independently of the size of the FoV (120) of the camera of the wearable device (101).

- FIG. 4an exemplary state (401) of the FoV (120) formed toward a direction (df) corresponding to the front of a user (110) wearing the wearable device (101) and the screen (130) displayed to the user (110) is illustrated.

- the wearable device (101)can display a screen (130) having a size smaller than the size of the FoV (120) to the user (110).

- the wearable device (101)moves a virtual object within the screen (130) based on the position of the hand (112) within the FoV (120)

- the wearable device (101)can identify a position within the screen (130) corresponding to the position of the hand (112) based on the relationship between the FoV (120) and the screen (130).

- the wearable device (101)can display an image acquired through a camera on the screen (130).

- a user (110) wearing a wearable device (101)can recognize the external environment in the direction (df) (e.g., forward).

- the wearable device (101)can synthesize a virtual object on the image and display a screen (130) in which the virtual object and the external environment are mixed to the user (110).

- the wearable device (101)can display a virtual object (e.g., a virtual object (142) of FIG. 1) overlapping a hand (112) visible to the user (110) through the image.

- the wearable device (101)which has identified an input for moving the virtual object based on the hand (112), can move the virtual object based on the position of the hand (112) visible through the screen (130). For example, while the hand (112) is moved within the FoV (120), the wearable device (101) can adjust the position of the virtual object within the screen (130) based on the position of the hand (112) within the FoV (120).

- the user (110) wearing the wearable device (101)can simultaneously view the hand (112) and a virtual object moving based on the hand (112) through the screen (130). While the hand (112) is moved within the region (r2) of the FoV (120) outside the screen (130), the user (110) wearing the wearable device (101) cannot view the hand (112) through the screen (130), but can view the virtual object moving based on the hand (112). While the hand (112) is moved in an area (r3) outside the FoV (120), the user (110) wearing the wearable device (101) cannot see the hand (112) and can see the virtual object moved by the hand (112) stop.

- the wearable device (101)can re-execute a function that was performed by a gesture of the hand (112) based on the re-entry of the hand (112) that moved into an area (r3) outside the FoV (120).

- the wearable device (101)can identify, based on the posture and/or gesture of the hand (112) identified using the image of the camera, whether the hand (112) that moved into the FoV (120) corresponds to a body part that was moved out of the FoV (120).

- FIG. 5is a diagram illustrating exemplary operations performed by a wearable device (101) to obtain information about a body part.

- the wearable device (101) of FIGS. 1A and 1B, FIG. 2, and/or the processor (210) of FIG. 2may perform the operations described with reference to FIG. 5.

- the operations of the wearable device (101) described with reference to FIG. 5may be related to at least one of the operations of FIG. 3 (e.g., operation (340) of FIG. 3).

- a wearable device (101)that identifies a body part (e.g., a hand (112)) based on a camera (e.g., a camera (225) of FIG. 2) is illustrated.

- the wearable device (101)can obtain information about an area in which the body part can move using the camera.

- the wearable device (101)can identify or measure a range (or area) in which the hand (112) can move using an image and/or a video of the FoV (120) of the camera.

- the wearable device (101)can obtain information for distinguishing the hand (112) using the image and/or the video.

- the wearable device (101)can obtain the information based on the shape, skin color, size of the hand (112) and/or one or more accessories attached to the hand (112).

- the information acquired by the wearable device (101)may be used to identify the identity of body parts (e.g., hands (112)) identified in different time intervals.

- the wearable device (101)which acquired information about a hand (112) that moved within the FoV (120) in a first time interval, may identify a body part that moves within the FoV (120) in a second time interval after the first time interval, and may use the information to identify whether the body part and the hand (112) match each other.

- the wearable device (101) that has acquired information about the hand (112) of the user (110)can identify the hand (112) of the user (110) based on the information when the hands of different users included in the FoV (120) are identified.

- the wearable device (101)can identify an area in which the hand (112) identified from the information can move.

- the wearable device (101)can determine one hand included in the area among the plurality of hands as the hand (112) of the user (110).

- the wearable device (101)can identify the hand (112) of the user (110) among the plurality of hands based on the shape, skin color, and/or size of the hand (112) identified from the information within the area.

- the wearable device (101)can identify the hand (112) of the user (110) among the plurality of hands based on one or more accessories attached to the hand (112) identified from the information within the area.

- the wearable device (101)may output a message to a user (110) to obtain information about an area of the FoV (120) in which the hand (112) can move.

- the messagemay include designated text for obtaining an image and/or video of the area in which the hand (112) can move, such as, for example, “Rotate your arm greatly.”

- the wearable device (101)may identify a position (ph1) of the hand (112) of the user (110) and a path and/or range of the hand (112) moving along one of the directions (dh1, dh2, dh3, dh4) using the image and/or video of the FoV (120).

- the wearable device (101)can identify a hand (112) displayed at a position (ih1) corresponding to the position (ph1) in the image and/or the video and moving along directions (id1, id2, id3, id4) corresponding to each of the directions (dh1, dh2, dh3, dh4). Based on the image and/or the video, the wearable device (101) can identify a position (ph1) of the hand (112) and/or positions (j1, j2) of one or more joints connected to the hand (112). The one or more joints may be included in an arm of the user (110).

- the wearable device (101)can identify a range (510) within the FoV (120) in which the hand (112) of the user (110) can move based on the movement of the hand (112) within the FoV (120). Based on identifying the hand (112) moving from outside the FoV (120) to the range (510) of the FoV (120), the wearable device (101) can determine the identified hand (112) as the hand (112) of the user (110). According to one embodiment, the wearable device (101) can identify whether the hand (112) identified based on the range (510) of the FoV (120) is the hand (112) of the user (110) based on the direction (iv1) of the hand (112) with respect to the arm.

- the wearable device (101)can identify whether the hand (112) included in the image is the hand (112) of the user (110) by comparing the direction (iv1) identified from the image for the FoV (120) and the direction (av) of the hand (112) with respect to the arm of the user (110) in the external space.

- the wearable device (101)can determine whether a body part identified from an image and/or video of the FoV (120) corresponds to a body part that has moved out of the FoV (120).

- the wearable device (101)can use information about an area (e.g., range (510)) in which the body part can move to identify whether the body part within the FoV (120) is a designated body part for identification of a gesture (e.g., a hand (112) of the user (110)).

- a gesturee.g., a hand (112) of the user (110)

- the wearable device (101) that has identified the hand (112) of the user (110)can identify an input for controlling at least one virtual object displayed through the display of the wearable device (101) (e.g., the display (220) of FIG. 2) based on the posture and/or gesture of the hand (112).

- FIGS. 6a, 6b and 6cexemplary operations of the wearable device (101) related to the path of the hand (112) identified based on the FoV (120) are described in more detail with reference to FIGS. 6a, 6b and 6c and/or FIGS. 7a, 7b and 7c.

- FIGS. 6A, 6B, and 6Care diagrams illustrating exemplary operations of a wearable device (101) performed based on movement of a body part.

- the wearable device (101) of FIGS. 1A and 1B, FIG. 2, and/or the processor (210) of FIG. 2may perform the operations described with reference to FIGS. 6A, 6B, and 6C.

- the operations of the wearable device (101) described with reference to FIGS. 6A, 6B, and 6Cmay be related to at least one of the operations of FIG. 3.

- exemplary states (601, 602, 603) of a wearable device (101) that identify a hand (112) of a user (110) within a FoV (610) of one or more cameras (e.g., camera (225) of FIG. 2) positioned toward one direction of the wearable device (101) (e.g., toward the front of the wearable device (101))are illustrated.

- the wearable device (101)can identify a body part, such as a hand (112), using an image and/or video corresponding to the FoV (120).

- the wearable device (101)can display a screen (620) including a virtual object (630) on a display (e.g., the display (220) of FIG. 2).

- a displaye.g., the display (220) of FIG. 2.

- the wearable device (101)can display a screen (620) including an image for the FoV (120) and all of the virtual objects (630).

- the wearable device (101)displays a screen (620) based on VR

- the wearable device (101)can display a screen (620) representing a virtual environment that completely obscures the external space.

- the wearable device (101)can identify a gesture of the hand (112) indicating movement of a virtual object (630) within the screen (620).

- the wearable device (101)can identify a pinch gesture of the hand (112) performed within the FoV (610) based on the operations described above with reference to FIGS. 4 and 5.

- the wearable device (101) based on the pinch gestureis described, the present disclosure is not limited thereto.

- the wearable device (101)can perform the operations of FIGS. 6a, 6b, and 6c based on identifying a pointing gesture.

- the wearable device (101)can identify the pinch gesture performed by the hand (112).

- the wearable device (101)can identify a location (ip1) within the screen (620) corresponding to the location (fp1) within the FoV (610) corresponding to the fingertip of the extended finger.

- the wearable device (101)can identify an input indicating movement of the virtual object (630).

- the wearable device (101)can identify a path (640) along which a hand (112) moves within the FoV (610). Based on the path (640), the wearable device (101) can change the position of the virtual object (630) within the display.

- the wearable device (101)can move the virtual object (630) along a path (642) corresponding to the path (640) of the hand (112), based on identifying a hand (112) that moves from a position (fp1) along the path (640) and maintains the pinch gesture.

- the wearable device (101)can move a virtual object (630) along a path (642) from a location (ip1) within the screen (620).

- the shape of the path (642) along which the virtual object (630) is moved within the screen (620)can be matched to the path (640) along which the hand (112) is moved within the FoV (610).

- the wearable device (101)can provide a user experience in which the virtual object (630) is connected to the hand (112) being moved within the FoV (610).

- the wearable device (101)can stop moving the virtual object (630) based on the release of the pinch gesture performed by the hand (112). For example, if the posture of the hand (112) being moved within the FoV (610) changes to a posture different from the posture of the pinch gesture, the wearable device (101) can stop moving the virtual object (630) based on the position and/or path of the hand (112) within the FoV (610). In the example, the position of the virtual object (630) within the screen (620) can be fixed to the position of the hand (112) within the FoV (610) at the time when the posture of the hand (112) changes to the different posture.

- the wearable device (101)can display a virtual object (630) based on the position (ip2) of the edge of the FoV (610).

- the position (ip2) within the FoV (610) corresponding to the position of the virtual object (630) within the screen (620)can correspond to the position of the hand (112) within the FoV (610) that was last identified before being moved out of the FoV (610).

- the wearable device (101)can display the virtual object (630) on the screen (620) based on the position of the hand (112) within the FoV (610) at the timing when the hand (112) is moved out of the FoV (610).

- the wearable device (101)can display a virtual object (630) based on the location (ip2) of the intersection of the path (640) of the hand (112) and the edge of the FoV (610).

- the wearable device (101)may display a virtual object (630) at a location connected to the external space within a state (601) in which the virtual object (630) is displayed based on a virtual space mapped with the external space. As the location of the virtual object (630) is linked to the external space, the wearable device (101) may move the virtual object (630) within the screen (620) similarly to being fixed to a specific location in the external space. Within the state (601), based on identifying a hand (112) having a posture of a pinch gesture, the wearable device (101) may disconnect the connection between the virtual object (630) and the external space.

- the wearable device (101)may display a virtual object (630) moving along a path (642).

- the wearable device (101)can display the virtual object (630) independently of the position of the virtual object (630) with respect to the external space (e.g., the absolute position of the virtual object (630) with respect to the external space).

- the wearable device (101)can display the virtual object (630) based on the position of the virtual object (630) within the screen (620) (e.g., the relative position of the virtual object (630) with respect to the wearable device (101).

- the wearable device (101)can identify a body part (e.g., a hand (112)) moving into the FoV (610) of the camera.

- a body parte.g., a hand (112) moving into the FoV (610) of the camera.

- a user (110)can move a hand (112) having a pinch gesture posture from a location (fp3) outside the FoV (610) into the FoV (610) along a path (650).

- the wearable device (101)can identify the hand (112) based on an image and/or video of the FoV (610).

- the wearable device (101)can identify the virtual object (630) that was connected to the hand (112) before the timing. For example, the wearable device (101) can identify the virtual object (630) that was moved by the hand (112) in the state (601) prior to the state (602).

- the wearable device (101) that has identified a virtual object (630) moved by the hand (112)can display the virtual object (630) based on the location of the hand (112) within the FoV (610). For example, the wearable device (101) can display the virtual object (630) that is moved within the screen (620) based on the path of the hand (112) within the FoV (610). For example, the wearable device (101) that has identified the hand (112) that has moved within the FoV (610) from the location (fp4) along the path (650) can move the virtual object (630) to the location (ip4) within the screen (620) corresponding to the location (fp4).

- the wearable device (101)can move a virtual object (630) moved to a location (ip4) along a path (652) within the screen (620) corresponding to the path (650) based on identifying a path (650) within the FoV (610) of the hand (112). Referring to FIG. 6B, while the hand (112) sequentially passes through locations (fp4, fp5, fp6) on the path (650), the wearable device (101) can move the virtual object (630) along locations (ip4, ip5, ip6) within the screen (620) corresponding to each of the locations (fp4, fp5, fp6).

- the wearable device (101) for a hand (112) once moved out of the FoV (610)has been described, but the present disclosure is not limited thereto.

- the wearable device (101)may continue to execute a function corresponding to the posture and/or gesture of the hand (112) based on whether the posture and/or gesture of the hand (112) is maintained.

- the wearable device (101)in a state (603) after the state (601) of FIG. 6a, can identify a body part moving into the FoV (610) of the camera.

- the wearable device (101)can identify a hand (112) having a posture different from the posture of the pinch gesture. For example, when a user (110) moves a fully extended hand (112) from a location (fp7) outside the FoV (610) into the FoV (610) along a path (660), the wearable device (101) can execute a different function corresponding to the pinch gesture based on the posture of the hand (112).

- the wearable device (101)can display a virtual object representing the hand (112) at a position (ip8) in the screen (620) corresponding to the position (fp8). While the hand (112) moves from the position (fp8) to the position (fp9) along the path (660), the wearable device (101) can move the virtual object displayed at the position (ip8) to the position (ip9) in the screen (620) corresponding to the position (fp9) along the path (662) corresponding to the path (660).

- the wearable device (101)may not move the virtual object (630) displayed at the location (ip2) within the screen (620) based on the path (660) of the hand (112).

- the wearable device (101)may determine the position of the virtual object (630) as the position (ip2) moved by the hand (112) before being moved out of the FoV (610).

- the present disclosureis not limited thereto, and the wearable device (101) may determine the position of the virtual object (630) as the position of the virtual object (630) before being moved by the hand (112) before being moved out of the FoV (610).

- the wearable device (101)may display the virtual object (630) in conjunction with an external space.

- the wearable device (101)can display a virtual object (630) based on a location in external space corresponding to a location (ip2) in the screen (620).

- the wearable device (101) tracking the hand (112) within the FoV (610)can continuously execute the function that was executed by the tracking of the hand (112) based on the re-entry of the hand (112) into the FoV (610) after the tracking of the hand (112) is stopped as the hand (112) moves out of the FoV (610).

- the wearable device (101) in the form of an HMD wearable on the head of a user (110)is exemplarily described, the present disclosure is not limited thereto.

- an operation of tracking a body part to move a virtual object (630)is described based on an electronic device having a different form factor from the HMD.

- FIGS. 7A, 7B, and 7Care diagrams illustrating exemplary operations of an electronic device (101-1) performed based on movement of a body part.

- the electronic device (101-1) of FIGS. 7A, 7B, and 7Cmay perform the operations of the wearable device (101) described with reference to FIGS. 1A to 6C.

- the operations of the electronic device (101-1) described with reference to FIGS. 7A, 7B, and 7Cmay be related to at least one of the operations of the wearable device of FIG. 3.

- the electronic device (101-1) described with reference to FIGS. 7A, 7B, and 7Cmay include one or more hardwares described with reference to FIG. 2.

- the electronic device (101-1) described with reference to FIGS. 7a, 7b, and 7ccan execute one or more programs described with reference to FIG. 2.

- the electronic device (101-1)can identify a body part, such as a hand (112), using an image and/or video corresponding to the FoV (710).

- the electronic device (101-1)may display a screen (720) including one or more icons on the display (220).

- icons included in the screen (720)are expressed as squares filled with consistent slashes.