WO2021177045A1 - Signal processing device, signal processing method, and range-finding module - Google Patents

Signal processing device, signal processing method, and range-finding moduleDownload PDFInfo

- Publication number

- WO2021177045A1 WO2021177045A1PCT/JP2021/006075JP2021006075WWO2021177045A1WO 2021177045 A1WO2021177045 A1WO 2021177045A1JP 2021006075 WJP2021006075 WJP 2021006075WWO 2021177045 A1WO2021177045 A1WO 2021177045A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- unit

- signal processing

- luminance

- pixel

- model

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Ceased

Links

Images

Classifications

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C3/00—Measuring distances in line of sight; Optical rangefinders

- G01C3/02—Details

- G01C3/06—Use of electric means to obtain final indication

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S17/00—Systems using the reflection or reradiation of electromagnetic waves other than radio waves, e.g. lidar systems

- G01S17/02—Systems using the reflection of electromagnetic waves other than radio waves

- G01S17/06—Systems determining position data of a target

- G01S17/08—Systems determining position data of a target for measuring distance only

- G01S17/32—Systems determining position data of a target for measuring distance only using transmission of continuous waves, whether amplitude-, frequency-, or phase-modulated, or unmodulated

- G01S17/36—Systems determining position data of a target for measuring distance only using transmission of continuous waves, whether amplitude-, frequency-, or phase-modulated, or unmodulated with phase comparison between the received signal and the contemporaneously transmitted signal

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S17/00—Systems using the reflection or reradiation of electromagnetic waves other than radio waves, e.g. lidar systems

- G01S17/88—Lidar systems specially adapted for specific applications

- G01S17/89—Lidar systems specially adapted for specific applications for mapping or imaging

- G01S17/894—3D imaging with simultaneous measurement of time-of-flight at a 2D array of receiver pixels, e.g. time-of-flight cameras or flash lidar

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S7/00—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00

- G01S7/48—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S17/00

- G01S7/497—Means for monitoring or calibrating

Definitions

- the present technologyrelates to a signal processing device, a signal processing method, and a ranging module, and more particularly to a signal processing device, a signal processing method, and a ranging module capable of more appropriately correcting characteristic variations between taps.

- a distance measuring moduleis mounted on a mobile terminal such as a so-called smartphone.

- smartphonesare equipped with a distance measurement module that measures distance by the Indirect ToF (Time of Flight) method.

- IndirectToFTime of Flight

- the irradiation lightis emitted toward the object, the reflected light is reflected on the surface of the object and returned, and the flight from the emission of the irradiation light to the reception of the reflected light is detected. This is a method of calculating the distance to an object based on time.

- the light receiving sensor sidereceives the reflected light at the light receiving timings shifted by 0 °, 90 °, 180 °, and 270 ° based on the irradiation timing of the irradiation light.

- a method of calculating the distance to an object by using four phase images detected in four different phases with respect to the irradiation timing of the irradiation lightis called a 4 Phase method or the like.

- one pixelhas two charge storage portions, a first tap and a second tap, and by alternately distributing the received charge to the first tap and the second tap, the phase is inverted in one phase image. Since two phases can be detected, there is also a method called a 2-phase method in which the distance to an object is calculated using two phase images.

- the 2Phase methodhas the advantage that the distance can be calculated with half the number of phase images of the 4Phase method, but the characteristics of the first tap and the second tap, which are the two charge storage units of each pixel, vary between taps (tap). Since there is a sensitivity difference between taps), it is necessary to correct the characteristic variation between taps.

- Patent Document 1proposes a method of calculating the offset of each tap by pre-measurement to reduce the error of distance calculation.

- the correction formula for correcting the characteristic variation between tapsis a formula for dividing by a value close to 0 when the amplitude of the received light waveform is small, which is sufficient for calculation stability and noise immunity. I could not say.

- This technologywas made in view of such a situation, and makes it possible to more appropriately correct the characteristic variation between taps in a light receiving sensor having two charge storage units in one pixel.

- the signal processing device on the first aspect of the present technologyis based on the pixel data obtained by the pixels that receive the reflected light that is reflected by the object and returned by the irradiation light emitted from the predetermined light emitting source.

- a signal processing unit that performs processing for calculating the distance to the Ithas a characteristic calculation unit that calculates correction parameters that correct the characteristics of the first charge detection unit and the second charge detection unit.

- the signal processing method of the second aspect of the present technologyis based on the pixel data obtained by the pixel that receives the reflected light that is reflected by the object and returned by the irradiation light emitted from the predetermined light emitting source.

- the signal processing devicethat performs the process of calculating the distance to 2 Calculate the correction parameter that corrects the characteristics with the charge detection unit.

- the distance measuring module on the third side of the present technologycomprises a predetermined light emitting source and a distance measuring sensor having pixels that receive the reflected light that is reflected by an object and returned from the irradiation light emitted from the light emitting source.

- the distance measuring sensorincludes a first charge detection unit and a second charge detection unit of the pixel based on a luminance model corresponding to the shape of the emission waveform of the irradiation light and the shape of the exposure waveform of the pixel. It has a characteristic calculation unit that calculates correction parameters for correcting characteristics.

- the first charge detection unit and the second charge detection unit of the pixelare based on the luminance model according to the shape of the emission waveform of the irradiation light and the shape of the exposure waveform of the pixel.

- a correction parameter that corrects the characteristics of andis calculated.

- the signal processing device and the ranging modulemay be independent devices or may be modules incorporated in other devices.

- step S105 of FIG.It is a detailed flowchart of the fixed pattern noise evaluation process executed in step S105 of FIG. It is a perspective view which shows the chip structure example of the distance measuring sensor. It is a block diagram which shows the configuration example of a smartphone as an electronic device equipped with a distance measurement module. It is a block diagram which shows an example of the schematic structure of a vehicle control system. It is explanatory drawing which shows an example of the installation position of the vehicle exterior information detection unit and the image pickup unit.

- FIG. 1is a block diagram showing a schematic configuration example of a distance measuring module to which the present technology is applied.

- the distance measurement module 11 shown in FIG. 1is a distance measurement module that performs distance measurement by the Indirect ToF method, and has a light emitting unit 12 and a distance measurement sensor 13.

- the ranging module 11irradiates an object with light, and the light (irradiation light) receives the light (reflected light) reflected by the object to generate a depth map as distance information to the object. And output.

- the distance measuring sensor 13includes a control unit 14, a light receiving unit 15, and a signal processing unit 16.

- the light emitting unit 12includes, for example, a VCSEL array in which a plurality of VCSELs (Vertical Cavity Surface Emitting Lasers) are arranged in a plane in a plane as a light emitting source, and responds to a light emitting control signal supplied from the control unit 14. It emits light while being modulated at the timing, and irradiates the object with irradiation light.

- VCSELsVertical Cavity Surface Emitting Lasers

- the control unit 14controls the operation of the entire ranging module 11.

- the control unit 14controls the light emitting unit 12 by supplying a light emitting control signal of a predetermined frequency (for example, 200 MHz or the like) to the light emitting unit 12.

- the control unit 14also supplies a light emission control signal to the light receiving unit 15 in order to drive the light receiving unit 15 in accordance with the timing of light emission in the light emitting unit 12.

- the light receiving unit 15receives the reflected light from the object in the pixel array 32 in which a plurality of pixels 31 are two-dimensionally arranged, which will be described in detail later with reference to FIG. Then, the light receiving unit 15 supplies the pixel data composed of the detection signals according to the received amount of the received reflected light to the signal processing unit 16 in units of pixels 31 of the pixel array 32.

- the signal processing unit 16calculates a depth value, which is the distance from the distance measuring module 11 to the object, based on the pixel data supplied from the light receiving unit 15 for each pixel 31 of the pixel array 32, and the pixel value of each pixel 31. Generates a depth map in which the depth value is stored as, and outputs it to the outside of the module.

- FIG. 2is a block diagram showing a detailed configuration example of the light receiving unit 15.

- the light receiving unit 15generates a charge corresponding to the amount of received light, and a pixel array 32 and a pixel array in which pixels 31 that output a detection signal corresponding to the charge are two-dimensionally arranged in a matrix in the row direction and the column direction. It has a drive control circuit 33 arranged in a peripheral region of 32.

- the drive control circuit 33is, for example, a control signal for controlling the drive of the pixel 31 based on a light emission control signal supplied from the control unit 14, (for example, a distribution signal DIMIX, a selection signal ADDRESS DECODE, or a reset, which will be described later). (Signal RST, etc.) is output.

- the pixel 31includes a photodiode 51 as a photoelectric conversion unit that generates an electric charge according to the amount of received light, a first tap 52A (first charge detecting unit) that detects the electric charge generated by the photodiode 51, and a second. It has a tap 52B (second charge detection unit).

- the electric charge generated by one photodiode 51is distributed to the first tap 52A or the second tap 52B.

- the charges distributed to the first tap 52Aare output as a detection signal A from the signal line 53A

- the charges distributed to the second tap 52Bare detected signals B from the signal line 53B. Is output as.

- the first tap 52Ais composed of a transfer transistor 41A, an FD (Floating Diffusion) unit 42A, a selection transistor 43A, and a reset transistor 44A.

- the second tap 52Bis composed of a transfer transistor 41B, an FD unit 42B, a selection transistor 43B, and a reset transistor 44B.

- the reflected lightis received by the photodiode 51 with a delay time ⁇ T. It is assumed that the waveform of the reflected light is the same as the emission waveform of the irradiation light except for the delay of the phase (delay time ⁇ T) according to the distance to the object.

- the distribution signal DIMIX_Acontrols the on / off of the transfer transistor 41A

- the distribution signal DIMIX_Bcontrols the on / off of the transfer transistor 41B.

- the distribution signal DIMIX_A in FIG. 3is a signal having the same phase as the irradiation light

- the distribution signal DIMIX_Bhas a phase in which the distribution signal DIMIX_A is inverted.

- the electric charge generated by the photodiode 51 receiving the reflected lightis transferred to the FD unit 42A according to the distribution signal DIMIX_A while the transfer transistor 41A is on, and is transferred to the transfer transistor according to the distribution signal DIMIX_B. While 41B is on, it is transferred to the FD unit 42B.

- the electric charges transferred via the transfer transistor 41Aare sequentially accumulated in the FD section 42A and transferred via the transfer transistor 41B during a predetermined period in which the irradiation light of the irradiation time T is periodically irradiated.

- the electric chargeis sequentially accumulated in the FD unit 42B.

- the selection transistor 43Ais turned on according to the selection signal ADDRESS DECODE_A after the period for accumulating the electric charge

- the electric charge accumulated in the FD unit 42Ais read out via the signal line 53A and corresponds to the amount of the electric charge.

- the detection signal Ais output from the light receiving unit 15.

- the selection transistor 43Bis turned on according to the selection signal ADDRESS DECODE_B

- the electric charge accumulated in the FD unit 42Bis read out via the signal line 53B, and the detection signal B corresponding to the amount of the electric charge is transmitted from the light receiving unit 15. It is output.

- the electric charge stored in the FD section 42Ais discharged when the reset transistor 44A is turned on according to the reset signal RST_A, and the electric charge stored in the FD section 42B is discharged when the reset transistor 44B is turned on according to the reset signal RST_B. Will be done.

- the pixel 31distributes the electric charge generated by the reflected light received by the photodiode 51 to the first tap 52A or the second tap 52B according to the delay time ⁇ T, and outputs the detection signal A and the detection signal B to the pixels. Output as data.

- the signal processing unit 16calculates the depth value based on the detection signal A and the detection signal B supplied as pixel data from each pixel 31.

- a method for calculating the depth valuethere are a 2Phase method using two types of phase detection signals and a 4Phase method using four types of phase detection signals.

- the light receiving unit 15transmits the reflected light at the light receiving timings shifted by 0 °, 90 °, 180 °, and 270 ° with respect to the irradiation timing of the irradiation light.

- Receive lightExposure

- the light receiving unit 15receives light with the phase set to 0 ° with respect to the irradiation timing of the irradiation light in a certain frame period, and receives light with the phase set to 90 ° in the next frame period. In the frame period, the phase is set to 180 ° to receive light, and in the next frame period, the phase is set to 270 ° to receive light.

- the phase of the light receiving timing that is preset with reference to the irradiation timing of the irradiation lightis referred to as the set phase.

- the set phase of 0 °, 90 °, 180 °, or 270 °represents the set phase of the pixel 31 at the first tap 52A unless otherwise specified. Since the second tap 52B has a phase inverted from that of the first tap 52A, when the first tap 52A has a set phase of 0 °, 90 °, 180 °, or 270 °, the second tap 52B has a phase opposite to that of the first tap 52A, respectively. , 180 °, 270 °, 0 °, or 90 °.

- FIG. 5is a diagram showing the exposure periods of the first tap 52A of the pixel 31 in each set phase of 0 °, 90 °, 180 °, and 270 ° side by side so that the difference in the set phase can be easily understood.

- the reflected lightis received by the light receiving unit 15 in a state in which the phase is delayed from the irradiation timing of the irradiation light by the time ⁇ T corresponding to the distance to the object.

- the phase difference generated according to the distance to the objectis also referred to as a distance phase to distinguish it from the set phase.

- FIG. 5is a diagram illustrating a method of calculating the depth value d by the 2Phase method and the 4Phase method.

- the depth value dcan be obtained by the following equation (1).

- equation (1)c is the speed of light

- ⁇ Tis the delay time

- fis the modulation frequency of light.

- ⁇ in the equation (1)represents the phase shift amount [rad] of the reflected light, that is, the metric phase, and is represented by the following equation (2).

- I of equation (2)Q is set phase 0 °, 90 °, 180 °, and 270 detect signals I A (0) obtained in ° to I A (270) and the detection signal I B (0) through using I B (270), is calculated by the following formula (3).

- I and Qare signals obtained by converting the phase of the sine wave from polar coordinates to a Cartesian coordinate system (IQ plane), assuming that the change in brightness of the irradiation light is a sine wave.

- the depth value d to the objectcan be obtained by using only two set phases that are orthogonal to each other.

- I and Qare given by the following equation (5).

- the characteristic variation between taps existing in each pixelcannot be removed, but the depth value d to the object can be obtained only from the detection signals of the two set phases, which is twice that of the 4Phase method.

- Distance measurementcan be performed at the frame rate.

- the distance to the objectcan be measured accurately and at high speed by adopting the 2Phase method.

- the offset c 0 and the gain c 1are set by the least squares method. There is a way to calculate.

- the value of the equation (8)approaches zero as much as possible when the amplitude of the emission waveform of the irradiation light that controls the irradiation timing is small. It becomes a value. For example, when the amplitude of the emission waveform becomes 1/100, the value of the equation (8) becomes about 1/8000. Therefore, the calculation of the offset c 0 and the gain c 1 becomes unstable when the reflectance is low, the object is far away, or the amount of light emitted is reduced to reduce power consumption.

- the signal processing unit 16 of the distance measuring sensor 13 in FIG. 1more appropriately corrects the characteristic variation between taps and calculates the distance to the object using the 2Phase method.

- FIG. 7is a block diagram showing a first configuration example of the signal processing unit 16 of the distance measuring sensor 13 of FIG.

- the signal processing unit 16 of FIG. 7includes a model determination unit 71, a characteristic calculation unit 72, a signal correction unit 73, and a distance calculation unit 74.

- the luminance waveform detected by each pixel 31 of the light receiving unit 15is a convolution of the emission waveform of the irradiation light output by the light emitting unit 12 and the exposure waveform when each pixel 31 of the light receiving unit 15 exposes (receives light). It becomes a waveform.

- the model determination unit 71assumes (predicts) the shape of the emission waveform of the irradiation light output by the light emitting unit 12 and the shape of the exposure waveform when each pixel 31 of the light receiving unit 15 exposes (receives light). Then, a model (luminance model) of the brightness waveform observed by the light receiving unit 15 is determined.

- FIG. 8shows an example of a luminance model determined by the model determination unit 71.

- the model determination unit 71assumes a square wave as the shape of the emission waveform of the irradiation light and assumes a square wave as the shape of the exposure waveform as the first luminance model (model 1). Then, it is assumed that the luminance waveform observed by the light receiving unit 15 is a triangular wave.

- the model determination unit 71assumes a sine wave as the shape of the emission waveform of the irradiation light as the second luminance model (model 2), assumes a square wave as the shape of the exposure waveform, and observes with the light receiving unit 15. It is assumed that the luminance waveform to be generated is a sine wave.

- the luminance waveform observed by the light receiving unit 15is a harmonic as the third luminance model (model 3). Is assumed to be.

- the model determination unit 71determines a luminance model, which is a model of the luminance waveform observed by the light receiving unit 15, from among a plurality of luminance models as shown in FIG. 3, and supplies the luminance model to the characteristic calculation unit 72. If the emission waveform is known by the initial setting by the user, the brightness model may be determined based on the set value.

- the characteristic calculation unit 72has offset c 0 and gain, which are correction parameters for correcting characteristic variations between taps of each pixel 31 based on a luminance waveform (luminance model) corresponding to the shape of the emission waveform and the shape of the exposure waveform. Calculate c 1. The calculated offset c 0 and gain c 1 are supplied to the signal correction unit 73.

- the characteristic calculation unit 72calculates the offset c 0 and the gain c 1 which are the correction parameters, assuming that the luminance waveform is a triangular wave. do.

- the model determination unit 71determines the second model as the luminance model

- the characteristic calculation unit 72assumes that the luminance waveform is a sine wave, and sets the offset c 0 and the gain c 1 which are correction parameters. calculate.

- the characteristic calculation unit 72assumes that the luminance waveform is a harmonic and sets the offset c 0 and the gain c 1 which are correction parameters. calculate.

- the detailed calculation method of the correction parameter when the luminance waveform is assumed to be a triangular wave, a sine wave, or a harmonic wavewill be described later.

- Signal correcting unit 73uses the offset c 0 and a gain c 1 calculated by the characteristic calculating section 72, the detection signal I B of the detection signals I A ( ⁇ ) or the second tap 52B of the first tap 52A (theta) Correct one of the signals.

- the signal correcting unit 73in accordance with the above equation (6), by correcting the detection signal I B of the second tap 52B of the phase setting 0 ° (0), detection of the first tap 52A of the phase setting 180 °

- the detection signal IA (0) of the first tap 52A having the set phase 270 ° 180

- the detection signal I ( ⁇ ) converted using the correction parameteris represented by adding “” ”like the detection signal I” ( ⁇ ).

- I "A (180)c 0 + c 1 ⁇ I B (0)

- I "A (270)c 0 + c 1 ⁇ I B (90)

- the distance calculation unit 74is the distance to the object by the 2 Phase method based on the phase images of the two set phases having an orthogonal relationship, specifically, the corrected pixel data supplied from the signal correction unit 73. Calculate the depth value. Then, the distance calculation unit 74 generates a depth map in which the depth value is stored as the pixel value of each pixel 31 and outputs the depth map to the outside of the module.

- the light receiving unit 15 of the distance measuring sensor 13may sequentially change the set phase to 0 °, 90 °, 180 °, and 270 ° to receive light, and for example, only the set phases of 0 ° and 90 °.

- the light receptionmay be performed so that the above steps are alternately repeated.

- the signal processing unit 16can generate and output a depth map using two adjacent (two set phases) phase images.

- the characteristic calculation unit 72is supplied with four phase images obtained by sequentially setting the set phase ⁇ to 0 °, 90 °, 180 °, and 270 ° from the light receiving unit 15 (FIG. 1). Since the detection signal I A ( ⁇ ) and I B of the reflected light received by the set phase theta in the first tap 52A and the second tap 52B of the pixels 31 of the pixel array 32 (theta) correspond to the function representing the luminance waveform , the detection signal I a ( ⁇ ) and I B the (theta), also referred to as the intensity function I a ( ⁇ ) and I B (theta).

- Characteristic calculation unit 720 ° setting phase, 90 °, 180 °, and, 270 ° of 4 luminance function I A of the first tap 52A of each pixel 31 is detected by the light receiving portion 15 are sequentially set to the phase (0), I a (90 ), and I a (180), and I a (270), the intensity function I B of the second tap 52B (0), I B ( 90), I B (180), and based on the I B (270), calculates the offset c 0 and the gain c 1 is a correction parameter for correcting the variation in characteristics between taps.

- the intensity function I A detected by the first tap 52A(theta), such as shown in FIG. 9, the central center A, the amplitude # 038 A, by the offset offset A follow the specified triangular wave.

- the intensity function I B detected by the second tap 52B(theta), such as shown in FIG. 9, the central center B, the amplitude # 038 B, according to the triangular wave is defined by an offset offset B.

- the offset c 0 and the gain c 1can be calculated by the following equations (9) and (10).

- the amplitude # 038 A of the triangular wave of the luminance function I A detected by the first tap 52A (theta), and the amplitude # 038 B of the triangular wave of the luminance function I B detected by the second tap 52B (theta)is For example, as described in the literature “M. Schmidt.” Spatiotemporal Analysis of Range Imagery “. Dissertation, Department of Physics and Astronomy, University of Heidelberg, 2008.", the following equations (11) and (12) ) Can be calculated.

- the center of the triangular wavecan be obtained by Eq. (18).

- offset Acenter A -amp A ⁇ (21)

- offset Bcenter B -amp B ⁇ (22)

- Characteristic calculating unit 72assuming a triangular wave as a brightness model, the amplitude # 038 A of the triangular wave of the detected intensity function I A first tap 52A (theta), and the intensity function I detected by the second tap 52B

- the amplitude amp B of the triangular wave of B ( ⁇ )is calculated by the above equations (11) and (12), and the offset offset A and the offset offset B are calculated by the above equations (21) and (22). calculate.

- the characteristic calculation unit 72calculates the offset c 0 and the gain c 1 by the above equations (9) and (10).

- FIG. 10shows a conceptual diagram of correction processing performed by the signal correction unit 73 when the luminance model is assumed to be a triangular wave of the first model.

- Signal correction unit 73by correcting using the offset c 0 and the gain c 1 a detection signal I B (0) of the second tap 52B of the phase setting 0 °, the detection of the first tap 52A of the phase setting 180 ° The signal I " A (180) is generated. Further, the signal correction unit 73 corrects the detection signal I B (90) of the second tap 52B having the set phase of 90 ° by using the offset c 0 and the gain c 1. Therefore, the detection signal I "A (270) of the first tap 52A having the set phase of 270 ° is generated.

- the four-phase detection signals I ( ⁇ )are aligned, so the depth value can be calculated using equations (1), (2), and (4).

- the arithmetic expressions for obtaining the amplitude amp A and the amplitude amp Bare different from the above-mentioned equations (11) and (12) for the triangular wave.

- the amplitude amp A and the amplitude amp B when the luminance model is a sine waveare calculated by the following equations (23) and (24).

- Characteristic calculating unit 72assuming a sin wave as a brightness model, the amplitude # 038 A of sin wave of the detected intensity function I A first tap 52A (theta), and the luminance detected by the second tap 52B the amplitude # 038 B of sin wave function I B (theta), is calculated by the above equation (23) and (24).

- the characteristic calculating section 72calculates the offset c 0 and the gain c 1 by the above equations (9) and (10).

- FIG. 12shows a conceptual diagram of correction processing performed by the signal correction unit 73 when the luminance model is assumed to be a sine wave of the second model.

- the actual emission waveformmay be distorted from the rectangle depending on the time constant of the emission circuit, the modulation frequency of the emission waveform and the exposure waveform, and the like. In that case, it may be closer to the actual luminance model to assume the luminance model as a sine wave instead of assuming it as a triangular wave, and calculate the offset c 0 and gain c 1 by assuming the luminance model as a sine wave. In some cases, the calculation result of the distance is better.

- the characteristic calculation unit 72calculates the correction parameter using machine learning.

- the ranging module 11acquires four phase images with the set phases set to 0 °, 90 °, 180 °, and 270 ° in various scenes (measurement targets).

- the four phase images of the acquired various scenesare accumulated in the characteristic calculation unit 72.

- the characteristic calculation unit 72has a neural network learner having the same configuration for each of the first tap 52A and the second tap 52B.

- FIG. 13is a diagram illustrating a learning process for learning the luminance model of the harmonics detected by the first tap 52A.

- Equation (25)the luminance function I 'A (theta) on the assumption that higher harmonics, centered c A 0 harmonics, and cos function from primary to M order, from the primary to M order It is represented by the sin function.

- the order MM is a natural number

- the input v A in of the learner 81Ais the first tap 52 A of the predetermined pixel 31 in the four phase images of the accumulated predetermined scenes of set phases 0 °, 90 °, 180 °, and 270 °.

- the luminance function I A '( ⁇ ) assumed to be the harmonicis restored.

- harmonic intensity function I 'A ( ⁇ )is representative good intensity function I A (theta)

- itsets the phase 0 °, 90 °, 180 °

- the luminance as input learning device 81Ais the value of the function I a ( ⁇ ), the brightness value I a (0), I a (90), I a (180), and I a (270) ⁇ and should be the same.

- characteristic calculation unit 72performs learning such that the difference between the value of the intensity function I 'A ( ⁇ ) of the input v A in the output v A out of the learning device 81A is reduced.

- W A 'of formula (27)represents the weighting coefficients after updating, the eta A is a coefficient representing the learning rate.

- More weighting factor W update of Athe luminance value I A of the first tap 52A of the same pixel in the four phase images of the stored various scenes (0), I A (90 ), I A (180) , and by repeating a predetermined number of times by using the I a (270), the intensity function I 'a harmonics of the formula (25) ( ⁇ ) is obtained.

- the characteristic calculation unit 72performs the same learning for the second tap 52B.

- Equation (28)the luminance function I 'B (theta) on the assumption that higher harmonics, centered c B 0 harmonic, and cos function from primary to M order, from the primary to M order It is represented by the sin function.

- the order MM is a natural number

- the luminance value of the second tap 52B of predetermined pixels 31 I B (0), I B (90), I B (180), and I inputs B (270). That is, the input v B in⁇ I B ( 0), I B (90), I B (180), and I B (270) ⁇ is.

- the characteristic calculating section 72performs learning such that the difference between the intensity function I 'B ( ⁇ ) of the input v B in the output v B out of the learning device 81B decreases.

- W B 'is of formula (30)represents the weighting coefficients after updating, eta B is a coefficient representing the learning rate.

- the intensity function I 'A ( ⁇ ) and the intensity function I' B to be restoredsince the center of the amplitude is considered to differ with the characteristics of the same light emission waveform as exposure waveform, the intensity function I '( It is considered that the shape of the function obtained by whitening ⁇ ) is the same. Therefore, as a constraint condition when updating the weighting coefficient W of each node of the learner 81, the first evaluation functions L A 1 and L B 1 described above are subjected to the second evaluation represented by the following equation (31). A function L 2 may be added to obtain a weighting coefficient W such that the second evaluation function L 2 is also small. The update of the weighting coefficient W is represented by the equation (32).

- FIG. 14shows a conceptual diagram of an operation for obtaining the second evaluation function L 2.

- intensity function I of the detected reflected light at the second tap 52B' luminance function I of the reflected light detected by the first tap 52A B ( ⁇ )is estimated.

- characteristic calculation unit 72uses 'and A (theta), intensity function I of the second tap 52B' luminance function I of the first tap 52A estimated and B (theta), the following equation (33)

- the gain c 1is calculated by the formula (34)

- the offset c 0is calculated by the equation (34).

- the characteristic calculation unit 72can calculate the correction parameters using machine learning as described above.

- the method of calculating harmonics when the luminance model is assumed as harmonicsis not limited to machine learning, and other methods may be used. For example, a method as disclosed in the document "Marvin Lindner and Andreas Kolb,” Lateral and Depth Calibration of PMD-Distance Sensors, International Symposium on Visual Computing ", 2006.” may be adopted. The technique disclosed in this document captures multiple known depths and obtains a harmonic component from the difference between the known depth and the actually measured depth, providing a look-up table for depth correction. The method of generation is disclosed.

- the correction parameterscan be calculated more accurately than with a simple model.

- step S1the control unit 14 of the distance measuring sensor 13 determines whether to estimate the correction parameter for correcting the characteristic variation between the taps of each pixel 31 of the pixel array 32 of the light receiving unit 15.

- the correction parametersare estimated. Further, for example, in the first measurement in which the distance measuring module 11 is activated, the correction parameter can be estimated without fail, or the correction parameter can be estimated every predetermined number of measurements.

- step S1If it is determined in step S1 that the correction parameters are to be estimated, the process proceeds to step S2, and the distance measuring module 11 estimates the correction parameters for estimating the offset c 0 and the gain c 1 which are the correction parameters of each pixel 31. Execute the process.

- step S1determines whether the correction parameter is not estimated. If it is determined in step S1 that the correction parameter is not estimated, the correction parameter estimation process in step S2 is skipped, and the process proceeds to step S3. When the correction parameter is not estimated, the correction parameter has already been set.

- step S3the distance measuring module 11 executes a distance measurement process for measuring the distance to the object by the 2 Phase method using the correction parameter for correcting the characteristic variation between the taps of each pixel 31, and ends the process.

- FIG. 16is a detailed flowchart of the correction parameter estimation process executed in step S2 of the measurement process of FIG.

- step S11the control unit 14 sets the phase difference (set phase) between the light emitting waveform and the exposure waveform to 0 °, and supplies the light emitting control signal to the light emitting unit 12 and the light receiving unit 15.

- step S12the ranging module 11 emits the irradiation light and receives the reflected light reflected and returned by the object. That is, the light emitting unit 12 emits light while modulating at a timing corresponding to the light emission control signal supplied from the control unit 14, and irradiates the object with the irradiation light.

- the light receiving unit 15receives the reflected light from the object.

- the light receiving unit 15supplies pixel data composed of detection signals according to the amount of received reflected light to the signal processing unit 16 in units of pixels 31 of the pixel array 32.

- step S13the control unit 14 determines whether or not four phase images having the set phases of 0 °, 90 °, 180 °, and 270 ° have been acquired.

- step S13If it is determined in step S13 that the acquisition of the four phase images has not yet been performed, the process proceeds to step S14, and the control unit 14 updates the set phase to a value incremented by 90 ° from the current value. .. After step S14, the process returns to step S12, and steps S12 and S13 described above are repeated.

- step S13when it is determined in step S13 that four phase images have been acquired, the process proceeds to step S15, and the characteristic calculation unit 72 of the signal processing unit 16 changes the shape of the emission waveform and the shape of the exposure waveform. Based on the corresponding luminance waveform, the offset c 0 and the gain c 1 which are the correction parameters for correcting the characteristic variation between the taps of each pixel 31 are calculated.

- the luminance modelis determined before the process of step S15, and is supplied from the model determination unit 71 to the characteristic calculation unit 72.

- step S15the offset c 0 and the gain c 1 are described above for each of the cases where a triangular wave is assumed as the luminance model, a sine wave is assumed as the luminance model, and a harmonic is assumed as the luminance model. It is calculated by the calculation method.

- the calculated offset c 0 and gain c 1are supplied to the signal correction unit 73, the correction parameter estimation process of FIG. 16 is completed, and the process returns to the measurement process of FIG.

- the correction parameters(offset c 0 and gain c 1 ) were calculated using only four phase images capable of generating one depth map, but the influence of noise is reduced. Therefore, even if eight or more phase images corresponding to a plurality of depth maps are used and the summation average of the plurality of correction parameters obtained as a result is used to calculate the final correction parameter. good.

- FIG. 17is a detailed flowchart of the distance measurement process by the 2 Phase method executed in step S3 of the measurement process of FIG.

- step S31the control unit 14 sets the phase difference (set phase) between the light emitting waveform and the exposure waveform to 0 °, and supplies the light emitting control signal to the light emitting unit 12 and the light receiving unit 15.

- step S32the ranging module 11 emits the irradiation light and receives the reflected light reflected and returned by the object. That is, the light emitting unit 12 emits light while modulating at a timing corresponding to the light emission control signal supplied from the control unit 14, and irradiates the object with the irradiation light.

- the light receiving unit 15receives the reflected light from the object.

- the light receiving unit 15supplies pixel data composed of detection signals according to the amount of received reflected light to the signal processing unit 16 in units of pixels 31 of the pixel array 32.

- step S33the control unit 14 determines whether or not two phase images having the set phases of 0 ° and 90 ° have been acquired.

- step S33If it is determined in step S33 that the acquisition of the two phase images has not yet been performed, the process proceeds to step S34, and the control unit 14 sets the phase difference (set phase) between the emission waveform and the exposure waveform to 90 °. Set. After step S34, the process returns to step S32, and steps S32 and S33 described above are repeated.

- step S33if it is determined in step S33 that the two phase images have been acquired, the process proceeds to step S35, and the signal correction unit 73 of the signal processing unit 16 has the offset c 0 calculated by the characteristic calculation unit 72. and using the gain c 1, in accordance with the equation (6), to correct the detection signals I B of the second tap 52B (theta).

- the signal correcting unit 73uses the detection signal I B of the second tap 52B of the pixels 31 acquired in set phases 0 ° and 90 ° (0) and I B (90), the following Calculate the corrected I " A (180) and I" A (270).

- I "A (180)c 0 + c 1 ⁇ I B (0)

- I "A (270)c 0 + c 1 ⁇ I B (90)

- step S36the distance calculation unit 74 uses the two phase images of the corrected set phases of 0 ° and 90 ° supplied from the signal correction unit 73 to reach the object for each pixel 31 of the pixel array 32.

- the depth valuewhich is the distance between, is calculated by the 2 Phase method. Then, the distance calculation unit 74 generates a depth map in which the depth value is stored as the pixel value of each pixel 31 and outputs the depth map to the outside of the module.

- step S15 of FIG. 16which is the process of calculating the offset c 0 and the gain c 1 using machine learning when harmonics are assumed as the luminance model. Will be described in more detail with reference to the flowchart of FIG.

- step S51characteristic calculation unit 72 sets a predetermined initial value the weight coefficient W A learner 81A corresponding to the first tap 52A.

- step S52the characteristic calculation unit 72 within four phase images of the set phases 0 °, 90 °, 180 °, and 270 ° of a predetermined one scene among the accumulated phase images of the plurality of scenes.

- the luminance value I a of the first tap 52A of predetermined pixels 31 (0), I a ( 90), I a (180), and extracts the I a (270), the input v a in the learning device 81A⁇ I a (0), I a (90), I a (180), and I a (270) ⁇ and.

- the luminance function I A '( ⁇ )assumed to be a harmonic.

- the weighting coefficients after updating W A 'is calculated.

- step S56the characteristic calculating section 72 determines whether performed predetermined number of times to update the weight coefficient W A.

- step S56when it is determined that not yet updated weight coefficient W A prescribed number, processing returns to step S52, characteristic calculation unit 72, among the accumulated plural scenes phase images, still Four phase images of set phases 0 °, 90 °, 180 °, and 270 ° of a predetermined unselected scene are acquired, and the above-described processes of steps S52 to S56 are repeated.

- step S56when it is determined that made the update of the weight coefficient W A prescribed number, the process proceeds to step S57.

- the processes of steps S51 to S56are also executed for the learner 81B that learns the luminance model of the harmonics detected by the second tap 52B, in the same manner as the process of the learner 81A.

- step S57the characteristic calculating section 72 uses 'and A (theta), intensity function I of the second tap 52B' luminance function I of the first tap 52A which is calculated and B (theta), the above Expression ( The offset c 0 is calculated by 34), and the gain c 1 is calculated by the above equation (33).

- the correction parameter for correcting the characteristic variation between the taps of each pixel 31is set based on the determined luminance model (luminance waveform). By calculating, it is possible to more appropriately correct the characteristic variation between taps.

- FIG. 19is a block diagram showing a second configuration example of the signal processing unit 16 of the distance measuring sensor 13 of FIG.

- FIG. 19the parts corresponding to the first configuration example shown in FIG. 7 are designated by the same reference numerals, and the description of the parts will be omitted as appropriate.

- the signal processing unit 16 of FIG. 19includes a model determination unit 71, a characteristic calculation unit 72, a signal correction unit 73, a distance calculation unit 74, and an optimum model selection unit 91.

- the optimum model selection unit 91is further added to the first configuration example of the signal processing unit 16 shown in FIG. 7.

- the model determination unit 71determines a predetermined one from a plurality of selectable luminance models, and the characteristic calculation unit 72 is supplied from the model determination unit 71.

- the correction parametersoffset c 0 and gain c 1 ) were calculated based on one luminance model (luminance waveform).

- the model determination unit 71supplies all the stored luminance models to the characteristic calculation unit 72, and the characteristic calculation unit 72 supplies all the luminance models (luminance).

- the correction parametersoffset c 0 and gain c 1

- N brightness modelsare stored in the model determination unit 71, and the offset c 0 and the gain c 1 calculated for each of the N brightness models are set to (c 0 1 , c 1 1 ), (c). 0 2 , c 1 2 ), ..., (c 0 N , c 1 N ).

- the characteristic calculation unit 72supplies the offset c 0 and the gain c 1 calculated for each of the N luminance models to the optimum model selection unit 91.

- the optimum model selection unit 91sets the offset and gain of each of the N luminance models (c 0 1 , c 1 1 ), (c 0 2 , c 1 2 ), ..., (C 0 N , c 1).

- the phase shift amount ⁇ ref of each pixel 31is calculated by the 4 Phase method. That is, the phase shift amount ⁇ ref of each pixel 31 is calculated by the above-mentioned equations (3) and (2).

- the optimum model selection unit 91sets the offset and gain (c 0 1 , c 1 1 ), (c 0 2 , c 1 2 ), ..., (C 0 N , c 1 N ), respectively. using equation (6), to produce "and a (180), the detection signal I of the first tap 52A configuration phase 270 °" detection signal I of the first tap 52A configuration phase 180 ° of the a (180).

- I "A (180)c 0 + c 1 ⁇ I B (0)

- I "A (270)c 0 + c 1 ⁇ I B (90)

- the optimum model selection unit 91uses the 2Phase method, that is, the phase shift amounts ⁇ (c 0 1 , c 1 1 ) and ⁇ (c 0 2) of each pixel 31 according to the above equations (4) and (2). , C 1 2 ), ⁇ , ⁇ (c 0 N , c 1 N ) is calculated.

- the optimum model selection unit 91has a phase shift amount ⁇ ref , a phase shift amount ⁇ (c 0 1 , c 1 1 ), ⁇ (c 0 2 , c 1 2 ), ..., ⁇ (c 0 N). , C 1 N ) to select the optimum offset and gain pair (c 0 opt , c 1 opt). That is, the optimum model selection unit 91 calculates the following equation (35).

- MSE [] in Eq. (35)is a function that calculates the mean square error in [].

- argminis a function that finds the minimum MSE [] (c 0 n , c 1 n). Therefore, in equation (35), (c 0 opt , c 1 opt ) is set to minimize the mean square error of ⁇ ref ⁇ (c 0 n , c 1 n ) ⁇ (c 0 n , c 1 n). Indicates that the decision is made.

- the function for evaluating the erroris not limited to the mean square error, and other functions may be used.

- the optimum model selection unit 91supplies the selected offset c 0 opt and gain c 1 opt to the signal correction unit 73.

- the processing of the signal correction unit 73 and the distance calculation unit 74is the same as that of the first configuration example.

- FIG. 20is a flowchart of the measurement process of the distance measuring module 11 of FIG. 1 when the second configuration example of the signal processing unit 16 is adopted. This process is started, for example, when the control unit of the host device in which the distance measuring module 11 is incorporated instructs the start of measurement.

- step S71the control unit 14 of the distance measuring sensor 13 determines whether to estimate the correction parameter for correcting the characteristic variation between the taps of each pixel 31 of the pixel array 32 of the light receiving unit 15.

- the process of step S71is the same as step S1 of the measurement process in the first configuration example described in the flowchart of FIG.

- step S71If it is determined in step S71 that the correction parameters are to be estimated, the process proceeds to step S2, and the ranging module 11 executes the correction parameter estimation process for estimating the correction parameters for all the luminance models.

- step S2in the first configuration example, the correction parameter of one predetermined luminance model determined by the model determination unit 71 is estimated, whereas in the process of step S72 of the second configuration example, the process is The difference is that the model determination unit 71 estimates the correction parameters of all the luminance models stored.

- the characteristic calculation unit 72supplies the offset c 0 and the gain c 1 calculated for each of the N luminance models to the optimum model selection unit 91.

- step S72the process proceeds to step S73, and the optimum model selection unit 91 selects the optimum luminance model from the N luminance models. That is, by calculating equation (35), the optimum offset c 0 opt and gain c 1 opt are selected from the correction parameters (offset c 0 n and gain c 1 n) of each of the N luminance models. NS.

- step S71determines whether the correction parameter is not estimated. If it is determined in step S71 that the correction parameter is not estimated, the processes of steps S72 and S73 are skipped, and the process proceeds to step S74.

- step S74the distance measuring module 11 executes a distance measurement process for measuring the distance to the object by the 2 Phase method using the correction parameter for correcting the characteristic variation between the taps of each pixel 31, and ends the process.

- the optimum luminance modelis selected from various luminance models (luminance waveforms), and between the taps of each pixel 31.

- the correction parameter for correcting the characteristic variationBy calculating the correction parameter for correcting the characteristic variation, the characteristic variation between taps can be corrected more appropriately.

- FIG. 21is a block diagram showing a third configuration example of the signal processing unit 16 of the distance measuring sensor 13 of FIG.

- FIG. 21the parts corresponding to the second configuration example shown in FIG. 19 are designated by the same reference numerals, and the description of the parts will be omitted as appropriate.

- the signal processing unit 16 of FIG. 21includes a model determination unit 71, a characteristic calculation unit 72, a signal correction unit 73, a distance calculation unit 74, an optimum model selection unit 91, and an evaluation unit 101.

- the evaluation unit 101is further added to the second configuration example of the signal processing unit 16 shown in FIG.

- the depth map calculated by the distance calculation unit 74is supplied to the evaluation unit 101.

- the evaluation unit 101evaluates whether or not the correction parameter currently used is appropriate by using two depth maps that are continuous in the time direction. If the correction parameter is not a value obtained by appropriately correcting the characteristic variation between taps of the pixel 31, the characteristic variation appears in the depth map as fixed pattern noise. The evaluation unit 101 determines whether or not fixed pattern noise appears in the depth map.

- the evaluation unit 101determines that fixed pattern noise appears in the depth map, the evaluation unit 101 instructs the model determination unit 71 to recalculate the correction parameters.

- the model determination unit 71supplies all the stored luminance models to the characteristic calculation unit 72.

- the fixed pattern noise evaluation process performed by the evaluation unit 101will be described with reference to FIG. 22.

- the depth map D t-1 at time t-1 and the depth map D t at time tare input to the evaluation unit 101.

- Evaluation unit 101initially, each time two consecutive in the direction depth map D t-1 and D t, to apply the spatial filter f for smoothing the image, the filtered depth map D 't Generate -1 and'D t.

- the depth map D 't-1 and D' t after filteringreferred to as a post-processing the depth map D 't-1 and D' t.

- D' t-1f (D t-1 )

- D' tf (D t )

- the spatial filter ffor example, an edge preservation type filter such as a Gaussian filter or a bilateral filter can be adopted.

- an edge preservation type filtersuch as a Gaussian filter or a bilateral filter.

- the evaluation unit 101, the area position of the small region g t-1 and g t obtained by setting the area size in advance, respectively,are sequentially slid in the post-processing the depth map D 't-1 and D' t, the small the dispersion of the depth value d that is detected at each pixel in the region g, both the smallest small region g t of the difference between the depth value d between two of the processed depth map, used in the evaluation of the fixed pattern noise as the representative small area gs' t.

- This processcan be expressed as follows.

- V ()represents the operator for the variance.

- the evaluation unit 101the representative small area gs' t subregions gs in the same area position, extracted from each of two depth map D t-1 and D t, the small region gs t-1 and gs t And.

- the evaluation unit 101calculates the following equation (37) using the small regions gs t-1 and gs t extracted from the two depth maps D t-1 and D t, respectively, and calculates the small region gs t-1. It is determined whether or not the sum of the difference between gs t and the variance of the small region gs t is larger than the predetermined threshold value Th.

- the evaluation unit 101determines that the correction parameter is not the value obtained by appropriately correcting the characteristic variation between taps.

- FIG. 23is a flowchart of the measurement process of the distance measuring module 11 of FIG. 1 when the third configuration example of the signal processing unit 16 is adopted. This process is started, for example, when the control unit of the host device in which the distance measuring module 11 is incorporated instructs the start of measurement.

- steps S101 to S104 of FIG. 23are the same as the processes of steps S71 to S74 described with reference to FIG. 20, the description thereof will be omitted.

- the depth map calculated in step S104is also supplied to the evaluation unit 101, and the evaluation unit 101 stores two depth maps D t-1 and D t that are continuous in the time direction.

- step S105the evaluation unit 101 executes a fixed pattern noise evaluation process for evaluating whether or not the correction parameter currently used is appropriate, using two depth maps that are continuous in the time direction. Details of the fixed pattern noise evaluation process in step S105 will be described later with reference to the flowchart of FIG. 24.

- step S106the evaluation unit 101 uses the result of the fixed pattern noise evaluation process to determine whether fixed pattern noise is generated in the depth maps D t-1 and D t. Specifically, the evaluation unit 101 determines whether or not the conditional expression of the equation (37) is satisfied.

- step S106If the conditional expression of the equation (37) is satisfied in step S106 and it is determined that the fixed pattern noise is generated, the process proceeds to step S107, and the evaluation unit 101 informs the model determination unit 71 of the correction parameter. Instruct the calculation.

- the model determination unit 71supplies all the stored luminance models to the characteristic calculation unit 72.

- the characteristic calculation unit 72executes a correction parameter estimation process for estimating correction parameters for all luminance models.

- the process of step S107 after the recalculation of the correction parameter is instructedis the same as that of step S102 and step S72 of FIG.

- step S108the optimum model selection unit 91 selects the optimum brightness model from the N brightness models.

- the process of step S108is the same as that of step S103 and step S73 of FIG.

- step S106determines whether fixed pattern noise has not occurred. If it is determined in step S106 that fixed pattern noise has not occurred, the processes of steps S107 and S108 are skipped, and the measurement process ends.

- FIG. 24is a detailed flowchart of the fixed pattern noise evaluation process executed in step S105 of FIG. 23.

- step S121the evaluation unit 101 applies a spatial filter f for smoothing an image to each of the two continuous depth maps D t-1 and D t in the time direction, and the processed depth map D. ' t-1 and D' t are generated.

- step S122the evaluation unit 101, the processing after the depth map D within 't-1 and D' t, respectively, is slid by setting small regions g t-1 and g t, a representative small region gs' t Set.

- Small representative subregion gs' thas the formula represented by (36), and the variance of depth value d in the small region g, the smallest both the difference between the depth value d between the two processed depth map It is an area g t.

- step S123the evaluation unit 101, the representative small area gs' t subregions gs in the same area position, extracted from each of two depth map D t-1 and D t, the small region gs t-1 and gs Let t .

- step S124the evaluation unit 101 uses the small regions gs t-1 and gs t extracted from the two depth maps D t-1 and D t, respectively, to use the left side of the equation (37), that is, the small region gs.

- the sum of the difference between t-1 and gs t and the variance of the small region gs tis calculated.

- step S124the process proceeds to step S106 of FIG. 23, and it is determined whether or not the conditional expression of the equation (37) is satisfied.

- the signal processing unit 16may be configured by any of the above-mentioned first configuration example to third configuration example, or may be configured so that the first configuration example to the third configuration example can be selectively executed.

- stable estimation of offset c 0 and gain c 1can be expected even when the signal-to-noise ratio of the signal is not sufficiently high at the timing of correcting the characteristic variation between taps.

- FIG. 25is a perspective view showing a chip configuration example of the distance measuring sensor 13.

- the distance measuring sensor 13can be composed of one chip in which a sensor die 151 as a plurality of dies (boards) and a logic die 152 are laminated.

- the sensor die 151is configured with a sensor unit 161 (as a circuit), and the logic die 152 is configured with a logic unit 162.

- a light receiving unit 15is formed in the sensor unit 161.

- the logic unit 162is formed with, for example, a control unit 14, a signal processing unit 16, input / output terminals, and the like.

- the distance measuring sensor 13may be composed of three layers in which another logic die is laminated in addition to the sensor die 151 and the logic die 152. Of course, it may be composed of a stack of four or more dies (boards).

- the ranging sensor 13is composed of, for example, as shown in FIG. 25B, a first chip 171 and a second chip 172, and a relay board (interposer board) 173 on which they are mounted. You may.

- a light receiving portion 15is formed on the first chip 171.

- a control unit 14, a signal processing unit 16, and the likeare formed on the second chip 172.

- the circuit arrangement of the sensor die 151 and the logic die 152 in A of FIG. 25 and the circuit arrangement of the first chip 171 and the second chip 172 in B of FIG. 25are merely examples. Not limited to.

- a signal processing unit 16 that performs depth map generation processing and the likemay be provided outside (separate chip) of the distance measuring sensor 13 as a signal processing device.

- the distance measuring module 11 described abovecan be mounted on an electronic device such as a smartphone, a tablet terminal, a mobile phone, a personal computer, a game machine, a television receiver, a wearable terminal, a digital still camera, or a digital video camera.

- an electronic devicesuch as a smartphone, a tablet terminal, a mobile phone, a personal computer, a game machine, a television receiver, a wearable terminal, a digital still camera, or a digital video camera.

- FIG. 26is a block diagram showing a configuration example of a smartphone as an electronic device equipped with a ranging module.

- the distance measuring module 202, the image pickup device 203, the display 204, the speaker 205, the microphone 206, the communication module 207, the sensor unit 208, the touch panel 209, and the control unit 210are connected via the bus 211. Is connected and configured. Further, the control unit 210 has functions as an application processing unit 221 and an operating system processing unit 222 by executing a program by the CPU.

- the distance measuring module 11 of FIG. 1is applied to the distance measuring module 202.

- the distance measuring module 202is arranged in front of the smartphone 201, and by performing distance measurement for the user of the smartphone 201, the depth value of the surface shape of the user's face, hand, finger, etc. is measured as a distance measurement result. Can be output as. It is also possible to recognize the user's gesture by using the distance measurement result by the distance measurement module 202.

- the image pickup device 203is arranged in front of the smartphone 201, and by taking an image of the user of the smartphone 201 as a subject, the image taken by the user is acquired. Although not shown, the image pickup device 203 may be arranged on the back surface of the smartphone 201.

- the display 204displays an operation screen for performing processing by the application processing unit 221 and the operation system processing unit 222, an image captured by the image pickup device 203, and the like.

- the speaker 205 and the microphone 206for example, output the voice of the other party and collect the voice of the user when making a call by the smartphone 201.

- the communication module 207communicates via the communication network.

- the sensor unit 208senses speed, acceleration, proximity, etc., and the touch panel 209 acquires a touch operation by the user on the operation screen displayed on the display 204.

- the application processing unit 221performs processing for providing various services by the smartphone 201.

- the application processing unit 221can create a face by computer graphics that virtually reproduces the user's facial expression based on the depth supplied from the distance measuring module 202, and can perform a process of displaying the face on the display 204.

- the application processing unit 221can perform a process of creating, for example, three-dimensional shape data of an arbitrary three-dimensional object based on the depth supplied from the distance measuring module 202.

- the operation system processing unit 222performs processing for realizing the basic functions and operations of the smartphone 201.

- the operation system processing unit 222can perform a process of authenticating the user's face and unlocking the smartphone 201 based on the depth value supplied from the distance measuring module 202.

- the operation system processing unit 222performs, for example, a process of recognizing a user's gesture based on the depth value supplied from the distance measuring module 202, and performs a process of inputting various operations according to the gesture. Can be done.

- the smartphone 201configured in this way, by applying the distance measuring module 11 described above, for example, a depth map can be generated with high accuracy and high speed. As a result, the smartphone 201 can detect the distance measurement information more accurately.

- the technology according to the present disclosurecan be applied to various products.

- the technology according to the present disclosureis realized as a device mounted on a moving body of any kind such as an automobile, an electric vehicle, a hybrid electric vehicle, a motorcycle, a bicycle, a personal mobility, an airplane, a drone, a ship, and a robot. You may.

- FIG. 27is a block diagram showing a schematic configuration example of a vehicle control system, which is an example of a mobile control system to which the technology according to the present disclosure can be applied.

- the vehicle control system 12000includes a plurality of electronic control units connected via the communication network 12001.

- the vehicle control system 12000includes a drive system control unit 12010, a body system control unit 12020, an outside information detection unit 12030, an in-vehicle information detection unit 12040, and an integrated control unit 12050.

- a microcomputer 12051, an audio image output unit 12052, and an in-vehicle network I / F (interface) 12053are shown as a functional configuration of the integrated control unit 12050.

- the drive system control unit 12010controls the operation of the device related to the drive system of the vehicle according to various programs.

- the drive system control unit 12010provides a driving force generator for generating the driving force of the vehicle such as an internal combustion engine or a driving motor, a driving force transmission mechanism for transmitting the driving force to the wheels, and a steering angle of the vehicle. It functions as a control device such as a steering mechanism for adjusting and a braking device for generating a braking force of a vehicle.

- the body system control unit 12020controls the operation of various devices mounted on the vehicle body according to various programs.

- the body system control unit 12020functions as a keyless entry system, a smart key system, a power window device, or a control device for various lamps such as headlamps, back lamps, brake lamps, blinkers or fog lamps.

- the body system control unit 12020may be input with radio waves transmitted from a portable device that substitutes for the key or signals of various switches.

- the body system control unit 12020receives inputs of these radio waves or signals and controls a vehicle door lock device, a power window device, a lamp, and the like.

- the vehicle outside information detection unit 12030detects information outside the vehicle equipped with the vehicle control system 12000.

- the image pickup unit 12031is connected to the vehicle exterior information detection unit 12030.

- the vehicle outside information detection unit 12030causes the image pickup unit 12031 to capture an image of the outside of the vehicle and receives the captured image.

- the vehicle exterior information detection unit 12030may perform object detection processing or distance detection processing such as a person, a vehicle, an obstacle, a sign, or a character on the road surface based on the received image.

- the imaging unit 12031is an optical sensor that receives light and outputs an electric signal according to the amount of the light received.

- the image pickup unit 12031can output an electric signal as an image or can output it as distance measurement information. Further, the light received by the imaging unit 12031 may be visible light or invisible light such as infrared light.

- the in-vehicle information detection unit 12040detects the in-vehicle information.

- a driver state detection unit 12041that detects the driver's state is connected to the in-vehicle information detection unit 12040.

- the driver state detection unit 12041includes, for example, a camera that images the driver, and the in-vehicle information detection unit 12040 determines the degree of fatigue or concentration of the driver based on the detection information input from the driver state detection unit 12041. It may be calculated, or it may be determined whether the driver is dozing.

- the microcomputer 12051calculates the control target value of the driving force generator, the steering mechanism, or the braking device based on the information inside and outside the vehicle acquired by the vehicle exterior information detection unit 12030 or the vehicle interior information detection unit 12040, and the drive system control unit.

- a control commandcan be output to 12010.

- the microcomputer 12051realizes ADAS (Advanced Driver Assistance System) functions including vehicle collision avoidance or impact mitigation, follow-up driving based on inter-vehicle distance, vehicle speed maintenance driving, vehicle collision warning, vehicle lane deviation warning, and the like. It is possible to perform cooperative control for the purpose of.

- ADASAdvanced Driver Assistance System

- the microcomputer 12051controls the driving force generator, the steering mechanism, the braking device, and the like based on the information around the vehicle acquired by the vehicle exterior information detection unit 12030 or the vehicle interior information detection unit 12040. It is possible to perform coordinated control for the purpose of automatic driving, etc., which runs autonomously without depending on the operation.

- the microcomputer 12051can output a control command to the body system control unit 12020 based on the information outside the vehicle acquired by the vehicle exterior information detection unit 12030.

- the microcomputer 12051controls the headlamps according to the position of the preceding vehicle or the oncoming vehicle detected by the external information detection unit 12030, and performs coordinated control for the purpose of anti-glare such as switching the high beam to the low beam. It can be carried out.

- the audio image output unit 12052transmits the output signal of at least one of the audio and the image to the output device capable of visually or audibly notifying the passenger of the vehicle or the outside of the vehicle.

- an audio speaker 12061, a display unit 12062, and an instrument panel 12063are exemplified as output devices.

- the display unit 12062may include, for example, at least one of an onboard display and a heads-up display.

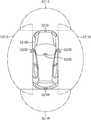

- FIG. 28is a diagram showing an example of the installation position of the imaging unit 12031.

- the vehicle 12100has image pickup units 12101, 12102, 12103, 12104, 12105 as the image pickup unit 12031.

- the imaging units 12101, 12102, 12103, 12104, 12105are provided at positions such as the front nose, side mirrors, rear bumpers, back doors, and the upper part of the windshield in the vehicle interior of the vehicle 12100, for example.

- the image pickup unit 12101 provided on the front nose and the image pickup section 12105 provided on the upper part of the windshield in the vehicle interiormainly acquire an image in front of the vehicle 12100.

- the imaging units 12102 and 12103 provided in the side mirrorsmainly acquire images of the side of the vehicle 12100.

- the imaging unit 12104 provided on the rear bumper or the back doormainly acquires an image of the rear of the vehicle 12100.

- the images in front acquired by the imaging units 12101 and 12105are mainly used for detecting a preceding vehicle or a pedestrian, an obstacle, a traffic light, a traffic sign, a lane, or the like.

- FIG. 28shows an example of the photographing range of the imaging units 12101 to 12104.

- the imaging range 12111indicates the imaging range of the imaging unit 12101 provided on the front nose

- the imaging ranges 12112 and 12113indicate the imaging ranges of the imaging units 12102 and 12103 provided on the side mirrors, respectively

- the imaging range 12114indicates the imaging range of the imaging units 12102 and 12103.

- the imaging range of the imaging unit 12104 provided on the rear bumper or the back dooris shown. For example, by superimposing the image data captured by the imaging units 12101 to 12104, a bird's-eye view image of the vehicle 12100 as viewed from above can be obtained.

- At least one of the imaging units 12101 to 12104may have a function of acquiring distance information.

- at least one of the image pickup units 12101 to 12104may be a stereo camera composed of a plurality of image pickup elements, or may be an image pickup element having pixels for phase difference detection.

- the microcomputer 12051has a distance to each three-dimensional object within the imaging range 12111 to 12114 based on the distance information obtained from the imaging units 12101 to 12104, and a temporal change of this distance (relative velocity with respect to the vehicle 12100). By obtaining can. Further, the microcomputer 12051 can set an inter-vehicle distance to be secured in front of the preceding vehicle in advance, and can perform automatic brake control (including follow-up stop control), automatic acceleration control (including follow-up start control), and the like. In this way, it is possible to perform coordinated control for the purpose of automatic driving or the like in which the vehicle travels autonomously without depending on the operation of the driver.

- automatic brake controlincluding follow-up stop control

- automatic acceleration controlincluding follow-up start control

- the microcomputer 12051converts three-dimensional object data related to a three-dimensional object into two-wheeled vehicles, ordinary vehicles, large vehicles, pedestrians, utility poles, and other three-dimensional objects based on the distance information obtained from the imaging units 12101 to 12104. It can be classified and extracted and used for automatic avoidance of obstacles. For example, the microcomputer 12051 distinguishes obstacles around the vehicle 12100 into obstacles that can be seen by the driver of the vehicle 12100 and obstacles that are difficult to see. Then, the microcomputer 12051 determines the collision risk indicating the risk of collision with each obstacle, and when the collision risk is equal to or higher than the set value and there is a possibility of collision, the microcomputer 12051 via the audio speaker 12061 or the display unit 12062. By outputting an alarm to the driver and performing forced deceleration and avoidance steering via the drive system control unit 12010, driving support for collision avoidance can be provided.

- At least one of the imaging units 12101 to 12104may be an infrared camera that detects infrared rays.

- the microcomputer 12051can recognize a pedestrian by determining whether or not a pedestrian is present in the captured image of the imaging units 12101 to 12104.

- pedestrian recognitionincludes, for example, a procedure for extracting feature points in an image captured by an imaging unit 12101 to 12104 as an infrared camera, and pattern matching processing for a series of feature points indicating the outline of an object to determine whether or not the pedestrian is a pedestrian. It is done by the procedure to determine.

- the audio image output unit 12052When the microcomputer 12051 determines that a pedestrian is present in the captured images of the imaging units 12101 to 12104 and recognizes the pedestrian, the audio image output unit 12052 outputs a square contour line for emphasizing the recognized pedestrian.

- the display unit 12062is controlled so as to superimpose and display. Further, the audio image output unit 12052 may control the display unit 12062 so as to display an icon or the like indicating a pedestrian at a desired position.

- the aboveis an example of a vehicle control system to which the technology according to the present disclosure can be applied.