KR20240126672A - Apparatus for artificial intelligence, controlling method of operational thereof and artificial intelligence service system - Google Patents

Apparatus for artificial intelligence, controlling method of operational thereof and artificial intelligence service systemDownload PDFInfo

- Publication number

- KR20240126672A KR20240126672AKR1020230019445AKR20230019445AKR20240126672AKR 20240126672 AKR20240126672 AKR 20240126672AKR 1020230019445 AKR1020230019445 AKR 1020230019445AKR 20230019445 AKR20230019445 AKR 20230019445AKR 20240126672 AKR20240126672 AKR 20240126672A

- Authority

- KR

- South Korea

- Prior art keywords

- data

- user

- home appliance

- artificial intelligence

- information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L12/00—Data switching networks

- H04L12/28—Data switching networks characterised by path configuration, e.g. LAN [Local Area Networks] or WAN [Wide Area Networks]

- H04L12/2803—Home automation networks

- H04L12/2816—Controlling appliance services of a home automation network by calling their functionalities

- H04L12/282—Controlling appliance services of a home automation network by calling their functionalities based on user interaction within the home

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N20/00—Machine learning

- G—PHYSICS

- G16—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS

- G16Y—INFORMATION AND COMMUNICATION TECHNOLOGY SPECIALLY ADAPTED FOR THE INTERNET OF THINGS [IoT]

- G16Y10/00—Economic sectors

- G16Y10/80—Homes; Buildings

- G—PHYSICS

- G16—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS

- G16Y—INFORMATION AND COMMUNICATION TECHNOLOGY SPECIALLY ADAPTED FOR THE INTERNET OF THINGS [IoT]

- G16Y40/00—IoT characterised by the purpose of the information processing

- G16Y40/30—Control

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L12/00—Data switching networks

- H04L12/28—Data switching networks characterised by path configuration, e.g. LAN [Local Area Networks] or WAN [Wide Area Networks]

- H04L12/2803—Home automation networks

- H04L12/2823—Reporting information sensed by appliance or service execution status of appliance services in a home automation network

- H04L12/2827—Reporting to a device within the home network; wherein the reception of the information reported automatically triggers the execution of a home appliance functionality

- H04L12/2829—Reporting to a device within the home network; wherein the reception of the information reported automatically triggers the execution of a home appliance functionality involving user profiles according to which the execution of a home appliance functionality is automatically triggered

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L67/00—Network arrangements or protocols for supporting network services or applications

- H04L67/50—Network services

- H04L67/52—Network services specially adapted for the location of the user terminal

Landscapes

- Engineering & Computer Science (AREA)

- Computing Systems (AREA)

- Signal Processing (AREA)

- Computer Networks & Wireless Communication (AREA)

- Automation & Control Theory (AREA)

- Theoretical Computer Science (AREA)

- Software Systems (AREA)

- Data Mining & Analysis (AREA)

- Physics & Mathematics (AREA)

- General Business, Economics & Management (AREA)

- Artificial Intelligence (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Development Economics (AREA)

- Evolutionary Computation (AREA)

- Medical Informatics (AREA)

- Accounting & Taxation (AREA)

- Economics (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Mathematical Physics (AREA)

- Business, Economics & Management (AREA)

- Structural Engineering (AREA)

- Civil Engineering (AREA)

- Architecture (AREA)

- Human Computer Interaction (AREA)

- Selective Calling Equipment (AREA)

Abstract

Translated fromKoreanDescription

Translated fromKorean본 개시는 인공지능 기기, 그 동작 제어 방법 및 인공지능 서비스 시스템에 관한 것이다.The present disclosure relates to an artificial intelligence device, a method for controlling its operation, and an artificial intelligence service system.

디지털 기술 또는 통신 기술의 발전과 함께 ICT(Information and Communications Technology) 기술의 발전이 눈부시다.With the advancement of digital technology or communication technology, the advancement of ICT (Information and Communications Technology) technology is remarkable.

최근 특히, 인공지능 기술에 대한 연구가 많이 이루어지고 있으며, 다양한 분야에 접목하기 위한 시도가 이루어지고 있다.Recently, in particular, much research has been conducted on artificial intelligence technology, and attempts are being made to apply it to various fields.

특히 홈 내에서 인공지능 기술이 채용된 다양한 제조사의 가전이 늘고 있으나, 댁내에서 이를 통합 제어하는 것은 쉽지 않아 문제가 된다.In particular, the number of home appliances from various manufacturers that use artificial intelligence technology is increasing, but it is difficult to control them in an integrated manner at home, which is problematic.

본 개시가 해결하고자 하는 과제는, 데이터 기반 사용자의 상황을 인지하여 그에 부합하는 가전을 제어하는 인공지능 기기, 그 동작 제어 방법 및 서비스 시스템을 제공하는 것이다.The problem that the present disclosure seeks to solve is to provide an artificial intelligence device that recognizes the user's situation based on data and controls home appliances accordingly, a method for controlling the operation thereof, and a service system.

본 개시가 해결하고자 하는 과제들은 이상에서 언급된 과제로 제한되지 않으며, 언급되지 않은 또 다른 과제들은 아래의 기재로부터 통상의 기술자에게 명확하게 이해될 수 있을 것이다.The problems to be solved by the present disclosure are not limited to the problems mentioned above, and other problems not mentioned will be clearly understood by those skilled in the art from the description below.

상술한 과제를 해결하기 위한 본 개시의 다양한 실시예들 중 적어도 하나에 따른 인공지능 장치는, 적어도 하나 이상의 센서; 메모리; 및 상기 메모리와 통신하며 데이터를 주고받는 프로세서를 포함하되, 상기 프로세서는, 상기 적어도 하나 이상의 센서로부터 센싱 데이터를 획득하고, 상기 센싱 데이터에 기초하여 사용자에 대한 이벤트 발생을 감지하고, 상기 이벤트 발생에 기초하여 상기 사용자 및 사용자의 현재 위치를 식별하고, 상기 식별된 사용자 및 위치 정보에 기초하여 적어도 하나 이상의 가전의 상태 데이터를 획득하고, 상기 센싱 데이터와 상태 데이터 및 상기 메모리로부터 독출된 상기 식별된 사용자에 대해 기저장된 데이터에 기초하여 사용자의 상황 인식 데이터를 생성하고, 상기 생성된 사용자의 상황 인식 데이터에 기초하여 제어 대상 가전을 결정하고, 결정된 제어 대상 가전으로 동작 제어 신호를 전송할 수 있다.An artificial intelligence device according to at least one of various embodiments of the present disclosure for solving the above-described problem includes: at least one sensor; a memory; and a processor communicating with the memory and transmitting and receiving data, wherein the processor obtains sensing data from the at least one sensor, detects an event occurrence for a user based on the sensing data, identifies the user and a current location of the user based on the event occurrence, obtains status data of at least one home appliance based on the identified user and location information, generates user situational awareness data based on the sensing data, the status data, and pre-stored data for the identified user read out from the memory, determines a control target home appliance based on the generated user situational awareness data, and transmits an operation control signal to the determined control target home appliance.

그리고 상기 프로세서는, 상기 식별된 사용자 및 현재 위치 정보에 기초하여 제어 대상 후보 가전을 선정할 수 있다.And the processor can select a candidate home appliance to be controlled based on the identified user and current location information.

또한, 상기 프로세서는, 상기 선정된 제어 대상 후보 가전에 대해서만 가전 상태 데이터를 획득할 수 있다.Additionally, the processor can obtain home appliance status data only for the selected control target candidate home appliances.

그리고 상기 사용자에 대해 기저장된 데이터에는, 상기 사용자의 가전 사용 패턴 데이터가 포함되고, 상기 가전 사용 패턴 데이터에는, 사용한 가전의 식별자 정보, 해당 가전 사용 전 센서에서 센싱된 데이터 및 가전의 상태 정보가 맵핑되어 포함될 수 있다.And the data stored for the user includes the user's home appliance usage pattern data, and the home appliance usage pattern data may include identifier information of the home appliance used, data sensed by a sensor before the use of the home appliance, and status information of the home appliance mapped thereto.

또한, 상기 프로세서는, 상기 사용자에 대한 이벤트 발생 여부를 모니터링할 수 있다.Additionally, the processor can monitor whether an event occurs for the user.

그리고 상기 프로세서는, 상기 이벤트 발생 모니터링 결과, 미리 정의된 시간동안 추가 이벤트가 발생하지 않는 경우, 상기 센서부를 통해 상기 사용자에 관한 정보를 수집할 수 있다.And, the processor can collect information about the user through the sensor unit if, as a result of the event occurrence monitoring, no additional event occurs for a predefined period of time.

또한, 상기 프로세서는, 상기 수집한 사용자에 관한 정보에 기초하여 제어 대상 후보 가전을 선정하고, 선정된 제어 대상 후보 가전의 상태 정보를 수집할 수 있다.In addition, the processor can select a candidate home appliance to be controlled based on the collected user information, and collect status information of the selected candidate home appliance to be controlled.

그리고 상기 프로세서는, 상기 수집한 제어 대상 후보 가전의 상태 정보에 기초하여, 최종 제어 대상 가전을 결정하고, 결정된 제어 대상 가전의 상태 변경을 위한 동작 제어 신호를 전송할 수 있다.And the processor can determine a final control target home appliance based on the status information of the collected control target candidate home appliances, and transmit an operation control signal for changing the status of the determined control target home appliance.

본 개시의 다양한 실시예들 중 적어도 하나에 따른 인공지능 장치의 동작 제어 방법은, 적어도 하나 이상의 센서로부터 센싱 데이터를 획득하는 단계; 상기 센싱 데이터에 기초하여 사용자에 대한 이벤트 발생을 모니터링하는 단계; 상기 모니터링 결과 이벤트가 발생한 경우, 상기 사용자 및 사용자의 현재 위치를 식별하는 단계; 상기 식별된 사용자 및 위치 정보에 기초하여 적어도 하나 이상의 가전의 상태 데이터를 획득하는 단계; 상기 센싱 데이터와 상태 데이터 및 상기 메모리로부터 독출된 상기 식별된 사용자에 대해 기저장된 데이터에 기초하여 사용자의 상황 인식 데이터를 생성하는 단계; 상기 생성된 사용자의 상황 인식 데이터에 기초하여 제어 대상 가전을 결정하는 단계; 및 결정된 제어 대상 가전으로 동작 제어 신호를 전송하는 단계를 포함할 수 있다.A method for controlling operation of an artificial intelligence device according to at least one of various embodiments of the present disclosure may include: obtaining sensing data from at least one sensor; monitoring an event occurrence for a user based on the sensing data; identifying the user and the user's current location when an event occurs as a result of the monitoring; obtaining status data of at least one home appliance based on the identified user and location information; generating user situational awareness data based on the sensing data, the status data, and pre-stored data for the identified user read from the memory; determining a control target home appliance based on the generated user situational awareness data; and transmitting an operation control signal to the determined control target home appliance.

본 개시의 다양한 실시예들 중 적어도 하나에 따른 인공지능 서비스 시스템은, 적어도 하나 이상의 가전; 상기 적어도 하나 이상의 가전과 통신하여 데이터를 주고받는 프로세서를 포함한 스마트 허브; 및 상기 스마트 허브와 데이터를 주고받는 서버를 포함하되, 상기 스마트 허브와 서버 중 적어도 하나는, 센싱 데이터를 획득하고, 상기 센싱 데이터에 기초하여 사용자에 대한 이벤트 발생을 감지하고, 상기 이벤트 발생에 기초하여 상기 사용자 및 사용자의 현재 위치를 식별하고, 상기 식별된 사용자 및 위치 정보에 기초하여 적어도 하나 이상의 가전의 상태 데이터를 획득하고, 상기 센싱 데이터와 상태 데이터 및 상기 메모리로부터 독출된 상기 식별된 사용자에 대해 기저장된 데이터에 기초하여 사용자의 상황 인식 데이터를 생성하고, 상기 생성된 사용자의 상황 인식 데이터에 기초하여 제어 대상 가전을 결정하여 결정된 제어 대상 가전으로 동작 제어 신호를 전송할 수 있다.An artificial intelligence service system according to at least one of the various embodiments of the present disclosure comprises: at least one home appliance; a smart hub including a processor for communicating with the at least one home appliance to exchange data; and a server for exchanging data with the smart hub, wherein at least one of the smart hub and the server obtains sensing data, detects an event occurrence for a user based on the sensing data, identifies the user and a current location of the user based on the event occurrence, obtains status data of at least one home appliance based on the identified user and location information, generates user situational awareness data based on the sensing data, the status data, and pre-stored data for the identified user read out from the memory, and determines a control target home appliance based on the generated user situational awareness data and transmits an operation control signal to the determined control target home appliance.

본 개시의 기타 구체적인 사항들은 상세한 설명 및 도면들에 포함되어 있다.Other specific details of the present disclosure are included in the detailed description and drawings.

본 개시의 다양한 실시 예들 중 적어도 하나에 따르면, 데이터 기반 사용자의 상황을 보다 정확하게 인지할 수 있는 효과가 있다.According to at least one of the various embodiments of the present disclosure, there is an effect of more accurately recognizing the situation of a data-based user.

본 개시의 다양한 실시 예들 중 적어도 하나에 따르면, 사용자의 상황을 정확하게 인지하여 그에 부합하는 가전을 자동으로 제어할 수 있는 효과가 있다.According to at least one of the various embodiments of the present disclosure, there is an effect of accurately recognizing a user's situation and automatically controlling a home appliance corresponding thereto.

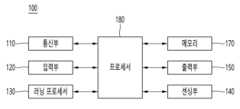

도 1은 본 개시의 일 실시 예에 따른 AI 장치를 나타낸다.

도 2는 본 개시의 일 실시 예에 따른 AI 서버를 나타낸다.

도 3은 본 개시의 일 실시 예에 따른 AI 시스템을 나타낸다.

도 4는 본 개시의 또 다른 실시 예에 따른 AI 장치를 나타낸다.

도 5는 본 개시의 일실시예에 따른 인공지능 서비스 시스템을 설명하기 위해 도시한 도면이다.

도 6은 본 개시의 일실시예에 따른 인공지능 서비스 시스템의 인공지능 기기 동작 제어 방법을 설명하기 위해 도시한 순서도이다.

도 7은 본 발명의 일실시예에 따른 홈 상태 감지를 위한 AI 네트워크 아키텍처를 설명하기 위해 도시한 도면이다.

도 8은 본 발명의 일실시예에 따른 인공지능 학습 모델을 설명하기 위해 도시한 도면이다.

도 9 내지 12는 본 발명의 일실시예에 따른 인공지능 서비스 시나리오를 설명하기 위해 도시한 도면이다.Figure 1 illustrates an AI device according to one embodiment of the present disclosure.

FIG. 2 illustrates an AI server according to one embodiment of the present disclosure.

FIG. 3 illustrates an AI system according to one embodiment of the present disclosure.

FIG. 4 illustrates an AI device according to another embodiment of the present disclosure.

FIG. 5 is a diagram illustrating an artificial intelligence service system according to an embodiment of the present disclosure.

FIG. 6 is a flowchart illustrating a method for controlling operation of an artificial intelligence device of an artificial intelligence service system according to an embodiment of the present disclosure.

FIG. 7 is a diagram illustrating an AI network architecture for home status detection according to one embodiment of the present invention.

FIG. 8 is a diagram illustrating an artificial intelligence learning model according to an embodiment of the present invention.

Figures 9 to 12 are diagrams illustrating an artificial intelligence service scenario according to an embodiment of the present invention.

이하, 본 발명과 관련된 실시 예에 대하여 도면을 참조하여 보다 상세하게 설명한다. 이하의 설명에서 사용되는 구성요소에 대한 접미사 "모듈" 및 "부"는 명세서 작성의 용이함만이 고려되어 부여되거나 혼용되는 것으로서, 그 자체로 서로 구별되는 의미 또는 역할을 갖는 것은 아니다.Hereinafter, embodiments related to the present invention will be described in more detail with reference to the drawings. The suffixes "module" and "part" used for components in the following description are given or used interchangeably only for the convenience of writing the specification, and do not have distinct meanings or roles in themselves.

인공 지능(AI: Artificial Intelligence)은 인공적인 지능 또는 이를 만들 수 있는 방법론을 연구하는 분야를 의미하며, 머신 러닝(기계 학습, Machine Learning)은 인공 지능 분야에서 다루는 다양한 문제를 정의하고 그것을 해결하는 방법론을 연구하는 분야를 의미한다. 머신 러닝은 어떠한 작업에 대하여 꾸준한 경험을 통해 그 작업에 대한 성능을 높이는 알고리즘으로 정의하기도 한다.Artificial Intelligence (AI) refers to a field that studies artificial intelligence or the methodologies for creating it, and machine learning (machine learning) refers to a field that defines various problems in the field of artificial intelligence and studies the methodologies for solving them. Machine learning is also defined as an algorithm that improves the performance of a task through constant experience with the task.

인공 신경망(Artificial Neural Network)은 머신 러닝에서 사용되는 모델로서, 시냅스(synapse)의 결합으로 네트워크를 형성한 인공 뉴런(artificial neurons)(노드)들로 구성되는, 문제 해결 능력을 가지는 모델 전반을 의미할 수 있다. 인공 신경망은 다른 레이어의 뉴런들 사이의 연결 패턴, 모델 파라미터를 갱신하는 학습 과정, 출력값을 생성하는 활성화 함수(Activation Function)에 의해 정의될 수 있다.An artificial neural network is a model used in machine learning, and can refer to a model with problem-solving capabilities, consisting of artificial neurons (nodes) that form a network by combining synapses. An artificial neural network can be defined by the connection pattern between neurons in different layers, the learning process that updates model parameters, and the activation function that generates the output value.

인공 신경망은 입력층(Input Layer), 출력층(Output Layer), 그리고 선택적으로 하나 이상의 은닉층(Hidden Layer)를 포함할 수 있다. 각 층은 하나 이상의 뉴런을 포함하고, 인공 신경망은 뉴런과 뉴런을 연결하는 시냅스를 포함할 수 있다. 인공 신경망에서 각 뉴런은 시냅스를 통해 입력되는 입력 신호들, 가중치(weight), 편향(bias)에 대한 활성 함수의 함수값을 출력할 수 있다.An artificial neural network may include an input layer, an output layer, and optionally one or more hidden layers. Each layer may include one or more neurons, and the artificial neural network may include synapses connecting neurons. In an artificial neural network, each neuron may output a function value of an activation function for input signals, weights, and biases input through synapses.

모델 파라미터는 학습을 통해 결정되는 파라미터를 의미하며, 시냅스 연결의 가중치와 뉴런의 편향 등이 포함된다. 그리고, 하이퍼 파라미터는 머신 러닝 알고리즘에서 학습 전에 설정되어야 하는 파라미터를 의미하며, 학습률(Learning Rate), 반복 횟수, 미니 배치 크기, 초기화 함수 등이 포함된다.Model parameters refer to parameters that are determined through learning, including the weights of synaptic connections and the biases of neurons. Hyperparameters refer to parameters that must be set before learning in machine learning algorithms, including learning rate, number of iterations, mini-batch size, and initialization functions.

인공 신경망의 학습의 목적은 손실 함수를 최소화하는 모델 파라미터를 결정하는 것으로 볼 수 있다. 손실 함수는 인공 신경망의 학습 과정에서 최적의 모델 파라미터를 결정하기 위한 지표로 이용될 수 있다.The purpose of learning an artificial neural network can be seen as determining model parameters that minimize a loss function. The loss function can be used as an indicator to determine optimal model parameters during the learning process of an artificial neural network.

머신 러닝은 학습 방식에 따라 지도 학습(Supervised Learning), 비지도 학습(Unsupervised Learning), 강화 학습(Reinforcement Learning)으로 분류할 수 있다.Machine learning can be classified into supervised learning, unsupervised learning, and reinforcement learning depending on the learning method.

지도 학습은 학습 데이터에 대한 레이블(label)이 주어진 상태에서 인공 신경망을 학습시키는 방법을 의미하며, 레이블이란 학습 데이터가 인공 신경망에 입력되는 경우 인공 신경망이 추론해 내야 하는 정답(또는 결과 값)을 의미할 수 있다. 비지도 학습은 학습 데이터에 대한 레이블이 주어지지 않는 상태에서 인공 신경망을 학습시키는 방법을 의미할 수 있다. 강화 학습은 어떤 환경 안에서 정의된 에이전트가 각 상태에서 누적 보상을 최대화하는 행동 혹은 행동 순서를 선택하도록 학습시키는 학습 방법을 의미할 수 있다.Supervised learning refers to a method of training an artificial neural network when labels for training data are given. The labels can refer to the correct answer (or result value) that the artificial neural network should infer when training data is input to the artificial neural network. Unsupervised learning can refer to a method of training an artificial neural network when labels for training data are not given. Reinforcement learning can refer to a learning method that trains an agent defined in a certain environment to select actions or action sequences that maximize cumulative rewards in each state.

인공 신경망 중에서 복수의 은닉층을 포함하는 심층 신경망(Deep Neural Network)으로 구현되는 머신 러닝을 딥 러닝(심층 학습, Deep Learning)이라 부르기도 하며, 딥 러닝은 머신 러닝의 일부이다. 이하에서, 머신 러닝은 딥 러닝을 포함하는 의미로 사용된다.Among artificial neural networks, machine learning implemented with a deep neural network that includes multiple hidden layers is also called deep learning, and deep learning is a part of machine learning. Hereinafter, machine learning is used to mean including deep learning.

기계 학습을 이용한 객체 감지 모델은 단일 단계 방식의 YOLO(you Only Look Once) 모델, 이단계 방식의 Faster R-CNN(Regions with Convolution Neural Networks) 모델 등이 있다.Object detection models using machine learning include the single-step YOLO (You Only Look Once) model and the two-step Faster R-CNN (Regions with Convolution Neural Networks) model.

YOLO 모델은 이미지 내에 존재하는 객체와 해당 객체의 위치가 이미지를 한번만 보고 예측할 수 있는 모델이다.The YOLO model is a model that can predict objects and their locations within an image by looking at the image only once.

YOLO 모델은 원본 이미지를 동일한 크기의 그리드(grid)로 나눈다. 그리고, 각 그리드에 대해 그리드 중앙을 중심으로 미리 정의된 형태로 지정된 경계 박스의 개수를 예측하고 이를 기반으로 신뢰도가 계산된다.The YOLO model divides the original image into grids of the same size. Then, for each grid, the number of bounding boxes specified in a predefined shape centered around the center of the grid is predicted, and the confidence is calculated based on this.

그 후, 이미지에 객체가 포함되어 있는지, 또는 배경만 단독으로 있는지에 대한 여부가 포함되며, 높은 객체 신뢰도를 가진 위치가 선택되어 객체 카테고리가 파악될 수 있다.After that, whether the image contains an object or is just a background is included, and the location with high object confidence is selected so that the object category can be identified.

Faster R-CNN 모델은 RCNN 모델 및 Fast RCNN 모델보다 더 빨리 객체를 감지할 수 있는 모델이다.The Faster R-CNN model is a model that can detect objects faster than the RCNN model and the Fast RCNN model.

Faster R-CNN 모델에 대해 구체적으로 설명한다.Let's explain the Faster R-CNN model in detail.

먼저, CNN 모델을 통해 이미지로부터 특징 맵이 추출된다. 추출된 특징 맵에 기초하여, 복수의 관심 영역(Region of Interest, RoI)들이 추출된다. 각 관심 영역에 대해 RoI 풀링이 수행된다.First, feature maps are extracted from the image using a CNN model. Based on the extracted feature maps, multiple regions of interest (RoIs) are extracted. RoI pooling is performed for each region of interest.

RoI 풀링은 관심 영역이 투사된 피쳐 맵(feature map)을 미리 정해 놓은 H x W 크기에 맞게 끔 그리드를 설정하고, 각 그리드에 포함된 칸 별로, 가장 큰 값을 추출하여, H x W 크기를 갖는 피쳐 맵을 추출하는 과정이다.RoI pooling is a process of extracting a feature map with a size of H x W by setting a grid to a predetermined size of H x W on which the region of interest is projected, and extracting the largest value for each cell included in the grid to extract a feature map with a size of H x W.

H x W 크기를 갖는 피쳐 맵로부터 특징 벡터가 추출되고, 특징 벡터로부터 객체의 식별 정보가 얻어질 수 있다.A feature vector is extracted from a feature map having the size of H x W, and object identification information can be obtained from the feature vector.

확장 현실(XR: eXtended Reality)은 가상 현실(VR: Virtual Reality), 증강 현실(AR: Augmented Reality), 혼합 현실(MR: Mixed Reality)을 총칭한다. VR 기술은 현실 세계의 객체나 배경 등을 CG 영상으로만 제공하고, AR 기술은 실제 사물 영상 위에 가상으로 만들어진 CG 영상을 함께 제공하며, MR 기술은 현실 세계에 가상 객체들을 섞고 결합시켜서 제공하는 컴퓨터 그래픽 기술이다.Extended reality (XR) is a general term for virtual reality (VR), augmented reality (AR), and mixed reality (MR). VR technology provides real-world objects and backgrounds only as CG images, AR technology provides virtual CG images on top of images of real objects, and MR technology is a computer graphics technology that mixes and combines virtual objects in the real world.

MR 기술은 현실 객체와 가상 객체를 함께 보여준다는 점에서 AR 기술과 유사하다. 그러나, AR 기술에서는 가상 객체가 현실 객체를 보완하는 형태로 사용되는 반면, MR 기술에서는 가상 객체와 현실 객체가 동등한 성격으로 사용된다는 점에서 차이점이 있다.MR technology is similar to AR technology in that it shows real objects and virtual objects together. However, there is a difference in that while AR technology uses virtual objects to complement real objects, MR technology uses virtual and real objects with equal characteristics.

XR 기술은 HMD(Head-Mounted Display), HUD(Head-Up Display), 휴대폰, 태블릿 PC, 랩탑, 데스크탑, TV, 디지털 사이니지 등에 적용될 수 있고, XR 기술이 적용된 장치를 XR 장치(XR Device)라 칭할 수 있다.XR technology can be applied to HMD (Head-Mounted Display), HUD (Head-Up Display), mobile phones, tablet PCs, laptops, desktops, TVs, digital signage, etc., and devices to which XR technology is applied can be called XR devices.

도 1은 본 개시의 일실시예에 따른 AI 장치(100)를 나타낸다.FIG. 1 illustrates an AI device (100) according to one embodiment of the present disclosure.

도 1을 참조하면, 단말기(100)는 통신부(110), 입력부(120), 러닝 프로세서(130), 센싱부(140), 출력부(150), 메모리(170), 프로세서(180) 등을 포함할 수 있다.Referring to FIG. 1, the terminal (100) may include a communication unit (110), an input unit (120), a running processor (130), a sensing unit (140), an output unit (150), a memory (170), a processor (180), etc.

통신부(110)는 유무선 통신 기술을 이용하여 다른 AI 장치(도 3의 100a 내지 100e)나 AI 서버(200) 등의 외부 장치들과 데이터를 송수신할 수 있다. 예컨대, 통신부(110)는 외부 장치들과 센서 정보, 사용자 입력, 학습 모델, 제어 신호 등을 송수신할 수 있다.The communication unit (110) can transmit and receive data with external devices such as other AI devices (100a to 100e of FIG. 3) or AI servers (200) using wired and wireless communication technology. For example, the communication unit (110) can transmit and receive sensor information, user input, learning models, control signals, etc. with external devices.

이 때, 통신부(110)가 이용하는 통신 기술에는 GSM(Global System for Mobile communication), CDMA(Code Division Multi Access), LTE(Long Term Evolution), 5G, 6G, WLAN(Wireless LAN), Wi-Fi(Wireless-Fidelity), 블루투스(Bluetooth), RFID(Radio Frequency Identification), 적외선 통신(Infrared Data Association; IrDA), 지그비(ZigBee), NFC(Near Field Communication) 등이 있다.At this time, the communication technologies used by the communication unit (110) include GSM (Global System for Mobile communication), CDMA (Code Division Multi Access), LTE (Long Term Evolution), 5G, 6G, WLAN (Wireless LAN), Wi-Fi (Wireless-Fidelity), Bluetooth, RFID (Radio Frequency Identification), Infrared Data Association (IrDA), ZigBee, NFC (Near Field Communication), etc.

입력부(120)는 다양한 종류의 데이터를 획득할 수 있다.The input unit (120) can obtain various types of data.

이 때, 입력부(120)는 영상 신호 입력을 위한 카메라, 오디오 신호를 수신하기 위한 마이크로폰, 사용자로부터 정보를 입력 받기 위한 사용자 입력부 등을 포함할 수 있다. 여기서, 카메라나 마이크로폰을 센서로 취급하여, 카메라나 마이크로폰으로부터 획득한 신호를 센싱 데이터 또는 센서 정보라고 할 수도 있다.At this time, the input unit (120) may include a camera for inputting a video signal, a microphone for receiving an audio signal, a user input unit for receiving information from a user, etc. Here, the camera or microphone may be treated as a sensor, and a signal obtained from the camera or microphone may be referred to as sensing data or sensor information.

입력부(120)는 모델 학습을 위한 학습 데이터 및 학습 모델을 이용하여 출력을 획득할 때 사용될 입력 데이터 등을 획득할 수 있다. 입력부(120)는 가공되지 않은 입력 데이터를 획득할 수도 있으며, 이 경우 프로세서(180) 또는 러닝 프로세서(130)는 입력 데이터에 대하여 전처리로써 입력 특징점(input feature)을 추출할 수 있다.The input unit (120) can obtain input data to be used when obtaining output using learning data and learning models for model learning. The input unit (120) can also obtain unprocessed input data, in which case the processor (180) or learning processor (130) can extract input features as preprocessing for the input data.

러닝 프로세서(130)는 학습 데이터를 이용하여 인공 신경망으로 구성된 모델을 학습시킬 수 있다. 여기서, 학습된 인공 신경망을 학습 모델이라 칭할 수 있다. 학습 모델은 학습 데이터가 아닌 새로운 입력 데이터에 대하여 결과 값을 추론해 내는데 사용될 수 있고, 추론된 값은 어떠한 동작을 수행하기 위한 판단의 기초로 이용될 수 있다.The learning processor (130) can train a model composed of an artificial neural network using learning data. Here, the learned artificial neural network can be called a learning model. The learning model can be used to infer a result value for new input data other than learning data, and the inferred value can be used as a basis for judgment to perform a certain action.

이 때, 러닝 프로세서(130)는 AI 서버(200)의 러닝 프로세서(240)과 함께 AI 프로세싱을 수행할 수 있다.At this time, the running processor (130) can perform AI processing together with the running processor (240) of the AI server (200).

이 때, 러닝 프로세서(130)는 AI 장치(100)에 통합되거나 구현된 메모리를 포함할 수 있다. 또는, 러닝 프로세서(130)는 메모리(170), AI 장치(100)에 직접 결합된 외부 메모리 또는 외부 장치에서 유지되는 메모리를 사용하여 구현될 수도 있다.At this time, the running processor (130) may include a memory integrated or implemented in the AI device (100). Alternatively, the running processor (130) may be implemented using a memory (170), an external memory directly coupled to the AI device (100), or a memory maintained in an external device.

센싱부(140)는 다양한 센서들을 이용하여 AI 장치(100) 내부 정보, AI 장치(100)의 주변 환경 정보 및 사용자 정보 중 적어도 하나를 획득할 수 있다.The sensing unit (140) can obtain at least one of internal information of the AI device (100), information about the surrounding environment of the AI device (100), and user information using various sensors.

이 때, 센싱부(140)에 포함되는 센서에는 근접 센서, 조도 센서, 가속도 센서, 자기 센서, 자이로 센서, 관성 센서, RGB 센서, IR 센서, 지문 인식 센서, 초음파 센서, 광 센서, 마이크로폰, 라이다, 레이더 등이 있다.At this time, the sensors included in the sensing unit (140) include a proximity sensor, a light sensor, an acceleration sensor, a magnetic sensor, a gyro sensor, an inertial sensor, an RGB sensor, an IR sensor, a fingerprint recognition sensor, an ultrasonic sensor, a light sensor, a microphone, a lidar, a radar, etc.

출력부(150)는 시각, 청각 또는 촉각 등과 관련된 출력을 발생시킬 수 있다.The output unit (150) can generate output related to vision, hearing, or touch.

이 때, 출력부(150)에는 시각 정보를 출력하는 디스플레이부, 청각 정보를 출력하는 스피커, 촉각 정보를 출력하는 햅틱 모듈 등이 포함될 수 있다.At this time, the output unit (150) may include a display unit that outputs visual information, a speaker that outputs auditory information, a haptic module that outputs tactile information, etc.

메모리(170)는 AI 장치(100)의 다양한 기능을 지원하는 데이터를 저장할 수 있다. 예컨대, 메모리(170)는 입력부(120)에서 획득한 입력 데이터, 학습 데이터, 학습 모델, 학습 히스토리 등을 저장할 수 있다.The memory (170) can store data that supports various functions of the AI device (100). For example, the memory (170) can store input data, learning data, learning models, learning history, etc. obtained from the input unit (120).

프로세서(180)는 데이터 분석 알고리즘 또는 머신 러닝 알고리즘을 사용하여 결정되거나 생성된 정보에 기초하여, AI 장치(100)의 적어도 하나의 실행 가능한 동작을 결정할 수 있다. 그리고, 프로세서(180)는 AI 장치(100)의 구성 요소들을 제어하여 결정된 동작을 수행할 수 있다.The processor (180) may determine at least one executable operation of the AI device (100) based on information determined or generated using a data analysis algorithm or a machine learning algorithm. Then, the processor (180) may control components of the AI device (100) to perform the determined operation.

이를 위해, 프로세서(180)는 러닝 프로세서(130) 또는 메모리(170)의 데이터를 요청, 검색, 수신 또는 활용할 수 있고, 상기 적어도 하나의 실행 가능한 동작 중 예측되는 동작이나, 바람직한 것으로 판단되는 동작을 실행하도록 AI 장치(100)의 구성 요소들을 제어할 수 있다.To this end, the processor (180) may request, retrieve, receive or utilize data from the running processor (130) or the memory (170), and control components of the AI device (100) to execute at least one of the executable operations, a predicted operation or an operation determined to be desirable.

이 때, 프로세서(180)는 결정된 동작을 수행하기 위하여 외부 장치의 연계가 필요한 경우, 해당 외부 장치를 제어하기 위한 제어 신호를 생성하고, 생성한 제어 신호를 해당 외부 장치에 전송할 수 있다.At this time, if linkage of an external device is required to perform a determined operation, the processor (180) can generate a control signal for controlling the external device and transmit the generated control signal to the external device.

프로세서(180)는 사용자 입력에 대하여 의도 정보를 획득하고, 획득한 의도 정보에 기초하여 사용자의 요구 사항을 결정할 수 있다.The processor (180) can obtain intent information for user input and determine the user's requirement based on the obtained intent information.

이 때, 프로세서(180)는 음성 입력을 문자열로 변환하기 위한 STT(Speech To Text) 엔진 또는 자연어의 의도 정보를 획득하기 위한 자연어 처리(NLP: Natural Language Processing) 엔진 중에서 적어도 하나 이상을 이용하여, 사용자 입력에 상응하는 의도 정보를 획득할 수 있다.At this time, the processor (180) can obtain intent information corresponding to the user input by using at least one of an STT (Speech To Text) engine for converting voice input into a string or a natural language processing (NLP) engine for obtaining intent information of natural language.

이 때, STT 엔진 또는 NLP 엔진 중에서 적어도 하나 이상은 적어도 일부가 머신 러닝 알고리즘에 따라 학습된 인공 신경망으로 구성될 수 있다. 그리고, STT 엔진 또는 NLP 엔진 중에서 적어도 하나 이상은 러닝 프로세서(130)에 의해 학습된 것이나, AI 서버(200)의 러닝 프로세서(240)에 의해 학습된 것이거나, 또는 이들의 분산 처리에 의해 학습된 것일 수 있다.At this time, at least one of the STT engine or the NLP engine may be configured with an artificial neural network at least partially learned according to a machine learning algorithm. And, at least one of the STT engine or the NLP engine may be learned by the learning processor (130), learned by the learning processor (240) of the AI server (200), or learned by distributed processing thereof.

프로세서(180)는 AI 장치(100)의 동작 내용이나 동작에 대한 사용자의 피드백 등을 포함하는 이력 정보를 수집하여 메모리(170) 또는 러닝 프로세서(130)에 저장하거나, AI 서버(200) 등의 외부 장치에 전송할 수 있다. 수집된 이력 정보는 학습 모델을 갱신하는데 이용될 수 있다.The processor (180) can collect history information including the operation details of the AI device (100) or the user's feedback on the operation, and store it in the memory (170) or the learning processor (130), or transmit it to an external device such as an AI server (200). The collected history information can be used to update the learning model.

프로세서(180)는 메모리(170)에 저장된 응용 프로그램을 구동하기 위하여, AI 장치(100)의 구성 요소들 중 적어도 일부를 제어할 수 있다. 나아가, 프로세서(180)는 상기 응용 프로그램의 구동을 위하여, AI 장치(100)에 포함된 구성 요소들 중 둘 이상을 서로 조합하여 동작 시킬 수 있다.The processor (180) can control at least some of the components of the AI device (100) to drive an application program stored in the memory (170). Furthermore, the processor (180) can operate two or more of the components included in the AI device (100) in combination to drive the application program.

도 2는 본 개시의 일실시예에 따른 AI 서버(200)를 나타낸다.FIG. 2 illustrates an AI server (200) according to one embodiment of the present disclosure.

도 2를 참조하면, AI 서버(200)는 머신 러닝 알고리즘을 이용하여 인공 신경망을 학습시키거나 학습된 인공 신경망을 이용하는 장치를 의미할 수 있다. 여기서, AI 서버(200)는 복수의 서버들로 구성되어 분산 처리를 수행할 수도 있고, 5G 네트워크로 정의될 수 있다. 이 때, AI 서버(200)는 AI 장치(100)의 일부의 구성으로 포함되어, AI 프로세싱 중 적어도 일부를 함께 수행할 수도 있다.Referring to FIG. 2, the AI server (200) may refer to a device that trains an artificial neural network using a machine learning algorithm or uses a trained artificial neural network. Here, the AI server (200) may be composed of multiple servers to perform distributed processing, and may be defined as a 5G network. In this case, the AI server (200) may be included as a part of the AI device (100) to perform at least a part of AI processing.

AI 서버(200)는 통신부(210), 메모리(230), 러닝 프로세서(240) 및 프로세서(260) 등을 포함할 수 있다.The AI server (200) may include a communication unit (210), a memory (230), a learning processor (240), and a processor (260).

통신부(210)는 AI 장치(100) 등의 외부 장치와 데이터를 송수신할 수 있다.The communication unit (210) can transmit and receive data with an external device such as an AI device (100).

메모리(230)는 모델 저장부(231)를 포함할 수 있다. 모델 저장부(231)는 러닝 프로세서(240)을 통하여 학습 중인 또는 학습된 모델(또는 인공 신경망, 231a)을 저장할 수 있다.The memory (230) may include a model storage unit (231). The model storage unit (231) may store a model (or artificial neural network, 231a) being learned or learned through a learning processor (240).

러닝 프로세서(240)는 학습 데이터를 이용하여 인공 신경망(231a)을 학습시킬 수 있다. 학습 모델은 인공 신경망의 AI 서버(200)에 탑재된 상태에서 이용되거나, AI 장치(100) 등의 외부 장치에 탑재되어 이용될 수도 있다.The learning processor (240) can train an artificial neural network (231a) using learning data. The learning model can be used while mounted on the AI server (200) of the artificial neural network, or can be mounted on an external device such as an AI device (100).

학습 모델은 하드웨어, 소프트웨어 또는 하드웨어와 소프트웨어의 조합으로 구현될 수 있다. 학습 모델의 일부 또는 전부가 소프트웨어로 구현되는 경우 학습 모델을 구성하는 하나 이상의 명령어(instruction)는 메모리(230)에 저장될 수 있다.The learning model may be implemented in hardware, software, or a combination of hardware and software. If part or all of the learning model is implemented in software, one or more instructions constituting the learning model may be stored in memory (230).

프로세서(260)는 학습 모델을 이용하여 새로운 입력 데이터에 대하여 결과 값을 추론하고, 추론한 결과 값에 기초한 응답이나 제어 명령을 생성할 수 있다.The processor (260) can use a learning model to infer a result value for new input data and generate a response or control command based on the inferred result value.

도 3은 본 개시의 일실시예에 따른 AI 시스템(1)을 나타낸다.Figure 3 illustrates an AI system (1) according to one embodiment of the present disclosure.

도 3을 참조하면, AI 시스템(1)은 AI 서버(200), 로봇(100a), 자율 주행 차량(100b), XR 장치(100c), 스마트폰(100d) 또는 가전(100e) 중에서 적어도 하나 이상이 클라우드 네트워크(10)와 연결된다. 여기서, AI 기술이 적용된 로봇(100a), 자율 주행 차량(100b), XR 장치(100c), 스마트폰(100d) 또는 가전(100e) 등을 AI 장치(100a 내지 100e)라 칭할 수 있다.Referring to FIG. 3, an AI system (1) is connected to a cloud network (10) by at least one of an AI server (200), a robot (100a), an autonomous vehicle (100b), an XR device (100c), a smartphone (100d), or an appliance (100e). Here, a robot (100a), an autonomous vehicle (100b), an XR device (100c), a smartphone (100d), or an appliance (100e) to which AI technology is applied may be referred to as an AI device (100a to 100e).

클라우드 네트워크(10)는 클라우드 컴퓨팅 인프라의 일부를 구성하거나 클라우드 컴퓨팅 인프라 안에 존재하는 네트워크를 의미할 수 있다. 여기서, 클라우드 네트워크(10)는 3G 네트워크, 4G 또는 LTE 네트워크 또는 5G 네트워크 등을 이용하여 구성될 수 있다.A cloud network (10) may mean a network that constitutes part of a cloud computing infrastructure or exists within a cloud computing infrastructure. Here, the cloud network (10) may be configured using a 3G network, a 4G or LTE network, a 5G network, etc.

즉, AI 시스템(1)을 구성하는 각 장치들(100a 내지 100e, 200)은 클라우드 네트워크(10)를 통해 서로 연결될 수 있다. 특히, 각 장치들(100a 내지 100e, 200)은 기지국을 통해서 서로 통신할 수도 있지만, 기지국을 통하지 않고 직접 서로 통신할 수도 있다.That is, each device (100a to 100e, 200) constituting the AI system (1) can be connected to each other through the cloud network (10). In particular, each device (100a to 100e, 200) can communicate with each other through a base station, but can also communicate with each other directly without going through a base station.

AI 서버(200)는 AI 프로세싱을 수행하는 서버와 빅 데이터에 대한 연산을 수행하는 서버를 포함할 수 있다.The AI server (200) may include a server that performs AI processing and a server that performs operations on big data.

AI 서버(200)는 AI 시스템(1)을 구성하는 AI 장치들인 로봇(100a), 자율 주행 차량(100b), XR 장치(100c), 스마트폰(100d) 또는 가전(100e) 중에서 적어도 하나 이상과 클라우드 네트워크(10)을 통하여 연결되고, 연결된 AI 장치들(100a 내지 100e)의 AI 프로세싱을 적어도 일부를 도울 수 있다.The AI server (200) is connected to at least one of AI devices constituting the AI system (1), such as a robot (100a), an autonomous vehicle (100b), an XR device (100c), a smartphone (100d), or a home appliance (100e), through a cloud network (10), and can assist at least part of the AI processing of the connected AI devices (100a to 100e).

이 때, AI 서버(200)는 AI 장치(100a 내지 100e)를 대신하여 머신 러닝 알고리즘에 따라 인공 신경망을 학습시킬 수 있고, 학습 모델을 직접 저장하거나 AI 장치(100a 내지 100e)에 전송할 수 있다.At this time, the AI server (200) can train an artificial neural network according to a machine learning algorithm on behalf of the AI device (100a to 100e), and can directly store the learning model or transmit it to the AI device (100a to 100e).

이 때, AI 서버(200)는 AI 장치(100a 내지 100e)로부터 입력 데이터를 수신하고, 학습 모델을 이용하여 수신한 입력 데이터에 대하여 결과 값을 추론하고, 추론한 결과 값에 기초한 응답이나 제어 명령을 생성하여 AI 장치(100a 내지 100e)로 전송할 수 있다.At this time, the AI server (200) can receive input data from the AI device (100a to 100e), infer a result value for the received input data using the learning model, and generate a response or control command based on the inferred result value and transmit it to the AI device (100a to 100e).

또는, AI 장치(100a 내지 100e)는 직접 학습 모델을 이용하여 입력 데이터에 대하여 결과 값을 추론하고, 추론한 결과 값에 기초한 응답이나 제어 명령을 생성할 수도 있다.Alternatively, the AI device (100a to 100e) may infer a result value for input data using a direct learning model and generate a response or control command based on the inferred result value.

이하에서는, 상술한 기술이 적용되는 AI 장치(100a 내지 100e)의 다양한 실시 예들을 설명한다. 여기서, 도 3에 도시된 AI 장치(100a 내지 100e)는 도 1에 도시된 AI 장치(100)의 구체적인 실시 예로 볼 수 있다.Below, various embodiments of AI devices (100a to 100e) to which the above-described technology is applied are described. Here, the AI devices (100a to 100e) illustrated in FIG. 3 can be viewed as specific embodiments of the AI device (100) illustrated in FIG. 1.

XR 장치(100c)는 AI 기술이 적용되어, HMD, 차량에 구비된 HUD, 텔레비전, 휴대폰, 스마트 폰, 컴퓨터, 웨어러블 디바이스, 가전 기기, 디지털 사이니지, 차량, 고정형 로봇이나 이동형 로봇 등으로 구현될 수 있다.The XR device (100c) can be implemented as an HMD, a HUD equipped in a vehicle, a television, a mobile phone, a smart phone, a computer, a wearable device, a home appliance, a digital signage, a vehicle, a fixed robot or a mobile robot, etc. by applying AI technology.

XR 장치(100c)는 다양한 센서들을 통해 또는 외부 장치로부터 획득한 3차원 포인트 클라우드 데이터 또는 이미지 데이터를 분석하여 3차원 포인트들에 대한 위치 데이터 및 속성 데이터를 생성함으로써 주변 공간 또는 현실 객체에 대한 정보를 획득하고, 출력할 XR 객체를 렌더링하여 출력할 수 있다. 예컨대, XR 장치(100c)는 인식된 물체에 대한 추가 정보를 포함하는 XR 객체를 해당 인식된 물체에 대응시켜 출력할 수 있다.The XR device (100c) can obtain information about surrounding space or real objects by analyzing 3D point cloud data or image data acquired through various sensors or from an external device to generate location data and attribute data for 3D points, and can render and output an XR object to be output. For example, the XR device (100c) can output an XR object including additional information about a recognized object by corresponding it to the recognized object.

XR 장치(100c)는 적어도 하나 이상의 인공 신경망으로 구성된 학습 모델을 이용하여 상기한 동작들을 수행할 수 있다. 예컨대, XR 장치(100c)는 학습 모델을 이용하여 3차원 포인트 클라우드 데이터 또는 이미지 데이터에서 현실 객체를 인식할 수 있고, 인식한 현실 객체에 상응하는 정보를 제공할 수 있다. 여기서, 학습 모델은 XR 장치(100c)에서 직접 학습되거나, AI 서버(200) 등의 외부 장치에서 학습된 것일 수 있다.The XR device (100c) can perform the above-described operations using a learning model composed of at least one artificial neural network. For example, the XR device (100c) can recognize a real object from 3D point cloud data or image data using the learning model, and provide information corresponding to the recognized real object. Here, the learning model can be learned directly in the XR device (100c) or learned in an external device such as an AI server (200).

이때, XR 장치(100c)는 직접 학습 모델을 이용하여 결과를 생성하여 동작을 수행할 수도 있지만, AI 서버(200) 등의 외부 장치에 센서 정보를 전송하고 그에 따라 생성된 결과를 수신하여 동작을 수행할 수도 있다.At this time, the XR device (100c) may perform an operation by generating a result using a direct learning model, but may also transmit sensor information to an external device such as an AI server (200) and perform an operation by receiving the result generated accordingly.

도 4는 본 개시의 일 실시 예에 따른 AI 장치(100)를 나타낸다.FIG. 4 illustrates an AI device (100) according to one embodiment of the present disclosure.

도 1과 중복되는 설명은 생략한다.Any description overlapping with Fig. 1 is omitted.

도 4를 참조하면, 입력부(120)는 영상 신호 입력을 위한 카메라(Camera, 121), 오디오 신호를 수신하기 위한 마이크로폰(Microphone, 122), 사용자로부터 정보를 입력 받기 위한 사용자 입력부(User Input Unit, 123)를 포함할 수 있다.Referring to FIG. 4, the input unit (120) may include a camera (Camera, 121) for inputting a video signal, a microphone (Microphone, 122) for receiving an audio signal, and a user input unit (User Input Unit, 123) for receiving information from a user.

입력부(120)에서 수집한 음성 데이터나 이미지 데이터는 분석되어 사용자의 제어 명령으로 처리될 수 있다.Voice data or image data collected from the input unit (120) can be analyzed and processed as a user's control command.

입력부(120)는 영상 정보(또는 신호), 오디오 정보(또는 신호), 데이터, 또는 사용자로부터 입력되는 정보의 입력을 위한 것으로서, 영상 정보의 입력을 위하여, AI 장치(100)는 하나 또는 복수의 카메라(121)들을 구비할 수 있다.The input unit (120) is for inputting image information (or signal), audio information (or signal), data, or information input from a user. For inputting image information, the AI device (100) may be equipped with one or more cameras (121).

카메라(121)는 화상 통화모드 또는 촬영 모드에서 이미지 센서에 의해 얻어지는 정지영상 또는 동영상 등의 화상 프레임을 처리한다. 처리된 화상 프레임은 디스플레이부(Display Unit, 151)에 표시되거나 메모리(170)에 저장될 수 있다.The camera (121) processes image frames, such as still images or moving images, obtained by the image sensor in video call mode or shooting mode. The processed image frames can be displayed on the display unit (151) or stored in the memory (170).

마이크로폰(122)은 외부의 음향 신호를 전기적인 음성 데이터로 처리한다. 처리된 음성 데이터는 AI 장치(100)에서 수행 중인 기능(또는 실행 중인 응용 프로그램)에 따라 다양하게 활용될 수 있다. 한편, 마이크로폰(122)에는 외부의 음향 신호를 입력 받는 과정에서 발생되는 잡음(noise)을 제거하기 위한 다양한 잡음 제거 알고리즘이 적용될 수 있다.The microphone (122) processes external acoustic signals into electrical voice data. The processed voice data can be utilized in various ways depending on the function being performed (or the application being executed) in the AI device (100). Meanwhile, various noise removal algorithms can be applied to the microphone (122) to remove noise generated in the process of receiving external acoustic signals.

사용자 입력부(123)는 사용자로부터 정보를 입력 받기 위한 것으로서, 사용자 입력부(123)를 통해 정보가 입력되면, 프로세서(180)는 입력된 정보에 대응되도록 AI 장치(100)의 동작을 제어할 수 있다.The user input unit (123) is for receiving information from a user. When information is input through the user input unit (123), the processor (180) can control the operation of the AI device (100) to correspond to the input information.

사용자 입력부(123)는 기계식(mechanical) 입력수단(또는, 메커니컬 키, 예컨대, 단말기(100)의 전/후면 또는 측면에 위치하는 버튼, 돔 스위치(dome switch), 조그 휠, 조그 스위치 등) 및 터치식 입력수단을 포함할 수 있다. 일 예로서, 터치식 입력수단은, 소프트웨어적인 처리를 통해 터치스크린에 표시되는 가상 키(virtual key), 소프트 키(soft key) 또는 비주얼 키(visual key)로 이루어지거나, 상기 터치스크린 이외의 부분에 배치되는 터치 키(touch key)로 이루어질 수 있다.The user input unit (123) may include a mechanical input means (or a mechanical key, for example, a button located on the front/rear or side of the terminal (100), a dome switch, a jog wheel, a jog switch, etc.) and a touch input means. As an example, the touch input means may be formed of a virtual key, a soft key, or a visual key displayed on a touch screen through software processing, or may be formed of a touch key placed on a part other than the touch screen.

출력부(150)는 디스플레이부(Display Unit, 151), 음향 출력부(Sound Output Unit, 152), 햅틱 모듈(Haptic Module, 153), 광 출력부(Optical Output Unit, 154) 중 적어도 하나를 포함할 수 있다.The output unit (150) may include at least one of a display unit (151), a sound output unit (152), a haptic module (153), and an optical output unit (154).

디스플레이부(151)는 AI 장치(100)에서 처리되는 정보를 표시(출력)한다. 예컨대, 디스플레이부(151)는 AI 장치(100)에서 구동되는 응용 프로그램의 실행화면 정보, 또는 이러한 실행화면 정보에 따른 UI(User Interface), GUI(Graphic User Interface) 정보를 표시할 수 있다.The display unit (151) displays (outputs) information processed in the AI device (100). For example, the display unit (151) can display execution screen information of an application program running in the AI device (100), or UI (User Interface) or GUI (Graphic User Interface) information according to such execution screen information.

디스플레이부(151)는 터치 센서와 상호 레이어 구조를 이루거나 일체형으로 형성됨으로써, 터치 스크린을 구현할 수 있다. 이러한 터치 스크린은, AI 장치(100)와 사용자 사이의 입력 인터페이스를 제공하는 사용자 입력부(123)로써 기능함과 동시에, 단말기(100)와 사용자 사이의 출력 인터페이스를 제공할 수 있다.The display unit (151) can implement a touch screen by forming a mutual layer structure with the touch sensor or by forming an integral structure. This touch screen can function as a user input unit (123) that provides an input interface between the AI device (100) and the user, and at the same time provide an output interface between the terminal (100) and the user.

음향 출력부(152)는 호신호 수신, 통화모드 또는 녹음 모드, 음성인식 모드, 방송수신 모드 등에서 통신부(110)로부터 수신되거나 메모리(170)에 저장된 오디오 데이터를 출력할 수 있다.The audio output unit (152) can output audio data received from the communication unit (110) or stored in the memory (170) in a call signal reception mode, call mode, recording mode, voice recognition mode, broadcast reception mode, etc.

음향 출력부(152)는 리시버(receiver), 스피커(speaker), 버저(buzzer) 중 적어도 하나 이상을 포함할 수 있다.The audio output unit (152) may include at least one of a receiver, a speaker, and a buzzer.

햅틱 모듈(haptic module)(153)은 사용자가 느낄 수 있는 다양한 촉각 효과를 발생시킨다. 햅틱 모듈(153)이 발생시키는 촉각 효과의 대표적인 예로는 진동이 될 수 있다.The haptic module (153) generates various tactile effects that the user can feel. A representative example of the tactile effect generated by the haptic module (153) may be vibration.

광출력부(154)는 AI 장치(100)의 광원의 빛을 이용하여 이벤트 발생을 알리기 위한 신호를 출력한다. AI 장치(100)에서 발생되는 이벤트의 예로는 메시지 수신, 호 신호 수신, 부재중 전화, 알람, 일정 알림, 이메일 수신, 애플리케이션을 통한 정보 수신 등이 될 수 있다.The light output unit (154) outputs a signal to notify the occurrence of an event using light from a light source of the AI device (100). Examples of events occurring in the AI device (100) may include message reception, call signal reception, missed call, alarm, schedule notification, email reception, and information reception through an application.

이하에서는 AI 장치(100), 그 동작 제어 방법 및 인공지능 서비스 시스템에 대해 기술한다.Below, an AI device (100), its operation control method, and an artificial intelligence service system are described.

이 때, AI 장치(100)는 TV, 프로젝터, 휴대폰, 스마트폰, 데스크탑 컴퓨터, 노트북, 디지털방송용 단말기, PDA(personal digital assistants), PMP(portable multimedia player), 네비게이션, 태블릿 PC, 웨어러블 장치, 셋톱박스(STB: Set-top Box), DMB 수신기, 라디오, 세탁기, 냉장고, 데스크탑 컴퓨터, 디지털 사이니지, 로봇, 차량 등과 같은, 고정형 기기 또는 이동 가능한 기기 등으로 구현될 수 있다.At this time, the AI device (100) may be implemented as a fixed device or a movable device, such as a TV, a projector, a mobile phone, a smart phone, a desktop computer, a laptop, a digital broadcasting terminal, a PDA (personal digital assistant), a PMP (portable multimedia player), a navigation device, a tablet PC, a wearable device, a set-top box (STB), a DMB receiver, a radio, a washing machine, a refrigerator, a desktop computer, digital signage, a robot, a vehicle, etc.

다만, 본 명세서에서는 본 개시에 따른 AI 장치(100)는 통신 네트워크를 통하여 전술한 기기들과 데이터를 주고받아 그를 제어하거나 제어하기 위한 스마트 허브 시스템(Smart hub system)이나 스마트 허브 시스템을 통해 상기 전술한 기기들을 제어하는 클라우드(Cloud)와 같은 서버(server)를 나타낼 수 있다. 다만, 이에 한정되는 것은 아니다.However, in this specification, the AI device (100) according to the present disclosure may represent a server such as a smart hub system for controlling or exchanging data with the aforementioned devices through a communication network or a cloud for controlling the aforementioned devices through a smart hub system. However, this is not limited thereto.

한편, 본 개시에서는 설명의 편의상 홈(Home)을 가정하여, 홈 내에서 인공지능 서비스의 구현에 대해 기술한다. 다만, 본 개시가 이에 한정되는 것은 아니다.Meanwhile, for convenience of explanation, this disclosure assumes a home and describes the implementation of artificial intelligence services within the home. However, this disclosure is not limited thereto.

도 5는 본 개시의 일실시예에 따른 인공지능 서비스 시스템을 설명하기 위해 도시한 도면이다.FIG. 5 is a diagram illustrating an artificial intelligence service system according to an embodiment of the present disclosure.

도 5를 참조하면, 인공지능 서비스 시스템은, 크게 스마트 디바이스(500), 스마트 허브 시스템(600) 및 서버(700)를 포함하여 구현될 수 있다.Referring to FIG. 5, the artificial intelligence service system can be implemented by largely including a smart device (500), a smart hub system (600), and a server (700).

전술한 도 1, 도 2 또는 도 4에 도시된 내지 4에 도시된 AI 장치(100) 또는 그 구성요소 중 적어도 하나(예를 들어, 프로세서)는 스마트 허브 시스템(600) 및 서버(700) 중 적어도 하나에 포함되거나 임베디드될 수 있다.At least one of the AI devices (100) or components thereof (e.g., a processor) illustrated in FIG. 1, FIG. 2 or FIG. 4 described above may be included or embedded in at least one of the smart hub system (600) and the server (700).

서버(700)는 도 3에서 AI 서버(200)일 수 있으며, 스마트 디바이스(500)와 스마트 허브 시스템(600)는 도 3의 클라우드 네트워크(10)와 연결되어 AI 서버(200)와 통신하는 로봇(100a), 자율 주행 차량(100b), XR 장치(100c), 스마트폰(100d) 또는 가전(100e) 중에서 적어도 하나 이상일 수 있다.The server (700) may be an AI server (200) in FIG. 3, and the smart device (500) and the smart hub system (600) may be at least one of a robot (100a), an autonomous vehicle (100b), an XR device (100c), a smartphone (100d), or a home appliance (100e) that is connected to the cloud network (10) of FIG. 3 and communicates with the AI server (200).

스마트 디바이스(500)에는, 스마트 가전, 홈 엔터테인먼트 시스템, 보안 시스템, 센서 등이 포함될 수 있다. 다만, 이는 편의상 분류한 것으로, 본 개시가 이러한 분류에 의해 제한 해석되는 것은 아니다. 예컨대, 스마트 디바이스(500)는 후술하는 스마트 허브 시스템(600) 및 서버(700) 중 적어도 하나에 의해 그 동작이 제어되는 대상 기기를 나타낼 수 있다.The smart device (500) may include smart home appliances, home entertainment systems, security systems, sensors, etc. However, this is a classification for convenience, and the present disclosure is not limited by this classification. For example, the smart device (500) may represent a target device whose operation is controlled by at least one of the smart hub system (600) and server (700) described below.

또한, 스마트 디바이스(500)는 전술한 도 1 내지 4에서 기술한 AI 장치(100)를 위한 구성요소들 중 적어도 하나 이상을 포함한 기기를 나타낼 수 있다.Additionally, the smart device (500) may represent a device including at least one of the components for the AI device (100) described in FIGS. 1 to 4 above.

한편, 본 개시에서 스마트 디바이스(500)는 Matter를 지원하는 디바이스를 나타낼 수 있으나, 이에 한정되는 것은 아니다.Meanwhile, in the present disclosure, the smart device (500) may represent a device that supports Matter, but is not limited thereto.

스마트 디바이스(500)는 DQ-C 보드를 이용하여 동작, 정보 및 연결 표시를 할 수 있다.A smart device (500) can operate, display information, and connect using the DQ-C board.

스마트 가전에는 예를 들어, 냉장고, 인덕션, 전자레인지, 정수기, 세탁기 및 건조기, 에어컨, 전등 등 조명 시스템, 식기세척기, 스타일러스 등이 포함될 수 있다.Smart appliances may include, for example, refrigerators, induction cookers, microwave ovens, water purifiers, washing machines and dryers, air conditioners, lighting systems such as lights, dishwashers, and styluses.

홈 엔터테인먼트 시스템에는 예를 들어, 디지털 TV, 블루투스/인공지능 스피커, 각종 오디오 시스템, 디지털 액자 등이 포함될 수 있다.Home entertainment systems may include, for example, digital TVs, Bluetooth/AI speakers, various audio systems, and digital picture frames.

보안 시스템에는 예를 들어, 스마트 도어벨(smart doorbell), CCTV(Closed Caption TV)와 같은 보안 카메라(security camera) 등이 포함될 수 있다.Security systems may include, for example, smart doorbells, security cameras such as Closed Caption TVs (CCTVs), etc.

센서에는 예를 들어, 마이크로폰, 카메라/이미지 센서, 근접 센서, GPS 센서, 모션 센서, 온도 센서 등이 포함될 수 있다. 상기 센서는 유선 또는 무선 기반 센서를 모두 포함할 수 있다.Sensors may include, for example, microphones, cameras/image sensors, proximity sensors, GPS sensors, motion sensors, temperature sensors, etc. The sensors may include both wired or wireless based sensors.

도 5에서는 스마트 디바이스(500)에 보안 시스템이나 센서가 포함되는 것으로 도시하였으나, 이에 한정되는 것은 아니며, 인공지능 서비스 시스템을 위한 스마트 디바이스(500)와는 별개의 구성요소일 수도 있다.In FIG. 5, a security system or sensor is illustrated as being included in a smart device (500), but it is not limited thereto, and may be a separate component from the smart device (500) for the artificial intelligence service system.

스마트 허브 시스템(600)은 스마트 디바이스(500)로부터 매시브 데이터(massive data)를 수집 또는 획득할 수 있으며, 스마트 디바이스(500)로 제어 신호를 전송할 수 있다. 이 때, 상기 제어 신호는 전술한 바와 같이, 스마트 허브 시스템(600)에서 직접 생성된 것일 수도 있고, 서버(700)에서 생성된 제어 신호를 수신하여 스마트 디바이스(500)로 전송하는 것일 수도 있다.The smart hub system (600) can collect or obtain massive data from the smart device (500) and transmit a control signal to the smart device (500). At this time, the control signal may be generated directly from the smart hub system (600), as described above, or may be generated from a server (700) and transmitted to the smart device (500).

한편, 스마트 허브 시스템(600) 및 서버(700) 중 적어도 하나를 통한 스마트 디바이스(500)에 대한 제어 내지 제어 신호의 전송은 실시간(real-time control)으로 이루어질 수 있다.Meanwhile, transmission of control or control signals to a smart device (500) through at least one of a smart hub system (600) and a server (700) can be performed in real-time (real-time control).

도 5를 참조하면, 스마트 허브 시스템(600)은 통신 인터페이스부(610), 센싱 데이터 처리부(620), 데이터 획득 서브시스템(630), 데이터 분석 서브시스템(640), 홈 오토메이션 서브시스템(650) 등을 포함하여 구성될 수 있다. 다만, 본 개시는 이에 한정되는 것은 아니며, 도 5에 도시되지 않은 적어도 하나의 구성요소가 더 포함되거나 반대일 수 있다. 또한, 도 5에 도시된 복수의 구성요소가 모듈화되어 하나의 구성요소로 구현될 수도 있다.Referring to FIG. 5, the smart hub system (600) may be configured to include a communication interface unit (610), a sensing data processing unit (620), a data acquisition subsystem (630), a data analysis subsystem (640), a home automation subsystem (650), etc. However, the present disclosure is not limited thereto, and at least one component not shown in FIG. 5 may be further included or vice versa. In addition, a plurality of components shown in FIG. 5 may be modularized and implemented as a single component.

통신 인터페이스부(610)는 스마트 디바이스(500)로부터 매시브 데이터를 획득하거나 스마트 디바이스(500)/보안 시스템이나 센서로 실시간 제어 신호를 전송하기 위하여 필요한 유무선 통신 네트워크를 제공하거나 그를 통한 데이터 커뮤니케이션을 위한 통신 인터페이스를 지원할 수 있다.The communication interface unit (610) may provide a wired or wireless communication network required to obtain massive data from a smart device (500) or transmit real-time control signals to a smart device (500)/security system or sensor, or support a communication interface for data communication therethrough.

통신 인터페이스부(610)는 Matter를 적용하여 디바이스 간 연결 및 제어를 할 수 있도록 지원할 수 있다.The communication interface unit (610) can support connection and control between devices by applying Matter.

센싱 데이터 처리부(620)는 센서로부터 센싱 데이터를 획득하거나 센서로 제어 신호를 전송하기 위한 통신 프로토콜을 지원하거나 센서로부터 수신한 데이터를 스마트 허브 시스템(600)에서 처리할 수 있는 데이터 포맷으로 변환 등 처리(interoperability)할 수 있다. 실시 예에 따라서, 센싱 데이터 처리부(620)는 통신 인터페이스부(610)와 모듈화되거나 통신 인터페이스부(610)에서 센싱 데이터 처리부(620)의 기능을 대신 수행할 수 있다. 실시 예에 따라서, 센싱 데이터 처리부(620)는 실시간 제어 신호를 스마트 디바이스(500)로 전송하는 경우에만 동작할 수도 있다.The sensing data processing unit (620) may obtain sensing data from a sensor, support a communication protocol for transmitting a control signal to a sensor, or process (interoperability) data received from a sensor by converting it into a data format that can be processed by a smart hub system (600). Depending on the embodiment, the sensing data processing unit (620) may be modularized with the communication interface unit (610), or the communication interface unit (610) may perform the function of the sensing data processing unit (620). Depending on the embodiment, the sensing data processing unit (620) may operate only when transmitting a real-time control signal to a smart device (500).

데이터 획득 서브시스템(630)은 센서를 포함하여 스마트 디바이스(500)로부터 획득되는 로 데이터(raw data)를 수신하여 구조화된 데이터(structured data) 예를 들어, 분석을 위한 데이터를 획득(추출)할 수 있다.The data acquisition subsystem (630) can receive raw data acquired from a smart device (500) including a sensor and acquire (extract) structured data, for example, data for analysis.

이를 위해, 데이터 획득 서브시스템(630)은 예를 들어, 사용자의 의도나 상황 파악을 위한 온-디바이스 인공지능 추론을 위한 구성을 포함할 수 있다. 이 때, 구성은 예를 들어, 상기 온-디바이스 인공지능 추론을 위한 프로그램 등 소프트웨어를 포함한 하드웨어 장치일 수 있다.To this end, the data acquisition subsystem (630) may include, for example, a configuration for on-device artificial intelligence inference for understanding the user's intention or situation. At this time, the configuration may be, for example, a hardware device including software such as a program for the on-device artificial intelligence inference.

데이터 획득 서브시스템(630)은 오디오, 비디오, 이미지 데이터를 디코딩하는 디코더, 필요에 따라 로 데이터를 분석을 위한 데이터 포맷으로 가공하기 위한 구성 등을 포함하여 구성될 수 있다.The data acquisition subsystem (630) may be configured to include a decoder for decoding audio, video, and image data, and a configuration for processing raw data into a data format for analysis as needed.

데이터 획득 서브시스템(630)은 IoT(Internet of Things) 프레임워크(framework)의 비전/이미지(vision/image) 처리를 적용할 수 있다. 이 과정에서, DNN(Deep Neural Network), 멀티-모달 데이터(multi-modal data)가 이용될 수 있다.The data acquisition subsystem (630) can apply vision/image processing of the IoT (Internet of Things) framework. In this process, DNN (Deep Neural Network) and multi-modal data can be used.

데이터 분석 서브시스템(640)은 데이터 획득 서브시스템(630)에 의해 획득된 데이터를 분석할 수 있다. 이를 통해, 데이터 분석 서브시스템(640)은 분석 결과에 기초하여 사용자의 상황 인식 데이터(상태 인식 데이터), 가전의 상태 데이터 등을 포함하여 각종 데이터를 생성할 수 있다.The data analysis subsystem (640) can analyze data acquired by the data acquisition subsystem (630). Through this, the data analysis subsystem (640) can generate various data, including user situational awareness data (state awareness data), home appliance status data, etc., based on the analysis results.

데이터 분석 서브시스템(640)은 서비스, 어플리케이션 등에서 필요로 하는 정보(예를 들어, 사용자 정보, 모션 등)을 분석하고 그 의도를 파악할 수 있도록 구현될 수 있다.The data analysis subsystem (640) can be implemented to analyze information (e.g., user information, motion, etc.) required by services, applications, etc. and to determine its intent.

홈 오토메이션 서브시스템(650)은 데이터 분석 서브시스템(640)에서 생성된 각종 데이터에 기반하여 스마트 디바이스(500)를 제어하기 위한 제어 명령이 포함된 제어 신호를 생성할 수 있다. 이를 위해, 홈 오토메이션 서브시스템(650)은 제어 대상 후보 스마트 디바이스를 선정하거나 최종 제어 대상 스마트 디바이스를 결정할 수 있다.The home automation subsystem (650) can generate a control signal including a control command for controlling a smart device (500) based on various data generated by the data analysis subsystem (640). To this end, the home automation subsystem (650) can select a candidate smart device to be controlled or determine a final smart device to be controlled.

홈 오토메이션 서브시스템(650)은 데이터 분석 서브시스템(640)에서 생성된 각종 데이터와 스마트 디바이스 제어 신호 등을 맵핑하여 메모리(미도시)에 저장되도록 할 수 있다.The home automation subsystem (650) can map various data generated by the data analysis subsystem (640) and smart device control signals and store them in memory (not shown).

홈 오토메이션 서브시스템(650)은 제어 신호가 생성되면 이를 통신 인터페이스부(610)와 센싱 데이터 처리부(620) 중 적어도 하나를 통해 스마트 디바이스(500)로 전송할 수 있다.When a control signal is generated, the home automation subsystem (650) can transmit it to a smart device (500) through at least one of the communication interface unit (610) and the sensing data processing unit (620).

홈 오토메이션 서브시스템(650)는 PoC(Point of Connection) 시나리오를 선정 및 구현할 수 있다.The home automation subsystem (650) can select and implement a PoC (Point of Connection) scenario.

마지막으로, 서버(700)는 전술한 바와 같이, 클라우드 형태로 구현될 수 있으며, 원격에 위치할 수 있다. 이 경우, 서버(700)는 예를 들어, 스마트 디바이스(500)의 제조업체에서 제공 또는 운영하는 서버일 수 있다.Finally, the server (700) may be implemented in a cloud form as described above and may be located remotely. In this case, the server (700) may be, for example, a server provided or operated by the manufacturer of the smart device (500).

서버(700)는 스마트 허브 시스템(600)으로부터 서브셋 정보(subset information)을 획득하여, 획득한 서브셋 정보에 기초하여 스마트 디바이스(500)를 원격 제어하기 위한 제어 명령이 포함된 제어 신호를 생성하여 스마트 허브 시스템(600)으로 전송할 수 있다.The server (700) can obtain subset information from the smart hub system (600), generate a control signal including a control command for remotely controlling the smart device (500) based on the obtained subset information, and transmit the control signal to the smart hub system (600).

도 6은 본 개시의 일실시예에 따른 인공지능 서비스 시스템의 인공지능 기기 동작 제어 방법을 설명하기 위해 도시한 순서도이다.FIG. 6 is a flowchart illustrating a method for controlling operation of an artificial intelligence device of an artificial intelligence service system according to an embodiment of the present disclosure.

도 6을 참조하면, 본 개시에 따른 동작 제어 방법의 일 예는, 다음과 같이 이루어질 수 있다. 다만, 본 개시가 이에 한정되는 것은 아니다.Referring to FIG. 6, an example of a motion control method according to the present disclosure may be performed as follows. However, the present disclosure is not limited thereto.

한편, 이하에서 스마트 허브 시스템(600)은 설명의 편의상 AI 장치(100)로 기술한다.Meanwhile, for convenience of explanation, the smart hub system (600) is described below as an AI device (100).

S101 단계에서, AI 장치(100)는 적어도 하나 이상의 센서로부터 센싱 데이터를 획득할 수 있다.At step S101, the AI device (100) can obtain sensing data from at least one sensor.

S103 단계에서, AI 장치(100)는 센싱 데이터에 기초하여 사용자에 대한 이벤트 발생을 모니터링(monitoring)할 수 있다.At step S103, the AI device (100) can monitor the occurrence of an event for the user based on sensing data.

이 때, 이벤트는 다양하게 정의할 수 있으나, 설명의 편의상 사용자가 홈 내 특정 공간을 향해 이동과 같은 사용자의 움직임 인식, 사용자의 특정 공간으로의 진입 인식 등을 나타낼 수 있으나, 이에 한정되는 것은 아니다.At this time, an event can be defined in various ways, but for convenience of explanation, it can represent, but is not limited to, recognition of a user's movement, such as a user moving toward a specific space within a home, or recognition of a user's entry into a specific space.

S105 단계에서, AI 장치(100)는 모니터링 결과 이벤트가 발생한 경우, 사용자 및 사용자의 현재 위치를 식별할 수 있다.At step S105, the AI device (100) can identify the user and the user's current location when a monitoring result event occurs.

S107 내지 S109 단계에서, AI 장치(100)는 식별된 사용자 및 사용자의 현재 위치에 관한 위치 정보에 기초하여, 제1 제어 후보 대상 가전을 선정하고, 선정된 제1 제어 후보 대상 가전의 상태 데이터를 획득할 수 있다.In steps S107 to S109, the AI device (100) can select a first control candidate target home appliance based on location information about the identified user and the user's current location, and obtain status data of the selected first control candidate target home appliance.

S111 단계에서, AI 장치(100)는 센싱 데이터, 상태 데이터 및 메모리로부터 독출된 식별된 사용자에 대해 기 저장된 데이터에 기초하여 사용자의 상황 인식 데이터(상태 데이터)를 생성할 수 있다.At step S111, the AI device (100) can generate user situational awareness data (state data) based on sensing data, state data, and previously stored data about the identified user read from memory.

S113 단계에서, AI 장치(100)는 S111 단계에서 생성한 사용자의 상황 인식 데이터에 기반하여 최종 제어 대상 가전을 결정하고, 결정된 가전의 상태 데이터를 참조하여 해당 가전을 제어하기 위한 동작 제어 신호를 생성 및 전송할 수 있다.In step S113, the AI device (100) can determine a final control target home appliance based on the user's situational awareness data generated in step S111, and generate and transmit an operation control signal for controlling the corresponding home appliance by referring to the status data of the determined home appliance.

한편, S103 단계에서, AI 장치(100)는 만약 이벤트가 발생하지 않았거나 미리 정의된 시간동안 추가 이벤트가 발생 또는 발생하지 않는 경우에는, 다음과 같은 동작을 수행할 수 있다.Meanwhile, at step S103, the AI device (100) can perform the following actions if an event has not occurred or an additional event has occurred or does not occur for a predefined time.

이 때, 미리 정의된 시간의 설정은 고정된 값일 수도 있으나, 사용자, 가전, 이전 이벤트에 따른 동작 제어 내용 등 중 적어도 하나 이상을 참조하여, 매번 다른 값이 설정될 수 있다.At this time, the setting of the predefined time may be a fixed value, but a different value may be set each time by referring to at least one of the user, the home appliance, the operation control contents according to the previous event, etc.

S115 단계에서, AI 장치(100)는 사용자의 현재 상태를 파악하기 위한 센싱 데이터를 수집 또는 획득할 수 있다. 이를 위해, 사용자의 단말, 센서 등이 이용되거나 그의 센싱 데이터가 이용될 수 있다.At step S115, the AI device (100) can collect or obtain sensing data to determine the user's current status. To this end, the user's terminal, sensor, etc. may be used, or its sensing data may be used.

S117 단계에서, AI 장치(100)는 S115 단계에서 수집 또는 획득한 센싱 데이터로부터 사용자의 현재 상태를 파악하고, 스마트 디바이스의 제어가 필요한지 여부를 판별할 수 있다. 이 때, 스마트 디바이스는 현재 AI 장치(100)에 의해 동작 제어 신호를 수신하여 동작 대기, 동작 중 또는 동작 완료한 스마트 디바이스를 나타낼 수 있다. 동작 완료한 스마트 디바이스는 만약 사용자 또는 AI 장치(100)에 의해서 동작 제어가 완전히 종료된 것으로 처리된 기기는 대상 스마트 디바이스에서 제외될 수 있다.In step S117, the AI device (100) can determine the current status of the user from the sensing data collected or acquired in step S115, and determine whether control of the smart device is necessary. At this time, the smart device can receive an operation control signal from the current AI device (100) to indicate a smart device that is in operation standby, in operation, or has completed operation. A smart device that has completed operation can be excluded from the target smart devices if the operation control is processed as being completely terminated by the user or the AI device (100).

S119 단계에서, AI 장치(100)는 스마트 디바이스의 제어가 필요한 것으로 판별된 경우에는, 대상 스마트 디바이스의 상태 데이터를 재수집할 수 있다.At step S119, if the AI device (100) determines that control of the smart device is necessary, it can re-collect status data of the target smart device.

반면, AI 장치(100)는 스마트 디바이스의 제어가 필요하지 않은 것으로 판별된 경우에는, 대기 명령을 전송하거나 초기 모드(즉, S101 단계 이전)로 돌아갈 수 있다.On the other hand, if the AI device (100) determines that control of the smart device is not necessary, it can transmit a standby command or return to the initial mode (i.e., before step S101).

S121 단계에서, AI 장치(100)는 S119 단계에서 재수집한 대상 스마트 디바이스의 상태 데이터에 기초하여, 사용자의 현재 상태 대비 대상 스마트 디바이스에 대한 제어 내용을 결정하여, 제어 신호를 전송할 수 있다.In step S121, the AI device (100) can determine control contents for the target smart device based on the current state of the user based on the state data of the target smart device recollected in step S119, and transmit a control signal.

하나의 공간 상에서 복수의 스마트 디바이스가 존재하고 복수의 이벤트가 있는 경우에는 AI 장치(100)는 매 이벤트에 대응하여 제어 대상 스마트 디바이스를 판별하고, 이벤트에 대응 여부, 대응 시 대응 내용 등을 결정하는 것이 바람직하다.When multiple smart devices exist in a single space and there are multiple events, it is desirable for the AI device (100) to determine the smart device to be controlled in response to each event and determine whether to respond to the event and, if so, the response content.

전술한 내용은, 결국 이전 이벤트 발생에 따른 동작 제어 이후에 사용자의 추가 이벤트에 따라서, 이전 이벤트 제어에 대한 AI 장치(100)에서 추가적인 동작을 해 줄 필요에 의한 것일 수 있다. 예를 들어, 사용자가 조리 중 이벤트 발생에 따라 인덕션 상의 조리기구의 온도가 50℃로 동작되도록 제어 신호가 전송되었다고 하자. 이 경우에 만약 소정 시간이 지났음에도 사용자가 조리기구에 대한 어떠한 관심이나 움직임이 없다고 인지되거나 사용자가 해당 공간을 벗어나 소정 시간동안 돌아오지 않는 경우에는, 사고 방지 또는 사용자의 의도에 부합하도록 하기 위해 인덕션에 대한 자동 제어가 필요할 수 있다. 상기에서, 추가 이벤트는 미리 정의된 시간 동안 추가 이벤트가 없는 경우도 포함할 수 있다.The above-mentioned content may be due to the need for the AI device (100) to perform additional actions for the previous event control according to the user's additional event after the action control according to the previous event occurrence. For example, let's say that a control signal is transmitted so that the temperature of the cookware on the induction is operated at 50°C according to the occurrence of an event while the user is cooking. In this case, if it is recognized that the user has no interest or movement in the cookware even after a predetermined time has passed or the user leaves the space and does not return for a predetermined time, automatic control of the induction may be required to prevent an accident or to match the user's intention. In the above, the additional event may also include a case where there is no additional event for a predefined time.

한편, 도시되진 않았으나, 사용자에 의한 하나의 이벤트가 만약 복수의 스마트 디바이스와 연관되는 경우에는, 복수의 스마트 디바이스들을 동시에 또는 순차로 제어할 수도 있고, 복수의 스마트 디바이스들 중 최우선순위나 미리 정의된 가중치에 기초하여 가중치가 가장 높은 하나 또는 그 이상의 스마트 디바이스들만 개별 제어할 수도 있다. 이는 추가 이벤트 발생에 따른 대응 동작의 경우에도 적용될 수 있다.Meanwhile, although not shown, if one event by a user is associated with multiple smart devices, the multiple smart devices can be controlled simultaneously or sequentially, or only one or more smart devices with the highest priority or highest weight based on predefined weights among the multiple smart devices can be individually controlled. This can also be applied to response actions according to the occurrence of additional events.

도 7은 본 발명의 일실시예에 따른 홈 상태 감지를 위한 AI 네트워크 아키텍처를 설명하기 위해 도시한 도면이다.FIG. 7 is a diagram illustrating an AI network architecture for home status detection according to one embodiment of the present invention.

도 8은 본 발명의 일실시예에 따른 인공지능 학습 모델을 설명하기 위해 도시한 도면이다.FIG. 8 is a diagram illustrating an artificial intelligence learning model according to an embodiment of the present invention.

도 7을 참조하면, 기본적으로 AI 네트워크 아키텍처는 크게 3부분으로 구성될 수 있다. 제1 부분은 Convolution 1, Convolution 2, 및 Pooling으로 구성된 합성곱 신경망(CNN: Convolutional Neural Network)을 포함하고, 제2 부분은 LSTM(Long Short-Term Memory)으로 구성된 RNN(Recurrent Neural Network)을 포함하고, 제3 부분은 Fully connected 1, Fully connected 2, 및 Softmax로 구성된 분류 부분(Classification part)을 나타낼 수 있다.Referring to Fig. 7, the AI network architecture can basically be largely composed of three parts. The first part includes a convolutional neural network (CNN) composed of

상기에서, 합성곱 신경망(CNN)은, 입력 데이터에서 반복적인 활동(특징)을 인식하기 위해 이용될 수 있다. 그리고 RNN은 활동 간의 시간 순서 관계 인식을 위해 이용될 수 있다. 또한, 분류 부분은 출력 시나리오 분류를 수행할 수 있다.In the above, a convolutional neural network (CNN) can be used to recognize repetitive activities (features) in input data. And an RNN can be used to recognize temporal order relationships between activities. In addition, the classification part can perform output scenario classification.

상기에서, RNN과 관련하여, RNN은 시간 경과에 따른 관찰 시퀀스, 즉 UMP에서의 동작 시퀀스와 같은 시퀀스 데이터에서 학습하도록 설계될 수 있다. 도 7을 참조하면, LSTM이 도시되었으며, LSTM은 가장 널리 사용되는 RNN 계층으로, 서로 다른 데이터 프레임 사이의 시퀀스를 기억하도록 훈련된 내부 메모리(매개변수)가 있을 수 있다. 예를 들어, 요리 시나리오는 여러 입력 프레임(1 프레임은 60초 길이의 데이터)에 걸쳐 발생할 수 있으며, LSTM 계층은 이 시퀀스를 인식하고 시나리오를 올바르게 예측하는 데 사용될 수 있다.In the above, with respect to RNN, RNN can be designed to learn from sequence data, such as observation sequences over time, i.e., action sequences in UMP. Referring to Fig. 7, LSTM is illustrated, and LSTM is the most widely used RNN layer, which can have internal memory (parameters) trained to remember sequences between different data frames. For example, a cooking scenario can occur across multiple input frames (one frame is 60 seconds of data), and the LSTM layer can be used to recognize this sequence and correctly predict the scenario.

도 7에서 홈 시나리오의 특성과 관련하여, 홈 시나리오 인식은 특정 시간 창 및 시간 제약에서 관심 있는 시나리오를 형성하는 일련의 사용자 동작을 감지하는 것이 바람직하다. 예를 들어, 요리/외출 시나리오의 경우, 시간 제약과 활동 순서가 광범위하여 집집마다 매우 다르기 때문에, 사용자 집에서 재교육이 필요할 수 있다. 또한, 집집마다 센서의 종류와 개수가 다르기 때문에, 감지 알고리즘은 입/출력 크기 변경이 용이한 것이 바람직할 수 있다.In relation to the characteristics of the home scenario in Fig. 7, it is desirable that the home scenario recognition detects a series of user actions forming a scenario of interest within a specific time window and time constraints. For example, in the case of the cooking/going out scenario, since the time constraints and activity sequences are extensive and very different from house to house, retraining may be required at the user's house. In addition, since the types and numbers of sensors vary from house to house, it may be desirable that the detection algorithm is easy to change the input/output size.

전술한 홈 시나리오 특성과 관련하여, AI 네트워크를 이용한 홈 상태 감지에 관해 기술하면, 기본적으로 AI 네트워크는 각 홈 상태를 출력 클래스로 감지하는 분류 심층 신경망을 포함할 수 있으며, 홈 상태 데이터에서 특징 추출을 수행하고 시간의 맥락에서 관심 시나리오를 형성하는 패턴을 학습할 수 있다. 이와 같이, AI 기술을 이용하여 홈 상태를 감지하게 되면, 네트워크 입력 및 출력 크기 변경/확장 용이할 수 있으며, 사용자 가정에서 실시하기 쉬운 단속 교육이 가능하고, 더불어 높은 감지 정확도를 제공할 수 있다.In relation to the aforementioned home scenario characteristics, when describing home state detection using an AI network, the AI network can basically include a classification deep neural network that detects each home state as an output class, performs feature extraction from home state data, and learns patterns that form interest scenarios in the context of time. In this way, if home states are detected using AI technology, the network input and output sizes can be easily changed/expanded, and easy-to-implement crackdown training can be performed at the user's home, and high detection accuracy can be provided.

한편, AI 기술을 이용함에 있어서, 입력 데이터에 대한 전처리가 필요할 수 있다. 관련하여, 홈 센서 사용 데이터에는 시간, 모션 센서, 냉장고/인덕션 사용 상태, 온도, 현관 상태 센서 등에 의한 센싱 데이터가 참고될 수 있으며, 센서 장치 상태는 초당 1번 샘플링(sampling)될 수 있으나, 이에 한정되는 것은 아니다. 한편, 데이터는 센서 사용 가능 상태를 기반으로 디지털화될 수 있어 예를 들어, [-1, 1] 범위의 부동 소수점 값으로 정규화(normalization) 할 수 있다. 또한, 매초마다 AI 네트워크에 대한 새로운 데이터 행을 수집할 수 있으며, 센서 데이터는 예를 들어, 5초 동안 누적되어 AI 네트워크로 전송될 수 있으나, 반드시 이에 한정되는 것은 아니다.Meanwhile, when utilizing AI technology, preprocessing of input data may be required. In this regard, home sensor usage data may refer to sensing data by time, motion sensor, refrigerator/induction usage status, temperature, and entrance status sensor, and the sensor device status may be sampled once per second, but is not limited thereto. Meanwhile, data may be digitized based on the sensor availability status, and may be normalized, for example, to a floating point value in the range of [-1, 1]. In addition, a new data row for the AI network may be collected every second, and sensor data may be accumulated for, for example, 5 seconds and transmitted to the AI network, but is not necessarily limited thereto.

또한, AI 네트워크 입력 데이터 형식은 다음을 참조할 수 있다. AI 네트워크는 필요한 패턴과 활동 순서를 감지하기 위해 충분히 긴 타이밍 창에서 데이터를 볼 필요가 있다. 한번에 입력되는 데이터 형식은 새로운 데이터 + 히스토리 데이터(중첩 데이터)를 포함할 수 있다. 이 때, 입력 형식은 T x N 크기의 2D 배열일 수 있으며, 상기 T는 시간 창 크기를 나타내고, N은 센서 데이터의 수를 나타낼 수 있다. 다시 말해, 시간 창 T = new_time_period + overlap_time_period으로 산출할 수 있다.In addition, the AI network input data format can refer to the following. The AI network needs to see data in a sufficiently long timing window to detect the required pattern and activity sequence. The data format input at one time may include new data + history data (overlapped data). At this time, the input format may be a 2D array of size T x N, where T represents the time window size and N represents the number of sensor data. In other words, the time window T = new_time_period + overlap_time_period can be calculated.

다음으로, 도 8을 참조하여 인공지능 학습 엔진, 모델 또는 학습 과정을 설명한다.Next, an artificial intelligence learning engine, model, or learning process is described with reference to FIG. 8.

본 개시에서 인공지능 기술은 전이학습(transfer learning) 기반일 수 있으나, 이에 한정되는 것은 아니다.In the present disclosure, the artificial intelligence technology may be based on transfer learning, but is not limited thereto.

먼저, 도 8의 (a)를 참조하면, 결합된 데이터를 이용하여 상황을 인식하기 위한 인공지능 상황 인식을 위한 도 5에 도시된 바와 같은 상황 인식 서브시스템을 구성할 수 있다.First, referring to (a) of Fig. 8, a situation awareness subsystem, such as that shown in Fig. 5, for artificial intelligence situation awareness to recognize a situation using combined data can be configured.

서브시스템(또는 인공지능 엔진)은 사용자의 가전/IoT 디바이스 사용 패턴이 학습된 개인화 학습 데이터를 입력 데이터로 하여, 외부 연결 장치와의 인터페이스를 통해 입력되는 센싱 데이터. 미래에 센서가 추가 가능하도록 리던던시(redundancy)를 갖는 구조에 기초하여, 일시적인 데이터(temporal data)와 개인 학습 데이터를 기반으로 추론한 스마트 홈의 상황에 대한 센서 데이터(S), 스마트 디바이스(가전) 데이터(HA), 상황인식 결과 데이터(St)를 학습할 수 있다.The subsystem (or AI engine) uses personalized learning data learned from the user's home appliance/IoT device usage patterns as input data, and based on a structure that has redundancy so that sensors can be added in the future, it can learn sensor data (S), smart device (home appliance) data (HA), and situational awareness result data (St) about the smart home situation inferred based on temporal data and personalized learning data.

도 8의 (b)를 참조하면, 실시간 인공지능 상황 인식 서브시스템의 업그레이드는 다음과 같이 이루어질 수 있다. 가전/IoT 디바이스 센싱 입력 데이터를 입력 데이터로 하여, 인공지능 상황 서브 시스템의 추론된 상황 결과를 획득하고, 센싱 데이터 임시 저장 공간을 거쳐, 일시적인 센서 데이터(Temporal sensor data)와 인공지능 상황 서브시스템 결과를 입력하고, 목적이 분명한 가전 상태를 그라운드-트루쓰(Ground-truth)로 활용하여 개인화 학습 데이터를 실시간 학습할 수 있다. 이를 통해, 상황 인식 서브시스템은, 학습된 개인화 학습 데이터를 업그레이드할 수 있게 된다.Referring to Fig. 8 (b), the upgrade of the real-time artificial intelligence situational awareness subsystem can be performed as follows. Using home appliance/IoT device sensing input data as input data, the inferred situation result of the artificial intelligence situational awareness subsystem is acquired, and through the sensing data temporary storage space, temporary sensor data and the artificial intelligence situational awareness subsystem result are input, and the home appliance state with a clear purpose is utilized as ground truth to learn personalized learning data in real time. Through this, the situational awareness subsystem can upgrade the learned personalized learning data.

이하, 도 9 내지 12에서는 본 개시가 적용되는 구체적인 시나리오(키친에서 조리 시나리오)를 예로 하여 설명하나, 본 개시가 설명되는 스마트 디바이스나 시나리오에만 한정되는 것은 아니다.Hereinafter, FIGS. 9 to 12 describe specific scenarios (kitchen cooking scenarios) to which the present disclosure is applied as examples, but the present disclosure is not limited to the smart devices or scenarios described.

도 9는 키친/리빙 공간 내부의 가전/IoT 데이터 기반으로 상황을 단계별로 구분하여 인식함으로써 인식 성능 개선 및 최적의 서비스 연동 가능에 대해 설명하기 위해 도시한 것이고, 도 10은 AI 장치(100)(예를 들어, 스마트 허브(500))에서 키친 공간에서의 가전/IoT 디바이스 정보 및 외부 정보 기반 조리 준비 상황으로 인식한 경우를, 도 11은 스마트 허브에서 키친 공간에서의 가전/IoT 디바이스 정보 및 외부 정보 기반 조리 중 상황으로 인식한 경우를, 그리고 도 12는 스마트 허브에서 키친 공간에서의 가전/IoT 디바이스 정보 및 외부 정보 기반 조리 후 상황으로 인식한 경우에 대한 시나리오일 수 있다.FIG. 9 illustrates a scenario in which a situation is recognized by dividing the situation into stages based on home appliance/IoT data inside a kitchen/living space, thereby improving recognition performance and enabling optimal service linkage. FIG. 10 illustrates a scenario in which an AI device (100) (e.g., a smart hub (500)) recognizes a cooking preparation situation based on home appliance/IoT device information and external information in a kitchen space. FIG. 11 illustrates a scenario in which a smart hub recognizes a cooking situation based on home appliance/IoT device information and external information in a kitchen space. FIG. 12 illustrates a scenario in which a smart hub recognizes a cooking situation based on home appliance/IoT device information and external information in a kitchen space.

이 때, 스마트 허브(500)는 은닉 마르코프 모델(HMM: Hidden Markov Model) 알고리즘 기반으로 상황 인식 추정을 할 수 있으나, 이에 한정되는 것은 아니다.At this time, the smart hub (500) can estimate situational awareness based on a hidden Markov Model (HMM) algorithm, but is not limited thereto.