KR102283934B1 - Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET image - Google Patents

Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET imageDownload PDFInfo

- Publication number

- KR102283934B1 KR102283934B1KR1020180141885AKR20180141885AKR102283934B1KR 102283934 B1KR102283934 B1KR 102283934B1KR 1020180141885 AKR1020180141885 AKR 1020180141885AKR 20180141885 AKR20180141885 AKR 20180141885AKR 102283934 B1KR102283934 B1KR 102283934B1

- Authority

- KR

- South Korea

- Prior art keywords

- image

- virtual

- pet

- network

- attenuation

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/52—Devices using data or image processing specially adapted for radiation diagnosis

- A61B6/5205—Devices using data or image processing specially adapted for radiation diagnosis involving processing of raw data to produce diagnostic data

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/02—Arrangements for diagnosis sequentially in different planes; Stereoscopic radiation diagnosis

- A61B6/03—Computed tomography [CT]

- A61B6/032—Transmission computed tomography [CT]

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/02—Arrangements for diagnosis sequentially in different planes; Stereoscopic radiation diagnosis

- A61B6/03—Computed tomography [CT]

- A61B6/037—Emission tomography

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/003—Reconstruction from projections, e.g. tomography

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10072—Tomographic images

- G06T2207/10104—Positron emission tomography [PET]

Landscapes

- Health & Medical Sciences (AREA)

- Life Sciences & Earth Sciences (AREA)

- Engineering & Computer Science (AREA)

- Medical Informatics (AREA)

- Physics & Mathematics (AREA)

- Heart & Thoracic Surgery (AREA)

- Surgery (AREA)

- Nuclear Medicine, Radiotherapy & Molecular Imaging (AREA)

- Optics & Photonics (AREA)

- Pathology (AREA)

- Radiology & Medical Imaging (AREA)

- Biomedical Technology (AREA)

- Biophysics (AREA)

- Molecular Biology (AREA)

- High Energy & Nuclear Physics (AREA)

- Animal Behavior & Ethology (AREA)

- General Health & Medical Sciences (AREA)

- Public Health (AREA)

- Veterinary Medicine (AREA)

- Theoretical Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Pulmonology (AREA)

- Nuclear Medicine (AREA)

- Apparatus For Radiation Diagnosis (AREA)

Abstract

Translated fromKoreanDescription

Translated fromKorean본 발명은 영상 처리에 관한 것으로서, 보다 상세하게는 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법 및 시스템에 관한 것이다.The present invention relates to image processing, and more particularly, to a method and system for generating a virtual CT image and attenuation-corrected PET image based on a PET image.

PET(Positron Emission Tomography)/CT(Computed Tomography) 검사는 기능적 영상과 질환의 형태적 영상을 동시에 획득하여, 몸 속 조직들의 기능과 생화학적인 대사 상태를 검사하고 인체 내의 생리적 지표들을 정량적으로 측정할 수 있어 질병 진단, 치료 후 예후 판정, 치료 계획 등에 사용되며 PET 영상을 이용해 측정된 표준섭취계수(Standardized Uptake Value, SUV)는 질환의 상태를 평가하는데 유용하게 사용된다.PET (Positron Emission Tomography)/CT (Computed Tomography) examination simultaneously acquires functional images and morphological images of diseases, and can examine the functions and biochemical metabolic states of tissues in the body and quantitatively measure physiological indicators in the body. Therefore, it is used for disease diagnosis, prognosis after treatment, and treatment planning.

예전의 PET 장비 영상에서는 감마선의 감쇠 정도가 체내 위치에 따라 컴프턴 산란에 의해 잡음이 유발되므로, 검출기 내 효율성의 차이 등을 해결하며 감쇠 보정맵을 얻기 위해 외부 감마선원을 이용하여 얻었다. 그러나 요즘은 CT 영상으로 대체함으로 스캔 시간이 단축되고 정확한 보정이 가능하게 되어 PET/CT 장비가 널리 이용된다.In the previous PET image, the attenuation degree of gamma rays is caused by Compton scattering according to the location of the body. However, PET/CT equipment is widely used these days by replacing it with CT images, which shortens the scan time and enables accurate correction.

결국, PET/CT 시스템에서 CT 영상은 해부학적 정보와 PET 영상의 감쇠보정을 위하여 획득한다. 그러나 방사성동위원소를 사용하여 기능정보를 획득하는 PET 영상의 방사선선량과 더불어 CT 영상의 방사선선량으로 인하여 환자에 대한 방사선피폭선량의 위험은 2배 이상으로 증가하게 된다. 신규 방사성의약품의 평가나 치료용 방사성의약품의 경우 여러 번의 PET 영상의 획득이 불가피하며 그에 따른 불필요한 CT 영상의 획득이 반복하여 수행되게 된다. Finally, in the PET/CT system, CT images are acquired for anatomical information and attenuation correction of PET images. However, the risk of radiation exposure to the patient increases more than twice due to the radiation dose of the CT image as well as the radiation dose of the PET image to obtain functional information using radioactive isotopes. In the case of radiopharmaceuticals for evaluation or treatment of new radiopharmaceuticals, it is inevitable to acquire multiple PET images, and unnecessary CT images are repeatedly acquired.

이에 환자에 대한 불필요한 방사선 피폭선량을 줄이는 동시에, PET 영상으로부터 CT 영상을 획득하고 나아가 감쇠보정된 PET 영상을 획득하기 위한 시스템의 필요성이 대두된다.Accordingly, there is a need for a system for reducing unnecessary radiation dose to a patient and acquiring a CT image from a PET image and further acquiring an attenuation-corrected PET image.

본 발명의 일 측면은 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법을 제공한다.One aspect of the present invention provides a method for generating a virtual CT image and attenuation-corrected PET image based on a PET image.

본 발명의 다른 측면은 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법을 수행하는 시스템을 제공한다.Another aspect of the present invention provides a system for performing a virtual CT image based on a PET image and a method for generating an attenuation-corrected PET image.

본 발명의 일 측면에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법은, (a) 네트워크 학습부가 PET/CT 데이터에 포함된 PET 영상과 CT 영상을 기반으로 머신러닝을 수행하는 단계; (b) CT 영상 생성부가 PET 영상을 수신하고, 상기 머신러닝 결과를 기반으로 상기 PET 영상으로부터 가상 CT 영상을 생성하는 단계; 및 (c) 감쇠보정맵 생성부가 상기 가상 CT 영상으로부터 감쇠보정 PET 영상을 생성하는 단계를 포함하되, 상기 (c) 단계는, (c1) 상기 감쇠보정맵 생성부가 상기 가상 CT 영상의 복셀을 맞추어 상기 가상 CT 영상의 에너지맵을 획득하는 단계; (c2) 상기 감쇠보정맵 생성부가 전방 투시법을 이용하여 상기 가상 CT 영상의 에너지맵으로부터 상기 가상 CT 영상의 사이노그램을 획득하는 단계; (c2) 상기 감쇠보정맵 생성부가 상기 PET 영상의 사이노그램을 획득하는 단계; 및 (c4) 상기 감쇠보정맵 생성부가 상기 가상 CT 영상의 사이노그램과 상기 PET 영상의 사이노그램을 곱하여 상기 감쇠보정 PET 영상을 생성하는 단계를 포함할 수 있다.A method for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an aspect of the present invention comprises the steps of: (a) performing machine learning on the basis of the PET image and the CT image included in the PET/CT data by the network learning unit; ; (b) receiving the PET image by a CT image generator and generating a virtual CT image from the PET image based on the machine learning result; and (c) generating, by an attenuation correction map generator, an attenuation-corrected PET image from the virtual CT image. obtaining an energy map of the virtual CT image; (c2) obtaining, by the attenuation correction map generator, a sinogram of the virtual CT image from the energy map of the virtual CT image using anterior perspective; (c2) obtaining, by the attenuation correction map generator, a sinogram of the PET image; and (c4) generating the attenuation-corrected PET image by multiplying, by the attenuation correction map generator, a sinogram of the virtual CT image and a sinogram of the PET image.

한편, 상기 머신러닝은 cGAN(conditional Generative Adversarial Network) 모델을 기반으로 수행되고, 상기 cGAN 모델은 생성망과 판별망으로 구성되고, 상기 생성망은 상기 PET 영상을 상기 가상 CT 영상으로 전이시키기 위하여 모델을 학습하고, 상기 판별망은 CNN(Convolutional neural network) 구조 기반으로 상기 생성망으로부터 생성된 상기 가상 CT 영상과 실제 CT 영상을 비교하여 학습할 수 있다.Meanwhile, the machine learning is performed based on a conditional generative adversarial network (cGAN) model, the cGAN model consists of a generative network and a discriminant network, and the generative network is a model to transfer the PET image to the virtual CT image. , and the discriminant network can learn by comparing the virtual CT image and the actual CT image generated from the generating network based on a CNN (Convolutional Neural Network) structure.

또한, 상기 가상 CT 영상은 상기 PET 영상의 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 생성될 수 있다.Also, the virtual CT image may be generated by mapping an image data distribution of the PET image to a virtual CT image data distribution.

삭제delete

본 발명의 일 측면에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템은, PET/CT 데이터에 포함된 PET 영상과 CT 영상을 기반으로 머신러닝을 수행하도록 구현되는 네트워크 학습부; PET 영상을 수신하고, 상기 머신러닝 결과를 기반으로 상기 PET 영상으로부터 가상 CT 영상을 생성하는 CT 영상 생성부; 및 상기 가상 CT 영상으로부터 감쇠보정 PET 영상을 생성하는 감쇠보정맵 생성부를 포함하며, 상기 감쇠보정맵 생성부는, 상기 가상 CT 영상의 복셀을 맞추어 에너지맵으로 변환하고, 상기 변환된 에너지맵으로부터 상기 가상 CT 영상의 사이노그램을 획득하고, 상기 PET 영상으로부터 사이노그램을 획득하며, 상기 가상 CT 영상의 사이노그램과 상기 PET 영상의 사이노그램을 곱하여 상기 감쇠보정 PET 영상을 생성할 수 있다.A virtual CT image and attenuation-corrected PET image generation system based on a PET image according to an aspect of the present invention comprises: a network learning unit implemented to perform machine learning based on a PET image and a CT image included in PET/CT data; a CT image generator for receiving a PET image and generating a virtual CT image from the PET image based on the machine learning result; and an attenuation correction map generation unit generating an attenuation-corrected PET image from the virtual CT image, wherein the attenuation correction map generation unit matches voxels of the virtual CT image to an energy map, and converts the virtual CT image into an energy map from the converted energy map. The attenuation-corrected PET image may be generated by acquiring a sinogram of a CT image, acquiring a sinogram from the PET image, and multiplying a sinogram of the virtual CT image and a sinogram of the PET image.

한편, 상기 머신러닝은 cGAN(conditional Generative Adversarial Network) 모델을 기반으로 수행되고, 상기 cGAN 모델은 생성망과 판별망으로 구성되고, 상기 생성망은 상기 PET 영상을 상기 가상 CT 영상으로 전이시키기 위한 모델을 학습하고, 상기 판별망은 CNN(Convolutional neural network) 구조 기반으로 생성망으로부터 생성된 상기 가상 CT 영상과 실제 CT 영상을 비교하여 학습할 수 있다.Meanwhile, the machine learning is performed based on a cGAN (conditional generative adversarial network) model, the cGAN model is composed of a generative network and a discriminant network, and the generative network is a model for transferring the PET image to the virtual CT image. , and the discriminant network can learn by comparing the virtual CT image and the actual CT image generated from the generating network based on a CNN (Convolutional Neural Network) structure.

또한, 상기 가상 CT 영상은 상기 PET 영상의 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 생성될 수 있다.Also, the virtual CT image may be generated by mapping an image data distribution of the PET image to a virtual CT image data distribution.

삭제delete

본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법 및 시스템에서는 PET 영상만으로부터 머신러닝을 이용하여 CT 영상을 생성하고, 종양의 검출 및 약물치료평가를 위한 해부학적 정보와 감쇠보정된 PET 영상을 생성함으로써 CT에 의한 추가 피폭선량을 감소시킬 수 있다.In the method and system for generating a virtual CT image and attenuation correction PET image based on a PET image according to an embodiment of the present invention, a CT image is generated using machine learning from only the PET image, and anatomical for tumor detection and drug treatment evaluation By generating information and attenuation-corrected PET images, additional doses from CT can be reduced.

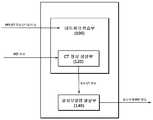

도 1은 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템을 나타낸 블록도이다.

도 2는 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템을 나타낸 도면이다.

도 3은 본 발명의 실시예에 따른 가상 CT 영상을 나타낸 개념도이다.

도 4는 본 발명의 실시예에 따른 PET/CT 영상을 이용한 가상 CT 영상 생성을 나타낸 개념도이다.

도 5는 본 발명의 실시예에 따른 감쇠보정맵 생성부의 감쇠보정 과정이 개시된다.

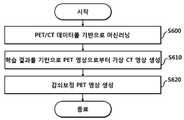

도 6은 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법을 나타낸 순서도이다.1 is a block diagram illustrating a system for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

2 is a diagram illustrating a system for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

3 is a conceptual diagram illustrating a virtual CT image according to an embodiment of the present invention.

4 is a conceptual diagram illustrating generation of a virtual CT image using a PET/CT image according to an embodiment of the present invention.

5 shows an attenuation correction process of an attenuation correction map generator according to an embodiment of the present invention.

6 is a flowchart illustrating a method for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

후술하는 본 발명에 대한 상세한 설명은, 본 발명이 실시될 수 있는 특정 실시예를 예시로서 도시하는 첨부 도면을 참조한다. 이들 실시예는 당업자가 본 발명을 실시할 수 있기에 충분하도록 상세히 설명된다. 본 발명의 다양한 실시예는 서로 다르지만 상호 배타적일 필요는 없음이 이해되어야 한다. 예를 들어, 여기에 기재되어 있는 특정 형상, 구조 및 특성은 일 실시예와 관련하여 본 발명의 정신 및 범위를 벗어나지 않으면서 다른 실시예로 구현될 수 있다. 또한, 각각의 개시된 실시예 내의 개별 구성요소의 위치 또는 배치는 본 발명의 정신 및 범위를 벗어나지 않으면서 변경될 수 있음이 이해되어야 한다. 따라서, 후술하는 상세한 설명은 한정적인 의미로서 취하려는 것이 아니며, 본 발명의 범위는, 적절하게 설명된다면, 그 청구항들이 주장하는 것과 균등한 모든 범위와 더불어 첨부된 청구항에 의해서만 한정된다. 도면에서 유사한 참조 부호는 여러 측면에 걸쳐서 동일하거나 유사한 기능을 지칭한다.DETAILED DESCRIPTION OF THE PREFERRED EMBODIMENTS [0010] DETAILED DESCRIPTION OF THE PREFERRED EMBODIMENTS [0010] DETAILED DESCRIPTION OF THE PREFERRED EMBODIMENTS [0023] Reference is made to the accompanying drawings, which show by way of illustration specific embodiments in which the present invention may be practiced. These embodiments are described in sufficient detail to enable those skilled in the art to practice the present invention. It should be understood that the various embodiments of the present invention are different but need not be mutually exclusive. For example, certain shapes, structures, and characteristics described herein may be implemented in other embodiments without departing from the spirit and scope of the invention with respect to one embodiment. In addition, it should be understood that the location or arrangement of individual components within each disclosed embodiment may be changed without departing from the spirit and scope of the present invention. Accordingly, the detailed description set forth below is not intended to be taken in a limiting sense, and the scope of the invention, if properly described, is limited only by the appended claims, along with all scope equivalents to those claimed. Like reference numerals in the drawings refer to the same or similar functions throughout the various aspects.

이하, 도면들을 참조하여 본 발명의 바람직한 실시예들을 보다 상세하게 설명하기로 한다.Hereinafter, preferred embodiments of the present invention will be described in more detail with reference to the drawings.

PET(Positron Emission Tomography)/CT(Computed Tomography) 시스템에서 CT 영상은 해부학적 정보와 PET 영상의 감쇠보정을 위하여 획득한다. 그러나 방사성동위원소를 사용하여 기능 정보를 획득하는 PET 영상의 방사선 선량과 더불어 CT 영상의 방사선 선량으로 인하여 환자에 대한 방사선 피폭 선량의 위험은 2배 이상으로 증가하게 된다. 신규 방사성 의약품의 평가나 치료용 방사성 의약품의 경우 여러 번의 PET 영상의 획득이 불가피하며 그에 따른 불필요한 CT 영상의 획득이 반복하여 수행되게 된다.In a PET (Positron Emission Tomography)/CT (Computed Tomography) system, CT images are acquired for anatomical information and attenuation correction of PET images. However, the risk of radiation exposure to the patient increases by more than two times due to the radiation dose of the CT image along with the radiation dose of the PET image that acquires functional information using radioactive isotopes. In the case of radiopharmaceuticals for evaluation or treatment of new radiopharmaceuticals, it is inevitable to acquire multiple PET images, and unnecessary CT images are repeatedly acquired.

본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 방법 및 시스템에서는 머신러닝 네트워크를 이용하여 PET 영상으로부터 CT 영상을 생성하고, 종양의 검출 및 약물치료평가를 위한 해부학적 정보와 감쇠보정 PET 영상을 생성함으로써 CT에 의한 추가 피폭선량을 감소시킬 수 있는 시스템이 개시된다.In the method and system for generating a virtual CT image and attenuation correction PET image based on a PET image according to an embodiment of the present invention, a CT image is generated from a PET image using a machine learning network, and anatomical for tumor detection and drug treatment evaluation A system capable of reducing additional exposure dose by CT by generating information and attenuation-corrected PET images is disclosed.

도 1은 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템을 나타낸 블록도이다.1 is a block diagram illustrating a system for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

도 1을 참조하면, PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템은 네트워크 학습부(network learning unit)(100), CT 영상 생성부(CT image generation unit)(120) 및 감쇠보정맵 생성부(Attenuation correction map generation unit)(140)을 포함할 수 있다.Referring to FIG. 1 , a virtual CT image and attenuation correction PET image generation system based on a PET image includes a

네트워크 학습부(100)는 PET 영상과 CT 영상이 포함된 PET/CT 데이터를 빅데이터로 취합하여 머신러닝을 수행한다. 네트워크 학습부(100)는 머신러닝을 통해 PET 영상으로부터 가상의 CT 영상을 획득하기 위해, 딥 러닝의 기반의 영상 변환 모델인 cGAN(conditional Generative Adversarial Network) 모델을 사용하여 영상 전이를 수행할 수 있다.The

cGAN 모델은 생성망(generator)과 판별망(discriminator)으로 구성되며, 생성망은 U-net 구조 기반으로 PET 영상을 가상 CT 영상으로 전이시키기 위하여 모델을 학습하고, 판별망은 CNN(Convolutional neural network) 구조 기반으로 생성망로부터 생성된 가상 CT 영상과 실제 CT 영상과 비교하기 위하여 학습한다.The cGAN model is composed of a generator and a discriminator. The generator network learns the model to transfer the PET image to a virtual CT image based on the U-net structure, and the discriminator network is a convolutional neural network (CNN). ) structure-based learning to compare the virtual CT image generated from the generation network with the actual CT image.

생성망은 판별망의 정확도를 향상시키기 위하여 보다 정교한 가상 CT 영상을 PET/CT 영상으로부터 학습하며, 판별망은 기존의 PET/CT 영상과 가상 CT 영상과 PET 영상을 이용하여 실제 CT 영상을 가상 CT 영상으로부터 더 잘 구분할 수 있도록 학습하여 경쟁학습(adversarial learning)을 통해 학습의 평형 (equilibrium) 상태에 이르게 된다.The generating network learns more sophisticated virtual CT images from PET/CT images in order to improve the accuracy of the discriminant network, and the discriminant network uses the existing PET/CT images, virtual CT images, and PET images to convert real CT images into virtual CT images. It learns to be better able to distinguish from images, and reaches an equilibrium state of learning through adversarial learning.

CT 영상 생성부(120)는 학습된 네트워크 학습부의 생성망을 이용하여 PET 영상 데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 입력된 PET 영상으로부터 가상 CT 영상을 생성할 수 있다.The

감쇠보정맵 생성부(140)는 CT 영상 생성부에서 PET 영상을 기반으로 생성된 가상 CT 영상의 복셀을 맞추어 에너지맵으로 변환하고, 전방 투시법(forward projection)을 이용하여 사이노그램으로 변환한후 PET 영상의 사이노그램과 곱하여 감쇠보정 PET 영상을 생성할 수 있다.The attenuation correction map generator 140 matches the voxels of the virtual CT image generated based on the PET image by the CT image generator to convert it into an energy map, and converts it into a sinogram using forward projection. An attenuation-corrected PET image can be generated by multiplying the PET image with a sinogram.

이러한 방법을 통해 PET 영상에 기반한 CT 영상 및 감쇠보정 PET 영상 생성 시스템은 추가 피폭선량 없이 기능 영상 정보를 이용하여 해부학적 정보를 제공할 수 있다. 생성된 CT 영상을 이용해 조영된 지연기 CT 영상을 생성하여 인체내 조영제 위험 요소 또한 해결할 수 있을 것으로 기대되며, 신약 치료평가 도구로도 이용 가능하다.Through this method, a CT image and attenuation-corrected PET image generation system based on PET images can provide anatomical information using functional image information without additional exposure dose. It is expected that the risk factors of the contrast medium in the human body can also be resolved by generating a contrasted delayed-phase CT image using the generated CT image, and it can be used as a treatment evaluation tool for new drugs.

도 2는 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠보정 PET 영상 생성 시스템을 나타낸 도면이다.2 is a diagram illustrating a system for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

도 2에서는 PET/CT 데이터 이미지에 대한 머신 러닝을 통해 PET 영상으로부터 가상 CT 영상 및 감쇠보정된 PET 영상 이미지를 생성하기 위한 방법이 개시된다.2 discloses a method for generating a virtual CT image and attenuation-corrected PET image from a PET image through machine learning on the PET/CT data image.

도 2를 참조하면, PET/CT 이미지(200)는 리사이징(resizing) 및 리스케일링(rescaling)을 거친 후 네트워크 학습부(210)로 입력될 수 있다. 이러한 PET/CT 이미지는 다수의 다양한 데이터들이 빅데이터로 네트워크 학습부(210)로 입력된다.Referring to FIG. 2 , the PET/

전술한 바와 같이 네트워크 학습부(210)는 PET 영상으로부터 가상의 CT 영상을 획득하기 위해 딥 러닝의 기반의 영상 변환 모델인 cGAN(conditional Generative Adversarial Network) 모델을 사용하여 영상 전이를 수행할 수 있다.As described above, the

cGAN 모델은 생성망(generator)(220)과 판별망(discriminator)(230)으로 구성되며, 생성망(220)은 U-net 구조 기반으로 PET 영상을 가상 CT 영상으로 전이시키기 위하여 모델을 학습하고, 판별망(230)은 CNN(Convolutional neural network) 구조 기반으로 생성망(220)로부터 생성된 가상 CT 영상과 실제 CT 영상과 비교하기 위하여 학습한다.The cGAN model consists of a

생성망(220)은 판별망(230)의 정확도를 향상시키기 위하여 보다 정교한 가상CT 영상을 PET/CT 이미지의 빅데이터로 학습하며, 판별망(230)은 기존의 PET/CT 데이터 영상과 가상 CT 영상과 PET 영상을 이용하여 실제 CT 영상을 가상 CT 영상으로부터 더 잘 구분할 수 있도록 학습하여 경쟁학습 (adversarial learning)을 통해 학습의 평형 (equilibrium) 상태에 이를 수 있다.The

또한, 전술한 바와 같이 CT 영상 생성부는 PET 영상(240)이 입력되는 경우, 학습된 네트워크 학습부의 생성망을 이용하여 PET 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 가상 CT 영상(250)을 생성한다.In addition, as described above, when the

또한, 감쇠보정맵 생성부는 CT 영상 생성부에서 PET 영상(240)을 기반으로 생성된 가상 CT 영상(250)의 복셀을 맞추어 에너지맵으로 변환하고, 전방 투시법(forward projection)을 이용하여 에너지맵을 사이노그램으로 변환한다. 그리고 나서 가상 CT 영상의 에너지맵으로부터 변환된 사이노그램과 PET 영상(240)의 사이노그램를 서로 곱하고 해당 데이터를 재구축하여 감쇠보정 PET 영상(260)을 생성할 수 있다.In addition, the attenuation correction map generation unit converts the energy map by matching voxels of the

도 3은 본 발명의 실시예에 따른 가상 CT 영상을 나타낸 개념도이다.3 is a conceptual diagram illustrating a virtual CT image according to an embodiment of the present invention.

도 3에서는 PET 영상을 기반으로 가상 CT 영상을 생성하는 과정이 개시된다.3 illustrates a process of generating a virtual CT image based on a PET image.

도 3을 참조하면, 심장(heart)과 간(liver)에 대한 PET 영상을 기반으로 가상 CT 영상이 생성될 수 있다.Referring to FIG. 3 , a virtual CT image may be generated based on a PET image of a heart and a liver.

전술한 바와 같이 PET/CT 영상을 입력으로 학습된 네트워크 학습부의 생성망을 이용하여 PET 영상 데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 가상CT 영상이 생성될 수 있다.As described above, a virtual CT image may be generated by mapping the PET image data distribution to the virtual CT image data distribution using the generation network of the network learning unit learned from the PET/CT image as an input.

네트워크 학습부는 PET 영상으로부터 가상의 CT 영상을 획득하기 위해 딥 러닝의 기반의 영상 변환 모델인 cGAN(conditional Generative Adversarial Network) 모델을 사용할 수 있다.The network learning unit may use a conditional generative adversarial network (cGAN) model, which is an image conversion model based on deep learning, to obtain a virtual CT image from a PET image.

도 4는 본 발명의 실시예에 따른 PET/CT 영상을 이용한 가상CT 영상 생성을 나타낸 개념도이다.4 is a conceptual diagram illustrating generation of a virtual CT image using a PET/CT image according to an embodiment of the present invention.

도 4에서는 PET/CT 데이터를 기반으로 가상CT 영상을 생성하는 과정이 개시된다.In FIG. 4 , a process of generating a virtual CT image based on PET/CT data is disclosed.

도 4를 참조하면, 심장(heart)과 간(liver)에 대한 CT 영상 및 PET 영상을 기반으로 가상 CT 영상이 생성될 수 있다.Referring to FIG. 4 , a virtual CT image may be generated based on a CT image and a PET image of the heart and liver.

마찬가지로, PET/CT 데이터로 학습된 네트워크 학습부의 생성망을 이용하여 PET 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 가상 CT 영상이 생성될 수 있다. 네트워크 학습부는 PET 영상을 통해 가상의 CT 영상을 획득하기 위해 딥 러닝의 기반의 영상 변환 모델인 cGAN(conditional Generative Adversarial Network) 모델을 사용할 수 있다.Similarly, a virtual CT image may be generated by mapping a distribution of PET image data to a distribution of virtual CT image data by using a generation network of a network learning unit learned from PET/CT data. The network learning unit may use a conditional generative adversarial network (cGAN) model, which is an image conversion model based on deep learning, to acquire a virtual CT image through a PET image.

도 5는 본 발명의 실시예에 따른 감쇠보정맵 생성부의 감쇠보정 과정이 개시된다.5 shows an attenuation correction process of an attenuation correction map generator according to an embodiment of the present invention.

도 5A에는 CT 영상의 HU(Hounsfield Units) 값과 선형감쇠계수(linear attenuation coefficient) 값 간의 관계가 개시되고, 도 5B에는 감쇠계수맵이 개시되고, 도 5C에는 감쇠보정된 PET 영상이 개시되며, 도 5D에는 전방투시된 사이노그램이 개시된다.5A discloses the relationship between the HU (Hounsfield Units) value and the linear attenuation coefficient value of the CT image, the attenuation coefficient map is disclosed in FIG. 5B, and the attenuation-corrected PET image is disclosed in FIG. 5C, 5D discloses an anterior perspective sinogram.

감쇠보정맵 생성부(140)는 CT 영상 생성부(120)를 통해 생성된 가상 CT 영상의 복셀 값을 기초로 가상 CT 영상의 에너지맵을 획득할 수 있다. 일반적으로 CT 영상은 -1000과 1000 사이의 Hounsfield unit(HU) 값을 가지는데, -1000은 공기(air)로 구성된 물질을 지날 때 해당 값을 나타내고, 1000 이상의 값은 뼈와 같은 물질을 지날 때 해당 값을 나타낸다. 또한, 체내의 연조직(soft tissue)은 0에서 100 HU 값을 나타낸다. 이러한 원리를 바탕으로 감쇠보정맵 생성부(140)는 생성된 가상 CT 영상의 각 복셀에서 HU(Hounsfield Units) 값과 선형감쇠계수(linear attenuation coefficient) 값 간의 관계로부터 PET 영상과 상응하는 물질의 밀도 정보를 나타내는 선형감쇠계수와 관련된 에너지맵을 생성할 수 있다.The attenuation correction map generator 140 may acquire an energy map of the virtual CT image based on the voxel value of the virtual CT image generated by the

CT 영상을 재구성할 수 있는 사이노그램 정보는 CT 영상 획득 시 얻어지는 X선이 물질을 투과하면서 흡수되는 비율에 관한 정보를 제공한다. 이러한 정보를 바탕으로 라돈 변환(Radon Transformation)을 이용하면 CT 영상을 얻을 수 있는데, 이 과정을 역으로 진행하면 에너지맵을 통해서 사이노그램 정보를 얻을 수 있다.The sinogram information capable of reconstructing a CT image provides information on the rate at which X-rays obtained when a CT image is acquired are absorbed while penetrating a material. Based on this information, a CT image can be obtained by using Radon Transformation. If this process is performed in reverse, sinogram information can be obtained through the energy map.

감쇠보정맵 생성부(140)는 가상 CT 영상의 에너지맵으로부터 가상 CT 영상의 사이노그램을 획득하고, 이와 동시에 PET 영상으로부터 PET 영상의 사이노그램을 획득한다.The attenuation correction map generator 140 acquires a sinogram of a virtual CT image from an energy map of the virtual CT image, and simultaneously acquires a sinogram of a PET image from the PET image.

그리고 나서, 감쇠보정맵 생성부(140)는 가상 CT 영상의 사이노그램과 PET 영상의 사이노그램을 곱하고 이를 재구축하여 최종적으로 감쇠보정 PET 영상을 획득한다.Then, the attenuation correction map generator 140 multiplies the sinogram of the virtual CT image and the sinogram of the PET image, and reconstructs it to finally obtain the attenuation corrected PET image.

도 6은 본 발명의 실시예에 따른 PET 영상에 기반한 가상 CT 영상 및 감쇠 보정 PET 영상 생성 방법을 나타낸 순서도이다.6 is a flowchart illustrating a method for generating a virtual CT image and attenuation-corrected PET image based on a PET image according to an embodiment of the present invention.

도 6을 참조하면, 네트워크 학습부(100)는 PET 영상과 CT 영상을 포함하는 PET/CT 데이터를 기반으로 머신러닝을 수행한다(단계 S600).Referring to FIG. 6 , the

PET 영상으로부터 가상의 CT 영상을 획득하기 위해 딥 러닝의 기반의 영상 변환 모델인 cGAN(conditional Generative Adversarial Network) 모델이 사용되어 영상 전이가 수행될 수 있다.In order to obtain a virtual CT image from a PET image, a conditional generative adversarial network (cGAN) model, which is an image transformation model based on deep learning, may be used to perform image transfer.

학습을 위해 cGAN 모델의 생성망은 U-net 구조 기반으로 PET 영상을 가상 CT 영상으로 전이시키기 위하여 모델을 학습하고, 판별망은 CNN(Convolutional neural network) 구조 기반으로 생성망로부터 생성된 가상 CT 영상과 실제 CT 영상과 비교하기 위하여 학습할 수 있다.For learning, the cGAN model generation network learns the model to transfer the PET image to a virtual CT image based on the U-net structure, and the discriminant network learns the model based on the CNN (Convolutional neural network) structure based on the virtual CT image generated from the generation network. and can learn to compare with actual CT images.

생성망은 판별망의 정확도를 향상시키기 위하여 보다 정교한 가상 CT 영상을 PET/CT 데이터로 학습하며, 판별망은 기존의 PET/CT 영상과 가상CT 영상과 PET 영상을 이용하여 실제 CT 영상을 가상CT 영상으로부터 더 잘 구분할 수 있도록 학습할 수 있다.The generating network learns more sophisticated virtual CT images from PET/CT data to improve the accuracy of the discriminant network, and the discriminant network uses the existing PET/CT images, virtual CT images, and PET images to convert real CT images into virtual CT images. It can learn to distinguish better from images.

CT 영상 생성부(120)는 학습 결과를 기반으로 PET 영상으로부터 가상 CT 영상을 생성한다(단계 S610).The

PET 영상을 입력으로 학습된 네트워크 학습부의 생성망을 이용하여 PET 영상데이터 분포를 가상 CT 영상 데이터 분포로 매핑하여 가상 CT 영상이 생성될 수 있다.A virtual CT image may be generated by mapping a distribution of PET image data to a distribution of virtual CT image data using a generation network of a network learning unit learned from a PET image as an input.

감쇠보정맵 생성부(140)는 감쇠보정 PET 영상을 생성한다(단계 S620).The attenuation correction map generation unit 140 generates an attenuation correction PET image (step S620).

PET 영상을 기반으로 생성된 가상 CT 영상의 복셀을 맞추어 가상 CT 영상의 에너지맵으로 변환하고 전방 투시법(forward projection)을 이용하여 사이노그램으로 변환한 후, 가상 CT 영상의 사이노그램과 PET 영상의 사이노그램을 곱하고 재구축하여 감쇠보정된 PET 영상을 생성할 수 있다.After matching the voxels of the virtual CT image generated based on the PET image to the energy map of the virtual CT image, and converting it into a sinogram using forward projection, the sinogram of the virtual CT image and the PET image The attenuation-corrected PET image can be generated by multiplying and reconstructing the sinogram of .

도 7은 감쇠보정 PET 영상 생성 단계를 나타낸 순서도이다.7 is a flowchart illustrating a step of generating an attenuation-corrected PET image.

감쇠보정맵 생성부(140)는 CT 영상 생성부(120)를 통해 생성된 가상 CT 영상의 복셀 값을 기초로 가상 CT 영상의 에너지맵을 획득한다(S700).The attenuation correction map generator 140 obtains an energy map of the virtual CT image based on the voxel value of the virtual CT image generated by the CT image generator 120 ( S700 ).

그리고 나서, 감쇠보정맵 생성부(140)는 가상 CT 영상의 에너지맵으로부터 가상 CT 영상의 사이노그램을 획득한다(S710). 이와 동시에 감쇠보정맵 생성부(140)는 PET 영상으로부터 PET 영상의 사이노그램을 획득한다(S720).Then, the attenuation correction map generator 140 obtains a sinogram of the virtual CT image from the energy map of the virtual CT image (S710). At the same time, the attenuation correction map generator 140 obtains a sinogram of the PET image from the PET image (S720).

그리고 나서, 감쇠보정맵 생성부(140)는 가상 CT 영상의 사이노그램과 PET 영상의 사이노그램을 곱하고 이를 재구축하여 최종적으로 감쇠보정 PET 영상을 획득한다(S730).Then, the attenuation correction map generator 140 multiplies the sinogram of the virtual CT image and the sinogram of the PET image, and reconstructs it to finally obtain an attenuation corrected PET image (S730).

전술한 방법은 애플리케이션으로 구현되거나 다양한 컴퓨터 구성요소를 통하여 수행될 수 있는 프로그램 명령어의 형태로 구현되어 컴퓨터 판독 가능한 기록 매체에 기록될 수 있다. 상기 컴퓨터 판독 가능한 기록 매체는 프로그램 명령어, 데이터 파일, 데이터 구조 등을 단독으로 또는 조합하여 포함할 수 있다.The above-described method may be implemented as an application or implemented in the form of program instructions that may be executed through various computer components and recorded in a computer-readable recording medium. The computer-readable recording medium may include program instructions, data files, data structures, etc. alone or in combination.

상기 컴퓨터 판독 가능한 기록 매체에 기록되는 프로그램 명령어는 본 발명을 위하여 특별히 설계되고 구성된 것들이거니와 컴퓨터 소프트웨어 분야의 당업자에게 공지되어 사용 가능한 것일 수도 있다.The program instructions recorded on the computer-readable recording medium are specially designed and configured for the present invention, and may be known and used by those skilled in the art of computer software.

컴퓨터 판독 가능한 기록 매체의 예에는, 하드 디스크, 플로피 디스크 및 자기 테이프와 같은 자기 매체, CD-ROM, DVD 와 같은 광기록 매체, 플롭티컬 디스크(floptical disk)와 같은 자기-광 매체(magneto-optical media), 및 ROM, RAM, 플래시 메모리 등과 같은 프로그램 명령어를 저장하고 수행하도록 특별히 구성된 하드웨어 장치가 포함된다.Examples of the computer-readable recording medium include a hard disk, a magnetic medium such as a floppy disk and a magnetic tape, an optical recording medium such as a CD-ROM and DVD, and a magneto-optical medium such as a floppy disk. media), and hardware devices specially configured to store and execute program instructions, such as ROM, RAM, flash memory, and the like.

프로그램 명령어의 예에는, 컴파일러에 의해 만들어지는 것과 같은 기계어 코드뿐만 아니라 인터프리터 등을 사용해서 컴퓨터에 의해서 실행될 수 있는 고급 언어 코드도 포함된다. 상기 하드웨어 장치는 본 발명에 따른 처리를 수행하기 위해 하나 이상의 소프트웨어 모듈로서 작동하도록 구성될 수 있으며, 그 역도 마찬가지이다.Examples of program instructions include not only machine language codes such as those generated by a compiler, but also high-level language codes that can be executed by a computer using an interpreter or the like. The hardware device may be configured to operate as one or more software modules to perform processing according to the present invention, and vice versa.

이상에서는 실시예들을 참조하여 설명하였지만, 해당 기술 분야의 숙련된 당업자는 하기의 특허 청구범위에 기재된 본 발명의 사상 및 영역으로부터 벗어나지 않는 범위 내에서 본 발명을 다양하게 수정 및 변경시킬 수 있음을 이해할 수 있을 것이다.Although the above has been described with reference to the embodiments, those skilled in the art will understand that various modifications and changes can be made to the present invention without departing from the spirit and scope of the present invention as set forth in the following claims. will be able

Claims (8)

Translated fromKorean(a) 네트워크 학습부가 PET/CT 데이터에 포함된 PET 영상과 CT 영상을 기반으로 머신러닝을 수행하는 단계;

(b) CT 영상 생성부가 PET 영상을 수신하고, 상기 머신러닝 결과를 기반으로 상기 수신된 PET 영상으로부터 가상 CT 영상을 생성하는 단계; 및

(c) 감쇠보정맵 생성부가 상기 가상 CT 영상으로부터 감쇠보정 PET 영상을 생성하는 단계를 포함하되,

상기 (c) 단계는,

(c1) 상기 감쇠보정맵 생성부가 상기 가상 CT 영상의 복셀을 맞추어 상기 가상 CT 영상의 에너지맵을 획득하는 단계;

(c2) 상기 감쇠보정맵 생성부가 전방 투시법을 이용하여 상기 가상 CT 영상의 에너지맵으로부터 상기 가상 CT 영상의 사이노그램을 획득하는 단계;

(c3) 상기 감쇠보정맵 생성부가 상기 PET 영상의 사이노그램을 획득하는 단계; 및

(c4) 상기 감쇠보정맵 생성부가 상기 가상 CT 영상의 사이노그램과 상기 수신된 PET 영상의 사이노그램을 곱하여 상기 감쇠보정 PET 영상을 생성하는 단계를 포함하는 것을 특징으로 하는 방법.A method of generating a virtual CT image and attenuation-corrected PET image based on a PET image,

(a) performing machine learning based on the PET image and the CT image included in the PET/CT data by the network learning unit;

(b) receiving a PET image by a CT image generator, and generating a virtual CT image from the received PET image based on the machine learning result; and

(c) an attenuation correction map generator generating an attenuation correction PET image from the virtual CT image,

The step (c) is,

(c1) obtaining, by the attenuation correction map generator, an energy map of the virtual CT image by matching voxels of the virtual CT image;

(c2) obtaining, by the attenuation correction map generator, a sinogram of the virtual CT image from the energy map of the virtual CT image using anterior perspective;

(c3) obtaining, by the attenuation correction map generator, a sinogram of the PET image; and

(c4) generating the attenuation-corrected PET image by multiplying, by the attenuation correction map generator, the sinogram of the virtual CT image and the sinogram of the received PET image.

상기 머신러닝은 cGAN(conditional Generative Adversarial Network) 모델을 기반으로 수행되고,

상기 cGAN 모델은 생성망과 판별망으로 구성되고,

상기 생성망은 상기 PET 영상을 상기 가상 CT 영상으로 전이시키기 위하여 모델을 학습하고,

상기 판별망은 CNN(Convolutional neural network) 구조 기반으로 상기 생성망으로부터 생성된 상기 가상 CT 영상과 실제 CT 영상을 비교하여 학습하는 것을 특징으로 하는 방법.According to claim 1,

The machine learning is performed based on a conditional generative adversarial network (cGAN) model,

The cGAN model consists of a generation network and a discrimination network,

The generating network trains a model to transfer the PET image to the virtual CT image,

The discriminant network is a method of learning by comparing the virtual CT image and the actual CT image generated from the generation network based on a CNN (Convolutional Neural Network) structure.

상기 가상 CT 영상은 상기 수신된 PET 영상의 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 생성되는 것을 특징으로 하는 방법.According to claim 1,

The virtual CT image is generated by mapping an image data distribution of the received PET image to a virtual CT image data distribution.

PET/CT 데이터에 포함된 PET 영상과 CT 영상을 기반으로 머신러닝을 수행하도록 구현되는 네트워크 학습부;

PET 영상을 수신하고, 상기 머신러닝 결과를 기반으로 상기 수신된 PET 영상으로부터 가상 CT 영상을 생성하는 CT 영상 생성부; 및

상기 가상 CT 영상으로부터 감쇠보정 PET 영상을 생성하는 감쇠보정맵 생성부를 포함하되,

상기 감쇠보정맵 생성부는, 상기 가상 CT 영상의 복셀을 맞추어 상기 가상 CT 영상의 에너지맵을 획득하고, 전방 투시법을 이용하여 상기 가상 CT 영상의 에너지맵으로부터 상기 가상 CT 영상의 사이노그램을 획득하고, 상기 PET 영상으로부터 상기 PET 영상의 사이노그램을 획득하며, 상기 가상 CT 영상의 사이노그램과 상기 PET 영상의 사이노그램을 곱하여 상기 감쇠보정 PET 영상을 생성하는 것을 특징으로 하는 시스템.The virtual CT image and attenuation correction PET image generation system based on the PET image,

a network learning unit implemented to perform machine learning based on PET images and CT images included in PET/CT data;

a CT image generator for receiving a PET image and generating a virtual CT image from the received PET image based on the machine learning result; and

Comprising an attenuation correction map generator for generating an attenuation-corrected PET image from the virtual CT image,

The attenuation correction map generation unit obtains an energy map of the virtual CT image by matching voxels of the virtual CT image, and obtains a sinogram of the virtual CT image from the energy map of the virtual CT image by using anterior perspective. , obtains a sinogram of the PET image from the PET image, and generates the attenuation-corrected PET image by multiplying the sinogram of the virtual CT image and the sinogram of the PET image.

상기 머신러닝은 cGAN(conditional Generative Adversarial Network) 모델을 기반으로 수행되고,

상기 cGAN 모델은 생성망과 판별망으로 구성되고,

상기 생성망은 상기 PET 영상을 상기 가상 CT 영상으로 전이시키기 위한 모델을 학습하고,

상기 판별망은 CNN(Convolutional neural network) 구조 기반으로 생성망으로부터 생성된 상기 가상 CT 영상과 실제 CT 영상을 비교하여 학습하는 것을 특징으로 하는 시스템.6. The method of claim 5,

The machine learning is performed based on a conditional generative adversarial network (cGAN) model,

The cGAN model consists of a generation network and a discrimination network,

The generating network learns a model for transferring the PET image to the virtual CT image,

The system, characterized in that the discriminant network is trained by comparing the virtual CT image and the actual CT image generated from the generating network based on a CNN (Convolutional Neural Network) structure.

상기 가상 CT 영상은 상기 수신된 PET 영상의 영상데이터 분포를 가상의 CT 영상 데이터 분포로 매핑하여 생성되는 것을 특징으로 하는 시스템.6. The method of claim 5,

The virtual CT image is generated by mapping an image data distribution of the received PET image to a virtual CT image data distribution.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020180141885AKR102283934B1 (en) | 2018-11-16 | 2018-11-16 | Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET image |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020180141885AKR102283934B1 (en) | 2018-11-16 | 2018-11-16 | Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET image |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20200057450A KR20200057450A (en) | 2020-05-26 |

| KR102283934B1true KR102283934B1 (en) | 2021-07-30 |

Family

ID=70915267

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020180141885AActiveKR102283934B1 (en) | 2018-11-16 | 2018-11-16 | Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET image |

Country Status (1)

| Country | Link |

|---|---|

| KR (1) | KR102283934B1 (en) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN111436958B (en)* | 2020-02-27 | 2021-06-01 | 之江实验室 | A CT image generation method for PET image attenuation correction |

| KR102447979B1 (en)* | 2020-10-08 | 2022-09-28 | 메디컬아이피 주식회사 | Method and apparatus for converting kernel of CT image |

| CN112419173B (en)* | 2020-11-04 | 2024-07-09 | 深圳先进技术研究院 | Deep learning framework and method for generating CT image from PET image |

| JP2025037333A (en)* | 2023-09-06 | 2025-03-18 | 浜松ホトニクス株式会社 | Attenuation distribution image creating device, image processing device, radiation tomography system, attenuation distribution image creating method, and image processing method |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7184193B2 (en) | 2004-10-05 | 2007-02-27 | Hewlett-Packard Development Company, L.P. | Systems and methods for amorphous flexures in micro-electro mechanical systems |

| KR101428005B1 (en)* | 2012-10-29 | 2014-08-07 | 한국과학기술원 | Method of motion compensation and phase-matched attenuation correction in pet imaging based on a few low-dose ct images |

| KR20170087320A (en)* | 2016-01-20 | 2017-07-28 | 삼성전자주식회사 | Tomography apparatus and method for reconstructing a tomography image thereof |

- 2018

- 2018-11-16KRKR1020180141885Apatent/KR102283934B1/enactiveActive

Non-Patent Citations (2)

| Title |

|---|

| Liu, F., Jang 외 5명, A deep learning approach for 18F-FDG PET attenuation correction. EJNMMI Phys 5, 24 (2018)* |

| Salome Kazeminia 외 6명, GANs for Medial Image Analysis.* |

Also Published As

| Publication number | Publication date |

|---|---|

| KR20200057450A (en) | 2020-05-26 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP7203852B2 (en) | Estimation of full-dose PET images from low-dose PET imaging using deep learning | |

| US9619905B2 (en) | Apparatus and method for generation of attenuation map | |

| CN103315760B (en) | Systems and methods for attenuation compensation in nuclear medicine imaging based on emission data | |

| CN102483852B (en) | Time-of-flight positron emission tomography reconstruction using image content generated event-by-event based on time-of-flight information | |

| JP5966112B1 (en) | Detection of bone tissue using magnetic resonance imaging | |

| KR102283934B1 (en) | Method and system for generating virtual CT(Computed Tomography) image and attenuation-corrected PET(Positron Emission Tomography) image based on PET image | |

| JP7326160B2 (en) | Generation of Accurate Hybrid Datasets for Quantitative Molecular Imaging | |

| CN110935109B (en) | Method and medical imaging unit for providing an annotated medical image data set | |

| US11574154B2 (en) | Patient-adaptive nuclear imaging | |

| CN117425433A (en) | Artificial intelligence training for tomosynthesis imaging systems using multiple moving pulsed X-ray sources | |

| EP4097683B1 (en) | Methods and apparatus for deep learning based image attenuation correction | |

| CN109414234A (en) | System and method for being projected from the 3D data set generation 2D being previously generated | |

| US20230065196A1 (en) | Patient-specific organ dose quantification and inverse optimization for ct | |

| Simon et al. | Initial evaluation of a four‐dimensional computed tomography system, using a programmable motor | |

| EP4148680A1 (en) | Attenuation correction-based weighting for tomographic inconsistency detection | |

| Tadesse et al. | Techniques for generating attenuation map using cardiac SPECT emission data only: a systematic review | |

| Pourmoghaddas et al. | Quantitatively accurate activity measurements with a dedicated cardiac SPECT camera: Physical phantom experiments | |

| Bosmans et al. | Physics of Medical Imaging | |

| Akolade | Cardiac Single Photon Emission Computed Tomography (SPECT) Simulation Using the XCAT Phantom and the SIMIND Package | |

| López Herraiz et al. | Deep-learning based positron range correction of PET images | |

| Monteiro et al. | Image segmentation and voxelization techniques for dose assessment in X-ray diagnostic procedures |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PA0109 | Patent application | Patent event code:PA01091R01D Comment text:Patent Application Patent event date:20181116 | |

| PA0201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| PE0902 | Notice of grounds for rejection | Comment text:Notification of reason for refusal Patent event date:20200512 Patent event code:PE09021S01D | |

| PG1501 | Laying open of application | ||

| E701 | Decision to grant or registration of patent right | ||

| PE0701 | Decision of registration | Patent event code:PE07011S01D Comment text:Decision to Grant Registration Patent event date:20210423 | |

| GRNT | Written decision to grant | ||

| PR0701 | Registration of establishment | Comment text:Registration of Establishment Patent event date:20210726 Patent event code:PR07011E01D | |

| PR1002 | Payment of registration fee | Payment date:20210727 End annual number:3 Start annual number:1 | |

| PG1601 | Publication of registration | ||

| PR1001 | Payment of annual fee | Payment date:20240619 Start annual number:4 End annual number:4 |