KR102159767B1 - Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device - Google Patents

Visibility improvement method based on eye tracking, machine-readable storage medium and electronic deviceDownload PDFInfo

- Publication number

- KR102159767B1 KR102159767B1KR1020200039807AKR20200039807AKR102159767B1KR 102159767 B1KR102159767 B1KR 102159767B1KR 1020200039807 AKR1020200039807 AKR 1020200039807AKR 20200039807 AKR20200039807 AKR 20200039807AKR 102159767 B1KR102159767 B1KR 102159767B1

- Authority

- KR

- South Korea

- Prior art keywords

- image

- user

- electronic device

- gaze

- display

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/366—Image reproducers using viewer tracking

- H04N13/383—Image reproducers using viewer tracking for tracking with gaze detection, i.e. detecting the lines of sight of the viewer's eyes

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/013—Eye tracking input arrangements

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/111—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation

- H04N13/117—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation the virtual viewpoint locations being selected by the viewers or determined by viewer tracking

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/122—Improving the 3D impression of stereoscopic images by modifying image signal contents, e.g. by filtering or adding monoscopic depth cues

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- User Interface Of Digital Computer (AREA)

- Controls And Circuits For Display Device (AREA)

Abstract

Translated fromKoreanDescription

Translated fromKorean본 발명은 카메라에 의해 촬영된 이미지를 처리하는 방법에 관한 것으로서, 특히 사용자의 시선을 고려한 이미지 처리 방법에 관한 것이다.The present invention relates to a method of processing an image photographed by a camera, and more particularly, to an image processing method in consideration of a user's gaze.

종래에, 카메라를 이용한 시선 추적 기술의 발달로 사람의 시선을 추적하여 화면상의 주목된 물체를 확대 및 축소하거나 관련 정보를 물체 주변에 표시하는 등, 사람의 관심사에 맞춰 정보를 제공하는 기술이 개시되어 있다.Conventionally, with the development of gaze tracking technology using a camera, a technology that provides information according to the interests of people, such as zooming in or reducing an object of interest on the screen by tracking the gaze of a person, or displaying related information around the object, has been disclosed. Has been.

예를 들어, 사용자의 시선을 추적하여, 화면상의 특정한 부분을 주목하는 경우에, 상기 특정 부분을 확대 또는 축소하는 기술이 있다.For example, when a user's gaze is tracked and a specific part on the screen is paid attention, there is a technique of expanding or reducing the specific part.

또한 예를 들어, 야구장에서 선수들을 바라보면 각 선수들에 대한 정보가 표시되거나, 유적지 등에서 유적에 대한 정보를 표시하는 것이 가능하다.In addition, for example, when looking at players in a baseball field, information about each player can be displayed, or information about relics can be displayed at a historical site.

종래 기술에 있어서, 사용자가 특정한 영역을 주목하는 경우에 특정 영역의 확대 및 관련 텍스트 정보의 표시는 사용자에게 보다 상세한 정보를 제공하는데 목적이 있지만, 종래 기술의 경우 화면상의 이미지, 또는 얼굴에 부착한 카메라 등을 통해 사용자가 바라보고 있는 실제 환경에서 촬영한 이미지가 저해상도이거나, 주변 광량 부족으로 어둡거나 노출이 부족하여 선명하지 않을 때, 간판 등 보고자 하는 물체까지의 거리가 멀어 확대해도 사용자가 원하는 시각 정보를 제공하기에는 어려움이 있다.In the prior art, when a user pays attention to a specific area, enlargement of a specific area and display of related text information are aimed at providing more detailed information to the user, but in the case of the prior art, an image on a screen or attached to a face When the image captured in the real environment that the user is looking at through a camera is low resolution, dark due to insufficient ambient light, or unclear due to insufficient exposure, or when the distance to the object to be viewed such as a signboard is too long and enlarged, the user desired view It is difficult to provide information.

또한, 텍스트로 대상 물체에 대한 정보를 표시하는 기술의 경우에는 시각 정보에서는 드러나지 않는 상세한 정보를 제공할 수 있는 장점이 있지만 실제 대상의 모습이나 색상 등 자세한 시각 정보는 제공하지 못하는 한계가 있다.In addition, in the case of a technology that displays information on a target object in text, it has the advantage of providing detailed information that is not revealed in visual information, but there is a limitation in that it cannot provide detailed visual information such as the shape or color of an actual object.

본 발명의 특정 실시 예들의 목적은 종래기술과 관련된 문제점들 및/또는 단점들 중의 적어도 하나를 적어도 부분적으로 해결, 경감 또는 제거하는 것이다.It is an object of certain embodiments of the present invention to at least partially solve, alleviate or eliminate at least one of the problems and/or disadvantages associated with the prior art.

본 발명의 일 목적은, 기존의 이미지 확대 및 텍스트 정보 표시의 정보 제공 방식을 개선하기 위한 것으로, 시선을 추적하여 주목하는 대상을 판별한 후 이미지를 재처리하거나 관련된 이미지 등으로 대체하여 보다 시인성이 높은 이미지를 제공함으로써, 사용자가 편안하게 대상을 식별할 수 있고 사용자에게 보다 풍부한 시각 정보를 제공함에 있다.An object of the present invention is to improve the information provision method of the existing image enlargement and text information display, and after identifying the object of interest by tracking the gaze, the image is reprocessed or replaced with a related image to provide more visibility. By providing a high image, the user can comfortably identify an object and provide richer visual information to the user.

본 발명의 일 측면에 따른 시선 추적을 이용한 시인성 개선 방법은, 카메라를 이용하여 사용자의 시선을 검출하는 과정과; 전자 장치의 디스플레이 유닛을 통해 보이는 적어도 하나의 객체 또는 투명한 디스플레이 등에 사용자의 시선의 연장선상에 있는 객체 중에서 상기 사용자의 시선이 가리키는 주목 대상을 확인하는 과정과; 상기 주목 대상에 대응하며 상기 주목 대상보다 시인성이 높은 이미지를 상기 디스플레이 유닛을 통해 표시하는 과정을 포함한다.A method for improving visibility using gaze tracking according to an aspect of the present invention includes the process of detecting a user's gaze using a camera; Identifying an object of interest indicated by the user's gaze from among at least one object visible through a display unit of the electronic device or an object extending from the user's gaze on a transparent display; And displaying an image corresponding to the target of interest and having a higher visibility than the target of interest through the display unit.

본 발명의 다른 측면에 따른 전자 장치는, 사용자의 눈을 촬영하는 카메라와; 적어도 하나의 객체를 표시하는 디스플레이 유닛과; 상기 촬영된 사용자의 눈에서 시선을 검출하고, 상기 적어도 하나의 객체 중에서 상기 사용자의 시선이 가리키는 주목 대상을 확인하고, 상기 주목 대상에 대응하며 상기 주목 대상보다 시인성이 높은 이미지를 상기 디스플레이 유닛을 통해 표시하는 제어부를 포함한다.An electronic device according to another aspect of the present invention includes a camera for photographing a user's eyes; A display unit that displays at least one object; Detects a gaze from the photographed user's eye, identifies an object of interest indicated by the user's gaze among the at least one object, and displays an image corresponding to the object of interest and having a higher visibility than the object of interest through the display unit And a display control unit.

본 발명에 따르면, 시선을 추적하여 주목하는 대상을 판별한 후 이미지를 재처리하거나 관련된 이미지 등으로 대체하여 보다 시인성이 높은 이미지를 제공함으로써, 사용자가 편안하게 대상을 식별할 수 있고 사용자에게 보다 풍부한 시각 정보를 제공할 수 있다.According to the present invention, by providing an image with higher visibility by reprocessing the image or replacing it with a related image, after determining the object of interest by tracking the gaze, the user can comfortably identify the object and provide a richer Visual information can be provided.

도 1은 본 발명의 제1 예에 따른 제1 전자 장치를 나타내는 개략적인 블록도,

도 2는 본 발명의 제1 예에 따른 제1 전자 장치의 전면 사시도를 나타낸 도면,

도 3은 본 발명의 제1 예에 따른 제1 전자 장치의 후면 사시도를 나타낸 도면,

도 4는 본 발명의 제2 예에 따른 제2 전자 장치를 외측에서 본 사시도,

도 5는 제2 전자 장치를 내측에서 본 사시도,

도 6은 제2 전자 장치의 회로 구성을 나타내는 도면,

도 7은 본 발명의 제1 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도,

도 8은 사용자의 눈을 나타내는 도면,

도 9는 얼굴 표정에 근거한 주목 여부의 판단 방법을 설명하기 위한 도면,

도 10은 본 발명의 제1 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면,

도 11은 본 발명의 제2 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면,

도 12는 본 발명의 제3 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면,

도 13은 본 발명의 제1 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면,

도 14는 본 발명의 제2 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면,

도 15는 본 발명의 제3 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면,

도 16은 본 발명의 제4 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면,

도 17은 서버의 구성을 나타내는 도면,

도 18 및 도 19는 본 발명의 제5 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면들,

도 20은 본 발명의 제6 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면,

도 21은 본 발명의 일 예에 따른 시인성 높은 이미지의 표시를 중단하는 방법을 설명하기 위한 도면,

도 22는 본 발명의 제2 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도,

도 23은 본 발명의 제3 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도,

도 24는 주목 대상의 변경을 설명하기 위한 도면.1 is a schematic block diagram illustrating a first electronic device according to a first example of the present invention;

2 is a front perspective view of a first electronic device according to a first example of the present invention;

3 is a rear perspective view of a first electronic device according to a first example of the present invention;

4 is a perspective view of a second electronic device according to a second example of the present invention as viewed from the outside;

5 is a perspective view of a second electronic device as viewed from the inside;

6 is a diagram showing a circuit configuration of a second electronic device;

7 is a flow chart showing a method for improving visibility using gaze tracking according to a first example of the present invention;

8 is a diagram showing a user's eyes;

9 is a diagram for explaining a method of determining whether attention is paid based on facial expressions;

10 is a diagram for explaining a method of detecting a target of interest according to a first example of the present invention;

11 is a diagram for explaining a method of detecting a target of interest according to a second example of the present invention;

12 is a diagram for explaining a method of detecting a target of interest according to a third example of the present invention;

13 is a diagram for explaining a method of displaying an image with high visibility according to a first example of the present invention;

14 is a diagram for explaining a method of displaying an image with high visibility according to a second example of the present invention;

15 is a diagram for explaining a method of displaying an image with high visibility according to a third example of the present invention;

16 is a diagram for explaining a method of displaying an image with high visibility according to a fourth example of the present invention;

17 is a diagram showing the configuration of a server;

18 and 19 are diagrams for explaining a method of displaying an image with high visibility according to a fifth example of the present invention;

20 is a view for explaining a method of displaying an image with high visibility according to a sixth example of the present invention;

21 is a diagram for explaining a method of stopping display of an image with high visibility according to an example of the present invention;

22 is a flow chart showing a method for improving visibility using gaze tracking according to a second example of the present invention;

23 is a flow chart showing a method for improving visibility using gaze tracking according to a third example of the present invention;

24 is a diagram for explaining a change of a target of interest.

본 발명은 다양한 변경을 가할 수 있고 여러 가지 실시 예를 가질 수 있는 바, 특정 실시 예들을 도면에 예시하여 상세하게 설명한다. 그러나, 이는 본 발명을 특정한 실시 형태에 대해 한정하려는 것이 아니며, 본 발명의 사상 및 기술 범위에 포함되는 모든 변경, 균등물 내지 대체물을 포함하는 것으로 이해되어야 한다.In the present invention, various modifications may be made and various embodiments may be provided, and specific embodiments will be described in detail by exemplifying them in the drawings. However, this is not intended to limit the present invention to a specific embodiment, it is to be understood to include all changes, equivalents, and substitutes included in the spirit and scope of the present invention.

제1, 제2 등과 같이 서수를 포함하는 용어는 다양한 구성요소들을 설명하는데 사용될 수 있지만, 상기 구성요소들은 상기 용어들에 의해 한정되지는 않는다. 상기 용어들은 하나의 구성요소를 다른 구성요소로부터 구별하는 목적으로만 사용된다. 예를 들어, 본 발명의 권리 범위를 벗어나지 않으면서 제1 구성요소는 제2 구성요소로 명명될 수 있고, 유사하게 제2 구성요소도 제1 구성요소로 명명될 수 있다. 및/또는 이라는 용어는 복수의 관련된 기재된 항목들의 조합 또는 복수의 관련된 기재된 항목들 중의 어느 항목을 포함한다.Terms including ordinal numbers, such as first and second, may be used to describe various elements, but the elements are not limited by the terms. These terms are used only for the purpose of distinguishing one component from another component. For example, without departing from the scope of the present invention, a first element may be referred to as a second element, and similarly, a second element may be referred to as a first element. The term and/or includes a combination of a plurality of related listed items or any of a plurality of related listed items.

본 출원에서 사용한 용어는 단지 특정한 실시 예를 설명하기 위해 사용된 것으로, 본 발명을 한정하려는 의도가 아니다. 단수의 표현은 문맥상 명백하게 다르게 뜻하지 않는 한, 복수의 표현을 포함한다. 본 출원에서, "포함하다" 또는 "가지다" 등의 용어는 명세서상에 기재된 특징, 숫자, 단계, 동작, 구성요소, 부품 또는 이들을 조합한 것이 존재함을 지정하려는 것이지, 하나 또는 그 이상의 다른 특징들이나 숫자, 단계, 동작, 구성요소, 부품 또는 이들을 조합한 것들의 존재 또는 부가 가능성을 미리 배제하지 않는 것으로 이해되어야 한다.The terms used in the present application are used only to describe specific embodiments, and are not intended to limit the present invention. Singular expressions include plural expressions unless the context clearly indicates otherwise. In the present application, terms such as "comprise" or "have" are intended to designate the presence of features, numbers, steps, actions, components, parts, or combinations thereof described in the specification, but one or more other features. It is to be understood that the presence or addition of elements or numbers, steps, actions, components, parts, or combinations thereof, does not preclude in advance.

다르게 정의되지 않는 한, 기술적이거나 과학적인 용어를 포함해서 여기서 사용되는 모든 용어들은 본 발명이 속하는 기술 분야에서 통상의 지식을 가진 자에 의해 일반적으로 이해되는 것과 동일한 의미를 가지고 있다. 일반적으로 사용되는 사전에 정의되어 있는 것과 같은 용어들은 관련 기술의 문맥 상 가지는 의미와 일치하는 의미를 가지는 것으로 해석되어야 하며, 본 출원에서 명백하게 정의하지 않는 한, 이상적이거나 과도하게 형식적인 의미로 해석되지 않는다.Unless otherwise defined, all terms used herein, including technical or scientific terms, have the same meaning as commonly understood by one of ordinary skill in the art to which the present invention belongs. Terms as defined in a commonly used dictionary should be interpreted as having a meaning consistent with the meaning in the context of the related technology, and should not be interpreted as an ideal or excessively formal meaning unless explicitly defined in this application. Does not.

본 발명에서 전자 장치는 임의의 장치일 수 있으며, 전자 장치는 휴대 단말, 이동 단말, 통신 단말, 휴대용 통신 단말, 휴대용 이동 단말 등으로 칭할 수 있다.In the present invention, the electronic device may be any device, and the electronic device may be referred to as a portable terminal, a mobile terminal, a communication terminal, a portable communication terminal, a portable mobile terminal, or the like.

예를 들어, 전자 장치는 스마트폰, 휴대폰, 게임기, TV, 디스플레이 장치, 차량용 헤드 유닛, 노트북 컴퓨터, 랩탑 컴퓨터, 태블릿(Tablet) 컴퓨터, PMP(Personal Media Player), PDA(Personal Digital Assistants) 등일 수 있다. 전자 장치는 무선 통신 기능을 갖는 포켓 사이즈의 휴대용 통신 단말이나 부착형 통신 단말로서 구현될 수 있다. 또한, 전자 장치는 플렉서블 장치, 플렉서블 디스플레이 장치, 투명 디스플레이 장치 등일 수 있다.For example, the electronic device may be a smartphone, a mobile phone, a game machine, a TV, a display device, a vehicle head unit, a notebook computer, a laptop computer, a tablet computer, a personal media player (PMP), personal digital assistants (PDA), and the like. have. The electronic device may be implemented as a pocket-sized portable communication terminal or an attached communication terminal having a wireless communication function. Also, the electronic device may be a flexible device, a flexible display device, a transparent display device, or the like.

본 발명의 제1 예에 따른 전자 장치는 휴대폰이며, 이러한 전자 장치의 대표적인 구성에서 일부 구성 소자는 필요에 따라 생략되거나 변경될 수 있다.The electronic device according to the first example of the present invention is a mobile phone, and in a typical configuration of such an electronic device, some constituent elements may be omitted or changed as necessary.

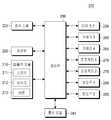

도 1은 본 발명의 제1 예에 따른 제1 전자 장치를 나타내는 개략적인 블록도이고, 도 2는 본 발명의 제1 예에 따른 제1 전자 장치의 전면 사시도를 나타낸 도면이고, 도 3은 본 발명의 제1 예에 따른 제1 전자 장치의 후면 사시도를 나타낸 도면이다.1 is a schematic block diagram illustrating a first electronic device according to a first example of the present invention, FIG. 2 is a front perspective view of a first electronic device according to a first example of the present invention, and FIG. 3 is a view A diagram showing a rear perspective view of a first electronic device according to a first example of the invention.

도 1을 참조하면, 제1 전자 장치(100)는 제1 통신 모듈(120), 커넥터 등을 통해 외부 전자 장치(도시되지 아니함)와 연결될 수 있다. 외부 전자 장치는 무선으로 연결 가능한 블루투스 통신 장치, NFC(Near Field Communication) 장치, 와이파이 다이렉트(WiFi Direct) 통신 장치, 무선 액세스 포인트(AP, Access Point)를 포함할 수 있다. 그리고, 제1 전자 장치(100)는 유선 또는 무선을 이용하여 다른 휴대 단말 또는 전자 장치, 예를 들어, 휴대폰, 스마트폰, 태블릿 PC, 데스크탑 PC 및 서버 중의 하나와 연결될 수 있다.Referring to FIG. 1, a first

도 1을 참조하면, 제1 전자 장치(100)는 적어도 하나의 터치 스크린(190)을 포함한다. 또한, 제1 전자 장치(100)는 제1 제어부(110), 제1 통신 모듈(120), 카메라 모듈(150), 제1 입/출력 모듈(160), 제1 센서 모듈(170) 및 제1 저장부(175)를 포함한다.Referring to FIG. 1, a first

제1 제어부(110)는 CPU(111), 제1 전자 장치(100)의 제어를 위한 제어 프로그램이 저장된 롬(ROM, 112) 및 제1 전자 장치(100)의 외부로부터 입력되는 신호 또는 데이터를 기억하거나, 제1 전자 장치(100)에서 수행되는 작업을 위한 기억 영역으로 사용되는 램(RAM, 113)을 포함할 수 있다. CPU(111)는 싱글 코어, 듀얼 코어, 트리플 코어 또는 쿼드 코어를 포함할 수 있다. CPU(111), 롬(112) 및 램(113)은 내부 버스(bus)를 통해 상호 연결될 수 있다.The

또한, 제1 제어부(110)는 제1 통신 모듈(120), 카메라 모듈(150), 제1 입/출력 모듈(160), 제1 센서 모듈(170), 제1 저장부(175) 및 터치 스크린(190)을 제어할 수 있다.In addition, the

제1 제어부(110)는 터치 스크린(190) 상에 복수의 객체 또는 아이템이 표시된 상태에서 사용자의 손가락 등의 터치 가능한 사용자 입력 수단이 어느 하나의 객체를 터치하거나, 그에 접근하거나, 그에 근접하게 위치함에 따른 사용자 입력을 감지하고, 사용자 입력이 발생한 터치 스크린(190) 상의 위치에 대응하는 객체를 식별한다. 터치 스크린(190)을 통한 사용자 입력은 객체를 직접 터치하는 직접 터치 입력과, 미리 설정된 인식 거리 이내로 객체에 접근하지만 객체를 직접 터치하지 않는 간접 터치 입력인 호버링 입력 중의 하나를 포함한다. 본 발명에서 사용자 입력은, 터치 스크린(190)을 통한 사용자 입력 외에, 카메라 모듈(150)을 통한 제스처 입력, 버튼(161)을 통한 스위치/버튼 입력, 마이크(162)를 통한 음성 입력 등을 포함한다.When a plurality of objects or items are displayed on the

객체 또는 아이템(또는 기능 아이템)은 제1 전자 장치(100)의 터치 스크린(190) 상에 표시되거나, 표시될 수 있는 것으로서, 예를 들어, 이미지, 애플리케이션, 메뉴, 문서, 위젯, 사진, 동영상, 이메일, SMS 메시지 및 MMS 메시지 중 적어도 하나를 나타내며, 사용자 입력 수단에 의해 선택, 실행, 삭제, 취소, 저장 및 변경될 수 있다. 이러한 아이템은 버튼, 아이콘(또는 단축 아이콘), 썸네일 이미지 또는 단말에서 적어도 하나의 객체를 저장하고 있는 폴더를 포괄하는 의미로도 사용될 수 있다. 또한, 이러한 아이템은 이미지, 텍스트 등의 형태로 표시될 수 있다.The object or item (or function item) is displayed on or can be displayed on the

단축 아이콘은 각각의 애플리케이션 또는 제1 전자 장치(100)에서 기본적으로 제공되는 통화, 연락처, 메뉴 등의 빠른 실행을 위해 제1 전자 장치(100)의 터치 스크린(190) 상에 표시되는 이미지로서, 이를 실행하기 위한 명령 또는 선택이 입력되면 해당 애플리케이션을 실행한다.The shortcut icon is an image displayed on the

제1 제어부(110)는 미리 설정된 아이템 또는 객체에 대해, 또는 미리 설정된 방식에 따라 사용자 입력 이벤트가 발생되면, 사용자 입력 이벤트에 대응하는 미리 설정된 프로그램 동작을 수행한다.When a user input event occurs with respect to a preset item or object or according to a preset method, the

제1 전자 장치(100)는 성능에 따라 이동 통신 모듈(121), 무선랜 모듈(131), 및 근거리 통신 모듈(132) 중 적어도 하나를 포함할 수 있다.The first

이동 통신 모듈(121)은 제1 제어부(110)의 제어에 따라 적어도 하나-하나 또는 복수-의 안테나(도시되지 아니함)를 이용하여 이동 통신을 통해 제1 전자 장치(100)가 외부 전자 장치와 연결되도록 할 수 있다. 이동 통신 모듈(121)은 제1 전자 장치(100)에 입력되는 전화번호를 가지는 휴대폰(도시되지 아니함), 스마트폰(도시되지 아니함), 태블릿 PC 또는 다른 전자 장치(도시되지 아니함)와 음성 통화, 화상 통화, 문자메시지(SMS) 또는 멀티미디어 메시지(MMS)를 위한 무선 신호를 통신사에 의해 제공되는 통신망을 거쳐 송/수신한다.The

서브 통신 모듈(130)은 무선랜 모듈(131)과 근거리 통신 모듈(132) 중 적어도 하나를 포함할 수 있다. 예를 들어, 무선랜 모듈(131)만 포함하거나, 근거리 통신 모듈(132)만 포함하거나 또는 무선랜 모듈(131)과 근거리 통신 모듈(132)을 모두 포함할 수 있다. 서브 통신 모듈(130)은 복수의 근거리 통신 모듈을 포함할 수도 있다.The

무선랜 모듈(131)은 제1 제어부(110)의 제어에 따라 무선 액세스 포인트(AP, access point)(도시되지 아니함)가 설치된 장소에서 인터넷에 연결될 수 있다. 무선랜 모듈(131)은 미국전기전자학회(IEEE)의 무선랜 규격(IEEE802.11x)을 지원한다. 근거리 통신 모듈(132)은 제1 제어부(110)의 제어에 따라 제1 전자 장치(100)과 외부 전자 장치 사이에 무선으로 근거리 통신을 할 수 있다. 근거리 통신 방식은 블루투스(bluetooth), 적외선 통신(IrDA, infrared data association), 와이파이 다이렉트(WiFi-Direct) 통신, NFC(Near Field Communication) 등이 포함될 수 있다.The

카메라 모듈(150)은 제1 제어부(110)의 제어에 따라 정지 이미지 또는 동영상을 촬영하는 제1 카메라(151) 및 제2 카메라(152) 중 적어도 하나를 포함할 수 있다. 또한, 카메라 모듈(150)은 피사체를 촬영하기 위해 필요한 보조 광원을 제공하는 플래시(153)를 더 포함할 수 있다. 제1 카메라(151)는 상기 제1 전자 장치(100) 전면에 배치되고, 제2 카메라(152)는 상기 제1 전자 장치(100)의 후면에 배치될 수 있다.The

제1 및 제2 카메라(151, 152)는 각각 렌즈계, 이미지 센서 등을 포함할 수 있다. 제1 및 제2 카메라(151, 152)는 각각 렌즈계를 통해 입력되는(또는 촬영되는) 광신호를 전기적인 이미지 신호(또는 디지털 이미지)로 변환하여 제1 제어부(110)로 출력하고, 사용자는 이러한 제1 및 제2 카메라(151, 152)를 통해 동영상 또는 정지 이미지를 촬영할 수 있다.Each of the first and

제1 입/출력 모듈(160)은 적어도 하나의 버튼(161), 적어도 하나의 마이크(162), 적어도 하나의 스피커(163), 커넥터 중 적어도 하나를 포함할 수 있다.The first input/

버튼(161)은 상기 제1 전자 장치(100)의 하우징(또는 케이스)의 전면, 측면 또는 후면에 형성될 수 있으며, 전원/잠금 버튼, 볼륨 버튼, 메뉴 버튼, 홈 버튼, 돌아가기 버튼(back button) 및 검색 버튼 중 적어도 하나를 포함할 수 있다.The

마이크(162)는 제1 제어부(110)의 제어에 따라 음성(voice) 또는 소리를 입력 받아 전기적인 신호를 생성한다.The

스피커(163)는 제1 제어부(110)의 제어에 따라 다양한 신호 또는 데이터(예를 들어, 무선 데이터, 방송 데이터, 디지털 오디오 데이터, 디지털 동영상 데이터 등)에 대응되는 소리를 제1 전자 장치(100)의 외부로 출력할 수 있다. 커넥터(도시되지 아니함)는 상기 제1 전자 장치(100)와 외부 전자 장치 또는 전원 소스(도시되지 아니함)를 연결하기 위한 인터페이스로 이용될 수 있다. 제1 제어부(110)는 커넥터에 연결된 유선 케이블을 통해 제1 전자 장치(100)의 제1 저장부(175)에 저장된 데이터를 외부 전자 장치로 전송하거나 외부 전자 장치로부터 데이터를 수신할 수 있다.The

제1 센서 모듈(170)은 제1 전자 장치(100)의 상태 또는 주변 환경 상태를 검출하는 적어도 하나의 센서를 포함한다. 예를 들어, 제1 센서 모듈(170)은 사용자의 제1 전자 장치(100)에 대한 접근 여부를 검출하는 근접 센서, 제1 전자 장치(100) 주변의 빛의 양을 검출하는 조도 센서, 또는 제1 전자 장치(100)의 동작(예를 들어, 제1 전자 장치(100)의 회전, 제1 전자 장치(100)의 가속 또는 진동)을 검출하는 모션 센서(도시되지 아니함), 제1 전자 장치(100)의 회전 운동을 검출하는 자이로스코프, 제1 전자 장치(100)의 가속 운동을 검출하는 가속도계, 지구 자기장을 이용해 제1 전자 장치(100)의 방위(point of the compass)를 검출하는 지자기 센서(Geo-magnetic Sensor), 중력의 작용 방향을 검출하는 중력 센서(Gravity Sensor), 대기의 압력을 측정하여 고도를 검출하는 고도계(Altimeter), GPS 모듈(157) 등의 적어도 하나의 센서를 포함할 수 있다.The

또한, 제1 센서 모듈(170)은 제1 및 제2 생체 센서(171, 176)를 포함한다.In addition, the

제1 생체 센서(171)는 제1 전자 장치(100)의 전면에 배치되며, 제1 생체 센서(171)는 제1 적외선 광원(172)과 제1 적외선 카메라(173)를 포함한다. 제1 적외선 광원(172)은 적외선을 출력하고, 제1 적외선 카메라(173)는 피사체로부터 반사된 적외선을 검출한다. 예를 들어, 제1 적외선 광원(172)은 행렬 구조의 LED 어레이로 구성될 수 있다.The first

예를 들어, 제1 적외선 카메라(173)는 적외선을 통과시키고 적외선 이외의 파장 대역을 차단하는 필터와, 필터를 통과한 적외선을 포커싱하는 렌즈계와, 렌즈계에 의해 형성된 광학 이미지를 전기적인 이미지 신호로 변환하여 출력하는 이미지 센서를 포함할 수 있다. 예를 들어, 이미지 센서는 행렬 구조의 PD 어레이로 구성될 수 있다.For example, the first

제2 생체 센서(176)는 제1 전자 장치(100)의 후면에 배치되며, 제2 생체 센서(176)는 제1 생체 센서(171)와 동일한 구성을 가지며, 제2 적외선 광원(177)과 제2 적외선 카메라(178)를 포함한다.The second

GPS 모듈(157)은 지구 궤도상에 있는 복수의 GPS 위성(도시되지 아니함)으로부터 전파를 수신하고, GPS 위성으로부터 제1 전자 장치(100)까지의 전파 도달 시간(Time of Arrival)을 이용하여 제1 전자 장치(100)의 위치를 산출할 수 있다.The

제1 저장부(175)는 제1 제어부(110)의 제어에 따라 제1 통신 모듈(120), 카메라 모듈(150), 제1 입/출력 모듈(160), 제1 센서 모듈(170) 또는 터치 스크린(190)의 동작에 따라 입/출력되는 신호 또는 데이터를 저장할 수 있다. 제1 저장부(175)는 제1 전자 장치(100) 또는 제1 제어부(110)의 제어를 위한 제어 프로그램 및 애플리케이션들을 저장할 수 있다.The

또한, 제1 저장부(175)는 네비게이션, 화상 통화, 게임, 사용자에게 시간을 기반으로 하는 알람 애플리케이션 등과 같은 다양한 기능들의 애플리케이션들과 이와 관련된 그래픽 사용자 인터페이스(graphical user interface: GUI)를 제공하기 위한 이미지들, 사용자 정보, 문서, 시선 추적을 이용한 시인성 개선 방법과 관련된 데이터베이스들 또는 데이터, 제1 전자 장치(100)을 구동하는데 필요한 배경 이미지들(메뉴 화면, 대기 화면 등) 또는 운영 프로그램들, 카메라 모듈(150)에 의해 촬영된 이미지들 등을 저장할 수 있다.In addition, the

또한, 제1 저장부(175)는 본 발명에 따른 시선 추적을 이용한 시인성 개선 방법을 실행하기 위한 프로그램 및 관련 데이터를 저장할 수 있다.In addition, the

제1 저장부(175)는 기계(예를 들어, 컴퓨터)로 읽을 수 있는 매체이며, 기계로 읽을 수 있는 매체라는 용어는 기계가 특정 기능을 수행할 수 있도록 상기 기계로 데이터를 제공하는 매체로 정의될 수 있다. 저장부(175)는 비휘발성 매체(non-volatile media) 및 휘발성 매체를 포함할 수 있다. 이러한 모든 매체는 상기 매체에 의해 전달되는 명령들이 상기 명령들을 상기 기계로 읽어 들이는 물리적 기구에 의해 검출될 수 있도록 유형의 것이어야 한다.The

상기 기계로 읽을 수 있는 매체는, 이에 한정되지 않지만, 플로피 디스크(floppy disk), 플렉서블 디스크(flexible disk), 하드 디스크, 자기 테이프, 시디롬(compact disc read-only memory: CD-ROM), 광학 디스크, 펀치 카드(punch card), 페이퍼 테이프(paper tape), 램, 피롬(Programmable Read-Only Memory: PROM), 이피롬(Erasable PROM: EPROM) 및 플래시-이피롬(FLASH-EPROM) 중의 적어도 하나를 포함한다.The machine-readable medium includes, but is not limited to, a floppy disk, a flexible disk, a hard disk, a magnetic tape, a compact disc read-only memory (CD-ROM), and an optical disk. , Punch card, paper tape, RAM, Programmable Read-Only Memory (PROM), Erasable PROM (EPROM) and Flash-EPROM (FLASH-EPROM) Include.

그리고, 제1 전자 장치(100)는 사용자에게 다양한 서비스(예, 통화, 데이터 전송, 방송, 사진촬영)에 대응되는 사용자 그래픽 인터페이스를 제공하는 적어도 하나의 터치 스크린(190)을 포함할 수 있다.In addition, the first

터치 스크린(190)은 사용자의 신체(예를 들어, 엄지를 포함하는 손가락) 또는 입력 유닛(예를 들어, 스타일러스 펜, 전자 펜)을 통해 적어도 하나의 사용자 입력을 수신할 수 있다.The

터치 스크린(190)은 하나의 터치의 연속적인 움직임(즉, 드래그 입력)을 수신할 수도 있다. 본 발명에서 터치는 터치 스크린(190)과 손가락 또는 입력 유닛과의 접촉에 한정되지 않고, 비접촉(예를 들어, 터치 스크린(190)과의 직접 접촉 없이 사용자 입력 수단을 검출할 수 있는 인식 거리(예를 들어, 1cm) 이내에 사용자 입력 수단이 위치하는 경우)을 포함할 수 있다.The

이러한, 터치 스크린(190)은 예를 들어, 저항막(resistive) 방식, 정전용량(capacitive) 방식, 적외선(infrared) 방식, 초음파(acoustic wave) 방식, EMR(Electromagnetic Resonance) 방식 또는 이들의 조합으로 구현될 수 있다.The

도 2 및 도 3을 참조하면, 제1 전자 장치(100)의 전면(101) 중앙에는 터치 스크린(190)이 배치된다. 터치 스크린(190)은 제1 전자 장치(100)의 전면(101)의 대부분을 차지하도록 크게 형성될 수 있다.2 and 3, a

상기 터치 스크린(190)의 아래에는 홈 버튼(161a), 메뉴 버튼(161b), 뒤로 가기 버튼(161c) 등과 같은 터치 키들, 기계식 버튼들 또는 이들의 조합이 형성될 수 있다. 또한, 이러한 터치 키들은 상기 터치 스크린(190)의 일부로 구성될 수 있다.Touch keys such as a

홈 버튼(161a)은 터치 스크린(190)에 메인 홈 화면(main Home screen)을 표시한다.The

메뉴 버튼(161b)은 터치 스크린(190) 상에 표시될 수 있는 연결 메뉴를 제공한다. 상기 연결 메뉴에는 위젯 추가 메뉴, 배경화면 변경 메뉴, 검색 메뉴, 편집 메뉴, 환경 설정 메뉴 등이 포함될 수 있다.The

뒤로 가기 버튼(161c)은 현재 실행되고 있는 화면의 바로 이전에 실행되었던 화면을 표시하거나, 가장 최근에 사용된 애플리케이션을 종료시키는 경우에 사용될 수 있다.The

제1 전자 장치(100)의 전면(101)의 상측에는 제1 카메라(151), 조도 센서(170a), 근접 센서(170b) 및 제1 생체 센서(171)가 배치될 수 있다. 제1 전자 장치(100)의 후면(103)에는 제2 카메라(152), 플래시(flash, 153), 스피커(163) 및 제2 생체 센서(176)가 배치될 수 있다.A

제1 전자 장치(100)의 측면(102)에는 예를 들어 전원/잠금 버튼, 볼륨 증가 버튼(161f) 및 볼륨 감소 버튼(161g)을 갖는 볼륨 버튼(161e), 하나 또는 복수의 마이크들(162) 등이 배치될 수 있다.On the

또한, 제1 전자 장치(100)의 하단 측면에는 커넥터가 형성될 수 있다. 커넥터에는 다수의 전극들이 형성되어 있으며 외부 장치와 유선으로 연결될 수 있다.In addition, a connector may be formed on a lower side of the first

본 발명은 시선 추적을 이용한 시인성 개선 방법을 제공하며, 이러한 시선 추적을 이용한 시인성 개선 방법은 일반적인 터치 스크린 상의 객체, 투명 터치 스크린을 통해 보이는 주변 객체, 증강 현실, 헤드-마운티드 디스플레이(Head Mounted Display: HMD) 장치 등에 적용될 수 있다.The present invention provides a method for improving visibility using gaze tracking, and the method for improving visibility using gaze tracking includes an object on a general touch screen, surrounding objects visible through a transparent touch screen, augmented reality, and a head-mounted display. HMD) device, etc.

제1 제어부(110)는 제1 전자 장치(100)의 전반적인 동작을 제어하며, 제1 제어부(110)는 제1 전자 장치(100) 내 다른 구성 소자들을 제어하여 본 발명에 따른 시선 추적을 이용한 시인성 개선 방법을 수행한다.The

도 4는 본 발명의 제2 예에 따른 제2 전자 장치를 외측에서 본 사시도이고, 도 5는 제2 전자 장치를 내측에서 본 사시도이다. 제2 예에 따른 제2 전자 장치(200)는 헤드-마운티드 디스플레이(Head Mounted Display: HMD)이다.4 is a perspective view of a second electronic device according to a second example of the present invention as viewed from the outside, and FIG. 5 is a perspective view of the second electronic device as viewed from the inside. The second

제2 전자 장치(200)는 전체적으로 안경의 외관을 가지며, 휴대 가능한 단말(또는 휴대 통신 단말)이며, 하우징(10)과, 하우징(10) 내에 실장된 회로를 포함한다.The second

하우징(10)은 좌측 눈 및 우측 눈에 각각 대응되는 제1 및 제2 윈도우(280, 285)가 고정되는 프론트 프레임(15)과, 제1 및 제2 힌지(22, 23)에 의해 내측으로 접거나 외측으로 펼칠 수 있는 제1 및 제2 템플 프레임(20, 21)을 포함한다. 이하, 좌측 눈 및 우측 눈은 제1 눈 및 제2 눈으로 칭할 수도 있다. 본 발명에서, 제1 및 제2 윈도우(280, 285)는 제1 및 제2 윈도우 패널이라고 칭할 수도 있다.The

프론트 프레임(15)의 내측면에는 제3 카메라(260)가 배치되어 있고, 프론트 프레임(15)의 외측면에는 제4 카메라(265)가 배치되어 있으며, 제3 및 제4 카메라(260, 265)는 제1 및 제2 윈도우(280, 285) 사이의 프론트 프레임(15)의 부분(즉, 통상의 안경에서 브릿지에 해당)에 배치된다.A

또한, 프론트 프레임(15)의 외측면에는 마이크(212)가 배치되어 있고, 또한 프론트 프레임(15)의 외측면에 터치 센서(250)가 배치되어 있다.Further, a

프론트 프레임(15)의 내측면에는 프론트 프레임(15) 내에 배치된 제1 프로젝터(270)로부터 출력되는 제1 투사 광(310)이 프론트 프레임(15)의 외부로 출력되는 통로가 되는 제1 개구(11)가 배치되어 있다. 또한, 프론트 프레임(15)의 내측면에는 프론트 프레임(15) 내에 배치된 제2 프로젝터(275)로부터 출력되는 제2 투사 광(320)이 프론트 프레임(15)의 외부로 출력되는 통로가 되는 제2 개구(12)가 배치되어 있다.A first opening in the inner side of the

제1 템플 프레임(20)의 외측면에는 적어도 하나의 버튼(213)이 배치된다.At least one

제1 및 제2 템플 프레임(20, 21)의 내측면에는 적어도 하나의 스피커(211)가 배치된다.At least one

제1 프로젝터(270)는 제1 가상 이미지를 형성하기 위한 제1 투사 광(310)을 출력하고, 제1 프로젝터(270)로부터 출력되는 제1 투사 광(310)은 제1 윈도우(280)에 의해 집속 및 반사되고, 집속 및 반사된 제1 투사 광(312)은 사용자의 좌측 눈(330)의 망막에 제1 가상 이미지를 형성한다. 이때, 집속은 광을 모으는 것을 말하고, 광을 한 점에 모으는 수렴이나, 광의 빔 스팟을 감소시키는 것 등을 포함하는 의미이다. 바람직하게는, 반사된 제1 투사 광(312)은 좌측 눈(330)의 수정체 또는 동공에 수렴한다.The

제2 프로젝터(275)는 제2 가상 이미지를 형성하기 위한 제2 투사 광(320)을 출력하고, 제2 프로젝터(275)로부터 출력되는 제2 투사 광(320)은 제2 윈도우(285)에 의해 집속 및 반사되고, 집속 및 반사된 제2 투사 광(322)은 사용자의 우측 눈(335)의 망막에 제2 가상 이미지를 형성한다. 바람직하게는, 집속 및 반사된 제2 투사 광(322)은 우측 눈(335)의 수정체 또는 동공에 수렴한다. 본 예에서, 2개의 프로젝터를 사용하는 것을 예시하고 있으나, 하나의 프로젝터만을 사용할 수도 있다.The

이하의 설명에서, 제1 가상 이미지와 제2 가상 이미지는 좌측 눈 및 우측 눈에 각각 표시된다는 점을 제외하고는 서로 동일하나, 본 발명은 이에 한정되지 않고, 제1 가상 이미지와 제2 가상 이미지 중의 하나만을 표시할 수도 있다.In the following description, the first virtual image and the second virtual image are the same as each other, except that the first virtual image and the second virtual image are respectively displayed on the left eye and the right eye, but the present invention is not limited thereto, and the first virtual image and the second virtual image You can also display only one of them.

도 6은 제2 전자 장치의 회로 구성을 나타내는 도면이다. 제2 전자 장치(200)의 회로 구성은 제1 전자 장치(100)의 회로 구성과 유사하므로, 중복되는 설명은 생략하기로 한다.6 is a diagram showing a circuit configuration of a second electronic device. Since the circuit configuration of the second

제2 전자 장치(200)는 제2 입/출력 모듈(210)과, 제2 저장부(220)와, 제2 센서 모듈(225)과, 제2 통신 모듈(240)과, 터치 센서(250)와, 제3 및 제4 카메라(260, 265)와, 제1 및 제2 프로젝터(270, 275)와, 제1 및 제2 윈도우(280, 285)와, 제2 제어부(290)를 포함한다.The second

제2 입/출력 모듈(210)은 사용자 입력을 수신하거나, 사용자에게 정보를 알리거나, 외부로부터 데이터를 수신하거나, 외부로 데이터를 출력하기 위한 수단으로서, 적어도 하나의 스피커(211), 적어도 하나의 마이크(212), 적어도 하나의 버튼(213), 커넥터, 키패드 또는 이들의 조합을 포함할 수 있다.The second input/output module 210 is a means for receiving a user input, notifying a user of information, receiving data from the outside, or outputting data to the outside, at least one

하나의 마이크(212)가 프론트 프레임(15)의 외측면에 배치될 수 있다. 본 명세서에서, 신호는 데이터로 대체 표기될 수 있으며, 또한 데이터는 데이터 신호로도 표기할 수 있다.One

버튼(213)은 사용자 입력을 수신하기 위해 제공되며, 제2 전자 장치(200)의 온/오프, 메뉴 항목 또는 아이템의 선택 및/또는 검색 등을 위해 사용된다. 버튼(213)은 제1 템플 프레임(120)의 외측면에 배치될 수 있다.The

제2 센서 모듈(225)은 제2 전자 장치(100)의 상태 또는 주변 환경 상태를 검출하는 적어도 하나의 센서를 포함한다.The

제2 통신 모듈(240)은 유선, 무선 또는 유/무선 통신부일 수 있으며, 제2 제어부(290)로부터의 데이터를 유선 또는 무선으로 외부 통신망 또는 대기를 통해 외부 전자 장치로 전송하거나, 외부 통신망 또는 대기를 통해 외부 전자 장치로부터 데이터를 유선 또는 무선으로 수신하여 제2 제어부(290)로 전달한다.The

터치 센서(250)는 적어도 하나의 터치 입력에 대응되는 신호를 제2 제어부(290)로 전송할 수 있다. 제2 제어부(290)는 이러한 터치 입력 정보로부터 메뉴 항목 또는 아이템의 선택 또는 이동이나, 필기 입력 등의 사용자 입력 정보를 파악하고, 이러한 사용자 입력 정보에 대응하는 기능(전화 연결, 카메라 촬영, 메시지 작성/보기, 데이터 전송 등)을 수행한다.The

제3 및 제4 카메라(260, 265)는 각각 렌즈계 및 이미지 센서를 포함하고, 플래쉬 등을 더 포함할 수 있다. 제3 및 제4 카메라(260, 265)는 각각 렌즈계를 통해 입력되는(또는 촬영되는) 광을 전기적인 이미지 신호로 변환하여 제2 제어부(290)로 출력하고, 사용자는 이러한 카메라(260, 265)를 통해 동영상 또는 정지 이미지를 촬영할 수 있다.The third and

제2 제어부(290)는 카메라(260, 265)로부터 입력되는 이미지, 제2 저장부(220)에 저장된 이미지, 또는 제2 저장부(220)에 저장된 데이터를 이용하여 제2 제어부(290)에 의해 구성된 이미지를 프레임(frame) 단위로 처리하며, 제1 및/또는 제2 프로젝터(270, 275)의 화면 출력 특성(크기, 화질, 해상도 등)에 맞도록 변환된 이미지를 제1 및/또는 제2 프로젝터(270, 275)를 통해 외부로 출력한다.The

제2 제어부(290)는 제1 및/또는 제2 프로젝터(270, 275)를 통해 사용자에게 다양한 서비스(예, 통화, 데이터 전송, 방송, 사진촬영 등)에 대응되는 이미지를 제공할 수 있다.The

사용자는 주변 광에 의한 주변 풍경 이미지와 프로젝터(270, 275)로부터 입력된 광에 의한 가상 이미지가 중첩된 이미지를 보게 되며, 사용자에게 이러한 가상 이미지는 주변 풍경 위에 투명한 층이 겹쳐진 것처럼 보여질 수 있다.The user sees an image in which the surrounding landscape image by ambient light and the virtual image by light input from the

제2 제어부(290)는 제2 전자 장치(200)의 전반적인 동작을 제어하며, 제2 전자 장치(200) 내 다른 구성 소자들을 제어하여 시선 추적을 이용한 시인성 개선 방법을 수행한다.The

상기 제2 제어부(290)는 제2 센서 모듈(225), 제2 입/출력 모듈(210), 제3 또는 제4 카메라(260, 265), 또는 터치 센서(250)를 통해 입력되는 사용자 명령, 메뉴 항목 또는 아이콘 선택, 또는 이벤트 정보에 따라 제2 저장부(220)에 저장되어 있거나, 제2 통신 모듈(240)을 통해 수신되거나, 제2 저장부(220)에 저장된 데이터를 이용하여 제2 제어부(290)에 의해 구성된 이미지 데이터를 제1 및/또는 제2 프로젝터(270, 275)를 통해 사용자에게 표시할 수 있다. 이때, 상기 이미지는 정지 이미지 또는 동영상일 수 있다.The

제2 저장부(220)는 제2 제어부(290)의 제어에 따라 신호 또는 데이터를 저장할 수 있다. 제2 저장부(220)는 제2 전자 장치(200) 또는 제2 제어부(290)를 위한 제어 프로그램 및 애플리케이션들을 저장할 수 있다.The

이하, 제1 전자 장치를 위주로 하여, 시선 추적을 이용한 시인성 개선 방법을 설명하기로 한다.Hereinafter, focusing on the first electronic device, a method of improving visibility using gaze tracking will be described.

도 7은 본 발명의 제1 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도이다.7 is a flowchart illustrating a method of improving visibility using eye tracking according to a first example of the present invention.

S110 단계는 사용자 검출 단계로서, 제1 제어부(110)는 제1 카메라(151) 또는 제1 생체 센서(171)를 통해 사용자를 검출한다. 제1 제어부(110)는 제1 카메라(151)에 의해 촬영된 이미지 내에 포함된 피사체가 얼굴을 포함하는지의 여부를 판단할 수 있다.Step S110 is a user detection step, and the

예를 들어, 얼굴 인식은 통상의 얼굴 인식 방법을 이용하여 수행되는데, 제1 저장부(175)에 저장된 얼굴의 윤곽선, 얼굴 피부의 색상 및/또는 질감, 템플리트 등을 이용한 얼굴 인식 기술이 이용될 수 있다. 예를 들어, 제1 제어부(110)는 다수의 사용자의 얼굴 이미지들을 통해 얼굴 학습을 수행하고, 이러한 얼굴 학습에 근거하여 입력 이미지에서 얼굴을 인식할 수 있다. 이러한 얼굴 학습 정보는 제1 저장부(175)에 저장되어 있다.For example, face recognition is performed using a conventional face recognition method, and a face recognition technology using a face outline, a color and/or texture of the face skin, and a template stored in the

또한, 제1 제어부(110)는 제1 카메라(151)로부터 입력된 이미지에서 제1 전자 장치(100)에 미리 등록된 사용자가 검출되는지의 여부를 판단할 수도 있다. 이러한 사용자의 등록은 사용자를 검출하기 위한 정보를 제1 저장부(175)의 데이터베이스에 저장함으로써 이루어진다. 이러한 등록된 사용자를 검출하기 위한 정보는 사용자의 얼굴 이미지, 사용자 얼굴 이미지의 특징점(또는 특징 이미지, 특징 패턴 등으로 지칭할 수도 있음) 정보 등을 포함할 수 있다. 이러한 특징점은 에지, 코너, 이미지 패턴, 외곽선 등일 수 있다.Also, the

예를 들어, 제1 제어부(110)는 등록된 사용자 이미지의 특징점들과 입력 이미지에서 검출된 특징점들의 매칭 과정을 수행함으로써, 입력 이미지의 사용자가 등록된 사용자인지의 여부를 결정할 수 있다.For example, the

또는, 제1 제어부(110)는 제1 생체 센서(171)에 의해 촬영된 이미지 내에 포함된 피사체가 생체를 포함하는지의 여부를 판단할 수 있다.Alternatively, the

이러한 생체는 눈, 홍채, 얼굴, 혈관(정맥 등) 등을 포함할 수 있다.Such a living body may include eyes, iris, face, blood vessels (veins, etc.).

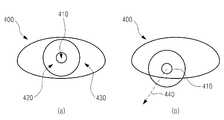

도 8은 사용자의 눈을 나타내는 도면이다.8 is a diagram illustrating a user's eyes.

도 8의 (a)를 참조하면, 사용자의 눈(400)은 동공(410), 홍채(420) 및 공막(430)을 가지며, 제1 적외선 광원(172)은 사용자의 눈(400)에 적외선을 조사하고, 제1 적외선 카메라(173)는 사용자의 눈(400)을 촬영하여 눈 이미지를 출력한다.Referring to FIG. 8A, the user's

예를 들어, 눈 인식은 통상의 눈 인식 방법을 이용하여 수행되는데, 제1 저장부(175)에 저장된 눈의 윤곽선, 템플리트 등을 이용한 눈 인식 기술이 이용될 수 있다. 예를 들어, 제1 제어부(110)는 다수의 사용자의 눈 이미지들을 통해 눈 학습을 수행하고, 이러한 눈 학습에 근거하여 입력 이미지에서 눈을 인식할 수 있다. 이러한 눈 학습 정보는 제1 저장부(175)에 저장되어 있다.For example, eye recognition is performed using a conventional eye recognition method, and an eye recognition technology using an outline of an eye or a template stored in the

또한, 제1 제어부(110)는 제1 저장부(175)에 저장된 사용자의 홍채 정보(홍채 이미지, 특징점 정보 등)와 입력 이미지를 비교함으로써, 사용자의 홍채를 인식할 수 있고, 입력 이미지의 사용자가 등록된 사용자인지의 여부를 결정할 수 있다.In addition, the

전술한 바와 마찬가지로, 제2 제어부(290)는 제3 카메라(260)를 통해 사용자를 검출할 수 있다.As described above, the

S120 단계는 시선 검출 단계로서, 제1 제어부(110)는 입력 이미지에서 사용자의 시선을 검출한다. 제1 제어부(100)는 통상의 눈 추적(Eye Tracking) 기술을 이용하여 입력 이미지에서 사용자의 시선을 검출할 수 있다.Step S120 is a gaze detection step, and the

도 8의 (b)를 참조하면, 제1 제어부(100)는 동공(410)의 포즈(위치 및/또는 방향)로부터 사용자의 시선(또는 시선 방향)을 검출한다.Referring to FIG. 8B, the

S130 단계는 주목 상태 확인 단계로서, 제1 제어부(110)는 사용자가 임의의 객체를 주목(또는 주시)하고 있는지의 여부를 판단한다. 예를 들어, 제1 제어부(110)는 입력 이미지 내 얼굴 표정, 시선 고정 시간 또는 동공(410)의 변화에 근거하여 사용자의 주목 여부를 판단할 수 있다.Step S130 is a step of checking the attention state, and the

도 9는 얼굴 표정에 근거한 주목 여부의 판단 방법을 설명하기 위한 도면이다.9 is a diagram for explaining a method of determining whether attention is paid based on facial expressions.

도 9의 (a)는 사용자가 주목하고 있지 않은 상태의 얼굴 표정을 나타내며, 양 눈(400)과, 양 눈썹(440)과, 미간 부위(450)에 위치한 양 눈썹(440) 사이의 추미근(460)(눈썹주름근)과, 미간 부위(450)에 위치한 양 눈(400) 사이의 비근근(470)(눈살근)이 표시되어 있다.9A shows facial expressions in a state that the user is not paying attention to, and between the

도 9의 (b)는 사용자가 주목하고 있는 상태의 얼굴 표정을 나타내며, 사용자가 주목하는 경우에, 일반적으로 미간을 찌푸리게 되며, 이러한 미간 부위(450)의 근육 변화를 이용하여 주목 여부를 판단할 수 있다. 예를 들어, 사용자가 주목하는 경우, 추미근의 움직임에 따라 양 눈썹(440) 사이가 좁아지면서 미간에 주름(480)이 생기는 변화와 비근근의 움직임에 따라 코가 위로 당겨지면서 콧등 부분에 주름(480)이 생기는 변화가 발생한다.9(b) shows the facial expression in a state that the user is paying attention to, and when the user pays attention, the glabellar is generally frowned, and whether or not attention can be determined by using the muscle change of the glabellar region 450 I can. For example, when the user pays attention, the

또는, 제1 제어부(110)는 시선 고정 시간에 근거하여 주목 여부를 판단하며, 사용자의 시선이 검출되면, 미리 설정된 제한 시간(즉, 임계값에 해당)을 갖는 타이머를 설정한다. 예를 들어, 타이머의 제한 시간은 1초일 수 있고, 타이머는 1초부터 0초까지 카운트 다운을 수행하고, 타이머의 잔여 시간이 0초가 되면 타이머의 만료를 제어부(110)에 통지하거나, 제1 제어부(110)가 타이머의 만료를 감지할 수 있다. 또는, 타이머는 0초부터 경과 시간을 카운트하고, 경과 시간이 1초가 되면 타이머의 만료를 제1 제어부(110)에 통지하거나, 제1 제어부(110)가 타이머의 만료를 감지할 수 있다. 제1 제어부(110)는 타이머의 제한 시간 동안에 시선 변화가 없으면 사용자가 주목하고 있는 것으로 판단할 수 있다.Alternatively, the

또는, 제1 제어부(110)는 사용자의 동공(410)의 변화를 통해 주목 여부를 판단하며, 주목할 때 동공(410)이 확장되는 현상을 이용하여 동공(410)의 변화로 주목 여부를 판단할 수 있다.Alternatively, the

제1 제어부(110)는 사용자가 주목 상태인 경우에 S140 단계를 수행하고, 사용자가 주목 상태가 아닌 경우에 사용자의 주목 여부를 주기적 또는 연속적으로 모니터링한다.The

S140 단계는 주목 대상/영역 검출 단계로서, 제1 제어부(110)는 사용자의 시선과 상면이 교차하는 영역(즉, 주목 영역)을 확인하고, 주목 영역에 위치하는 객체를 검출한다.In step S140, a target/area detection step is performed. The

도 10은 본 발명의 제1 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면이다. 본 예는 터치 스크린(190)이 불투명 터치 스크린인 경우를 예시한다.10 is a diagram illustrating a method of detecting a target of interest according to a first example of the present invention. This example illustrates a case where the

상면(510)은 터치 스크린(190)의 화면 또는 표면이 되며, 사용자 눈(400)의 시선(440)과 상면(510)이 교차하는 영역이 주목 영역(520)이 된다. 제1 제어부(110)는 주목 영역(520) 내 객체(530)를 확인한다.The

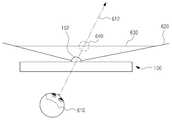

도 11은 본 발명의 제2 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면이다. 본 예는 터치 스크린(190)이 불투명 터치 스크린인 경우를 예시한다.11 is a diagram for describing a method of detecting a target of interest according to a second example of the present invention. This example illustrates a case where the

제2 카메라(152)의 화각(620)에 의해 제한된 주변 풍경, 즉 제2 카메라(152)에 의해 촬영된 주변 풍경 영역의 이미지가 상면(630)이 되며, 사용자(610) 눈의 시선(612)과 상면(630)이 교차하는 영역이 주목 영역(640)이 된다.The surrounding landscape limited by the angle of

도 12는 본 발명의 제3 예에 따른 주목 대상 검출 방법을 설명하기 위한 도면이다. 본 예는 제2 전자 장치(200)에서 주목 대상을 검출하는 경우를 예시한다. 주목 대상은 사람, 동물, 식물, 사물, 건물, 산 등 주변 풍경 내 임의의 객체를 포함한다.12 is a diagram for describing a method of detecting a target of interest according to a third example of the present invention. This example illustrates a case in which the second

제4 카메라(265)의 화각에 의해 제한된 주변 풍경(720), 즉 제4 카메라(265)에 의해 촬영된 주변 풍경 영역(720)의 이미지가 상면(730)이 되며, 사용자 눈(400)의 시선(440)과 상면(730)이 교차하는 영역이 주목 영역(732)이 된다. 제2 제어부(290)는 주변 풍경(720) 내 나무(722)에 대응되는 주목 영역(732) 내 나무 이미지(734)를 주목 대상으로 확인한다. 즉, 투명 윈도우(280, 285)에 사용자의 시선의 연장선상에 있는 영역 또는 객체가 주목 영역 또는 주목 대상이 된다. 다시 말해서, 투명 터치 스크린(190), 투명 윈도우(280, 285) 등과 같은 투명한 디스플레이에 사용자의 시선의 연장선상에 있는 영역 또는 객체가 주목 영역 또는 주목 대상이 된다.The surrounding

S150 단계는 이미지 검색 및 표시 단계로서, 제1 제어부(110)는 주목 대상에 대응하는 시인성 높은 이미지를 검색하고, 검색된 이미지를 표시한다.Step S150 is an image search and display step, in which the

시인성이 높은 이미지는 고해상도(또는 고화질)의 이미지, 선명도를 높인 이미지, 벡터 그래픽스 이미지, 근거리에서의 이미지, 시간적으로 광량이 풍부할 경우에 촬영한 이미지(즉, 주변 조도가 높은 상태에서 촬영한 이미지) 등이 있다. 시인성 높은 이미지는 동일한 크기를 기준으로 상기 주목 대상보다 해상도, 선명도 또는 밝기가 높다.High-visibility images are high-resolution (or high-definition) images, images with increased clarity, vector graphics images, images at close range, images taken when the amount of light is abundant in time (i.e., images taken with high ambient light) ), etc. An image with high visibility has a higher resolution, sharpness, or brightness than the object of interest based on the same size.

제1 제어부(110)는 제1 저장부(175)에서 시인성 낮은 주목 대상에 대응하는 시인성 높은 이미지를 검색할 수 있으며, 예를 들어, 제1 제어부(110)는 이미지 매칭 과정을 통해 제1 저장부(175)에 저장된 시인성 높은 이미지를 확인할 수 있다.The

또는, 제1 제어부(110)는 시인성 높은 이미지를 외부의 서버로부터 검색할 수 있다. 예를 들어, 제1 제어부(110)는 시인성 낮은 주목 대상을 포함하는 이미지(또는 이미지와 주목 대상의 위치 정보) 및/또는 주목 대상 관련 정보를 서버로 전송하고, 서버로부터 검색된 시인성 높은 이미지를 수신할 수도 있다. 이러한 주목 대상 관련 정보는 주목 대상을 촬영한 시점의 제1 전자 장치(100)의 위치 정보, 자세(또는, 방위 내지는 방향) 정보, 이미지 출처 정보(이미지 관련 프로그램, 이미지를 다운로드한 웹 주소 등) 등을 포함할 수 있다.Alternatively, the

도 13은 본 발명의 제1 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면이다.13 is a diagram illustrating a method of displaying an image with high visibility according to a first example of the present invention.

도 13의 (a)을 참조하면, 사용자의 눈(400)은 터치 스크린(190)에 표시된 썸네일 이미지(810)에 주목하고 있다.Referring to FIG. 13A, the user's

도 13의 (b)는 본 발명의 비교예로서, 해상도가 낮은 썸네일 이미지를 확대한 이미지(812)를 나타낸다.13B shows an

도 13의 (c)를 참고하면, 제1 제어부(110)는 썸네일 이미지(810)의 관련 정보(즉, 원본 이미지의 위치 정보)를 확인하고, 터치 스크린(190)에 확대된 원본 이미지(814)를 표시한다.Referring to FIG. 13C, the

도 13의 (b)와 같이, 해상도가 낮은 썸네일 이미지를 확대하면, 선명하지 않은 저화질의 이미지(812)가 표시되는 반면에, 도 13의 (c)와 같이, 썸네일 이미지과 연관된 원본 이미지를 사용함으로써 선명한 고화질의 이미지(814)를 표시할 수 있다.As shown in (b) of FIG. 13, when a thumbnail image having a low resolution is enlarged, an

도 14는 본 발명의 제2 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면이다.14 is a diagram for describing a method of displaying an image with high visibility according to a second example of the present invention.

도 14의 (a)를 참고하면, 제1 전자 장치(100)의 터치 스크린(190)에는 탁자 위에 놓인 제1 내지 제3 박스(830, 832, 834)를 촬영한 이미지(820)가 도시되어 있다. 제1 제어부(110)는 사용자의 시선에 근거하여 제1 박스(830)를 포함하는 주목 영역(840)을 확인한다.Referring to FIG. 14A, on the

도 14의 (b)를 참고하면, 제1 제어부(110)는 주목 영역 이미지(840)를 서버로 전송한다.Referring to FIG. 14B, the

도 14의 (c)를 참고하면, 제1 제어부(110)는 서버로부터 주목 영역 내 제1 박스에 대한 시인성 높은 이미지(832)를 수신하고, 터치 스크린(190)에는 시인성 높은 이미지(832)가 표시된다.Referring to FIG. 14C, the

도 15는 본 발명의 제3 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면이다.15 is a diagram for describing a method of displaying an image with high visibility according to a third example of the present invention.

도 15의 (a)를 참고하면, 제1 전자 장치(100)의 터치 스크린(190)에는 새를 촬영한 선명도가 낮은 이미지(850)가 도시되어 있다. 제1 제어부(110)는 사용자의 시선에 근거하여 시인성 낮은 이미지(850)를 주목 대상으로서 확인한다.Referring to FIG. 15A, on the

도 15의 (b)를 참고하면, 제1 제어부(110)는 주목 대상에 대응하는 시인성 높은 이미지를 검색할 수 없는 경우에, 이미지 필터링 또는 시각 효과 적용을 통해 선명도 높은 이미지를 생성하고, 생성된 선명도 높은 이미지(852)를 터치 스크린(190)에 표시한다.Referring to FIG. 15B, when it is not possible to search for an image with high visibility corresponding to the object of interest, the

또한 촬영시 사용한 카메라의 파라메터를 조정하는 것이 가능하다. 예를 들어 새 주변의 광량이 많거나 어두운 경우 카메라 조리개나 화이트 밸런스 수치에 의해 주목하는 대상이 제대로 찍히지 않는 경우 주목하는 대상을 확인 후 주목하는 대상을 중심으로 카메라의 파라메터를 조정하여 시인성이 높은 이미지를 표시한다.It is also possible to adjust the parameters of the camera used when shooting. For example, if the amount of light around the bird is high or dark, the object of interest is not properly captured by the camera aperture or white balance value.After confirming the object of interest, adjust the parameters of the camera centering on the object of interest, and an image with high visibility Is displayed.

도 16은 본 발명의 제4 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면이다.16 is a diagram for describing a method of displaying an image with high visibility according to a fourth example of the present invention.

도 16의 (a)을 참조하면, 사용자는 터치 스크린(190)에 표시된 글자(870)에 주목하고 있고, 제1 제어부(110)는 사용자의 시선에 근거하여 주목 영역(860)을 확인하고, 크기가 작아서 시인성이 낮은 글자(870)를 주목 대상으로서 확인한다.Referring to FIG. 16A, the user is paying attention to the

도 16의 (b)는 본 발명의 비교 예로서, 크기가 작은 글자를 나타내는 래스터 그래픽스 이미지 또는 비트맵 이미지를 확대한 경우에, 확인하기 어려운 이미지(872)가 생성됨을 나타낸다.FIG. 16B is a comparative example of the present invention, and shows that an

도 16의 (c)을 참조하면, 제1 제어부(110)는 비트맵 이미지 내 주목 대상인 글자를 통상의 문자 인식 방법을 이용하여 인식하고, 주목 대상에 대응하는 벡터 이미지를 제1 저장부(175)에서 검색하며, 검색된 벡터 이미지(874)를 확대하여 표시한다. 또한, 주목 대상인 글자가 벡터 이미지인 경우에 글자 크기를 증가시켜서 표시할 수 있다.Referring to FIG. 16C, the

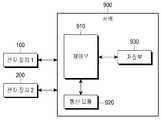

도 17은 서버의 구성을 나타내는 도면이다.17 is a diagram showing the configuration of a server.

서버(900)는 제3 통신 모듈(920), 제3 저장부(930) 및 제3 제어부(910)를 포함한다.The

제3 통신 모듈(920)은 제1 전자 장치(100) 또는 제2 전자 장치(200)와의 유선 또는 무선 통신을 수행한다.The

제3 저장부(930)는 제1 또는 제2 전자 장치(100, 200)가 시인성 높은 이미지를 표시하는 방법을 수행하도록 하는 지시들을 포함하는 프로그램, 상기 프로그램의 업데이트 정보, 이미지 데이터베이스, 스트리트 파노라마 데이터베이스, 2차원 맵 등을 포함한다.The

스트리트 파노라마 데이터베이스는 서로 다른 다수의 위치들과 맵핑된 스트리트 뷰 이미지들을 포함한다. 스트리트 파노라마 데이터베이스는 맵 데이터베이스로서 도시 또는 거리를 카메라로 촬영한 실사 이미지로 이루어진 실사 3차원 맵을 저장한다. 여기서 실사 3D 맵이란 차량 또는 항공기 등을 이용하여 실제 거리를 촬영하고, 상기 촬영된 실사를 이용하여 구현된 3D 맵을 의미한다. 이러한 실사 3D 맵은 차량에 장착된 스트레오 카메라를 이용하여 도시 또는 거리를 촬영함으로써 촬영된 영상 내에 포함된 객체들의 3차원 좌표(x축, y축, z축 좌표들)뿐만 아니라 상기 촬영에 사용된 카메라와 상기 객체들간의 거리에 대응하는 뎁스(depth) 정보를 얻을 수 있다. 또한, 이러한 실사 3D 맵은 항공기를 이용하여 넓은 지역에 대한 다수의 2차원 영상들을 촬영하고, 촬영된 영상들 중 인접한 2개의 2D 영상간의 겹치는 영역에서 뎁스(depth) 정보를 추출하고 3차원 매핑(mapping)을 통한 3차원 모델링에 의하여 구현될 수도 있다. 또한 상기 실사 3D 맵에 포함된 각 오브젝트들을 다수의 3차원 정보 및 뎁스 정보를 갖게 된다. 예를 들어 상기 각 오브젝트를 표시하는 다수의 픽셀(pixel)들 각각이 3차원 정보 및 뎁스 정보를 가질 수 있다. 이에 따라 상기 실사 3D 맵은 특정 빌딩의 위치뿐만 아니라 상기 특정 빌딩의 전면, 후면, 측면들과 같은 빌딩의 윤곽을 구분할 수 있고, 또한 상기 빌딩의 각 층을 구분할 수 있다. 이와 대조적으로, 기존 2D 맵에서는 단순히 GPS 정보만을 이용하였기 때문에 특정 건물에 대해서는 하나의 위치 정보만을 제공하였을 뿐, 특정 건물의 전면, 후면 또는 각 층을 세부적으로 구분하지 못하였다는 점에 실사 3D 맵과 차이가 있다.The street panorama database includes street view images mapped to a number of different locations. The street panorama database is a map database and stores a real three-dimensional map made up of real images of a city or street taken with a camera. Here, the real 3D map refers to a 3D map implemented by photographing an actual distance using a vehicle or an aircraft, and using the photographed real image. This real-life 3D map is used in the photographing as well as the three-dimensional coordinates (x-axis, y-axis, z-axis coordinates) of objects included in the captured image by photographing a city or a street using a stereo camera mounted on a vehicle. Depth information corresponding to the distance between the camera and the objects may be obtained. In addition, this realistic 3D map captures a number of 2D images for a wide area using an aircraft, extracts depth information from the overlapping area between two adjacent 2D images among the captured images, and performs 3D mapping ( Mapping) can also be implemented by 3D modeling. In addition, each object included in the realistic 3D map has a plurality of 3D information and depth information. For example, each of a plurality of pixels displaying each object may have 3D information and depth information. Accordingly, the photorealistic 3D map can distinguish not only the location of the specific building, but also the outline of the building such as the front, rear, and side surfaces of the specific building, and can also distinguish each floor of the building. In contrast, since the existing 2D map simply used GPS information, only one location information was provided for a specific building, but the real 3D map was not able to distinguish in detail the front, rear or each floor of a specific building. And there is a difference.

제3 제어부(910)는 제1 또는 제2 전자 장치(100, 200)의 요청 또는 자동으로 프로그램 또는 업데이트 정보를 상기 제1 또는 제2 전자 장치(100, 200)로 전송한다.The

또한, 제3 제어부(910)는 제1 또는 제2 전자 장치(100, 200)로부터 수신한 주목 대상 이미지(및/또는 관련 정보)와 이미지 데이터베이스 또는 스트리트 파노라마 데이터베이스에 저장된 이미지를 매칭하고, 매칭된 시인성 높은 이미지를 제1 또는 제2 전자 장치(100, 200)로 전송한다. 제3 제어부(910)는 제1 또는 제2 전자 장치(100, 200)로부터 수신한 주목 대상 관련 정보를 이용하여 매칭 속도 및 정확도를 향상시킬 수 있다. 각 데이터베이스는 이미지 외에 이와 대응되는 위치, 자세(방위) 등을 포함하는 위치 정보, 이미지 출처 정보(이미지 관련 프로그램, 이미지를 다운로드한 웹 주소 등) 등을 저장할 수 있다.In addition, the

전술한 예들에서 제1 전자 장치(100)를 위주로 설명하였으나, 본 발명의 예들은 제1 또는 제2 전자 장치(100, 200)에 동일 또는 유사하게 적용될 수 있다. 이하, 제2 전자 장치(200)를 이용한 시인성 높은 이미지를 표시하는 방법의 다른 예들을 예시하자면 아래와 같다.In the above-described examples, the first

도 18 및 도 19는 본 발명의 제5 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면들이다.18 and 19 are diagrams for explaining a method of displaying an image with high visibility according to a fifth example of the present invention.

사용자의 시선 방향에 복수의 주목 대상들이 존재하는 경우, 또는 하나의 주목 대상이 존재하는 경우에, 제2 제어부(290)는 사용자의 명령에 따라 사용자의 시점을 가상으로 이동할 수 있다. 이러한 시점 이동은 전술한 예들에서 주목 대상의 확대 표시에 대응되나, 또한 주목 대상의 축소에 대응될 수도 있다.When a plurality of objects of interest exist in the direction of the user's gaze, or when there is one object of interest, the

도 18의 (a)를 참조하면, 사용자 눈(1010)의 시선 방향(1020)에 제1 및 제2 주목 대상(1030, 1040)이 존재하는 경우에, 제2 제어부(290)는 사용자와 가까운 제1 주목 대상(1030)에 대한 시인성 높은 이미지를 표시하나, 사용자의 명령에 따라 가상 시점을 시선 방향을 따라 전후로 이동시킬 수 있다.Referring to FIG. 18A, when the first and second objects of

도 18의 (b)는 사용자가 제2 전자 장치(200)의 제2 윈도우(285)를 통해 제1 및 제2 주목 대상(1030, 1040)을 보는 것을 나타낸다.FIG. 18B shows that the user views the first and second objects of

도 19의 (a)는 사용자와 제1 주목 대상(1030) 사이의 제1 가상 시점(1012)에서의 확대된 제1 주목 대상(1032)(즉, 시인성 높은 이미지)이 제2 윈도우(285)를 통해 표시된다. 이와 마찬가지로, 제1 윈도우(280)를 통해서도 확대된 제1 주목 대상이 표시된다.19A shows the enlarged first object of interest 1032 (ie, an image with high visibility) at the first

도 19의 (b)는 제1 주목 대상(1030) 및 제2 주목 대상(1040) 사이의 제2 가상 시점(1014)에서의 확대된 제2 주목 대상(1042)(즉, 시인성 높은 이미지)이 제2 윈도우(285)에 표시된다.19B shows an enlarged second object of interest 1042 (that is, an image with high visibility) at a second

제2 제어부(290)는 주목 대상의 이미지 및 관련 정보(제2 전자 장치(200)의 위치 정보, 자세(또는, 방위 내지는 방향) 정보)를 서버(900)로 전송하고, 서버(900)로부터 수신한 시인성 높은 주목 대상의 이미지를 수신하여 사용자에게 표시할 수 있다. 이러한 가상 시점의 전환은 사용자의 명령(음성, 손짓, 터치)에 따라 수행될 수 있다. 또한 사용자의 표정 변화 (주목을 유지하는 경우 먼 곳의 물체 이미지 제공 등)에 의해 제공하는 이미지를 전환하는 것이 가능하다.The

도 24는 주목 대상의 변경을 설명하기 위한 도면이다.24 is a diagram for explaining a change of an object of interest.

제 2 윈도우(285)에 시인성 높은 이미지를 표시할 때 검출된 시선의 각도 오차에 의해 사용자의 의도와는 다른 위치에 있는 이미지를 표시하는 경우가 생길 수 있다. 시인성 높은 이미지를 표시할 때 사용자의 시선 이동을 검출하여 주목 대상을 변경함으로써 사용자의 의도에 맞는 이미지를 표시할 수 있도록 할 수 있다.When displaying an image with high visibility on the

도 24의 (a)를 참조하면, 사용자의 시선(1072)이 실제로는 제2 물체(1060)를 향하고 있는데, 주목 대상 판별시 오차에 의해 사용자의 시선(1071)이 제1 물체(1050)를 향하고 있는 것으로 잘못 판단될 수 있다.Referring to (a) of FIG. 24, the user's

도 24의 (b)를 참조하면, 제2 제어부(290)는 사용자가 제1 물체(1050)를 주목하고 있는 것으로 잘못 측정함으로써, 제1 물체(1050)의 시인성 높은 이미지(1052)를 제 2 윈도우(285)의 중앙에 표시한다.Referring to FIG. 24B, the

이후, 제2 제어부(290)는 사용자의 시선을 추적하여 사용자의 시선(1073)이 제2 물체(1060)의 시인성 높은 이미지(1062)를 향하고 있음을 확인하고, 주목 대상을 변경한다.Thereafter, the

도 24의 (c)를 참조하면, 제2 제어부(290)는 주목 대상을 변경하고, 제2 물체(1060)의 시인성 높은 이미지(1062)를 제 2 윈도우(285)의 중앙에 표시한다.Referring to FIG. 24C, the

본 예에서는, 사용자의 시선을 추적하여 제공한 이미지에서 사용자가 재차 주목하고 있는 대상을 중심으로 제공 대상 이미지를 보정하고 있으나, 이러한 시선 감지 외에도 사용자의 명령(손짓, 음성, 터치 등)에 따라 제공한 이미지의 세부 조정이 가능하다.In this example, in the image provided by tracking the user's gaze, the image to be provided is corrected centering on the object that the user is paying attention to again. Fine adjustment of one image is possible.

도 20은 본 발명의 제6 예에 따른 시인성 높은 이미지를 표시하는 방법을 설명하기 위한 도면이다.20 is a diagram illustrating a method of displaying an image with high visibility according to a sixth example of the present invention.

도 20의 (a)는 사용자(1010)가 주변이 어두운 밤에 제2 전자 장치(200)의 제2 윈도우(285)를 통해 어두운 주목 대상(1040)을 보는 것을 나타낸다.FIG. 20A illustrates that the

도 20의 (b)를 참고하면, 주목 대상(1040)의 확대된 밝은 이미지(1044)(즉, 시인성 높은 이미지)가 제2 윈도우(285)에 표시된다.Referring to FIG. 20B, an enlarged bright image 1044 (ie, an image with high visibility) of the object of

제2 제어부(290)는 주목 대상(1040)의 이미지 및 관련 정보(제2 전자 장치(200)의 위치 정보, 자세(또는, 방위 내지는 방향) 정보)를 서버(900)로 전송하고, 서버(900)로부터 수신한 시인성 높은 주목 대상의 이미지(1044)를 수신하여 사용자에게 표시할 수 있다.The

전술한 예들에서, 시인성 높은 이미지를 사용자에게 표시한 이후, 이전 화면으로의 복귀는 주목 상태의 해제에 의해 수행될 수 있다. 예를 들어, 제어부(110, 290)는 사용자의 시선이 변경된 경우, 찌푸린 표정이 풀린 경우 등과 같이 사용자가 해당 객체를 더 이상 주목하지 않을 때 시인성 높은 이미지를 표시하기 직전의 화면을 표시할 수 있다. 투명 터치 스크린이나 제2 전자 장치(200)의 경우에, 제어부(110, 290)는 시인성 높은 이미지의 표시를 중단할 수 있다.In the above-described examples, after displaying an image with high visibility to the user, return to the previous screen may be performed by releasing the attention state. For example, the

도 21은 본 발명의 일 예에 따른 시인성 높은 이미지의 표시를 중단하는 방법을 설명하기 위한 도면이다.21 is a diagram for describing a method of stopping display of an image with high visibility according to an example of the present invention.

도 21의 (a)는 터치 스크린(190)에 시인성 높은 이미지인 확대된 웹페이지(1110)가 표시된 것을 나타낸다.FIG. 21A shows that an

도 21의 (b)를 참고하면, 사용자(1120)가 '후'라는 입김(1122)을 불면, 제1 제어부(110)는 시인성 높은 이미지를 표시하기 직전의 화면, 즉 확대되기 이전의 웹페이지(1112)를 표시한다. 제1 제어부(110)는 입김이 마이크(162)를 지날 때의 마찰음을 이용하여 주목 상태의 해제 여부를 판단할 수 있다.Referring to (b) of FIG. 21, when the

전술한 예에서는, 제어부(110, 290)는 사용자가 임의의 객체를 주목(또는 주시)하고 있는지의 여부를 판단하였으나, 이러한 주목 여부는 얼굴 표정, 시선 고정 시간뿐만 아니라, 사용자의 직접적인 명령에 의해 판단될 수도 있다. 이는 주목 여부의 판단 대신에 사용자 명령이 수신되는지의 여부를 판단하는 것으로도 볼 수 있다.In the above-described example, the

도 22는 본 발명의 제2 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도이다.22 is a flowchart illustrating a method for improving visibility using eye tracking according to a second example of the present invention.

S210 단계는 사용자 검출 단계로서, 제1 제어부(110)는 제1 카메라(151) 또는 제1 생체 센서(171)를 통해 사용자를 검출한다. 제1 제어부(110)는 제1 카메라(151) 또는 제1 생체 센서(171)에 의해 촬영된 이미지 내에 포함된 피사체가 얼굴 또는 생체를 포함하는지의 여부를 판단할 수 있다.Step S210 is a user detection step, and the

S220 단계는 시선 검출 단계로서, 제1 제어부(110)는 입력 이미지에서 사용자의 시선을 검출한다.Step S220 is a gaze detection step, and the

S230 단계는 사용자 명령 확인 단계로서, 제1 제어부(110)는 사용자 명령이 수신되는지의 여부를 판단한다.Step S230 is a user command confirmation step, and the

이러한 명령은 음성, 터치 또는 물리적인 키/버튼 입력, 사용자 제스쳐, 제1 전자 장치(100)의 모션, 사용자의 표정, 사용자의 입김, 뇌파 등 사용자의 의도를 전달하는 모든 수단을 통해 이루어질 수 있다.These commands may be made through any means of conveying the user's intention, such as voice, touch, or physical key/button input, user gesture, motion of the first

예를 들어, 사용자는 "확대", "축소", "밝게" 등의 음성 명령을 입력할 수 있으며, 제1 제어부(110)는 마이크(162)를 통해 음성 명령을 수신할 수 있고, 시인성 높은 이미지를 확대, 축소 또는 밝게 하여 표시할 수 있다. 축소의 경우에, 제1 제어부(110)는 시인성 높은 이미지를 해당 객체보다 작게 표시하거나, 이미 표시되어 있는 시인성 높은 이미지를 축소하여 표시할 수 있다. 확대의 경우에도, 제1 제어부(110)는 이미 표시되어 있는 시인성 높은 이미지를 추가 확대하여 표시할 수 있다.For example, the user may input voice commands such as "enlarge", "reduce", and "bright", and the

예를 들어, 제1 제어부(110)는 터치 스크린(190)에 시인성 높은 이미지의 표시를 나타내는 버튼을 표시하거나, 물리적인 키들인 볼륨 증가 버튼(161f) 및 볼륨 감소 버튼(161g)에 "확대" 및 "축소" 기능을 맵핑할 수 있다.For example, the

예를 들어, 제2 제어부(200)는 제4 카메라(265)를 통해 미리 설정된 제스쳐가 검출되는지의 모니터링할 수 있다. 이러한 제스쳐의 예들은, 윈도우(280, 285)를 투과하여 보이는 객체를 손가락으로 가리키는 동작에 의한 주목 대상의 지정, 손가락의 핀치 동작(오므리거나 펴는 동작)을 통한 주목 대상의 확대 및 축소, 손가락을 전후로 움직이는 동작(손가락이 제2 전자 장치(200)에 가까워지거나 멀어지는 동작)에 의한 가상 시점의 이동을 포함한다.For example, the

예를 들어, 사용자는 제1 전자 장치(100)를 전후로 움직이거나, 기울이는 동작을 취할 수 있으며, 제1 제어부(110)는 제1 센서 모듈(170)을 통해 제1 전자 장치(100)의 움직임을 감지할 수 있다. 제1 제어부(110)는 제1 전자 장치(100)가 전방으로(즉, 사용자와 대면하는 방향) 이동하거나 기울어지는 경우에 시인성 높은 이미지를 확대하여 표시하고, 제1 전자 장치(100)가 후방으로(즉, 사용자와 멀어지는 방향) 이동하거나 기울어지는 경우에 시인성 높은 이미지를 축소하여 표시할 수 있다.For example, the user may move or tilt the first

예를 들어, 제1 제어부(110)는 사용자가 얼굴을 찌푸리는 정도에 따라 시인성이 높은 이미지의 확대 정도를 결정할 수 있다. 또는, 이미 시인성이 높은 이미지가 표시되어 있는 경우에, 제1 제어부(110)는 사용자가 얼굴을 더 찌푸리면 시인성이 높은 이미지를 추가 확대하고, 찌푸린 얼굴을 풀면 시인성이 높은 이미지를 축소할 수 있다.For example, the

제2 제어부(290)는 얼굴을 찌푸리는 정도에 따라 가상 시점의 위치를 결정하거나, 이미 시인성이 높은 이미지가 표시되어 있는 경우에, 제2 제어부(290)는 사용자가 얼굴을 더 찌푸리면 가상 시점을 보다 가깝게 또는 보다 멀리 이동시킬 수 있다.The

제1 제어부(110)는 사용자 명령을 수신한 경우에 S240 단계를 수행하고, 사용자 명령을 수신하지 못한 경우에 사용자 명령의 수신 여부를 주기적 또는 연속적으로 모니터링한다.The

S240 단계는 주목 대상/영역 검출 단계로서, 제1 제어부(110)는 사용자의 시선과 상면이 교차하는 영역(즉, 주목 영역)을 확인하고, 주목 영역에 위치하는 객체를 검출한다.In step S240, a target/area detection step is performed. The

S250 단계는 이미지 검색 및 표시 단계로서, 제1 제어부(110)는 주목 대상에 대응하는 시인성 높은 이미지를 검색하고, 검색된 이미지를 표시한다. 이때, 제1 제어부(110)는 S230 단계의 사용자 명령에 따라 검색된 이미지를 표시할 수 있다.Step S250 is an image search and display step, in which the

도 23은 본 발명의 제3 예에 따른 시선 추적을 이용한 시인성 개선 방법을 나타내는 흐름도이다.23 is a flowchart illustrating a method for improving visibility using eye tracking according to a third example of the present invention.

S310 단계는 사용자 명령 수신 단계로서, 제어부(110)는 음성, 터치 또는 물리적인 키/버튼 입력, 사용자 제스쳐, 제1 전자 장치(100)의 모션, 사용자의 표정, 사용자의 입김, 뇌파 등 사용자의 의도를 전달하는 임의의 수단을 통해 사용자 명령을 수신한다.Step S310 is a user command receiving step. The

S320 단계는 사용자 검출 단계로서, 제1 제어부(110)는 제1 카메라(151) 또는 제1 생체 센서(171)를 통해 사용자를 검출한다.Step S320 is a user detection step, and the

S330 단계는 시선 검출 단계로서, 제1 제어부(110)는 입력 이미지에서 사용자의 시선을 검출한다.In step S330, as a gaze detection step, the

S340 단계는 주목 대상/영역 검출 단계로서, 제1 제어부(110)는 사용자의 시선과 상면이 교차하는 영역(즉, 주목 영역)을 확인하고, 주목 영역에 위치하는 객체를 검출한다.In step S340, a target/area detection step is performed. The

S350 단계는 이미지 검색 및 표시 단계로서, 제1 제어부(110)는 주목 대상에 대응하는 시인성 높은 이미지를 검색하고, 검색된 이미지를 표시한다. 이때, 제1 제어부(110)는 S310 단계의 사용자 명령에 따라 검색된 이미지를 표시할 수 있다.Step S350 is an image search and display step. The

전술한 예들에서, 화면을 표시하는 디스플레이 유닛의 대표적인 예로 터치 스크린을 예시하고 있으나, 터치 스크린 대신에 터치 감지 기능이 없는 액정표시장치(Liquid Crystal Display: LCD), 유기발광다이오드(Organic Light Emitting Diodes: OLED), LED 등과 같은 통상의 디스플레이 유닛 또는 투명 디스플레이를 사용할 수도 있다.In the above-described examples, a touch screen is exemplified as a representative example of a display unit displaying a screen, but instead of a touch screen, a liquid crystal display (LCD) and organic light emitting diodes without a touch sensing function are illustrated. OLED), an ordinary display unit such as LED, or a transparent display may also be used.

또한, 제2 전자 장치(200)에 있어서, 제1 및 제2 윈도우(280, 285)는 디스플레이 유닛(들) 또는 투명 디스플레이로 볼 수 있다.In addition, in the second

본 발명의 실시 예들은 하드웨어, 소프트웨어 또는 하드웨어 및 소프트웨어의 조합의 형태로 실현 가능하다는 것을 알 수 있을 것이다. 이러한 임의의 소프트웨어는 예를 들어, 삭제 가능 또는 재기록 가능 여부와 상관없이, ROM 등의 저장 장치와 같은 휘발성 또는 비휘발성 저장 장치, 또는 예를 들어, RAM, 메모리 칩, 장치 또는 집적 회로와 같은 메모리, 또는 예를 들어 CD, DVD, 자기 디스크 또는 자기 테이프 등과 같은 광학 또는 자기적으로 기록 가능함과 동시에 기계(예를 들어, 컴퓨터)로 읽을 수 있는 저장 매체에 저장될 수 있다. 전자 장치 내에 포함될 수 있는 저장부는 본 발명의 실시 예들을 구현하는 지시들을 포함하는 프로그램 또는 프로그램들을 저장하기에 적합한 기계로 읽을 수 있는 저장 매체의 한 예임을 알 수 있을 것이다. 따라서, 본 발명은 본 명세서의 임의의 청구항에 기재된 장치 또는 방법을 구현하기 위한 코드를 포함하는 프로그램 및 이러한 프로그램을 저장하는 기계로 읽을 수 있는 저장 매체를 포함한다. 또한, 이러한 프로그램은 유선 또는 무선 연결을 통해 전달되는 통신 신호와 같은 임의의 매체를 통해 전자적으로 이송될 수 있고, 본 발명은 이와 균등한 것을 적절하게 포함한다.It will be appreciated that the embodiments of the present invention can be realized in the form of hardware, software, or a combination of hardware and software. Any such software, for example, whether erasable or rewritable, may be a volatile or nonvolatile storage device such as a storage device such as a ROM, or a memory device such as a RAM, memory chip, device or integrated circuit, for example. Or, for example, it may be optically or magnetically recordable, such as a CD, DVD, magnetic disk or magnetic tape, and stored in a storage medium readable by a machine (eg, a computer). It will be appreciated that the storage unit that may be included in the electronic device is an example of a program including instructions for implementing embodiments of the present invention or a machine-readable storage medium suitable for storing programs. Accordingly, the present invention includes a program including code for implementing the apparatus or method described in any claim of the present specification, and a machine-readable storage medium storing such a program. Further, such a program may be transferred electronically through any medium, such as a communication signal transmitted through a wired or wireless connection, and the present invention suitably includes equivalents thereto.

상술한 본 발명의 설명에서는 구체적인 실시 예에 관해 설명하였으나, 여러 가지 변형이 본 발명의 범위에서 벗어나지 않고 실시할 수 있다. 따라서 본 발명의 범위는 설명된 실시 예에 의하여 정할 것이 아니고 특허청구범위와 특허청구범위의 균등한 것에 의해 정해져야 한다.In the above description of the present invention, specific embodiments have been described, but various modifications may be made without departing from the scope of the present invention. Therefore, the scope of the present invention should not be determined by the described embodiments, but should be determined by the equivalent of the claims and the claims.

100: 전자 장치, 110: 제어부, 120: 통신 모듈, 130: 서브 통신 모듈, 140: 멀티미디어 모듈, 150: 카메라 모듈, 157: GPS 모듈, 160: 입/출력 모듈, 168: 입력 유닛, 170; 센서 모듈, 175: 저장부, 180: 전원 공급부, 190: 터치스크린, 195: 터치스크린 컨트롤러100: electronic device, 110: control unit, 120: communication module, 130: sub communication module, 140: multimedia module, 150: camera module, 157: GPS module, 160: input/output module, 168: input unit, 170; Sensor module, 175: storage, 180: power supply, 190: touch screen, 195: touch screen controller

Claims (19)

Translated fromKorean상기 전자 장치의 디스플레이 상에 제 1 이미지를 표시하는 단계;를 포함하고, 상기 제 1 이미지는 건물의 전면, 상기 건물의 후면, 또는 상기 건물의 측면 중 적어도 하나를 포함하는 3차원(3D) 지도의 제 1 뷰(view)를 포함하고,

상기 디스플레이 상에 상기 제 1 이미지가 표시되는 동안, 상기 전자 장치의 카메라 회로를 이용하여 사용자의 시선을 획득하는 단계;

상기 사용자의 시선의 유지 시간에 기초하여, 상기 제 1 이미지의 제 1 부분을 판단하는 단계;

서버로부터 제 2 이미지를 수신하는 단계;를 포함하고, 상기 제 2 이미지는 상기 3차원 지도의 제 2 뷰(view)를 포함하고, 상기 제 1 이미지의 상기 제 1 부분에 기반하여 상기 제 2 이미지의 제 2 부분은 상기 제 1 이미지의 상기 제 1 부분 보다 더 높은 시인성을 가지고,

상기 디스플레이 상에 상기 서버로부터 수신된 상기 제 2 이미지를 표시하는 단계;를 포함하고, 상기 제 2 이미지의 상기 제 2 부분의 더 높은 시인성은 상기 제 1 이미지의 상기 제 1 부분의 해상도 보다 더 높은 해상도, 상기 제 1 부분의 선명도 보다 더 높은 선명도, 또는 상기 제 1 부분의 밝기 보다 더 높은 밝기 중 적어도 하나를 포함하고,

상기 디스플레이 상에 상기 제 2 이미지가 표시되는 동안, 상기 사용자의 시선에 기반하여 상기 사용자의 시점의 이동을 판단하는 단계;를 포함하는, 제어 방법.

In the control method of an electronic device,

Displaying a first image on a display of the electronic device; wherein the first image includes at least one of a front surface of a building, a rear surface of the building, or a side surface of the building. Contains a first view of,

Obtaining a user's gaze using a camera circuit of the electronic device while the first image is displayed on the display;

Determining a first portion of the first image based on a retention time of the user's gaze;

Receiving a second image from a server; wherein the second image includes a second view of the three-dimensional map, and the second image based on the first portion of the first image The second part of the has a higher visibility than the first part of the first image,

Displaying the second image received from the server on the display, wherein a higher visibility of the second portion of the second image is higher than the resolution of the first portion of the first image At least one of resolution, sharpness higher than that of the first portion, or brightness higher than that of the first portion,

Determining a movement of the user's viewpoint based on the user's gaze while the second image is displayed on the display.

상기 카메라 회로를 이용하여 상기 사용자의 눈을 검출하는 단계;를 포함하고,

상기 사용자의 눈의 동공의 위치에 기반하여 상기 시선이 검출되는, 제어 방법.

The method of claim 1,

Including; detecting the eyes of the user using the camera circuit,

The control method, wherein the line of sight is detected based on the position of the pupil of the user's eye.

상기 디스플레이에 표시된 상기 제 1 이미지의 상기 제 1 부분을 상기 사용자가 주목하고 있는지 여부를 판단하는 단계;를 더 포함하는, 제어 방법.

The method of claim 1,

Determining whether the user is paying attention to the first portion of the first image displayed on the display; and further comprising.

상기 제 1 이미지의 상기 제 1 부분을 상기 사용자가 주목하고 있는지 여부를 판단하는 단계는, 상기 사용자의 눈의 동공의 변화 또는 상기 사용자의 표정 변화에 기반해서 상기 제 1 이미지의 상기 제 1 부분을 상기 사용자가 주목하고 있는지 여부를 판단하는 단계;를 포함하는, 제어 방법.

The method of claim 3,

The step of determining whether the user is paying attention to the first part of the first image may include selecting the first part of the first image based on a change in a pupil of the user's eye or a change in an expression of the user. Including; determining whether the user is paying attention.

The method of claim 1, wherein the second part of the second image is enlarged, the degree of enlargement of the second part of the second image is based on a frown degree of the user's face, and the viewpoint is the user's The control method is determined based on the degree of frowning of the face.

상기 사용자의 명령을 수신하는 단계;를 더 포함하고,

상기 사용자의 시선을 획득하는 단계는 상기 사용자의 상기 명령에 기반하여 상기 시선을 획득하는 단계;를 포함하는, 제어 방법.

The method of claim 1,

Receiving the user's command; further comprising,

The step of obtaining the gaze of the user includes acquiring the gaze based on the command of the user.

상기 사용자의 명령을 수신하는 단계;를 더 포함하고,

상기 제 1 이미지의 제 1 부분을 판단하는 단계는 상기 사용자의 상기 명령에 기반하여 상기 제 1 이미지의 상기 제 1 부분을 판단하는 단계;를 포함하는, 제어 방법.

The method of claim 1,

Receiving the user's command; further comprising,

The determining of the first portion of the first image includes determining the first portion of the first image based on the command of the user.

The method of claim 1, wherein the first image is obtained by photographing a street or a city.

The control method according to claim 1, wherein the first image and the second image are obtained from a map database of the server.

카메라 회로;

디스플레이;

통신 회로;

실행 가능한 인스트럭션들을 저장하는 적어도 하나의 메모리; 및

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

제 1 이미지를 표시하도록 상기 디스플레이를 제어하고, 상기 제 1 이미지는 건물의 전면, 상기 건물의 후면, 또는 상기 건물의 측면 중 적어도 하나를 포함하는 3차원(3D) 지도의 제 1 뷰(view)를 포함하고,

상기 제 1 이미지가 표시되는 동안, 상기 전자 장치의 카메라 회로를 이용하여 사용자의 시선을 획득하고,

상기 사용자의 시선의 유지 시간에 기초하여, 상기 제 1 이미지의 제 1 부분을 판단하고,

서버로부터 제 2 이미지를 수신하도록 상기 통신 회로를 제어하고, 상기 제 2 이미지는 상기 3차원 지도의 제 2 뷰(view)를 포함하고, 상기 제 1 이미지의 상기 제 1 부분에 기반하여 상기 제 2 이미지의 제 2 부분은 상기 제 1 이미지의 상기 제 1 부분 보다 더 높은 시인성을 가지고,

상기 서버로부터 수신된 상기 제 2 이미지를 표시하도록 상기 디스플레이를 제어하고, 상기 제 2 이미지의 상기 제 2 부분의 더 높은 시인성은 상기 제 1 이미지의 상기 제 1 부분의 해상도 보다 더 높은 해상도, 상기 제 1 부분의 선명도 보다 더 높은 선명도, 또는 상기 제 1 부분의 밝기 보다 더 높은 밝기 중 적어도 하나를 포함하고,

상기 디스플레이 상에 상기 제 2 이미지가 표시되는 동안, 상기 사용자의 시선에 기반하여 상기 사용자의 시점의 이동을 판단하도록 하는, 전자 장치.

As an electronic device,

Camera circuit;

display;

Communication circuit;

At least one memory for storing executable instructions; And

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

The display is controlled to display a first image, and the first image is a first view of a three-dimensional (3D) map including at least one of a front side of a building, a rear side of the building, or a side surface of the building. Including,

While the first image is displayed, using the camera circuit of the electronic device to acquire the user's gaze,

Determining a first portion of the first image based on the retention time of the user's gaze,

Controlling the communication circuit to receive a second image from a server, the second image comprising a second view of the three-dimensional map, and based on the first portion of the first image The second portion of the image has a higher visibility than the first portion of the first image,

Controlling the display to display the second image received from the server, wherein a higher visibility of the second portion of the second image is higher than the resolution of the first portion of the first image, the second At least one of a sharpness higher than the sharpness of the first part, or a brightness higher than the brightness of the first part,

An electronic device configured to determine a movement of the user's viewpoint based on the user's gaze while the second image is displayed on the display.

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

상기 카메라 회로를 이용하여 상기 사용자의 눈을 검출하도록 하고, 상기 사용자의 눈의 동공의 위치에 기반하여 상기 시선이 검출되는, 전자 장치.

The method of claim 10,

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

The electronic device, wherein the eye of the user is detected using the camera circuit, and the line of sight is detected based on the position of the pupil of the user's eye.

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

상기 디스플레이에 표시된 상기 제 1 이미지의 상기 제 1 부분을 상기 사용자가 주목하고 있는지 여부를 판단하도록 하는, 전자 장치.

The method of claim 10,

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

The electronic device configured to determine whether the user is paying attention to the first portion of the first image displayed on the display.

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

상기 사용자의 눈의 동공의 변화 또는 상기 사용자의 표정 변화에 기반해서 상기 제 1 이미지의 상기 제 1 부분을 상기 사용자가 주목하고 있는지 여부를 판단하도록 하는, 전자 장치.

The method of claim 12,

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

The electronic device configured to determine whether the user is paying attention to the first part of the first image based on a change in the pupil of the user's eye or a change in the user's facial expression.

The method of claim 10, wherein the second portion of the second image is enlarged, the degree of enlargement of the second portion of the second image is based on a frown degree of the user's face, and the viewpoint is the user's The electronic device, which is determined based on the degree of frowning of the face.

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

상기 사용자의 명령을 수신하고,

상기 사용자의 상기 명령에 기반하여 상기 시선을 획득하도록 하는, 전자 장치.

The method of claim 10,

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

Receive the user's command,

The electronic device to obtain the gaze based on the user's command.

상기 인스트럭션들은, 상기 인스트럭션들이 상기 적어도 하나의 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 프로세서가:

상기 사용자의 명령을 수신하고,

상기 제 1 이미지의 제 1 부분을 판단하는 단계는 상기 사용자의 상기 명령에 기반하여 상기 제 1 이미지의 상기 제 1 부분을 판단하도록 하는, 전자 장치.

The method of claim 10,

The instructions are, when the instructions are executed by the at least one processor, the at least one processor:

Receive the user's command,

The electronic device, wherein the determining of the first portion of the first image includes determining the first portion of the first image based on the command of the user.

The electronic device of claim 10, wherein the first image is obtained by photographing a street or a city.

The electronic device of claim 10, wherein the first image and the second image are obtained from a map database of the server.

실행 가능한 제 1 인스트럭션들을 저장하는 적어도 하나의 제 1 메모리; 적어도 하나의 제 1 프로세서를 포함하고, 상기 제 1 인스트럭션들은, 상기 제 1 인스트럭션들이 상기 적어도 하나의 제 1 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 제 1 프로세서가: 제 1 이미지를 표시하도록 제 1 장치의 제 1 디스플레이를 제어하고, 상기 제 1 이미지는 건물의 전면, 상기 건물의 후면, 또는 상기 건물의 측면 중 적어도 하나를 포함하는 3차원(3D) 지도의 제 1 뷰(view)를 포함하고, 상기 제 1 이미지가 표시되는 동안, 상기 제 1 장치의 제 1 카메라 회로를 이용하여 사용자의 시선을 획득하고, 상기 사용자의 시선의 유지 시간에 기초하여, 상기 제 1 이미지의 제 1 부분을 판단하고, 제 2 장치로부터 제 2 이미지를 수신하도록 상기 제 1 장치의 제 1 통신 회로를 제어하고, 상기 제 2 이미지는 상기 3차원 지도의 제 2 뷰(view)를 포함하고, 상기 제 1 이미지의 상기 제 1 부분에 기반하여 상기 제 2 이미지의 제 2 부분은 상기 제 1 이미지의 상기 제 1 부분 보다 더 높은 시인성을 가지고, 상기 제 2 장치로부터 수신된 상기 제 2 이미지를 표시하도록 상기 제 1 디스플레이를 제어하고, 상기 제 2 이미지의 상기 제 2 부분의 더 높은 시인성은 상기 제 1 이미지의 상기 제 1 부분의 해상도 보다 더 높은 해상도, 상기 제 1 부분의 선명도 보다 더 높은 선명도, 또는 상기 제 1 부분의 밝기 보다 더 높은 밝기 중 적어도 하나를 포함하고, 상기 제 1 디스플레이 상에 상기 제 2 이미지가 표시되는 동안, 상기 사용자의 시선에 기반하여 상기 사용자의 시점의 이동을 판단하도록 하고,

실행 가능한 제 2 인스트럭션들을 저장하는 적어도 하나의 제 2 메모리; 및 적어도 하나의 제 2 프로세서를 포함하고, 상기 제 2 인스트럭션들은, 상기 제 2 인스트럭션들이 상기 적어도 하나의 제 2 프로세서에 의해 실행되는 경우, 상기 적어도 하나의 제 2 프로세서가: 상기 제 1 장치로부터 상기 제 1 이미지의 상기 제 1 부분과 관련된 정보를 수신하도록 제 2 장치의 제 2 통신 회로를 제어하고, 상기 제 1 이미지의 상기 제 1 부분과 관련된 정보에 기반하여 상기 제 2 이미지를 상기 제 1 장치로 송신하도록 상기 제 2 통신 회로를 제어하도록 하는, 시스템.As a system device for improving visibility using gaze tracking,

At least one first memory for storing executable first instructions; Comprising at least one first processor, wherein the first instructions, when the first instructions are executed by the at least one first processor, the at least one first processor: first to display a first image 1 controls a first display of the device, wherein the first image comprises a first view of a three-dimensional (3D) map including at least one of a front of a building, a rear of the building, or a side of the building And, while the first image is displayed, the user's gaze is acquired using a first camera circuit of the first device, and based on the retention time of the user's gaze, a first portion of the first image is Determine and control a first communication circuit of the first device to receive a second image from a second device, the second image comprising a second view of the three-dimensional map, and the first image The second portion of the second image based on the first portion of the first has a higher visibility than the first portion of the first image, the first to display the second image received from the second device Control a display, and a higher visibility of the second portion of the second image is a higher resolution than the resolution of the first portion of the first image, a higher sharpness than the sharpness of the first portion, or the first It includes at least one of brightness higher than the brightness of the part, and determines the movement of the user's viewpoint based on the user's gaze while the second image is displayed on the first display,

At least one second memory for storing second executable instructions; And at least one second processor, wherein the second instructions, when the second instructions are executed by the at least one second processor, the at least one second processor: from the first device to the Controlling a second communication circuit of a second device to receive information relating to the first portion of the first image, and displaying the second image based on information relating to the first portion of the first image To control the second communication circuit to transmit to.

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020200039807AKR102159767B1 (en) | 2020-04-01 | 2020-04-01 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

| KR1020200120590AKR102312601B1 (en) | 2020-04-01 | 2020-09-18 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020200039807AKR102159767B1 (en) | 2020-04-01 | 2020-04-01 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020130066578ADivisionKR102098277B1 (en) | 2013-06-11 | 2013-06-11 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020200120590ADivisionKR102312601B1 (en) | 2020-04-01 | 2020-09-18 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20200040716A KR20200040716A (en) | 2020-04-20 |

| KR102159767B1true KR102159767B1 (en) | 2020-09-24 |

Family

ID=70467546

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020200039807AActiveKR102159767B1 (en) | 2020-04-01 | 2020-04-01 | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device |

Country Status (1)

| Country | Link |

|---|---|

| KR (1) | KR102159767B1 (en) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR102305880B1 (en)* | 2020-06-26 | 2021-09-28 | 이종우 | User's Gaze Tracking Method, and Medium Being Recorded with Program for Executing the Method |

| JP7528621B2 (en)* | 2020-08-05 | 2024-08-06 | 富士フイルムビジネスイノベーション株式会社 | Information processing device and information processing program |

| KR20230044833A (en)* | 2021-09-27 | 2023-04-04 | 삼성전자주식회사 | Electronic device and the method for representing contents |

| CN118140169A (en) | 2021-09-27 | 2024-06-04 | 三星电子株式会社 | Electronic device and method for displaying content |

| WO2024058405A1 (en)* | 2022-09-15 | 2024-03-21 | 삼성전자 주식회사 | Electronic device and method for controlling electronic device |

Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003174578A (en) | 2001-12-07 | 2003-06-20 | Nikon Corp | Electronic camera, image display device, and image display method |

| JP2009192448A (en) | 2008-02-18 | 2009-08-27 | Tama Art Univ | Information display device and information providing system |

| US20130050432A1 (en) | 2011-08-30 | 2013-02-28 | Kathryn Stone Perez | Enhancing an object of interest in a see-through, mixed reality display device |

Family Cites Families (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR101740728B1 (en)* | 2010-04-23 | 2017-05-29 | 주식회사 비즈모델라인 | System and Device for Displaying of Video Data |

- 2020

- 2020-04-01KRKR1020200039807Apatent/KR102159767B1/enactiveActive

Patent Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003174578A (en) | 2001-12-07 | 2003-06-20 | Nikon Corp | Electronic camera, image display device, and image display method |

| JP2009192448A (en) | 2008-02-18 | 2009-08-27 | Tama Art Univ | Information display device and information providing system |

| US20130050432A1 (en) | 2011-08-30 | 2013-02-28 | Kathryn Stone Perez | Enhancing an object of interest in a see-through, mixed reality display device |

Also Published As

| Publication number | Publication date |

|---|---|

| KR20200040716A (en) | 2020-04-20 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US12182322B2 (en) | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device | |

| US12249036B2 (en) | Augmented reality eyewear with speech bubbles and translation | |

| KR102159767B1 (en) | Visibility improvement method based on eye tracking, machine-readable storage medium and electronic device | |

| US11546505B2 (en) | Touchless photo capture in response to detected hand gestures | |

| US20240296633A1 (en) | Augmented reality experiences using speech and text captions | |

| US9857589B2 (en) | Gesture registration device, gesture registration program, and gesture registration method | |