KR101795574B1 - Electronic device controled by a motion, and control method thereof - Google Patents

Electronic device controled by a motion, and control method thereofDownload PDFInfo

- Publication number

- KR101795574B1 KR101795574B1KR1020110001522AKR20110001522AKR101795574B1KR 101795574 B1KR101795574 B1KR 101795574B1KR 1020110001522 AKR1020110001522 AKR 1020110001522AKR 20110001522 AKR20110001522 AKR 20110001522AKR 101795574 B1KR101795574 B1KR 101795574B1

- Authority

- KR

- South Korea

- Prior art keywords

- motion

- user

- electronic device

- recognition mode

- recognized

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/002—Specific input/output arrangements not covered by G06F3/01 - G06F3/16

- G06F3/005—Input arrangements through a video camera

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/26—Speech to text systems

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M1/00—Substation equipment, e.g. for use by subscribers

- H04M1/72—Mobile telephones; Cordless telephones, i.e. devices for establishing wireless links to base stations without route selection

- H04M1/724—User interfaces specially adapted for cordless or mobile telephones

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- General Physics & Mathematics (AREA)

- Multimedia (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Health & Medical Sciences (AREA)

- Acoustics & Sound (AREA)

- Computational Linguistics (AREA)

- General Health & Medical Sciences (AREA)

- Computer Vision & Pattern Recognition (AREA)

- User Interface Of Digital Computer (AREA)

Abstract

Translated fromKoreanDescription

Translated fromKorean본 발명은 전자기기 및 그 제어 방법에 대한 것으로, 보다 구체적으로는 모션을 이용하여 제어할 수 있는 전자기기 및 그 제어 방법에 대한 것이다.BACKGROUND OF THE INVENTION 1. Field of the Invention The present invention relates to an electronic apparatus and a control method thereof, and more particularly, to an electronic apparatus and a control method thereof that can be controlled using motion.

전자 기술의 발달에 힘입어, 다양한 종류의 최신 전자기기들이 개발되어 보급되고 있다. 최신 제품들에는 사용자가 해당 제품을 좀 더 편리하고 효과적으로 이용할 수 있도록 하기 위한 최신 기술들이 적용되고 있다. 그러한 기술들의 예를 들면, 모션 인식 기술, 음성 인식 기술 등이 있을 수 있다.Due to the development of electronic technology, various kinds of advanced electronic devices have been developed and popularized. The latest products include the latest technologies to make the product more convenient and effective for users. Examples of such techniques are motion recognition technology, speech recognition technology, and the like.

모션 인식 기술이란 모션 센서 등을 이용하여 사용자의 움직임, 즉, 모션을 센싱한 후, 그 센싱 결과를 이용하는 기술을 의미한다. 음성 인식 기술이란 사용자의 음성 명령어를 입력받아 분석한 후, 그 분석 결과를 이용하는 기술을 의미한다.The motion recognition technology refers to a technique of sensing a user's motion, that is, motion using a motion sensor, and using the sensing result. Speech recognition technology refers to a technique of receiving and analyzing a voice command of a user and using the analysis result.

이와 같은 인식 기술들은, 사용자가 편리하게 이용할 수는 있으나 모션이나 음성 명령어를 정확하게 입력하지 않으면, 의도하지 않은 기능을 수행하거나 입력 자체가 이루어지지 않아 수차례 반복 입력하여야 하는 번거로움이 있을 수 있다.Such recognition techniques can be conveniently used by the user, but if motion or voice commands are not inputted correctly, it may be troublesome to carry out an unintended function or to input a repetitive number of times because the input itself is not performed.

특히 모션 인식의 경우, 사용자가 모션 제어를 수행하기 위하여 취하는 모션인지, 무의식적으로 취하는 모션인지를 분간하기에 어려움이 있다. 또한, 3차원 공간에서의 모션을 감지하여야 하기 때문에, 연산 부담이 가중된다는 문제점도 있었다.Particularly, in the case of motion recognition, it is difficult to discriminate whether the user takes a motion to perform motion control or a motion unconsciously taken. In addition, since motion must be detected in the three-dimensional space, there is a problem that the calculation burden is increased.

따라서, 상대적으로 연산 부담을 경감시키면서도, 정확하게 사용자의 의사를 반영하여 동작을 취할 수 있는 모션 인식 기술에 대한 필요성이 대두되고 있다.Therefore, there is a need for a motion recognition technology capable of accurately taking actions of the user while reducing the computational burden relatively.

본 발명은 상술한 필요성에 따른 것으로, 본 발명의 목적은, 효과적인 모션 인식 기술을 사용하여 제어할 수 있는 전자기기 및 그 제어방법을 제공함에 있다.It is an object of the present invention to provide an electronic apparatus and a control method thereof that can be controlled using an effective motion recognition technology.

이상과 같은 목적을 달성하기 위한 본 발명의 일 실시 예에 따른 전자기기는, 모션을 인식하기 위한 모션 인식부, 전자기기의 전방에 위치한 객체가 상기 전자기기 방향으로 이동하는 푸쉬 모션이, 상기 모션 인식부에 의해 인식되면, 모션 인식 모드를 활성화하고, 상기 푸쉬 모션을 취한 객체의 이동을 추적(tracking)하여 상기 객체의 후속 모션에 대응되는 동작을 수행하는 제어부를 포함한다.According to another aspect of the present invention, there is provided an electronic device including a motion recognition unit for recognizing motion, a push motion in which an object positioned in front of the electronic device moves toward the electronic device, And a control unit for activating the motion recognition mode and tracking movement of the object that has taken the push motion and performing an operation corresponding to the subsequent motion of the object when the recognition unit recognizes the motion.

여기서, 상기 제어부는, 상기 모션 인식 모드가 활성화 되어 있는 상태에서, 상기 객체가 일 방향으로 이동하여 사용자의 신체면 또는 사물에 접하게 되는 모션이 상기 모션 인식부에 의해 인식되면, 상기 모션 인식 모드를 비활성화시킬 수 있다.Here, when the motion recognizing mode is activated, the controller moves the object in one direction and recognizes the motion of the user's body or object, Can be deactivated.

그리고, 상기 모션 인식부는, 상기 객체를 촬영하여 뎁스 정보를 포함하는 촬영 이미지 데이터를 생성하는 촬영부, 상기 촬영 이미지 데이터 상에서 상기 객체에 해당하는 픽셀군의 뎁스 정보가 변경되면 상기 푸쉬 모션이 이루어진 것으로 판단하는 판단부를 포함할 수 있다.The motion recognition unit may include a photographing unit that photographs the object and generates photographed image data including depth information, and the push motion is performed when the depth information of the pixel group corresponding to the object is changed on the photographed image data And may include a judgment unit for judging the judgment.

한편, 본 전자기기는, 음성 입력을 수신하기 위한 음성 입력부를 더 포함할 수 있다. 이 경우, 상기 제어부는, 음성 인식 모드를 상징하는 제1 모션이 인식되면, 음성 인식 모드로 전환하여, 상기 음성 입력에 대응되는 동작을 수행할 수 있다.Meanwhile, the electronic apparatus may further include a voice input unit for receiving voice input. In this case, when the first motion representing the voice recognition mode is recognized, the control unit can switch to the voice recognition mode and perform an operation corresponding to the voice input.

이 경우, 상기 제어부는, 상기 제1 모션의 반대 형태인 제2 모션이 인식되면, 상기 음성 인식 모드를 비활성화시킬 수도 있다.In this case, the controller may deactivate the voice recognition mode if the second motion, which is the opposite of the first motion, is recognized.

한편, 본 전자기기는, 상기 객체의 형태 및 크기에 대한 정보가 저장되는 저장부를 더 포함할 수도 있다. 여기서, 상기 객체의 형태 및 크기에 대한 정보는 사용자 설정에 따라 변경 가능하다.Meanwhile, the electronic device may further include a storage unit for storing information on the shape and size of the object. Here, information on the type and size of the object can be changed according to the user setting.

그리고, 상기 푸쉬 모션은 상기 객체가 상기 전자기기 방향으로 이동하였다가 반대 방향으로 이동하는 푸쉬-풀 모션 또는 상기 객체가 상기 전자기기 방향으로 이동한 상태에서 정지하는 푸쉬-스톱 모션이 될 수 있다.The push motion may be a push-pull motion in which the object moves in the direction of the electronic device and moves in the opposite direction, or a push-stop motion in which the object stops in the direction of the electronic device.

한편, 본 발명의 일 실시 예에 따르면, 전자기기의 제어 방법은, 상기 전자기기의 전방에 위치한 객체를 촬영하여, 상기 객체가 상기 전자기기 방향으로 이동하는 푸쉬 모션을 인식하는 단계, 상기 푸쉬 모션이 인식되면, 모션 인식 모드를 활성화하는 단계, 상기 푸쉬 모션을 취한 객체의 이동을 추적(tracking)하여 상기 객체의 모션에 대응되는 동작을 수행하는 단계를 포함한다.According to another aspect of the present invention, there is provided a method of controlling an electronic device, comprising: capturing an object positioned in front of the electronic device to recognize a push motion in which the object moves in the direction of the electronic device; Activating a motion recognition mode, tracking movement of the object taking the push motion, and performing an operation corresponding to the motion of the object.

이 경우, 상기 모션 인식 모드가 활성화된 상태에서, 상기 객체가 일 방향으로 이동하여 사용자의 신체면 또는 사물에 접하게 되는 모션이 인식되면, 상기 모션 인식 모드를 비활성화시키는 단계를 더 포함할 수 있다.In this case, when the motion recognition mode is activated, the motion recognition mode may be deactivated when the object moves in one direction and a motion of the user's face or object is recognized.

한편, 상기 객체의 푸쉬 모션을 인식하는 단계는, 상기 전자기기의 전방을 촬영하여 촬영 이미지 데이터를 생성하는 단계, 상기 촬영 이미지 데이터 상에서 상기 객체에 해당하는 픽셀군의 뎁스 정보가 변경되면 상기 푸쉬 모션이 이루어진 것으로 판단하는 판단 단계를 포함할 수 있다.The step of recognizing the push motion of the object may further include the steps of photographing the front of the electronic device to generate shot image data, and when the depth information of the pixel group corresponding to the object is changed on the shot image data, It may be judged that it has been performed.

여기서, 상기 판단 단계는, 상기 객체에 해당하는 픽셀군의 형태 및 크기에 대하여 기 저장된 정보를 독출하는 단계, 상기 촬영 이미지 데이터의 전체 픽셀들 중에서 뎁스 정보가 변경된 부분의 형태 및 크기를 상기 기 저장된 정보와 비교하여, 매칭되면 상기 객체의 푸쉬 모션이 이루어진 것으로 판단하는 단계를 포함할 수 있다. 여기서, 상기 정보는 사용자 설정에 따라 변경 가능할 수 있다.Here, the determining may include reading previously stored information about the shape and size of the pixel group corresponding to the object, comparing the shape and size of the portion where the depth information is changed among the pixels of the captured image data, Comparing the stored information with the stored information, and determining that the push motion of the object is made if the matching is performed. Here, the information may be changeable according to user settings.

한편, 본 제어 방법은, 음성 인식 모드를 상징하는 제1 모션이 인식되면, 음성 인식 모드로 전환하여, 상기 음성 입력에 대응되는 동작을 수행하는 단계를 더 포함할 수 있다.The control method may further include switching to a voice recognition mode and performing an operation corresponding to the voice input when the first motion symbolizing the voice recognition mode is recognized.

이 경우, 상기 제1 모션의 반대인 제2 모션이 인식되면, 상기 음성 인식 모드를 비활성화시키는 단계를 더 포함할 수도 있다.In this case, if the second motion opposite to the first motion is recognized, the method may further include deactivating the voice recognition mode.

그리고, 상기 푸쉬 모션은 상기 객체가 상기 전자기기 방향으로 이동하였다가 반대 방향으로 이동하는 푸쉬-풀 모션 또는 상기 객체가 상기 전자기기 방향으로 이동한 상태에서 정지하는 푸쉬-스톱 모션이 될 수 있다.The push motion may be a push-pull motion in which the object moves in the direction of the electronic device and moves in the opposite direction, or a push-stop motion in which the object stops in the direction of the electronic device.

이상과 같은 본 발명의 다양한 실시 예에 따르면, 사용자는 푸쉬 모션을 취하여 모션 인식 모드를 이용할 수 있게 된다. 이에 따라, 연산량을 줄이면서, 모션 인식의 오작동을 방지할 수 있게 된다.According to various embodiments of the present invention as described above, the user can use the motion recognition mode by taking the push motion. This makes it possible to prevent malfunction of the motion recognition while reducing the amount of calculation.

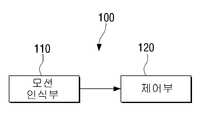

도 1은 본 발명의 일 실시 예에 따른 전자기기의 구성을 나타내는 블럭도,

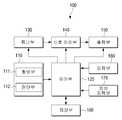

도 2는 본 발명의 다양한 실시 예를 설명하기 위한 전자기기의 세부구성을 나타내는 블럭도,

도 3은 푸쉬 모션을 설명하기 위한 도면,

도 4 및 도 5는 모션 인식 모드를 종료하기 위한 종료 모션의 다양한 예를 나타내는 도면,

도 6 내지 8은 음성 인식 모드를 활성화 또는 비활성화시키기 위한 모션의 다양한 예를 나타내는 도면,

도 9는 푸쉬 모션을 인식하는 과정을 설명하기 위한 도면,

도 10은 푸쉬-풀 모션을 설명하기 위한 도면, 그리고,

도 11은 본 발명의 다양한 실시 예에 따른 전자기기의 제어 방법을 설명하기 위한 흐름도이다.1 is a block diagram showing a configuration of an electronic apparatus according to an embodiment of the present invention,

2 is a block diagram showing a detailed configuration of an electronic device for explaining various embodiments of the present invention,

3 is a diagram for explaining push motion,

Figs. 4 and 5 are diagrams showing various examples of the end motion for ending the motion recognition mode; Fig.

6 to 8 are diagrams showing various examples of motions for activating or deactivating the speech recognition mode,

9 is a diagram for explaining a process of recognizing push motion,

10 is a diagram for explaining push-pull motion, and FIG.

11 is a flowchart illustrating a method of controlling an electronic apparatus according to various embodiments of the present invention.

이하에서, 첨부된 도면을 참조하여 본 발명에 대하여 구체적으로 설명한다.Hereinafter, the present invention will be described in detail with reference to the accompanying drawings.

도 1은 본 발명의 일 실시 예에 따른 전자기기의 구성을 나타내는 블럭도이다. 본 전자기기는 TV, 휴대폰, 모니터, 노트북 PC, 전자 액자, 전자 책, PDA, 네비게이션 등과 같이 디스플레이 유닛을 구비한 디스플레이 장치로 구현될 수도 있고, 그 밖에, 냉장고나, 에어컨, 오디오 등과 같은 다양한 가전 제품으로 구현될 수도 있다.1 is a block diagram showing a configuration of an electronic device according to an embodiment of the present invention. The present electronic device may be implemented as a display device having a display unit such as a TV, a mobile phone, a monitor, a notebook PC, an electronic photo frame, an electronic book, a PDA, navigation or the like, or various other home appliances such as a refrigerator, It may be implemented as a product.

도 1에 따르면, 본 전자기기(100)는 모션 인식부(110) 및 제어부(120)를 포함한다. 모션 인식부(110)는 전자기기(100)를 사용하는 사용자의 움직임, 즉, 모션을 센싱하여, 어떠한 모션이 이루어졌는지를 인식하는 구성이다.1, the

이를 위해, 모션 인식부(110)는 카메라와 같은 촬영 수단을 포함할 수 있다. 모션 인식부(110)는 촬영 수단의 촬영 범위 내에 존재하는 사용자 등을 촬영하여, 그 결과를 분석하여 모션을 인식한다. 구체적으로는, 모션 인식부(110)는 깊이 정보를 포함하는 촬영 이미지 데이터를 생성할 수 있는 깊이 카메라(depth camera)와 같은 촬영수단을 포함할 수 있다.For this, the

이에 따라, 모션 인식부(110)는 촬영 범위 내의 일 객체가 전자기기(100) 방향으로 이동하는 푸쉬 모션을 인식할 수 있다. 구체적으로는, 객체가 놓여진 지점에 3차원 좌표계를 적용하면, 전자기기(100)를 기준으로 상측을 향하도록 배치되는 Y축, Y축과 직교하면서 우측을 향하도록 배치되는 X축과, X축 및 Y축이 이루는 평면으로부터 전자기기(100)를 향하도록 배치되는 Z축으로 설명할 수 있다. 푸쉬 모션이란 Z축 방향으로의 모션을 의미한다.Accordingly, the

제어부(120)는 푸쉬 모션이 인식되면, 모션 인식 모드로 동작하는 것으로 판단하고, 모션 인식 모드로 전환한다. 즉, 푸쉬 모션이 인식되기 이전까지는 일반 모드로 동작하여, 사용자의 리모콘 조작이나 전자기기(100) 본체에 구비된 키조작에 따른 제어 동작을 수행한다. 이러한 상태에서 모션 인식 모드로 전환되면, 제어부(120)는 이후부터는 사용자의 모션을 인식하여 그 모션에 부합되는 동작을 수행한다.When the push motion is recognized, the

이 경우, 제어부(120)는 최초 푸쉬 모션을 수행한 객체의 움직임을 추적하여, 해당 객체의 모션을 인식하고, 그 인식된 모션에 대응되는 동작을 수행한다. 이러한 동작의 예로는 파워 턴-온, 턴-오프, 채널 변경, 볼륨 변경, 이전 페이지 또는 상위 페이지로의 전환, 각종 메뉴 또는 아이콘 선택, 커서 이동 등과 같은 다양한 동작이 있을 수 있다.In this case, the

모션 인식 모드로 전환된 경우, 제어부(120)는 모션 이외의 입력은 수용하지 않을 수도 있으나, 이와 다른 실시 예에서는 모션 인식 모드로 전환된 상태에서도 제어부(120)는 리모콘이나 본체 키 조작이 있으면, 그 키조작에 따른 동작도 함께 수행할 수도 있다. 즉, 모션 인식 모드가 반드시 모션에 의해서만 제어되는 모드인 것은 아니다.When the mode is switched to the motion recognition mode, the

한편, 제어부(120)는 기 설정된 특정 모션이 모션인식부(110)에 의해 인식되면, 모션 인식 모드를 종료한다. 모션 인식 모드를 종료시키기 위한 모션을 이하에서는 종료 모션이라 명명한다. 종료 모션은 다양하게 정해질 수 있다. 일 예로는, 객체가 사용자의 손바닥이라면, 종료 모션은 손바닥 부분이 더이상 인식되지 않도록 객체가 사용자의 신체나 타 사물에 접하게 되는 모션이 될 수 있다. 이에 대해서는 후술하는 부분에서 도면과 함께 설명한다.On the other hand, when the predetermined motion is recognized by the

상술한 바와 같이 푸쉬 모션을 이용하여 모션 인식 모드를 개시하게 되면, Z축 방향으로의 움직임이 감지되기 이전까지는 굳이 X축 및 Y축 방향으로의 모션을 분석할 필요가 없어진다. 이에 따라, 촬영 이미지 데이터 파싱으로 인한 연산 부담이 경감될 수 있다. 또한, X 및 Y축 방향으로의 움직임은 사용자의 일상 생활에서 무심코 취할 수 있는 것이 대부분이나, 전자기기 방향으로 손바닥을 뻗어서 푸쉬하는 푸쉬 모션은 사용자가 제어를 위한 의도를 가지고 수행하는 동작이라고 볼 수 있다. 따라서, X축 및 Y축 방향으로의 움직임을 이용하여 모션을 인식하는 것보다, 좀 더 정확하게 사용자의 의도를 이해하여 모션 인식 제어를 수행할 수 있게 된다.As described above, when the motion recognition mode is started by using the push motion, it is not necessary to analyze the motion in the X and Y axis directions until the motion in the Z axis direction is sensed. Accordingly, the computational burden due to the parsing of the shot image data can be alleviated. In addition, most of the movements in the X and Y axis directions can be taken unintentionally in the user's daily life. However, the push motion in which the user pushes the palm of the hand in the direction of the electronic device is an operation performed by the user with intention for control have. Accordingly, it is possible to perform motion recognition control more accurately by understanding the intention of the user than by using motion in the X-axis and Y-axis directions to recognize the motion.

도 2는 본 발명의 다양한 실시 예에 따른 전자기기의 구성을 설명하기 위한 블럭도이다. 구체적으로는, 도 2는 TV와 같이 방송 신호 채널을 튜닝하여 방송 데이터를 출력할 수 있는 디스플레이 장치의 구성을 예로 들어 설명한다.2 is a block diagram for explaining a configuration of an electronic apparatus according to various embodiments of the present invention. Specifically, FIG. 2 illustrates an example of a configuration of a display device that can output broadcast data by tuning a broadcast signal channel like a TV.

도 2에 따르면, 본 전자기기(100)는 모션 인식부(110) 및 제어부(120) 이외에, 튜너부(130), 신호처리부(140), 출력부(150), 입력부(160), 음성 입력부(170), 저장부(180)를 포함할 수 있다.2, the

튜너부(130)는 방송 신호 채널을 선국하여, 그에 따른 방송 신호를 수신하고, 다운 컨버팅하여 신호처리부(140)로 제공하는 구성을 의미한다.The

신호 처리부(140)는 튜너부(130)에서 제공되는 신호에 대하여 복호화, 등화(equalizing), 디코딩, 스케일링 등의 신호 처리를 수행하여, 출력부(150)로 제공한다.The

출력부(150)는 신호 처리부(140)에서 처리된 영상 신호 및 음성 신호 등을 디스플레이 유닛이나, 스피커 등과 같은 출력 소자들을 이용하여 출력하는 구성이다.The

입력부(160)는 전자기기(100) 본체에 구비된 키 또는 외부 리모콘에 구비된 키의 조작에 따른 사용자 선택 신호를 입력받는 구성이다. 구체적으로는, 입력부(160)는 키패드 및 IR 신호 수신 램프 등을 포함할 수 있다.The

음성 입력부(170)는 사용자가 발음하는 음성 입력을 수신하는 구성이다. 음성 입력부(170)는 사용자의 음성 입력이 수신되면, 음성 인식 기술을 이용하여 음성 입력을 분석할 수 있다.The

음성 입력부(170)의 내부 구성은 그 사용되는 기술의 종류에 따라 다양하게 변형될 수 있다. 일 예로, 단어 인식 기술이 사용된다면, 음성 입력부(170)는 음성 입력을 수집하는 마이크부, 수집된 음성 입력을 분석하는 분석부, 분석 결과를 이용하여 음운을 인식하는 음운 인식부, 인식된 음운을 이용하여 단어를 인식하는 단어 인식부, 인식된 단어를 제어부로 제공하는 처리부(이상, 미도시) 등을 포함할 수 있다.The internal structure of the

분석부는, 수신된 음성 입력 신호에 대해 약 20~30㎳의 짧은 구간마다 주파수분석 또는 선형예측분석과 같은 수학적인 변환 처리를 수행하고, 이를 이용하여 특징 벡터 계열의 신호를 출력한다. 음운 인식부는, 출력되는 신호의 특징을 이용하여 세그먼테이션(segmentation)을 수행하여, 음성 신호의 각 구간을 하나의 단위로 하여 모음 및 자음을 인식한다. 인식 결과는 음운 래티스(phoneme lattice) 형태로 단어 인식부로 제공될 수 있다. 단어 인식부는 단어의 음형이 기록되어 있는 단어 사전을 참조하여, 음운 래티스를 단어 래티스로 변환한다. 단어 사전은 음성 입력부(170) 내부 또는 전자기기(100) 자체에 마련된 메모리에 저장되어 있을 수 있다. 처리부는, 단어 래티스에 포함된 단어를 이용하여 의미적으로 정합되는 단어열을 구성한다.The analyzer performs a mathematical conversion process such as frequency analysis or linear prediction analysis for a short interval of about 20 to 30 ms with respect to the received voice input signal, and outputs a signal of a feature vector series using the mathematical conversion process. The phonological recognition unit performs segmentation using the characteristics of the output signal and recognizes vowels and consonants as a unit of each section of the voice signal. The recognition result may be provided as a phoneme lattice to the word recognition unit. The word recognition unit refers to a word dictionary in which a pattern of a word is recorded, and converts the phonological lattice to the word lattice. The word dictionary may be stored in the

저장부(180)는 전자기기(100)와 관련된 각종 정보를 저장하는 구성을 의미한다. 일 예로, 저장부(180)에는 객체에 대한 정보가 저장될 수 있다. 객체에 대한 정보란 객체의 형태나 크기 등이 될 수 있으며, 사용자에 의해 적절하게 변경될 수도 있다.The

즉, 상술한 바와 같이 사용자의 손바닥이 객체로 사용된다면, 사용자는 자신의 손바닥을 미리 모션 인식부(110)를 통해 촬영하여 그 형태 및 크기에 대한 정보를 저장부(180)에 등록시켜둘 수 있다. 이에 따라, 객체 등록이 되지 않은 타 사용자들에 대해서는, 모션 인식 제어가 불가능하도록 설정해 둘 수도 있다. 이에 따라, 전자기기(100)에 대한 사용 권한을 사용자만이 가지도록 구현할 수도 있다.That is, if the user's palm is used as an object as described above, the user can photograph his / her palm through the

또는, 다른 실시 예에 따르면, 저장부(180)에 저장되는 객체 관련 정보는 전자기기(100)의 제작시에 디폴트로 결정되어 저장부(180)에 저장될 수도 있다.Alternatively, according to another embodiment, the object-related information stored in the

한편, 다른 실시 예에서는, 저장부(180)에 미리 객체 관련 정보를 저장해 두지 않고, 촬영 이미지 데이터 내에서 특정 부분이 푸쉬 모션을 취한 것으로 인식되면, 그 부분의 형태나 크기 등에 상관없이 바로 모션 인식 모드로 전환되도록 구현할 수도 있다.On the other hand, in another embodiment, if object-related information is not stored in advance in the

또한, 복수의 사용자들이 함께 시청하는 경우, 그 중 제일 먼저 푸쉬 모션을 취한 사용자의 객체만을 추적하여, 그 객체에 따른 제어를 수행하도록 구현될 수도 있다.Also, when a plurality of users watch together, only the object of the user who has taken the first push motion may be tracked, and control may be performed according to the object.

한편, 도 2에 따르면, 모션 인식부(110)는 촬영부(111) 및 판단부(112)를 포함한다. 촬영부(111)는 전자기기 방향으로의 움직임을 센싱하기 위하여 3차원 깊이 카메라를 구비할 수 있다. 3차원 깊이 카메라는 적외선을 방사하고, 그 적외선이 물체에 닿았다가 되돌아오는 시간을 측정해 물체까지의 거리를 산출한다. 깊이 카메라에서 얻은 이미지는 그레이 레벨로 출력되며, 각 픽셀 별로 가로, 세로, 거리와 같은 좌표 값이 표현된다. 즉, 픽셀 별로 뎁스 정보가 마련되는 촬영 이미지 데이터를 생성한다.Referring to FIG. 2, the

판단부(112)는 촬영부(111)에서 생성된 촬영 이미지 데이터를 분석하여, 푸쉬 모션이 발생하였는지 여부를 판단한다. 구체적으로는, 상술한 객체에 해당하는 픽셀 군을 탐색하고, 해당 픽셀 군의 뎁스 정보가 변경되었는지 여부를 판단한다. 이 경우, 판단부(112)는 객체와의 거리가 전자기기로부터 멀어지는 경우로 판단되면 푸쉬 모션이라고 판단하지 않고, 전자기기로 가까워지는 경우로 판단될 때만 푸쉬 모션이라고 판단한다.The

다른 실시 예에 따르면, 판단부(112)는 촬영 이미지 데이터 중에서 깊이 정보가 변경된 부분이 있는지 판단한다. 이에 따라, 깊이 정보가 변경되어 Z축 방향으로 이동한 상태인 것으로 판단되면, 푸쉬 모션이 이루어진 것으로 바로 판단할 수 있다. 또는, 이 경우, 판단부(112)는 기 등록된 객체 관련 정보가 있으면, 깊이 정보가 변경된 픽셀군의 크기 및 형태를 등록된 객체 관련 정보와 비교하여 유사성이 있는지 여부를 판단한다. 이에 따라, 매칭된다고 볼 수 있을 정도로 유사성이 있으면 푸쉬 모션으로 판단한다.According to another embodiment, the

상술한 바와 같이, 모션 인식 모드로 전환하기 위한 모션은 전자기기 방향으로 객체가 이동하는 푸쉬 모션이 사용된다. 푸쉬 모션은 Z축 방향으로의 이동이므로, 일반 모드 하에서 모션 인식부(110)는 촬영 이미지 데이터의 깊이 정보 변화 여부만을 체크하여 푸쉬 모션이 이루어졌는지를 판단한다. 이에 따라, 푸쉬 모션이 이루어져서 모션 인식 모드로 전환되면, 그 이후부터는 모션 인식부(110)는 Z축 뿐만 아니라 X축 및 Y축 방향으로의 움직임도 모두 체크하여, 객체의 움직임을 분석한다.As described above, the motion for switching to the motion recognition mode uses the push motion in which the object moves in the direction of the electronic device. Since the push motion is the movement in the Z-axis direction, in the normal mode, the

제어부(120)는 모션 인식부(110)에서 인식된 결과에 따라 모션 인식 모드로 전환되면, 이후부터 인식되는 모션, 즉, 후속 모션에 대응되는 동작을 수행한다. 모션 별로 대응되는 동작에 대한 정보는 저장부(180)에 저장되어 있을 수 있다. 제어부(120)는 모션 인식 모드로 전환된 상태에서 모션 인식부(110)에서 모션이 인식되면, 인식된 모션에 대응되는 동작 정보가 저장부(180)에 저장되어 있는지 확인한다. 이에 따라, 확인된 정보가 있으면, 제어부(120)는 해당 동작을 수행하기 위하여, 튜너부(130), 신호처리부(140), 출력부(150), 입력부(160), 음성 입력부(170), 저장부(180) 등의 구성요소들을 제어한다.When the mode is switched to the motion recognition mode according to the result recognized by the

일 예로, 제어부(120)는 채널 변경 명령을 의미하는 모션이 인식되면, 그 모션에 따라 튜너부(130)를 제어하여 다른 채널을 선국하도록 한다.For example, when a motion indicating a channel change command is recognized, the

한편, 다른 실시 예에 따르면, 제어부(120)는 일반 모드나 모션 인식 모드로 동작하는 중에 특정 모션이 감지되면, 음성 인식 모드로 전환할 수도 있다. 음성 입력부(170)는 이러한 실시 예의 경우에 사용되는 구성이다. 즉, 제어부(120)는 음성 인식 모드로 진입하기 위하여 설정된 모션이 감지되면, 음성 입력부(170)를 활성화하여 그 이후부터 사용자가 발음하는 음성 명령어를 입력받는다. 이에 따라, 그 음성 명령어에 대응되는 동작을 수행할 수 있다.Meanwhile, according to another embodiment, the

일 예에 따르면, 제어부(120)는 모션 인식 모드로 동작하는 중에 음성 인식 모드로 진입하기 위한 모션이 감지될 경우, 모션 인식 모드를 자동으로 종료하고 음성 인식 모드에 따라 음성 제어만을 수행하도록 구현될 수 있다. 이 경우, 제어부(120)는 모션 인식부(110)를 자동으로 비활성화시킬 수도 있다. 여기서 비활성화란 전원 공급을 차단하는 동작이 될 수 있다.According to one example, when the motion for entering the voice recognition mode is detected while the mobile terminal is operating in the motion recognition mode, the

한편, 다른 예에 따르면, 제어부(120)는 모션 인식 모드 자체가 종료되지 않은 상태에서 음성 인식 모드로 진입하기 위한 모션이 감지될 경우, 모션 제어와 음성 제어를 모두 수행하도록 구현될 수도 있다. 즉, 모션 인식부(110)와 음성 입력부(170) 모두를 활성화시켜서 사용자의 모션이나 음성 모두에 반응하여, 대응되는 동작을 수행할 수 있다.Meanwhile, according to another example, the

그 밖에, 제어부(120)는 음성 인식 모드로 동작하거나, 모션 인식 모드로 동작하는 경우에도 입력부(160)를 통해 입력되는 사용자 선택 신호에 따른 동작을 수행할 수 있다.In addition, the

한편, 도 2에서는 입력부(160), 음성 입력부(170), 모션 인식부(110) 등을 모두 포함하고 있는 구성을 도시하였으나, 반드시 이와 같이 구현될 필요는 없다. 즉, 음성 인식 모드를 지원하지 않는 경우에는 음성 입력부(170)가 배제될 수도 있다.2, the

도 3은 푸쉬 모션을 설명하기 위한 도면이다. 도 3과 같이, 전자기기(100)는 TV로 구현될 수 있다. 이 경우, 촬영부(111)는 TV를 이용하는 사용자가 위치하는 주된 위치인 전방을 향하여 배치될 수 있다. 이러한 상태에서, 사용자는 손을 들어서 손바닥을 전자기기(100) 측으로 미는 동작, 즉, 푸쉬 모션을 수행한다. 따라서, 손 또는 손바닥이 상술한 객체에 해당한다. 한편, 손이나 손바닥 이외에 특정한 사물, 예를 들어, 지휘봉이나 특정 카드 등을 객체로 활용할 수도 있다. 3 is a diagram for explaining push motion. 3, the

상술한 바와 같이 사용자가 있는 지점에서 X축 및 Y축은 디스플레이 화면과 수평한 평면을 이루도록 배치되고, Z축은 X축 및 Y축 평면에 수직하도록 전자기기(100)를 향하도록 배치된 축을 의미한다. 객체(11)가 Z축을 따라 전자기기(100) 방향으로 이동하는 것이 푸쉬 모션이다.As described above, the X axis and the Y axis are arranged so as to form a horizontal plane with the display screen at the point where the user is present, and the Z axis is arranged to face the

도 4는 모션 인식 모드를 종료하기 위한 모션의 일 예를 나타내는 도면이다. 도 4에 따르면, 객체(11)를 사용자의 신체 일부에 붙이는 모션을 종료 모션으로 사용할 수 있다. 객체(11)를 추적하여 촬영하던 전자기기(100)는 추적중이던 객체(11)가 하측으로 이동하면서, 객체(11)에 해당하는 픽셀 군의 크기가 감소하여 사라지면, 종료 모션으로 인식하고 모션 인식 모드를 비활성화시킨다.4 is a diagram showing an example of motion for ending the motion recognition mode. According to Fig. 4, a motion of attaching the

도 5는 모션 인식 모드를 종료하기 위한 모션의 다른 예를 나타내는 도면이다. 도 5에 따르면, 객체(11)를 사용자의 신체가 아닌 다른 사물에 붙이는 모션을 종료 모션으로 사용할 수 있다. 도 4에서와 마찬가지로 손, 즉, 객체(11)를 사물에 붙이게 되면, 객체(11)에 해당하는 픽셀 군의 크기가 감소하여 사라지게 되므로, 이를 종료 모션으로 인식하여 모션 인식 모드를 비활성화시킬 수 있다.5 is a diagram showing another example of motion for ending the motion recognition mode. According to Fig. 5, a motion of attaching the

실험적으로, 사용자는 손을 이용하여 모션 제어를 하는 것이 대부분이다.Experimentally, it is mostly that the user uses the hand to perform motion control.

이상과 같은 본 발명의 다양한 실시 예들에 따르면, 손을 들어서 전자기기(100)를 향하게 되면 푸쉬 모션으로 인식되어 모션 인식 모드가 자동으로 개시되고, 이 후에는 손을 이용하여 여러 모션을 취하여 모션 제어를 하다가 단순히 손을 내리기만 하면 모션 인식 모드가 자동으로 종료된다. 따라서, 별도의 어려운 모션을 취하지 않더라도 모션 제어를 손쉽게 개시하고 종료시킬 수 있다.According to various embodiments of the present invention as described above, when the hand is lifted and is pointed toward the

한편, 도 4 및 도 5에서는 객체(11)를 내리면서 사용자의 다리나 사물에 붙이는 모션이 수행되었을 때 모션 인식 모드를 종료하게 되지만, 반드시 이에 한정되지 않으며, 모션 인식 모드를 종료하기 위한 특정 키가 입력되었을 경우에도 모션 인식 모드가 종료될 수 있다.4 and 5, the motion recognition mode is terminated when the motion to be attached to the user's leg or object is performed while the

또는, 모션 인식 모드가 개시된 이후, 기 설정된 임계 시간 이상(예를 들어, 1분 정도) 별다른 모션이 감지되지 않으면 모션 인식 모드를 바로 비활성화시킬 수도 있다.Alternatively, after the start of the motion recognition mode, the motion recognition mode may be immediately deactivated if no other motion is detected over a predetermined threshold time (for example, about one minute).

도 6은 음성 인식 모드를 활성화시키기 위한 모션의 일 예를 나타낸다. 도 6에 따르면, 사용자는 음성 인식 모드를 상징하는 제1 모션을 수행하여 음성 인식 모드를 개시할 수 있다. 음성 인식 모드를 상징한다는 것은, 사용자가 음성 인식 모드를 연상할 수 있는 모션이라는 의미이다. 도 6에 따르면, "Voice"를 의미하는 "V" 형태의 제1 모션을 취하게 되면, 음성 인식 모드가 개시된다.6 shows an example of a motion for activating the voice recognition mode. According to Fig. 6, the user can perform the first motion symbolizing the voice recognition mode to start the voice recognition mode. Symbolizing the voice recognition mode means that the user can reminisce the voice recognition mode. According to Fig. 6, when the first motion of the "V" type, which means "Voice", is taken, the voice recognition mode is started.

음성 인식 모드가 개시된 이후에는 사용자는 다양한 음성 명령어를 발음하여 음성 제어를 수행할 수 있다. 음성 인식 모드 하에서 사용자가 특정한 모션을 다시 취하거나, 일정 시간 동안 음성 입력이 없으면 음성 인식 모드는 자동으로 종료될 수 있다.After the voice recognition mode is started, the user can perform voice control by pronouncing various voice commands. Under the voice recognition mode, the user may take a specific motion again, or the voice recognition mode may be automatically terminated if there is no voice input for a certain period of time.

도 7은 음성 인식 모드를 비활성화시키기 위한 모션의 일 예를 나타낸다. 도 7에 따르면, 사용자의 객체(11)가 제1 모션의 반대 형태인 제2 모션, 즉, "V"자가 거꾸로 뒤집혀진 형태의 곡선을 그리게 되면, 음성 인식 모드를 비활성화시키게 된다.7 shows an example of a motion for deactivating the voice recognition mode. Referring to FIG. 7, if the user's

도 8은 음성 인식 모드를 활성화 또는 비활성화시키기 위한 또 다른 모션의 예를 나타낸다. 도 8에 따르면, "Speech"를 의미하는 "S"자 형태의 곡선이 음성 인식 모드를 활성화 또는 비활성화시키는 모션으로 사용될 수 있다.8 shows an example of another motion for activating or deactivating the voice recognition mode. According to Fig. 8, an "S" -shaped curve representing "Speech " can be used as the motion to activate or deactivate the speech recognition mode.

한편, 상술한 바와 같이 사용자는 일반 모드 하에서도 도 6 또는 도 8과 같은 모션을 취하여 음성 인식 모드를 활성화시킬 수 있다.Meanwhile, as described above, the user can activate the voice recognition mode by taking the motion as shown in FIG. 6 or FIG. 8 even in the normal mode.

또는, 모션 인식 모드로 전환하는 중에도 도 6 또는 도 8과 같은 모션을 취하여 음성 인식 모드를 활성화시킬 수도 있다. 이 경우, 음성 인식 모드를 비활성화시키기 위한 모션(즉, 도 7과 같은 모션)이나, 음성 명령어, 키입력신호 등이 입력되면, 전자기기(100)는 모션 인식 모드로 전환될 수 있다.Alternatively, the voice recognition mode may be activated by taking the motion as shown in FIG. 6 or FIG. 8 even while switching to the motion recognition mode. In this case, when the motion for disabling the speech recognition mode (i.e., the motion as shown in FIG. 7), the voice command, the key input signal, and the like are input, the

한편, 상술한 여러 실시 예들에서는 전자기기(100)가 3차원 뎁스 카메라를 이용하여 깊이 정보를 포함하는 촬영 이미지 데이터를 분석하여 푸쉬 모션을 감지하는 것으로 설명하였으나, 3차원 뎁스 카메라를 이용하지 않고도 2차원 평면 상에서의 크기 변화를 인식하여 푸쉬 모션인지 여부를 감지할 수도 있다.Meanwhile, in the above-described various embodiments, the

도 9는 푸쉬 모션을 인식하기 위하여 촬영 이미지 데이터를 분석하는 것을 나타내는 도면이다. 도 9에 따르면, 전자기기(100)는 객체가 촬영된 촬영 이미지 데이터의 각 프레임을 복수 개의 블록으로 구분하여, 객체에 해당하는 블록의 개수를 확인한다. 도 9의 좌측 도면과 우측 도면은 각각 현재 프레임 및 다음 프레임(또는, 일정 시간 이후의 프레임)을 나타낸다. 도 9에서와 같이, 현재 프레임에 비해 다음 프레임에서 객체(11)에 해당하는 블록의 개수가 더 증대하면, 푸쉬 모션으로 판단할 수 있다. 객체(11)에 해당하는 블록이란, 평균 픽셀값 등이 객체(11)의 평균 픽셀값과 유사한 범위 내에 있으며 연속적으로 이어지는 블록들을 의미한다.Fig. 9 is a view showing analysis of photographed image data in order to recognize the push motion. Fig. Referring to FIG. 9, the

한편, 도 10은 객체(11), 즉, 손을 전자기기 방향으로 뻗었다가 다시 오무리는 동작, 즉, 푸쉬-풀 모션을 나타낸다. 실험에 따르면, 사용자는 푸쉬 모션을 취하기 위하여 손을 뻗었다가 반사적으로 다시 오무리는 것이 일반적이다. 따라서, 단순히 손을 앞으로 뻗는 동작과의 차별화를 위하여, 푸쉬-풀 모션이 감지되었을 때 모션 인식 모드를 개시할 수 있다. 전자기기는 Z축 방향으로의 깊이 정보가 커졌다가 다시 작아지는지 여부를 판단하여, 푸쉬-풀 모션을 인식할 수 있다.On the other hand, Fig. 10 shows an

그 밖에, 손을 뻗고 그 상태를 그대로 유지하는 푸쉬-스톱 모션이 일어났을 때, 모션 인식 모드를 개시할 수도 있다.Alternatively, the motion recognition mode may be started when a push-stop motion occurs in which a hand is extended and the state is maintained.

이와 같이, 푸쉬 모션은 푸쉬-풀 모션이나 푸쉬-스톱 모션을 포함할 수 있다.As such, the push motion may include push-pull motion or push-stop motion.

도 11은 본 발명의 일 실시 예에 따른 전자기기의 제어 방법을 설명하기 위한 흐름도이다. 도 11에 따르면, 푸쉬 모션이 일어난 것으로 판단되면(S1110), 모션 인식 모드로 전환한다(S1120).11 is a flowchart illustrating a method of controlling an electronic device according to an embodiment of the present invention. Referring to FIG. 11, when it is determined that the push motion has occurred (S1110), the mode is switched to the motion recognition mode (S1120).

푸쉬 모션이 일어났는지 여부를 판단하는 판단 단계는, 다양한 실시 예로 구현될 수 있다. 일 예로, 객체에 해당하는 픽셀군의 형태 및 크기에 대하여 기 저장된 정보를 독출하고, 촬영 이미지 데이터의 전체 픽셀들 중에서 뎁스 정보가 변경된 부분의 형태 및 크기를 독출된 정보와 비교할 수 있다. 비교 결과 서로 매칭되면 객체의 푸쉬 모션이 이루어진 것으로 판단할 수 있다. 객체와 관련된 상술한 정보들은 사용자 또는 제조자 등에 의해 상이하게 변경될 수도 있다.The determination step of determining whether or not the push motion has occurred may be implemented in various embodiments. For example, it is possible to read previously stored information about the shape and size of the pixel group corresponding to the object, and to compare the shape and size of the changed portion of the depth information among the entire pixels of the shot image data with the read information. If the comparison results match, it can be determined that the push motion of the object has been performed. The above-described information related to the object may be changed differently by the user or the manufacturer.

모션 인식 모드로 전환된 상태에서 후속하는 모션이 인식되면(S1130), 인식된 모션에 대응되는 동작을 수행한다(S1140).When the motion is recognized in the motion recognition mode (S1130), the motion corresponding to the recognized motion is performed (S1140).

예를 들면, 전자기기는, 손을 흔드는 모션이 있으면, 이전 페이지 또는 상위 페이지로 전환하는 동작을 수행하고, 손을 일 방향으로 이동시키면 그 방향으로 커서를 이동시키는 동작을 수행할 수 있다. 또한, 커서가 특정 메뉴 상에 위치한 상태에서 손이 일정시간 정지하는 홀드 모션이 있으면, 해당 메뉴를 선택하여 그 기능을 실행할 수 있다. 그 밖에, 채널 조정 메뉴, 또는 볼륨 조정 메뉴 등이 선택된 상태에서는 손의 이동 방향 및 이동 거리에 따라 채널 조정 또는 볼륨 조정을 수행할 수도 있다.For example, when there is motion in which the hand is shaken, the electronic device performs an operation of switching to the previous page or an upper page, and when the hand is moved in one direction, the electronic device can perform an operation of moving the cursor in that direction. If there is a hold motion in which the hand is stopped for a predetermined time while the cursor is positioned on a specific menu, the corresponding menu can be selected and the function can be executed. In addition, when the channel adjustment menu or the volume adjustment menu is selected, the channel adjustment or the volume adjustment may be performed according to the movement direction and the movement distance of the hand.

또한, 음성 인식 모드를 활성화시키기 위한 모션이 입력되면, 음성 인식 모드를 활성화시킬 수도 있다. 즉, 사용자는 전자기기에서 일반모드로 이용하다가 음성 인식 모드를 이용하고 싶은 경우, 손을 들고 앞으로 뻗어서 푸쉬 모션을 취한 후 도 6이나 도 8과 같은 모션을 취하고 손을 내리면 된다. 이에 따라, 바로 음성 인식 모드로 들어갈 수 있다.Further, when a motion for activating the voice recognition mode is input, the voice recognition mode may be activated. That is, if the user wants to use the voice recognition mode while using the electronic device in the normal mode, he or she may extend the hand to reach the forward motion, take the motion as shown in FIG. 6 or 8, and lower the hand. Accordingly, it is possible to directly enter the voice recognition mode.

한편, 모션 인식 모드로 동작하는 경우, 전자기기는 모션의 속도나 거리에 따라 동작의 수행 정도를 다르게 적용할 수 있다. 예를 들어, 채널 변경을 수행하는 모션이 수행될 때, 일반적인 속도 또는 일반적인 거리만큼 모션을 수행하게 되면 1채널 단위로 채널 변경을 수행할 수 있다. 반면, 임계값 이상으로 빠른 속도 또는 먼 거리만큼 모션을 수행하게 되면 5 채널 단위 또는 10 채널 단위와 같이 더 큰 단위로 채널 변경을 수행할 수 있다. 이와 같이, 모션에 따른 동작의 수행 단위는 모션 속도나 모션 거리에 따라 상이하게 설정할 수 있다.On the other hand, when operating in the motion recognition mode, the electronic device can apply the degree of performance of the motion differently depending on the speed or distance of the motion. For example, when a motion for performing a channel change is performed, if the motion is performed at a normal speed or a general distance, the channel change can be performed on a channel-by-channel basis. On the other hand, if the motion is performed at a high speed or a long distance beyond the threshold value, the channel change can be performed in a larger unit such as a 5-channel unit or a 10-channel unit. In this way, the unit of motion according to the motion can be set differently according to the motion speed or the motion distance.

또한, 모션이 수행되었는 지 여부는, 모션이 일어난 후 정지할 때까지의 시간이나, 반복 횟수, 모션이 이루어진 거리 등을 종합적으로 고려하여 인식할 수 있다.Whether or not the motion has been performed can be recognized in consideration of the time until the motion is stopped, the number of repetitions, the distance at which the motion is performed, and the like in a comprehensive manner.

한편, 이상과 같은 제어 방법을 수행하기 위한 프로그램 코드는 다양한 유형의 기록 매체에 저장될 수 있다. 구체적으로는, RAM(Random Access Memory), 플레시메모리, ROM(Read Only Memory), EPROM(Erasable Programmable ROM), EEPROM(Electronically Erasable and Programmable ROM), 레지스터, 하드디스크, 리무버블 디스크, 메모리 카드, USB 메모리, CD-ROM 등과 같이, 단말기에서 판독 가능한 다양한 유형의 기록 매체에 저장되어 있을 수 있다.On the other hand, the program code for carrying out the control method as described above can be stored in various types of recording media. More specifically, it may be a random access memory (RAM), a flash memory, a ROM (Read Only Memory), an EPROM (Erasable Programmable ROM), an Electrically Erasable and Programmable ROM (EEPROM), a register, a hard disk, a removable disk, And may be stored in various types of recording media readable by a terminal, such as a memory, a CD-ROM, and the like.

이에 따라, 모션 인식이 가능한 각종 장치에, 상술한 프로그램 코드가 기록된 기록 매체가 연결되거나 탑재된다면, 상술한 제어 방법이 지원될 수 있게 된다.Accordingly, if the recording medium on which the above-described program code is recorded is connected to or mounted on various devices capable of motion recognition, the above-described control method can be supported.

또한, 이상에서는 본 발명의 바람직한 실시예에 대하여 도시하고 설명하였지만, 본 발명은 상술한 특정의 실시예에 한정되지 아니하며, 청구범위에서 청구하는 본 발명의 요지를 벗어남이 없이 당해 발명이 속하는 기술분야에서 통상의 지식을 가진자에 의해 다양한 변형실시가 가능한 것은 물론이고, 이러한 변형실시들은 본 발명의 기술적 사상이나 전망으로부터 개별적으로 이해되어져서는 안될 것이다.While the present invention has been particularly shown and described with reference to exemplary embodiments thereof, it is to be understood that the invention is not limited to the disclosed exemplary embodiments, but, on the contrary, It will be understood by those skilled in the art that various changes in form and detail may be made therein without departing from the spirit and scope of the present invention.

110 : 모션 인식부120 : 제어부

130 : 튜너부140 : 신호처리부

150 : 출력부160 : 입력부

170 : 음성 입력부180 : 저장부110: motion recognition unit 120: control unit

130: tuner unit 140: signal processing unit

150: output unit 160: input unit

170: Voice input unit 180:

Claims (15)

Translated fromKorean뎁스(depth) 정보를 포함하는 이미지를 촬영하는 촬영부; 및

상기 촬영부에서 촬영한 상기 이미지로부터 사용자의 신체 일부의 움직임에 따른 제1 모션이 인식되면, 상기 전자기기의 모션 인식 모드를 활성화하고, 상기 모션 인식 모드가 활성화되면 상기 사용자의 신체 일부의 움직임을 추적하여, 특정 모션이 인식되면 상기 특정 모션에 대응되는 상기 전자기기의 기능을 수행하고, 상기 모션 인식 모드가 활성화되지 않은 경우에는 상기 특정 모션이 인식되더라도 상기 특정 모션에 대응되는 상기 전자기기의 기능을 수행하지 않는 제어부;를 포함하며,

상기 제어부는,

상기 제1 모션을 수행한 사용자의 신체 일부가 상기 촬영된 이미지에 포함되지 않는 것으로 판단되면, 상기 모션 인식 모드를 비활성화시키는 전자기기.1. An electronic device for supporting motion recognition,

A photographing unit photographing an image including depth information; And

A motion recognition mode of the electronic device is activated when a first motion corresponding to a user's body motion is recognized from the image captured by the photographing unit and a motion of the user's body part is activated when the motion recognition mode is activated And when the motion recognition mode is not activated, performing the function of the electronic device corresponding to the specific motion, if the specific motion is recognized, And a control unit which does not perform the operation,

Wherein,

And deactivates the motion recognition mode if it is determined that a body part of the user who has performed the first motion is not included in the photographed image.

상기 제어부는,

상기 촬영된 이미지로부터 상기 제1 모션을 수행한 사용자의 신체 일부가 사용자의 다른 신체면 또는 사용자 외부 사물에 접촉하는 모션이 인식된 경우, 상기 모션 인식 모드를 비활성화시키는 것을 특징으로 하는 전자기기.The method according to claim 1,

Wherein,

Wherein the controller is configured to deactivate the motion recognition mode when a motion is detected in which a body part of a user who has performed the first motion from the photographed image contacts a user's other body surface or a user external object.

상기 제1 모션은,

상기 전자기기의 전방에 위치한 상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동하는 모션인 것을 특징으로 하는 전자기기.3. The method of claim 2,

Wherein the first motion comprises:

Wherein a part of the body of the user located in front of the electronic device is a motion of moving in the direction of the electronic device.

상기 제어부는,

상기 촬영된 이미지의 데이터 상에서 상기 사용자의 신체 일부에 해당하는 픽셀군의 뎁스 정보가 변경되면 상기 제1 모션이 이루어진 것으로 판단하는 것을 특징으로 하는 전자기기.The method of claim 3,

Wherein,

Wherein the controller determines that the first motion is performed when the depth information of the pixel group corresponding to the body part of the user is changed on the data of the photographed image.

상기 제1 모션은

상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동하였다가 반대 방향으로 이동하는 푸쉬-풀 모션 또는 상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동한 상태에서 정지하는 푸쉬-스톱 모션인 것을 특징으로 하는 전자기기.5. The method of claim 4,

The first motion

Stop motion in which a part of the user's body moves in the direction of the electronic device and moves in the opposite direction or a push-stop motion in which a part of the user's body moves in the direction of the electronic device. Electronics.

음성 입력을 수신하기 위한 음성 입력부;를 더 포함하며,

상기 제어부는,

제2 모션이 인식되면, 음성 인식 모드를 활성화시켜 상기 음성 입력에 대응되는 동작을 수행하고,

상기 제2 모션의 반대 형태인 제3 모션이 인식되면, 상기 음성 인식 모드를 비활성화시키는 것을 특징으로 하는 전자기기.The method according to claim 1,

And a voice input unit for receiving voice input,

Wherein,

When the second motion is recognized, activates a voice recognition mode to perform an operation corresponding to the voice input,

And to deactivate the voice recognition mode when the third motion, which is an opposite type of the second motion, is recognized.

상기 사용자의 신체 일부의 형태 및 크기에 대한 정보가 저장되는 저장부;를 더 포함하며,

상기 사용자의 신체 일부의 형태 및 크기에 대한 정보는 사용자 설정에 따라 변경 가능한 것을 특징으로 하는 전자기기.7. The method according to any one of claims 1 to 6,

And a storage unit for storing information on the shape and size of the user's body part,

Wherein the information about the shape and size of the body part of the user is changeable according to a user setting.

뎁스(depth) 정보를 포함하는 이미지를 촬영하는 단계;

상기 촬영된 상기 뎁스 정보를 포함하는 이미지로부터 사용자의 신체 일부의 움직임에 따른 제1 모션이 인식되면, 상기 전자기기의 모션 인식 모드를 활성화하는 단계;

상기 모션 인식 모드가 활성화되면 상기 사용자의 신체 일부의 움직임을 추적하여, 특정 모션이 인식되면 상기 특정 모션에 대응되는 상기 전자기기의 기능을 수행하는 단계; 및

상기 제1 모션을 수행한 상기 사용자의 신체 일부가 상기 촬영된 이미지에 포함되지 않는 것으로 판단되면, 상기 모션 인식 모드를 비활성화시키는 단계;를 포함하고,

상기 수행하는 단계는,

상기 모션 인식 모드가 활성화되지 않은 경우에는 상기 특정 모션이 인식되더라도 상기 특정 모션에 대응되는 상기 전자기기의 기능을 수행하지 않는 제어 방법.A control method of an electronic device supporting motion recognition,

Capturing an image including depth information;

Activating a motion recognition mode of the electronic device when a first motion corresponding to a motion of a part of a user's body is recognized from an image including the photographed depth information;

Tracking the movement of a part of the user's body when the motion recognition mode is activated and performing a function of the electronic device corresponding to the specific motion when a specific motion is recognized; And

And deactivating the motion recognition mode if it is determined that a body part of the user who has performed the first motion is not included in the photographed image,

Wherein the performing comprises:

When the motion recognition mode is not activated, the function of the electronic device corresponding to the specific motion is not performed even if the specific motion is recognized.

상기 촬영된 이미지로부터 상기 제1 모션을 수행한 사용자의 신체 일부가 사용자의 다른 신체면 또는 사용자 외부 사물에 접촉하는 모션이 인식된 경우, 상기 모션 인식 모드를 비활성화시키는 것을 특징으로 하는 제어 방법.9. The method of claim 8,

Wherein the motion recognition mode is deactivated when motion is detected in which a body part of a user who has performed the first motion from the photographed image contacts a user's other body surface or a user external object.

상기 제1 모션은,

상기 전자기기의 전방에 위치한 상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동하는 모션인 것을 특징으로 하는 제어 방법.10. The method of claim 9,

Wherein the first motion comprises:

Wherein a part of the body of the user located in front of the electronic device is a motion that moves in the direction of the electronic device.

상기 활성화하는 단계는,

상기 이미지 내에서 상기 사용자의 신체 일부에 해당하는 픽셀 군의 뎁스 정보가 변경되면 상기 제1 모션이 이루어진 것으로 판단하는 것을 특징으로 하는 제어 방법.11. The method of claim 10,

Wherein the activating comprises:

Wherein when the depth information of the pixel group corresponding to the body part of the user is changed in the image, it is determined that the first motion is performed.

상기 제1 모션은

상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동하였다가 반대 방향으로 이동하는 푸쉬-풀 모션 또는 상기 사용자의 신체 일부가 상기 전자기기 방향으로 이동한 상태에서 정지하는 푸쉬-스톱 모션인 것을 특징으로 하는 제어 방법.12. The method of claim 11,

The first motion

Stop motion in which a part of the user's body moves in the direction of the electronic device and moves in the opposite direction or a push-stop motion in which a part of the user's body moves in the direction of the electronic device. Control method.

제2 모션이 인식되면, 음성 인식 모드를 활성화시켜 음성 입력에 대응되는 동작을 수행하는 단계;를 더 포함하는 것을 특징으로 하는 제어 방법.9. The method of claim 8,

And when the second motion is recognized, activating a voice recognition mode to perform an operation corresponding to the voice input.

상기 제2 모션의 반대 형태인 제3 모션이 인식되면, 상기 음성 인식 모드를 비활성화시키는 단계;를 더 포함하는 것을 특징으로 하는 제어 방법.14. The method of claim 13,

And deactivating the speech recognition mode if a third motion that is an opposite type of the second motion is recognized.

상기 사용자의 신체 일부의 형태 및 크기에 대한 정보는 상기 전자 기기에 저장되며, 사용자 설정에 따라 변경 가능한 것을 특징으로 하는 제어 방법.

15. The method according to any one of claims 8 to 14,

Wherein the information about the shape and size of the body part of the user is stored in the electronic device and is changeable according to a user setting.

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020110001522AKR101795574B1 (en) | 2011-01-06 | 2011-01-06 | Electronic device controled by a motion, and control method thereof |

| US13/335,200US9513711B2 (en) | 2011-01-06 | 2011-12-22 | Electronic device controlled by a motion and controlling method thereof using different motions to activate voice versus motion recognition |

| EP12150202AEP2474883A1 (en) | 2011-01-06 | 2012-01-04 | Electronic device controlled by a motion and controlling method thereof |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020110001522AKR101795574B1 (en) | 2011-01-06 | 2011-01-06 | Electronic device controled by a motion, and control method thereof |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020140081937ADivisionKR20140096250A (en) | 2014-07-01 | 2014-07-01 | Electronic device controled by a motion, and control method thereof |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20120080070A KR20120080070A (en) | 2012-07-16 |

| KR101795574B1true KR101795574B1 (en) | 2017-11-13 |

Family

ID=45558499

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020110001522AExpired - Fee RelatedKR101795574B1 (en) | 2011-01-06 | 2011-01-06 | Electronic device controled by a motion, and control method thereof |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US9513711B2 (en) |

| EP (1) | EP2474883A1 (en) |

| KR (1) | KR101795574B1 (en) |

Families Citing this family (20)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP2834721A4 (en)* | 2012-08-02 | 2015-12-09 | Samsung Electronics Co Ltd | METHOD FOR CONTROLLING A DEVICE, AND DEVICE THEREFOR |

| DE102013109862A1 (en)* | 2012-09-10 | 2014-03-13 | Electronics And Telecommunications Research Institute | Device and method for user connection and terminal that uses the same |

| KR101350314B1 (en)* | 2013-08-12 | 2014-01-13 | 전자부품연구원 | Character input apparatus based on depth information of hand gesture and method thereof |

| JP2015089059A (en)* | 2013-11-01 | 2015-05-07 | ソニー株式会社 | Information processing device, information processing method, and program |

| KR101636903B1 (en)* | 2014-01-02 | 2016-07-07 | 경희대학교 산학협력단 | Electronic device including motion sensing camera and operating method according to motion sensing |

| KR102210433B1 (en)* | 2014-01-21 | 2021-02-01 | 삼성전자주식회사 | Electronic device for speech recognition and method thereof |

| KR102171817B1 (en)* | 2014-03-14 | 2020-10-29 | 삼성전자주식회사 | Display apparatus and method for controlling display apparatus thereof |

| US9495004B2 (en) | 2014-09-08 | 2016-11-15 | Qualcomm Incorporated | Display device adjustment by control device |

| US10917627B2 (en)* | 2016-06-03 | 2021-02-09 | Utku Buyuksahin | System and a method for capturing and generating 3D image |

| KR101937823B1 (en)* | 2016-10-24 | 2019-01-14 | 주식회사 브이터치 | Method, system and non-transitory computer-readable recording medium for assisting object control |

| CN110009639A (en)* | 2018-08-02 | 2019-07-12 | 永康市柴迪贸易有限公司 | Books automatic push platform |

| KR102831245B1 (en)* | 2018-10-23 | 2025-07-08 | 삼성전자주식회사 | Electronic device and method for controlling electronic device |

| US11508378B2 (en)* | 2018-10-23 | 2022-11-22 | Samsung Electronics Co., Ltd. | Electronic device and method for controlling the same |

| US11151993B2 (en)* | 2018-12-28 | 2021-10-19 | Baidu Usa Llc | Activating voice commands of a smart display device based on a vision-based mechanism |

| US11437031B2 (en)* | 2019-07-30 | 2022-09-06 | Qualcomm Incorporated | Activating speech recognition based on hand patterns detected using plurality of filters |

| US11809633B2 (en) | 2021-03-16 | 2023-11-07 | Snap Inc. | Mirroring device with pointing based navigation |

| US11798201B2 (en)* | 2021-03-16 | 2023-10-24 | Snap Inc. | Mirroring device with whole-body outfits |

| US11908243B2 (en) | 2021-03-16 | 2024-02-20 | Snap Inc. | Menu hierarchy navigation on electronic mirroring devices |

| US11978283B2 (en) | 2021-03-16 | 2024-05-07 | Snap Inc. | Mirroring device with a hands-free mode |

| US11734959B2 (en) | 2021-03-16 | 2023-08-22 | Snap Inc. | Activating hands-free mode on mirroring device |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2008516322A (en)* | 2004-10-05 | 2008-05-15 | ソニー フランス エスアー | Content management interface |

| JP2008162376A (en)* | 2006-12-27 | 2008-07-17 | Takata Corp | Vehicular working system, and vehicle |

| US20100295781A1 (en)* | 2009-05-22 | 2010-11-25 | Rachid Alameh | Electronic Device with Sensing Assembly and Method for Interpreting Consecutive Gestures |

| WO2010138952A2 (en)* | 2009-05-29 | 2010-12-02 | Microsoft Corporation | Gesture shortcuts |

Family Cites Families (81)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH08211979A (en) | 1995-02-02 | 1996-08-20 | Canon Inc | Hand gesture input device and method |

| US5594469A (en) | 1995-02-21 | 1997-01-14 | Mitsubishi Electric Information Technology Center America Inc. | Hand gesture machine control system |

| KR19990008158A (en) | 1995-04-28 | 1999-01-25 | 모리시타요우이치 | Interface device |

| US5855000A (en) | 1995-09-08 | 1998-12-29 | Carnegie Mellon University | Method and apparatus for correcting and repairing machine-transcribed input using independent or cross-modal secondary input |

| US5767457A (en) | 1995-11-13 | 1998-06-16 | Cirque Corporation | Apparatus and method for audible feedback from input device |

| JPH1144703A (en) | 1997-07-25 | 1999-02-16 | Matsushita Electric Ind Co Ltd | Hand gesture input device |

| US6950534B2 (en) | 1998-08-10 | 2005-09-27 | Cybernet Systems Corporation | Gesture-controlled interfaces for self-service machines and other applications |

| US6501515B1 (en) | 1998-10-13 | 2002-12-31 | Sony Corporation | Remote control system |

| US6351222B1 (en) | 1998-10-30 | 2002-02-26 | Ati International Srl | Method and apparatus for receiving an input by an entertainment device |

| US6952803B1 (en) | 1998-12-29 | 2005-10-04 | Xerox Corporation | Method and system for transcribing and editing using a structured freeform editor |

| US6842175B1 (en) | 1999-04-22 | 2005-01-11 | Fraunhofer Usa, Inc. | Tools for interacting with virtual environments |

| KR100446612B1 (en) | 2001-07-24 | 2004-09-04 | 삼성전자주식회사 | Method and apparatus for selecting information in multi-dimensional space |

| US7096432B2 (en) | 2002-05-14 | 2006-08-22 | Microsoft Corporation | Write anywhere tool |

| US20030233237A1 (en) | 2002-06-17 | 2003-12-18 | Microsoft Corporation | Integration of speech and stylus input to provide an efficient natural input experience |

| JP2004246814A (en) | 2003-02-17 | 2004-09-02 | Takenaka Komuten Co Ltd | Indication movement recognition device |

| US7665041B2 (en)* | 2003-03-25 | 2010-02-16 | Microsoft Corporation | Architecture for controlling a computer using hand gestures |

| KR20050065198A (en) | 2003-12-24 | 2005-06-29 | 한국전자통신연구원 | Three-dimensional motion command recognizer using motion of user |

| US8684839B2 (en) | 2004-06-18 | 2014-04-01 | Igt | Control of wager-based game using gesture recognition |

| JP4005061B2 (en) | 2004-06-30 | 2007-11-07 | 株式会社ソニー・コンピュータエンタテインメント | Information processing apparatus, program, and object control method in information processing apparatus |

| US8335694B2 (en) | 2004-07-09 | 2012-12-18 | Bruce Reiner | Gesture-based communication and reporting system |

| NZ553141A (en) | 2004-07-19 | 2009-08-28 | Creative Tech Ltd | Method and apparatus for touch scrolling |

| KR20060070280A (en) | 2004-12-20 | 2006-06-23 | 한국전자통신연구원 | User interface device using hand gesture recognition and its method |

| US7551779B2 (en) | 2005-03-17 | 2009-06-23 | Microsoft Corporation | Word or character boundary-based scratch-out gesture recognition |

| US8280169B2 (en) | 2005-12-21 | 2012-10-02 | Michael Linderman | Recordation of handwriting and hand movement using electromyography |

| WO2007097548A1 (en) | 2006-02-20 | 2007-08-30 | Cheol Woo Kim | Method and apparatus for user-interface using the hand trace |

| KR100858358B1 (en) | 2006-09-29 | 2008-09-11 | 김철우 | Method and apparatus for user-interface using the hand trace |

| US8249334B2 (en) | 2006-05-11 | 2012-08-21 | Primesense Ltd. | Modeling of humanoid forms from depth maps |

| US7721207B2 (en) | 2006-05-31 | 2010-05-18 | Sony Ericsson Mobile Communications Ab | Camera based control |

| KR20080006393A (en) | 2006-07-12 | 2008-01-16 | 삼성전자주식회사 | Display device, control method and signal processing device using same |

| JP2008090625A (en) | 2006-10-02 | 2008-04-17 | Sharp Corp | Character input device, character input method, control program, and recording medium |

| US20080134102A1 (en) | 2006-12-05 | 2008-06-05 | Sony Ericsson Mobile Communications Ab | Method and system for detecting movement of an object |

| CN101558367A (en) | 2006-12-05 | 2009-10-14 | 索尼爱立信移动通讯有限公司 | Method and system for detecting movement of an object |

| US8144148B2 (en) | 2007-02-08 | 2012-03-27 | Edge 3 Technologies Llc | Method and system for vision-based interaction in a virtual environment |

| US20080221882A1 (en) | 2007-03-06 | 2008-09-11 | Bundock Donald S | System for excluding unwanted data from a voice recording |

| US20100153880A1 (en) | 2007-03-07 | 2010-06-17 | Kannuu Pty Ltd. | Method system and apparatus for entering text on a computing device |

| JP2008269174A (en) | 2007-04-18 | 2008-11-06 | Fujifilm Corp | Control device, method and program |

| JP4625831B2 (en) | 2007-08-01 | 2011-02-02 | シャープ株式会社 | Display device and display method |

| US20110210931A1 (en) | 2007-08-19 | 2011-09-01 | Ringbow Ltd. | Finger-worn device and interaction methods and communication methods |

| JP2009069202A (en) | 2007-09-10 | 2009-04-02 | Teac Corp | Audio processing device |

| US20090070109A1 (en) | 2007-09-12 | 2009-03-12 | Microsoft Corporation | Speech-to-Text Transcription for Personal Communication Devices |

| JP2009093291A (en) | 2007-10-04 | 2009-04-30 | Toshiba Corp | Gesture determination device and method |

| TW200928892A (en) | 2007-12-28 | 2009-07-01 | Wistron Corp | Electronic apparatus and operation method thereof |

| US8555207B2 (en) | 2008-02-27 | 2013-10-08 | Qualcomm Incorporated | Enhanced input using recognized gestures |

| US20110029869A1 (en) | 2008-02-29 | 2011-02-03 | Mclennan Hamish | Method and system responsive to intentional movement of a device |

| US8380119B2 (en) | 2008-05-15 | 2013-02-19 | Microsoft Corporation | Gesture-related feedback in eletronic entertainment system |

| US8566717B2 (en) | 2008-06-24 | 2013-10-22 | Microsoft Corporation | Rendering teaching animations on a user-interface display |

| US20110115702A1 (en) | 2008-07-08 | 2011-05-19 | David Seaberg | Process for Providing and Editing Instructions, Data, Data Structures, and Algorithms in a Computer System |

| US20100031202A1 (en) | 2008-08-04 | 2010-02-04 | Microsoft Corporation | User-defined gesture set for surface computing |

| US20100079413A1 (en) | 2008-09-29 | 2010-04-01 | Denso Corporation | Control device |

| JP5183398B2 (en) | 2008-09-29 | 2013-04-17 | 株式会社日立製作所 | Input device |

| EP2180395A1 (en) | 2008-10-24 | 2010-04-28 | Himax Media Solutions, Inc. | Display control device and display control method |

| KR101737829B1 (en) | 2008-11-10 | 2017-05-22 | 삼성전자주식회사 | Motion Input Device For Portable Device And Operation Method using the same |

| CN201294582Y (en) | 2008-11-11 | 2009-08-19 | 天津三星电子有限公司 | Television set controlled through user gesture motion |

| KR20100056838A (en) | 2008-11-20 | 2010-05-28 | 주식회사 대우일렉트로닉스 | Apparatus and method for controlling electronics based on user action |

| US8543415B2 (en) | 2008-11-26 | 2013-09-24 | General Electric Company | Mobile medical device image and series navigation |

| CN101437124A (en) | 2008-12-17 | 2009-05-20 | 三星电子(中国)研发中心 | Method for processing dynamic gesture identification signal facing (to)television set control |

| CN101751206A (en) | 2008-12-19 | 2010-06-23 | 英华达股份有限公司 | Electronic book device and operation method thereof |

| JP5175755B2 (en) | 2009-02-04 | 2013-04-03 | 株式会社東芝 | Gesture recognition device, method and program thereof |

| US8517834B2 (en) | 2009-02-17 | 2013-08-27 | Softkinetic Studios Sa | Computer videogame system with body position detector that requires user to assume various body positions |

| US20100235786A1 (en) | 2009-03-13 | 2010-09-16 | Primesense Ltd. | Enhanced 3d interfacing for remote devices |

| JP5246010B2 (en) | 2009-04-20 | 2013-07-24 | 富士通モバイルコミュニケーションズ株式会社 | Mobile terminal and data display method |

| JP5256109B2 (en) | 2009-04-23 | 2013-08-07 | 株式会社日立製作所 | Display device |

| KR20100118317A (en) | 2009-04-28 | 2010-11-05 | 삼성전자주식회사 | Gesture recognition method using portable terminal with camera by camera movement tracking and thereof system |

| US9377857B2 (en) | 2009-05-01 | 2016-06-28 | Microsoft Technology Licensing, Llc | Show body position |

| US20100277470A1 (en) | 2009-05-01 | 2010-11-04 | Microsoft Corporation | Systems And Methods For Applying Model Tracking To Motion Capture |

| KR20110003146A (en) | 2009-07-03 | 2011-01-11 | 한국전자통신연구원 | Gesture recognition device, robot system having same and gesture recognition method using same |

| US9400548B2 (en) | 2009-10-19 | 2016-07-26 | Microsoft Technology Licensing, Llc | Gesture personalization and profile roaming |

| KR101612788B1 (en)* | 2009-11-05 | 2016-04-18 | 엘지전자 주식회사 | Mobile terminal and method for controlling the same |

| WO2011066343A2 (en) | 2009-11-24 | 2011-06-03 | Next Holdings Limited | Methods and apparatus for gesture recognition mode control |

| US20110161889A1 (en) | 2009-12-30 | 2011-06-30 | Motorola, Inc. | User Interface for Electronic Devices |

| US9268404B2 (en) | 2010-01-08 | 2016-02-23 | Microsoft Technology Licensing, Llc | Application gesture interpretation |

| US20130120282A1 (en) | 2010-05-28 | 2013-05-16 | Tim Kukulski | System and Method for Evaluating Gesture Usability |

| US8836643B2 (en)* | 2010-06-10 | 2014-09-16 | Qualcomm Incorporated | Auto-morphing adaptive user interface device and methods |

| US8296151B2 (en)* | 2010-06-18 | 2012-10-23 | Microsoft Corporation | Compound gesture-speech commands |

| US20120096345A1 (en) | 2010-10-19 | 2012-04-19 | Google Inc. | Resizing of gesture-created markings for different display sizes |

| US9348417B2 (en) | 2010-11-01 | 2016-05-24 | Microsoft Technology Licensing, Llc | Multimodal input system |

| US8786547B2 (en) | 2010-12-23 | 2014-07-22 | Microsoft Corporation | Effects of gravity on gestures |

| US20130246063A1 (en) | 2011-04-07 | 2013-09-19 | Google Inc. | System and Methods for Providing Animated Video Content with a Spoken Language Segment |

| DE112011105305T5 (en) | 2011-06-03 | 2014-03-13 | Google, Inc. | Gestures for text selection |

| US8442970B2 (en) | 2011-08-05 | 2013-05-14 | Microsoft Corporation | Creating and editing user search queries |

| US20130067411A1 (en) | 2011-09-08 | 2013-03-14 | Google Inc. | User gestures indicating rates of execution of functions |

- 2011

- 2011-01-06KRKR1020110001522Apatent/KR101795574B1/ennot_activeExpired - Fee Related

- 2011-12-22USUS13/335,200patent/US9513711B2/enactiveActive

- 2012

- 2012-01-04EPEP12150202Apatent/EP2474883A1/ennot_activeCeased

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2008516322A (en)* | 2004-10-05 | 2008-05-15 | ソニー フランス エスアー | Content management interface |

| JP2008162376A (en)* | 2006-12-27 | 2008-07-17 | Takata Corp | Vehicular working system, and vehicle |

| US20100295781A1 (en)* | 2009-05-22 | 2010-11-25 | Rachid Alameh | Electronic Device with Sensing Assembly and Method for Interpreting Consecutive Gestures |

| WO2010138952A2 (en)* | 2009-05-29 | 2010-12-02 | Microsoft Corporation | Gesture shortcuts |

Also Published As

| Publication number | Publication date |

|---|---|

| US9513711B2 (en) | 2016-12-06 |

| KR20120080070A (en) | 2012-07-16 |

| US20120179472A1 (en) | 2012-07-12 |

| EP2474883A1 (en) | 2012-07-11 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR101795574B1 (en) | Electronic device controled by a motion, and control method thereof | |

| CN102681658B (en) | By display device and the method for controlling operation thereof of action control | |

| CN102681659B (en) | Display apparatus controlled by a motion, and motion control method thereof | |

| KR102230630B1 (en) | Rapid gesture re-engagement | |

| US9927974B2 (en) | Automatic customization of keypad key appearance | |

| US20120050530A1 (en) | Use camera to augment input for portable electronic device | |

| CN114578951B (en) | Display device and control method thereof | |

| US20130211843A1 (en) | Engagement-dependent gesture recognition | |

| US20120304067A1 (en) | Apparatus and method for controlling user interface using sound recognition | |

| KR20080104099A (en) | Input device and its input method | |

| WO2012011614A1 (en) | Information device, control method thereof and system | |

| KR20160106691A (en) | System and method for controlling playback of media using gestures | |

| CN106713767A (en) | Focusing method for camera on intelligent mobile phone, tablet personal computer or netbook | |

| WO2015041954A1 (en) | Method and apparatus for controlling display of region in mobile device | |

| KR20120004569A (en) | Mobile device interface device, method and recording medium therefor | |

| KR101348763B1 (en) | Apparatus and method for controlling interface using hand gesture and computer-readable recording medium with program therefor | |

| CN112256126A (en) | Method, electronic circuit, electronic device, and medium for recognizing gesture | |

| US20150116209A1 (en) | Electronic device and method for controlling buttons of electronic device | |

| KR101803574B1 (en) | Gesture Recognition System Based on Vision | |

| KR20140096250A (en) | Electronic device controled by a motion, and control method thereof | |

| JP2013145434A (en) | Switch depression determination system, method, program and computer readable medium storing program in gesture recognition device | |

| KR101414345B1 (en) | Input device using camera and method thereof | |

| CN111949132A (en) | Gesture control method based on touch and talk pen and touch and talk pen |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PA0109 | Patent application | St.27 status event code:A-0-1-A10-A12-nap-PA0109 | |

| R18-X000 | Changes to party contact information recorded | St.27 status event code:A-3-3-R10-R18-oth-X000 | |

| PG1501 | Laying open of application | St.27 status event code:A-1-1-Q10-Q12-nap-PG1501 | |

| A201 | Request for examination | ||

| AMND | Amendment | ||

| P11-X000 | Amendment of application requested | St.27 status event code:A-2-2-P10-P11-nap-X000 | |

| P13-X000 | Application amended | St.27 status event code:A-2-2-P10-P13-nap-X000 | |

| PA0201 | Request for examination | St.27 status event code:A-1-2-D10-D11-exm-PA0201 | |

| P11-X000 | Amendment of application requested | St.27 status event code:A-2-2-P10-P11-nap-X000 | |

| P13-X000 | Application amended | St.27 status event code:A-2-2-P10-P13-nap-X000 | |

| D13-X000 | Search requested | St.27 status event code:A-1-2-D10-D13-srh-X000 | |

| D14-X000 | Search report completed | St.27 status event code:A-1-2-D10-D14-srh-X000 | |

| E902 | Notification of reason for refusal | ||

| PE0902 | Notice of grounds for rejection | St.27 status event code:A-1-2-D10-D21-exm-PE0902 | |

| E601 | Decision to refuse application | ||

| PE0601 | Decision on rejection of patent | St.27 status event code:N-2-6-B10-B15-exm-PE0601 | |

| T11-X000 | Administrative time limit extension requested | St.27 status event code:U-3-3-T10-T11-oth-X000 | |

| A107 | Divisional application of patent | ||

| AMND | Amendment | ||

| P11-X000 | Amendment of application requested | St.27 status event code:A-2-2-P10-P11-nap-X000 | |

| P13-X000 | Application amended | St.27 status event code:A-2-2-P10-P13-nap-X000 | |

| PA0107 | Divisional application | St.27 status event code:A-0-1-A10-A18-div-PA0107 St.27 status event code:A-0-1-A10-A16-div-PA0107 | |

| PX0901 | Re-examination | St.27 status event code:A-2-3-E10-E12-rex-PX0901 | |

| E902 | Notification of reason for refusal | ||

| PE0902 | Notice of grounds for rejection | St.27 status event code:A-1-2-D10-D21-exm-PE0902 | |

| T11-X000 | Administrative time limit extension requested | St.27 status event code:U-3-3-T10-T11-oth-X000 | |

| T11-X000 | Administrative time limit extension requested | St.27 status event code:U-3-3-T10-T11-oth-X000 | |

| AMND | Amendment | ||

| P11-X000 | Amendment of application requested | St.27 status event code:A-2-2-P10-P11-nap-X000 | |

| P13-X000 | Application amended | St.27 status event code:A-2-2-P10-P13-nap-X000 | |

| E902 | Notification of reason for refusal | ||

| PE0902 | Notice of grounds for rejection | St.27 status event code:A-1-2-D10-D21-exm-PE0902 | |

| AMND | Amendment | ||

| P11-X000 | Amendment of application requested | St.27 status event code:A-2-2-P10-P11-nap-X000 | |

| P13-X000 | Application amended | St.27 status event code:A-2-2-P10-P13-nap-X000 | |

| PX0601 | Decision of rejection after re-examination | St.27 status event code:N-2-6-B10-B17-rex-PX0601 | |

| J201 | Request for trial against refusal decision | ||

| PJ0201 | Trial against decision of rejection | St.27 status event code:A-3-3-V10-V11-apl-PJ0201 | |

| J301 | Trial decision | Free format text:TRIAL NUMBER: 2015101007845; TRIAL DECISION FOR APPEAL AGAINST DECISION TO DECLINE REFUSAL REQUESTED 20151230 Effective date:20170703 | |

| PJ1301 | Trial decision | St.27 status event code:A-3-3-V10-V15-crt-PJ1301 Decision date:20170703 Appeal event data comment text:Appeal Kind Category : Appeal against decision to decline refusal, Appeal Ground Text : 2011 0001522 Appeal request date:20151230 Appellate body name:Patent Examination Board Decision authority category:Office appeal board Decision identifier:2015101007845 | |

| PS0901 | Examination by remand of revocation | St.27 status event code:A-6-3-E10-E12-rex-PS0901 | |

| S901 | Examination by remand of revocation | ||

| GRNO | Decision to grant (after opposition) | ||

| PS0701 | Decision of registration after remand of revocation | St.27 status event code:A-3-4-F10-F13-rex-PS0701 | |

| GRNT | Written decision to grant | ||

| PR0701 | Registration of establishment | St.27 status event code:A-2-4-F10-F11-exm-PR0701 | |

| PR1002 | Payment of registration fee | St.27 status event code:A-2-2-U10-U11-oth-PR1002 Fee payment year number:1 | |

| PG1601 | Publication of registration | St.27 status event code:A-4-4-Q10-Q13-nap-PG1601 | |

| PR1001 | Payment of annual fee | St.27 status event code:A-4-4-U10-U11-oth-PR1001 Fee payment year number:4 | |

| PC1903 | Unpaid annual fee | St.27 status event code:A-4-4-U10-U13-oth-PC1903 Not in force date:20211103 Payment event data comment text:Termination Category : DEFAULT_OF_REGISTRATION_FEE | |

| PC1903 | Unpaid annual fee | St.27 status event code:N-4-6-H10-H13-oth-PC1903 Ip right cessation event data comment text:Termination Category : DEFAULT_OF_REGISTRATION_FEE Not in force date:20211103 |