JP7588467B2 - Processing system and program - Google Patents

Processing system and programDownload PDFInfo

- Publication number

- JP7588467B2 JP7588467B2JP2020047764AJP2020047764AJP7588467B2JP 7588467 B2JP7588467 B2JP 7588467B2JP 2020047764 AJP2020047764 AJP 2020047764AJP 2020047764 AJP2020047764 AJP 2020047764AJP 7588467 B2JP7588467 B2JP 7588467B2

- Authority

- JP

- Japan

- Prior art keywords

- song

- marker

- mixing

- information

- character

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Landscapes

- Electrophonic Musical Instruments (AREA)

Description

Translated fromJapanese本発明は、処理システム及びプログラム等に関する。The present invention relates to a processing system, a program, etc.

従来より、先行楽曲の再生後、先行楽曲の途中から後続楽曲を再生するというように2つの楽曲を連続再生する手法が知られている。例えば特許文献1には、先行楽曲のコマンドコメントと後続楽曲のコマンドコメントとに応じて2つの楽曲を連続再生する再生装置が開示されている。特許文献2には、リスナーの心情や気分を感知して楽曲を自動選択することで、先行楽曲の途中から後続楽曲へと違和感なくスムーズに再生移行する再生装置が開示されている。Conventionally, there have been known techniques for playing two songs consecutively, such as playing a preceding song and then playing a subsequent song from the middle of the preceding song. For example,

先行楽曲から後続楽曲への再生移行の際には、先行楽曲と後続楽曲のミキシングを行うことが望ましい。例えばミキシング期間において、先行楽曲の音量を徐々に小さくしながら、後続楽曲の音量を徐々に大きくすることで、違和感のないスムーズな再生移行を実現できる。そして先行楽曲から後続楽曲へと、ミキシングしながら再生移行するためには、先行楽曲と後続楽曲を接続するための接続情報が必要になる。しかしながら、これまでは、このような接続情報を有効利用する手法や、接続情報を用いた適切でスムーズな再生移行を実現する手法については提案されていなかった。When transitioning from a preceding song to a following song, it is desirable to mix the preceding song and the following song. For example, during the mixing period, a smooth playback transition without any sense of discomfort can be achieved by gradually decreasing the volume of the preceding song while gradually increasing the volume of the following song. And to transition from a preceding song to a following song while mixing, connection information for connecting the preceding song and the following song is required. However, until now, no method has been proposed for effectively utilizing such connection information, or for achieving an appropriate and smooth playback transition using connection information.

本開示によれば、先行楽曲と後続楽曲の接続情報の有効利用や、或いは接続情報を利用した適切でスムーズな楽音の再生移行を実現できる処理システム及びプログラム等を提供できる。The present disclosure provides a processing system and program that can effectively utilize the connection information between the preceding and succeeding songs, or that can realize an appropriate and smooth transition in the playback of musical sounds by utilizing the connection information.

本開示の一態様は、複数の楽曲についての楽曲情報を記憶する楽曲情報記憶部と、マーカー情報を記憶するマーカー情報記憶部と、前記楽曲情報に基づいて楽曲の再生処理を行う音処理部と、キャラクタの動作制御を行うキャラクタ処理部と、前記キャラクタの画像の表示処理を行う表示処理部と、を含み、前記音処理部は、先行楽曲から後続楽曲への切り替えの際に、前記マーカー情報に応じて前記先行楽曲と前記後続楽曲のミキシング処理を行い、前記キャラクタ処理部は、前記先行楽曲から前記後続楽曲への切り替えの際に、前記マーカー情報に応じて前記先行楽曲と前記後続楽曲のミキシング期間での前記キャラクタの動作を制御する処理システムに関係する。また本開示の一態様は、上記各部としてコンピュータを機能させるプログラム、又は該プログラムを記憶したコンピュータ読み取り可能な情報記憶媒体に関係する。One aspect of the present disclosure relates to a processing system that includes a music information storage unit that stores music information for multiple songs, a marker information storage unit that stores marker information, a sound processing unit that performs playback processing of songs based on the music information, a character processing unit that controls the movement of a character, and a display processing unit that performs display processing of an image of the character, where the sound processing unit performs mixing processing of the preceding music and the following music in response to the marker information when switching from the preceding music to the following music, and the character processing unit controls the movement of the character during the mixing period of the preceding music and the following music in response to the marker information when switching from the preceding music to the following music. Another aspect of the present disclosure relates to a program that causes a computer to function as each of the above units, or a computer-readable information storage medium that stores the program.

本開示の一態様によれば、楽曲情報記憶部に記憶される楽曲情報に基づいて楽曲の再生処理が行われると共に、キャラクタの動作制御が行われて、当該キャラクタの画像の表示処理が行われる。そして先行楽曲から後続楽曲への切り替えの際に、マーカー情報に応じた先行楽曲と後続楽曲のミキシング処理が行われると共に、マーカー情報に応じたミキシング期間でのキャラクタの動作制御が行われる。このようにすれば、先行楽曲と後続楽曲の接続情報となるマーカー情報の有効利用を図ったり、或いは先行楽曲と後続楽曲の接続情報となるマーカー情報を利用した適切でスムーズな楽音の再生移行を実現できるようになる。According to one aspect of the present disclosure, a song is played back based on the song information stored in the song information storage unit, and character movement control is performed to display an image of the character. When switching from the preceding song to the following song, a mixing process is performed between the preceding song and the following song according to the marker information, and character movement control is performed during the mixing period according to the marker information. In this way, it is possible to effectively use the marker information that serves as connection information between the preceding song and the following song, or to realize an appropriate and smooth transition in the playback of musical sounds by using the marker information that serves as connection information between the preceding song and the following song.

また本開示の一態様では、前記キャラクタ処理部は、前記先行楽曲と前記後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、外部情報の分析結果、及び楽曲の曲構成の少なくとも1つに応じて、前記キャラクタの動作を変化させてもよい。In one aspect of the present disclosure, the character processing unit may change the behavior of the character in response to at least one of the mixing pattern of the preceding song and the subsequent song, the mix mode for playing multiple songs, the analysis results of external information, and the song structure of the song.

このようにすれば、ミキシングパターン、ミックスモード、外部情報の分析結果、又は楽曲の曲構成に応じてキャラクタの動作が様々に変化するようになり、ミキシングパターン、ミックスモード、外部情報の分析結果、又は曲構成を反映させたキャラクタの動作制御を実現できるようになる。In this way, the character's movements will vary depending on the mixing pattern, mix mode, the results of analysis of external information, or the composition of the song, making it possible to control the character's movements in a way that reflects the mixing pattern, mix mode, the results of analysis of external information, or the composition of the song.

また本開示の一態様では、前記音処理部は、前記キャラクタの情報に基づいて、前記先行楽曲と前記後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、及びミキシングに使用する前記マーカー情報の少なくとも1つを変化させてもよい。In one aspect of the present disclosure, the sound processing unit may change at least one of the mixing pattern of the preceding song and the subsequent song, the mix mode for playing multiple songs, and the marker information used for mixing, based on the character information.

このようにすればキャラクタの情報に応じたミキシングパターン、ミックスモード又はマーカー情報により、先行楽曲と後続楽曲のミキシング処理などを行えるようになり、様々な態様の楽曲ミキシングを実現できるようになる。In this way, mixing processes such as mixing previous and subsequent songs can be performed using mixing patterns, mix modes, or marker information according to character information, making it possible to realize a variety of types of song mixing.

また本開示の一態様では、前記ミキシングパターンは、前記先行楽曲と前記後続楽曲のミキシングにおける音量調整パターン及びイコライザー調整パターンの少なくとも一方の調整パターンであり、前記ミックスモードは、ベーシックミックスモード、ショートミックスモード又はロングミックスモードであってもよい。In one aspect of the present disclosure, the mixing pattern may be at least one of a volume adjustment pattern and an equalizer adjustment pattern in mixing the preceding song and the subsequent song, and the mix mode may be a basic mix mode, a short mix mode, or a long mix mode.

このようにすれば、ミキシングの音量調整パターン又はイコライザー調整パターン、ベーシックミックスモード、ショートミックスモード又はロングミックスモードを反映させたキャラクタの動作制御を実現したり、或いは、音量調整パターン又はイコライザー調整パターン、或いはこれらのミックスモードを、キャラクタの情報に応じて変化させることが可能になる。In this way, it is possible to realize character movement control that reflects the mixing volume adjustment pattern or equalizer adjustment pattern, basic mix mode, short mix mode, or long mix mode, or to change the volume adjustment pattern, equalizer adjustment pattern, or these mix modes according to character information.

また本開示の一態様では、前記マーカー情報記憶部は、前記ミキシング期間の開始タイミングに対応するマーカーの情報と、前記ミキシング期間の終了タイミングに対応するマーカーの情報を記憶してもよい。In one aspect of the present disclosure, the marker information storage unit may store marker information corresponding to the start timing of the mixing period and marker information corresponding to the end timing of the mixing period.

このようにすれば、マーカー情報によりミキシング期間の開始タイミングや終了タイミングを設定して、先行楽曲と後続楽曲のミキシング処理を行ったり、ミキシング期間でのキャラクタの動作を制御できるようになる。In this way, the marker information can be used to set the start and end timing of the mixing period, allowing mixing of the preceding and succeeding songs and control of the character's movements during the mixing period.

また本開示の一態様では、前記マーカー情報のマーカーは、楽曲の曲構成に対応づけられており、前記音処理部は、前記先行楽曲が第j曲構成(jは1以上の整数)であり、前記後続楽曲が第k曲構成(kは1以上の整数)である期間を、前記マーカー情報に基づき特定し、当該期間を前記ミキシング期間として前記ミキシング処理を行ってもよい。In one aspect of the present disclosure, the markers in the marker information may correspond to the song structure of the song, and the sound processing unit may identify a period during which the preceding song is the jth song structure (j is an integer equal to or greater than 1) and the succeeding song is the kth song structure (k is an integer equal to or greater than 1) based on the marker information, and perform the mixing process with that period as the mixing period.

このようにすれば、先行楽曲が第j曲構成であり、後続楽曲が第k曲構成であるときに、第j曲構成と第k曲構成のミキシング処理を行って、再生楽曲を先行楽曲から後続楽曲に切り替えることが可能になる。In this way, when the preceding song has a jth song structure and the succeeding song has a kth song structure, it is possible to perform a mixing process of the jth song structure and the kth song structure, and switch the song being played from the preceding song to the succeeding song.

また本開示の一態様では、前記マーカー情報記憶部は、楽曲が第1ジャンルである場合には、第1設定パターンで楽曲の曲構成に対してマーカーが設定され、楽曲が第2ジャンルである場合には、前記第1設定パターンとは異なる第2設定パターンで楽曲の曲構成に対してマーカーが設定される前記マーカー情報を記憶してもよい。In one aspect of the present disclosure, the marker information storage unit may store the marker information in which, if the song is in a first genre, markers are set for the song structure in a first setting pattern, and, if the song is in a second genre, markers are set for the song structure in a second setting pattern different from the first setting pattern.

このようにすれば、楽曲のジャンルに応じて異なる設定パターンで楽曲の曲構成に設定されるマーカーの情報に応じて、先行楽曲と後続楽曲のミキシング処理を行ったり、ミキシング期間でのキャラクタの動作制御を行うことが可能になる。In this way, it becomes possible to mix the previous and subsequent songs and control the character's movements during the mixing period according to the marker information that is set in the song's composition in different setting patterns depending on the genre of the song.

また本開示の一態様は、複数の楽曲についての楽曲情報を記憶する楽曲情報記憶部と、マーカー情報を記憶するマーカー情報記憶部と、前記楽曲情報に基づいて楽曲の再生処理を行う音処理部と、を含み、前記マーカー情報記憶部は、楽曲が第1ジャンルである場合には、第1設定パターンで楽曲の曲構成に対してマーカーが設定され、楽曲が第2ジャンルである場合には、前記第1設定パターンとは異なる第2設定パターンで楽曲の曲構成に対してマーカーが設定される前記マーカー情報を記憶し、前記音処理部は、先行楽曲から後続楽曲への切り替えの際に、前記マーカー情報に応じて設定されるミキシング期間において、前記先行楽曲と前記後続楽曲のミキシング処理を行う処理システムに関係する。また本開示の一態様は、上記各部としてコンピュータを機能させるプログラム、又は該プログラムを記憶したコンピュータ読み取り可能な情報記憶媒体に関係する。An aspect of the present disclosure relates to a processing system that includes a music information storage unit that stores music information for multiple music pieces, a marker information storage unit that stores marker information, and a sound processing unit that performs playback processing of music based on the music information, and the marker information storage unit stores the marker information in which markers are set for the music structure of a music piece in a first setting pattern when the music piece is in a first genre, and in which markers are set for the music structure of a music piece in a second setting pattern different from the first setting pattern when the music piece is in a second genre, and the sound processing unit performs mixing processing of the preceding music piece and the following music piece during a mixing period that is set according to the marker information when switching from the preceding music piece to the following music piece. Another aspect of the present disclosure relates to a program that causes a computer to function as each of the above-mentioned units, or a computer-readable information storage medium that stores the program.

本開示の一態様によれば、楽曲情報記憶部に記憶される楽曲情報に基づいて楽曲の再生処理が行われる。そして楽曲のジャンルに応じて異なった設定パターンでマーカー情報が設定されており、当該マーカーの情報に応じて設定されるミキシング期間において、先行楽曲と後続楽曲のミキシング処理が行われる。従って、先行楽曲と後続楽曲の接続情報であるマーカー情報を利用して適切でスムーズな楽音の再生移行を実現できるようになる。According to one aspect of the present disclosure, music playback processing is performed based on music information stored in a music information storage unit. Marker information is set in different setting patterns depending on the genre of the music, and mixing processing of the preceding music and the following music is performed during a mixing period set according to the marker information. Therefore, it is possible to realize an appropriate and smooth transition of musical sound playback by utilizing the marker information, which is connection information between the preceding music and the following music.

また本開示の一態様では、前記先行楽曲の音波形と、前記後続楽曲の音波形と、前記マーカー情報のマーカーのタイミングを、ユーザが視覚的に認識するための表示処理を行う表示処理部を含んでもよい。In one aspect of the present disclosure, the device may also include a display processing unit that performs display processing to allow a user to visually recognize the sound waveform of the preceding song, the sound waveform of the subsequent song, and the timing of the markers in the marker information.

このような表示処理を行えば、ユーザは、先行楽曲、後続楽曲の音波形や、マーカーの画像を見ることで、先行楽曲から後続楽曲への切り替え操作や、或いは先行楽曲と後続楽曲のミキシングの操作を容易に行えるようになる。By performing this type of display processing, the user can easily switch from the preceding song to the following song, or mix the preceding song and the following song, by looking at the sound waveforms of the preceding and following songs and the marker images.

また本開示の一態様では、前記音処理部は、ユーザのミキシング操作のタイミングと前記マーカー情報のマーカーのタイミングとのズレ量が所定の範囲内である場合に、前記マーカーのタイミングに合うように前記ミキシング操作のタイミングを補正する処理を行ってもよい。In one aspect of the present disclosure, when the amount of deviation between the timing of the user's mixing operation and the timing of the marker in the marker information is within a predetermined range, the sound processing unit may perform a process of correcting the timing of the mixing operation to match the timing of the marker.

このようにすれば、ユーザの技量が足りなくて、ユーザの操作が適切なタイミングで行われなかった場合にも、マーカーにより設定されるタイミングで楽曲のミキシングや切り替えを行うことが可能になる。In this way, even if a user lacks the skill to perform operations at the appropriate time, it is possible to mix or switch songs at the timing set by the markers.

また本開示の一態様では、前記音処理部は、ユーザのミキシング操作のタイミングとマーカーのタイミングとのズレ量に基づいて、ユーザのミキシング操作の評価処理を行ってもよい。In one aspect of the present disclosure, the sound processing unit may perform an evaluation process of the user's mixing operation based on the amount of deviation between the timing of the user's mixing operation and the timing of the marker.

このようにすれば、マーカーを見ながらユーザがミキシング操作を行った場合に、そのミキシング操作のタイミングが適切なタイミングであったか否かを評価できるようになり、ミキシング操作を行うことの面白味をユーザに与えることが可能になる。In this way, when a user performs a mixing operation while looking at the markers, it becomes possible to evaluate whether the timing of the mixing operation was appropriate or not, making it possible to provide the user with the fun of performing a mixing operation.

また本開示の一態様では、前記マーカー情報記憶部は、楽曲が前記先行楽曲であるときのミキシング開始の許可タイミングを設定する第1マーカーの情報と、楽曲が前記先行楽曲であるときのミキシング終了タイミングを設定する第2マーカーの情報と、楽曲が前記後続楽曲であるときのミキシング開始の許可タイミングを設定する第3マーカーの情報と、楽曲が前記後続楽曲であるときのミキシング終了タイミングを設定する第4マーカーの情報を記憶してもよい。In one aspect of the present disclosure, the marker information storage unit may store information on a first marker that sets the timing at which mixing is permitted to start when the song is the preceding song, information on a second marker that sets the timing at which mixing is permitted to end when the song is the preceding song, information on a third marker that sets the timing at which mixing is permitted to start when the song is the following song, and information on a fourth marker that sets the timing at which mixing is permitted to end when the song is the following song.

このような第1マーカー、第2マーカー、第3マーカー、第4マーカーの情報を用いることで、先行楽曲と後続楽曲のミキシング期間を適切に設定して、先行楽曲と後続楽曲をミキシングしながら、先行楽曲から後続楽曲に切り替える再生移行を実現できるようになる。By using the information of the first, second, third, and fourth markers, it is possible to appropriately set the mixing period of the preceding song and the following song, and realize a playback transition from the preceding song to the following song while mixing the preceding song and the following song.

また本開示の一態様では、前記音処理部は、前記先行楽曲の前記第2マーカーと前記後続楽曲の前記第4マーカーとに基づいて、前記後続楽曲の再生開始タイミングを決定し、前記先行楽曲の前記第1マーカーと前記後続楽曲の前記第3マーカーに基づいて、前記ミキシング処理の開始タイミングを決定してもよい。In one aspect of the present disclosure, the sound processing unit may determine a timing for starting playback of the subsequent song based on the second marker of the preceding song and the fourth marker of the subsequent song, and may determine a timing for starting the mixing process based on the first marker of the preceding song and the third marker of the subsequent song.

このようにすれば、第1マーカー~第4マーカーの情報を用いて、ミキシング期間の開始タイミングや終了タイミングを決定して、当該ミキシング期間において先行楽曲と後続楽曲のミキシング処理を行いながら、先行楽曲から後続楽曲に切り替える再生移行を実現できるようになる。In this way, the start and end timings of the mixing period can be determined using the information from the first to fourth markers, and a playback transition can be realized in which the preceding song is switched to the following song while mixing the preceding song and the following song during the mixing period.

また本開示の一態様では、前記マーカー情報記憶部は、第1ミックスモードで使用される前記第1~第4マーカーの第1マーカーセットの情報と、第2ミックスモードで使用される前記第1~第4マーカーの第2マーカーセットの情報を記憶し、前記音処理部は、前記第1ミックスモードでは、前記第1マーカーセットの情報に応じて設定される前記ミキシング期間において前記ミキシング処理を行い、前記第2ミックスモードでは、前記第2マーカーセットの情報に応じて設定される前記ミキシング期間において前記ミキシング処理を行ってもよい。In one aspect of the present disclosure, the marker information storage unit stores information on a first marker set of the first to fourth markers used in a first mix mode and information on a second marker set of the first to fourth markers used in a second mix mode, and the sound processing unit performs the mixing process in the first mix mode during the mixing period set according to the information on the first marker set, and performs the mixing process in the second mix mode during the mixing period set according to the information on the second marker set.

このようにすれば、ベーシックミックスモード、ショートミックスモード又はロングミックスモードなどのミックスモードが設定された場合に、楽曲に設定される複数のマーカーセットの中から、設定されたミックスモードに対応するマーカーセットを用いることで、当該ミックスモードに適切なマーカーを用いてミキシング処理を行えるようになる。In this way, when a mix mode such as basic mix mode, short mix mode, or long mix mode is set, the marker set corresponding to the set mix mode from among multiple marker sets set for the song is used, and mixing processing can be performed using markers appropriate for that mix mode.

以下、本実施形態について説明する。なお、以下に説明する本実施形態は、特許請求の範囲の記載内容を不当に限定するものではない。また本実施形態で説明される構成の全てが、必須構成要件であるとは限らない。The present embodiment will be described below. Note that the present embodiment described below does not unduly limit the contents of the claims. Furthermore, not all of the configurations described in the present embodiment are necessarily essential components.

1.処理システム

図1は、本実施形態の処理システム(情報処理装置、アトラクション用装置、ゲーム装置)の構成例を示すブロック図である。なお、本実施形態の処理システムは図1の構成に限定されず、その構成要素の一部を省略したり、他の構成要素を追加するなどの種々の変形実施が可能である。 1. Processing System Fig. 1 is a block diagram showing an example of the configuration of a processing system (information processing device, attraction device, game device) according to this embodiment. Note that the processing system according to this embodiment is not limited to the configuration shown in Fig. 1, and various modifications are possible, such as omitting some of the components or adding other components.

操作部160は、ユーザ(オペレータ、プレーヤ)が種々の操作情報(入力情報)を入力するためのものである。操作部160は、例えばキーボード、操作ボタン、方向指示キー、ジョイスティック、レバー又はタッチパネル型ディスプレイ等により実現できる。The

記憶部170は各種の情報を記憶する。記憶部170は、処理部100や通信部196などのワーク領域として機能する。プログラムや、プログラムの実行に必要なデータは、この記憶部170に保持される。記憶部170の機能は、半導体メモリ(DRAM、VRAM)、HDD(hard disk drive)、SSD(Solid State Drive)、又は光ディスク装置などにより実現できる。記憶部170は、楽曲情報記憶部172、マーカー情報記憶部174、モーションデータ記憶部175、キャラクタ情報記憶部176、オブジェクト情報記憶部177、描画バッファ178を含む。楽曲情報記憶部172は再生対象となる楽曲の情報を記憶する。例えば楽曲のサウンドデータや、ジャンル、アーティスト名又はアルバム名などの付加データを記憶する。マーカー情報記憶部174はマーカーについての各種の情報を記憶する。例えば楽曲に対するマーカーの設定パターン等の設定情報を楽曲に関連づけて記憶する。モーションデータ記憶部175は、キャラクタ等のモデルオブジェクトのモーション再生処理を行うためのモーションデータを記憶する。モーション再生処理はアニメーション処理とも呼ばれる。キャラクタ情報記憶部176は、キャラクタについての種々の情報を記憶する。例えばキャラクタのレベル又は能力等のパラメータの情報や、キャラクタの性格などの属性や状態を表す情報を記憶する。オブジェクト情報記憶部177は、キャラクタなどのモデルオブジェクトを構成するオブジェクトや仮想空間を構成するオブジェクトについての各種の情報(形状情報、位置情報等)を記憶する。描画バッファ178は、フレームバッファ、ワークバッファ等のピクセル単位で画像情報を記憶できるバッファである。The

情報記憶媒体180は、コンピュータにより読み取り可能な媒体であり、プログラムやデータなどを格納するものである。情報記憶媒体180は、光ディスク(DVD、BD、CD)、HDD、或いは半導体メモリ(ROM)などにより実現できる。処理部100は、情報記憶媒体180に格納されるプログラム(データ)に基づいて本実施形態の種々の処理を行う。即ち情報記憶媒体180には、本実施形態の各部としてコンピュータ(入力装置、処理部、記憶部、出力部を備える装置)を機能させるためのプログラム(各部の処理をコンピュータに実行させるためのプログラム)が記憶される。The

表示部190は、本実施形態により生成された画像を出力するものであり、その機能は、LCD、有機ELディスプレイ、CRT、タッチパネル型ディスプレイ、或いはHMD(Head Mounted Display)などにより実現できる。音出力部192は、本実施形態により生成された音を出力するものであり、その機能は、スピーカ又はヘッドホン等により実現できる。The

I/F部194(インターフェース部)は、携帯型情報記憶媒体195とのインターフェース処理を行うものであり、その機能はI/F処理用のASICなどにより実現できる。携帯型情報記憶媒体195は、ユーザが各種の情報を保存するためのものであり、電源が非供給になった場合にもこれらの情報の記憶を保持する記憶装置である。携帯型情報記憶媒体195は、ICカード(メモリカード)、USBメモリ、或いは磁気カードなどにより実現できる。The I/F unit 194 (interface unit) performs interface processing with the portable

通信部196は、有線や無線のネットワークを介して外部(他の装置)との間で通信を行うものであり、その機能は、通信用ASIC又は通信用プロセッサなどのハードウェアや、通信用ファームウェアにより実現できる。The

なお本実施形態の各部としてコンピュータを機能させるためのプログラム(データ)は、サーバ(ホスト装置)が有する情報記憶媒体からネットワーク及び通信部196を介して情報記憶媒体180(或いは記憶部170)に配信してもよい。このようなサーバによる情報記憶媒体の使用も本実施形態の範囲内に含めることができる。The programs (data) for causing a computer to function as each part of this embodiment may be distributed from an information storage medium held by a server (host device) to information storage medium 180 (or storage unit 170) via a network and

処理部100(プロセッサ)は、操作部160からの操作入力情報やプログラムなどに基づいて、音処理、キャラクタ処理、或いは表示処理などを行う。The processing unit 100 (processor) performs sound processing, character processing, display processing, etc. based on operation input information from the

処理部100の各部が行う本実施形態の各処理はプロセッサ(ハードウェアを含むプロセッサ)により実現できる。例えば本実施形態の各処理は、プログラム等の情報に基づき動作するプロセッサと、プログラム等の情報を記憶するメモリにより実現できる。プロセッサは、例えば各部の機能が個別のハードウェアで実現されてもよいし、或いは各部の機能が一体のハードウェアで実現されてもよい。例えば、プロセッサはハードウェアを含み、そのハードウェアは、デジタル信号を処理する回路及びアナログ信号を処理する回路の少なくとも一方を含むことができる。例えば、プロセッサは、回路基板に実装された1又は複数の回路装置(例えばIC等)や、1又は複数の回路素子(例えば抵抗、キャパシター等)で構成することもできる。プロセッサは、例えばCPU(Central Processing Unit)であってもよい。但し、プロセッサはCPUに限定されるものではなく、GPU(Graphics Processing Unit)、或いはDSP(Digital Signal Processor)等、各種のプロセッサを用いることが可能である。またプロセッサはASICによるハードウェア回路であってもよい。またプロセッサは、アナログ信号を処理するアンプ回路やフィルター回路等を含んでもよい。メモリ(記憶部170)は、SRAM、DRAM等の半導体メモリであってもよいし、レジスターであってもよい。或いはハードディスク装置(HDD)等の磁気記憶装置であってもよいし、光学ディスク装置等の光学式記憶装置であってもよい。例えば、メモリはコンピュータにより読み取り可能な命令を格納しており、当該命令がプロセッサにより実行されることで、処理部100の各部の処理が実現されることになる。ここでの命令は、プログラムを構成する命令セットでもよいし、プロセッサのハードウェア回路に対して動作を指示する命令であってもよい。Each process of the present embodiment performed by each part of the

処理部100は、音処理部102、キャラクタ処理部110、表示処理部120を含む。上述したように、これらの各部により実行される本実施形態の各処理は、プロセッサ(或いはプロセッサ及びメモリ)により実現できる。なお、これらの構成要素(各部)の一部を省略したり、他の構成要素を追加するなどの種々の変形実施が可能である。The

音処理部102は種々の音処理を行う。例えば音処理部102は楽曲の再生処理を行う。或いは音処理部102は、サウンドデータに対するフィルター処理などのデジタル信号処理や、音声解析処理などの音の解析処理や、或いは音に関する種々の判断処理を行ってもよい。The

キャラクタ処理部110は、キャラクタについての種々の処理を行う。例えばキャラクタ処理部110は、オブジェクト空間である仮想空間において、モデルオブジェクトであるキャラクタを動作させる処理を行う。例えばキャラクタ処理部110は、モーションデータ記憶部175に記憶されるモーションデータに基づいてキャラクタを動作させる処理を行う。モーションデータに基づくモーション再生処理はアニメーション処理とも呼ばれる。例えばキャラクタ処理部110は、プログラム(移動・動作アルゴリズム)や、各種データ(モーションデータ、キャラクタ情報)などに基づいて、キャラクタを仮想空間内で動作(モーション、アニメーション)させたり、移動させる制御処理を行う。具体的には、キャラクタの動作情報(パーツオブジェクトの位置、或いは回転角度)や、移動情報(位置、回転角度、速度、或いは加速度)を、1フレーム(例えば1/60秒)毎に順次求めるシミュレーション処理を行う。なおフレームは、キャラクタの動作処理や画像生成処理を行う時間の単位である。The

表示処理部120は、表示部190に画像を表示するための処理を行う。例えば処理部100で行われる種々の処理の結果に基づいて描画処理を行い、これにより画像を生成し、表示部190に表示する。具体的には、座標変換(ワールド座標変換、カメラ座標変換)、クリッピング処理、透視変換、或いは光源処理等のジオメトリ処理が行われ、その処理結果に基づいて、描画データ(プリミティブ面の頂点の位置座標、テクスチャ座標、色データ、法線ベクトル或いはα値等)が作成される。そして、この描画データ(プリミティブ面データ)に基づいて、透視変換後(ジオメトリ処理後)のオブジェクト(1又は複数プリミティブ面)を、描画バッファ178(フレームバッファ、ワークバッファ等のピクセル単位で画像情報を記憶できるバッファ)に描画する。これにより、仮想空間において仮想カメラから見える画像が生成される。なお、表示処理部120で行われる描画処理は、頂点シェーダ処理やピクセルシェーダ処理等により実現することができる。The

例えば本実施形態では、処理部100は、ゲーム処理、仮想空間設定処理、仮想カメラ設定処理、移動体処理などを行うことができる。ゲーム処理は、例えば、ゲーム開始条件が満たされた場合にゲームを開始する処理、開始したゲームを進行させる処理、ゲーム終了条件が満たされた場合にゲームを終了する処理、或いはゲーム成績を演算する処理などである。仮想空間設定処理は、例えば、移動体(車、人、ロボット、電車、飛行機、船、モンスター又は動物等)、マップ(地形)、建物、観客席、コース(道路)、アイテム、樹木、壁、水面などの表示物を表す各種オブジェクト(ポリゴン、自由曲面又はサブディビジョンサーフェイスなどのプリミティブ面で構成されるオブジェクト)を仮想空間に配置設定する処理である。例えば仮想空間設定処理では、ワールド座標系でのオブジェクトの位置や回転角度(向き、方向と同義)を決定し、その位置(X、Y、Z)にその回転角度(X、Y、Z軸回りでの回転角度)でオブジェクトを配置する処理が行われる。具体的には、記憶部170のオブジェクト情報記憶部177には、仮想空間でのオブジェクト(パーツオブジェクト)の位置、回転角度、移動速度又は移動方向等の情報であるオブジェクト情報がオブジェクト番号に対応づけて記憶される。仮想空間設定処理では、例えば各フレーム毎に、仮想空間情報であるオブジェクト情報の更新処理が行われる。また仮想カメラ設定処理は、仮想空間での仮想カメラの位置や方向を設定する処理である。例えば仮想カメラ設定処理では、キャラクタなどの移動体の位置や方向の情報や、或いは仮想カメラの位置や方向の設定情報に基づいて、仮想空間での仮想カメラの位置や方向を設定する処理が行われる。移動体処理は、仮想空間での移動体の移動情報を演算する処理である。例えば移動体処理では、仮想空間において移動体を移動させるための処理が行われる。また処理部100は、音の生成処理を行う。例えば処理部100での種々の処理の結果に基づいて音の生成処理を行う。具体的には、楽曲、効果音、又は音声などを生成し、音出力部192に出力させる。For example, in this embodiment, the

そして本実施形態の処理システムは、図1に示すように、楽曲情報記憶部172と、マーカー情報記憶部174と、音処理部102と、キャラクタ処理部110と、表示処理部120を含む。As shown in FIG. 1, the processing system of this embodiment includes a music

楽曲情報記憶部172は楽曲情報を記憶する。例えば複数の楽曲についての楽曲情報を記憶する。例えば楽曲情報記憶部172は、再生対象となる複数の楽曲についての楽曲情報を記憶する。楽曲情報は、例えば楽曲のサウンドデータである。或いは楽曲情報は、ジャンル、アーティスト名又はアルバム名などの付加データを含んでもよい。この楽曲情報に基づいて、楽曲の再生処理が行われる。The music

マーカー情報記憶部174は、マーカー情報を記憶する。マーカー情報は、例えば先行楽曲から後続楽曲に切り替える際のタイミングを設定する情報である。例えばマーカー情報のマーカーは、先行楽曲から後続楽曲への切り替えタイミングの目印となるものである。具体的にはマーカー情報は、先行楽曲と後続楽曲のミキシング期間を設定する情報である。例えばマーカー情報のマーカーは、ミキシング期間のタイミングの目印となるものである。先行楽曲は、現在の楽曲から次の楽曲に切り替える再生移行において、先行する楽曲であり、後続楽曲は、先行楽曲に続く次の楽曲である。The marker

キャラクタ処理部110はキャラクタの動作制御を行う。例えばキャラクタ処理部110は、キャラクタの動作制御としてキャラクタのモーションを再生するモーション再生処理を行う。モーション再生処理は、モデルオブジェクトのスケルトンの姿勢を変化させて、モデルオブジェクトを動かすための処理であり、アニメーション処理とも呼ばれる。具体的にはキャラクタ処理部110は、モーションデータ記憶部175に記憶されたモーションデータに基づいてキャラクタのモーション処理を行う。モーションデータは、例えばキャラクタの動作を演じる演者の動作のモーションキャプチャを行うことで取得できる。モーションキャプチャの方式としては、光学式、慣性センサ式、機械式、磁気式などの種々の方式がある。モーションデータは、キャラクタ(演者)に対応するスケルトンの姿勢を規定するものであり、スケルトンは、複数の関節や、関節で規定される骨により構成され、階層構造である親子構造を有する。具体的にはモーションデータは、親の骨に対する子の骨の、X軸、Y軸、Z軸回りの回転角度α、β、γなどの情報を含むことができる。或いはモーションデータは、X軸方向、Y軸方向、Z軸方向での骨のスケーリング率などの情報を含んでもよい。例えばモーションデータは、回転角度α、β、γ等が行列要素となる行列情報などにより実現される。The

表示処理部120は、キャラクタの画像の表示処理を行う。例えば表示処理部120は、3次元のモデルオブジェクトであるキャラクタのレンダリング処理を行い、オブジェクト空間である仮想空間において仮想カメラから見える画像であって、キャラクタの画像を含む仮想空間画像を生成する。The

そして音処理部102は、先行楽曲から後続楽曲への切り替えの際に、マーカー情報に応じて先行楽曲と後続楽曲のミキシング処理を行う。例えば音処理部102は、マーカー情報に応じたミキシング期間を設定し、設定されたミキシング期間において先行楽曲と後続楽曲のミキシング処理を行う。例えばミキシング期間の開始タイミングに対応するマーカーと、ミキシング期間の終了タイミングに対応するマーカーが、先行楽曲や後続楽曲に設定されており、これらのマーカーを用いてミキシング期間が特定される。そして音処理部102は、これらのマーカーで特定されたミキシング期間において、先行楽曲と後続楽曲のミキシング処理を行う。ミキシング処理では、ミキシング期間において、例えば先行楽曲の音量を徐々に小さくしながら後続楽曲の音量を徐々に大きくする音量調整が行われる。例えばミキシング期間の開始タイミングでは、後続楽曲の音量は例えばゼロであり、先行楽曲だけが再生出力される状態になっている。そしてミキシング期間の終了タイミングでは、先行楽曲の音量が例えばゼロになり、後続楽曲だけが再生出力される状態になる。またミキシング期間においては、例えば低周波数帯域などの特定の周波数帯域を減衰したり或いは増幅するイコライザー調整が行われる。例えばミキシング期間が開始してから所定期間の間は、後続楽曲の低周波数帯域を減衰したままの状態にし、ミキシング期間の終了タイミング又は終了タイミングを含む短い期間において、後続楽曲の低周波数帯域を増幅して元に戻すというようなイコライザー調整が行われる。Then, the

そしてキャラクタ処理部110は、先行楽曲から後続楽曲への切り替えの際に、マーカー情報に応じて先行楽曲と後続楽曲のミキシング期間でのキャラクタの動作を制御する。例えばキャラクタ処理部110は、マーカー情報により設定されるミキシング期間において、ミキシング用の動作を行うようにキャラクタの動作を制御する。例えばキャラクタ処理部110は、マーカー情報に応じてミキシング期間を設定し、設定されたミキシング期間において、ミキシング用の動作を行うようにキャラクタの動作を制御する。具体的には、ミキシング期間の開始タイミングに対応するマーカーと、ミキシング期間の終了タイミングに対応するマーカーが先行楽曲や後続楽曲に設定され、キャラクタ処理部110は、これらのマーカーを用いてミキシング期間を特定して、キャラクタの動作を制御する。例えばキャラクタ処理部110は、ミキシング期間において行われる音処理部102のミキシング処理に連動して、キャラクタの動作を制御する。例えばミキシング用のモーションでキャラクタを動作させる。例えばキャラクタ処理部110は、キャラクタのモーションの補正を行うことで、ミキシング用のモーションでキャラクタを動作させる。具体的には、キャラクタの手がミキシング操作を行うように、キャラクタのモーション補正を行う。ミキシング操作は、例えばフェーダーの操作又はイコライザーの操作などである。一例としては、キャラクタの手(指)が、ミキシング操作を行うように、キャラクタの手を動かすためのインバースキネマティクス処理を行うことで、ミキシング用のモーションをキャラクタに行わせる。Then, when switching from the preceding song to the subsequent song, the

またキャラクタ処理部110は、先行楽曲と後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、外部情報の分析結果、及び楽曲の曲構成の少なくとも1つに応じて、キャラクタの動作を変化させる。例えばミキシングパターンが第1ミキシングパターンである場合には、第1ミキシングパターンに対応するモーションパターンで、キャラクタを動作させ、ミキシングパターンが第2ミキシングパターンである場合には、第2ミキシングパターンに対応するモーションパターンで、キャラクタを動作させる。また複数の楽曲を再生する際におけるミックスモードが、第1ミックスモードである場合には、第1ミックスモードに対応するモーションパターンで、キャラクタを動作させ、ミックスモードが第2ミックスモードである場合には、第2ミックスモードに対応するモーションパターンで、キャラクタを動作させる。或いは処理システムが外部情報を取得して外部情報の分析を行い、キャラクタ処理部110は、この外部情報の分析結果に基づいて、キャラクタの動作を変化させる。外部情報の分析結果は、例えばインターネット投票の分析結果、歓声などの外部環境の音声の分析結果、或いは観客の動きの分析結果などである。また楽曲の曲構成が第1曲構成である場合には、第1曲構成に対応するモーションパターンで、キャラクタを動作させ、楽曲の曲構成が第2曲構成である場合には、第2曲構成に対応するモーションパターンで、キャラクタを動作させる。The

また音処理部102は、キャラクタの情報に基づいて、先行楽曲と後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、及びミキシングに使用するマーカー情報の少なくとも1つを変化させる。キャラクタの情報は例えばキャラクタに対して設定された判断条件の情報である。例えば音処理部102は、キャラクタの情報が第1情報である場合には、第1ミキシングパターンで先行楽曲と後続楽曲のミキシング処理を行い、キャラクタの情報が第1情報から第2情報に変化すると、第2ミキシングパターンで先行楽曲と後続楽曲のミキシング処理を行う。また音処理部102は、キャラクタの情報が第1情報である場合には、第1ミックスモードで複数の楽曲再生を行い、キャラクタの情報が第1情報から第2情報に変化すると、第2ミックスモードで複数の楽曲再生を行う。また音処理部102は、キャラクタの情報が第1情報である場合には、ミキシング処理や表示処理に使用するマーカー情報として、第1タイプのマーカー情報を使用し、キャラクタの情報が第1情報から第2情報に変化すると、第2タイプのマーカー情報を使用する。キャラクタの情報は、例えばキャラクタのレベル又は能力のパラメータや、キャラクタに設定された動作アルゴリズムなどのアルゴリズムの情報や、キャラクタの性格又は属性などの情報である。キャラクタの能力は例えばキャラクタのリズム感の能力、演奏テクニックの能力又はその場対応能力などであり、例えばDJとして能力である。キャラクタの情報は、例えばキャラクタに対して予め設定されており、例えばキャラクタに対応づけてキャラクタ情報記憶部176に記憶される。The

またミキシングパターンは、先行楽曲と後続楽曲のミキシングにおける音量調整パターン及びイコライザー調整パターンの少なくとも一方の調整パターンである。音量調整パターンは、例えばミキシングにおけるフェーダーによる音量調整パターンである。例えば音量調整のパターンは、ミキシング期間における先行楽曲や後続楽曲の音量の調整度合いや音量カープのパターンである。イコライザー調整パターンは、例えばミキシングにおけるイコライザーの調整パターンである。例えばイコライザー調整のパターンは、イコライザーによる低音、中音又は高音などの各周波数帯域の成分の調整度合いや調整カーブのパターンである。The mixing pattern is at least one of a volume adjustment pattern and an equalizer adjustment pattern when mixing a preceding song and a following song. The volume adjustment pattern is, for example, a volume adjustment pattern using a fader in mixing. For example, a volume adjustment pattern is a pattern of the degree of volume adjustment or volume curve of the preceding song and the following song during the mixing period. The equalizer adjustment pattern is, for example, an equalizer adjustment pattern in mixing. For example, an equalizer adjustment pattern is a pattern of the degree of adjustment or adjustment curve of components of each frequency band such as bass, midrange, or treble by the equalizer.

またミックスモードは、ベーシックミックスモード、ショートミックスモード又はロングミックスモードである。ショートミックスモードは、ベーシックミックスモードに比べて、先行楽曲に対して早いタイミングで後続楽曲をミキシングするミックスモードである。例えばショートミックスモードは、所定の演奏時間内における楽曲の演奏曲数が、ベーシックミックスモードに比べて多くなるミックスモードである。ロングミックスモードは、ベーシックミックスモードに比べて、先行楽曲に対して遅いタイミングで後続楽曲をミキシングするミックスモードである。例えばロングミックスモードは、所定の演奏時間内における楽曲の演奏曲数が、ベーシックミックスモードに比べて少なくなるミックスモードである。なおミックスモードの設定は、複数の楽曲に対して一括で行われてもよいし、楽曲ごとに変えてミックスモードを設定してもよい。例えばベーシックミックスモード用の第1楽曲群、ショートミックスモード用の第2楽曲群、ロングミックスモード用の第3楽曲群を用意して、これらの楽曲情報を楽曲情報記憶部172に記憶してもよい。またミックスモードの設定は、処理システムが自動的に行ってもよいし、ユーザが操作部160などを用いて設定してもよい。The mix mode may be a basic mix mode, a short mix mode, or a long mix mode. The short mix mode is a mix mode in which the following music piece is mixed at an earlier timing than the basic mix mode with respect to the preceding music piece. For example, the short mix mode is a mix mode in which the number of music pieces played within a given performance time is greater than that of the basic mix mode. The long mix mode is a mix mode in which the following music piece is mixed at a later timing than that of the basic mix mode with respect to the preceding music piece. For example, the long mix mode is a mix mode in which the number of music pieces played within a given performance time is less than that of the basic mix mode. The mix mode may be set for multiple music pieces at once, or may be set differently for each music piece. For example, a first music piece group for the basic mix mode, a second music piece group for the short mix mode, and a third music piece group for the long mix mode may be prepared, and information on these music pieces may be stored in the music

またマーカー情報記憶部174は、ミキシング期間の開始タイミングに対応するマーカーの情報と、ミキシング期間の終了タイミングに対応するマーカーの情報を記憶する。ミキシング期間の開始タイミングに対応するマーカーは、例えば当該開始タイミングに対応づけられるマーカーであり、例えばミキシング期間の開始タイミングを設定するマーカーであってもよいし、ミキシング開始の許可タイミングを設定するマーカーであってもよい。ミキシング期間の終了タイミングに対応するマーカーは、例えば当該終了タイミングに対応づけられるマーカーであり、ミキシング期間の終了タイミングを設定するマーカーである。或いはミキシング終了の許可タイミングを設定するマーカーであってもよい。The marker

またマーカー情報のマーカーは、楽曲の曲構成に対応づけられている。例えば楽曲が第1曲構成~第m曲構成(mは2以上の整数)を有する場合に、マーカーは、例えば第1曲構成~第m曲構成のうちの第i曲構成(1≦i≦m)に対応づけられている。例えばマーカーは、曲構成の先頭タイミング、終了タイミング又は途中タイミングに対応づけられている。なおマーカーは例えば小節単位で設定される。また楽曲の曲構成に対して、楽曲が先行楽曲である場合のマーカーと、楽曲が後続楽曲である場合のマーカーを対応づけてもよい。曲構成は、例えば2小節、4小節、8小節、16小節又は32小節などの複数小節を1つのブロックとするものであり、楽曲は、このブロックである曲構成が複数個連なることで構成される。曲構成としては、例えばイントロ、イントロコーラス、ビルドアップ、ドロップ、ブレーク、コーラス、バース、Aメロ、Bメロ又はアウトロなどの種々の構成がある。そして音処理部102は、先行楽曲が第j曲構成(jは1以上の整数)であり、後続楽曲が第k曲構成(kは1以上の整数)である期間を、マーカー情報に基づき特定し、当該期間をミキシング期間としてミキシング処理を行う。例えば先行楽曲用のマーカーが先行楽曲の第j曲構成に設定されており、後続楽曲用のマーカーが後続楽曲の第k曲構成に設定されている場合に、音処理部102は、これらのマーカーに基づいてミキシング期間を特定する。先行楽曲用のマーカーとしては、例えば先行楽曲の第j曲構成の開始タイミングに対応するマーカーや、第j曲構成の終了タイミングに対応するマーカーなど想定できる。また後続楽曲用のマーカーとしては、例えば後続楽曲の第k曲構成の開始タイミングに対応するマーカーや、第k曲構成の終了タイミングに対応するマーカーなどを想定できる。そして音処理部102は、これらのマーカーを用いてミキシング期間を設定して、先行楽曲と後続楽曲のミキシング処理を行う。例えば先行楽曲の第j曲構成と後続楽曲の第k曲構成は、両者の曲構成同士をミキシングしても違和感や不自然さが少ない曲構成として、例えば楽曲のジャンルに応じて特定されている曲構成である。The markers in the marker information are also associated with the song structure of the music. For example, if a song has a first song structure to an mth song structure (m is an integer of 2 or more), the markers are associated with, for example, the i-th song structure (1≦i≦m) of the first song structure to the mth song structure. For example, the markers are associated with the beginning timing, end timing, or middle timing of the song structure. The markers are set, for example, in units of bars. Also, for the song structure of a song, markers when the song is a preceding song and markers when the song is a following song may be associated with each other. A song structure is a block of multiple bars, such as 2 bars, 4 bars, 8 bars, 16 bars, or 32 bars, and a song is composed of multiple song structures that are blocks. There are various song structures, such as an intro, intro chorus, build-up, drop, break, chorus, verse, A melody, B melody, or outro. The

また本実施形態の処理システムは、複数の楽曲についての楽曲情報を記憶する楽曲情報記憶部172と、マーカー情報を記憶するマーカー情報記憶部174と、楽曲情報に基づいて楽曲の再生処理を行う音処理部102を含む。そしてマーカー情報記憶部174は、楽曲が第1ジャンルである場合には、第1設定パターンで楽曲の曲構成に対してマーカーが設定され、楽曲が第2ジャンルである場合には、第1設定パターンとは異なる第2設定パターンで楽曲の曲構成に対してマーカーが設定されるマーカー情報を記憶する。第1設定パターン、第2設定パターンは、楽曲のどの曲構成にマーカーを設定するかについてのパターンである。例えば第1設定パターン、第2設定パターンは、楽曲のどの曲構成に、ミキシング期間の開始タイミング用のマーカーやミキシング期間の終了タイミング用のマーカーを設定するかについてのパターンである。例えば楽曲が第1ジャンルである場合と第2ジャンルである場合とで、楽曲のどの曲構成に対してマーカーを設定するかが異なっている。The processing system of this embodiment also includes a music

そして音処理部102は、先行楽曲から後続楽曲への切り替えの際に、マーカー情報に応じて設定されるミキシング期間において、先行楽曲と後続楽曲のミキシング処理を行う。例えば音処理部102は、ジャンルに応じて異なった設定パターンで曲構成に対してマーカーが設定されるマーカー情報に基づいて、ミキシング期間を設定し、設定されたミキシング期間において先行楽曲と後続楽曲のミキシング処理を行う。例えばミキシング期間の開始タイミングに対応するマーカーと、ミキシング期間の終了タイミングに対応するマーカーが、ジャンルに応じて異なる設定パターンで、先行楽曲や後続楽曲の曲構成に設定されており、これらのマーカーを用いてミキシング期間が設定される。そして音処理部102は、これらのマーカーにより設定されたミキシング期間において、先行楽曲と後続楽曲のミキシング処理を行う。Then, when switching from the preceding song to the following song, the

また表示処理部120は、先行楽曲の音波形と、後続楽曲の音波形と、マーカー情報のマーカーのタイミングを、ユーザが視覚的に認識するための表示処理を行う。例えば表示処理部120は、先行楽曲の音波形の画像と、後続楽曲の音波形の画像を表示部190に表示する処理を行う。そして表示処理部120は、先行楽曲の音波形の画像に対して、先行楽曲用のマーカーの画像を、当該マーカーにより設定されるタイミングの位置に表示する処理を行う。また表示処理部120は、後続楽曲の音波形の画像に対して、後続楽曲用のマーカーの画像を、当該マーカーにより設定されるタイミングの位置に表示する処理を行う。The

また音処理部102は、ユーザのミキシング操作のタイミングとマーカー情報のマーカーのタイミングとのズレ量が所定の範囲内である場合に、マーカーのタイミングに合うようにミキシング操作のタイミングを補正する処理を行う。即ちユーザが、操作部160を用いて、後続楽曲の再生開始操作、フェーダーによる音量調整、又はイコライザーによるイコライザー調整などのミキシング操作を行った場合に、当該ミキシング操作のタイミングを取得する。そして当該ミキシング操作のタイミングと、マーカー情報のマーカーにより設定されるタイミングとのズレ量を測定する。そしてズレ量が所定の許容の範囲内である場合には、マーカーのタイミングに合うようにミキシング操作のタイミングを補正する処理を行う。即ち音処理部104は、マーカーで設定されるタイミングで、ユーザのミキシング操作が行われたとして、先行楽曲と後続楽曲のミキシング処理を行う。The

また音処理部104は、ユーザのミキシング操作のタイミングとマーカーのタイミングとのズレ量に基づいて、ユーザのミキシング操作の評価処理を行う。例えばズレ量が所定の範囲内である場合にはミキシング操作に対して良い評価(グッド、エクセレント)を付与し、ズレ量が所定の範囲を越えている場合にはミキシング操作に対して悪い評価(バッド)を付与する評価処理を行う。そして表示処理部120は、この評価処理の結果に応じた表示処理を行う。例えば表示処理部120は、ユーザのミキシング操作に対する評価が、どのような評価結果(グッド、エクセレント、バッド)であったのかをユーザに報知する表示処理を行う。例えば評価処理の結果に基づくゲーム成績の情報を表示する。或いは表示処理部120は、評価処理の結果に基づいて、演出用の表示処理を行う。例えば演出エフェクトを発生させるような表示処理を行う。具体的には、キャラクタの周囲に演出エフェクトの表示物を出現させる表示処理を行う。The sound processing unit 104 also performs evaluation processing of the user's mixing operation based on the amount of deviation between the timing of the user's mixing operation and the timing of the marker. For example, if the amount of deviation is within a predetermined range, a good evaluation (good, excellent) is given to the mixing operation, and if the amount of deviation exceeds the predetermined range, a bad evaluation (bad) is given to the mixing operation. The

またマーカー情報記憶部174は、楽曲が先行楽曲であるときのミキシング開始の許可タイミングを設定する第1マーカーの情報と、楽曲が先行楽曲であるときのミキシング終了タイミングを設定する第2マーカーの情報を記憶する。またマーカー情報記憶部174は、楽曲が後続楽曲であるときのミキシング開始の許可タイミングを設定する第3マーカーの情報と、楽曲が後続楽曲であるときのミキシング終了タイミングを設定する第4マーカーの情報を記憶する。即ち、マーカー情報記憶部174は、1つの楽曲に対して、楽曲が先行楽曲であるときに使用される第1マーカー、第2マーカーの情報と、楽曲が後続楽曲であるときに使用される第3マーカー、第4マーカーの情報を、当該楽曲に対応づけて記憶する。ここで、ミキシング開始の許可タイミングを設定するマーカーは、当該許可タイミング移行のタイミングでのミキシングを許可(許容)することを示すマーカーである。The marker

そして音処理部102は、先行楽曲の第2マーカーと後続楽曲の第4マーカーとに基づいて、後続楽曲の再生開始タイミングを決定する。そして先行楽曲の第1マーカーと後続楽曲の第3マーカーに基づいて、ミキシング処理の開始タイミングを決定する。例えば先行楽曲の第2マーカーのタイミングと後続楽曲の第4マーカーのタイミングが一致するように、後続楽曲の再生開始タイミングを決定する。そして後続楽曲の再生開始以降のタイミングにおいて、第1マーカーと第3マーカーによりミキシングが許可されたと判断されたタイミングで、先行楽曲と後続楽曲のミキシング処理を開始する。Then, the

またマーカー情報記憶部174は、第1ミックスモードで使用される第1~第4マーカーの第1マーカーセットの情報と、第2ミックスモードで使用される第1~第4マーカーの第2マーカーセットの情報を記憶する。即ち第1ミックスモード用の第1~第4マーカーの情報を、第1マーカーセットの情報として記憶し、第2ミックスモード用の第1~第4マーカーの情報を、第2マーカーセットの情報として記憶する。第1ミックスモード、第2ミックスモードの各々は、ベーシックミックスモード、ショートミックスモード又はロングミックスモードである。そして音処理部102は、第1ミックスモードでは、第1マーカーセットの情報に応じて設定されるミキシング期間においてミキシング処理を行う。例えば第1マーカーセットの第1~第4マーカーを用いて、ミキシング期間を設定し、設定されたミキシング期間において先行楽曲と後続楽曲のミキシング処理を行う。また音処理部102は、第2ミックスモードでは、第2マーカーセットの情報に応じて設定されるミキシング期間においてミキシング処理を行う。例えば第2マーカーセットの第1~第4マーカーを用いて、ミキシング期間を設定し、設定されたミキシング期間において先行楽曲と後続楽曲のミキシング処理を行う。The marker

なお本実施形態の処理システムは情報処理装置により実現される。即ち、この場合には情報処理装置が本実施形態の処理システムを含む構成になる。情報処理装置は、楽曲情報やマーカー情報などの各種の情報を処理する装置であり、プロセッサ等により実現される。情報処理装置は、例えばパーソナルコンピュータ、ゲーム装置又は携帯型情報処理装置などの端末装置である。或いは情報処理装置はサーバ装置であってもよい。また処理システムは端末装置とサーバ装置の分散処理により実現されてもよい。この場合には処理システムは複数の情報処理装置により実現される。この場合に端末装置は情報の入力処理や受信処理や送信処理や表示処理などだけを行うものであってもよい。The processing system of this embodiment is realized by an information processing device. That is, in this case, the information processing device includes the processing system of this embodiment. The information processing device is a device that processes various types of information such as music information and marker information, and is realized by a processor or the like. The information processing device is, for example, a terminal device such as a personal computer, a game device, or a portable information processing device. Alternatively, the information processing device may be a server device. The processing system may also be realized by distributed processing of the terminal device and the server device. In this case, the processing system is realized by multiple information processing devices. In this case, the terminal device may only perform information input processing, reception processing, transmission processing, display processing, etc.

2.本実施形態の手法

次に本実施形態の手法について詳細に説明する。 2. Method of the Present Embodiment Next, the method of the present embodiment will be described in detail.

2.1 仮想DJのキャラクタ

本実施形態では、図2に示すように、仮想的なDJ(Disc Jockey)のキャラクタCHを登場させて、当該キャラクタCHの映像の表示を可能にしている。例えば仮想空間には、DJ機器10のオブジェクトが配置され、キャラクタCHはこのDJ機器10を操作して、楽曲を連続再生するパフォーマンスを行う。例えばキャラクタCHは、楽曲のリズムやテンポに合わせて飛び跳ねたり踊るなどの動作をしながら、DJ機器10のフェーダーやイコライザーやターンテーブルなどを操作するDJのパフォーマンスを行う。このようなDJのパフォーマンスを行うキャラクタCHの映像は、クラブやライブの会場に設置された大型のモニターに表示される。また会場に設置されたスピーカからは、キャラクタCHの操作で次々と再生される楽曲のサウンドが出力される。或いは、図2のDJのキャラクタCHの映像は、インターネットなどのネットワークを介して、ユーザのスマートフォンやPC(パーソナルコンピュータ)などの端末装置に配信される。ユーザはDJのキャラクタCHの映像をスマートフォンやPCのディスプレイを見ながら、スピーカから出力される楽曲を聴いて、DJのキャラクタCHのパフォーマンスを楽しむ。 2.1 Virtual DJ Character In this embodiment, as shown in FIG. 2, a virtual DJ (Disc Jockey) character CH appears, and an image of the character CH can be displayed. For example, an object of a

キャラクタCHは、キャラクタCHに対応する人物である演者のモーションキャプチャにより収録されたモーションデータに基づいて動作する。例えばキャラクタCHは、モーションデータに基づいて、楽曲のリズムやテンポに合わせて飛び跳ねたり踊るなどの動作を行う。また先行楽曲から後続楽曲に切り替わる際には、先行楽曲をフェードアウトして、後続楽曲をフェードインするミキシングが行われるが、このミキシング期間において、キャラクタCHはミキシング操作の動作を行う。例えばキャラクタCHは、仮想的なDJ機器10のフェーダーやイコライザーなどを操作するミキシング操作を行う。例えばキャラクタCHの手がフェーダーを動かしたり、イコライザーのツマミを回す操作を行う。The character CH acts based on motion data recorded by motion capture of the performer who corresponds to the character CH. For example, based on the motion data, the character CH performs actions such as jumping and dancing to the rhythm and tempo of the music. When switching from the preceding music to the succeeding music, a mixing operation is performed in which the preceding music is faded out and the succeeding music is faded in, and during this mixing period, the character CH performs a mixing operation. For example, the character CH performs a mixing operation to operate the fader, equalizer, etc. of the

図3は、キャラクタCHが操作するDJ機器10(DJプレーヤー、ミキシング装置)の一例を簡素的に示す図である。フェーダー11、12は、各々、チャンネル1、チャンネル2の音量を調整するものである。本実施形態ではチャンネル1(デッキ1)で先行楽曲が再生され、チャンネル2(デッキ2)で後続楽曲が再生されるものとする。クロスフェーダー14は、チャンネル1とチャンネル2の音量バランスを調整するものである。イコライザー21、22は、各々、チャンネル1、チャンネル2の楽曲のイコライジングを行うものであり、高音、中音、低音の調整用のツマミを有する。トリム調整ツマミ23、24は、各々、チャンネル1、2のゲインを調整するものである。また再生ボタン31、32、キューボタン33、34により、チャンネル1、2の楽曲の再生、停止、キューの操作などが可能になる。またターンテーブル35、36によりスクラッチなどのエフェクトの操作が可能になる。またディスプレイ41、42には楽曲の音波形が表示される。なお図3はDJ機器10の一例を模式的に示すものであり、DJ機器10には図3に示すもの以外にも、例えばピッチコントローラー、エフェクト操作ツマミ又はパフォーマンスパッドなどが設けられていてもよい。またDJ機器10は、キャラクタCHと同様に仮想空間のオブジェクトにより構成されるものであり、キャラクタCHやDJ機器10のオブジェクトを用いて、キャラクタCHやDJ機器10の画像を含む仮想空間画像が生成される。Figure 3 is a simplified diagram showing an example of DJ equipment 10 (DJ player, mixing device) operated by character CH.

2.2 マーカー情報に応じたミキシング処理とキャラクタ動作制御

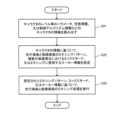

図4は本実施形態の処理を説明するフローチャートである。まず処理システムは、再生対象となる楽曲の楽曲情報を読み出す(ステップS1)。例えば図1の楽曲情報記憶部172から楽曲のサウンドデータなどの楽曲情報を読み出す。例えばDJの演奏においてプレイリストが作成されている場合には、プレイリストの複数の楽曲の楽曲情報を読み出す。また楽曲のマーカー情報を読み出す(ステップS2)。例えば図1のマーカー情報記憶部174から、再生される楽曲に対応づけられるマーカー情報を読み出す。そして処理システムは、キャラクタの楽曲の再生操作の動作に合わせ、楽曲の再生を開始する(ステップS3)。例えば1曲目の再生開始時には、キャラクタが再生ボタンを押すなどの再生操作の動作(アニメーション)を行うため、この再生操作の動作に合わせて、楽曲再生を開始する。具体的には複数の楽曲を、楽曲同士のミキシング等を行いながら次々に連続再生する楽曲再生を開始する。そして再生楽曲の情報に基づいたキャラクタの動作制御を行う(ステップS4)。例えば図2に示す仮想的なDJのキャラクタCHが、再生楽曲のテンポやリズムに合わせてダンスをしたり煽り動作をする動作制御を行う。 2.2 Mixing process and character movement control according to marker information FIG. 4 is a flow chart for explaining the process of this embodiment. First, the processing system reads out the music information of the music to be played (step S1). For example, the processing system reads out music information such as the sound data of the music from the music

次に処理システムは、マーカー情報に基づいて、先行楽曲と後続楽曲のミキシング期間になったか否かを判断する(ステップS5)。例えば先行楽曲の所定の楽曲構成に対応づけられたマーカーの情報や、後続楽曲の所定の楽曲構成に対応づけられたマーカーの情報に基づいて、先行楽曲と後続楽曲のミキシング期間になったか否かを判断する。具体的には、ミキシング期間の開始タイミングに対応するマーカーの情報や、ミキシング期間の終了タイミングに対応するマーカーの情報に基づいて、ミキシング期間になったか否かを判断する。そしてミキシング期間になった場合には、先行楽曲と後続楽曲のミキシング処理を行う(ステップS6、S7)。例えば先行楽曲をフェードアウトさせながら後続楽曲をフェードインさせるミキシング処理を行う。またミキシング期間になった場合には、ミキシング処理に基づいたキャラクタの動作制御を行う(ステップS8)。例えばミキシング用のモーションでキャラクタを動作させる。例えばインバースキネマティクス処理などによりキャラクタの手(指)を動かすモーション補正を、その時の基準のモーションに対して行うことで、ミキシング操作の動作をキャラクタに行わせる。即ち図3のフェーダー11、12、クロスフェーダー14、イコライザー21、22などを操作するミキシング操作の動作をキャラクタに行わせる。そしてミキシング期間が終了したか否かを判断し(ステップS9)、終了した場合にはステップS4に戻る。これにより、そのときの後続楽曲を先行楽曲とし、次の楽曲を後続楽曲とするミキシング処理が行われるようになる。そして、全楽曲の再生が完了するまで複数の楽曲の連続再生が行われる。Next, the processing system judges whether or not it is the mixing period of the preceding song and the following song based on the marker information (step S5). For example, based on the marker information associated with a predetermined song composition of the preceding song or the marker information associated with a predetermined song composition of the following song, it judges whether or not it is the mixing period of the preceding song and the following song. Specifically, it judges whether or not it is the mixing period based on the marker information corresponding to the start timing of the mixing period or the marker information corresponding to the end timing of the mixing period. Then, when it is the mixing period, it performs a mixing process of the preceding song and the following song (steps S6, S7). For example, it performs a mixing process in which the preceding song is faded out while the following song is faded in. Also, when it is the mixing period, it performs the motion control of the character based on the mixing process (step S8). For example, it makes the character move with a motion for mixing. For example, it makes the character perform the motion of the mixing operation by performing a motion correction of the character's hand (fingers) by inverse kinematics processing or the like with respect to the reference motion at that time. That is, the character is made to perform mixing operations such as operating the

このように本実施形態では、図4のステップS1~S4に示すように、楽曲情報に基づいて楽曲の再生処理が行われると共に、キャラクタの動作制御が行われ、図2に示すようにキャラクタの画像の表示処理が行われる。そして図4のステップS5~S9に示すように、先行楽曲から後続楽曲への切り替えの際に、マーカー情報に応じて先行楽曲と後続楽曲のミキシング処理が行われると共に、マーカー情報に応じて先行楽曲と後続楽曲のミキシング期間でのキャラクタの動作制御が行われる。例えばマーカー情報に基づいてミキシング期間が特定され、特定されたミキシング期間において、先行楽曲と後続楽曲のミキシング処理が行われると共に、ミキシング操作に対応したモーションを行うように、キャラクタの動作が制御される。例えばマーカー情報に基づいてミキシング期間での先行楽曲と後続楽曲のミキシング処理とキャラクタの動作制御とが連動するように制御され、当該キャラクタの画像が図2に示すように表示されるようになる。このようにすれば、先行楽曲から後続楽曲に切り替える際に、先行楽曲と後続楽曲の接続情報となるマーカー情報を有効利用した画像生成を実現できるようになる。例えばマーカー情報を用いて先行楽曲と後続楽曲のミキシング処理を実現できると共に、ミキシング操作等の動作を行うキャラクタの画像を生成できるようになる。また先行楽曲と後続楽曲の接続情報となるマーカー情報を利用したスムーズな楽音の再生移行も実現できるようになる。例えばマーカー情報により設定されるミキシング期間において先行楽曲と後続楽曲のミキシングを行うことで、先行楽曲から後続楽曲へのスムーズに再生移行することが可能になる。In this embodiment, as shown in steps S1 to S4 of FIG. 4, the music is played based on the music information, and the character's movement is controlled, and the character's image is displayed as shown in FIG. 2. Then, as shown in steps S5 to S9 of FIG. 4, when switching from the preceding music to the following music, the preceding music and the following music are mixed according to the marker information, and the character's movement is controlled during the mixing period of the preceding music and the following music according to the marker information. For example, the mixing period is specified based on the marker information, and the preceding music and the following music are mixed during the specified mixing period, and the character's movement is controlled to perform a motion corresponding to the mixing operation. For example, the mixing process of the preceding music and the following music during the mixing period and the character's movement control are controlled to be linked based on the marker information, and the character's image is displayed as shown in FIG. 2. In this way, when switching from the preceding music to the following music, it is possible to realize image generation that effectively uses the marker information that serves as the connection information between the preceding music and the following music. For example, the marker information can be used to realize the mixing process of the preceding song and the following song, and an image of a character performing actions such as mixing operations can be generated. It can also realize a smooth transition in the playback of musical sounds by using the marker information, which is the connection information between the preceding song and the following song. For example, by mixing the preceding song and the following song during the mixing period set by the marker information, it becomes possible to smoothly transition the playback from the preceding song to the following song.

また本実施形態では、先行楽曲と後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、外部情報の分析結果、及び楽曲の曲構成の少なくとも1つに応じて、キャラクタの動作を変化させる。このようにすれば、ミキシングパターン、ミックスモード、外部情報の分析結果、又は楽曲の曲構成に応じてキャラクタの動作が様々に変化するようになり、ミキシングパターン、ミックスモード、外部情報の分析結果、又は曲構成を反映させたキャラクタの動作制御を実現できるようになる。In addition, in this embodiment, the character's behavior is changed according to at least one of the mixing pattern of the preceding song and the following song, the mix mode in playing multiple songs, the analysis results of external information, and the song composition of the song. In this way, the character's behavior changes in various ways according to the mixing pattern, mix mode, the analysis results of external information, or the song composition of the song, making it possible to realize character behavior control that reflects the mixing pattern, mix mode, the analysis results of external information, or the song composition.

例えば図5では、先行楽曲と後続楽曲のミキシングパターンPMX、PMY、PMZ・・・と、キャラクタの動作パターンMTX、MTY、MTZ・・・とが対応づけられている。そしてミキシングパターンがPMXである場合には、ミキシング期間においてキャラクタは動作パターンMTXで動作する。同様に、ミキシングパターンがPMY、PMZである場合には、ミキシング期間においてキャラクタは、各々、動作パターンMTY、MTZで動作する。For example, in Figure 5, the mixing patterns PMX, PMY, PMZ, etc. of the preceding and succeeding songs correspond to the character's movement patterns MTX, MTY, MTZ, etc. If the mixing pattern is PMX, the character moves according to the movement pattern MTX during the mixing period. Similarly, if the mixing pattern is PMY or PMZ, the character moves according to the movement patterns MTY or MTZ, respectively, during the mixing period.

ここでミキシングパターンは、例えば先行楽曲と後続楽曲のミキシングにおける音量調整パターン及びイコライザー調整パターンの少なくとも一方の調整パターンである。例えばミキシングパターンPMXが、ミキシング期間において、先行楽曲の音量を徐々に小さくしながら、後続楽曲の音量を徐々に大きくする音量調整を行うパターンだったとする。この場合にミキシングパターンPMXに対応するキャラクタの動作パターンMTXは、図2の先行楽曲用のフェーダー11を徐々に下方向に下げながら、後続楽曲用のフェーダー12を徐々に上方向に上げる動作パターンになる。具体的には、リズムやテンポに合わせて動く基本モーションを行っている図2のキャラクタの左手を、フェーダー11の位置に移動し、右手をフェーダー12の位置に移動し、左手を下方向に動かし、右手を上方向に動かす動作パターンMTXのモーションを行わせる。このような動作パターンMTXのモーション処理は、左手や右手をエンドエフェクタとするインバースキネマティクス処理などにより実現できる。Here, the mixing pattern is, for example, at least one of the volume adjustment pattern and the equalizer adjustment pattern in mixing the preceding and succeeding songs. For example, suppose that the mixing pattern PMX is a pattern in which the volume of the preceding song is gradually decreased while the volume of the succeeding song is gradually increased during the mixing period. In this case, the character's motion pattern MTX corresponding to the mixing pattern PMX is a motion pattern in which the fader 11 for the preceding song in FIG. 2 is gradually lowered downward while the

またミキシングパターンPMYが、ミキシングパターンPMXのような音量調整を行うと共に、低音をイコライザー調整するパターンであったとする。例えばミキシング期間の初めにおいて、後続楽曲の低音を減衰させてバスドラム等が聞こえないようにして、ミキシング期間の最後に後続楽曲の低音を増加させて元に戻し、バスドラムが聞こえるようにするイコライザー調整パターンであったとする。この場合には、ミキシングパターンPMYに対応するキャラクタの動作パターンMTYは、フェーダー11、12又はクロスフェーダー14の操作を行いながら、後続楽曲用のイコライザー22の低音の調整ツマミを回す動作パターンになる。この動作パターンMTYも上述のようなインバースキネマティクス処理などにより実現できる。Suppose mixing pattern PMY is a pattern that adjusts the volume like mixing pattern PMX, while also adjusting the bass with an equalizer. For example, assume that at the beginning of the mixing period, the bass of the following song is attenuated so that the bass drum and the like cannot be heard, and at the end of the mixing period, the bass of the following song is increased back to its original level so that the bass drum can be heard. In this case, the character's movement pattern MTY corresponding to mixing pattern PMY is a movement pattern in which the bass adjustment knob of the

またミキシングパターンPMZが、ミキシングパターンPMXのような音量調整を行うと共に、中音をイコライザー調整するパターンであったとする。例えば、先行楽曲及び後続楽曲がボーカル曲であり、ミキシング期間の初めにおいて、後続楽曲の中音を減衰させてボーカルが聞こえないようにして、ミキシング期間の最後に後続楽曲の中音を増加させて元に戻し、ボーカルが聞こえるようにするイコライザー調整パターンであったとする。この場合には、ミキシングパターンPMZに対応するキャラクタの動作パターンMTZは、フェーダー11、12又はクロスフェーダー14の操作を行いながら、後続楽曲用のイコライザー22の中音の調整ツマミを回す動作パターンになる。この動作パターンMTZも上述のようなインバースキネマティクス処理などにより実現できる。或いは、例えば図3のターンテーブル35、36によるエフェクトが加わるミキシングパターンである場合には、ターンテーブル35、36を操作するような動作パターンでキャラクタを動作させてもよい。このようにすれば、ミキシングパターンにおける音量調整やイコライザー調整のパターンに連動するように、ミキシング期間においてキャラクタを動作させること可能になり、あたかも本物のDJがDJ機器10を操作しているかのように見える仮想空間画像を生成できるようになる。Also, suppose that the mixing pattern PMZ is a pattern that adjusts the volume like the mixing pattern PMX and adjusts the midrange with an equalizer. For example, suppose that the preceding and following songs are vocal songs, and the equalizer adjustment pattern attenuates the midrange of the following song at the beginning of the mixing period so that the vocals cannot be heard, and increases the midrange of the following song at the end of the mixing period so that the vocals can be heard. In this case, the character's motion pattern MTZ corresponding to the mixing pattern PMZ is a motion pattern in which the adjustment knob for the midrange of the

なおミキシング期間におけるキャラクタの動作は、インバースキネマティクス処理を行う手法には限定されず、種々のモーション処理手法を採用できる。例えばミキシング期間用のモーションデータを別途に用意して、ミキシング期間になったら、モーションデータを、ミキシング期間用のモーションデータに切り替えるようにしてもよい。The character's movements during the mixing period are not limited to inverse kinematics processing, and various motion processing methods can be used. For example, separate motion data for the mixing period can be prepared, and when the mixing period begins, the motion data can be switched to the motion data for the mixing period.

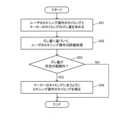

また本実施形態では、ミックスモードに応じてキャラクタの動作を変化させる。ここでミックスモードは、ベーシックミックスモード、ショートミックスモード又はロングミックスモードである。ショートミックスモードは、ベーシックミックスモードに比べて、先行楽曲に対して早いタイミングで後続楽曲をミキシングするモードであり、ロングミックスモードは、先行楽曲に対して遅いタイミングで後続楽曲をミキシングするモードである。図6は、ミックスモードに応じてキャラクタの動作を変化させる処理を説明するフローチャートである。In this embodiment, the character's behavior is changed depending on the mix mode. Here, the mix mode is a basic mix mode, a short mix mode, or a long mix mode. Compared to the basic mix mode, the short mix mode is a mode in which the subsequent song is mixed at an earlier timing than the preceding song, and the long mix mode is a mode in which the subsequent song is mixed at a later timing than the preceding song. Figure 6 is a flowchart that explains the process of changing the character's behavior depending on the mix mode.

まず処理システムは、ミックスモードが設定(変更)された否かを判断し、ベーシックミックスモードが設定された場合には、後述の図21で例示されるようなベーシックミックスモード用のマーカーセットを用いて、ベーシックミックスモードで楽曲再生を行うと共に、ベーシックミックスモードに対応したキャラクタの動作制御を行う(ステップS11、S12、S13、S14)。一方、ショートミックスモードが設定された場合には、ショートミックスモード用のマーカーセットを用いて、ショートミックスモードで楽曲再生を行うと共に、ショートミックスモードに対応したキャラクタの動作制御を行う(ステップS15、S16、17)。またショートミックスモードが設定されていない場合には、ロングミックスモードが設定されたとして、ロングミックスモード用のマーカーセットを用いて、ロングミックスモードで楽曲再生を行うと共に、ロングミックスモードに対応したキャラクタの動作制御を行う(ステップS18、S19)。First, the processing system determines whether the mix mode has been set (changed), and if the basic mix mode has been set, the marker set for the basic mix mode, as illustrated in FIG. 21 below, is used to play music in the basic mix mode, and character movement control corresponding to the basic mix mode is performed (steps S11, S12, S13, S14). On the other hand, if the short mix mode has been set, the marker set for the short mix mode is used to play music in the short mix mode, and character movement control corresponding to the short mix mode is performed (steps S15, S16, S17). If the short mix mode has not been set, the long mix mode is assumed to have been set, and the marker set for the long mix mode is used to play music in the long mix mode, and character movement control corresponding to the long mix mode is performed (steps S18, S19).

例えばショートミックスモードでは、ベーシックミックスモードに比べて、演奏時間内において速いタイミングで次々に楽曲が切り替わって行く。そこでショートミックスモードでは、ベーシックミックスモードに比べて、速い動きや激しい動きの動作パターンでキャラクタを動作させる。例えばショートミックスモード用のモーションデータとして、ベーシックミックスモード用のモーションデータに比べて、速い動きや激しい動きになるモーションデータを用意して、モーション再生を行う。一方、ロングミックスモードでは、ベーシックミックスモードに比べて、演奏時間内において遅いタイミングでゆっくりと楽曲が切り替わって行く。そこでロングミックスモードでは、ベーシックミックスモードに比べて、遅い動きや穏やかな動きの動作パターンでキャラクタを動作させる。例えばロングミックスモード用のモーションデータとして、ベーシックミックスモード用のモーションデータに比べて、遅い動きや穏やかな動きになるモーションデータを用意して、モーション再生を行う。このようにすれば、ベーシックミックスモード、ショートミックスモード又はロングミックスモードに応じたモーションでキャラクタを動作させることが可能になり、各ミックスモードに適した動作を行うキャラクタの画像を表示できるようになる。For example, in the short mix mode, music pieces are switched one after another at a faster timing within the playing time than in the basic mix mode. Therefore, in the short mix mode, the character is moved in a faster or more intense motion pattern than in the basic mix mode. For example, as the motion data for the short mix mode, motion data that is faster or more intense than the motion data for the basic mix mode is prepared, and motion is played. On the other hand, in the long mix mode, music pieces are switched more slowly within the playing time than in the basic mix mode. Therefore, in the long mix mode, the character is moved in a slower or more gentle motion pattern than in the basic mix mode. For example, as the motion data for the long mix mode, motion data that is slower or more gentle than the motion data for the basic mix mode is prepared, and motion is played. In this way, it is possible to move the character in a motion corresponding to the basic mix mode, short mix mode, or long mix mode, and it is possible to display an image of the character performing a motion suitable for each mix mode.

また本実施形態では、外部情報の分析結果に応じて、キャラクタの動作を変化させる。例えば図7では端末装置TM1~TMnがネットワーク510を介して本実施形態の処理システムに通信接続されている。ネットワーク510は、例えばインターネットを利用した通信路である。そして端末装置TM1~TMnのユーザが、DJのキャラクタのパフォーマンスや再生楽曲についてのインターネット投票を行い、このインターネット投票の結果が、外部情報として分析される。そして処理システムは、インターネット投票の結果である外部情報の分析結果に応じて、キャラクタの動作を変化させる。例えばキャラクタのパフォーマンスを多くのユーザが支持するような分析結果である場合には、キャラクタの動きが盛り上がった動きになったり、ユーザへの特典となる特別な動きを行うようになる。或いはインターネット投票の結果である外部情報の分析結果に応じて、キャラクタがDJとして次に演奏する楽曲を選択するようにしてもよい。また外部情報の分析結果は、外部環境の音声や観客の動きの分析結果であってもよい。例えばクラブやライブの会場で図2に示すようなDJのキャラクタの映像をモニターに表示した場合に、観客の歓声や、キャラクタのパフォーマンスで盛り上がった観客の動きを分析する。そして、この分析結果を反映した動きでキャラクタを動作させる。例えば歓声が大きかったり、観客が盛り上がった動きをした場合には、それに応じてキャラクタの動きが盛り上がった動きになったり、ユーザへの特典となる特別な動きを行うようになる。このようにすれば、外部情報の分析結果を反映させた動作をキャラクタが行うようになり、あたかも本物のDJが、観客の歓声や動きに反応してパフォーマンスを行うようなリアルな仮想空間画像を生成することが可能になる。In this embodiment, the character's behavior is changed according to the analysis results of the external information. For example, in FIG. 7, the terminal devices TM1 to TMn are connected to the processing system of this embodiment via the

また本実施形態では、楽曲の曲構成に応じてキャラクタの動作を変化させる。例えば後述するようにハウスミュージック(テクノハウス)のジャンルの楽曲は、図8に示すようにイントロ、ビルドアップA、ドロップA、ブレーク、ビルドアップB、ドロップB、アウトロの曲構成を有する。この場合にこれらの曲構成に対して、キャラクタの動作パターンMTA、MTB、MTC、MTD、MTE、MTF、MTGが対応づけられている。例えば楽曲のイントロの曲構成が再生されているときには、キャラクタは動作パターンMTAで動作する。同様にビルドアップA、ドロップA、ブレーク、ビルドアップB、ドロップB、アウトロの曲構成が再生されているときには、各々、キャラクタは動作パターンMTB、MTC、MTD、MTE、MTF、MTGで動作する。例えば図8の各曲構成が再生されているときに、動作パターンMTA~MTGに対応するモーションデータを用いてキャラクタのモーション再生を行う。このようにすれば楽曲の曲構成に応じた動きでキャラクタを動作させることができ、楽曲に連動したキャラクタの動作を実現できるようになる。例えば楽曲のビルドアップが再生されているときには、図9に示すように、キャラクタCHが手を振ったり、体を激しく動かすなどの動作パターンで動作するようにする。これによりクラブやライブの会場の観客や、動画配信を端末装置で見ているユーザを盛り上げることが可能になる。なお動作パターンMTA~MTGは全てが互いに異なった動作パターンである必要はなく、これらのうちの少なくとも2つが異なった動作パターンであればよい。In this embodiment, the character's movements are changed according to the musical composition of the song. For example, as described later, a song in the genre of house music (techno house) has a musical composition of intro, build-up A, drop A, break, build-up B, drop B, and outro, as shown in FIG. 8. In this case, the character's movement patterns MTA, MTB, MTC, MTD, MTE, MTF, and MTG are associated with these musical compositions. For example, when the intro musical composition of a song is being played, the character moves according to the movement pattern MTA. Similarly, when the build-up A, drop A, break, build-up B, drop B, and outro musical compositions are being played, the character moves according to the movement patterns MTB, MTC, MTD, MTE, MTF, and MTG, respectively. For example, when each musical composition of FIG. 8 is being played, the character's motion is played using the motion data corresponding to the movement patterns MTA to MTG. In this way, the character can be made to move in accordance with the musical composition of the song, and the character's movements linked to the song can be realized. For example, when a song's build-up is being played, the character CH can move in a pattern of waving its hands and vigorously moving its body, as shown in FIG. 9. This can liven up the atmosphere for the audience at a club or live concert, or for users watching a video stream on a terminal device. Note that the movement patterns MTA to MTG do not all need to be different from each other, as long as at least two of them are different.

また本実施形態では、キャラクタの情報に基づいて、先行楽曲と後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、及びミキシングに使用するマーカー情報の少なくとも1つを変化させる。このようにすればキャラクタの情報に応じたミキシングパターン、ミックスモード又はマーカー情報により、先行楽曲と後続楽曲のミキシング処理などを行えるようになり、様々な態様の楽曲ミキシングを実現できるようになる。図10は、キャラクタの情報に基づいてミキシングパターン、ミックスモード、使用するマーカー情報を変化させる処理を説明するフローチャートである。In this embodiment, at least one of the mixing pattern of the preceding song and the following song, the mix mode for playing multiple songs, and the marker information used for mixing is changed based on the character information. In this way, mixing processing of the preceding song and the following song can be performed using the mixing pattern, mix mode, or marker information according to the character information, making it possible to realize various types of song mixing. Figure 10 is a flowchart explaining the process of changing the mixing pattern, mix mode, and marker information used based on the character information.

まずキャラクタのレベル等のパラメータ、性格情報、又は制御アルゴリズム情報などのキャラクタの情報を読み出す(ステップS21)。即ち図1のキャラクタ情報記憶部176からキャラクタの情報を読み出す。キャラクタの情報は例えばキャラクタに対して予め設定された判断条件の情報である。次にキャラクタの情報に基づいて、先行楽曲と後続楽曲のミキシングパターン、複数の楽曲再生におけるミックスモード、又はミキシングに使用するマーカー情報を設定する(ステップS22)。そして、このようにして設定されたミキシングパターン、ミックスモード又はマーカー情報に基づいて、先行楽曲と後続楽曲のミキシング処理を実行する(ステップS23)。これによりキャラクタの情報を反映させたミキシングパターン、ミックスモード又はマーカー情報を用いてミキシング処理を実行できるようになる。First, character information such as parameters such as the character's level, personality information, or control algorithm information is read (step S21). That is, character information is read from the character

例えばキャラクタの情報に基づいて、図5で説明した先行楽曲と後続楽曲のミキシングにおける音量調整パターン及びイコライザー調整パターンの少なくとも一方の調整パターンであるミキシングパターンを設定する。キャラクタの情報は、例えばキャラクタのレベル、能力等のパラメータ、キャラクタの性格、或いはキャラクタの制御アルゴリズムなどの情報である。例えばキャラクタのレベル又は能力が高い場合には、より複雑で難易度が高いミキシングパターンを設定する。或いはキャラクタの性格に応じてミキシングパターンを設定する。例えばキャラクタが細かい綿密な性格である場合には、複雑で綿密なミキシングパターンを設定する。或いはキャラクタを制御する制御アルゴリズムに応じて、ミキシングパターンを異ならせる。またキャラクタのレベル、能力等のパラメータ、性格、又は制御アルゴリズムに応じて、ベーシックミックスモード、ショートミックスモード、ロングミックスモードのうちのどのミックスモードを使用するのかを異ならせる。例えばキャラクタのレベル又は能力が低い場合には、ベーシックミックスモードしか使用できないが、レベル又は能力が高くなると、ショートミックスモードやロングミックスモードについても使用できるようになる。また例えばキャラクタがノリの良い性格である場合には、ショートミックスモードが使用され、大人しく落ち着きのある性格である場合には、ロングミックスモードが使用される。またキャラクタのレベル、能力等のパラメータ、性格、又は制御アルゴリズムに応じて、使用されるマーカー情報を異ならせる。例えば後述の図21のように複数のマーカーセットがある場合に、どのマーカーセットを使用するかをキャラクタの情報に応じて異ならせる。或いは、キャラクタのレベル、能力等のパラメータ、性格又は制御アルゴリズムに応じて、楽曲の複数の曲構成のうちのどの曲構成に設定されたマーカー情報を使用するかを決定する。例えばキャラクタがノリの良い性格である場合には、ノリの良い曲構成のパートに設定されたマーカー情報が使用され、その曲構成になったときにミキシング処理が行われる。またキャラクタが大人しく落ち着きのある性格である場合には、静かなタイプの曲構成のパートに設定されたマーカー情報が使用され、その曲構成になったときにミキシング処理が行われる。For example, based on character information, a mixing pattern is set, which is at least one of the volume adjustment pattern and the equalizer adjustment pattern in mixing the preceding music and the following music as described in FIG. 5. The character information is, for example, information such as the character's level, ability, and other parameters, the character's personality, or the character's control algorithm. For example, when the character's level or ability is high, a more complex and difficult mixing pattern is set. Or a mixing pattern is set according to the character's personality. For example, when the character has a detailed and meticulous personality, a complex and meticulous mixing pattern is set. Or, the mixing pattern is made different according to the control algorithm that controls the character. Also, depending on the character's level, ability, and other parameters, personality, or control algorithm, which mix mode is used among the basic mix mode, short mix mode, and long mix mode is made different. For example, when the character's level or ability is low, only the basic mix mode can be used, but when the character's level or ability is high, the short mix mode and long mix mode can also be used. Also, for example, when the character has a fun-loving personality, the short mix mode is used, and when the character has a quiet and calm personality, the long mix mode is used. Also, the marker information used is made different depending on the character's level, ability parameters, personality, or control algorithm. For example, when there are multiple marker sets as shown in FIG. 21 described below, which marker set is used is made different depending on the character information. Alternatively, the marker information set for which of multiple song configurations of a song is used is determined depending on the character's level, ability parameters, personality, or control algorithm. For example, if the character has a catchy personality, the marker information set for the part of the catchy song configuration is used, and mixing processing is performed when that song configuration is achieved. Also, if the character has a quiet and calm personality, the marker information set for the part of the quiet type song configuration is used, and mixing processing is performed when that song configuration is achieved.

またマーカー情報記憶部174は、ミキシング期間の開始タイミングに対応するマーカーの情報と、ミキシング期間の終了タイミングに対応するマーカーの情報を記憶する。このようにすれば、マーカー情報記憶部174に記憶されるマーカー情報により、ミキシング期間の開始タイミングや終了タイミングを設定して、先行楽曲と後続楽曲のミキシング処理を行ったり、ミキシング期間でのキャラクタの動作を制御できるようになる。The marker

例えば図11では、先行楽曲はCXA~CXGの曲構成を有しており、後続楽曲はCYA~CYGの曲構成を有している。そして先行楽曲では、曲構成CXEに対して、ミキシング期間の開始タイミングに対応するマーカーMSXと、ミキシング期間の終了タイミングに対応するマーカーMEXが設定されている。また後続楽曲では、曲構成CYCに対して、ミキシング期間の開始タイミングに対応するマーカーMSYと、ミキシング期間の終了タイミングに対応するマーカーMEYが設定されている。このようにすれば、例えばマーカーMSX、MSYのタイミングをミキシング期間の開始タイミングとし、マーカーMEX、MEYのタイミングをミキシング期間の終了タイミングとして、先行楽曲と後続楽曲のミキシング処理を行えるようになる。例えばマーカーMSXのタイミングを開始タイミングとして、先行楽曲のフェードアウトが開始され、マーカーMEXのタイミングを終了タイミングとして、先行楽曲のフェードアウトが終了する。またマーカーMSYのタイミングを開始タイミングとして、後続楽曲のフェードインが開始され、マーカーMEYのタイミングを終了タイミングとして、後続楽曲のフェードインが終了する。この場合に、マーカーMSX、MSYが一致するタイミングや、或いはマーカーMEX、MEYが一致するタイミングを特定することで、後続楽曲の再生を開始するタイミングを特定できる。例えばマーカーMSX、MSYのタイミングが一致するように、後続楽曲の再生を開始したり、或いはマーカーMEX、MEYのタイミングが一致するように、後続楽曲の再生を開始する。For example, in FIG. 11, the preceding song has a song structure of CXA-CXG, and the succeeding song has a song structure of CYA-CYG. In the preceding song, a marker MSX corresponding to the start timing of the mixing period and a marker MEX corresponding to the end timing of the mixing period are set for the song structure CXE. In the succeeding song, a marker MSY corresponding to the start timing of the mixing period and a marker MEY corresponding to the end timing of the mixing period are set for the song structure CYC. In this way, for example, the timing of the markers MSX and MSY can be used as the start timing of the mixing period, and the timing of the markers MEX and MEY can be used as the end timing of the mixing period to perform the mixing process of the preceding song and the succeeding song. For example, the fade-out of the preceding song starts with the timing of the marker MSX as the start timing, and the fade-out of the preceding song ends with the timing of the marker MEX as the end timing. The fade-in of the subsequent song starts with the timing of the marker MSY as the start timing, and ends with the timing of the marker MEY as the end timing. In this case, the timing to start playing the subsequent song can be specified by identifying the timing at which the markers MSX and MSY match, or the timing at which the markers MEX and MEY match. For example, playback of the subsequent song is started so that the timing of the markers MSX and MSY match, or playback of the subsequent song is started so that the timing of the markers MEX and MEY match.

また本実施形態では、マーカー情報のマーカーは、楽曲の曲構成に対応づけられている。そして先行楽曲が第j曲構成(jは1以上の整数)であり、後続楽曲が第k曲構成(kは1以上の整数)である期間を、マーカー情報に基づき特定し、当該期間をミキシング期間としてミキシング処理を行う。このようにすれば、先行楽曲が第j曲構成であり、後続楽曲が第k曲構成であるときに、第j曲構成と第k曲構成のミキシング処理を行って、再生楽曲を先行楽曲から後続楽曲に切り替えることが可能になる。In this embodiment, the markers in the marker information correspond to the song structure of the song. Then, the period during which the preceding song is the jth song structure (j is an integer equal to or greater than 1) and the following song is the kth song structure (k is an integer equal to or greater than 1) is identified based on the marker information, and mixing processing is performed for that period as the mixing period. In this way, when the preceding song is the jth song structure and the following song is the kth song structure, mixing processing of the jth song structure and the kth song structure is performed, making it possible to switch the played song from the preceding song to the following song.

例えば図11では、マーカー情報のマーカーMSX、MEXは、先行楽曲の曲構成CXEに対応づけられ、マーカーMSY、MEYは、後続楽曲の曲構成CYCに対応づけられている。そして先行楽曲が曲構成CXE(第j曲構成)であり、後続楽曲が曲構成CYC(第k曲構成)である期間が、マーカーMSX、MEX、MSY、MEYに基づき特定され、当該期間をミキシング期間として、先行楽曲の曲構成CXEと後続楽曲の曲構成CYCのミキシング処理が行われる。例えば、マーカーMSX、MSYのタイミングを開始タイミングとし、マーカーMEX、MEYのタイミングを終了タイミングとするミキシング期間において、先行楽曲の曲構成CXEと後続楽曲の曲構成CYCのミキシング処理が行われる。例えば当該ミキシング期間において、先行楽曲の曲構成CXEをフェードアウトしながら、後続楽曲の曲構成CYCをフェードインするミキシング処理が行われる。この場合、例えば、曲構成CXEは、先行楽曲の曲構成CXA~CXGのうち、後続楽曲の曲構成CYCとミキシングが行われても、不自然さや違和感が少ない曲構成である。同様に曲構成CYEは、後続楽曲の曲構成CYA~CYGのうち、先行楽曲の曲構成CXEとミキシングが行われても不自然さや違和感が少ない曲構成である。従って、マーカーMSX、MEX、MSY、MEYを利用して、先行楽曲の曲構成CXEと後続楽曲の曲構成CYCのミキシングを行えば、先行楽曲から後続楽曲への不自然さや違和感が少ない再生移行が可能になる。For example, in FIG. 11, the markers MSX and MEX in the marker information are associated with the song structure CXE of the preceding song, and the markers MSY and MEY are associated with the song structure CYC of the following song. The period during which the preceding song has the song structure CXE (jth song structure) and the following song has the song structure CYC (kth song structure) is identified based on the markers MSX, MEX, MSY, and MEY, and the mixing process of the song structure CXE of the preceding song and the song structure CYC of the following song is performed during the mixing period, which is started at the timing of the markers MSX and MSY and ended at the timing of the markers MEX and MEY, during which the mixing process of the song structure CXE of the preceding song and the song structure CYC of the following song is performed. For example, during the mixing period, a mixing process is performed in which the song structure CXE of the preceding song is faded out while the song structure CYC of the following song is faded in. In this case, for example, among the preceding song structures CXA to CXG, the song structure CXE is the song structure that will not sound unnatural or strange even if it is mixed with the following song structure CYC. Similarly, among the following song structures CYA to CYG, the song structure CYE is the song structure that will not sound unnatural or strange even if it is mixed with the preceding song structure CXE. Therefore, by using the markers MSX, MEX, MSY, and MEY to mix the preceding song structure CXE with the following song structure CYC, it becomes possible to transition from the preceding song to the following song in a playback that does not sound unnatural or strange.

2.3 ジャンルに応じた設定パターンのマーカー情報

本実施形態では、楽曲のジャンルに応じた設定パターンのマーカー情報を用いる手法を採用する。即ち楽曲のジャンルに応じて異なる設定パターンで楽曲の曲構成に設定されるマーカーの情報を用いて、先行楽曲と後続楽曲のミキシング処理を行う。なお、このようなマーカー情報を用いる本実施形態の手法は、上述のような仮想的なDJのキャラクタを登場させる適用例には限定されず、例えばキャラクタの動作制御や表示処理を行わないシステムにも適用できる。 2.3 Marker information of a setting pattern according to a genre In this embodiment, a method is adopted that uses marker information of a setting pattern according to a genre of a song. That is, a mixing process of a preceding song and a succeeding song is performed using marker information that is set in the song structure with a different setting pattern according to the genre of the song. Note that the method of this embodiment that uses such marker information is not limited to the application example in which a virtual DJ character appears as described above, and can also be applied to a system that does not control the movement or display processing of a character, for example.

具体的には、このようなマーカー情報を用いる本実施形態の処理システムは、楽曲情報記憶部172とマーカー情報記憶部174と音処理部102を含む。そしてマーカー情報記憶部174は、楽曲が第1ジャンルである場合には第1設定パターンで曲構成に対してマーカーが設定され、楽曲が第2ジャンルである場合には第2設定パターンで曲構成に対してマーカーが設定されるマーカー情報を記憶する。即ち、ジャンルに応じて異なる設定パターンで楽曲の曲構成に設定されるマーカーの情報を記憶する。そして音処理部102は、先行楽曲から後続楽曲への切り替えの際に、このマーカー情報に応じて設定されるミキシング期間において、先行楽曲と後続楽曲のミキシング処理を行う。図12はこの場合の本実施形態の処理例を説明するフローチャートである。Specifically, the processing system of this embodiment using such marker information includes a music

まず処理システムは、再生対象となる楽曲の楽曲情報を読み出す(ステップS31)。そして、ジャンルに応じて異なる設定パターンで楽曲の曲構成に設定されるマーカーのマーカー情報を読み出す(ステップS32)。即ちマーカー情報記憶部174は、楽曲が第1ジャンルである場合には第1設定パターンで曲構成に対してマーカーが設定され、楽曲が第2ジャンルである場合には第2設定パターンで曲構成に対してマーカーが設定されるマーカー情報を記憶しており、このような設定パターンのマーカー情報を読み出す。そして楽曲の再生を開始する(ステップS33)。例えば複数の楽曲を、楽曲同士のミキシング等を行いながら次々に連続再生する楽曲再生を開始する。First, the processing system reads out the music information of the music to be played (step S31). Then, it reads out the marker information of the markers that are set in the music structure of the music in different setting patterns depending on the genre (step S32). That is, the marker

次に処理システムは、マーカー情報に基づいて先行楽曲と後続楽曲のミキシング期間になったか否かを判断する(ステップS34)。例えばジャンルに応じて異なる設定パターンで先行楽曲や後続楽曲の曲構成に設定されるマーカー情報に基づいて、先行楽曲と後続楽曲のミキシング期間になったか否かを判断する。そしてミキシング期間になった場合には、先行楽曲と後続楽曲のミキシング処理を行う(ステップS35、S36)。例えば先行楽曲をフェードアウトさせながら後続楽曲をフェードインさせるミキシング処理を行う。そしてミキシング期間が終了したか否かを判断し(ステップS37)、終了した場合にはステップS34に戻る。これにより、そのときの後続楽曲を先行楽曲とし、次の楽曲を後続楽曲とするミキシング処理が行われるようになる。そして、全楽曲の再生が完了するまで複数の楽曲の連続再生が行われる。The processing system then determines whether or not it is the mixing period for the preceding and subsequent songs based on the marker information (step S34). For example, the processing system determines whether or not it is the mixing period for the preceding and subsequent songs based on marker information that is set in the song configuration of the preceding and subsequent songs in different setting patterns depending on the genre. If it is the mixing period, the processing system performs mixing processing for the preceding and subsequent songs (steps S35 and S36). For example, the processing system performs mixing processing in which the preceding song is faded out while the subsequent song is faded in. The processing system then determines whether or not the mixing period has ended (step S37), and if so, returns to step S34. This causes mixing processing to be performed in which the subsequent song at that time is the preceding song and the next song is the subsequent song. Then, multiple songs are played continuously until playback of all songs is completed.

図13は、DJ画面の一例を示す図である。このDJ画面は、例えばPC、スマートフォン又はゲーム装置などの端末装置のディスプレイに表示される。そしてユーザは、このDJ画面を見ながらDJの操作を行う。フェーダー51、52は、各々、チャンネル1、チャンネル2の音量を調整するものである。クロスフェーダー54は、チャンネル1とチャンネル2の音量バランスを調整するものである。イコライザー61、62は、各々、チャンネル1、チャンネル2の楽曲のイコライジングを行うものであり、高音、中音、低音の調整用のツマミが設けられる。トリム調整ツマミ63、64は、各々、チャンネル1、2のゲインを調整するものである。シンクボタン65、66は、チャンネル1とチャンネル2の楽曲のテンポを同期させるボタンである。再生ボタン71、72、キューボタン73、74により、チャンネル1、2の楽曲の再生、停止、キューの操作が可能になる。表示領域80には、楽曲再生のプレイリストが表示される。表示領域81には、チャンネル1の先行楽曲の音波形が表示され、表示領域82には、チャンネル2の後続楽曲の音波形が表示される。そして表示領域81には、先行楽曲に設定されたマーカーMK1、MK2が、先行楽曲の音波形に対応づけられて表示される。表示領域82には、後続楽曲に設定されたマーカーMK3、MK4が、後続楽曲の音波形に対応づけられて表示される。なお表示領域83、84には、各々、先行楽曲、後続楽曲の音波形が拡大表示される。Figure 13 is a diagram showing an example of a DJ screen. This DJ screen is displayed on the display of a terminal device such as a PC, a smartphone, or a game device. The user operates the DJ while watching this DJ screen. The

図14は本実施形態のマーカー情報のマーカーMK1、MK2、MK3、MK4の説明図である。マーカーMK1、MK2、MK3、MK4は、各々、第1マーカー、第2マーカー、第3マーカー、第4マーカーである。Figure 14 is an explanatory diagram of markers MK1, MK2, MK3, and MK4 in the marker information of this embodiment. Markers MK1, MK2, MK3, and MK4 are the first marker, second marker, third marker, and fourth marker, respectively.

例えばマーカーMK1は、楽曲が先行楽曲であるときのミキシング開始の許可タイミングを設定するマーカーである。即ちマーカーMK1のタイミング以降のタイミングにおいて、ミキシングの開始が許容される。マーカーMK1は、先行楽曲のミックスアウトのマーカーとも呼ぶことができる。For example, marker MK1 is a marker that sets the permitted timing for starting mixing when a song is a preceding song. In other words, mixing is permitted to start at any timing after the timing of marker MK1. Marker MK1 can also be called a mix-out marker for the preceding song.

マーカーMK2は、楽曲が先行楽曲であるときのミキシング終了タイミングを設定するマーカーである。マーカーMK2は、例えばミキシングの対象となる先行楽曲の曲構成の終了タイミングを示している。マーカーMK2は先行楽曲のカットのマーカーとも呼ぶことができる。Marker MK2 is a marker that sets the mixing end timing when the song is a preceding song. Marker MK2 indicates, for example, the end timing of the song structure of the preceding song that is the subject of mixing. Marker MK2 can also be called a marker for the cut of the preceding song.

マーカーMK3は、楽曲が後続楽曲であるときのミキシング開始の許可タイミングを設定するマーカーである。即ちマーカーMK3のタイミング以降のタイミングにおいて、ミキシングの開始が許容される。マーカーMK3は、後続楽曲のミックスインのマーカーとも呼ぶことができる。Marker MK3 is a marker that sets the permitted timing for starting mixing when the song is a subsequent song. In other words, mixing is permitted to start at any timing after the timing of marker MK3. Marker MK3 can also be called a mix-in marker for the subsequent song.

マーカーMK4は、楽曲が後続楽曲であるときのミキシング終了タイミングを設定するマーカーである。例えばマーカーMK4は、先行楽曲から後続楽曲への完全移行のタイミングを示している。マーカーMK4は、後続楽曲への完全移行を示すトランスのマーカーとも呼ぶことができる。本実施形態では、マーカー情報記憶部174が、これらのマーカーMK1、MK2、MK3、MK4の情報を、例えば複数の楽曲の各楽曲に対応づけて記憶している。Marker MK4 is a marker that sets the timing of mixing end when the song is a subsequent song. For example, marker MK4 indicates the timing of complete transition from the preceding song to the subsequent song. Marker MK4 can also be called a transition marker that indicates complete transition to the subsequent song. In this embodiment, the marker

このようなマーカーMK1、MK2、MK3、MK4の情報を用いることで、先行楽曲と後続楽曲のミキシング期間を適切に設定して、先行楽曲と後続楽曲をミキシングしながら、先行楽曲から後続楽曲に切り替える再生移行を実現できるようになる。例えばマーカーMK1、MK3を用いれば、先行楽曲と後続楽曲の各々について、どのタイミング以降であればミキシングの開始が許容されるのかを処理システム(コンピュータ)又はユーザが認識できるようになる。例えば先行楽曲から後続楽曲への切り替えを処理システムが自動的に行う場合は、マーカーMK1、MK3を用いることで、ミキシングの開始が許容されるタイミングを処理システムが認識できるようになる。一方、先行楽曲から後続楽曲への切り替えをユーザが手動で行う場合は、マーカーMK1、MK3を用いることで、ミキシングの開始が許容されるタイミングをユーザが認識できるようになる。またマーカーMK2、MK4を用いれば、先行楽曲と後続楽曲の各々について、どのタイミングでミキシング期間が終了して先行楽曲から後続楽曲に移行するのかを処理システム又はユーザが認識できるようになる。By using such information of markers MK1, MK2, MK3, and MK4, it is possible to appropriately set the mixing period of the preceding song and the following song, and to realize a playback transition in which the preceding song is switched to the following song while mixing the preceding song and the following song. For example, by using markers MK1 and MK3, the processing system (computer) or the user can recognize the timing at which mixing is permitted to start for each of the preceding song and the following song. For example, when the processing system automatically switches from the preceding song to the following song, the processing system can recognize the timing at which mixing is permitted to start by using markers MK1 and MK3. On the other hand, when the user manually switches from the preceding song to the following song, the markers MK1 and MK3 can be used to enable the user to recognize the timing at which mixing is permitted to start. Furthermore, by using markers MK2 and MK4, the processing system or the user can recognize the timing at which the mixing period ends for each of the preceding song and the following song and the transition from the preceding song to the following song occurs.