JP7306439B2 - Information processing device, information processing method, information processing program and information processing system - Google Patents

Information processing device, information processing method, information processing program and information processing systemDownload PDFInfo

- Publication number

- JP7306439B2 JP7306439B2JP2021183024AJP2021183024AJP7306439B2JP 7306439 B2JP7306439 B2JP 7306439B2JP 2021183024 AJP2021183024 AJP 2021183024AJP 2021183024 AJP2021183024 AJP 2021183024AJP 7306439 B2JP7306439 B2JP 7306439B2

- Authority

- JP

- Japan

- Prior art keywords

- subject

- information

- image

- situation

- information processing

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 230000010365information processingEffects0.000titleclaimsdescription97

- 238000003672processing methodMethods0.000titleclaimsdescription5

- 230000033001locomotionEffects0.000claimsdescription18

- 230000008921facial expressionEffects0.000claimsdescription15

- 238000003384imaging methodMethods0.000claimsdescription13

- 230000036760body temperatureEffects0.000claimsdescription6

- 206010028813NauseaDiseases0.000claimsdescription5

- 235000003642hungerNutrition0.000claimsdescription5

- 230000008693nauseaEffects0.000claimsdescription5

- 230000035922thirstEffects0.000claimsdescription5

- 210000004556brainAnatomy0.000claimsdescription3

- 230000036387respiratory rateEffects0.000claimsdescription3

- 230000008451emotionEffects0.000description15

- 238000000034methodMethods0.000description14

- 238000010586diagramMethods0.000description7

- 230000008859changeEffects0.000description6

- XLYOFNOQVPJJNP-UHFFFAOYSA-NwaterSubstancesOXLYOFNOQVPJJNP-UHFFFAOYSA-N0.000description6

- 230000001815facial effectEffects0.000description4

- 230000006870functionEffects0.000description4

- 230000003340mental effectEffects0.000description4

- 230000005540biological transmissionEffects0.000description3

- 230000008569processEffects0.000description3

- 238000004458analytical methodMethods0.000description2

- 230000006399behaviorEffects0.000description2

- 230000004397blinkingEffects0.000description2

- 238000006243chemical reactionMethods0.000description2

- 230000000694effectsEffects0.000description2

- 230000007613environmental effectEffects0.000description2

- 230000014509gene expressionEffects0.000description2

- 239000011521glassSubstances0.000description2

- 230000003449preventive effectEffects0.000description2

- 210000001747pupilAnatomy0.000description2

- 230000005856abnormalityEffects0.000description1

- 230000003190augmentative effectEffects0.000description1

- 230000015572biosynthetic processEffects0.000description1

- 230000002996emotional effectEffects0.000description1

- 239000000284extractSubstances0.000description1

- 230000004424eye movementEffects0.000description1

- 238000012986modificationMethods0.000description1

- 230000004048modificationEffects0.000description1

- 230000036651moodEffects0.000description1

- 230000029058respiratory gaseous exchangeEffects0.000description1

- 230000004044responseEffects0.000description1

- 239000000725suspensionSubstances0.000description1

- 238000003786synthesis reactionMethods0.000description1

- 238000001931thermographyMethods0.000description1

Images

Landscapes

- Measuring And Recording Apparatus For Diagnosis (AREA)

- Closed-Circuit Television Systems (AREA)

- Studio Devices (AREA)

Description

Translated fromJapanese本発明は、情報処理装置、情報処理方法、情報処理プログラムおよび情報処理システムに関する。 The present invention relates to an information processing device, an information processing method, an information processing program, and an information processing system.

上記技術分野において、特許文献1には、取得した映像情報に基づいて、映像情報に映し出されている者に関する感情情報を取得し、取得した音声情報に基づいて、文脈情報を取得する。そして、取得した感情情報および文脈情報に基づいて、メディア表現文書情報を生成する技術が開示されている。また、特許文献2には、魚眼レンズと無指向性マイクロフォンとを用いて、音源位置方向(話者方向)を判定し、音源位置方向の画像(話者人物像)を切り出して映像信号を生成する技術が開示されている。 In the above technical field, Japanese Patent Laid-Open No. 2002-200003 discloses a method for obtaining emotional information about a person displayed in the video information based on the obtained video information, and obtaining contextual information based on the obtained audio information. A technique is disclosed for generating media expression document information based on the acquired emotion information and context information. Further, in Patent Document 2, a fisheye lens and an omnidirectional microphone are used to determine the sound source position direction (speaker direction), and an image in the sound source position direction (speaker person image) is cut out to generate a video signal. Techniques are disclosed.

しかしながら、上記文献に記載の技術では、映像を見ている人が現場の臨場感を共有することができなかった。 However, with the technology described in the above document, the person watching the video cannot share the realism of the scene.

本発明の目的は、上述の課題を解決する技術を提供することにある。 An object of the present invention is to provide a technique for solving the above problems.

上記目的を達成するため、本発明に係る情報処理装置は、

所定エリアおよび少なくとも1人の被写体を撮像した映像を取得する映像取得手段と、

前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識手段と、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示手段と、

を備えた。In order to achieve the above object, an information processing device according to the present invention includes:

an image acquiring means for acquiring an image of a predetermined area and at least one subject;

information collecting means for collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

subject situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , display means for displayingon one of the display screens ;

provided.

上記目的を達成するため、本発明に係る情報処理方法は、

所定エリアおよび少なくとも1人の被写体を撮像した映像を取得する映像取得ステップと、

前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識ステップと、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示ステップと、

を含む。In order to achieve the above object, an information processing method according to the present invention comprises:

an image acquisition step of acquiring an image of a predetermined area and at least one subject;

an information collecting step of collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

a subject situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , a display step of displayingon one of the display screens ;

including.

上記目的を達成するため、本発明に係る情報処理プログラムは、

所定エリアおよび少なくとも1人の被写体を撮像した映像を取得する映像取得ステップと、

前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識ステップと、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示ステップと、

をコンピュータに実行させる。In order to achieve the above object, an information processing program according to the present invention comprises:

an image acquisition step of acquiring an image of a predetermined area and at least one subject;

an information collecting step of collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

a subject situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , a display step of displayingon one of the display screens ;

run on the computer.

上記目的を達成するため、本発明に係る情報処理システムは、

所定エリアおよび少なくとも1人の被写体の映像を撮像する撮像手段と、

前記撮像手段により撮像された前記被写体に関する被写体情報と、前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識手段と、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示手段と、

を備えた。In order to achieve the above object, an information processing system according to the present invention includes:

imaging means for capturing an image of a predetermined area and at least one subject;

information collecting means for collecting subject information about the subject imaged by the imaging means and surrounding environment information that is information on the surrounding environment of the subject;

subject situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , display means for displayingon one of the display screens ;

provided.

本発明によれば、映像を見ている人が現場の臨場感を共有することができる。 According to the present invention, people watching the video can share the realism of the scene.

以下に、本発明を実施するための形態について、図面を参照して、例示的に詳しく説明記載する。ただし、以下の実施の形態に記載されている、構成、数値、処理の流れ、機能要素などは一例に過ぎず、その変形や変更は自由であって、本発明の技術範囲を以下の記載に限定する趣旨のものではない。 BEST MODE FOR CARRYING OUT THE INVENTION Hereinafter, embodiments for carrying out the present invention will be exemplarily described in detail with reference to the drawings. However, the configuration, numerical values, process flow, functional elements, etc. described in the following embodiments are merely examples, and modifications and changes are free, and the technical scope of the present invention is not limited to the following description. It is not intended to be limited.

[第1実施形態]

本発明の第1実施形態としての情報処理装置100について、図1を用いて説明する。情報処理装置100は、撮像された映像に写っている被写体の状況を認識して表示する装置である。[First embodiment]

An

図1に示すように、情報処理装置100は、映像取得部101と、被写体情報収集部102と、状況認識部103と、表示部104と、を含む。 As shown in FIG. 1, the

映像取得部101は、所定エリアを撮像する撮像手段から映像を取得する。被写体情報収集部102は、撮像された映像に写っている被写体の被写体情報を収集する。状況認識部103は、被写体の映像および被写体情報に基づいて、被写体の状況を認識する。表示部104は、認識された状況を識別可能に表示する。 The

本実施形態によれば、映像を見ている人が現場の臨場感を共有することができる。 According to this embodiment, people watching the video can share the realism of the scene.

[第2実施形態]

次に本発明の第2実施形態に係る情報処理システムについて、図2乃至図6を用いて説明する。図2は、本実施形態に係る情報処理システムの構成の一例を説明するための図である。[Second embodiment]

Next, an information processing system according to a second embodiment of the present invention will be explained using FIGS. 2 to 6. FIG. FIG. 2 is a diagram for explaining an example of the configuration of the information processing system according to this embodiment.

情報処理システム200は、情報処理装置210、表示部220およびカメラ230を含む。また、情報処理システム200は、図示しない、音声情報取得センサ(マイク)やバイタルデータ取得センサ、環境情報取得センサなどの各種センサを含む。

情報処理システム200は、例えば、人が多く集まる集会会場やコンサート会場、病院、刑務所、一般家庭などにおいて、映像に写る被写体の状況を認識し、認識した状況を識別可能に表示することにより、映像を見ている人が現場の臨場感を共有することができるシステムである。また、情報処理システムは、カメラに写っている人の感情を表現するシステムであり、喜怒哀楽以上の感情を表現するシステムである。さらに、情報処理システム200は、多くの人が集まっているようなイベント会場や、設備の整っている病院ではなく、設備の整っていない在宅医療、多くの囚人をコントロールしなければならない刑務所、デモ行進などにも適用可能なシステムである。 The

情報処理装置210は、カメラ230が撮像した複数の被写体が存在する所定エリアの映像を取得し、取得した映像に写っている被写体の被写体情報を取得する。被写体情報は、例えば、音声情報やバイタルデータ、動作情報、表情情報などである。音声情報は、例えば、被写体の声や声紋、発話内容などである。バイタルデータは、例えば、体温や心拍、脈拍、空腹、のどの渇き、吐き気、尿意、痛み、瞳孔、脳波、指紋、呼吸数、発汗量、虹彩などを含む。動作情報は、例えば、被写体の動きに関する情報であり、被写体の行動などである。表情情報は、被写体の表情、顔の動き、目の動きなどである。 The

また、情報処理装置210は、被写体の周辺環境の情報を取得する。周辺環境情報は、例えば、被写体のいる場所の温度や湿度、震度、雑音の大きさ、照度、輝度、水位、水量、速度、角度、位置、熟成度、時間などである。 The

そして、情報処理装置210は、取得した映像および被写体情報に基づいて、被写体の状況を認識する。被写体の状況は、例えば、被写体の感情や心の動き、身体状態などである。 Then, the

表示部220は、表示領域221にカメラ230で撮像した映像と共に、被写体のバイタイルデータなどをグラフ化などして表示する。グラフなどは、例えば、カメラ230で撮像した映像に重畳して表示(例えば、AR(Augmented Reality)表示)し、カメラ230の映像を見ている人が視覚的に分かるように表示してもよい。 The

また、表示部220は、表示領域222に被写体の状況や感情を表示する。被写体の感情などは、例えば、テキストや絵文字などで表示されるが、被写体の感情の表示方法は、これらには限定されない。 The

さらに、表示部220は、表示領域223に被写体の会話情報として会話内容や発話内容を表示する。会話情報は、例えば、テキスト表示されるが、発話者ごとにテキストの大きさやフォントなどを変更してもよい。また、声の大きさに応じてテキストの大きさを変更してもよい。さらに、発話者ごとにテキストに色を付けてもよく、テキスト表示の方法は、これらには限定されない。また、表示部220は、表示領域224に被写体の付加情報を表示する。付加情報は、バイタルデータ:体温、心拍、脈拍、空腹、渇き、吐き気、尿意、痛み、行動、瞳孔、表情、脳波、生体情報(指紋、顔、声紋、虹彩)などを含む。 Furthermore, the

また、表示部220は、表示領域225に周辺環境情報を表示する。周辺環境情報は、温度、湿度、震度、雑音の大きさ、照度、輝度、水位、水量、速度、角度、位置、熟成度、時間などであり、これらの情報が表示される。なお、表示部220に表示する各種情報は、必要に応じてONまたはOFFすることができる。 The

情報処理システム200は、例えば、カメラ230で撮像した映像中に写っている被写体の状況などに変化があった場合、映像を見ている人物などにアラートを報知してもよい。 For example, the

図3は、本実施形態に係る情報処理システムに含まれる情報処理装置の構成を示すブロック図である。情報処理装置210は、映像取得部301、被写体情報収集部302、周辺環境情報取得部303、状況認識部304、表示部305およびアラート報知部306を有する。 FIG. 3 is a block diagram showing the configuration of an information processing device included in the information processing system according to this embodiment. The

映像取得部301は、カメラ230などの撮像デバイスが撮像した所定エリアの映像を取得する。カメラ230は、例えば、施設に取り付けられた防犯カメラや監視カメラなどが代表的であるが、これらには限定されない。 The

被写体情報収集部302は、カメラ230で撮像した映像に写っている被写体の被写体情報を収集する。被写体情報収集部302は、映像取得部301が取得した映像から、人物などの被写体を抽出し、抽出した被写体の被写体情報を収集する。被写体情報は、例えば、被写体の音声情報や生体情報、動作情報、表情情報である。音声情報は、被写体の声や声量、声紋、発話内容、会話内容などである。音声情報は、カメラ230に取り付けられたマイクや、施設に取り付けられたマイク、被写体の所持するスマートフォンなどの携帯端末のマイクから取得される。 A subject

また、生体情報は、いわゆるバイタルデータなどと呼ばれるものであり、例えば、体温、心拍、脈拍、空腹、のどの渇き、吐き気、尿意、痛み、呼吸数、脳波、発汗量などである。生体情報は、例えば、被写体が身に着けている時計型なメガネ型、肌着型などのウェアラブルデバイスや、医療機器などから取得されるが、生体情報の取得方法はこれには限定されない。 Biological information is so-called vital data, and includes, for example, body temperature, heart rate, pulse, hunger, thirst, nausea, urge to urinate, pain, respiration rate, electroencephalogram, and amount of perspiration. The biometric information is acquired, for example, from wearable devices such as watch-shaped glasses or underwear worn by the subject, medical equipment, or the like, but the biometric information acquisition method is not limited to this.

動作情報は、被写体の動きに関する情報であり、被写体がどのような動きをしているかに関する情報である。動作情報は、例えば、被写体が歩いているのか、座っているのか、走っているのか、止まっているのか、腕を動かしているのかなどに関する情報であるが、これらには限定されない。 The motion information is information about the movement of the subject, and information about how the subject is moving. The motion information is, for example, information about whether the subject is walking, sitting, running, standing still, or moving the arm, but is not limited to these.

さらに、表情情報は、被写体の表情や人相などに関する情報である。表情情報は、例えば、被写体の表情が、笑った表情か、怒った表情かなどに関する情報であるが、これらには限定されない。 Furthermore, facial expression information is information relating to the subject's facial expression, facial features, and the like. The facial expression information is, for example, information regarding whether the facial expression of the subject is a smiling facial expression or an angry facial expression, but is not limited to these.

これらの他にも被写体情報として、被写体の背格好や服装、性別、年齢、身長、髪型、メガネの有無などを含めてもよい。 In addition to these, subject information may include the subject's stature, clothing, sex, age, height, hairstyle, presence or absence of glasses, and the like.

周辺環境情報取得部303は、カメラ230で撮像した映像中の被写体の周辺環境に関する情報を取得する。周辺環境情報は、例えば、温度、湿度、震度、雑音の大きさ、照度、輝度、水位、水量、速度、角度、位置、熟成度、時間などである。周辺環境情報は、例えば、被写体が所持するスマートフォンやスマートウォッチなどの携帯端末や、被写体のいる施設に設置されたセンサ、その他のセンサ、赤外線カメラ、サーモグラフィーなどから取得されるが、取得方法はこれらには限定されない。 Surrounding environment

状況認識部304は、被写体の映像や被写体情報、被写体情報の変化情報などに基づいて、被写体の状況を認識する。例えば、体温や心拍などのバイタルデータの値と、バイタルデータの変化情報から、状況認識部304は、被写体の感情や心の動きなどを認識する。 The

また、状況認識部304は、バイタルデータ以外にも、温度や湿度、震度、雑音の大きさ、照度、輝度などの環境に関するパラメータを測定可能なセンサからの情報などから、被写体の状況を認識する。これらの情報によっても、被写体の感情や心の動きは推移するもと考えられ、これを踏まえて、状況認識部304は、被写体の状況を認識する。また、この他にも、状況認識部304は、被写体の表情の変化や動作の変化、発汗量の変化、音声の変化、環境情報の変化などに基づいて、被写体の状況を認識する。 In addition to the vital data, the

表示部305は、認識された状況を識別可能に表示する。例えば、表示部305は、認識した状況や感情、心の動きをテキストを含む何らかの形式で表現する。表示部305は、例えば、被写体が怒っている場合には、怒っていることが分かる形式で、被写体が平常心でいる場合には、平常心であることが分かる形式で、これらの状況を表現する。表示部305は、カメラ230が撮像した映像に、例えば、被写体の状況や被写体の発話内容、バイタイルデータ、周辺環境情報などを重畳して表示してもよい。 A

アラート報知部306は、認識した状況に基づいて、アラートを報知する。アラート報知部306は、例えば、表示部220を見ている人物などにアラートを報知する。アラート報知部306は、例えば、映像中の被写体である人物のバイタイルデータなどに異常を示す変化が現れた場合、その旨のアラートを報知してもよい。また、被写体の感情に変化があった場合、例えば、平常心であった被写体が突然激高した場合や、椅子に座っていた被写体が急な意識低下に見舞われた場合などに、その旨のアラートを報知してもよい。 The

アラートは、例えば、画面の点滅、アラートの内容を示すアイコンなどの表示、アラート内容を示すテキストの表示、アラーム音の発報、表示部220の振動、ランプの点滅、などにより行われる。 The alert is issued by, for example, blinking the screen, displaying an icon or the like indicating the content of the alert, displaying text indicating the content of the alert, issuing an alarm sound, vibrating the

なお、被写体の状況や感情、環境の変化などから、次に起こりうることを予測して、予防策や対策を報知して、例えば、映像を見ている人が、これらの予防策や対策などを実施してもよい。 In addition, it predicts what may happen next from the situation and emotions of the subject, changes in the environment, etc., and notifies preventive measures and countermeasures, for example, so that the person watching the video can understand these preventive measures and countermeasures. may be implemented.

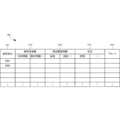

図4は、本実施形態に係る情報処理システムに含まれる情報処理装置が有する状況テーブルの一例を示す図である。状況テーブル401は、被写体ID(Identifier)411に対応付けて、被写体情報412、周辺環境情報413、状況414およびアラート415を記憶して保持する。 FIG. 4 is a diagram showing an example of a situation table held by an information processing device included in the information processing system according to this embodiment. The situation table 401 stores and holds

被写体ID411は、カメラ230が撮像した所定エリアの映像中の被写体を識別する識別子(識別情報)である。被写体情報412は、被写体に関する情報であり、例えば、被写体の生体情報や動作情報、音声情報、表情情報などである。周辺環境情報413は、被写体の周辺環境の情報であり、例えば、温度や湿度、震度、雑音の大きさ、照度、輝度などである。状況414は、被写体の状況を表し、例えば、被写体の感情や心の動きなどを表す。アラート415は、報知するアラートの内容である。 The

図5は、本実施形態に係る情報処理システムに含まれる情報処理装置210のハードウェア構成を説明するブロック図である。CPU(Central Processing Unit)510は、演算制御用のプロセッサであり、プログラムを実行することで図3の情報処理装置203の機能構成部を実現する。CPU510は複数のプロセッサを有し、異なるプログラムやモジュール、タスク、スレッドなどを並行して実行してもよい。ROM(Read Only Memory)520は、初期データおよびプログラムなどの固定データおよびその他のプログラムを記憶する。また、ネットワークインタフェース530は、ネットワークを介して他の装置などと通信する。なお、CPU510は1つに限定されず、複数のCPUであっても、あるいは画像処理用のGPU(Graphics Processing Unit)を含んでもよい。また、ネットワークインタフェース530は、CPU510とは独立したCPUを有して、RAM(Random Access Memory)540の領域に送受信データを書き込みあるいは読み出しするのが望ましい。また、RAM540とストレージ550との間でデータを転送するDMAC(Direct Memory Access Controller)を設けるのが望ましい(図示なし)。さらに、入出力インタフェース560は、CPU510とは独立したCPUを有して、RAM540の領域に入出力データを書き込みあるいは読み出しするのが望ましい。したがって、CPU510は、RAM540にデータが受信あるいは転送されたことを認識してデータを処理する。また、CPU510は、処理結果をRAM540に準備し、後の送信あるいは転送はネットワークインタフェース530やDMAC、あるいは入出力インタフェース560に任せる。 FIG. 5 is a block diagram illustrating the hardware configuration of the

RAM540は、CPU510が一時記憶のワークエリアとして使用するランダムアクセスメモリである。RAM540には、本実施形態の実現に必要なデータを記憶する領域が確保されている。被写体ID541は、カメラ230により撮像された映像中の被写体を識別するデータである。被写体情報542は、被写体に関する情報である。周辺環境情報543は、被写体の周辺環境に関する情報である。被写体状況544は、被写体の状況に関するデータである。アラート内容545は、報知するアラートに関するデータである。これらのデータや情報は、例えば、状況テーブル401から展開される。 A

入出力データ546は、入出力インタフェース560を介して入出力されるデータである。送受信データ547は、ネットワークインタフェース530を介して送受信されるデータである。また、RAM540は、各種アプリケーションモジュールを実行するためのアプリケーション実行領域548を有する。 The input/

ストレージ550には、データベースや各種のパラメータ、あるいは本実施形態の実現に必要な以下のデータまたはプログラムが記憶されている。ストレージ550は、状況テーブル401を格納する。状況テーブル401は、図4に示した、被写体ID411と、状況414などとの関係を管理するテーブルである。 The

ストレージ550は、さらに、映像取得モジュール551、被写体情報収集モジュール552、周辺環境情報取得モジュール553、状況認識モジュール554、表示モジュール555およびアラート報知モジュール556を格納する。 The

映像取得モジュール551は、カメラ230で撮像した所定エリアの映像を取得するモジュールである。被写体情報収集モジュール552は、カメラ230で撮像した映像中の被写体の情報を収集するモジュールである。周辺環境情報取得モジュール553は、被写体の周辺環境の情報を取得するモジュールである。状況認識モジュール554は、被写体の映像や被写体情報、周辺環境情報に基づいて、被写体の状況を認識する。表示モジュール555は、認識された被写体の状況を識別可能に表示するモジュールである。アラート報知モジュール556は、認識された状況に基づいて、アラートを報知するモジュールである。これらのモジュール551~556は、CPU510によりRAM540のアプリケーション実行領域548に読み出され、実行される。制御プログラム557は、情報処理装置210の全体を制御するためのプログラムである。 The

入出力インタフェース560は、入出力機器との入出力データをインタフェースする。入出力インタフェース560には、表示部561、操作部562、が接続される。また、入出力インタフェース560には、さらに、記憶媒体564が接続されてもよい。さらに、音声出力部であるスピーカ563や、音声入力部であるマイク(図示せず)、あるいは、GPS位置判定部が接続されてもよい。なお、図5に示したRAM540やストレージ550には、情報処理装置210が有する汎用の機能や他の実現可能な機能に関するプログラムやデータは図示されていない。 The input/

図6は、本実施形態に係る情報処理装置210の処理手順を説明するフローチャートである。このフローチャートは、図5のCPU510がRAM540を使用して実行し、図3の情報処理装置210の機能構成部を実現する。 FIG. 6 is a flowchart for explaining the processing procedure of the

ステップS601において、情報処理装置210は、カメラ230が撮像した所定エリアの映像を取得する。ステップS603において、情報処理装置210は、撮像された映像中の被写体の被写体情報を収集する。ステップS605において、情報処理装置210は、被写体の周辺環境の情報である周辺環境情報を取得する。ステップS607において、情報処理装置210は、被写体の映像、被写体情報および周辺環境情報に基づいて、被写体の状況を認識する。 In step S<b>601 , the

ステップS609において、情報処理装置210は、認識した状況を表示する。ステップS611において、情報処理装置210は、認識した情報に基づいて、アラートの報知が必要か否かを判断する。アラートの報知が必要ない場合(ステップS611のNO)、情報処理装置210は、処理を終了する。アラートの報知が必要な場合(ステップS611のYES)、情報処理装置210は、ステップS613へ進む。ステップS613において、情報処理装置210は、所定の報知方法でアラートを報知する。 In step S609, the

本実施形態によれば、映像を見ている人が現場の臨場感や現場の状況を共有することができる。また、映像を見ている人が、被写体の状況を把握したり、共有したりすることができる。さらにまた、途中から映像を見た人物であっても、現場の臨場感などを共有することができる。さらに、アラートを報知するので、映像を見ている人がアラートに従って現場で起こっている事態に対して対処することができる。 According to the present embodiment, the people watching the video can share the presence of the site and the situation of the site. Also, a person viewing the video can grasp and share the situation of the subject. Furthermore, even a person who has watched the video in the middle can share the realism of the scene. Furthermore, since an alert is issued, the person watching the video can respond to the situation occurring at the site according to the alert.

[第3実施形態]

次に本発明の第3実施形態に係る情報処理システムについて、図7を用いて説明する。図7は、本実施形態に係る情報処理システムの構成を説明するための図である。本実施形態に係る情報処理システムは、上記第2実施形態と比べると、会議システムに情報処理システムを適用した点で異なる。その他の構成および動作は、第2実施形態と同様であるため、同じ構成および動作については同じ符号を付してその詳しい説明を省略する。[Third embodiment]

Next, an information processing system according to a third embodiment of the present invention will be explained using FIG. FIG. 7 is a diagram for explaining the configuration of the information processing system according to this embodiment. The information processing system according to this embodiment differs from the second embodiment in that the information processing system is applied to a conference system. Since other configurations and operations are similar to those of the second embodiment, the same configurations and operations are denoted by the same reference numerals, and detailed description thereof will be omitted.

情報処理システム(会議システム)700は、マイクスピーカ付端末701,702から会議における参加者の発話や会話などの音声情報を取得する。また、情報処理システム700は、各種センサ703から、会議中の映像や、会議参加者のバイタイルデータや、会議室内の環境データなどを取得する。 An information processing system (conference system) 700 acquires voice information such as utterances and conversations of participants in a conference from

情報処理システム700は、マイクスピーカ付端末701,702のマイクからの音声情報をもとに、声紋認識などにより話者を特定する。または、カメラからの映像の情報をもとに、顔認証などにより話者を特定する。あるいは、声紋認証と顔認証とを組み合わせて話者を特定してもよい。 The

また、例えば、1つのマイクスピーカ付端末701を会議参加者で共有している場合には、各種センサ703として360度カメラや魚眼レンズ付カメラなどの映像を合わせて総合的に判断することで、より高い精度で話者を特定できる。例えば、カメラの映像から会議参加者の口の動きの認証や、顔認証、発言者の方向の特定などを行い、マイクで収集した音声から声紋などを判定するなど、複数の情報を総合的に判断することにより、各発話や会話に対して、より高い精度で話者を特定することができる。 In addition, for example, when one

情報処理システム700は、例えば、マイクスピーカ付端末701,702や各種センサ703からの情報をもとに、特定した話者と発言内容(発話内容)とをセットでテキスト化する。なお、テキスト化は端末704にインストールされたアプリケーションで行ってもよい。このように、端末704にインストールされたアプリケーションでテキスト化を行うと、ネットワークを経由する前の音声情報を入力とすることができるので、テキスト化の精度を上げることができる。 The

そして、情報処理システム700は、会話解析(発話解析)を行い、会議中の情景を思い浮かべられるような会話の付加情報(力強い、弱い、笑、怒り、悲しみなど)も合わせてテキストで表現する。このようにすることにより、マイクやスピーカなしで会議に参加している人物も会議の内容、臨場感などを共有することができる。 Then, the

また、情報処理システム700は、マイク、スピーカ以外にも、各種センサ703、例えば、温度、湿度、雑音、奇声、バイタル情報、計測器などの変化や動きを付加することで、会議室以外の場所においても、その場所にいない人が臨場感を共有できる。 In addition to microphones and speakers, the

また、マイクやスピーカの無い環境において、端末704を用いて、テキストで会議に参加している人物がテキスト入力した内容を音声合成で各参加者のスピーカに流してもよい。 Further, in an environment without a microphone or a speaker, the terminal 704 may be used to output text input by a person who participates in the conference by speech synthesis to the speaker of each participant.

会議室以外の場所としては、例えば、設備の整っている病院ではなく、在宅医療などの設備の不十分な環境においても、その場にいない人が臨場感を共有することができる。 As a place other than a conference room, for example, even in an environment with insufficient facilities such as home medical care, instead of a well-equipped hospital, people who are not present can share a sense of reality.

その他に、情報処理システム700は、話者特定ができているので、テキスト化した内容を会議の議事録として記録することができる。また、情報処理システム700は、記録した議事録を会議参加者にメールなどで送信することにより、アクティブなフォローをすることができる。 In addition, since the

また、発話内容などをテキスト化するのでテキスト化した内容をリアルタイムまたは事後的に翻訳することもできる。これにより、議事録入手希望者の希望する言語の議事録を作成することも可能となる。 In addition, since the utterance content is converted into text, the text content can be translated in real time or after the fact. As a result, it is possible to prepare the minutes in the language desired by the person who wishes to obtain the minutes.

さらに、情報処理システム700は、テキスト化された発話内容を解析することにより、発話内容に応じたアクションを自動的に行うことができる。情報処理システム700は、商品の発注や各種調整、検索、回答、アラーム、発信、停止などを自動的に行うことができる。情報処理システム700は、例えば、「302号室にタオルを至急運ぶ」といった内容のアラートを担当者に対して報知することができる。 Further, the

本実施形態によれば、会議に参加していない人も、会議現場の臨場感を共有することができる。また、途中から会議に参加した場合でも、会議現場の臨場感などを共有することができる。さらに、設備の整っている病院ではなく、在宅医療などの設備の不十分な環境においても、映像を見ている人物が、被写体の状況や現場の臨場感を共有することができる。また、コンサート会場や刑務所、デモ行進などのように多くの人が集まるような状況において、その場にいない人物や、映像を見ている人物が参加者の状況や現場の臨場感を共有することができる。 According to this embodiment, even those who are not participating in the conference can share the presence of the conference site. In addition, even if participants join the conference midway through, they can share the realism of the conference site. Furthermore, even in an environment with insufficient facilities such as home medical care, instead of a well-equipped hospital, the person watching the video can share the situation of the subject and the realism of the scene. Also, in situations where many people gather, such as concert venues, prisons, and demonstration marches, people who are not there or who are watching the video can share the situation of the participants and the presence of the scene. can be done.

[他の実施形態]

以上、実施形態を参照して本願発明を説明したが、本願発明は上記実施形態に限定されるものではない。本願発明の構成や詳細には、本願発明のスコープ内で当業者が理解し得る様々な変更をすることができる。また、それぞれの実施形態に含まれる別々の特徴を如何様に組み合わせたシステムまたは装置も、本発明の範疇に含まれる。[Other embodiments]

Although the present invention has been described with reference to the embodiments, the present invention is not limited to the above embodiments. Various changes that can be understood by those skilled in the art can be made to the configuration and details of the present invention within the scope of the present invention. Also, any system or apparatus that combines separate features included in each embodiment is also included in the scope of the present invention.

また、本発明は、複数の機器から構成されるシステムに適用されてもよいし、単体の装置に適用されてもよい。さらに、本発明は、実施形態の機能を実現する情報処理プログラムが、システムあるいは装置に直接あるいは遠隔から供給される場合にも適用可能である。したがって、本発明の機能をコンピュータで実現するために、コンピュータにインストールされるプログラム、あるいはそのプログラムを格納した媒体、そのプログラムをダウンロードさせるWWW(World Wide Web)サーバも、本発明の範疇に含まれる。特に、少なくとも、上述した実施形態に含まれる処理ステップをコンピュータに実行させるプログラムを格納した非一時的コンピュータ可読媒体(non-transitory computer readable medium)は本発明の範疇に含まれる。 Further, the present invention may be applied to a system composed of a plurality of devices, or may be applied to a single device. Furthermore, the present invention is also applicable when an information processing program that implements the functions of the embodiments is directly or remotely supplied to a system or apparatus. Therefore, in order to implement the functions of the present invention on a computer, a program installed in a computer, a medium storing the program, and a WWW (World Wide Web) server from which the program is downloaded are also included in the scope of the present invention. . In particular, non-transitory computer readable media storing programs that cause a computer to perform at least the processing steps included in the above-described embodiments are included within the scope of the present invention.

[実施形態の他の表現]

上記の実施形態の一部または全部は、以下の付記のようにも記載されうるが、以下には限られない。

(付記1)

所定エリアを撮像する撮像手段から映像を取得する映像取得手段と、

撮像された映像に写っている被写体の被写体情報を収集する被写体情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する状況認識手段と、

認識された前記状況を識別可能に表示する表示手段と、

を備えた情報処理装置。

(付記2)

前記被写体の周辺環境の情報である周辺環境情報を取得する周辺環境情報取得手段をさらに備え、

前記状況認識手段は、さらに、前記周辺環境情報に基づいて、前記被写体の状況を認識する付記1に記載の情報処理装置。

(付記3)

前記周辺環境情報は、温度、湿度、震度、雑音の大きさ、照度および輝度のうち少なくとも1つを含む付記2に記載の情報処理装置。

(付記4)

認識された前記状況に基づいて、アラートを報知するアラート報知手段をさらに備える付記1乃至3のいずれか1項に記載の情報処理装置。

(付記5)

前記被写体情報は、前記被写体の音声情報、生体情報、動作情報および表情情報のうち少なくとも1つを含む付記1乃至4のいずれか1項に記載の情報処理装置。

(付記6)

生体情報は、体温、心拍、脈拍、空腹、のどの渇き、吐き気、尿意、痛み、呼吸数、脳波、発汗量のうち少なくとも1つを含む付記5に記載の情報処理装置。

(付記7)

前記状況は、少なくとも前記被写体の感情を含む付記1乃至6のいずれか1項に記載の情報処理装置。

(付記8)

前記表示手段は、前記状況を表すテキストを表示する付記1乃至7のいずれか1項に記載の情報処理装置。

(付記9)

所定エリアを撮像する撮像手段から映像を取得する映像取得ステップと、

撮像された映像に写っている被写体の被写体情報を収集する被写体情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する状況認識ステップと、

認識された前記状況を識別可能に表示する表示ステップと、

を含む情報処理方法。

(付記10)

所定エリアを撮像する撮像手段から映像を取得する映像取得ステップと、

撮像された映像に写っている被写体の被写体情報を収集する被写体情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する状況認識ステップと、

認識された前記状況を識別可能に表示する表示ステップと、

をコンピュータに実行させる情報処理プログラム。

(付記11)

所定エリアの映像を撮像する撮像手段と、

前記撮像手段により撮像された所定エリアの映像に含まれる被写体の被写体情報を収集する被写体情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する状況認識手段と、

認識された前記状況を識別可能に表示する表示手段と、

を備えた情報処理システム。[Other expressions of the embodiment]

Some or all of the above embodiments can also be described as the following additional remarks, but are not limited to the following.

(Appendix 1)

an image acquiring means for acquiring an image from an imaging means for imaging a predetermined area;

subject information collecting means for collecting subject information of a subject appearing in a captured image;

situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

display means for identifiably displaying the recognized situation;

Information processing device with

(Appendix 2)

Further comprising surrounding environment information acquisition means for acquiring surrounding environment information, which is information on the surrounding environment of the subject,

The information processing apparatus according to appendix 1, wherein the situation recognition means further recognizes the situation of the subject based on the surrounding environment information.

(Appendix 3)

2. The information processing apparatus according to appendix 2, wherein the surrounding environment information includes at least one of temperature, humidity, seismic intensity, noise level, illuminance and brightness.

(Appendix 4)

4. The information processing apparatus according to any one of appendices 1 to 3, further comprising alert reporting means for reporting an alert based on the recognized situation.

(Appendix 5)

5. The information processing apparatus according to any one of appendices 1 to 4, wherein the subject information includes at least one of voice information, biological information, motion information, and facial expression information of the subject.

(Appendix 6)

6. The information processing apparatus according to appendix 5, wherein the biological information includes at least one of body temperature, heartbeat, pulse, hunger, thirst, nausea, urge to urinate, pain, respiratory rate, brain wave, and amount of perspiration.

(Appendix 7)

7. The information processing apparatus according to any one of appendices 1 to 6, wherein the situation includes at least the emotion of the subject.

(Appendix 8)

8. The information processing apparatus according to any one of appendices 1 to 7, wherein the display means displays text representing the situation.

(Appendix 9)

an image acquisition step of acquiring an image from imaging means for imaging a predetermined area;

a subject information collecting step of collecting subject information of a subject appearing in the imaged video;

a situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

a display step of identifiably displaying the recognized situation;

Information processing method including.

(Appendix 10)

an image acquisition step of acquiring an image from imaging means for imaging a predetermined area;

a subject information collecting step of collecting subject information of a subject appearing in the imaged video;

a situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

a display step of identifiably displaying the recognized situation;

An information processing program that causes a computer to execute

(Appendix 11)

imaging means for capturing an image of a predetermined area;

subject information collection means for collecting subject information of a subject included in the image of the predetermined area captured by the imaging means;

situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

display means for identifiably displaying the recognized situation;

Information processing system with

Claims (10)

Translated fromJapanese前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識手段と、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示手段と、

を備えた情報処理装置。an image acquiring means for acquiring an image of a predetermined area and at least one subject;

information collecting means for collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

subject situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , display means for displayingon one of the display screens ;

Information processing device with

前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識ステップと、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示ステップと、

を含む情報処理方法。an image acquisition step of acquiring an image of a predetermined area and at least one subject;

an information collecting step of collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

a subject situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , a display step of displayingon one of the display screens ;

Information processing method including.

前記被写体に関する被写体情報と前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集ステップと、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識ステップと、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示ステップと、

をコンピュータに実行させる情報処理プログラム。an image acquisition step of acquiring an image of a predetermined area and at least one subject;

an information collecting step of collecting subject information about the subject and surrounding environment information that is information about the surrounding environment of the subject;

a subject situation recognition step of recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , a display step of displayingon one of the display screens ;

An information processing program that causes a computer to execute

前記撮像手段により撮像された前記被写体に関する被写体情報と、前記被写体の周辺環境の情報である周辺環境情報とを収集する情報収集手段と、

前記被写体の映像および前記被写体情報に基づいて、前記被写体の状況を認識する被写体状況認識手段と、

表示画面を見ている人が前記所定エリアの臨場感を共有できるように、前記被写体の映像を含む前記所定エリアの映像と、前記被写体の状況と、前記被写体情報と、前記周辺環境情報とを、1つの前記表示画面に表示する表示手段と、

を備えた情報処理システム。imaging means for capturing an image of a predetermined area and at least one subject;

information collecting means for collecting subject information about the subject imaged by the imaging means and surrounding environment information that is information on the surrounding environment of the subject;

subject situation recognition means for recognizing the situation of the subject based on the image of the subject and the subject information;

The image of the predetermined area including the image of the subject, the situation of the subject, the subject information, and the surrounding environment information are displayed so that the viewers of the display screen can share the presence of the predetermined area. , display means for displayingon one of the display screens ;

Information processing system with

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2021183024AJP7306439B2 (en) | 2017-03-30 | 2021-11-10 | Information processing device, information processing method, information processing program and information processing system |

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2017068440AJP2018170714A (en) | 2017-03-30 | 2017-03-30 | Information processing device, information processing method, information processing program, and information processing system |

| JP2021183024AJP7306439B2 (en) | 2017-03-30 | 2021-11-10 | Information processing device, information processing method, information processing program and information processing system |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2017068440ADivisionJP2018170714A (en) | 2017-03-30 | 2017-03-30 | Information processing device, information processing method, information processing program, and information processing system |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2022028769A JP2022028769A (en) | 2022-02-16 |

| JP7306439B2true JP7306439B2 (en) | 2023-07-11 |

Family

ID=87072542

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2021183024AActiveJP7306439B2 (en) | 2017-03-30 | 2021-11-10 | Information processing device, information processing method, information processing program and information processing system |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP7306439B2 (en) |

Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2006326184A (en) | 2005-05-30 | 2006-12-07 | Nippon Telegr & Teleph Corp <Ntt> | Psychological state analyzer |

| JP2007129312A (en) | 2005-11-01 | 2007-05-24 | Sekisui Chem Co Ltd | Interphone system |

| JP2009288446A (en) | 2008-05-28 | 2009-12-10 | Nippon Telegr & Teleph Corp <Ntt> | Karaoke video editing device, method and program |

| JP2013239914A (en) | 2012-05-15 | 2013-11-28 | Nikon Corp | Imaging device |

| US20140247343A1 (en) | 2013-03-04 | 2014-09-04 | Alex C. Chen | Method and apparatus for sensing and displaying information |

| WO2016170810A1 (en) | 2015-04-23 | 2016-10-27 | ソニー株式会社 | Information processing device, control method, and program |

- 2021

- 2021-11-10JPJP2021183024Apatent/JP7306439B2/enactiveActive

Patent Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2006326184A (en) | 2005-05-30 | 2006-12-07 | Nippon Telegr & Teleph Corp <Ntt> | Psychological state analyzer |

| JP2007129312A (en) | 2005-11-01 | 2007-05-24 | Sekisui Chem Co Ltd | Interphone system |

| JP2009288446A (en) | 2008-05-28 | 2009-12-10 | Nippon Telegr & Teleph Corp <Ntt> | Karaoke video editing device, method and program |

| JP2013239914A (en) | 2012-05-15 | 2013-11-28 | Nikon Corp | Imaging device |

| US20140247343A1 (en) | 2013-03-04 | 2014-09-04 | Alex C. Chen | Method and apparatus for sensing and displaying information |

| WO2016170810A1 (en) | 2015-04-23 | 2016-10-27 | ソニー株式会社 | Information processing device, control method, and program |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2022028769A (en) | 2022-02-16 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| Zhou et al. | Tackling mental health by integrating unobtrusive multimodal sensing | |

| CN109475294A (en) | Mobile and wearable video capture and feedback platform for the treatment of mental disorders | |

| CN109155837A (en) | A kind of wearable TeleConference Bridge of mood sensing | |

| JP2020057111A (en) | Facial expression determination system, program and facial expression determination method | |

| JP2020113197A (en) | Information processing apparatus, information processing method, and information processing program | |

| JP7266984B2 (en) | Server equipment | |

| US20220067353A1 (en) | System and method for reading and analysing behaviour including verbal, body language and facial expressions in order to determine a person's congruence | |

| JP7306152B2 (en) | Emotion estimation device, emotion estimation method, program, information presentation device, information presentation method, and emotion estimation system | |

| US20220383896A1 (en) | System and method for collecting behavioural data to assist interpersonal interaction | |

| JP2015092646A (en) | Information processing device, control method, and program | |

| US20240251121A1 (en) | Focus group apparatus and system | |

| JP2019175108A (en) | Emotional information management server device, emotional information management method, program, terminal device, and information communication system | |

| CN112998707B (en) | Monitoring system for monitoring a patient and method for operating a monitoring system | |

| US20220101873A1 (en) | Techniques for providing feedback on the veracity of spoken statements | |

| US11227148B2 (en) | Information processing apparatus, information processing method, information processing program, and information processing system | |

| CN113468488A (en) | Remote examination system and method | |

| JP7306439B2 (en) | Information processing device, information processing method, information processing program and information processing system | |

| US20250021693A1 (en) | Techniques for de-identifying sensor data captured in a medical facility room | |

| WO2022230139A1 (en) | Video analysis system | |

| Akshay et al. | ialert: An alert system based on eye gaze for human assistance | |

| WO2023119526A1 (en) | Wearable device and behavior evaluation system | |

| CN115813343A (en) | Child behavior abnormity evaluation method and system | |

| El Kaliouby et al. | iSET: interactive social-emotional toolkit for autism spectrum disorder | |

| US20210142047A1 (en) | Salient feature extraction using neural networks with temporal modeling for real time incorporation (sentri) autism aide | |

| CN114980814A (en) | Information processing method, computer program, information processing apparatus, and information processing system |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20211110 | |

| A977 | Report on retrieval | Free format text:JAPANESE INTERMEDIATE CODE: A971007 Effective date:20221124 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20221206 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20230131 | |

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 Effective date:20230530 | |

| A61 | First payment of annual fees (during grant procedure) | Free format text:JAPANESE INTERMEDIATE CODE: A61 Effective date:20230612 | |

| R151 | Written notification of patent or utility model registration | Ref document number:7306439 Country of ref document:JP Free format text:JAPANESE INTERMEDIATE CODE: R151 |