JP6497651B2 - Speech recognition apparatus and speech recognition program - Google Patents

Speech recognition apparatus and speech recognition programDownload PDFInfo

- Publication number

- JP6497651B2 JP6497651B2JP2015055977AJP2015055977AJP6497651B2JP 6497651 B2JP6497651 B2JP 6497651B2JP 2015055977 AJP2015055977 AJP 2015055977AJP 2015055977 AJP2015055977 AJP 2015055977AJP 6497651 B2JP6497651 B2JP 6497651B2

- Authority

- JP

- Japan

- Prior art keywords

- phrase

- speech

- recognition

- registered

- hmm

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000000605extractionMethods0.000claimsdescription60

- 238000000034methodMethods0.000claimsdescription53

- 230000008569processEffects0.000claimsdescription31

- 238000012545processingMethods0.000claimsdescription31

- 238000003860storageMethods0.000claimsdescription27

- 238000004364calculation methodMethods0.000description20

- 230000001186cumulative effectEffects0.000description19

- 239000013598vectorSubstances0.000description7

- 238000001514detection methodMethods0.000description5

- 238000010586diagramMethods0.000description4

- 238000009826distributionMethods0.000description4

- 238000002474experimental methodMethods0.000description4

- 230000006870functionEffects0.000description4

- 230000005236sound signalEffects0.000description4

- 238000004891communicationMethods0.000description3

- 239000000284extractSubstances0.000description3

- 239000011159matrix materialSubstances0.000description3

- 238000004458analytical methodMethods0.000description2

- 230000007704transitionEffects0.000description2

- 238000009825accumulationMethods0.000description1

- 230000008859changeEffects0.000description1

- 230000000052comparative effectEffects0.000description1

- 238000007796conventional methodMethods0.000description1

- 238000005520cutting processMethods0.000description1

- 230000007423decreaseEffects0.000description1

- 238000007562laser obscuration time methodMethods0.000description1

- 238000004519manufacturing processMethods0.000description1

- 238000012986modificationMethods0.000description1

- 230000004048modificationEffects0.000description1

- 230000003287optical effectEffects0.000description1

Images

Landscapes

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

Description

Translated fromJapanese本発明は、音声認識装置および音声認識プログラムに関し、特に、孤立単語認識方式により音声認識を行う音声認識装置および音声認識プログラムに関する。 The present invention relates to a speech recognition apparatus and a speech recognition program, and more particularly to a speech recognition apparatus and speech recognition program that perform speech recognition using an isolated word recognition method.

一般的に、特定話者対応の音声認識装置では、特定話者の少ない発話音声の特徴量から得られるパターンデータが用いられる。これに対し、不特定話者対応の音声認識装置では、多数の教師音声の特徴量から生成されたモデルパラメータが用いられる。前者のパターンデータを用いた音声認識手法の代表例として、DTW(Dynamic Time Warping)アルゴリズムが挙げられる。後者のモデルパラメータを用いた音声認識手法の代表例としては、HMM(Hidden Markov Model)法が挙げられる。 In general, in a speech recognition apparatus corresponding to a specific speaker, pattern data obtained from a feature amount of uttered speech with few specific speakers is used. On the other hand, in the speech recognition apparatus for unspecified speakers, model parameters generated from a large number of feature amounts of teacher speech are used. A typical example of the voice recognition method using the former pattern data is a DTW (Dynamic Time Warping) algorithm. A typical example of the speech recognition method using the latter model parameter is an HMM (Hidden Markov Model) method.

モデルパラメータを用いて音声認識を行う装置において、ユーザにより連続的に発話されたフレーズ群の音声を認識可能とするために、次のような技術が提案されている。 In an apparatus for performing speech recognition using model parameters, the following techniques have been proposed in order to enable recognition of speech of a phrase group continuously spoken by a user.

たとえば特開2008−116744号公報(特許文献1)には、連続音声認識装置の従来例として、探索処理部において、音響モデルと言語モデルを用いて、入力音声の特徴量ベクトルの時系列と文法で許容される単語列の仮説が照合されることが開示されている。具体的には、文法で規定された単語の接続関係を示す単語ネットワークで許容される仮説に対応した音響モデルと特徴量ベクトルの時系列をフレーム単位で照合し、音響的な尤もらしさを示す音響スコアを求めると同時に、その仮説に対応した言語モデルから言語スコアを求め、音響スコアと言語スコアからなる仮説のスコアを、入力音声の始端から終端まで各仮説について求め、最もスコアの大きい仮説、つまり入力音声に最も近い仮説を認識結果として出力することが開示されている。 For example, in Japanese Patent Laid-Open No. 2008-116744 (Patent Document 1), as a conventional example of a continuous speech recognition apparatus, a search processing unit uses an acoustic model and a language model, and a time series and a grammar of a feature vector of input speech. It is disclosed that a hypothesis of a word string that is allowed is collated. Specifically, the acoustic model corresponding to the hypothesis allowed by the word network that indicates the connection relationship of the words specified in the grammar and the time series of the feature vectors are collated in units of frames, and the acoustic likelihood is shown. At the same time as obtaining the score, the language score is obtained from the language model corresponding to the hypothesis, the hypothesis score consisting of the acoustic score and the language score is obtained for each hypothesis from the beginning to the end of the input speech, and the hypothesis with the highest score, that is, It is disclosed that a hypothesis closest to the input speech is output as a recognition result.

また、特開2014−44363号公報(特許文献2)には、自由な連続発話を認識対象とする音声認識装置においては、辞書・言語モデル格納部に登録されている単語のN連鎖確率を保持しているN−gramモデルが用いられ、これによりN連鎖以下の単語のつながり易さが言語尤度として計算されることが開示されている。 Japanese Patent Laying-Open No. 2014-44363 (Patent Document 2) describes the N-chain probabilities of words registered in a dictionary / language model storage unit in a speech recognition apparatus that recognizes free continuous utterances. The N-gram model is used, and it is disclosed that the ease of connection of words below the N chain is calculated as the language likelihood.

上記した従来の技術では、複数の登録単語が連続的に発話されたフレーズ群の音声を認識する場合、上記特許文献1の「文法」や特許文献2の「N−gramモデル」のように、発話された単語(登録単語)間の繋がりが考慮されている。したがって、連続的に発話された単語間に繋がりがない場合、発話音声を適切に認識するのは困難であった。 In the conventional technique described above, when recognizing the speech of a phrase group in which a plurality of registered words are continuously spoken, as in the “grammar” of

本発明は、上記のような課題を解決するためになされたものであって、その目的は、連続的に発話された単語間に繋がりのない場合であっても、発話音声を適切に認識することのできる音声認識装置および音声認識プログラムを提供することである。 The present invention has been made to solve the above-described problems, and its purpose is to appropriately recognize the spoken voice even when there is no connection between continuously spoken words. It is to provide a voice recognition device and a voice recognition program.

この発明のある局面に従う音声認識装置は、記憶手段と、音声入力手段と、推定手段とを備える。記憶手段は、認識可能な複数の登録単語のモデルパラメータから復元された、複数の登録単語それぞれのテンプレート特徴量列を記憶する。音声入力手段は、登録単語が連続的に発話されたフレーズ群の音声を入力する。推定手段は、音声入力手段に入力された音声の特徴量に基づいて、フレーズ群に含まれる登録単語を推定する。推定手段は、記憶手段に記憶された複数の登録単語それぞれのテンプレート特徴量列と、認識対象区間内の音声の特徴量列とを照合させることによって、登録単語候補を抽出する候補抽出手段を含む。 A speech recognition apparatus according to an aspect of the present invention includes a storage unit, a speech input unit, and an estimation unit. The storage means stores a template feature amount sequence of each of the plurality of registered words restored from the model parameters of the plurality of registered words that can be recognized. The voice input means inputs a voice of a phrase group in which registered words are continuously spoken. The estimation means estimates a registered word included in the phrase group based on the feature amount of the voice input to the voice input means. The estimation means includes candidate extraction means for extracting registered word candidates by collating a template feature quantity sequence of each of a plurality of registered words stored in the storage means with a speech feature quantity sequence in the recognition target section. .

好ましくは、記憶手段は、複数の登録単語のモデルパラメータを予め記憶している。この場合、推定手段は、モデルパラメータを用いた認識処理によって、候補抽出手段により抽出された登録単語候補の音声区間内の特徴量に基づき登録単語を推定する認識処理手段をさらに含むことが望ましい。 Preferably, the storage means stores in advance model parameters of a plurality of registered words. In this case, it is desirable that the estimation unit further includes a recognition processing unit that estimates a registered word based on a feature amount in a speech section of the registered word candidate extracted by the candidate extraction unit by a recognition process using a model parameter.

また、音声認識装置は、記憶手段に記憶されたモデルパラメータから、複数の登録単語それぞれの特徴パターンを算出し、登録単語ごとにテンプレート特徴量列を復元する復元手段をさらに備えていてもよい。 The speech recognition apparatus may further include a restoring unit that calculates a feature pattern for each of a plurality of registered words from the model parameters stored in the storage unit, and restores a template feature amount sequence for each registered word.

復元手段は、算出した特徴パターンに対して補間処理を行うことにより、テンプレート特徴量列を復元してもよい。 The restoration unit may restore the template feature quantity sequence by performing an interpolation process on the calculated feature pattern.

好ましくは、候補抽出手段は、モデルパラメータに含まれるばらつき情報に基づいて重み付けを行って、登録単語候補を抽出する。 Preferably, the candidate extraction unit performs weighting based on variation information included in the model parameter to extract a registered word candidate.

好ましくは、音声認識装置は、推定手段により単語が推定された場合に、推定された単語を認識結果として受理するか否かの受理判定を行う受理判定手段と、受理判定手段により受理された単語を出力する出力手段と、受理判定手段により受理された単語の音声区間を認識対象区間から削除することによって、認識対象区間を更新する更新手段とをさらに備える。 Preferably, when the word is estimated by the estimation unit, the speech recognition apparatus accepts the estimated word as a recognition result, and accepts the acceptance determination unit for accepting whether the estimated word is accepted as a recognition result. And an update means for updating the recognition target section by deleting the speech section of the word accepted by the acceptance determining means from the recognition target section.

この発明のある局面に従う音声認識プログラムは、登録単語が連続的に発話されたフレーズ群の音声を入力するステップと、入力された音声の特徴量に基づいて、フレーズ群に含まれる登録単語を推定する推定ステップとを備える。推定ステップは、認識可能な複数の登録単語のモデルパラメータから復元された、複数の登録単語それぞれのテンプレート特徴量列と、認識対象区間内の音声の特徴量列とを照合させることによって、登録単語候補を抽出するステップを含む。 The speech recognition program according to an aspect of the present invention estimates a registered word included in a phrase group based on a step of inputting speech of a phrase group in which registered words are continuously uttered and a feature amount of the input speech And an estimating step. The estimation step includes registering the registered word by collating the template feature amount sequence of each of the plurality of registered words restored from the model parameters of the plurality of recognizable registered words with the speech feature amount sequence in the recognition target section. Extracting a candidate.

本発明によれば、連続的に発話された単語間に繋がりのない場合であっても、発話音声を適切に認識することができる。 According to the present invention, even when there is no connection between words that are continuously spoken, it is possible to appropriately recognize the spoken voice.

本発明の実施の形態について図面を参照しながら詳細に説明する。なお、図中同一または相当部分には同一符号を付してその説明は繰返さない。 Embodiments of the present invention will be described in detail with reference to the drawings. In the drawings, the same or corresponding parts are denoted by the same reference numerals and description thereof will not be repeated.

<概要について>

本実施の形態に係る音声認識装置は、孤立単語認識方式を採用し、音声信号を分析することで、複数の登録単語から、音声信号が表わす単語を推定して出力する。この音声認識装置は、複数の登録単語が連続的に発話された音声(以下「連続的音声」という)の認識を可能としている。<About overview>

The speech recognition apparatus according to the present embodiment employs an isolated word recognition method and analyzes a speech signal to estimate and output a word represented by the speech signal from a plurality of registered words. This speech recognition apparatus can recognize speech in which a plurality of registered words are continuously spoken (hereinafter referred to as “continuous speech”).

本実施の形態に係る音声認識装置は、典型的には不特定話者対応の装置であり、各登録単語のモデルパラメータを用いて、発話音声を認識する。具体的には、HMM法に基づいて登録単語の認識を行う。そのため、後の説明においては、「登録単語」を「HMMフレーズ」と記している。 The speech recognition device according to the present embodiment is typically a device that supports unspecified speakers, and recognizes speech speech using model parameters of each registered word. Specifically, the registered word is recognized based on the HMM method. Therefore, in the following description, “registered word” is described as “HMM phrase”.

以下に、このような音声認識装置の構成および動作について、詳細に説明する。 Hereinafter, the configuration and operation of such a speech recognition apparatus will be described in detail.

<構成について>

(ハードウェア構成)

本実施の形態に係る音声認識装置は、たとえばPC(Personal Computer)などの汎用コンピュータによって実現可能である。<About configuration>

(Hardware configuration)

The speech recognition apparatus according to the present embodiment can be realized by a general-purpose computer such as a PC (Personal Computer).

図1は、本発明の実施の形態に係る音声認識装置1のハードウェア構成例を示すブロック図である。図1を参照して、音声認識装置1は、各種演算処理を行うためのCPU(Central Processing Unit)11と、各種データおよびプログラムを格納するROM(Read Only Memory)12と、作業データ等を記憶するRAM(Random Access Memory)13と、不揮発性の記憶装置、たとえばハードディスク14と、キーボードなどを含む操作部15と、各種情報を表示するための表示部16と、記録媒体17aからのデータやプログラムを読み出しおよび書き込み可能なドライブ装置17と、ネットワーク通信するための通信I/F(インターフェイス)18と、マイクロフォン20から音声信号を入力するための入力部19とを備える。記録媒体17aは、たとえば、CD−ROM(Compact Disc-ROM)や、メモリカードなどであってよい。 FIG. 1 is a block diagram showing a hardware configuration example of a

(機能構成)

図2は、本発明の実施の形態に係る音声認識装置1の機能構成を示す機能ブロック図である。図2を参照して、音声認識装置1は、その主な機能構成として、音声入力部101と、抽出部102と、設定・更新部103と、HMMフレーズ推定部104と、受理判定部105と、結果出力部108とを含む。(Functional configuration)

FIG. 2 is a functional block diagram showing a functional configuration of the

音声入力部101は、複数のHMMフレーズが連続的に発話されたフレーズ群の音声、すなわち連続的音声を入力する。抽出部102は、入力された音声を分析し、音声の特徴量を抽出する。具体的には、音声信号を所定の時間長のフレーム単位で切出し、フレーム単位で音声信号を分析することで特徴量を算出する。たとえば、切出された音声信号が、MFCC(Mel-frequency cepstral coefficient)特徴量に変換される。 The

設定・更新部103は、音声の検出区間のなかから、HMMフレーズ推定部104におけるフレーズの推定対象の区間(以下「認識対象区間」という)の設定および更新を行う。 The setting /

HMMフレーズ推定部104は、HMM記憶部201に記憶されたモデルパラメータと、抽出部102で抽出された音声の特徴量とに基づいて、フレーズ群に含まれるHMMフレーズを推定する。 The HMM

受理判定部105は、HMMフレーズ推定部104により推定されたHMMフレーズを認識結果として受理するか否かの受理判定を行う。 The acceptance determination unit 105 determines whether to accept the HMM phrase estimated by the HMM

結果出力部108は、受理判定部105により受理された単語を認識結果として確定し、出力する。具体的には、結果出力部108は、たとえば表示部16に出力する。 The

ここで、HMMフレーズ推定部104は、公知のHMM法に従ってフレーズ認識を行う認識処理部212だけでなく、候補抽出部211を含んでいる。 Here, the HMM

HMMフレーズ推定部104の候補抽出部211は、認識対象区間から、HMMフレーズ候補を抽出し、抽出されたHMMフレーズ候補の音声区間を切り出す処理を実行する。これにより、認識対象区間から、HMMフレーズが存在する可能性の高い音声区間が切り出される。HMMフレーズ候補の抽出処理は、具体的には、複数のHMMフレーズそれぞれのテンプレート特徴量列と認識対象区間内の音声の特徴量列とを照合させることによって行われる。候補抽出部211で用いられるテンプレート特徴量列については、後述する。これにより、認識処理部212では、切出された音声区間内の特徴量から、HMMフレーズを推定することができる。 The

ここで、候補抽出部211において実行されるフレーズ(候補)抽出処理について説明する。フレーズ抽出処理では、HMM記憶部201に記憶されたモデルパラメータそのものを用いずに、パターン記憶部202に記憶された、HMMフレーズごとのテンプレート特徴量列のパターンデータを用いて、HMMフレーズ候補を抽出する。本実施の形態では、DTWアルゴリズムに準拠したアルゴリズムによって、パターン記憶部202に記憶されたパターンデータを用いて、フレーズ抽出を行う。DTWアルゴリズムは、特定話者対応の登録単語(以下「DTWフレーズ」という)の認識に広く用いられている。 Here, the phrase (candidate) extraction process executed in the

候補抽出部211におけるフレーズ抽出処理の理解を深めるために、まず、図3を参照しながら、DTWアルゴリズムに従ったDTWフレーズ認識処理について簡単に説明する。図3では、入力フレーズの特徴量列が横軸に示され、あるDTWフレーズの特徴量列が縦軸に示されている。たとえば、入力フレーズの特徴量列が3,5,6,4,2,5であり、あるDTWフレーズの特徴量列が5,6,3,1,5であると仮定する。 In order to deepen the understanding of the phrase extraction process in the

DTW認識処理では、入力フレーズの特徴量列を、DTWフレーズのテンプレート特徴量列に照合させて、両者の類似度を示す最小累積距離を算出する。DTW認識処理において算出される最小累積距離については、以下「DTW距離」という。この場合、両フレーズの始端と終端とを合わせ、たとえば、最大傾き「2」、最小傾き「1/2」とし、一点鎖線で示す平行四辺形内でDTW距離を計算する。この場合、DTW距離は「5」となっている。DTWフレーズ認識においては、各登録フレーズについて上記のような計算を行い、DTW距離が最も小さい登録フレーズが認識結果とされる。 In the DTW recognition process, the feature amount sequence of the input phrase is collated with the template feature amount sequence of the DTW phrase, and the minimum cumulative distance indicating the similarity between the two is calculated. The minimum cumulative distance calculated in the DTW recognition process is hereinafter referred to as “DTW distance”. In this case, the start and end of both phrases are combined, for example, the maximum inclination is “2” and the minimum inclination is “½”, and the DTW distance is calculated within the parallelogram indicated by the alternate long and short dash line. In this case, the DTW distance is “5”. In DTW phrase recognition, the above calculation is performed for each registered phrase, and the registered phrase having the smallest DTW distance is used as the recognition result.

これに対し、候補抽出部211において実行されるフレーズ抽出処理においては、DTW認識処理とは逆に、入力フレーズの特徴量列に、登録フレーズのテンプレート特徴量列を照合させて、両者の類似度を示す最小累積距離を算出する。このように、照合先と照合元とを認識処理と逆にしているのは、連続的に発話されたフレーズ群の入力音声全体から、入力音声のどの部分に登録フレーズが存在するか分からないためである。 On the other hand, in the phrase extraction process executed in the

図4には、フレーズ抽出処理における最小累積距離の計算例が示されている。図4においても、図3と同様に、たとえば、入力フレーズの特徴量列が3,5,6,4,2,5であり、登録フレーズの特徴量列が5,6,3,1,5である場合の計算例が示されている。この場合、両フレーズの始端だけを合わせ、たとえば、最大傾き「2」、最小傾き「1/2」とし、一点鎖線で示すV字内で最小累積距離を計算する。この場合、登録フレーズの最終フレームで複数の累積距離が算出されるが、これらの累積距離(11,7,7,4)のうちの最小の累積距離(4)が、両フレーズの特徴量列の最小累積距離となる。ただし、登録フレーズのフレーム長が異なるため、計算された最小累積距離を登録フレーズのフレーム数で割った数値を、両フレーズの類似度として求めることが望ましい。 FIG. 4 shows a calculation example of the minimum cumulative distance in the phrase extraction process. 4, as in FIG. 3, for example, the feature amount sequence of the input phrase is 3, 5, 6, 4, 2, 5, and the feature amount sequence of the registered phrase is 5, 6, 3, 1, 5 An example calculation is shown for. In this case, only the starting ends of both phrases are combined, for example, the maximum inclination is “2” and the minimum inclination is “½”, and the minimum cumulative distance is calculated within the V-shape indicated by the alternate long and short dash line. In this case, a plurality of cumulative distances are calculated in the final frame of the registered phrase, and the minimum cumulative distance (4) of these cumulative distances (11, 7, 7, 4) is the feature amount sequence of both phrases. Is the minimum cumulative distance. However, since the frame lengths of the registered phrases are different, it is desirable to obtain a numerical value obtained by dividing the calculated minimum cumulative distance by the number of frames of the registered phrases as the similarity between both phrases.

なお、図3および図4の距離計算例では、理解を容易にするために、特徴量の次元を1次元とし、かつ、極めて少ないフレーム数のフレーズを例にしたが、通常の入力音声で距離計算をする場合には、登録フレーズの始端と入力音声の始端付近とを合わせればよい。 In the distance calculation examples in FIG. 3 and FIG. 4, for ease of understanding, the dimension of the feature quantity is one dimension and a phrase having an extremely small number of frames is used as an example. When calculating, it is sufficient to match the beginning of the registered phrase with the vicinity of the beginning of the input voice.

ところで、上述のように、HMMフレーズの認識自体には、パターンデータが用いられないため、上記のような距離計算を可能とするためには、別途テンプレート特徴量列を準備しなければならない。 By the way, as described above, since pattern data is not used for the recognition of the HMM phrase itself, in order to enable the distance calculation as described above, it is necessary to prepare a template feature amount sequence separately.

そこで、本実施の形態では、HMM記憶部201に記憶されたモデルパラメータから、各HMMフレーズのテンプレート特徴量列を復元することとしている。すなわち、音声認識装置1は、その機能として復元部109をさらに備えている。 Therefore, in the present embodiment, the template feature amount sequence of each HMM phrase is restored from the model parameters stored in the HMM

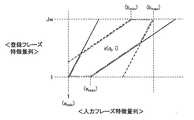

復元部109は、HMM記憶部201に記憶されたモデルパラメータから、複数のHMMフレーズそれぞれの特徴パターンを算出し、テンプレート特徴量列を復元する。HMM記憶部201には、HMMフレーズごとに、状態遷移確率、出力確率分布、初期状態確率などのパラメータが予め記憶されている。復元部109は、これらのパラメータを用いて、各HMMフレーズのテンプレート特徴量列を復元する。この具体的な方法について、以下に説明する。 The

状態kから状態lへの状態遷移確率が「akl」、状態kの特徴量「y」の出力確率分布が「bk(y)」のHMMフレーズから、テンプレート特徴量列を生成すると仮定する。なお、ここでは、状態数NのスキップなしLR型HMMで、状態kにおける特徴量の出力確率分布が、平均ベクトル「μk」、共分散行列「Σk」の多次元正規分布である場合について述べる。Assume that a template feature quantity sequence is generated from an HMM phrase in which the state transition probability from the state k to the state l is “akl ” and the output probability distribution of the feature quantity “y” in the state k is “bk (y)”. . Here, in the case of NR HMM without skipping with the number of states N, the output probability distribution of the feature quantity in state k is a multidimensional normal distribution of mean vector “μk ” and covariance matrix “Σk ”. State.

状態kから出力される特徴量の平均値は平均ベクトル「μk」である。そして、状態kから特徴量が出力される平均フレーム数は「1/(1−akk)」であるため、状態kから状態(k+1)に遷移する時刻の平均値「tk」は、次の式(1)で表される。The average value of the feature values output from the state k is the average vector “μk ”. Since the average number of frames from which the feature amount is output from the state k is “1 / (1-akk )”, the average value “tk ” at the time of transition from the state k to the state (k + 1) is It is represented by the formula (1).

これにより、本実施の形態では、図5で示すような変化をするテンプレート特徴量列を生成する。この場合、テンプレート特徴量列は、以下の式(2)で表される。なお、状態Nから最後に特徴量が出力される時刻の平均値「tN」は、HMMの教師音声の特徴量列の平均フレーム長からも求めることができる。Thereby, in this Embodiment, the template feature-value row | line | column which changes as shown in FIG. 5 is produced | generated. In this case, the template feature amount sequence is represented by the following equation (2). Note that the average value “tN ” of the time when the feature amount is output last from the state N can be obtained from the average frame length of the feature amount sequence of the HMM teacher speech.

図6のグラフには、あるHMMフレーズについての複数の教師音声の特徴量列と、復元された特徴量列(特徴パターン)との関係が示されている。 The graph of FIG. 6 shows the relationship between a feature amount sequence of a plurality of teacher speeches for a certain HMM phrase and a restored feature amount sequence (feature pattern).

復元部109は、上記のような計算によって、HMMフレーズごとに、テンプレート特徴量列を復元する。なお、復元部109は、候補抽出部211においてHMMフレーズ抽出処理が行われるたびに作動して復元処理を行ってもよいが、そうすると、認識速度が低下する。そのため、復元部109は、たとえば初期設定時など、ユーザからの所定の指示が入力された場合にのみ作動し、算出された特徴パターンに応じたパターンデータを、パターン記憶部202に記憶しておくことが望ましい。あるいは、音声認識装置1の製造または出荷時に、HMMから復元されたパターンデータを、予めパターン記憶部202に記憶しておいてもよい。この場合、音声認識装置1は復元部109を有していなくてもよい。 The

なお、図2に示した各記憶部201,202は、たとえばハードディスク14に含まれる。音声入力部101は、たとえば入力部19により実現される。それ以外の機能部は、CPU11が、たとえばROM12に格納されたソフトウェアを実行することで実現される。なお、これらの機能部のうちの少なくとも1つは、ハードウェアにより実現されてもよい。 Note that the

<動作について>

図7は、本発明の実施の形態における音声認識処理を示すフローチャートである。図7のフローチャートに示す処理手順は、予めプログラムとしてROM12に格納されており、CPU11が当該プログラムを読み出して実行することにより音声認識処理の機能が実現される。<About operation>

FIG. 7 is a flowchart showing voice recognition processing in the embodiment of the present invention. The processing procedure shown in the flowchart of FIG. 7 is stored in advance in the

図7を参照して、音声入力部101に音声が入力されると(ステップS(以下「S」と略す)2)、音声信号のエネルギー等に基づき音声が検出される(S4)。検出された音声には、連続的に発話された複数のHMMフレーズが含まれているものとする。 Referring to FIG. 7, when a voice is input to voice input unit 101 (step S (hereinafter abbreviated as “S”) 2), the voice is detected based on the energy of the voice signal (S4). It is assumed that the detected voice includes a plurality of continuously spoken HMM phrases.

音声が検出されると、その区間内の音声に対し、連続的音声認識処理が実行される(S6)。なお、検出した音声区間の前後に、検出し損ねたエネルギーの小さい音声が存在する可能性を考慮し、音声区間を前後に数百ミリ秒程度ずつ拡大しておくことが望ましい。 When the voice is detected, continuous voice recognition processing is executed for the voice in the section (S6). In consideration of the possibility that there is a voice with low energy that is not detected before and after the detected voice section, it is desirable to enlarge the voice section by several hundred milliseconds before and after.

図8は、本実施の形態における連続的音声認識処理を示すフローチャートである。図8を参照して、抽出部102は、検出音声を長さ20ミリ秒程度のフレームに区切って分析し、MFCC等の特徴量を抽出する(S12)。抽出部102は、フレームを10ミリ秒程度ずつずらして分析することを繰り返す。これにより、検出音声(入力音声)の特徴量列が得られる。 FIG. 8 is a flowchart showing continuous speech recognition processing in the present embodiment. Referring to FIG. 8, the

設定・更新部103は、図7のS4で検出された音声区間全体を、認識対象区間として設定する(S14)。 The setting /

認識対象区間が設定されると、まず、HMMフレーズ推定部104の候補抽出部211が、HMMフレーズの抽出処理を実行する(S16)。すなわち、パターン記憶部202に記憶された各HMMフレーズのテンプレート特徴量列を、検出音声の特徴量列に照合させて、HMMフレーズ候補を抽出する。ここでは、認識対象区間の始端付近にHMMフレーズが存在すると仮定して、DTWアルゴリズムに準拠したフレーズ抽出処理を行う。 When the recognition target section is set, first, the

具体的には、図4に示したような計算方法によりHMMフレーズごとに最小累積距離を算出し、算出された最小累積距離をそのフレーム数で除算することで、1フレーム当たりの最小累積距離を求める。1フレーム当たりの最小累積距離が最小になるHMMフレーズをHMMフレーズ候補とする。このような処理は、所定の計算式により行うことができる。候補抽出部211は、抽出されたHMMフレーズ候補の音声区間を、HMMフレーズが存在する可能性が最も高い区間として切出す。 Specifically, the minimum cumulative distance for each HMM phrase is calculated by the calculation method as shown in FIG. 4, and the calculated minimum cumulative distance is divided by the number of frames to obtain the minimum cumulative distance per frame. Ask. An HMM phrase that minimizes the minimum cumulative distance per frame is set as an HMM phrase candidate. Such processing can be performed by a predetermined calculation formula. The

なお、HMM記憶部201には、平均ベクトルだけではなく、平均ベクトルからのばらつきの情報、つまり、共分散行列も記憶されている。したがって、HMMフレーズ抽出においては、2つの特徴量列の照合における類似性の距離尺度として、以下の式(3)で示すマハラノビス距離を適用することができる。 The HMM

マハラノビス距離は、平均ベクトルからのばらつきの程度に応じて距離の重み付けがなされる。そのため、ユークリッド距離による類似度の計算よりも、HMMフレーズ候補の抽出精度を向上させることができる。 The Mahalanobis distance is weighted according to the degree of variation from the average vector. Therefore, the HMM phrase candidate extraction accuracy can be improved as compared with the similarity calculation based on the Euclidean distance.

次に、HMMフレーズ推定部104の認識処理部212が、HMM記憶部201に記憶されたモデルパラメータを用いて、HMMフレーズの認識処理を実行する(S18)。具体的には、認識処理部212は、候補抽出部211において切出された音声区間内の特徴量に基づいて、HMMフレーズを推定する。すなわち、HMMフレーズ抽出処理の結果である特徴量列を、HMM法により認識する。 Next, the

このように、S16でのHMMフレーズ抽出の結果をそのまま認識結果とせず、不特定話者の音声認識に適したHMM法により認識処理を行うことで、認識精度を高めることができる。 As described above, the recognition accuracy can be improved by performing the recognition process by the HMM method suitable for the speech recognition of the unspecified speaker without using the result of the HMM phrase extraction in S16 as the recognition result as it is.

続いて、受理判定部105は、S18での認識結果の受理判定を行う(S20)。すなわち、認識処理部212において推定されたHMMフレーズを認識結果として受理するか、棄却するかの判定を行う。簡易な棄却アルゴリズムでは、1位のHMMフレーズの尤度値が或る閾値以上であり、かつ、1位と2位の尤度比が別の或る閾値以上であれば受理し、さもなければ、棄却する。これらの閾値は、登録音声から予め求められ、記憶されているものとする。 Subsequently, the acceptance determination unit 105 performs acceptance determination of the recognition result in S18 (S20). That is, it is determined whether the HMM phrase estimated by the

推定されたHMMフレーズが認識結果として受理されると(S20にて「受理」)、結果出力部108は、受理されたHMMフレーズを認識結果として出力する(S22)。 When the estimated HMM phrase is accepted as a recognition result (“accept” in S20), the

抽出されたHMMフレーズ候補と受理したHMMフレーズとが異なる場合には、候補抽出部211による音声区間の切出しと同様に、受理されたHMMフレーズが存在する区間を検出しなおす(S24)。この処理が終わると、S26へ進む。 If the extracted HMM phrase candidate is different from the accepted HMM phrase, the section in which the accepted HMM phrase exists is detected again in the same manner as the extraction of the voice section by the candidate extraction unit 211 (S24). When this process ends, the process proceeds to S26.

S20において、推定されたHMMフレーズが棄却された場合(S20にて「棄却」)、認識対象区間の始端付近には、HMMフレーズは存在しないと判断し、S28に移行する。 If the estimated HMM phrase is rejected in S20 ("reject" in S20), it is determined that there is no HMM phrase near the beginning of the recognition target section, and the process proceeds to S28.

なお、HMMフレーズ抽出処理(S16)において最も類似度が高かった1位のHMMフレーズ候補の音声区間における認識結果が棄却された場合、直ちにS28に移行せずに、HMMフレーズの再認識処理を行ってもよい。具体的には、HMMフレーズ抽出処理において次に類似度が高かった2位のHMMフレーズ候補の音声区間について、HMMフレーズ認識処理(S18)および受理判定(S20)を行ってもよい。その場合、S22において出力されるHMMフレーズは、再認識処理で認識および受理されたフレーズであってもよい。これにより、入力音声の認識精度を高めることができる。このような再認識処理は、2位以降の複数(所定数)のHMMフレーズ候補の音声区間について行われてもよい。 In addition, when the recognition result in the speech section of the first HMM phrase candidate having the highest similarity in the HMM phrase extraction process (S16) is rejected, the HMM phrase re-recognition process is performed without proceeding to S28 immediately. May be. Specifically, the HMM phrase recognition process (S18) and the acceptance determination (S20) may be performed on the speech section of the second highest HMM phrase candidate having the next highest similarity in the HMM phrase extraction process. In that case, the HMM phrase output in S22 may be a phrase recognized and accepted in the re-recognition process. Thereby, the recognition accuracy of input speech can be improved. Such re-recognition processing may be performed for the speech sections of a plurality (predetermined number) of HMM phrase candidates after the second place.

S26では、設定・更新部103は、認識対象区間から受理フレーズ区間を削除し、認識対象区間を更新する。具体的には、認識対象区間の始端から、受理フレーズを抽出した区間の終端までの特徴量列を削除する。つまり、認識処理区間の始端が、削除した分だけ後方にずらされる。 In S26, the setting /

S28では、設定・更新部103は、認識対象区間から所定の棄却区間を削除する。具体的には、認識対象区間の始端から、100〜200ミリ秒程度の特徴量列を削除する。つまり、認識処理区間の始端が、後方に100〜200ミリ秒程度ずらされる。 In S28, the setting /

認識対象区間が更新されると、認識対象区間長を検査する(S30)。具体的には、認識対象区間の時間長が或る閾値以上であれば(S30にて「しきい値以上」)、認識対象区間にフレーズが存在する可能性があると判断し、S16に戻り、上記処理を繰り返す。さもなければ(S30にて「しきい値未満」)、一連の処理は終了される。なお、この閾値は、HMMフレーズの時間長から求めることができる。具体的には、HMMフレーズの中で最短のフレーズの時間長のたとえば半分を、閾値として設定してもよい。 When the recognition target section is updated, the recognition target section length is inspected (S30). Specifically, if the time length of the recognition target section is equal to or greater than a certain threshold value (“threshold value or more” in S30), it is determined that a phrase may exist in the recognition target section, and the process returns to S16. The above process is repeated. Otherwise (“less than threshold value” in S30), the series of processing is terminated. This threshold value can be obtained from the time length of the HMM phrase. Specifically, for example, half the time length of the shortest phrase in the HMM phrases may be set as the threshold value.

上述のように、本実施の形態の音声認識方法によれば、HMMフレーズのテンプレート特徴量列を用いることで、DTWアルゴリズムに準拠したフレーズ抽出を行うことができるため、単語間の繋がりを考慮することなく連続的音声を認識することができる。なお、認識精度をより向上させるためには、構文分析等を組み合わせてもよい。 As described above, according to the speech recognition method of the present embodiment, phrase extraction conforming to the DTW algorithm can be performed by using the template feature amount sequence of the HMM phrase, and thus the connection between words is taken into consideration. Continuous speech can be recognized without any problem. In order to further improve recognition accuracy, syntax analysis or the like may be combined.

また、HMMフレーズのテンプレート特徴量列は、HMMパラメータから復元されるため、別途、教師音声による学習を行う必要がない。そのため、簡易な手法で連続的音声を認識することができる。また、HMMパラメータが、多数の話者が発声した音声を学習して求められたパラメータであるため、HMMパラメータから復元されたテンプレート特徴量列は、不特定話者に対応可能なものとなっている。したがって、多数の話者が発声した各音声から求めたテンプレート特徴量列を使ってフレーズ抽出を行うよりも、不特定話者に対してフレーズ抽出の精度が良いと期待できる。しかも、1フレーズ当たり1個のテンプレート特徴量列を生成するだけでよいため、類似度の計算量を少なくすることもできる。 In addition, since the template feature amount sequence of the HMM phrase is restored from the HMM parameters, it is not necessary to separately perform learning by teacher speech. Therefore, continuous speech can be recognized by a simple method. In addition, since the HMM parameter is a parameter obtained by learning speech uttered by a large number of speakers, the template feature amount sequence restored from the HMM parameter is compatible with unspecified speakers. Yes. Therefore, it can be expected that the phrase extraction accuracy is better for the unspecified speaker than the phrase extraction is performed using the template feature amount sequence obtained from each voice uttered by a large number of speakers. In addition, since only one template feature amount sequence needs to be generated per phrase, the amount of calculation of similarity can be reduced.

また、HMMパラメータからテンプレート特徴量列を復元する際に、共分散行列の時系列データも復元しておくことで、HMMフレーズ候補の抽出処理において、特徴量のばらつきに応じて距離の重み付けが可能である。したがって、候補抽出の精確性を向上させることができる。 Also, by restoring the time series data of the covariance matrix when restoring the template feature value sequence from the HMM parameter, it is possible to weight the distance according to the feature value variation in the HMM phrase candidate extraction process It is. Therefore, the accuracy of candidate extraction can be improved.

また、HMMフレーズの最終的な認識処理はHMM法に基づいて行うため、認識率の低下を防ぐことができる。 Further, since the final recognition process of the HMM phrase is performed based on the HMM method, it is possible to prevent the recognition rate from being lowered.

また、HMMフレーズの抽出処理では、通常のDTWアルゴリズムと異なり、テンプレート特徴量列を照合元とすることで、入力音声から、フレーズ認識に最適な範囲を探索することができる。また、通常、フレーズごとに数千回程度必要となる距離計算を、1回の距離計算で済ますこともできる。このことについては、さらに詳細に説明する。 In addition, in the HMM phrase extraction process, unlike the normal DTW algorithm, a template feature amount sequence is used as a collation source, so that an optimum range for phrase recognition can be searched from input speech. In addition, the distance calculation that is usually required several thousand times for each phrase can be performed by a single distance calculation. This will be described in more detail.

一般的なDTWアルゴリズムによるフレーズ抽出では、入力音声の特徴量列から部分列を取り出して照合元とし、テンプレート特徴量列に照合することによって最小累積距離が計算される。この場合、取り出す部分列ごとに、そこに存在する可能性が最も高いフレーズとその最小累積距離とが求まる。このような計算は、あらゆる部分列について行われる。そして、最小累積距離を部分列の長さであるフレーム数で割った値のうち、最小となる部分列を探す。これにより、見付かった部分列に、存在する可能性が最も高いフレーズが抽出されたことになる。このような計算は、各フレーズについて数千回程度行う必要がある。これは、部分列の入力音声からの取り出し方が数千通り程度あるためである。 In phrase extraction by a general DTW algorithm, a minimum sequence distance is calculated by extracting a partial sequence from a feature sequence of input speech and using it as a collation source and collating it with a template feature sequence. In this case, for each partial sequence to be extracted, the phrase most likely to be present there and its minimum cumulative distance are obtained. Such a calculation is performed for every subsequence. Then, the smallest partial sequence is searched for among the values obtained by dividing the minimum cumulative distance by the number of frames, which is the length of the partial sequence. As a result, the phrase most likely to exist is extracted from the found partial sequence. Such a calculation needs to be performed several thousand times for each phrase. This is because there are about several thousand ways to extract subsequences from input speech.

また、一般的なHMM法によるフレーズ抽出においても、対数尤度の計算を1フレーズ当たり数千回程度計算する必要がある。詳述すると、一般的なHMM法によるフレーズ抽出では、認識対象区間(音声検出区間)から、始端および終端の位置を様々に変えて、その一部を取り出し、ビタビアルゴリズムにより、各フレーズのHMMに対する対数尤度を計算する。このとき、始端の位置を200ミリ秒程度の範囲で変え、かつ、終端の位置を始端の位置から500〜1500ミリ秒程度の範囲で変えることにより、部分列が取り出される。この場合、部分列の取り出し方が数千通りある。したがって、1フレーズ当たり、数千回も対数尤度を計算する必要がある。 Also, in the phrase extraction by the general HMM method, it is necessary to calculate the log likelihood about several thousand times per phrase. More specifically, in the phrase extraction by the general HMM method, the start and end positions are changed in various ways from the recognition target section (speech detection section), and a part thereof is extracted, and the Viterbi algorithm is used for the HMM of each phrase. Calculate the log likelihood. At this time, the partial sequence is extracted by changing the position of the start end in the range of about 200 milliseconds and changing the position of the end in the range of about 500 to 1500 milliseconds from the position of the start end. In this case, there are thousands of ways to take out the partial sequence. Therefore, it is necessary to calculate the log likelihood several thousand times per phrase.

なお、この場合においても、たとえば、計算された対数尤度をフレーム数で除算した値を用いるなど、多くの場合、切出した区間の長さの違いが対数尤度の値に与える影響が考慮されている。対数尤度が最大のフレーズが受理されると、そのフレーズが認識結果となる。 Even in this case, for example, the value obtained by dividing the calculated log likelihood by the number of frames is used. In many cases, the influence of the difference in the length of the extracted section on the log likelihood value is taken into consideration. ing. When a phrase with the maximum log likelihood is accepted, the phrase becomes a recognition result.

このような、一般的なHMM法によるフレーズ抽出において、リアルタイム性を要求すると高い演算処理能力を持つハードウェアが必要となり、コストがかかる。一方、コストを抑えるために演算処理能力が高くないハードウェアを使用すると、処理時間が長くなってしまう。 In such a phrase extraction by the general HMM method, if real-time performance is required, hardware having high arithmetic processing capability is required, which is expensive. On the other hand, if hardware that does not have high processing capacity is used in order to reduce costs, the processing time will be long.

これに対し、本実施の形態では、各フレーズ(w)に対して入力音声の特徴量列を照合先、テンプレート特徴量列を照合元とする最小累積距離をテンプレート特徴量列の長さで割った値を計算し、その中で最小となるフレーズW*を求める。この際に、次のような式(4)を用いることで、各フレーズ(w)についての距離計算を1回で済ませることができる。On the other hand, in the present embodiment, for each phrase (w), the minimum accumulated distance with the feature sequence of the input speech as the collation destination and the template feature sequence as the collation source is divided by the length of the template feature sequence. And obtain the smallest phrase W* among them. In this case, the distance calculation for each phrase (w) can be completed once by using the following equation (4).

式(4)中の「Rw」は、フレーズwのテンプレート特徴量列、「Jw」はその長さを示し、「amin」は始端フレーム番号「a」の最小値、「bmax」は終端フレーム番号「b」の最大値を示す。また、「X(amin,bmax)」は、入力音声の特徴量列Xのaminフレームからbmaxフレームまでを取り出した部分列を示す。この場合、Rwを照合元、X(amin,bmax)を照合先とする最小累積距離「D(Rw,X(amin,bmax))」は、次の式(5)により定義できる。なお、先に示した図4には、参考として、入力フレーズおよび登録フレーズの特徴量列と、式(5)の記号との関係が図示されている。In the formula (4), “Rw” is a template feature amount sequence of the phrase w, “Jw” indicates its length, “amin ” is the minimum value of the start frame number “a”, and “bmax ” is the end point. The maximum value of the frame number “b” is indicated. “X (amin , bmax )” indicates a partial sequence obtained by extracting from the amin frame to the bmax frame of the feature amount sequence X of the input speech. In this case, the minimum cumulative distance “D (Rw, X (amin , bmax ))” where Rw is the collation source and X (amin , bmax ) is the collation destination can be defined by the following equation (5). . In addition, in FIG. 4 shown previously, the relationship between the feature-value string of an input phrase and a registration phrase, and the symbol of Formula (5) is illustrated as reference.

式(5)の「q1,・・・,qJw」に関する制約条件は、次の通りである。The constraint conditions regarding “q1 ,..., QJw ” in Expression (5) are as follows.

図9には、条件(1)〜(6)の不等式で定まる領域を囲む線が、一点鎖線で示されている。本実施の形態では、フレーズごとに、この領域内で最小累積距離を計算する。 In FIG. 9, a line surrounding a region defined by the inequalities of the conditions (1) to (6) is indicated by a one-dot chain line. In the present embodiment, the minimum cumulative distance is calculated within this area for each phrase.

候補抽出部211において、式(4)による計算を行うことで、フレーズ抽出処理に掛かる時間を大幅に短縮することができる。なお、理想的には、式(4)による計算が行われるが、本実施の形態におけるフレーズ抽出処理と、照合元および照合先は同じとしたまま、照合先を、入力音声の特徴量列から取り出されたあらゆる部分列としてもよい。 In the

<実験結果について>

本実施の形態における連続的音声認識方法に従い、一例として、「デンシメール(電子メール)、メールジュシン(メール受信)」という連続的音声に対して行った実験結果について説明する。「電子メール」および「メール受信」は、いずれも事前に登録された単語(HMMフレーズ)である。<Experimental results>

In accordance with the continuous speech recognition method according to the present embodiment, as an example, a description will be given of the results of experiments performed on continuous speech such as “Denshi Mail (e-mail), Mail Jushin (mail reception)”. “E-mail” and “mail reception” are both pre-registered words (HMM phrases).

図10には、入力音声波形が示されている。このような入力音声に対して、音声信号のエネルギーに基づいて音声検出を行った場合、これらのフレーズ群の音声は、図10のグラフの0.80秒から2.57秒の間(△印の間)に検出された(図7のS4)。 FIG. 10 shows an input speech waveform. When speech detection is performed on the input speech based on the energy of the speech signal, the speech of these phrase groups is between 0.80 seconds and 2.57 seconds (Δ mark in the graph of FIG. 10). (S4 in FIG. 7).

図10の入力音声波形を見ると、「電子メール」の音声と「メール受信」の音声との間には、0.2秒程度の非発話区間があるが、ここでは区切られず、両フレーズを含んだ区間が音声区間として検出されている。登録単語の中には、たとえば促音(「ッ」)などエネルギーが小さい音素を有するフレーズが含まれる。ここでの非発話区間の時間は、このような促音の時間と同じぐらいかそれよりも短い時間である。そのため、促音を含むフレーズが発話された場合に、この促音の箇所で区切らないように音声検出を行うためには、短い非発話区間の箇所で音声波形を区切ることができない。本実施の形態の認識方法では、このように、1フレーズずつ検出して認識するのが困難な音声を認識することを想定している。 Looking at the input speech waveform in FIG. 10, there is a non-speech interval of about 0.2 seconds between the voice of “e-mail” and the voice of “mail reception”. The included section is detected as a voice section. The registered word includes a phrase having a phoneme with low energy, such as a prompt sound (“tsu”). The time of the non-speaking section here is a time that is about the same as or shorter than the time of such a prompt sound. For this reason, when a phrase including an urging sound is uttered, the speech waveform cannot be separated at a short non-utterance interval in order to detect the voice so as not to be separated at the portion of the urging sound. In the recognition method of the present embodiment, it is assumed that speech that is difficult to detect and recognize one phrase at a time is recognized.

図8のステップS14で設定される認識対象区間の始端および終端は、図11において□印で示されている。この段階での認識対象区間は、音声が検出された区間(図10の△印の間)と、ほぼ等しい。 The start and end points of the recognition target section set in step S14 in FIG. 8 are indicated by □ in FIG. The recognition target section at this stage is substantially equal to the section in which the voice is detected (between Δ marks in FIG. 10).

認識対象区間の始端付近にHMMフレーズが存在する可能性を見積り、最も可能性が高い単語、および、その単語がある区間を求めたところ、「電子メール」というフレーズが単語候補として抽出された(図8のS16)。このフレーズは、0.82秒から1.52秒(○の間)にある可能性が最も高いという結果となった。 When the possibility that an HMM phrase exists near the beginning of the recognition target section and the most probable word and the section in which the word is found were obtained, the phrase “e-mail” was extracted as a word candidate ( S16 in FIG. This phrase resulted in the highest probability of being between 0.82 seconds and 1.52 seconds (between circles).

次に、0.82秒から1.52秒の音声区間を切出し、その区間内の音声をHMM認識したところ、「電子メール」という結果となった(図8のS18)。この場合、認識結果を受理判定したところ、受理された(図8のS20にて「受理」)。 Next, when a voice section from 0.82 seconds to 1.52 seconds was cut out and the voice in the section was HMM-recognized, the result was “electronic mail” (S18 in FIG. 8). In this case, when the recognition result is accepted, it is accepted (“accept” in S20 of FIG. 8).

そのため、「電子メール」が1つ目の認識結果として出力された(図8のS22)。単語が受理されると、図12に示す認識対象区間(□印の間)に更新される(図8のS26)。すなわち、認識対象区間は、「電子メール」の終端直後の1.53秒から音声検出区間の終端2.57秒の間となる。更新された認識対象区間の音声に対し2回目の推定処理が実行される(図8のS30にて「しきい値以上」)。 Therefore, “e-mail” is output as the first recognition result (S22 in FIG. 8). When the word is accepted, it is updated to the recognition target section (between □ marks) shown in FIG. 12 (S26 in FIG. 8). That is, the recognition target section is between 1.53 seconds immediately after the end of “e-mail” and 2.57 seconds at the end of the voice detection section. A second estimation process is performed on the updated speech of the recognition target section (“threshold or higher” in S30 of FIG. 8).

認識対象区間の始端付近にHMMフレーズが存在する可能性を見積り、最も可能性が高い単語、および、その単語がある区間を求めたところ、「メール受信」というフレーズが、1.78秒から2.55秒(○の間)にある可能性が最も高いという結果となった(図8のS16)。 Estimating the possibility that an HMM phrase exists near the beginning of the recognition target section, and obtaining the most likely word and the section with the word, the phrase “mail received” is changed from 1.78 seconds to 2. The result is the highest possibility of being in .55 seconds (between ○) (S16 in FIG. 8).

そのため、1.78秒から2.55秒の音声区間内の音声を認識したところ、「メール受信」という結果となった(図8のS18)。この認識結果を受理判定したところ、受理されたため(図8のS20にて「受理」)、「メール受信」が2つ目の認識結果として出力された(図8のS22)。 Therefore, when the voice in the voice section from 1.78 seconds to 2.55 seconds was recognized, the result was “mail received” (S18 in FIG. 8). When the recognition result is accepted, it is accepted (“accept” in S20 of FIG. 8), and “mail reception” is output as the second recognition result (S22 of FIG. 8).

次に、認識対象区間を更新すると、残りの区間は、「メール受信」の終端直後の2.56秒から音声検出区間の終端2.57秒の間となる(図8のS26)。この場合、認識対象区間の長さは0.01秒と非常に短いため、この間にフレーズは存在しないと判断し(図8のS30にて「しきい値未満」)、認識処理が終了される。 Next, when the recognition target section is updated, the remaining section is between 2.56 seconds immediately after the end of “mail reception” and the end of the voice detection section 2.57 seconds (S26 in FIG. 8). In this case, since the length of the recognition target section is as very short as 0.01 seconds, it is determined that there is no phrase during this period (“less than threshold” in S30 of FIG. 8), and the recognition process is terminated. .

上記の実験結果から、連続的音声を精度良く認識できていることが分かる。したがって、本実施の形態に係る音声認識装置1によれば、ユーザの満足度を向上させることができる。 From the above experimental results, it can be seen that continuous speech can be accurately recognized. Therefore, according to the

なお、本実施の形態では、図6のグラフに示したように、HMMパラメータからテンプレート特徴量列を階段状に復元することとしたが、多項式補間やスプライン補間等の補間処理を用いて、テンプレート特徴量列を曲線状に復元してもよい。つまり、HMMパラメータから算出した特徴パターンに対して補間処理を行うことにより、テンプレート特徴量列を復元してもよい。 In the present embodiment, as shown in the graph of FIG. 6, the template feature amount sequence is restored in a staircase shape from the HMM parameters. However, the template feature sequence is interpolated by using interpolation processing such as polynomial interpolation or spline interpolation. The feature amount sequence may be restored to a curved shape. That is, the template feature quantity sequence may be restored by performing an interpolation process on the feature pattern calculated from the HMM parameter.

また、本実施の形態では、候補抽出部211により抽出された1位のフレーズ候補をそのまま認識結果とせずに、そのフレーズ候補の音声区間に対してHMM法による認識処理を行うこととした。しかしながら、候補抽出部211により抽出された1位のフレーズ候補を認識結果としてもよい。すなわち、1位のフレーズ候補に対して受理判定を行ってもよい。この場合、HMMフレーズ推定部104は、認識処理部212を含まなくてもよい。また、復元部109の機能が別装置にて実現されるような場合には、音声認識装置1に、HMM記憶部201が含まれていなくてもよい。 Further, in the present embodiment, the first phrase candidate extracted by the

また、本実施の形態では、認識対象区間の始端付近にHMMフレーズが存在すると仮定して、フレーズ抽出処理を行ったが、認識対象区間の終端付近にHMMフレーズが存在すると仮定して、フレーズ抽出処理を行ってもよい。この場合、認識対象区間の更新を行う際に、受理フレーズを抽出した区間の始端から、認識対象区間の終端までの特徴量列を削除すればよい。また、棄却区間の削除においては、認識処理区間の終端から、100〜200ミリ秒程度の特徴量列を削除すればよい。 In this embodiment, the phrase extraction process is performed on the assumption that an HMM phrase exists near the beginning of the recognition target section. However, the phrase extraction assumes that an HMM phrase exists near the end of the recognition target section. Processing may be performed. In this case, when updating the recognition target section, the feature amount sequence from the start end of the section from which the acceptance phrase is extracted to the end of the recognition target section may be deleted. Further, in deleting the rejection section, a feature amount sequence of about 100 to 200 milliseconds may be deleted from the end of the recognition processing section.

なお、本実施の形態に係る音声認識装置1により実行される音声認識方法を、プログラムとして提供することもできる。このようなプログラムは、CD−ROM(Compact Disc-ROM)などの光学媒体や、メモリカードなどのコンピュータ読取り可能な一時的でない(non-transitory)記録媒体にて記録させて提供することができる。また、ネットワークを介したダウンロードによって、プログラムを提供することもできる。 Note that the speech recognition method executed by the

本発明にかかるプログラムは、コンピュータのオペレーティングシステム(OS)の一部として提供されるプログラムモジュールのうち、必要なモジュールを所定の配列で所定のタイミングで呼出して処理を実行させるものであってもよい。その場合、プログラム自体には上記モジュールが含まれずOSと協働して処理が実行される。このようなモジュールを含まないプログラムも、本発明にかかるプログラムに含まれ得る。 The program according to the present invention may be a program module that is provided as a part of a computer operating system (OS) and that calls necessary modules in a predetermined arrangement at a predetermined timing to execute processing. . In that case, the program itself does not include the module, and the process is executed in cooperation with the OS. A program that does not include such a module can also be included in the program according to the present invention.

また、本発明にかかるプログラムは他のプログラムの一部に組込まれて提供されるものであってもよい。その場合にも、プログラム自体には上記他のプログラムに含まれるモジュールが含まれず、他のプログラムと協働して処理が実行される。このような他のプログラムに組込まれたプログラムも、本発明にかかるプログラムに含まれ得る。 The program according to the present invention may be provided by being incorporated in a part of another program. Even in this case, the program itself does not include the module included in the other program, and the process is executed in cooperation with the other program. Such a program incorporated in another program can also be included in the program according to the present invention.

今回開示された実施の形態はすべての点で例示であって制限的なものではないと考えられるべきである。本発明の範囲は上記した説明ではなくて特許請求の範囲によって示され、特許請求の範囲と均等の意味および範囲内でのすべての変更が含まれることが意図される。 The embodiment disclosed this time should be considered as illustrative in all points and not restrictive. The scope of the present invention is defined by the terms of the claims, rather than the description above, and is intended to include any modifications within the scope and meaning equivalent to the terms of the claims.

1 音声認識装置、11 CPU、12 ROM、13 RAM、14 ハードディスク、15 操作部、16 表示部、17 ドライブ装置、17a 記録媒体、18 通信I/F、19 入力部、20 マイクロフォン、101 音声入力部、102 抽出部、103 設定・更新部、104 HMMフレーズ推定部、105 受理判定部、108 結果出力部、109 復元部、201 HMM記憶部、202 パターン記憶部、211 候補抽出部、212 認識処理部。 DESCRIPTION OF

Claims (6)

Translated fromJapanese登録単語が連続的に発話されたフレーズ群の音声を入力する音声入力手段と、

前記音声入力手段に入力された音声の特徴量に基づいて、前記フレーズ群に含まれる登録単語を推定する推定手段とを備え、

前記推定手段は、

前記記憶手段に記憶された前記複数の登録単語それぞれのテンプレート特徴量列と、認識対象区間内の音声の特徴量列とを照合させることによって、登録単語候補を抽出する候補抽出手段と、

前記記憶手段に記憶された前記モデルパラメータを用いた認識処理によって、前記候補抽出手段により抽出された前記登録単語候補の音声区間内の特徴量に基づき登録単語を推定する認識処理手段とを含む、音声認識装置。And model parameters of a plurality of registered wordsrecognizable, the recovered fromthe model parameters, storage means for storinga plurality of registered words of each template feature amount column,

A voice input means for inputting a voice of a phrase group in which registered words are continuously spoken;

An estimation unit that estimates a registered word included in the phrase group based on a feature amount of the voice input to the voice input unit;

The estimation means includes

Candidate extraction means for extracting registered word candidates by collating a template feature quantity sequence of each of the plurality of registered words stored in the storage means with a speech feature quantity sequence in a recognition target section;

Recognition processing means for estimating a registered word based on a feature amount in a speech section of the registered word candidate extracted by the candidate extraction means by recognition processing using the model parameter stored in the storage means , Voice recognition device.

前記受理判定手段により受理された単語を出力する出力手段と、

前記受理判定手段により受理された単語の音声区間を前記認識対象区間から削除することによって、前記認識対象区間を更新する更新手段とをさらに備える、請求項1〜4のいずれかに記載の音声認識装置。An acceptance determination means for performing an acceptance determination as to whether or not to accept the estimated word as a recognition result when a word is estimated by the estimation means;

Output means for outputting the word received by the acceptance determination means;

The speech recognition according to any one of claims 1 to4 , further comprising update means for updating the recognition target section by deleting a speech section of the word accepted by the acceptance determination means from the recognition target section. apparatus.

入力された音声の特徴量に基づいて、前記フレーズ群に含まれる登録単語を推定する推定ステップとを備え、

前記推定ステップは、

認識可能な複数の登録単語のモデルパラメータから復元された、前記複数の登録単語それぞれのテンプレート特徴量列と、認識対象区間内の音声の特徴量列とを照合させることによって、登録単語候補を抽出するステップと、

予め記憶された前記モデルパラメータを用いた認識処理によって、抽出された前記登録単語候補の音声区間内の特徴量に基づき登録単語を推定するステップとを含む、音声認識プログラム。Inputting voices of phrases in which registered words are continuously spoken;

An estimation step of estimating a registered word included in the phrase group based on a feature amount of the input speech,

The estimation step includes

Registered word candidates are extracted by collating the template feature amount sequence of each of the plurality of registered words and the speech feature amount sequence in the recognition target section restored from the model parameters of a plurality of recognizable registered words. And stepsto

A step of estimating a registered word based on a feature amount in a speech section of the registered word candidate extracted by a recognition process using the model parameter stored in advance .

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2015055977AJP6497651B2 (en) | 2015-03-19 | 2015-03-19 | Speech recognition apparatus and speech recognition program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2015055977AJP6497651B2 (en) | 2015-03-19 | 2015-03-19 | Speech recognition apparatus and speech recognition program |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2016177046A JP2016177046A (en) | 2016-10-06 |

| JP6497651B2true JP6497651B2 (en) | 2019-04-10 |

Family

ID=57069995

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2015055977AActiveJP6497651B2 (en) | 2015-03-19 | 2015-03-19 | Speech recognition apparatus and speech recognition program |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP6497651B2 (en) |

Families Citing this family (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7311310B2 (en)* | 2018-10-18 | 2023-07-19 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカ | Information processing device, information processing method and program |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4349700A (en)* | 1980-04-08 | 1982-09-14 | Bell Telephone Laboratories, Incorporated | Continuous speech recognition system |

| JPS6157995A (en)* | 1984-08-29 | 1986-03-25 | 日本電気株式会社 | Voice recognition equipment |

| JP2737122B2 (en)* | 1987-07-29 | 1998-04-08 | 富士通株式会社 | Voice dictionary creation device |

| JP2862306B2 (en)* | 1990-02-01 | 1999-03-03 | キヤノン株式会社 | Voice recognition device |

| JP3428058B2 (en)* | 1993-03-12 | 2003-07-22 | 松下電器産業株式会社 | Voice recognition device |

| JP3461789B2 (en)* | 2000-06-22 | 2003-10-27 | シャープ株式会社 | Speech recognition device, speech recognition method, and program recording medium |

- 2015

- 2015-03-19JPJP2015055977Apatent/JP6497651B2/enactiveActive

Also Published As

| Publication number | Publication date |

|---|---|

| JP2016177046A (en) | 2016-10-06 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| EP2048655B1 (en) | Context sensitive multi-stage speech recognition | |

| JP5282737B2 (en) | Speech recognition apparatus and speech recognition method | |

| US9672815B2 (en) | Method and system for real-time keyword spotting for speech analytics | |

| JP5739718B2 (en) | Interactive device | |

| JP4224250B2 (en) | Speech recognition apparatus, speech recognition method, and speech recognition program | |

| JP6481939B2 (en) | Speech recognition apparatus and speech recognition program | |

| JP5200712B2 (en) | Speech recognition apparatus, speech recognition method, and computer program | |

| JP6690484B2 (en) | Computer program for voice recognition, voice recognition device and voice recognition method | |

| US20110218802A1 (en) | Continuous Speech Recognition | |

| WO2010128560A1 (en) | Voice recognition device, voice recognition method, and voice recognition program | |

| JP6276513B2 (en) | Speech recognition apparatus and speech recognition program | |

| JP4074543B2 (en) | Audio processing apparatus, audio processing method, audio processing program, and program recording medium | |

| EP3309778A1 (en) | Method for real-time keyword spotting for speech analytics | |

| JP2005148342A (en) | Speech recognition method, apparatus for implementing this method, program, and recording medium | |

| JP3444108B2 (en) | Voice recognition device | |

| JP2020008730A (en) | Emotion estimation system and program | |

| JP6027754B2 (en) | Adaptation device, speech recognition device, and program thereof | |

| JP6497651B2 (en) | Speech recognition apparatus and speech recognition program | |

| JP2008026721A (en) | Speech recognizer, speech recognition method, and program for speech recognition | |

| JP4987530B2 (en) | Speech recognition dictionary creation device and speech recognition device | |

| JP2000352993A (en) | Voice recognition system and learning method of hidden markov model | |

| JP2001312293A (en) | Voice recognition method and apparatus, and computer-readable storage medium | |

| JP2000075885A (en) | Voice recognition device | |

| JP2001109491A (en) | Continuous voice recognition device and continuous voice recognition method | |

| JP2002149188A (en) | Device and method for processing natural language and recording medium |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20180122 | |

| A977 | Report on retrieval | Free format text:JAPANESE INTERMEDIATE CODE: A971007 Effective date:20181206 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20181218 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20190207 | |

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 Effective date:20190226 | |

| A61 | First payment of annual fees (during grant procedure) | Free format text:JAPANESE INTERMEDIATE CODE: A61 Effective date:20190304 | |

| R150 | Certificate of patent or registration of utility model | Ref document number:6497651 Country of ref document:JP Free format text:JAPANESE INTERMEDIATE CODE: R150 | |

| R250 | Receipt of annual fees | Free format text:JAPANESE INTERMEDIATE CODE: R250 | |

| R250 | Receipt of annual fees | Free format text:JAPANESE INTERMEDIATE CODE: R250 |