JP4604173B2 - Remote conference / education system - Google Patents

Remote conference / education systemDownload PDFInfo

- Publication number

- JP4604173B2 JP4604173B2JP2005076012AJP2005076012AJP4604173B2JP 4604173 B2JP4604173 B2JP 4604173B2JP 2005076012 AJP2005076012 AJP 2005076012AJP 2005076012 AJP2005076012 AJP 2005076012AJP 4604173 B2JP4604173 B2JP 4604173B2

- Authority

- JP

- Japan

- Prior art keywords

- psychological state

- information

- data

- psychological

- voice

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- User Interface Of Digital Computer (AREA)

- Measuring And Recording Apparatus For Diagnosis (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Description

Translated fromJapanese本発明は、遠隔地間で異なる時間帯で活動する人々、特に、異なる文化間、業務分野間など異なる文脈で活動する人々が共同作業、会議、議論、意思決定を円滑に遂行する遠隔会議・教育システムを提供する。 The present invention is a remote conference / conference that facilitates collaboration, conferences, discussions, and decision-making by people working at different times in remote locations, especially people working in different contexts such as between different cultures and business fields. Provide an education system.

ユビキタス社会になり、いつでも、どこからでもコミュニケ−ションを取ることが可能になりつつあるが、場所だけでなく時間も共有しないコミュニケーションにより共同作業、会議、講義を経済的に実現することが求められている。

例えば、グローバルに事業展開している企業では、時差がある遠隔地間の事業所間で異なる時間帯に活動する社員の共同作業、会議、議論、意思決定を円滑に行う手段が求められている。特に、グローバル企業では、時間帯だけなく、業務分野や文化的背景など異なる文脈で活動している社員が多く、言語や映像から得られる情報とともに、対話相手の真意の理解、心理状態の推定が円滑な共同作業、会議、議論、迅速な意思決定において重要であるが、経済的に実現するのは、現状技術では、困難である。Being a ubiquitous society, it is becoming possible to communicate from anywhere at any time, but it is required to economically realize joint work, meetings, and lectures through communication that not only shares place but also time. Yes.

For example, companies that operate globally need a means to facilitate joint work, meetings, discussions, and decision-making for employees working at different times between offices between remote locations with time differences. . In particular, global companies have many employees who work in different contexts, such as work fields and cultural backgrounds, not only in time, but with the information obtained from the language and video, understanding the true intention of the conversation partner and estimating the psychological state. It is important for smooth collaboration, meetings, discussions, and rapid decision making, but it is difficult to achieve economically with current technology.

デジタル映像音響技術とインターネット通信技術を使って遠隔地間で共同作業、会議、講義が行われている。しかし、映像音響入出力機器の機能と性能の限界から遠隔地間で受け取る情報は、限定されたものである。高品質な映像音響入出力機器と広帯域な通信回線を使って臨場感ある遠隔地間のコミュニケーションを実現する試みがあるが装置コスト、運用コストの点で実現が難しい場合があり、現状技術では、時差がない遠隔地間の同期遠隔会議においても対面コミュニケーションに近い場の共有が、困難なことが多い。Collaborative work, conferences, and lectures are held between remote locations using digital audiovisual technology and Internet communication technology. However, information received between remote locations is limited due to limitations in the functions and performance of audiovisual input / output devices. Although there are attempts to realize communication between remote places with a sense of reality using high-quality audiovisual input / output devices and broadband communication lines, there are cases where it is difficult to realize in terms of equipment cost and operation cost, Even in a synchronous teleconference between remote locations with no time difference, it is often difficult to share a place close to face-to-face communication.

これらの諸課題のうち、時間を共有しない人の間で知識を共有する課題を解決する手段の提案例として、特開平10−214022「グループ学習教材編成方法及びシステム」がある。この例では、仲間同士で議論し教え合うことで、学習者間の相互作用を活性化することができるグループ学習教材編成方法及びシステムを提供する。共通の学習対象をもつ複数の学習者の協調的な振る舞いから得られるデータを基本とし、先行する学習者の学習履歴を記録し、後進学習者に対し目的状態へ至る手順を表示する機能を持ったグループ学習教材を編集し、編成されたグループ学習教材を他の学習者が共有、利用しながら、学習対象についての情報を表示し、学習者のノート/メモを取込みながら、グループ学習教材を更新する。 Among these various problems, as a proposal example of means for solving the problem of sharing knowledge among people who do not share time, there is JP-A-10-214022, “Group learning teaching material organizing method and system”. In this example, the group learning teaching material organization method and system which can activate the interaction between learners by discussing and teaching with each other are provided. Based on data obtained from the cooperative behavior of multiple learners with a common learning target, it has a function to record the learning history of the preceding learner and display the procedure to reach the target state for the backward learner. Edit group learning materials, share and use organized group learning materials, display information about learning targets, and update group learning materials while taking learner notes / memos To do.

しかし、この方法では、忙しいビジネスマンにとって、皆で共有するノートに書き込むのは、煩雑である。仮に、入力が容易な映像及び音声情報の蓄積交換が出来たとしても、リアルタイムに双方向でやり取りを行わない非同期のコミュニケーションでは、対話の文脈が分断されるため、蓄積交換された映像、音声情報だけから遠隔地の対話相手、特に異文化圏、異なる分野で業務を遂行している対話相手の真意を理解し、相手の心理状態を推定することは、困難である。 However, with this method, it is cumbersome for a busy businessman to write in a notebook shared by everyone. Even if it is possible to store and exchange video and audio information that is easy to input, asynchronous communication that does not exchange interactively in real time breaks the context of the conversation. From the above, it is difficult to understand the true intentions of remote conversation partners, especially those in different cultures and fields, and to estimate the psychological state of the other party.

一方、電子メディアの使用者の心理状態を推定する方法も提案されている。例えば、特開平5−12023「感情認識装置」では、基準となる音声信号と特徴信号とのズレ量を検出し、このズレ量に基づいて、感情状態を判断する。

図1は、遠隔会議使用者の音声スペクトルの最大パワーレベルとその周波数の変化率と「嬉しい」、「怒り」、「悲しい」、「納得」、「困惑」といった心理状態の関係を統計的信頼区間(信頼度95%)で示したデータ例である。このデータから分かるように、音声データのバラツキが大きい。従って、遠隔会議使用者の心理状態を音声データのみから適切に判断するのは、困難である。On the other hand, a method for estimating the psychological state of a user of electronic media has also been proposed. For example, Japanese Patent Laid-Open No. 5-12023 “Emotion Recognition Device” detects a deviation amount between a reference voice signal and a feature signal, and determines an emotional state based on this deviation amount.

Figure 1 shows the statistical trust of the relationship between the maximum power level of the voice spectrum and the frequency change rate of the teleconference user and the psychological state such as “happy”, “angry”, “sad”, “convinced”, “confused”. It is an example of data shown in a section (95% reliability). As can be seen from this data, the variation of the audio data is large. Therefore, it is difficult to appropriately determine the psychological state of the remote conference user only from the voice data.

別の考案例として特開平9−56703「感情検出装置および心拍データ発信器および感情表示装置」がある。これは、心拍センサから出力する心拍信号により心拍数の変化度合いを演算することにより、対話等における相手あるいは双方の緊張度や興奮度を、その場で的確に定量的に、しかも、場の雰囲気を害することなく検出し、その検出結果を表示することをめざしている。図2は、電子メディア利用者の脈拍数と皮膚温度の変化率と「面白い」、「驚き」、「納得」、「困惑」といった心理状態の関係を統計的信頼区間(信頼度95%)で示したデータ例である。図2は、心拍数や脈拍数情報に皮膚温度情報を組み合わせた場合でも、電子メディア利用者の心理状態を細かく識別することが出来ないことを示している。 Another example of the invention is Japanese Patent Laid-Open No. 9-56703 “Emotion detection device, heart rate data transmitter and emotion display device”. This is because the heart rate signal output from the heart rate sensor is used to calculate the degree of change in heart rate, so that the degree of tension and excitement of the other party or both parties in the conversation can be accurately and quantitatively determined on the spot, and the atmosphere of the field. Is detected without harming, and the detection result is displayed. Figure 2 shows the relationship between the electronic media user's pulse rate and skin temperature change rate and psychological states such as “interesting”, “surprise”, “convinced”, and “confused” in a statistical confidence interval (95% confidence level). It is the example of data shown. FIG. 2 shows that even when skin temperature information is combined with heart rate and pulse rate information, the psychological state of the electronic media user cannot be identified in detail.

生体情報を活用する別の考案例に、特開平7−204168「生体情報自動識別装置」がある。これは、脳波センサのデジタル出力信号をフーリエ変換し所望周波数帯域内の複数の分割された周波数帯域毎のスペクトルパワーを求め、センサを取り付けた被験者の複数の心理状態又は知的作業内容を判定することを狙っている。表1は、電子メディア利用者の脳波成分と「面白い」、「驚き」、「納得」、「困惑」といった心理状態の関係を示したデータ例である。表1は、α波、β波、δ波、θ波の増減からのみ心理状態を適切に判断するのは、困難であることを示している。 Japanese Patent Laid-Open No. 7-204168 “Biometric Information Automatic Identification Device” is another example of a device that utilizes biometric information. This is the Fourier transform of the digital output signal of the electroencephalogram sensor to obtain the spectral power for each of a plurality of divided frequency bands within the desired frequency band, and to determine the plurality of psychological states or intellectual work contents of the subject to which the sensor is attached. I am aiming for that. Table 1 is an example of data showing the relationship between the electroencephalogram components of electronic media users and psychological states such as “interesting”, “surprise”, “convincing”, and “confusing”. Table 1 shows that it is difficult to appropriately determine the psychological state only from the increase / decrease of the α wave, β wave, δ wave, and θ wave.

本発明は、時間を共有しない人の間で情報交換を行う非同期遠隔会議・教育システムにおいて、映像、音声情報に加え、使用者の音声、表情・動作、生体情報のデータから抽出した多様な心理状態推定情報を遠隔地の対話相手に表示することを可能にする遠隔会議・教育システムを提供する。 The present invention is an asynchronous remote conference / education system in which information is exchanged between people who do not share time, in addition to video and audio information, various psychology extracted from user's voice, facial expression / motion, and biological information data. A teleconference / education system is provided that enables state estimation information to be displayed to remote conversation partners.

前記課題を解決する請求項1に記載の発明は、サーバ及び複数の端末を、ネットワークを介して接続可能な遠隔会議・教育システムであって、各端末は、音声情報の入出力を行う音声情報入出力手段と、映像情報の入出力を行う映像情報入出力手段と、

生体情報の入力を行う生体情報入力手段と、音声、表情・動作、生体情報のデータを実時間でそれぞれ抽出するデータ抽出手段と、音声、表情・動作、生体情報の抽出データから利用者の心理状態を実時間で推定する心理状態推定手段と、利用者自身の映像音響情報に加え心理状態表示データをサーバに実時間伝送し、当該サーバに映像音響情報と心理状態表示データを一時蓄積させ、通信相手が前記サーバを介して任意の時間に取り出すことを可能にする送信手段と、蓄積された対話相手の端末の映像音響情報と心理状態表示データを、ネットワークを介してサーバより受信する受信手段と、そして、前記受信手段を介して取得した心理状態表示データから対話相手の心理状態表示人工構造物を表示する心理状態表示人工構造物表示手段とを備え、心理状態推定手段は、遠隔地間での対話開始前に、各個人別に音声、表情・動作、生体情報から各心理状態に対応する測定基準値を予め測定し、前記端末の心理状態推定回路内に蓄積記憶し、音声、映像情報の入出力手段を介して入力された音声の音声最大レベル値及び最大レベルの周波数の変化から「高揚」又は「非高揚」の心理状態を推定し、音声、映像情報の入出力手段を介して入力された顔画像の複数の特徴点の相対的移動変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、利用者の顔画像の唇の左右端2点、右眉の左右端2点、左眉の左右端2点の相対的移動変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、利用者の脈拍数、皮膚温度、呼吸数の生体情報の変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、各々の心理状態ごとに算出された各一致指数をそれぞれ合算し、一致指数が最大の心理状態をその時点の心理状態と推定することを特徴とする。The invention according to

Abiological information input means for inputting biometric information, voice, facial expression and operation, adata extracting means for extractingrespective data of the biological information in real time, voice, facial expression and operation, psychology of the user from the extracted data of the biological informationPsychological state estimating means for estimating the state in real time, in addition to the user's own audiovisual information, the psychological statedisplay data is transmitted to the server in real time, the audiovisual information and the psychological statedisplay data are temporarily storedin the server, atransmission unit that makes it possible to retrieve any time the communication partnervia the server, the video-audio information and psychologicalstatus data of the terminal of the stored dialogue partner,receiving means for receiving from the server via the network If, then, thepsychological status artificial structure display means for displaying the mental status artificial structure of dialogue partnerfrom psychological status data acquired through the receiving meansIncludes, psychological state estimation means, before starting dialogue between remote locations, the audio for each individual expression and operation,previously measured metric values corresponding to the psychological stateof the biological information,the psychological state estimation of the terminal Accumulating and storing in thecircuit, estimating the psychological state of"uplifting" or "non-uplifting" from the change of the maximum voice level and the maximum level frequency of the voice inputted through the input and output means of voice and video information ,Estimate the psychological state of “surprise”, “convinced”, “interesting”, and “confused” from the relative movement change amount of multiple feature points ofthe face imageinput via voice / video information input / output meansThe distance from the average point of the psychological state determination section is calculated as acoincidence index, and the relative movement changes of the two left and right lips of theuser's face image, the two right and left ends of the right eyebrow, and the two left and right ends of the left eyebrowestimated the psychological state of the "surprise", "assent", "fun", "embarrassment" from the amount"Surprise"the distance from the average point of the psychological state determining section calculates a concordance index, pulse rateof the user, skin temperature, the amount of change in respiration rate of the biologicalinformation, "satisfied", "fun", " Calculate the distance from the average point of the psychological state determination interval that estimates the psychological state of `` confused '' as a coincidence index, add up each coincidence index calculated for each psychological state, and calculate the psychological state with the largest coincidence index It is characterized by estimating the psychological state at that time.

前記課題を解決する請求項2に記載の発明は、請求項1記載の遠隔会議・教育システムにおいて、顔画像の複数の特徴点の変化量を1〜3秒間隔で算出することを特徴とする。The invention according to

前記課題を解決する請求項3に記載の発明は、請求項1の遠隔会議・教育システムにおいて、生体情報の変化量を2〜10秒間隔で算出することを特徴とする。The invention according to

上述した本発明は、遠隔地間で異なる時間帯で活動する人々、特に異なる文化や業務分野の人々が共同作業、会議、議論、意思決定を円滑かつ迅速に遂行する。 The above-described present invention enables smooth and quick collaboration, meetings, discussions, and decision-making by people working at different times in remote locations, especially people in different cultures and business fields.

以下、図面を用いて本発明に係る遠隔会議・教育システムについて詳細に説明する。

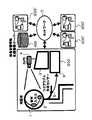

図3は、遠隔地間で時間を共有せず会議を行う非同期式遠隔会議の実施例の構成である。1は、ヘッドフォン、2は、マイクロフォン、3は、画像表示装置、4は、カメラ、5は、身体装着型生体センサ、7は、通信ネットワーク、9は、蓄積型遠隔会議情報処理装置、300,300’は、通信端末、400は、映像音響情報蓄積サーバである。通信端末300、300’は、各々、ヘッドフォン1、マイクロフォン2、画像表示装置3、カメラ4、身体装着型生体センサ5、蓄積型遠隔会議情報処理装置9で構成されている。Hereinafter, a remote conference / education system according to the present invention will be described in detail with reference to the drawings.

FIG. 3 shows a configuration of an embodiment of an asynchronous remote conference that performs a conference without sharing time between remote locations. 1 is a headphone, 2 is a microphone, 3 is an image display device, 4 is a camera, 5 is a body-mounted biosensor, 7 is a communication network, 9 is a storage-type remote conference information processing device, 300,

上記の構成において、遠隔会議システム使用者は、相手と時間を共有して通信回線を通じて直接対話するのではなく、映像音響情報蓄積サーバ400に、映像情報、音声情報、心理状態表示データをいったん蓄積し、相手の都合が良いときにダウンロードしてもらって情報伝達を行う。また、他者から情報伝達があったときは、都合が良いときに、映像音響情報蓄積サーバ400にアクセスし、蓄積された送信者の映像情報、音声情報、心理状態表示データをダウンロードして閲覧する。

自分宛の情報があることを認識した通信端末300の使用者は、映像音響情報蓄積サーバ400にいったん蓄積された遠隔地の通信端末300’の対話相手の情報をダウンロードし、音声情報は、ヘッドフォン1により、相手の映像情報及び心理状態表示データは、画像表示装置3により得る。In the above configuration, the user of the teleconference system temporarily stores video information, audio information, and psychological state display data in the video / audio

The user of the

他者に送りたいメッセージがあるときは、マイクロフォン2で対話相手に話しかける音声情報は、送付先ラベルを添付して映像音響情報蓄積サーバ400に送る。同時に、蓄積型遠隔会議情報処理装置9で音声解析による使用者の心理状態推定にも用いられる。

カメラ4は、遠隔会議使用者の映像を撮影する。その映像情報は、送付先ラベルを添付して遠隔地の映像音響情報蓄積サーバ400に送る。同時に、蓄積型遠隔会議情報処理装置9で顔画像解析による使用者の心理状態推定にも用いられる。身体装着型生体センサ5は、脈拍数、皮膚温度、呼吸数の生体情報を検出する。これらのデータは、蓄積型遠隔会議情報処理装置9で生体情報解析による使用者の心理状態推定に用いられる。蓄積型遠隔会議情報処理装置9は、リアルタイムで生体情報、顔画像、音声情報の解析による使用者心理状態推定を行い、そのデータを使用者の映像、音声とともに送付先ラベルを添付して映像音響情報蓄積サーバ400に送る。Whenthere is a message to be sent to another person, the voice information to be spoken to the conversation partner with the

The

映像音響情報蓄積サーバ400は、遠隔会議システム使用者の映像、音声及び使用者の心理状態表示データを受け取ると、蓄積するとともに、情報送付先に伝達メッセージ到着を連絡する。When receiving the video and audio of the teleconference system user andthe psychological statedisplay data ofthe user,the video / audio

映像音響情報蓄積サーバ400から伝達メッセージ到着の連絡を受けた通信端末300の使用者は、都合が良いときに、映像音響情報蓄積サーバ400にアクセスし、蓄積された送信者の映像情報、音声情報、心理状態表示データをダウンロードする。相手の心理状態表示データは、蓄積型遠隔会議情報処理装置9で処理され、映像情報とともに画像表示装置3に表示される。送られてきた相手の音声情報は、遠隔会議情報処理装置9で処理され、ヘッドフォン1に出力される。 The user of the

以上の構成により、非同期遠隔会議使用者の音声、表情・動作、生体情報のデータから総合的に判断した心理状態を遠隔地の対話相手に表示することを可能にし、時間、空間を越えて心の微妙な変化を対話相手に伝える事が可能になる。With the above configuration, the asynchronous remote conference user of voice, facial expression and operation,the psychologicalstate after comprehensive consideration from the data of biological information makes it possible to display a remote location of the dialogue partner, time, beyond the space It is possible to convey subtle changes in mind to the other party.

図4は、非同期式遠隔会議の実施例の遠隔会議情報処理装置9の構成を示している。21は、音響出力インタフェース回路、22は、音響入力インタフェース回路、23は、映像出力インタフェース回路、24は、映像入力インタフェース回路、25は、生体情報入力インタフェース回路、26は、音響データ抽出回路、27は、映像データ抽出回路、28は、生体情報抽出回路、29は、心理状態推定回路、30は、心理状態データ生成回路、31は、映像・音響多重回路、32は、送信データ多重化回路、33は、送信回路、34は、受信回路、35は、受信データ分離回路、36は、映像・音響分離回路、37は、会議映像/心理状態データ合成回路である。 FIG. 4 shows the configuration of the remote conference information processing apparatus 9 in the embodiment of the asynchronous remote conference. 21 is an acoustic output interface circuit, 22 is an acoustic input interface circuit, 23 is a video output interface circuit, 24 is a video input interface circuit, 25 is a biological information input interface circuit, 26 is an acoustic data extraction circuit, 27 Is a video data extraction circuit, 28 is a biological information extraction circuit, 29 is a psychological state estimation circuit, 30 is a psychological state data generation circuit, 31 is a video / acoustic multiplexing circuit, 32 is a transmission data multiplexing circuit, 33 is a transmission circuit, 34 is a reception circuit, 35 is a reception data separation circuit, 36 is a video / sound separation circuit, and 37 is a conference video / psychological state data synthesis circuit.

音響出力インタフェース回路21は、図3のヘッドフォン1に接続されている。音響入力インタフェース回路22は、マイクロフォン2に接続されている。映像出力インタフェース回路23は、画像表示装置3に接続されている。映像入力インタフェース回路24は、カメラ4に接続されている。生体情報入力インタフェース回路25は、身体装着型生体センサ5に接続されている。 The sound

音響データ抽出回路26は、音響入力インタフェース回路22の信号から、心理状態を推定する音声データとして、音声スペクトルの最大パワーレベルとその周波数を抽出する。 The sound

映像データ抽出回路27は、映像入力インタフェース回路24の映像信号から顔画像の複数の特徴点の相対的移動変化量から心理状態を推定する。具体的には、顔画像の唇の左右端2点、右眉の左右端2点、左眉の左右端2点の相対的移動変化量を抽出する。これらの顔画像の特徴点の変化量を1〜3秒間隔で算出する。 The video data extraction circuit 27 estimates a psychological state from the relative movement change amounts of a plurality of feature points of the face image from the video signal of the video input interface circuit 24. Specifically, the relative movement change amounts of the two left and right end points of the lips of the face image, the two right and left end points of the right eyebrow, and the two left and right end points of the left eyebrow are extracted. The amount of change of the feature points of these face images is calculated at intervals of 1 to 3 seconds.

生体情報抽出回路28は、生体情報入力インタフェース回路25の信号から脈拍数、皮膚温度、呼吸数の変化量を抽出する。これらの生体情報の変化量を2〜10秒間隔で算出する。 The biometric

心理状態推定回路29は、音響データ抽出回路26の音声データ、映像データ抽出回路27の顔画像データ、生体情報抽出回路28の生体データを基に「驚き」、「納得」、「面白さ」、「困惑」といった利用者の心理状態を実時間で推定する回路である。

心理状態データ生成回路30は、心理状態推定回路29の出力である利用者の心理状態推定結果をもとに、使用者の推定心理状態を他人が一目でわかるようなアバタ−、二次元もしくは三次元アニメーションなど心理状態表示人工構造物データを生成する。

音響入力インタフェース回路22及び映像入力インタフェース回路24のデジタル出力信号は、映像・音響多重回路31で多重化される。The psychological state estimation circuit 29 performs “surprise”, “consent”, “fun” based on the audio data of the acoustic

The psychological state

Digital output signals of the audio

映像・音響多重回路31及び心理状態データ生成回路30の出力は、送信データ多重化回路32で多重化され、送信回路33からネットワークに送り出される。

ネットワークから送られてきたデータは、受信回路34で受信され、受信データ分離回路35で、対話相手の心理状態表示人工構造物データと対話相手の映像・音声多重化データに分離される。The outputs of the video /

The data sent from the network is received by the receiving

映像・音響分離回路36は、映像・音声多重化データを映像データと音声データに分離する。分離された音声データは、音響出力インタフェース回路21に送られ、アナログ情報に変換される。 The video / sound separation circuit 36 separates the video / audio multiplexed data into video data and audio data. The separated audio data is sent to the acoustic

会議映像/心理状態データ合成回路37は、分離された映像データと心理状態表示人工構造物データを合成し、映像出力インタフェース回路23に送られ、アナログ情報に変換される。

推定する利用者の心理状態の種類を予め「驚き」、「納得」、「面白さ」、「困惑」の四つに設定し、生体情報、顔画像のデータごとに個々の前記心理状態に対応する判断基準値を蓄積記憶し、抽出された各時点の音声、表情・動作、生体情報のデータごとに前記心理状態の判断基準値との差分から一致指数を算出し、心理状態ごとに生体情報、表情・動作のデータの一致指数を合算し、一致指数が最大の心理状態をその時点の心理状態と推定する。The conference video / psychological state

Predict the user's psychological state types to “surprise”, “convince”, “interesting”, and “confused” in advance, corresponding to each psychological state for each piece of biometric information and facial image data The judgment reference value is stored and stored, and the coincidence index is calculated from the difference from the judgment reference value of the psychological state for each extracted voice, facial expression / motion, biological information data at each time point, and the biometric information for each psychological state Then, the coincidence indices of the facial expression / motion data are added together, and the psychological state having the maximum coincidence index is estimated as the psychological state at that time.

音声データでは、詳細な心理状態の識別が困難であるので、「高揚」もしくは「非高揚」心理状態の識別のみを行う。例えば、前記4つの心理状態にさらに「怒り」の心理状態を追加する必要がある場合に、本データを追加することができる。

判断基準値は、測定データの変化率で定めており、遠隔地間での対話開始前に、各個人別に音声、表情・動作、生体情報のデータごとに各心理状態に対応する測定基準値を測定し蓄積記憶しておく。With voice data, it is difficult to identify a detailed psychological state, so only “high” or “non-high” psychological states are identified. For example, this data can be added when it is necessary to add an “anger” psychological state to the four psychological states.

Judgment standard values are determined by the rate of change of measurement data, and before each conversation between remote locations, the measurement standard values corresponding to each psychological state for each voice, facial expression / motion, and biological information data for each individual. Measure and store it.

図5は、心理状態推定回路29の処理アルゴリズムを示している。顔画像データ1(右唇位置)、顔画像データ2(左唇位置)、顔画像データ3(右内眉位置)、顔画像データ4(左内眉位置)、顔画像データ5(右外眉位置)、顔画像データ6(左外眉位置)、生体データ1(呼吸数)、生体データ2(心拍数)、生体データ3(皮膚温度)ごとにその測定変化率から「驚き」、「納得」、「面白さ」、「困惑」の四つの心理状態に対応する判断基準値が蓄積記憶されている。特定の時点の測定データから各心理状態別の一致指数を計算する。 FIG. 5 shows a processing algorithm of the psychological state estimation circuit 29. Face image data 1 (right lip position), face image data 2 (left lip position), face image data 3 (right inner eyebrow position), face image data 4 (left inner eyebrow position), face image data 5 (right outer eyebrow position) Position), face image data 6 (left outer eyebrow position), biometric data 1 (respiration rate), biometric data 2 (heart rate), and biometric data 3 (skin temperature) from the measurement change rate, "surprise" ”,“ Interesting ”, and“ Confusion ”are stored and stored as reference values corresponding to the four psychological states. The coincidence index for each psychological state is calculated from the measurement data at a specific time.

9種類の測定データごとに計算した四つの心理状態に対応する一致指数を「驚き」、「納得」、「面白さ」、「困惑」の心理状態ごとに合算する。一致指数合算値が最大の心理状態と判定する。

音声データから「高揚」心理状態/「非高揚」心理状態の判定を行う。これらの推定データは、心理状態データ生成回路30に送られ、使用者の推定心理状態を他人が一目でわかるようなアバタ−、二次元もしくは三次元アニメーションなど心理状態表示人工構造物データを生成する。The coincidence indices corresponding to the four psychological states calculated for each of the nine types of measurement data are summed up for each psychological state of “surprise”, “convinced”, “fun”, and “confused”. The psychological state having the maximum coincidence index sum is determined.

Judgment of “uplifted” psychological state / “non-uplifted” psychological state is performed from the voice data. These estimated data are sent to the psychological state

以下、図5のアルゴリズムに組み込まれている音声、顔画面、生体情報別にその判定基準値の具体例を説明する。

図6は、音声最大レベル値及び最大レベルの周波数の変化率と心理状態の関係を示している。音声最大パワーレベル及びその周波数の変化率からは細かい心理状態を分けて推測することは難しい。怒りといった高揚心理状態とその他の心理状態(非高揚心理状態)の分離のみが可能である。測定データが四角の枠内であるならば、「高揚」心理状態もしくは「非高揚」心理状態と判断する。Hereinafter, specific examples of the determination reference value will be described for each voice, face screen, and biological information incorporated in the algorithm of FIG.

FIG. 6 shows the relationship between the voice maximum level value and the frequency change rate of the maximum level and the psychological state. It is difficult to deduce a detailed psychological state from the maximum voice power level and the rate of change of its frequency. Only the uplifting psychological state such as anger and other psychological states (non-uplifting psychological state) can be separated. If the measurement data is within the square frame, it is determined as an “uplift” psychological state or a “non-uplift” psychological state.

顔画面の解析は、頭頂−あごのラインを基準線41として相対座標系40を再計算することにより、頭のぶれや画面に占める顔の割合などに左右されずに、ほぼ計測点の動きだけを算定し、顔画像の複数の特徴点の相対的移動変化量から心理状態を推定する。具体的には、顔画像の唇の左右端2点、右眉の左右端2点、左眉の左右端2点の相対的移動変化量から心理状態を推定する。 In the analysis of the face screen, the relative coordinate

図7は、顔画面をデータから頭頂−あごのラインを基準線41として相対座標系40を再計算する過程の画像の一部である。顔画像の複数の特徴点の変化量は、1〜3秒間隔で算出する。

図8は、右唇の画像解析結果(位置変化率)を示している。「驚き」の心理状態での変化は広範囲にy軸下方に広がっている。「面白さ」の心理状態での変化はy軸上方向に引き上げられる傾向がある。逆に、「困惑」での変化はx軸方向外側に伸びる傾向にある。図9は、左唇の画像解析結果を示している。右唇と同様な動きをしている。FIG. 7 is a part of an image in the process of recalculating the relative coordinate

FIG. 8 shows the image analysis result (position change rate) of the right lip. The change in the psychological state of “surprise” has spread widely below the y-axis. Changes in the psychological state of “interesting” tend to be raised in the y-axis upward direction. On the contrary, the change in “confused” tends to extend outward in the x-axis direction. FIG. 9 shows the image analysis result of the left lip. It moves in the same way as the right lip.

図10は、右内眉の画像解析結果(位置変化率)を示している。「驚き」及び「困惑」の心理状態での変化は、x軸方向に長くなる傾向にある。「納得」と「面白さ」の心理状態での変化は左右どちらもほぼ重なっており、これらの計測点だけで判断するのは難しい。

図11は、左内眉の画像解析結果(位置変化率)を示している。右内眉とほぼ同様な変化の動きをしている。図12は、右外眉の画像解析結果(位置変化率)を示している。「驚き」及び「困惑」の心理状態での変化は、x軸方向長くなる傾向にあり、重なりやすくなっている(識別しにくくなっている)。「面白さ」の心理状態での変化はx,y軸方向ともに一番変化が少ない。「納得」の心理状態での変化はx軸方向へ大きく動くことが多い。FIG. 10 shows the image analysis result (position change rate) of the right inner eyebrow. Changes in the psychological state of “surprise” and “confused” tend to be longer in the x-axis direction. Changes in the psychological state of "Consent" and "Interesting" are almost overlapped on both the left and right sides, and it is difficult to judge only from these measurement points.

FIG. 11 shows the image analysis result (position change rate) of the left inner eyebrow. The movement is almost the same as the right inner eyebrow. FIG. 12 shows the image analysis result (position change rate) of the right outer eyebrow. Changes in the psychological state of “surprise” and “confused” tend to be longer in the x-axis direction, and are more likely to overlap (become difficult to identify). The change in the psychological state of “fun” is the least in both the x and y axis directions. Changes in the psychological state of “convinced” often move greatly in the x-axis direction.

図13は、左外眉の画像解析結果(位置変化率)を示している。右外眉と同様な動きをしている。図14は、平均化時間を5秒に設定したときの生体情報のデータ例、図15は、平均化時間を10秒に設定したときの生体情報のデータ、図16は、平均化時間を30秒に設定したときの生体情報のデータ例である。平均化時間が長くなると雑音成分が除去されるが同時に生体情報の急峻な変化量も平滑化され重要な情報が失われる。そこで、本実施態様では、脈拍数、皮膚温度、呼吸数の生体情報の変化量を10秒間隔で抽出している。 FIG. 13 shows the image analysis result (position change rate) of the left outer eyebrow. It moves in the same way as the right outer eyebrow. FIG. 14 shows an example of biometric information data when the averaging time is set to 5 seconds, FIG. 15 shows biometric information data when the averaging time is set to 10 seconds, and FIG. It is a data example of the biometric information when set to second. When the averaging time becomes longer, the noise component is removed, but at the same time, the abrupt change amount of the biological information is also smoothed and important information is lost. Therefore, in this embodiment, changes in biological information such as pulse rate, skin temperature, and respiratory rate are extracted at 10-second intervals.

図17は、生体情報のうち、脈拍と呼吸数の心理状態判定基準を示している。「納得」と「面白さ」の心理状態は、「困惑」心理状態は分離することが可能であるが、「驚き」の心理状態の範囲は全体に広がっており、他の心理状態との分離は不可能である。

図18は、生体情報のうち、呼吸数と皮膚温度の心理状態判定基準を示している。「納得」と「面白さ」の心理状態は「困惑」の心理状態と分離可能である。

図19 左外眉の測定データの一致度指数の算出方法を示している。測定点と「驚き」、「納得」、「困惑」、「面白さ」の四つの心理状態判定区間の平均点の距離をもとに一致指数を算出している。もっとも距離の短い心理状態の一致指数を「+1」、もっとも距離の長い心理状態の一致指数を「−1」、その他の心理状態の一致指数を「0」とした。FIG. 17 shows psychological state determination criteria for pulse and respiratory rate in the biological information. Psychological states of “Consent” and “Interesting” can be separated from “Puzzled” psychological states, but the range of “Surprised” psychological states is widened and separated from other psychological states. Is impossible.

FIG. 18 illustrates psychological state determination criteria for respiratory rate and skin temperature in the biological information. The psychological state of "Consent" and "Interesting" can be separated from the psychological state of "Confusion".

FIG. 19 shows a method for calculating the coincidence index of the measurement data of the left outer eyebrow. The coincidence index is calculated based on the distance between the measurement points and the average points of the four psychological state determination sections of “surprise”, “convinced”, “confused”, and “interesting”. The coincidence index of the psychological state with the shortest distance was “+1”, the coincidence index of the psychological state with the longest distance was “−1”, and the coincidence index of the other psychological states was “0”.

以上の構成により、遠隔会議使用者の音声、表情・動作、生体情報のデータを総合的に判断して多様な使用者心理状態を実時間で推定し、遠隔地の対話相手に表示することを可能にし、遠隔にいる対話相手の心の微妙な変化を相手に伝える事が可能になる。 With the above configuration, it is possible to comprehensively judge the remote conference user's voice, facial expression / motion, and biological information data, estimate various user psychological states in real time, and display them to the remote conversation partner. It becomes possible, and it becomes possible to convey the subtle change of the mind of the remote conversation partner to the other party.

1 ヘッドフォン

2 マイクロフォン

3 画像表示装置

4 カメラ

5 身体装着型生体センサ

7 通信ネットワーク

9 蓄積型遠隔会議情報処理装置

21 音響出力インタフェース回路

22 音響入力インタフェース回路

23 映像出力インタフェース回路

24 映像入力インタフェース回路

25 生体情報入力インタフェース回路

26 音響データ抽出回路

27 映像データ抽出回路

28 生体情報抽出回路

29 心理状態推定回路

30 心理状態データ生成回路

31 映像・音響多重回路

32 送信データ多重化回路

33 送信回路

34 受信回路

35 受信データ分離回路

36 映像・音響分離回路

37 会議映像/心理状態データ合成回路

300,300’ 通信端末

400 映像音響情報蓄積サーバDESCRIPTION OF

Claims (3)

Translated fromJapanese音声情報の入出力を行う音声情報入出力手段と、

映像情報の入出力を行う映像情報入出力手段と、

生体情報の入力を行う生体情報入力手段と、

音声、表情・動作、生体情報のデータを実時間でそれぞれ抽出するデータ抽出手段と、

音声、表情・動作、生体情報の抽出データから利用者の心理状態を実時間で推定する心理状態推定手段と、

利用者自身の映像音響情報に加え心理状態表示データをサーバに実時間伝送し、当該サーバに前記映像音響情報と心理状態表示データを一時蓄積させ、通信相手が前記サーバを介して任意の時間に取り出すことを可能にする送信手段と、

前記蓄積された対話相手の端末の映像音響情報と心理状態表示データを、ネットワークを介してサーバより受信する受信手段と、そして、

前記受信手段を介して取得した心理状態表示データから対話相手の心理状態表示人工構造物を表示する心理状態表示人工構造物表示手段と、

を備え、

前記心理状態推定手段は、

遠隔地間での対話開始前に、各個人別に音声、表情・動作、生体情報から各心理状態に対応する測定基準値を予め測定し、前記端末の心理状態推定回路内に蓄積記憶し、

前記音声、映像情報の入出力手段を介して入力された音声の音声最大レベル値及び最大レベルの周波数の変化から「高揚」又は「非高揚」の心理状態を推定し、

前記音声、映像情報の入出力手段を介して入力された顔画像の複数の特徴点の相対的移動変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、

前記利用者の顔画像の唇の左右端2点、右眉の左右端2点、左眉の左右端2点の相対的移動変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、

前記利用者の脈拍数、皮膚温度、呼吸数の生体情報の変化量から「驚き」、「納得」、「面白さ」、「困惑」の心理状態を推定する心理状態判定区間の平均点からの距離を一致指数として算出し、

各々の心理状態ごとに算出された各前記一致指数をそれぞれ合算し、一致指数が最大の心理状態をその時点の心理状態と推定することを特徴とする遠隔会議・教育システム。A remote conference / education system in which a server and a plurality of terminals can be connected via a network.

Voice information input /output means forinputting andoutputting voice information ;

Video information input /output means forinputting / outputting video information ;

Biometric informationinput means forinputting biometric information ;

Audio, anddata extracting means for extractingrespective expression-operation, the data of the biological information in real time,

Psychological state estimating means for estimating a user's psychological state in real time from extracted data of voice, facial expression / motion and biological information;

In addition to the user's own audiovisual information, the psychological statedisplay data is transmitted to the server in real time, the audiovisual information and the psychological statedisplay data are temporarily storedin theserver , and the communication partner can communicate at any timevia the server. Atransmission means that enables retrieval;

Receiving means for receiving the stored audiovisual information and psychological statedisplay data of the conversation partner terminal from a server via a network; and

Psychological state display artificial structure display means for displaying thepsychological state display artificial structure of the conversation partnerfrom the psychological state display data acquired via the receiving means ;

Equipped witha,

The psychological state estimating means includes

Before starting the conversation between remote locations, measure the reference value correspondingto each psychological state inadvancefrom voice, facial expression / motion, biometric information for each individual, and store and store inthe psychological state estimation circuit of the terminal ,

Estimating the psychological state of“uplifting” or “non-uplifting” from the change in the maximum audio level value and the maximum level frequency of the audio input through the audio and video information input / output means ,

Estimate the psychological state of "surprise", "convincing", "interesting", or "confused" from the relative movement change amount of a plurality of feature points ofthe face imageinput through the voice / video information input / output meansCalculate the distance from the average point of the psychological state determination interval to be a match index ,

“Surprise”, “Consent”, “Interesting”, “Interest” from the relative movement change amounts of the left and right ends of the lips, the left and right ends of the right eyebrow, and the left and right ends of the left eyebrow of theuser's face image.Calculate the distance from the average point of the psychological state determination section that estimates the psychological state of "confused" as a coincidence index,

Fromthe average point of the psychological state determination section that estimates the psychological state of "surprise", "consent", "interesting", "confused" from the amount of change in the biological information of theuser's pulse rate, skin temperature, respiratory rateCalculate distance as a match index,

A teleconferencing / education system characterized bysumming up the respective coincidence indexes calculated for each psychological state, and estimating a psychological state having the maximum coincidence index as a psychological state at that time.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2005076012AJP4604173B2 (en) | 2005-03-16 | 2005-03-16 | Remote conference / education system |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2005076012AJP4604173B2 (en) | 2005-03-16 | 2005-03-16 | Remote conference / education system |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2006262010A JP2006262010A (en) | 2006-09-28 |

| JP4604173B2true JP4604173B2 (en) | 2010-12-22 |

Family

ID=37100759

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2005076012AExpired - Fee RelatedJP4604173B2 (en) | 2005-03-16 | 2005-03-16 | Remote conference / education system |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4604173B2 (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US10798337B2 (en) | 2017-10-06 | 2020-10-06 | Fuji Xerox Co., Ltd. | Communication device, communication system, and non-transitory computer readable medium storing program |

Families Citing this family (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR100657901B1 (en)* | 2004-10-12 | 2006-12-14 | 삼성전자주식회사 | Method and apparatus for generating avatar image according to health condition |

| JP2010531478A (en)* | 2007-04-26 | 2010-09-24 | フォード グローバル テクノロジーズ、リミテッド ライアビリティ カンパニー | Emotional advice system and method |

| EP2206053A4 (en)* | 2007-10-03 | 2012-11-21 | Ottawa Hospital Res Inst | METHOD AND APPARATUS FOR MONITORING THE TIME VARIABILITY OF A PHYSIOLOGICAL PARAMETER FOR ONE OR MORE ORGANS |

| JP5338350B2 (en)* | 2009-02-06 | 2013-11-13 | 富士ゼロックス株式会社 | Information processing apparatus and voice correction program |

| JP4788786B2 (en)* | 2009-02-09 | 2011-10-05 | 株式会社デンソー | Sleepiness detection device, program, and sleepiness detection method |

| JP2016131741A (en)* | 2015-01-20 | 2016-07-25 | 株式会社リコー | Communication terminal, Interview system, display method and program |

| JP6841016B2 (en)* | 2016-11-21 | 2021-03-10 | コニカミノルタ株式会社 | Conference system, conference management equipment and programs |

| JP6981214B2 (en) | 2017-12-05 | 2021-12-15 | 富士通株式会社 | Image generation program, image generation device and image generation method |

| JP7132568B2 (en)* | 2018-05-17 | 2022-09-07 | Cyberdyne株式会社 | Biological information measuring device and biological information measuring method |

| JP7379907B2 (en)* | 2019-07-30 | 2023-11-15 | 株式会社リコー | Information processing device, information processing program, information processing system, information processing method |

| TWI829944B (en)* | 2020-02-27 | 2024-01-21 | 未來市股份有限公司 | Avatar facial expression generating system and method of avatar facial expression generation |

| WO2021210332A1 (en)* | 2020-04-14 | 2021-10-21 | ソニーグループ株式会社 | Information processing device, information processing system, information processing method, and program |

| JP6872066B1 (en)* | 2020-07-03 | 2021-05-19 | 株式会社シーエーシー | Systems, methods and programs for conducting communication via computers |

| JP7427112B2 (en)* | 2020-12-25 | 2024-02-02 | 三菱電機株式会社 | Information processing device, display control system, display control method, and display control program |

| JP7590866B2 (en)* | 2020-12-28 | 2024-11-27 | シャープ株式会社 | Interactive communication support system and computer program |

| JP2023056780A (en)* | 2021-10-08 | 2023-04-20 | コニカミノルタ株式会社 | Information processing device and program |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH04260291A (en)* | 1991-02-15 | 1992-09-16 | Fujitsu Ltd | Picture transmission system |

| JPH09138767A (en)* | 1995-11-14 | 1997-05-27 | Fujitsu Ten Ltd | Communication equipment for feeling expression |

| JP3730505B2 (en)* | 2000-10-31 | 2006-01-05 | 株式会社東芝 | COMMUNICATION IMAGE GENERATION DEVICE, COMMUNICATION IMAGE GENERATION METHOD, AND RECORDING MEDIUM |

| JP2003037826A (en)* | 2001-07-23 | 2003-02-07 | Alpine Electronics Inc | Substitute image display and tv phone apparatus |

| JP2004349851A (en)* | 2003-05-20 | 2004-12-09 | Ntt Docomo Inc | Mobile terminal, image communication program, and image communication method |

- 2005

- 2005-03-16JPJP2005076012Apatent/JP4604173B2/ennot_activeExpired - Fee Related

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US10798337B2 (en) | 2017-10-06 | 2020-10-06 | Fuji Xerox Co., Ltd. | Communication device, communication system, and non-transitory computer readable medium storing program |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2006262010A (en) | 2006-09-28 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN112075075B (en) | Method and computerized intelligent assistant for facilitating teleconferencing | |

| JP4604173B2 (en) | Remote conference / education system | |

| JP7400100B2 (en) | Privacy-friendly conference room transcription from audio-visual streams | |

| CN107918771B (en) | Person identification method and wearable person identification system | |

| US9329677B2 (en) | Social system and method used for bringing virtual social network into real life | |

| US8243116B2 (en) | Method and system for modifying non-verbal behavior for social appropriateness in video conferencing and other computer mediated communications | |

| US11341148B2 (en) | Information processing system and information processing method to specify persons with good affinity toward each other | |

| US20180077095A1 (en) | Augmentation of Communications with Emotional Data | |

| EP3739573B1 (en) | Information processing device, information processing method, and program | |

| US20040013252A1 (en) | Method and apparatus for improving listener differentiation of talkers during a conference call | |

| JP2002034936A (en) | Communication device and communication method | |

| JP2011186521A (en) | Emotion estimation device and emotion estimation method | |

| JP2016103081A (en) | Conversation analysis device, conversation analysis system, conversation analysis method and conversation analysis program | |

| JP7323098B2 (en) | Dialogue support device, dialogue support system, and dialogue support program | |

| US20020197967A1 (en) | Communication system with system components for ascertaining the authorship of a communication contribution | |

| JP2021521704A (en) | Teleconference systems, methods for teleconferencing, and computer programs | |

| JP2019086858A (en) | Customer service system and customer service method | |

| WO2022137547A1 (en) | Communication assistance system | |

| JP6977463B2 (en) | Communication equipment, communication systems and programs | |

| JP6901190B1 (en) | Remote dialogue system, remote dialogue method and remote dialogue program | |

| KR20230103664A (en) | Method, device, and program for providing interactive non-face-to-face video conference using avatar based on emotion and concentration indicators by using deep learning module | |

| US11348368B2 (en) | Measuring and transmitting emotional feedback in group teleconferences | |

| JP2004248125A (en) | Video switching device, video switching method, program of this method, and recording medium recording this program | |

| US12107699B2 (en) | Systems and methods for creation and application of interaction analytics | |

| JP6823367B2 (en) | Image display system, image display method, and image display program |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20080311 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20100713 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20100803 | |

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 Effective date:20100907 | |

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 | |

| A61 | First payment of annual fees (during grant procedure) | Free format text:JAPANESE INTERMEDIATE CODE: A61 Effective date:20100907 | |

| R150 | Certificate of patent or registration of utility model | Free format text:JAPANESE INTERMEDIATE CODE: R150 | |

| FPAY | Renewal fee payment (event date is renewal date of database) | Free format text:PAYMENT UNTIL: 20131015 Year of fee payment:3 | |

| LAPS | Cancellation because of no payment of annual fees |