JP4351982B2 - Personal authentication method, apparatus and program - Google Patents

Personal authentication method, apparatus and programDownload PDFInfo

- Publication number

- JP4351982B2 JP4351982B2JP2004295312AJP2004295312AJP4351982B2JP 4351982 B2JP4351982 B2JP 4351982B2JP 2004295312 AJP2004295312 AJP 2004295312AJP 2004295312 AJP2004295312 AJP 2004295312AJP 4351982 B2JP4351982 B2JP 4351982B2

- Authority

- JP

- Japan

- Prior art keywords

- skin texture

- personal authentication

- image

- degree

- texture

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Collating Specific Patterns (AREA)

Description

Translated fromJapanese本発明は、認証対象の個人が登録されている個人であるかどうかを認証する個人認証方法及び装置に関する。 The present invention relates to a personal authentication method and apparatus for authenticating whether or not an individual to be authenticated is a registered individual.

近年、セキュリティ技術やヒューマンインタフェースの分野では、コンピュータ技術を利用し、人物をカメラで撮影して得られる画像を解析することにより個人認証、すなわち対象の個人が登録されている個人か否かを認証することが試みられている。人間の生体情報を利用する個人認証技術としては、顔、声紋、指紋、虹彩などを認識する方法がある。それらの中で特に顔を認識して個人認証を行う方法は、対象の個人に精神的、肉体的負担をかけることがなく、利用しやすいという特徴がある。 In recent years, in the field of security technology and human interface, personal authentication is performed by analyzing the image obtained by photographing a person with a camera using computer technology, that is, whether the target individual is a registered individual or not. It has been tried to do. As a personal authentication technique using human biometric information, there is a method for recognizing a face, a voiceprint, a fingerprint, an iris, or the like. Among them, the method of performing personal authentication especially by recognizing a face is characterized by being easy to use without placing a mental or physical burden on the target individual.

顔の認識方法については、例えばGabor-Waveletによって顔画像から特徴点を抽出し、特徴点同士の位置関係から認識を行う手法や、顔画像の濃淡パターンを特徴ベクトルとして抽出する手法などが例えば非特許文献1:赤松茂:“コンピュータによる顔の認識”電子情報通信学会論文誌Vol. J80-A No.8 pp.1215-1230(1997)によって紹介されている。 As for the face recognition method, for example, a method of extracting feature points from a face image by Gabor-Wavelet and recognizing from the positional relationship between the feature points, a method of extracting a shading pattern of the face image as a feature vector, etc. Patent Document 1: Shigeru Akamatsu: “Recognition of Face by Computer” is introduced in IEICE Transactions Vol. J80-A No.8 pp.1215-1230 (1997).

これらの手法においては、ホクロ、シミ、ソバカス、アザ、傷跡、毛穴、刺青などに関する情報はノイズとして無視される。例えば、特許文献1:特開平10−283472号公報では、このような小領域をノイズとみなして削除することが述べられている。 In these methods, information on moles, spots, freckles, aza, scars, pores, tattoos, etc. is ignored as noise. For example, Japanese Patent Application Laid-Open No. 10-283472 discloses that such a small area is regarded as noise and deleted.

一方、ホクロの位置に代表されるように、皮膚のテクスチャに関する情報は個人の特徴として古くから指名手配や鑑識などの犯罪捜査で使われており、また特許文献2:特開平10−283472号公報などにおいても個人の特徴として指摘されている。

上述のように従来のコンピュータ技術を利用した個人認証技術においては、顔画像全体から特徴点や濃淡パターンの特徴ベクトルといった特徴情報を抽出して顔の認識を行うため、例えば双子のように認証対象の人物に顔が全体的に似ている人を認証対象の個人と誤認する可能性がある。また、認証対象の個人を撮影する際の照明光の照度変動や色温度などの影響や、表情の経年変化などの影響によっても個人認証の精度が低下するという問題点がある。 As described above, in the personal authentication technology using the conventional computer technology, feature information such as feature points and feature vectors of gray pattern is extracted from the entire face image to recognize the face. There is a possibility that a person whose face generally resembles the person in question is mistaken as an individual to be authenticated. In addition, there is a problem that the accuracy of the personal authentication is lowered due to the influence of the illuminance fluctuation and color temperature of the illumination light when photographing the person to be authenticated, and the influence of the aging of the facial expression.

本発明は、比較的簡単な処理によって精度のよい個人認証を行うことができる個人認証方法及び装置を提供することにある。 An object of the present invention is to provide a personal authentication method and apparatus capable of performing accurate personal authentication by relatively simple processing.

上記の課題を解決するため、本発明では認証対象の個人の画像を入力し、入力された画像から前記認識対象の個人の特定の皮膚テクスチャの分離度と前記皮膚テクスチャの内側と外側の平均輝度の比とを含む属性情報から得られる、前記分離度と前記平均輝度の比との積を用いて定義される皮膚テクスチャらしさを用いて前記皮膚テクスチャを検出する。検出された皮膚テクスチャの位置に皮膚テクスチャらしさから得られる値を持つ、皮膚テクスチャの特徴量を示す第1特徴パターンを生成し、該第1特徴パターンとデータベースに予め記憶された、皮膚テクスチャの位置に皮膚テクスチャらしさから得られる値を持つ、皮膚テクスチャの特徴量を示す複数の第2特徴パターンとをそれぞれの類似度を用いて照合して認証対象の個人についての個人認証結果を得る。In order to solve the above problems, in the present invention, an image of an individual to be authenticated is input, thedegree ofseparation of a specific skin texture of the individual to be recognized from the input image,and the average brightness inside and outside the skin texture The skin texture is detected by usinga skin texture-likenessdefined by using a product of the degree of separation and the ratio of the average luminance, which is obtained from attribute informationincludingthe ratio .The position of the detected skin texturewith a value derived from the skin texture likelihoodto generate a first feature pattern indicating a characteristic of the skin texture, stored in advance in the first feature patternand thedatabase, the position of the skin texture A plurality of second feature patternshaving a value obtained from skin texture likelihood and indicating a feature amount of the skin texture are collatedusing respective similarities to obtain a personal authentication result for the individual to be authenticated.

ホクロ、シミ、ソバカス、アザ、傷跡、毛穴、刺青などといった皮膚テクスチャに関する情報は、個人を特定する上で有効な特徴であり、これを個人認証に利用することは有用と考えられる。 Information on skin texture such as mole, stain, buckwheat, aza, scar, pore, tattoo, etc. is an effective feature for identifying an individual, and it is considered useful to use this for personal authentication.

本発明によれば、このような皮膚テクスチャに関する情報を用いて個人認証を行うことにより、例えば双子のように顔が似ている人物同士でも皮膚テクスチャまでが類似していることは少ないので、別の人物として正しく認証することが可能になる。また、これら皮膚のテクスチャの特徴は一般に照明光の照度変動や色温度の影響を受けにくく、さらに経年変化の影響も受けにくいので、精度のよい個人認証が可能となる。 According to the present invention, by performing personal authentication using such information on skin texture, it is rare that even people with similar faces such as twins have similar skin textures. It becomes possible to authenticate correctly as a person. In addition, these skin texture features are generally less susceptible to illuminance fluctuations and color temperature of illumination light, and are also less susceptible to secular change, enabling accurate personal authentication.

以下、図面を参照して本発明の実施形態について説明する。以下の実施形態では、認証対象の個人の顔の画像から皮膚テクスチャとしてホクロを検出し、顔上でのホクロの配置や濃淡に関する情報を使用して個人認証を行う例について述べる。 Hereinafter, embodiments of the present invention will be described with reference to the drawings. In the following embodiment, an example will be described in which a mole is detected as a skin texture from an image of the face of an individual to be authenticated, and personal authentication is performed using information on the arrangement and density of the mole on the face.

(第1の実施形態)

図1に示されるように、第1の実施形態に係る個人認証装置は画像入力部11、皮膚テクスチャ検出部12、特徴パターン生成部13、照合部14、データベース15及び認証結果出力部16を有する。以下、図1の各部の概略について説明すると、まず画像入力部11は例えば認証対象の個人の顔を撮影して顔の画像を画像信号として入力する。画像入力部11が入力する画像は、典型的には可視光画像であるが、赤外線画像や紫外線画像であっても構わない。可視光画像を入力する装置としては、具体的には電子的なカメラ、例えばディジタルスチルカメラあるいはビデオカメラが用いられる。(First embodiment)

As shown in FIG. 1, the personal authentication device according to the first embodiment includes an

画像入力部11によって入力される画像は、皮膚テクスチャ検出部12に入力される。皮膚テクスチャ検出部12は、入力される画像から顔の皮膚テクスチャ、ここでは顔のホクロを検出する処理を行う。皮膚テクスチャ検出部12により検出された皮膚テクスチャの情報は、特徴パターン生成部13に渡される。特徴パターン生成部13では、皮膚テクスチャの特徴量を示す特徴パターンが生成される。 An image input by the

特徴パターン生成部13で生成された皮膚テクスチャの特徴パターンは照合部14に入力され、ここで予め登録されている複数の特徴パターン、すなわち予め作成されデータベース15に記憶されている複数の個人の特徴パターンと比較・照合される。データベース15に記憶されている複数の特徴パターンは、複数の個人の顔の皮膚テクスチャ(ここでは、ホクロのテクスチャ)の特徴量を示しており、各個人を示す個人IDと対応付けられて記憶されている。照合部14での照合により最終的に個人認証が行われ、認証結果出力部16において認証結果が例えば表示されることによって出力される。 The feature pattern of the skin texture generated by the feature

以下、図2〜図7を用いて図1の個人認証装置の処理手順について説明する。図2は、個人認証処理の大まかな手順を示すフローチャートである。

まず、画像入力部11によって認証対象の個人の顔を含む画像を入力する(ステップS21)。顔の画像は、典型的には正面を向いた顔の画像であり、後述する皮膚テクスチャ検出における基準点検出処理で基準点を検出できるような画像であればよい。画像入力部11は、画像をカラーとして取得する場合、後の処理を容易にするためにカラー画像を白黒の濃淡画像に変換することが望ましい。また、画像入力部11は画像をRGB空間またはY・Cr・Cb空間などの色空間へ変換して色情報を出力してもよい。Hereinafter, the processing procedure of the personal authentication device of FIG. 1 will be described with reference to FIGS. FIG. 2 is a flowchart showing a rough procedure of personal authentication processing.

First, an image including an individual face to be authenticated is input by the image input unit 11 (step S21). The face image is typically an image of a face facing the front, and may be an image that can detect a reference point by a reference point detection process in skin texture detection described later. When the

次に、皮膚テクスチャ検出部12によって顔の皮膚テクスチャ、例えばホクロを検出する(ステップS22)。皮膚テクスチャとしてホクロを検出する場合、まず入力された画像中から顔領域を特定し、次に一般にホクロは黒い円形状のものであるので、特定した顔領域から黒い円形領域を抽出する。さらに、皮膚テクスチャ検出部12では抽出した円形領域について表示画面上での属性情報、例えば座標、濃淡及び半径などの情報を併せて出力する。 Next, the skin

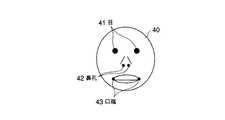

ここで、図3を用いて皮膚テクスチャ検出ステップS22の詳細を述べる。まず、顔領域を特定するために使用する顔の基準点を検出する(ステップS31)。ここでは、入力した顔の画像から例えば図4に示すように顔40の基準点として目41、鼻孔42及び口端43を検出し、目41、鼻孔42及び口端43の計6点の画像上での座標を出力する。基準点の検出方法は特に限定されないが、例えば参考文献1:福井和広、山口修:「形状抽出とパターン照合の組み合わせによる顔特徴点抽出」、電子情報通信学会論文誌(D), vol.J80-D-II, No.8, pp2170-2177(1997)に記載された顔特徴点の検出方法を用いることができる。 Here, details of the skin texture detection step S22 will be described with reference to FIG. First, the reference point of the face used for specifying the face area is detected (step S31). Here, for example, as shown in FIG. 4, the eyes 41, the

ここでは基準点検出ステップS31において顔40の基準点として目41、鼻孔42及び口端43の計6点の画像上での座標を出力するとしたが、目41、鼻孔42及び口端43のうちの任意の一つまたは二つを基準点としてもよい。さらに、目、鼻孔及び口端ではなく、目頭、目尻、眉、鼻、唇及び耳などを基準点として用いるか、あるいは目、鼻孔、目頭、目尻、眉、鼻、唇及び耳のうちの任意の一つまたは二つを基準点として使用することも可能である。 Here, in the reference point detection step S31, the coordinates on the image of a total of six points including the eye 41, the

次に、画像中の顔領域の位置及び大きさを予め決めた位置及び大きさに揃える正規化の処理を行う(ステップS32)。ここでは、ステップS31で検出した顔の基準点を用いて位置及び大きさを揃えた顔領域を求める。ステップS31で検出した目41、鼻孔42及び口端43の6点の座標を予め定めた6点の座標に移すアファイン変換を画像全体に施し、アフィン変換後の画像を出力する。目41、鼻孔42及び口端43の6点が予め定めた6点に移るようなアファイン変換が存在しない場合は、目41、鼻孔42及び口端43の6点に対し、該6点に対応する6点の残差が最小になるアファイン変換を正規化に使用するアファイン変換とする。 Next, normalization processing is performed to align the position and size of the face area in the image with a predetermined position and size (step S32). Here, a face region having the same position and size is obtained using the reference point of the face detected in step S31. The affine transformation is performed on the entire image, and the image after the affine transformation is output, by moving the coordinates of the six points of the eye 41, the

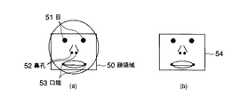

この結果、例えば図5(a)に示されるように、正規化した画像の目51、鼻孔52及び口端53の位置を基準に予め定めた領域を顔領域50とし、顔領域50で切り取った画像を図5(b)に示す正規化顔画像54とする。基準点検出ステップS31において、顔40の基準点として目41、鼻孔42及び口端43のうちの任意の一つまたは二つを基準点として用いたり、目頭、目尻、眉、鼻、唇及び耳などを基準点として用いたり、あるいは目、鼻孔、目頭、目尻、眉、鼻、唇及び耳のうちの任意の一つまたは二つを基準点として用いる場合、正規化ステップS32においてもステップS31で検出した顔の基準点を使用して顔領域の位置及び大きさを揃えればよい。 As a result, for example, as shown in FIG. 5A, a predetermined area based on the positions of the

なお、図3では正規化ステップS32の処理を基準点検出ステップS31の直後に行ったが、正規化ステップS32の処理は後述する照合ステップまでの間のどのタイミングで行ってもよい。 In FIG. 3, the process of normalization step S32 is performed immediately after the reference point detection step S31. However, the process of normalization step S32 may be performed at any timing until the collation step described later.

次に、分離度マップ生成ステップS33、特徴点候補検出ステップS34及び皮膚テクスチャ判定ステップS35によって、ステップS31〜S32で特定された顔領域からホクロらしい形状と色を持つ小領域を検出し、ホクロであるか判断する処理を行う。ここでは、ホクロらしい小領域として特に円形の黒色領域を検出する。 Next, in the separation degree map generation step S33, the feature point candidate detection step S34, and the skin texture determination step S35, a small region having a shape and color that seems to be a mole is detected from the face regions identified in steps S31 to S32. Processing to determine if there is. Here, a circular black area is detected as a small area that seems to be a mole.

分離度マップ生成ステップS33では、ホクロらしい形状を持つ小領域、ここでは円形領域を検出するための準備の処理を行う。すなわち、顔領域である正規化顔画像54の各点での分離度を計算し、各点での分離度を対応させた分離度マップを生成する。ここで、分離度とは2つの領域間の画像特徴量の分離度合いを0から1までの数値で表した指標であり、以下の数式(1)のηで計算される。

ただし、Piは画素iの輝度、P1,P2及びP1+2はそれぞれ領域1,領域2及び領域(1+2)における平均輝度、n1,n2及びNはそれぞれの領域1、領域2及び領域(1+2)における画素数である。Where Pi is the luminance of the pixel i, P1 , P2 and P1 + 2 are the average luminance in the region 1, region 2 and region (1 + 2), respectively, and n1 , n2 and N are the respective region 1 and region 2 and the number of pixels in the region (1 + 2).

画像入力部11が白黒画像の画像信号を生成する場合、輝度Piとしては白黒画像における画素値をそのまま用いる。また、画像入力部11が色情報を有する画像信号を生成する場合、分離度マップ生成ステップS33においては、分離度の計算の際にRGBやY・Cr・Cbなどの色情報を含んだ画素値を使用してもよい。When the

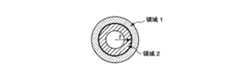

領域1及び領域2は、図6に示す円形の分離度フィルタにおいて半径rの円の外側の領域及び内側の領域とする。このような形状の分離度フィルタを使用することで、円形またはそれに準ずる形状の小領域を抽出することが可能である。分離度フィルタを用いて特徴点を検出する方法は、例えば特許第3279913号公報に開示されている。 Region 1 and region 2 are an outer region and an inner region of a circle with a radius r in the circular separability filter shown in FIG. By using the separability filter having such a shape, it is possible to extract a small region having a circular shape or a shape similar thereto. A method for detecting feature points using a separability filter is disclosed in, for example, Japanese Patent No. 3279913.

正規化された顔画像から半径rの円形領域を検出する場合は、図6に示す半径rの円形分離度フィルタを使用して分離度マップを作成する。大きさの異なる複数の円形領域を検出する場合は、それぞれ半径がr1, ..., r2の円形分離度フィルタを用意し、それぞれの円形分離度フィルタを用いて分離度マップを作成する。次の処理を軽くするために、各点で半径がr1, ..., r2の円形分離度フィルタで計算した分離度のうち、最大の分離度を対応させ、併せてそのときの半径を記憶するという方法をとってもよい。また、ノイズに対する耐性を上げるために、上述のようにして作成した分離度マップにガウスフィルタなどの平滑化フィルタ処理を行ってもよい。When detecting a circular region having a radius r from the normalized face image, a separability map is created using a circular separability filter having a radius r shown in FIG. When detecting a plurality of circular regions having different sizes, a circular separability filter having radii r1 ,..., R2 is prepared, and a separability map is created using each circular separability filter. . In order to lighten the next processing, at each point, the maximum resolution among the resolutions calculated by the circular resolution filter with radii r1 , ..., r2 is made to correspond, and the radius at that time You may take the method of memorize | storing. Further, in order to increase resistance to noise, smoothing filter processing such as a Gaussian filter may be performed on the separability map created as described above.

次の特徴点候補検出ステップS34では、分離度マップ生成ステップS33で生成された分離度マップである、ホクロらしい形状の小領域(ここでは円形領域)の特徴点候補を検出し、検出した円形領域がホクロであるかを判断するための属性情報を収集して付加する。すなわち、ステップS34ではステップS33で生成された分離度マップから特徴点候補を検出し、さらに各特徴点候補の点に関する属性情報を付加する。具体的な手順としては、まず分離度の低い部分を除去するために、分離度マップ内において分離度の値が予め定めた閾値を超える点を抽出する。 In the next feature point candidate detection step S34, feature point candidates of small regions (here, circular regions) shaped like moles, which are the separability maps generated in the separability map generating step S33, are detected, and the detected circular regions Collect and add attribute information to determine whether is a mole. That is, in step S34, feature point candidates are detected from the separability map generated in step S33, and attribute information regarding each feature point candidate point is added. As a specific procedure, first, in order to remove a portion having a low degree of separation, a point where the value of the degree of separation exceeds a predetermined threshold in the degree of separation map is extracted.

次に、円形の領域の中心において分離度が局所最大になる性質を利用して、抽出した点に対して分離度マップが局所最大となっている画像上の点を特徴点候補とし、属性情報と合わせてF=(x, y, s, r, b)を抽出する。ここで、x,yはそれぞれ特徴点候補の画像上のx座標及びy座標、sは特徴点候補における分離度、rは分離度フィルタの半径、bは分離度フィルタにおける円の外側と内側(図6の領域1と領域2)での輝度値の平均の比P1/P2である。Next, using the property that the separability is locally maximum at the center of the circular area, the point on the image where the separability map is locally maximum with respect to the extracted point is used as a feature point candidate, and attribute information And F = (x, y, s, r, b) is extracted. Here, x and y are the x-coordinate and y-coordinate on the feature point candidate image, s is the separability in the feature point candidate, r is the radius of the separability filter, and b is outside and inside the circle in the separability filter ( This is the average ratio P1 / P2 of the luminance values in region 1 and region 2) of FIG.

分離度マップが複数ある場合は、それぞれの分離度マップで上記の処理を行う。そして複数の分離度マップに対して、画像上の各点(x, y)において異なる半径の分離度マップにおける特徴点候補の数をカウントし、その数を点(x, y)での重複度mとする。位置ずれに対する耐性を上げるために、各点の重複度を数える際に周囲に特徴点候補があれば含めて数え上げてもよい。 When there are a plurality of separability maps, the above processing is performed for each separability map. Then, for a plurality of separability maps, the number of feature point candidates in the separability map having different radii at each point (x, y) on the image is counted, and the number of overlaps at the point (x, y) is counted. m. In order to increase the tolerance against misalignment, when the number of overlapping points is counted, if there are feature point candidates in the vicinity, they may be counted up.

重複度mが1の点では、特徴点候補が1つしかないので、その特徴点候補の属性情報F=(x, y, s, r, b)に重複度1を加えたF=(x, y, s, r, b, 1)を改めてその特徴点候補の属性情報とする。重複度mが2以上の点では、複数存在する特徴点候補Fi=(xi, yi, si, ri, bi)(i=1, ..., m)とその属性情報について、分離度siが最大である属性情報Fn=(xn, yn, sn, rn, bn)に重複度mを加えたFn=(xn, yn, sn, rn, bn,m)を改めてその特徴点候補の属性情報とする。At the point where the degree of overlap m is 1, there is only one feature point candidate. Therefore, the feature information F = (x, y, s, r, b) is added to the attribute information F = (x, y, s, r, b). , y, s, r, b, 1) are used again as attribute information of the feature point candidates. At the point where the degree of overlap m is 2 or more, a plurality of feature point candidates Fi = (xi , yi , si , ri , bi ) (i = 1,..., M) and their attribute information for the separation degree si attribute information Fn = the maximum(x n, y n, s n, r n, b n) F were added multiplicity m ton = (x n, y n , s n , rn , bn, m) are used again as attribute information of the feature point candidates.

次の皮膚テクスチャ判定ステップS35においては、ステップS34で抽出した特徴点候補とその属性情報からホクロと判断される点を判定して抽出する。すなわち、ステップS34において特徴点候補に付加されたF=(x, y, s, r, b, m)から、ホクロと判断される点を抽出する。具体的には、s, b, m, s×b×mに対して予め閾値ks, kb, km, ksbmを定め、s≧ks, b≧kb, m≧km, s×b×m≧ksbmの4条件を全て満たす特徴点候補をホクロとする。抽出するホクロの数を予め決めている場合は、ホクロをs×b×mが大きい順番にソートし、予め決めた数だけ選択する。こうして求めた分離度sと内外輝度比bと重複度mの積s×b×mをそのホクロにおける皮膚テクスチャ適合度とする。In the next skin texture determination step S35, a point determined to be a mole is determined and extracted from the feature point candidate extracted in step S34 and its attribute information. That is, a point determined to be a mole is extracted from F = (x, y, s, r, b, m) added to the feature point candidate in step S34. Specifically, s, b, m, advance the threshold ks relatives × b × m, k b , k m, determine thek sbm, s ≧ k s, b ≧ k b, m ≧ k m, A feature point candidate that satisfies all the four conditions of s × b × m ≧ ksbm is amole . When the number of moles to be extracted is determined in advance, the moles are sorted in descending order of s × b × m, and a predetermined number is selected. The product s × b × m of the degree of separation s, the internal / external luminance ratio b, and the degree of overlap m thus obtained is defined as the skin texture suitability for the mole.

上記説明では、皮膚テクスチャ判定ステップS35において皮膚テクスチャの判定に特徴点候補検出ステップS34で検出された重複度m、分離度s、内外輝度比b及び皮膚テクスチャ適合度s×b×mを使用しているが、重複度m、分離度s、内外輝度比b及び皮膚テクスチャ適合度s×b×mのうちの任意の一つ、またはいくつかの組み合わせ、あるいは重複度m、分離度s及び内外輝度比bのいくつかの組み合わせの積をそれぞれの皮膚テクスチャの判定に使用してもよい。 In the above description, the overlap m, the separation s, the internal / external luminance ratio b, and the skin texture suitability s × b × m detected in the feature point candidate detection step S34 are used for skin texture determination in the skin texture determination step S35. However, the degree of overlap m, the degree of separation s, the internal / external luminance ratio b, and the skin texture suitability s × b × m, or some combination thereof, or the degree of overlap m, the degree of separation s, and the inside / outside The product of several combinations of brightness ratios b may be used for determining the respective skin texture.

図2に説明を戻すと、ステップS22の皮膚テクスチャ検出処理に引き続き、特徴パターン生成部13によってステップS22で検出したホクロとその属性情報を使った人物認証を行うための特徴パターンの画像(特徴パターン画像)を生成する特徴パターン生成処理を行う(ステップS23)。すなわち、この処理ではステップS22で抽出したホクロと皮膚テクスチャ適合度s×b×mから皮膚テクスチャパターン画像を生成する。皮膚テクスチャパターン画像は、ホクロの位置に皮膚テクスチャ適合度を輝度に持つ点を配置した画像である。図7(a)はステップS22で検出されたホクロ71の位置を表し、図7(b)は図7(a)から生成した皮膚テクスチャパターン画像である。 Returning to FIG. 2, following the skin texture detection process in step S22, a feature pattern image (feature pattern) for performing person authentication using the mole and its attribute information detected in step S22 by the feature pattern generation unit 13 A feature pattern generation process for generating (image) is performed (step S23). That is, in this process, a skin texture pattern image is generated from the mole extracted in step S22 and the skin texture suitability s × b × m. The skin texture pattern image is an image in which dots having skin texture suitability in luminance are arranged at the mole position. FIG. 7A shows the position of the mole 71 detected in step S22, and FIG. 7B is a skin texture pattern image generated from FIG. 7A.

ステップS23においては、ホクロ検出の位置ずれに対する耐性を上げるために、ガウスフィルタなどの平滑化フィルタ処理を行ってもよい。また位置ずれに対する耐性を上げる別の方法としては、正規化した顔画像を縦にm等分、横にn等分し、m×n個の各領域内の皮膚テクスチャ適合度の平均を輝度に持つm×nのモザイク画像を皮膚テクスチャパターン画像としてよい。ただしm,nは1以上の自然数である。 In step S <b> 23, smoothing filter processing such as a Gaussian filter may be performed in order to increase the tolerance against the misalignment of the mole detection. As another method for increasing the resistance to displacement, the normalized face image is divided into m equal parts vertically and n equal parts horizontally, and the average of the skin texture conformity in each of the m × n regions is used as the luminance. The m × n mosaic image possessed may be used as the skin texture pattern image. However, m and n are natural numbers of 1 or more.

次に、照合部14では照合処理を行う(ステップS24)。この処理では、ステップS23により作成された皮膚テクスチャパターン画像について予めデータベース15に登録してある複数の個人の皮膚テクスチャパターン画像との類似度合いを計算することで照合を行い、個人認証を行う。データベース15に記憶されている皮膚テクスチャパターン画像は、複数の特徴点候補とその属性F=(x, y, s, r, b, m)のように皮膚テクスチャパターンを生成できるものであればよい。また計算量削減のため、あらかじめ皮膚テクスチャパターン画像をベクトルとみなして長さを1に正規化した画像をデータベース15に記憶しておいてもよい。類似度合いを数値化した類似度は、次の数式(2)によって計算される。

ただし、xi, yiはそれぞれ皮膚テクスチャパターン画像の各画素の輝度、nは皮膚テクスチャパターン画像の画素の数、simは類似度とする。数式(2)の類似度simは皮膚テクスチャパターン画像を各画素の輝度を成分とするベクトルとみなし、正規化で長さを1にした後にベクトル同士の内積を計算したものと同じである。データベース15に皮膚テクスチャパターンが記憶され、類似度simが予め定めた閾値を超えた人物の中で、最大の類似度を持つ人物を認証対象の人物、すなわち画像入力部11により入力された顔画像の人物であると認識する。Here, xi and yi are the brightness of each pixel of the skin texture pattern image, n is the number of pixels of the skin texture pattern image, and sim is the similarity. The similarity sim in Expression (2) is the same as that obtained by considering the skin texture pattern image as a vector having the luminance of each pixel as a component and setting the length to 1 by normalization and calculating the inner product of the vectors. A skin texture pattern is stored in the

次に、認証結果出力部15では認証結果出力処理を行う(ステップS25)。ステップS25では、具体的にはステップS24によって得られた、認証対象の人物に対する認識結果を認証結果として出力し、場合によって類似度simも合わせて認証結果として出力する。 Next, the authentication

このように本実施形態によると、ホクロの皮膚テクスチャを利用して個人認証を行うため、顔画像全体の特徴を認識して個人認証を行う従来の技術に比較して、少ない処理量で精度の高い認証を行うことができる。 As described above, according to the present embodiment, since personal authentication is performed using the skin texture of the mole, the accuracy of the processing can be reduced with a small amount of processing compared to the conventional technology that recognizes the characteristics of the entire face image and performs personal authentication. High authentication can be performed.

すなわち、例えば一卵性双生児や兄弟・姉妹・親子などは、顔が似ていて顔全体の特徴が類似していても、ホクロのような皮膚テクスチャまでが類似している例は少ない。従って、本実施形態のように皮膚テクスチャを利用して個人認証を行うと、認識対象の個人と一卵性双生児や兄弟・姉妹・親子の関係にある別の人物を認識対象の個人と誤って認証する可能性が低くなる。また、皮膚テクスチャの特徴は顔全体の特徴と異なり、照明光の照度変動や色温度の影響を受けにくく、ホクロが消滅するなどの経年変化も少ないので、より精度のよい個人認証が可能となる。 That is, for example, monozygotic twins, brothers / sisters / parents, and the like have few faces that have similar faces and similar skin textures, even if the features of the whole face are similar. Therefore, when personal authentication is performed using skin texture as in this embodiment, another person who is in the relationship of an identical twin or sibling / sister / parent with an individual to be recognized is mistakenly identified as an individual to be recognized. The possibility of authenticating decreases. In addition, the skin texture features are different from the features of the entire face, and are less susceptible to illuminance fluctuations and color temperature of the illumination light, and are less susceptible to aging, such as the disappearance of moles, enabling more accurate personal authentication. .

尚、上述の説明では分離度マップ生成ステップS33において図6に示したような円形分離度フィルタを使用したが、図8(a)(b)に示すような三角形、四角形または五角形、六角形、あるいは図8(c)に示すような楕円など閉じた曲線で作られた分離度フィルタを用いてもよい。また、シワなどの線状のテクスチャを検出するために、図8(d)(e)に示すような直線や曲線の分離度フィルタを用いてもよい。 In the above description, the circularity separation filter as shown in FIG. 6 is used in the separation degree map generation step S33, but a triangle, a square or pentagon, a hexagon, Alternatively, a separability filter made of a closed curve such as an ellipse as shown in FIG. 8C may be used. Further, in order to detect a linear texture such as wrinkles, a linearity or curved separability filter as shown in FIGS. 8D and 8E may be used.

(第2の実施形態)

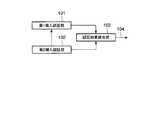

次に、図9を用いて本発明の第2の実施形態について説明する。本実施形態に係る個人認証装置は第1個人認証部101、第2個人認証部102及びこれらの認証結果を統合する認証結果統合部103を有する。ここで、第1個人認証部101及び第2個人認証部102は、同一個人を認証対象として異なる処理で個人認証を行うものとする。(Second Embodiment)

Next, a second embodiment of the present invention will be described with reference to FIG. The personal authentication apparatus according to the present embodiment includes a first

図10を用いて説明すると、まず第1個人認証部101により第1個人認証処理を行う(ステップS201)。第1個人認証処理は、第1の実施形態で説明したような皮膚テクスチャを用いた個人認証処理である。 Referring to FIG. 10, first, the first

次に、第2個人認証部102により第2個人認証処理を行う(ステップS202)。第2個人認証処理は、第1個人認証処理とは異なる個人認証処理であれば基本的にどのような処理でもよく、複数の異なる個人認証処理の組み合わせであってもよい。例えば、第2個人認証処理として顔認識による個人認証処理を用いることができる。その場合、第2個人認証処理として、例えば顔全体の画像パターンをそのまま入力し、部分空間法など使って個人認証を行う手法が考えられる。部分空間法については、例えば「飯島泰蔵“パターン認識理論”森北出版(1989年)」「エルッキ・オヤ著“パターン認識と部分空間法”産業図書(1986年)」などに詳しい。 Next, a second personal authentication process is performed by the second personal authentication unit 102 (step S202). The second personal authentication process may be basically any process as long as it is a personal authentication process different from the first personal authentication process, and may be a combination of a plurality of different personal authentication processes. For example, personal authentication processing based on face recognition can be used as the second personal authentication processing. In this case, as the second personal authentication process, for example, a method of inputting the entire face image pattern as it is and performing personal authentication using the subspace method or the like can be considered. The subspace method is detailed in, for example, “Yasuzo Iijima“ Pattern Recognition Theory ”by Morikita Publishing (1989)” “Erki Oya“ Pattern Recognition and Subspace Method ”Sangyo Tosho (1986)”.

認証結果統合部103では、第1個人認証処理の結果と第2個人認証処理の結果を統合して最終的な個人認証結果を出力する処理を行う(ステップS203)。この認識結果統合処理の具体例としては、例えば第1個人認証処理の結果と第2個人認証処理の結果としてそれぞれ複数の候補を生成し、これらを統合して最も確からしい候補を最終的な個人認証結果として出力する方法が考えられる。 The authentication

このように本実施形態によると、二種類の個人認証処理による個人認証結果を統合することによって、それぞれの個人認証処理を補完でき、より精度のよい個人認証が可能となる。すなわち、例えば別人同士で顔全体の特徴は異なるが、顔のホクロなどの皮膚テクスチャはたまたま類似することが考えられるが、このような場合は皮膚テクスチャを用いた第1個人認証処理に顔認識による第2個人認証処理を併用することで、認証誤りを避けることができる。この場合、顔認識による第2個人認証処理は、第1個人認証処理を補完するものであるため、顔全体の認識のみによって最終的な個人認証処理を行う方法に比較して精度は低くてよい。 As described above, according to the present embodiment, by integrating the personal authentication results by the two types of personal authentication processing, the individual authentication processing can be complemented, and more accurate personal authentication can be performed. That is, for example, although the characteristics of the whole face are different between different people, the skin texture such as a mole on the face may happen to be similar, but in such a case, the first personal authentication process using the skin texture is based on face recognition. By using the second personal authentication process together, an authentication error can be avoided. In this case, since the second personal authentication process based on face recognition complements the first personal authentication process, the accuracy may be lower than a method in which the final personal authentication process is performed only by recognizing the entire face. .

本実施形態の変形として、図11、図12あるいは図13に示すような構成も考えられる。図11は、第1個人認証部101の出力を第2個人認証部102が使用して処理する例であり、図12は、逆に第2個人認証部102の出力を第1個人認証部101が使用して処理する例である。さらに、図13は第1個人認証部101と第2個人認証部103が互いに情報をやり取りしながら処理する例である。例えば、第2個人認証部102として顔認識による個人認証処理を用いる場合を例にとると、第2個人認証部102に顔認識用として入力された顔画像から第1個人認証部101により皮膚テクスチャを検出し、皮膚テクスチャによる第1個人認証結果と顔認識による第2個人認証結果を統合して最終的な認証処理を行う方法が考えられる。 As a modification of the present embodiment, a configuration as shown in FIG. 11, FIG. 12, or FIG. 13 is also conceivable. FIG. 11 is an example in which the output of the first

上記実施形態で説明した個人認証処理は、ハードウェアによって実現することもできるし、コンピュータを用いてソフトウェアにより実行することもできる。すなわち、本発明によると、認証対象の個人の画像を入力する処理と、入力された画像から前記認識対象の個人の特定の皮膚テクスチャを検出する処理と、検出された皮膚テクスチャの特徴量を示す第1特徴パターンを生成する処理と、生成された第1特徴パターンをデータベースに予め記憶された複数の第2特徴パターンと照合して前記認証対象の個人についての個人認証結果を得る処理とを含む個人認証処理をコンピュータに行わせるためのプログラムを提供することもできる。 The personal authentication process described in the above embodiment can be realized by hardware, or can be executed by software using a computer. That is, according to the present invention, a process for inputting an image of an individual to be authenticated, a process for detecting a specific skin texture of the individual to be recognized from the input image, and a feature amount of the detected skin texture are shown. Including a process of generating a first feature pattern and a process of obtaining a personal authentication result for the individual to be authenticated by comparing the generated first feature pattern with a plurality of second feature patterns stored in advance in a database A program for causing a computer to perform personal authentication processing can also be provided.

(変形例)

本発明は、上記実施形態に限られるものでななく、以下に挙げるように種々の変形が可能である。(Modification)

The present invention is not limited to the above embodiment, and various modifications are possible as listed below.

(1)上記実施形態では、個人認証に使用する皮膚テクスチャとしてホクロを使用しているが、個人を識別できる特徴を示す皮膚のテクスチャであればどのようなものでもよい。例えばシミ、ソバカス、アザ、イボ、ニキビ、傷跡、シワ、毛穴、刺青などを用いてもよい。 (1) In the above embodiment, moles are used as the skin texture used for personal authentication. However, any skin texture may be used as long as it shows a feature that can identify an individual. For example, stains, buckwheat, aza, warts, acne, scars, wrinkles, pores, tattoos, and the like may be used.

(2)上記実施形態では、皮膚テクスチャを用いた個人認証に顔の皮膚テクスチャを使用しているが、認証対象の身体の顔以外の部位を単独であるいは組み合わせて使ってもよい。例えば、手、腕、肩、腹、胸、背中、足、脚などの部位の皮膚テクスチャ、あるいはこれら部位の皮膚テクスチャの組み合わせを使ってもよい。 (2) In the above embodiment, the facial skin texture is used for personal authentication using the skin texture. However, parts other than the face of the body to be authenticated may be used alone or in combination. For example, skin textures of parts such as hands, arms, shoulders, abdomen, chest, back, legs, legs, or a combination of skin textures of these parts may be used.

このように顔以外の身体の部位の皮膚テクスチャを使用する場合、図3中の正規化ステップS32においては予めそれぞれの部位の画像を正規化するための向き、形及び大きさなどを決めておくことが好ましい。例えば、図14に示すような手の皮膚テクスチャを用いる場合には、開いた状態の手のひら、開いた状態の手の甲、あるいはこれら両方の組み合わせを正規化の基準とすることができる。 When the skin texture of a body part other than the face is used in this way, in the normalizing step S32 in FIG. 3, the orientation, shape, size, etc. for normalizing the image of each part are determined in advance. It is preferable. For example, when the skin texture of the hand as shown in FIG. 14 is used, the standard for normalization can be the open palm, the open back of the hand, or a combination of both.

(3)上記実施形態では、皮膚テクスチャ検出ステップS22において、図3に示す基準点検出ステップS31及び正規化ステップS32によって顔領域を特定する方法を用いたが、顔領域の特定には他の方法を用いることもできる。例えば、画像入力部11によって入力される画像中の色情報を用いて肌色の領域を顔領域と特定したり、画像中の輪郭を抽出して顔領域を特定したりする方法など、基準点の検出を使用しない顔領域の特定法を使用してもよい。 (3) In the above embodiment, in the skin texture detection step S22, the method of specifying the face area by the reference point detection step S31 and the normalization step S32 shown in FIG. 3 is used. Can also be used. For example, a method for specifying a skin color region as a face region using color information in an image input by the

(4)上記実施形態では、皮膚テクスチャ判定ステップS35において重複度m、分離度s、内外輝度比b及び皮膚テクスチャ適合度s×b×mといった指標を用いたが、このような指標を用いることなく皮膚テクスチャを判定してもよい。例えば、図6に示した分離度フィルタの内側(領域2)の輝度値の平均である数式(1)のP1や、分離度フィルタの円内の輝度値の平均などの皮膚テクスチャらしさを数値化する処理によって皮膚テクスチャの判定を行ってもよい。(4) In the above embodiment, indices such as the degree of overlap m, the degree of separation s, the internal / external luminance ratio b, and the degree of skin texture suitability s × b × m are used in the skin texture determination step S35. Alternatively, the skin texture may be determined. For example, the value of skin texture such as P1 in Equation (1), which is the average of the luminance values inside (region 2) of the separability filter shown in FIG. 6, and the average of the luminance values in the circle of the separability filter are numerical values. The skin texture may be determined by the processing to be changed.

(5)上記実施形態では、皮膚テクスチャ検出ステップS22において分離度フィルタを使用したが、エッジ抽出による方法、Gabor-waveletによる方法、あるいは2値化による方法など、皮膚テクスチャを検出できるものであれば、皮膚テクスチャ検出ステップS22はどのような処理でもよい。その際の皮膚テクスチャ適合度は、例えば検出した皮膚テクスチャの領域の輝度値の平均など、皮膚テクスチャらしさを数値化したものを用いることができる。 (5) In the above embodiment, the separability filter is used in the skin texture detection step S22. However, any method capable of detecting skin texture, such as a method using edge extraction, a method using Gabor-wavelet, or a method using binarization. The skin texture detection step S22 may be any process. As the skin texture suitability at that time, for example, a value obtained by quantifying the skin texture, such as an average of luminance values of the detected skin texture regions, can be used.

(6)上記実施形態では、特徴パターン生成ステップS23において個人を識別する皮膚テクスチャの特徴量として、図7(b)に示すような皮膚テクスチャパターン画像を生成したが、皮膚テクスチャに関する情報から抽出した個人を識別できる特徴であればどのようなものでもよい。例えば、座標、分離度、半径、内外輝度比を並べたベクトルF=(x, y, s, r, b, m)を複数もって、それぞれが対応している数を類似度として識別してもよい。 (6) In the above embodiment, the skin texture pattern image as shown in FIG. 7B is generated as the feature value of the skin texture for identifying the individual in the feature pattern generation step S23, but extracted from the information regarding the skin texture. Any feature that can identify an individual may be used. For example, even if there are a plurality of vectors F = (x, y, s, r, b, m) in which coordinates, separation degrees, radii, and internal / external luminance ratios are arranged, the numbers corresponding to each vector are identified as similarities Good.

(7)上記実施形態では、照合ステップS24において類似度の計算に数式(2)を使用しているが、(sim)2や以下の数式(3)で表される値などの類似性を数値化できるものであれば、どのような計算式でもよい。

また、データベース15に予め複数の顔の画像や皮膚テクスチャパターン画像が登録されている場合は、複数の皮膚テクスチャパターン画像をベクトルとみなし、それらのベクトルから部分空間を生成し、部分空間法で類似度を計算してもよい。 When a plurality of face images and skin texture pattern images are registered in the

さらに、画像入力部11で複数の画像が入力される場合は、それぞれの画像の類似度の平均や、それぞれの画像から生成した皮膚テクスチャパターン画像をベクトルとみなし、それらのベクトルが生成する部分空間を使う部分空間法や、例えば参考文献2:前田賢一、渡辺貞一、“局所的構造を導入したパターン・マッチング法”、信学論(D), vol.J68-D, No.3, pp.345-352, 1985に開示された相互部分空間法によって類似度を計算してもよい。 Further, when a plurality of images are input by the

11…画像入力部;

12…皮膚テクスチャ検出部;

13…特徴パターン検出部;

14…照合部;

15…データベース;

16…認証結果出力部;

101…第1個人認証部;

102…第2個人認証部;

103…認証結果統合部;

104…最終認証結果11 ... Image input unit;

12 ... skin texture detection unit;

13 ... Feature pattern detection unit;

14 ... collation part;

15 ... Database;

16 ... authentication result output part;

101 ... 1st personal authentication part;

102 ... 2nd personal authentication part;

103 ... authentication result integration unit;

104 ... Final authentication result

Claims (8)

Translated fromJapanese入力された画像から前記認識対象の個人の特定の皮膚テクスチャの分離度と前記皮膚テクスチャの内側と外側の平均輝度の比とを含む属性情報から得られる、前記分離度と前記平均輝度の比との積を用いて定義される皮膚テクスチャらしさを用いて前記皮膚テクスチャを検出するテクスチャ検出ステップと、

前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す第1特徴パターンを生成するパターン生成ステップと、

前記第1特徴パターンとデータベースに予め記憶された、前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す複数の第2特徴パターンとをそれぞれの類似度を用いて照合して前記認証対象の個人についての個人認証結果を得る照合ステップとを具備する個人認証方法。An image input step for inputting an image of an individual to be authenticated;

A ratio between thedegree of separation and the average luminance obtained from attribute informationincluding a degree ofseparation of the specific skin texture of the individual to be recognized from the input imageand a ratio of the average luminance between the inside and outside of the skin texture; A texture detection step of detecting the skin texture using skin texture likelihooddefined using a product of :

A pattern generation step of generating a first feature pattern indicating a feature amount of the skin texturehaving a value obtained from the skin texture likelihood at a positionof the skin texture;

The pre-stored in the first feature patternand adatabase, wherein with the value obtained from the skin texture likelihood,each of the similarity degree anda plurality of second featurepattern indicating a characteristic of the skin texture to the position of the skin textureAnd a collating step for obtaining a personal authentication result for the individual to be authenticated.

入力された画像から前記認識対象の個人の特定の皮膚テクスチャの分離度と前記皮膚テクスチャの内側と外側の平均輝度の比とを含む属性情報から得られる、前記分離度と前記平均輝度の比との積を用いて定義される皮膚テクスチャらしさを用いて前記皮膚テクスチャを検出するテクスチャ検出部と、

前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す第1特徴パターンを生成するパターン生成部と、

前記第1特徴パターンとデータベースに予め記憶された、前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す複数の第2特徴パターンとをそれぞれの類似度を用いて照合して前記認証対象の個人についての個人認証結果を得る照合部とを具備する個人認証装置。An image input unit for inputting an image of an individual to be authenticated;

A ratio between thedegree of separation and the average luminance obtained from attribute informationincluding a degree ofseparation of the specific skin texture of the individual to be recognized from the input imageand a ratio of the average luminance between the inside and outside of the skin texture; A texture detection unit for detecting the skin texture usinga skin texture likenessdefined using a product of :

A pattern generation unit for generating a first feature pattern indicating a feature amount of the skin texturehaving a value obtained from the skin texture likeness at a positionof the skin texture;

The pre-stored in the first feature patternand adatabase, wherein with the value obtained from the skin texture likelihood,each of the similarity degree anda plurality of second featurepattern indicating a characteristic of the skin texture to the position of the skin texture A personal authentication apparatus comprising: a verification unit that performs verification byusing a verification unit to obtain a personal authentication result for the individual to be authenticated.

入力された画像から前記認識対象の個人の特定の皮膚テクスチャの分離度と前記皮膚テクスチャの内側と外側の平均輝度の比とを含む属性情報から得られる、前記分離度と前記平均輝度の比との積を用いて定義される皮膚テクスチャらしさを用いて前記皮膚テクスチャを検出する処理と、

前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す第1特徴パターンを生成する処理と、

前記第1特徴パターンとデータベースに予め記憶された、前記皮膚テクスチャの位置に前記皮膚テクスチャらしさから得られる値を持つ、前記皮膚テクスチャの特徴量を示す複数の第2特徴パターンとをそれぞれの類似度を用いて照合して前記認証対象の個人についての個人認証結果を得る処理とを含む個人認証処理をコンピュータに行わせるためのプログラム。The process of entering an image of the person to be authenticated,

A ratio between thedegree of separation and the average luminance obtained from attribute informationincluding a degree ofseparation of the specific skin texture of the individual to be recognized from the input imageand a ratio of the average luminance between the inside and outside of the skin texture; Detecting the skin texture using skin texture likelihooddefined using a product of :

A process of generating a first feature pattern indicating a feature amount of the skin texturehaving a value obtained from the skin texture likeness at a positionof the skin texture;

The pre-stored in the first feature patternand adatabase, wherein with the value obtained from the skin texture likelihood,each of the similarity degree anda plurality of second featurepattern indicating a characteristic of the skin texture to the position of the skin texture program for causing a personal authentication process on a computer that includes a personal authentication result obtaining processing for individual of the authentication object by matchingwith.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004295312AJP4351982B2 (en) | 2004-10-07 | 2004-10-07 | Personal authentication method, apparatus and program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004295312AJP4351982B2 (en) | 2004-10-07 | 2004-10-07 | Personal authentication method, apparatus and program |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2006107288A JP2006107288A (en) | 2006-04-20 |

| JP4351982B2true JP4351982B2 (en) | 2009-10-28 |

Family

ID=36376934

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2004295312AExpired - Fee RelatedJP4351982B2 (en) | 2004-10-07 | 2004-10-07 | Personal authentication method, apparatus and program |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4351982B2 (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2014098136A1 (en) | 2012-12-19 | 2014-06-26 | 株式会社デンソーウェーブ | Information code, method for generating information code, device for reading information code, and system for using information code |

Families Citing this family (29)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4992289B2 (en)* | 2006-05-11 | 2012-08-08 | コニカミノルタホールディングス株式会社 | Authentication system, authentication method, and program |

| KR100888475B1 (en) | 2007-02-02 | 2009-03-12 | 삼성전자주식회사 | Method and device for checking collision between models |

| KR20200090943A (en) | 2007-09-24 | 2020-07-29 | 애플 인크. | Embedded authentication systems in an electronic device |

| US8600120B2 (en) | 2008-01-03 | 2013-12-03 | Apple Inc. | Personal computing device control using face detection and recognition |

| JP4919118B2 (en)* | 2008-01-21 | 2012-04-18 | 日本電気株式会社 | Pattern matching system, pattern matching method, and program for pattern matching |

| US20110002511A1 (en)* | 2008-02-27 | 2011-01-06 | Hitoshi Imaoka | Mole identifying device, and personal authentication device, method, and program |

| WO2009131209A1 (en) | 2008-04-24 | 2009-10-29 | 日本電気株式会社 | Image matching device, image matching method, and image matching program |

| US8638385B2 (en) | 2011-06-05 | 2014-01-28 | Apple Inc. | Device, method, and graphical user interface for accessing an application in a locked device |

| US9002322B2 (en) | 2011-09-29 | 2015-04-07 | Apple Inc. | Authentication with secondary approver |

| US8769624B2 (en) | 2011-09-29 | 2014-07-01 | Apple Inc. | Access control utilizing indirect authentication |

| JP5867267B2 (en)* | 2012-04-26 | 2016-02-24 | 日産自動車株式会社 | Pedestrian detection device and pedestrian detection method |

| CN111310619B (en) | 2012-05-18 | 2021-06-04 | 苹果公司 | Device, method and graphical user interface for manipulating a user interface |

| US9898642B2 (en) | 2013-09-09 | 2018-02-20 | Apple Inc. | Device, method, and graphical user interface for manipulating user interfaces based on fingerprint sensor inputs |

| CN106104630B (en) | 2014-03-13 | 2020-12-25 | 日本电气株式会社 | Testing equipment and testing methods |

| US10043185B2 (en) | 2014-05-29 | 2018-08-07 | Apple Inc. | User interface for payments |

| US10055661B2 (en) | 2015-03-24 | 2018-08-21 | Intel Corporation | Skin texture-based authentication |

| DK179186B1 (en) | 2016-05-19 | 2018-01-15 | Apple Inc | REMOTE AUTHORIZATION TO CONTINUE WITH AN ACTION |

| DK179978B1 (en) | 2016-09-23 | 2019-11-27 | Apple Inc. | Image data for enhanced user interactions |

| JP6798285B2 (en) | 2016-11-30 | 2020-12-09 | 富士通株式会社 | Biometric device, biometric method and program |

| KR102185854B1 (en) | 2017-09-09 | 2020-12-02 | 애플 인크. | Implementation of biometric authentication |

| CN117077102A (en) | 2017-09-09 | 2023-11-17 | 苹果公司 | Implementation of biometric authentication |

| US11170085B2 (en) | 2018-06-03 | 2021-11-09 | Apple Inc. | Implementation of biometric authentication |

| US11100349B2 (en) | 2018-09-28 | 2021-08-24 | Apple Inc. | Audio assisted enrollment |

| US10860096B2 (en) | 2018-09-28 | 2020-12-08 | Apple Inc. | Device control using gaze information |

| CN110110637A (en)* | 2019-04-25 | 2019-08-09 | 深圳市华嘉生物智能科技有限公司 | A kind of method of face wrinkle of skin automatic identification and wrinkle severity automatic classification |

| JP2020074241A (en)* | 2020-02-12 | 2020-05-14 | 日本電気株式会社 | Detector |

| EP4264460A1 (en) | 2021-01-25 | 2023-10-25 | Apple Inc. | Implementation of biometric authentication |

| US12210603B2 (en) | 2021-03-04 | 2025-01-28 | Apple Inc. | User interface for enrolling a biometric feature |

| US12216754B2 (en) | 2021-05-10 | 2025-02-04 | Apple Inc. | User interfaces for authenticating to perform secure operations |

- 2004

- 2004-10-07JPJP2004295312Apatent/JP4351982B2/ennot_activeExpired - Fee Related

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2014098136A1 (en) | 2012-12-19 | 2014-06-26 | 株式会社デンソーウェーブ | Information code, method for generating information code, device for reading information code, and system for using information code |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2006107288A (en) | 2006-04-20 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP4351982B2 (en) | Personal authentication method, apparatus and program | |

| US12223760B2 (en) | Systems and methods for performing fingerprint based user authentication using imagery captured using mobile devices | |

| US8655029B2 (en) | Hash-based face recognition system | |

| US20190392129A1 (en) | Identity authentication method | |

| US7412081B2 (en) | Personal authentication apparatus and personal authentication method | |

| JP4786483B2 (en) | Biometric guidance control method for biometric authentication device and biometric authentication device | |

| JP5304901B2 (en) | Biological information processing apparatus, biological information processing method, and computer program for biological information processing | |

| CN109800643B (en) | Identity recognition method for living human face in multiple angles | |

| JP4406547B2 (en) | ID card creation device, ID card, face authentication terminal device, face authentication device and system | |

| JP5439809B2 (en) | Biometric authentication device | |

| KR100940902B1 (en) | The biometrics using finger geometry information | |

| JP2006500662A (en) | Palmprint authentication method and apparatus | |

| Charity et al. | A bimodal biometrie student attendance system | |

| Khan et al. | Low dimensional representation of dorsal hand vein features using principle component analysis (PCA) | |

| CN111178130A (en) | Face recognition method, system and readable storage medium based on deep learning | |

| Pan et al. | Securitas: user identification through rgb-nir camera pair on mobile devices | |

| Muthukumaran et al. | Face and Iris based Human Authentication using Deep Learning | |

| Xu et al. | Robust shape-feature-vector-based face recognition system | |

| Sanches et al. | A single sensor hand biometric multimodal system | |

| Sharma et al. | Human recognition methods based on biometric technologies | |

| Sharma et al. | Fingerprint matching Using Minutiae Extraction Techniques | |

| Shukla et al. | A Hybrid Model of Multimodal Biometrics System using Fingerprint and Face as Traits | |

| Dere et al. | Biometric Accreditation Adoption using Iris and Fingerprint: A Review | |

| Sree et al. | Dorsal Hand Vein Pattern Authentication by Hough Peaks | |

| OLAYIWOLA et al. | Development of Palmvein Recognition System Using Fire Fly Algorithm |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20060131 | |

| A977 | Report on retrieval | Free format text:JAPANESE INTERMEDIATE CODE: A971007 Effective date:20081128 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20081209 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20090209 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20090407 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20090604 | |

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 Effective date:20090630 | |

| A01 | Written decision to grant a patent or to grant a registration (utility model) | Free format text:JAPANESE INTERMEDIATE CODE: A01 | |

| A61 | First payment of annual fees (during grant procedure) | Free format text:JAPANESE INTERMEDIATE CODE: A61 Effective date:20090727 | |

| FPAY | Renewal fee payment (event date is renewal date of database) | Free format text:PAYMENT UNTIL: 20120731 Year of fee payment:3 | |

| FPAY | Renewal fee payment (event date is renewal date of database) | Free format text:PAYMENT UNTIL: 20130731 Year of fee payment:4 | |

| LAPS | Cancellation because of no payment of annual fees |