JP2017150957A - Navigation device, navigation method, and program - Google Patents

Navigation device, navigation method, and programDownload PDFInfo

- Publication number

- JP2017150957A JP2017150957AJP2016033782AJP2016033782AJP2017150957AJP 2017150957 AJP2017150957 AJP 2017150957AJP 2016033782 AJP2016033782 AJP 2016033782AJP 2016033782 AJP2016033782 AJP 2016033782AJP 2017150957 AJP2017150957 AJP 2017150957A

- Authority

- JP

- Japan

- Prior art keywords

- character

- unit

- navigation

- comment

- attribute

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

- 238000000034methodMethods0.000titleclaimsdescription54

- 230000003068static effectEffects0.000claimsabstractdescription80

- 238000001514detection methodMethods0.000claimsabstractdescription52

- 230000005540biological transmissionEffects0.000claimsdescription59

- 230000008859changeEffects0.000claimsdescription57

- 230000006870functionEffects0.000claimsdescription7

- 230000010365information processingEffects0.000claimsdescription2

- 238000007726management methodMethods0.000description48

- 230000008569processEffects0.000description42

- 238000010586diagramMethods0.000description22

- 238000004891communicationMethods0.000description15

- 239000000446fuelSubstances0.000description11

- 206010034719Personality changeDiseases0.000description9

- 230000008921facial expressionEffects0.000description6

- 125000002066L-histidyl groupChemical group[H]N1C([H])=NC(C([H])([H])[C@](C(=O)[*])([H])N([H])[H])=C1[H]0.000description3

- 230000014509gene expressionEffects0.000description3

- 238000013070change managementMethods0.000description2

- 230000004048modificationEffects0.000description2

- 238000012986modificationMethods0.000description2

- 230000001133accelerationEffects0.000description1

- 230000004913activationEffects0.000description1

- 238000004590computer programMethods0.000description1

- 230000000694effectsEffects0.000description1

- 230000006855networkingEffects0.000description1

- 230000003287optical effectEffects0.000description1

- 239000004065semiconductorSubstances0.000description1

- 230000000699topical effectEffects0.000description1

- 238000012384transportation and deliveryMethods0.000description1

Images

Landscapes

- Instructional Devices (AREA)

- Navigation (AREA)

- Processing Or Creating Images (AREA)

- Traffic Control Systems (AREA)

Abstract

Description

Translated fromJapanese本発明は、キャラクタを用いたナビゲーションを行うナビゲーション装置に関するものである。 The present invention relates to a navigation device that performs navigation using characters.

従来、既定のキャラクタを用いたナビゲーションを行うナビゲーション装置が知られている(特許文献1参照)。例えば、特許文献1では、先導キャラクタに複数種類の動きを順次付与することで、経路上の方向転換点を案内している。 Conventionally, a navigation device that performs navigation using a predetermined character is known (see Patent Document 1). For example, in

しかしながら、従来のナビゲーション装置では、キャラクタに個性がなく、愛着がわかなかった。 However, in the conventional navigation device, the character has no personality and attachment is not known.

そこで、本発明は、個性があり、愛着のあるキャラクタを用いたナビゲーション装置、ナビゲーション方法およびプログラムを提供することを目的とする。 SUMMARY OF THE INVENTION An object of the present invention is to provide a navigation device, a navigation method, and a program using a character that has individuality and attachment.

本発明のナビゲーション装置は、移動体の1以上の静的属性値を含む静的属性を受け付ける属性受付部と、前記属性受付部が受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択部と、移動体の位置を示す位置情報を取得する位置検出部と、前記位置検出部によって取得された位置情報を用いて、前記キャラクタ生成選択部によって生成または選択されたキャラクタを用いたナビゲーションを行うナビゲーション部と、を具備することを特徴とする。 A navigation device according to the present invention includes an attribute receiving unit that receives a static attribute including one or more static attribute values of a moving object, and a character that generates or selects a character using the static attribute received by the attribute receiving unit. A generation selection unit, a position detection unit that acquires position information indicating the position of the moving body, and a character generated or selected by the character generation selection unit using the position information acquired by the position detection unit. A navigation unit that performs navigation.

かかる構成により、前記属性受付部と、前記キャラクタ生成選択部と、前記位置検出部と、前記ナビゲーション部と、を具備し、移動体の属性に基づくキャラクタを生成または選択するので、個性があり、愛着のあるキャラクタを用いたナビゲーションを行うことができる。 With such a configuration, the attribute reception unit, the character generation selection unit, the position detection unit, and the navigation unit are provided, and the character is generated or selected based on the attribute of the moving object, so there is individuality, Navigation using attached characters can be performed.

前記構成において、静的属性はユーザの静的属性に関する情報であるユーザ情報をさらに含んでもよい。 In the above configuration, the static attribute may further include user information that is information related to the static attribute of the user.

かかる構成により、ユーザ情報も加味してキャラクタを生成または選択するので、キャラクタに一層愛着がわくようにすることができる。 With this configuration, since the character is generated or selected in consideration of the user information, the character can be more attached to the character.

前記構成において、移動体の移動履歴を取得する移動履歴取得部と、前記移動履歴取得部によって取得された移動履歴に応じて、キャラクタを変化させるキャラクタ変化部と、をさらに具備してもよい。 The said structure WHEREIN: You may further comprise the movement history acquisition part which acquires the movement history of a moving body, and the character change part which changes a character according to the movement history acquired by the said movement history acquisition part.

かかる構成により、移動履歴をキャラクタの変化で直感的に認識させることができる。 With this configuration, the movement history can be intuitively recognized by the change of the character.

前記構成において、移動体の状態の変化を検知する状態変化検知部と、前記状態変化検知部によって検知された変化後の状態が一定の条件を満たす場合にキャラクタに発言を行わせるキャラクタ発言部と、をさらに具備してもよい。 In the above configuration, a state change detection unit that detects a change in the state of the moving body, and a character speech unit that causes the character to speak when the state after the change detected by the state change detection unit satisfies a certain condition, , May be further provided.

かかる構成により、移動体の状態が変化したことを、キャラクタの発言を通じて知らせることができる。 With such a configuration, it is possible to notify through the character's remark that the state of the moving body has changed.

前記構成において、キャラクタが行う発言の内容は前記状態変化検知部によって検知された変化後の状態の情報を含んでもよい In the above-described configuration, the content of the speech made by the character may include information on the state after the change detected by the state change detection unit.

かかる構成により、移動体の変化後の状態を認識させることができる。 With this configuration, it is possible to recognize the state after the change of the moving body.

前記構成において、他人の移動体の位置を示す他人位置情報を受信する他人位置受信部と、他人の移動体に関するキャラクタである他人キャラクタを受信する他人キャラクタ受信部と、前記他人位置受信部によって受信された他人位置情報が示す位置を他人キャラクタを用いて出力する他人位置出力部と、をさらに具備してもよい。 In the above configuration, the other person position receiving unit that receives the other person position information indicating the position of the moving body of the other person, the other person character receiving unit that receives the other person character that is a character related to the moving body of the other person, and the other person position receiving unit The other person position output part which outputs the position which the other person position information shown by using the other person character may further be provided.

かかる構成により、他人の移動体の位置を当該他人のキャラクタで直感的に認識させることができる。 With this configuration, the position of another person's moving body can be intuitively recognized by the other person's character.

前記構成において、前記位置検出部によって取得された位置情報および前記他人位置受信部によって受信された他人位置情報の関係が予め決められた条件を満足した場合に、注意喚起を行う注意喚起部、をさらに具備してもよい。 In the above-described configuration, an alerting unit that alerts the user when the relationship between the location information acquired by the location detection unit and the location information of others received by the location of other person satisfies a predetermined condition. Furthermore, you may comprise.

かかる構成により、他人の移動体との位置関係に応じた注意喚起を行うことができる。 With this configuration, it is possible to call attention according to the positional relationship with another person's moving body.

前記構成において、他人からのコメントを受領するコメント受領部と、前記コメント受領部によって受領されたコメントを他人に対応する他人キャラクタが発言しているように出力する他人コメント出力部と、をさらに具備してもよい。 In the above configuration, a comment receiving unit that receives a comment from another person, and a comment output unit that outputs the comment received by the comment receiving unit as if the other person character corresponding to the other person is speaking. May be.

かかる構成により、他人からのコメントを他人キャラクタを通して伝えることができる。 With this configuration, a comment from another person can be transmitted through the other person character.

前記構成において、他人へのコメントを受け付けるコメント受付部と、前記コメント受付部が受け付けたコメントを他人の移動体へと発信するコメント発信部と、をさらに具備してもよい。 The said structure WHEREIN: You may further comprise the comment reception part which receives the comment to others, and the comment transmission part which transmits the comment which the said comment reception part received to another person's mobile body.

かかる構成により、他人にコメントを発信することができる。 With this configuration, it is possible to send comments to others.

前記構成において、前記他人キャラクタ受信部、前記コメント受領部および前記コメント発信部は、それぞれSNS(Social Networking Service)のサーバ装置経由で他人キャラクタの取得、コメントの受領およびコメントの発信を行ってもよい。 In the above-described configuration, the other-character receiving unit, the comment receiving unit, and the comment sending unit may acquire other-person characters, receive a comment, and send a comment via a SNS (Social Networking Service) server device, respectively. .

かかる構成により、SNSを介して効率よく連携することができる。 With this configuration, it is possible to efficiently cooperate via the SNS.

本発明にかかるナビゲーション方法は、属性受付部、キャラクタ生成選択部、位置検出部およびナビゲーション部によって行われるナビゲーション方法であって、前記属性受付部による、移動体の静的属性値を含む静的属性を受け付ける属性受付ステップと、前記キャラクタ生成選択部による、前記属性受付ステップで受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択ステップと、前記位置検出部による、前記移動体の位置を検示す位置情報を取得する位置検出ステップと、前記位置検出ステップで取得した位置情報と、前記キャラクタ生成選択ステップで生成または選択したキャラクタを用いて、前記ナビゲーション部がナビゲーションを行うナビゲーションステップとを含む、ナビゲーション方法である。 A navigation method according to the present invention is a navigation method performed by an attribute reception unit, a character generation selection unit, a position detection unit, and a navigation unit, and includes a static attribute including a static attribute value of a moving object by the attribute reception unit. An attribute receiving step for receiving the character, a character generation selecting step for generating or selecting a character using the static attribute received in the attribute receiving step by the character generation selecting unit, and a position detection unit for A position detecting step for acquiring position information for detecting a position, a position information acquired in the position detecting step, and a navigation step in which the navigation unit performs navigation using the character generated or selected in the character generation selection step; Including navigation methods .

かかる構成により、移動体の属性に基づくキャラクタを生成または選択するので、個性があり、愛着のあるキャラクタを用いたナビゲーションを行うことができる。 With such a configuration, a character based on the attribute of the moving object is generated or selected, so that navigation using a character that has individuality and attachment can be performed.

本発明にかかるプログラムは、コンピュータを、移動体の静的属性値を含む静的属性を受け付ける属性受付部と、前記属性受付部が受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択部と、前記移動体の位置を示す位置情報を取得する位置検出部と、前記位置検出部が取得した位置情報と、前記キャラクタ生成選択部が生成または選択したキャラクタを用いたナビゲーションを行うナビゲーション部として機能させるプログラムである。 The program according to the present invention includes a computer that generates a character or selects a character using an attribute receiving unit that receives a static attribute including a static attribute value of a moving object, and a static attribute received by the attribute receiving unit. A generation selection unit, a position detection unit that acquires position information indicating the position of the moving body, position information acquired by the position detection unit, and navigation using the character generated or selected by the character generation selection unit It is a program that functions as a navigation unit.

かかる構成により、移動体の属性に基づくキャラクタを生成または選択するので、個性があり、愛着のあるキャラクタを用いたナビゲーションを行うことができる。 With such a configuration, a character based on the attribute of the moving object is generated or selected, so that navigation using a character that has individuality and attachment can be performed.

本発明によるナビゲーション装置によれば、個性があり、愛着のあるキャラクタを用いたナビゲーションを行うことができる。 According to the navigation device of the present invention, it is possible to perform navigation using a character that is unique and attached.

以下、ナビゲーション装置等の実施形態について図面を参照して説明する。なお、実施の形態において同じ符号を付した構成要素は同様の動作を行うので、再度の説明を省略する場合がある。 Hereinafter, embodiments of a navigation device and the like will be described with reference to the drawings. In addition, since the component which attached | subjected the same code | symbol in embodiment performs the same operation | movement, description may be abbreviate | omitted again.

(実施の形態)

図1は、本実施の形態における情報システムの概念図である。情報システムは、2以上のナビゲーション装置1とサーバ装置2を備える。各ナビゲーション装置1は、互いに同じ構成を有するので、共通の参照番号が付されている。ただし、各々を区別する場合には、ナビゲーション装置1A、ナビゲーション装置1B、のように記載する。(Embodiment)

FIG. 1 is a conceptual diagram of the information system in the present embodiment. The information system includes two or

まず、情報システムの概要を説明する。ナビゲーション装置1は、移動体に搭載され、GPSや無線通信ネットワークの位置検出機能などを利用して当該移動体の現在位置を含む位置情報を取得したり、取得した位置情報を表示したり、現在位置から任意の目的地までの経路を探索したり、探索した経路に沿ってユーザを誘導したり、といったナビゲーションを行う。なお、移動体は、典型的には、自動車、バイク、自転車、船舶などであるが、ユーザの操作により任意の方向に移動可能なものであれば、種類は問わない。 First, an overview of the information system will be described. The

特に、ナビゲーション装置1は、例えば、ナビゲーション装置1が搭載された移動体の静的属性値(移動体静的属性)や、ナビゲーション装置1を操作するユーザの静的属性値(ユーザ情報)を含む静的属性の入力を受け付け、入力された静的属性を用いて、当該移動体を擬人化したようなキャラクタを生成または選択する。ナビゲーション装置1は、こうして生成または選択したキャラクタを用いて、上記のようなナビゲーションとそれに関連する処理(例えば、情報提供、注意喚起、コミュニケーション等)を行う。具体例として、ナビゲーション装置1は、交差点で「右折してください」のように誘導したり、サイドブレーキが引かれたとき「お疲れさまです」と発言したり、速度が制限値を超えたとき「速度オーバーです」のように注意喚起したりする。 In particular, the

なお、例えば移動体の走行距離やユーザの運転時間のような、時々刻々変化する動的属性に対して、静的属性とは、例えば移動体のタイプ(車種)やボディカラー、あるいはユーザの性別や年齢のような、永続的または一定期間変化しない属性をいう。上述した移動体のタイプやボディカラー等の属性値である移動体静的属性、またはユーザ情報、または移動体静的属性とユーザ情報である。 Note that, for example, a dynamic attribute such as a travel distance of a moving object or a user's driving time changes with time, and a static attribute is, for example, the type (vehicle type) or body color of a moving object, or the gender of a user. An attribute that does not change permanently or over a period of time, such as age or age. These are the moving body static attributes, which are attribute values such as the type of the moving body and the body color, or user information, or the moving body static attributes and user information.

サーバ装置2は、各地の地図情報を蓄積すると共に、各ナビゲーション装置1で上記のように取得された位置情報および生成されたキャラクタのアップロードを受け付ける。そして、各ナビゲーション装置1に対し、現在位置周辺の地図情報を配信すると共に、他の移動体に関する位置情報(他人位置情報)およびキャラクタ(当該他の移動体に対応する他人キャラクタ)のダウンロードも行う。各ナビゲーション装置1では、他の移動体の現在位置が当該他の移動体に対応する他人キャラクタによって出力される。 The

このように、ナビゲーション装置1は、ナビゲーション装置1が搭載される移動体の属性に基づくキャラクタを生成または選択するので、個性があり、愛着のあるキャラクタでナビゲーションを行うことができる。なお、自動車等の移動体に搭乗する者は、自分の移動体に愛着を持っている場合が多く、本実施の形態において、例えば、その移動体への愛着に似た愛着をキャラクタに与えることができる。 Thus, since the

次に、ナビゲーション装置1およびサーバ装置2の構成を説明する。 Next, the structure of the

図2は、本実施の形態におけるナビゲーション装置1のブロック図である。ナビゲーション装置1は、格納部11、受付部12、処理部13、送信部14、受信部15、出力部16を備える。 FIG. 2 is a block diagram of the

格納部11は、キャラクタ格納部111を備える。受付部12は、属性受付部121、コメント受付部122を備える。処理部13は、キャラクタ生成選択部131、位置検出部132、ナビゲーション部133、移動履歴取得部134、キャラクタ変化部135、注意喚起部136、状態変化検知部137を備える。送信部14は、コメント発信部141を備える。受信部15は、他人位置受信部151、他人キャラクタ受信部152、コメント受領部153を備える。出力部16は、他人位置出力部161、他人コメント出力部162、キャラクタ発言部163を備える。 The storage unit 11 includes a

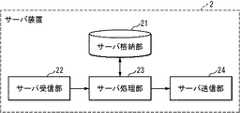

図3は、本実施の形態におけるサーバ装置2のブロック図である。サーバ装置2は、サーバ格納部21、サーバ受信部22、サーバ処理部23、サーバ送信部24を備える。 FIG. 3 is a block diagram of the

格納部11は、地図情報、各種のキャラクタ、位置情報(例えば現在位置を示す情報、現在位置までの移動経路を示す情報)などを格納する。なお、一のキャラクタは、通常、1または2以上の静止画、または動画により構成され得るが、そのデータ構造等は問わない。キャラクタは、当該キャラクタの音声を決定するための情報を有しても良い。 The storage unit 11 stores map information, various characters, position information (for example, information indicating the current position, information indicating a movement route to the current position), and the like. Note that one character can normally be composed of one or more still images or moving images, but the data structure or the like is not limited. The character may have information for determining the voice of the character.

また、格納部11(およびこれに含まれるキャラクタ格納部111:以下同様)は、不揮発性の記録媒体が好適であるが、揮発性の記録媒体でも実現可能である。また、格納部11にキャラクタ等が格納される過程(いつどのように記憶されるか)は問わない。例えば、記録媒体を介してキャラクタ等が格納部11で記憶されるようになってもよく、通信回線等を介して送信されたキャラクタ等が格納部11で記憶されるようになってもよく、あるいは、入力デバイスを介して入力されたキャラクタ等が格納部11で記憶されるようになってもよい。特に、キャラクタ格納部111は、キャラクタ生成選択部131で生成または選択されたキャラクタを格納する。また、キャラクタ格納部111は、他のナビゲーション装置1のキャラクタ生成選択部131で生成または選択されたキャラクタ(他人キャラクタ)も格納する。また、キャラクタ格納部111は、選択対象となる複数のキャラクタや、キャラクタの生成元となる複数のパーツを予め格納している。 The storage unit 11 (and the

受付部12は、入力手段による情報の入力を受け付ける。なお、入力手段は、キーボードやマウスやメニュー画面によるもの等、何でも良い。また、受け付けとは、キーボードやマウス、タッチパネルなどの入力デバイスから入力された情報の受け付け、有線もしくは無線の通信回線を介して送信された情報の受信、光ディスク、半導体メモリなどの記録媒体から読み出された情報の受け付けなどを含む概念である。そして、受付部12は、キーボード等の入力手段のデバイスドライバーや、メニュー画面の制御ソフトウェア等で実現され得る。特に、属性受付部121は、移動体の1以上の静的属性値を含む静的属性を受け付ける。移動体の属性値とは、車種、メーカ名、車のタイプ(スポーツカー、コンパクトカー、セダン、クーペ、ワンボックス等)、色などである。移動体の属性値以外の静的属性としては、ユーザの性別、年齢、趣味嗜好などに関する情報(ユーザ情報)が挙げられる。 The accepting unit 12 accepts input of information by the input means. The input means may be anything such as a keyboard, mouse or menu screen. In addition, reception means reception of information input from an input device such as a keyboard, mouse, touch panel, reception of information transmitted via a wired or wireless communication line, and reading from a recording medium such as an optical disk or semiconductor memory. It is a concept that includes the reception of information that has been made. The receiving unit 12 can be realized by a device driver of an input unit such as a keyboard, menu screen control software, or the like. In particular, the

コメント受付部122は、コメントを受け付ける。コメントは、例えば、「疲れていない?」、「次のサービスエリアで休憩しよう」、「この先にコンビニがあるよ」などのように、他人とのコミュニケーションや情報伝達のために発される言葉(メッセージ)である。なお、コメントは、通常、文字列であるが、画像(いわゆるスタンプ等)、動画、音声等、そのデータ構造は問わない。 The

処理部13は、経路の探索および案内を含むナビゲーションとそれに関連する各種の処理を行う。なお、処理部13(およびこれに含まれる各部131〜137:以下同様)は、通常、MPUやメモリ等から実現され得る。処理部13の処理手順は、通常、ソフトウェアで実現され、当該ソフトウェアはROM等の記録媒体に記録されている。但し、ハードウェア(専用回路)で実現しても良い。 The

特に、キャラクタ生成選択部131は、属性受付部121が受け付けた静的属性を用いてキャラクタを生成または選択する。ここで、生成とは予め準備されたパーツ群の中から適宜なものを組み合わせて静的属性に適合するキャラクタを作り出すことであり、選択とは予め準備された複数のキャラクタの中から静的属性に適合するものを選ぶことである。具体的には、キャラクタは、例えば次の手順で生成される。まず、キャラクタを複数の部位(例えば頭部、上半身および下半身の3部位)に区分し、各部位について、互いに異なる複数種類のパーツ(パーツ群)を準備して、各パーツに静的属性(移動体属性およびユーザ情報)への適合性を示すタグを付しておく。 In particular, the character generation /

図4(A)〜(C)は、キャラクタ格納部111に格納されている部位毎のパーツ群の例を示す。頭部パーツ群には、例えば若い男性の頭部や若い女性の頭部などが含まれており、各頭部パーツには頭部パーツID(1,2,…)が付されている。図5(A)〜(C)は、各部位のパーツ群を管理するためのパーツ管理表の例を示す。パーツ管理表は、「パーツID」、「移動体属性」および「ユーザ属性」を有するレコードを1以上格納している。「パーツID」はパーツを識別する情報であり、「移動体属性」は移動体の静的属性(例えば「タイプ」および「ボディカラー」など)であり、「ユーザ属性」は、例えば「性別」、「年齢」といったユーザの静的属性である。このパーツ管理表から、例えば、頭部パーツ“1”は静的属性“スポーツカー,赤,男,20代”に適合し、頭部パーツ“2”は静的属性“コンパクトカー,水色,女,20代”に適合するパーツであることがわかる。同様に、上半身パーツ“1”は静的属性“スポーツカー,赤,男,20代”に適合し、下半身パーツ“1”は静的属性“スポーツカー,赤,男,20代”に適合することがわかる。パーツ管理表には、可能な静的属性の組み合わせに適合するパーツが網羅されている。 4A to 4C show examples of parts groups for each part stored in the

キャラクタ生成選択部131は、例えば、パーツ管理表を参照して、各部位のパーツ群の中から、属性受付部121が受け付けた静的属性に最も適合するパーツを組み合わせて、キャラクタを生成する。例えば、静的属性として「スポーツカー、赤、20代、男性」が受け付けられた場合、頭部パーツ群の中から若い男性の頭部パーツと、上半身パーツ群の中から赤いTシャツを着た上半身パーツと、下半身パーツ群の中からジーパンを履いた下半身パーツとを組み合わせることで、あたかも赤いスポーツカーを擬人化したような青年キャラクタが生成される。 For example, the character generation /

なお、上の例では、ユーザは静的属性の入力を行うだけで、キャラクタ生成選択部131によってキャラクタが自動的に生成されたが、キャラクタ生成選択部131は、静的属性に基づくパーツの絞り込みを行い、部位毎に幾つかのパーツを画面上に提示して、ユーザに好みの組み合わせを選択させてもよい。この場合、ユーザは、静的属性を入力した後、絞り込まれた複数の頭部パーツから1つを選択し、同じく複数の上半身パーツから1つを選択し、というように、好みのパーツを順次選んでいくと、キャラクタ生成選択部131によって、それらのパーツからなるキャラクタが生成される。 In the above example, the character is automatically generated by the character generation /

また、上記のキャラクタ生成方法は、予め準備されたパーツを組み合わせて静的属性に適合するキャラクタを生成するものであるが、これに代えて、例えば、予め準備された生成元となるキャラクタの形状や色彩を変化させることで、静的属性に適合するキャラクタを生成するようなキャラクタ生成方法を採用してもよい。なお、キャラクタ生成のアルゴリズムは問わない。 In addition, the character generation method described above is to generate a character that conforms to a static attribute by combining parts prepared in advance, but instead, for example, the shape of the character that is a source that is prepared in advance. A character generation method that generates a character that conforms to the static attribute by changing the color or color may be employed. The character generation algorithm does not matter.

キャラクタを選択する場合には、例えば、処理部13が、性別、年齢、髪型、服装等の異なる複数種類のキャラクタ(選択対象キャラクタ群)を準備し、各選択対象キャラクタに静的属性への適合性を示すタグを付しておく。キャラクタ生成選択部131は、例えば、各選択対象キャラクタのタグを参照して、属性受付部121が受け付けた静的属性に最も適合する選択対象キャラクタを選択する。 When selecting a character, for example, the

図6(A)は、キャラクタ格納部111に格納されている選択対象キャラクタ群の例を示す。選択対象キャラクタ群には、例えば、「赤いTシャツとジーンズを身に着けた若い長身の男性」や、「水色のワンピースと白い靴を身に着けた若い小柄な女性」などが含まれており、各選択対象キャラクタにはキャラクタID(1,2,…)が付されている。図6(B)は、選択対象キャラクタ群を管理するためのキャラクタ管理表の例を示す。このキャラクタ管理表から、例えば、キャラクタ“1”は“スポーツカー,赤,男,20代”に適合し、キャラクタ“2”は“コンパクトカー,水色,女,20代”に適合するキャラクタであることがわかる。キャラクタ管理表には、可能な静的属性の組み合わせに適合する選択対象キャラクタが網羅されている。 FIG. 6A shows an example of a selection target character group stored in the

キャラクタ生成選択部131は、キャラクタ管理表を参照して、選択対象キャラクタ群の中から、属性受付部121が受け付けた静的属性に最も適合するキャラクタを選択する。例えば、静的属性として「スポーツカー、赤、20代、男性」が受け付けられた場合、キャラクタ生成選択部131は、「赤いTシャツとジーンズを身に着けた若い長身の男性」のキャラクタを選択する。 The character generation /

また、位置検出部132は、移動体の位置を示す位置情報を取得する。位置検出は、例えばGPSや無線通信ネットワークの位置検出機能などを利用して行われる。また、位置情報とは、通常、(緯度,経度)であるが、地点IDなど、位置を示す情報であれば何でも良い。 In addition, the

また、ナビゲーション部133は、位置検出部132が取得した位置情報と、キャラクタ生成選択部131によって生成または選択したキャラクタを用いたナビゲーションを行う。ナビゲーションは、移動体の現在位置を地図上に表示したり、現在位置から目的地までの経路探索を行ったり、移動体のユーザを経路に沿って誘導したり、といった経路案内のための処理を含む。 In addition, the

また、移動履歴取得部134は、移動体の移動履歴を取得する。移動履歴は、例えば、位置情報と時刻との対の集合である。移動履歴は、例えば、時系列に並んだ位置情報の集合でも良い。また、移動履歴は、例えば、位置情報と時刻との対の集合である移動経路(現在位置を示す点の軌跡)、移動経路の長さを示す走行距離などに関する情報を含んでも良い。移動履歴取得部134は、位置検出部132が取得した位置情報をもとに移動履歴を取得する。取得された移動履歴は、格納部11に格納され、格納部11に格納された移動履歴は、新たな位置情報が得られる度に、処理部13により更新される。 Moreover, the movement

なお、移動履歴は、移動体が通過した地点名、都道府県名等に関する情報や、移動経路上での安全運転度合に関する情報をさらに含んでもよい。通過した地点名や都道府県名は、移動経路と地図情報との比較から求めることができる。安全運転度合は、例えば、移動速度が制限値を超えた頻度(単位時間当たりの発生回数、ないしは全走行距離に占める当該事象が生じていた距離の割合)、急ブレーキの頻度などであり、前者は移動経路と走行距離から、後者は急ブレーキの時刻を記録しておくことで、それぞれ求めることができる。なお、安全運転度合とは、安全運転または危険運転の度合いに関する情報であり、その取得アルゴリズムは問わない。 Note that the movement history may further include information on the name of the point where the moving body has passed, the name of the prefecture, etc., and information on the degree of safe driving on the movement route. The name of the spot that passed and the name of the prefecture can be obtained by comparing the movement route with the map information. The degree of safe driving is, for example, the frequency at which the moving speed exceeds the limit value (the number of occurrences per unit time or the ratio of the distance in which the event occurred in the total travel distance), the frequency of sudden braking, etc. Can be obtained from the travel route and travel distance, and the latter can be obtained by recording the time of sudden braking. The safe driving degree is information related to the degree of safe driving or dangerous driving, and the acquisition algorithm is not limited.

また、キャラクタ変化部135は、移動履歴取得部134が取得した移動履歴に応じて、キャラクタを変化させる。変化は、キャラクタの表示態様(形状,大きさ,色など)や、表情(明るい表情,心配げな表情など)に関する変化を含む。例えば、走行距離に応じて表示サイズが大きくなったり、安全運転度合が一定値を下回る(危険な運転を行っている傾向にある)と心配げな表情に変わったり、といった変化がキャラクタに与えられる。なお、このような変化は、公知の画像処理によって実現可能である。また、変化は、移動体の移動履歴と、キャラクタに与えられる変化とを対にして記述したキャラクタ変化管理表(図示せず)によって管理される。 In addition, the

また、注意喚起部136は、位置検出部132が取得した位置情報および他人位置受信部151が受信した他人位置情報の関係が予め決められた条件を満足した場合に、注意喚起を行う。条件は、例えば、「(移動体間の距離が)離れすぎた」、「(自身が入ったのではなく)先頭車両がパーキングエリアに入った」などである。注意喚起は、典型的にはキャラクタの発言を通じて行われるが、単なる警告音でもよい。なお、キャラクタの発言とは、注意喚起等の文言(例えば「車間が離れてきています」、「先頭車がパーキングエリアに入りました」など)をあたかもキャラクタが発言しているかのように音声および/または映像(吹き出し、テロップなど)で出力することをいう。なお、注意喚起は、自他の位置関係に関する条件と、位置関係が条件を満たす場合に行う注意喚起とを対にして記載した注意喚起管理表(図示せず)によって管理される。また、注意喚起部136は、他人位置情報が予め決められた条件を満足した場合に、注意喚起を行っても良い。かかる場合は、他人位置情報が示す位置が一般道路に入った場合、他人位置情報が示す位置が目的地になった場合等である。 In addition, the alerting

そして、状態変化検知部137は、移動体の状態変化を検知する。検知対象となる状態変化としては、例えば、速度の変化、残燃料の減少、「サイドブレーキが引かれた(目的地に着いた)」などが挙げられる。移動体の状態とは、例えば、速度、加速度、残燃料、ブレーキの押下の状態、サイドブレーキの状態、移動体の現在位置等である。 And the state

送信部14は、キャラクタ生成選択部131が生成または選択したキャラクタや、位置検出部132が取得した位置情報などをサーバ装置2経由で、他人の移動体に搭載されたナビゲーション装置1に送信する。なお、送信部14は、通常、無線または有線の通信手段で実現されるが、放送手段で実現されても良い。特に、コメント発信部141は、コメント受付部122が受け付けたコメントをサーバ装置2経由で、他人の移動体に搭載されているナビゲーション装置1へと発信する。ただし、コメントの発信先は、当該コメントの発信元と同じグループに属するナビゲーション装置1に限られる。グループは、サーバ装置2がグループ管理表(図7(C)参照)で管理している。 The

受信部15は、他人の移動体に搭載されたナビゲーション装置1からサーバ装置2経由で送信された他人キャラクタ、他人位置情報、コメントなどを受信する。なお、受信部15は、通常、無線または有線の通信手段で実現されるが、放送を受信する手段で実現されても良い。また、受信部15は、通常、他人キャラクタ、他人位置情報、コメントなどを、他人または他人の移動体のナビゲーション装置1を識別する送信元識別情報と対にして、受信する。なお、送信元識別情報とは、送信元を識別する情報であり、例えば、IPアドレス、ID、MACアドレス等である。ただし、送信元識別情報は、送信元が識別できれば良く、そのデータの種類は問わない。特に、他人位置受信部151は、他人の移動体の位置を示す位置情報を受信する。他人キャラクタ受信部152は、他人の移動体に関するキャラクタである他人キャラクタ、もしくはそのような他人キャラクタの識別情報(他人キャラクタID)を受信する。コメント受領部153は、他人のコメントを受領する。なお、受領とは、通常、受信と同意義である。 The receiving

出力部16は、キャラクタを用いたナビゲーションに必要な情報、例えば、地図情報、キャラクタ生成選択部131が生成または選択したキャラクタや、位置検出部132が取得した位置情報などを出力する。なお、出力とは、ディスプレイへの表示、プロジェクターを用いた投影、プリンタでの印字、音出力、外部の装置への送信、記録媒体への蓄積、他の処理装置や他のプログラムなどへの処理結果の引渡しなどを含む概念である。 The output unit 16 outputs information necessary for navigation using a character, for example, map information, a character generated or selected by the character generation /

特に、他人位置出力部161は、他人位置受信部151が受信した位置情報が示す位置を他人キャラクタを用いて出力する。具体的には、例えば、ナビ画面上に他人キャラクタを表示し、位置情報が示す位置について発言させる。あるいは、他人の移動体からの位置情報をもとに、地図上での他人の移動体の位置を特定して、そこに他人キャラクタを単に表示してもよい。 In particular, the other person

また、他人コメント出力部162は、コメント受領部153が受領したコメントを他人に対応する他人キャラクタが発言しているように出力する。例えば、他人キャラクタの近くに吹き出しを配置して、そこにコメントを表示する。ただし、吹き出しは用いず、キャラクタの近くにコメントを表示するだけでも良いし、キャラクタとコメントの対応関係がわかれば、どのような態様で表示しても構わない。このようなコメントの表示(文字出力)に代えて、またはこれに加えて、他人キャラクタの口を動かしつつ、コメントを音声出力してもよい。 Also, the other person comment

そして、キャラクタ発言部163は、状態変化検知部137が検知した変化後の状態が一定の条件を満たす場合に、キャラクタに発言を行わせる。発言には、状態変化に関連する内容、特に変化後の状態を示す情報が含まれる。発言は、例えば格納部11に格納された図7(A)に示す発言管理表により管理される。発言管理表には、移動体の状態変化に関する条件と、当該条件が満たされたとき出力されるべき発言とが対にして記述され、各発言にはID(発言ID)が付されている。 Then, the

キャラクタ発言部163は、発言管理表を参照して、例えば、速度が制限値を超えた場合はキャラクタに「制限速度オーバーです」と発言させ、残燃料が基準値を下回った場合にはキャラクタに「燃料が残り少なくなっています」のように発言させる。ただし、発言は、状態変化について直接言及するものでなくてもよい。例えば、サイドブレーキが引かれた場合、目的地に着いたとしてキャラクタに「お疲れさま」と発言させる。 The

サーバ装置2は、各ナビゲーション装置1が独自に、または互いに連携して、キャラクタを用いたナビゲーションを行うのに必要な情報、例えば、地図情報、位置情報、キャラクタなどを管理する。各ナビゲーション装置1のユーザは、当該ナビゲーション装置1からサーバ装置2にアクセスしてユーザ登録を行う。また、他のユーザと共にグループを形成して、当該グループおよびそのメンバをサーバ装置2に登録することもできる。 The

図7(B)は、ナビゲーション装置1を使用するユーザを管理するためのユーザ管理表の例を示す。ユーザ管理表には、各ユーザについて、ユーザID(1,2,…)、送信元識別子(例えばIPアドレスまたはMACアドレス)、ユーザの名前、およびキャラクタの愛称が組みにして登録される。例えば、ナビゲーション装置1Aのユーザについては、ユーザID“1”、送信元識別子としてのIPアドレス“168.2.71.211”、ユーザの名前“山田さん”、およびキャラクタの愛称“カラーちゃん”が登録される。 FIG. 7B shows an example of a user management table for managing users who use the

図7(C)は、ユーザ管理表に登録されたユーザが所属するグループを管理するためのグループ管理表の例を示す。グループ管理表には、各グループについて、グループIDと、所属メンバを示すメンバIDとが対にして登録される。ここでは、ユーザID“1”および“2”の二人をメンバとするグループ“1”と、ユーザID“3”,“4”および“5”の三人をメンバとするグループ“2”とが登録されている。 FIG. 7C shows an example of a group management table for managing groups to which users registered in the user management table belong. In the group management table, for each group, a group ID and a member ID indicating an affiliated member are registered as a pair. Here, a group “1” whose members are user IDs “1” and “2” and a group “2” whose members are user IDs “3”, “4” and “5” are as follows: Is registered.

サーバ格納部21は、各地の地図情報を格納しており、また、各ナビゲーション装置1からアップロードされてくる情報、例えば、各移動体に関する位置情報や各移動体に対応するキャラクタなども格納する。上記のユーザ管理表やグループ管理表もサーバ格納部21に格納されている。なお、サーバ格納部21は、不揮発性の記録媒体が好適であるが、揮発性の記録媒体でも実現可能である。また、サーバ格納部21にキャラクタ等が記憶される過程は問わない。例えば、記録媒体を介してキャラクタ等がサーバ格納部21で記憶されるようになってもよく、通信回線等を介して送信されたキャラクタ等がサーバ格納部21で記憶されるようになってもよく、あるいは、入力デバイスを介して入力されたキャラクタ等がサーバ格納部21で記憶されるようになってもよい。 The server storage unit 21 stores map information of each location, and also stores information uploaded from each

サーバ受信部22は、各ナビゲーション装置1から送信された位置情報やキャラクタを受信する。なお、サーバ受信部22は、通常、無線または有線の通信手段で実現されるが、放送を受信する手段で実現されても良い。 The

サーバ処理部23は、サーバ受信部22が受信した位置情報やキャラクタを所定の形式でサーバ格納部21に書き込んだり、各ナビゲーション装置1が必要とする位置情報やキャラクタをサーバ格納部21から読み出してサーバ送信部24に転送したりする。図7(D)は、サーバ受信部22が受信した位置情報やキャラクタを管理するための位置・キャラクタ管理表の例を示す。各ナビゲーション装置1からの位置情報やキャラクタ(キャラクタIDでもよい)は、送信元識別情報(ユーザIDでもよい)と対応付けて格納される。なお、サーバ処理部23は、通常、MPUやメモリ等から実現され得る。サーバ処理部23の処理手順は、通常、ソフトウェアで実現され、当該ソフトウェアは記録媒体に記録されている。但し、ハードウェア(専用回路)で実現しても良い。 The

サーバ送信部24は、サーバ処理部23から転送されてきた位置情報やキャラクタを目的のナビゲーション装置1に送信する。なお、サーバ送信部24は、通常、無線または有線の通信手段で実現されるが、放送手段で実現されても良い。 The

次に、情報システムの動作について図8〜図10のフローチャートを用いて説明する。図8〜図9は、ナビゲーション装置1の動作について説明するフローチャートである。 Next, the operation of the information system will be described using the flowcharts of FIGS. 8 to 9 are flowcharts for explaining the operation of the

(ステップS101)ナビゲーション装置1が起動されると、処理部13は、静的属性の入力があったか否かを判別する。静的属性の入力があった場合はステップS102に進み、なかった場合はステップS105に進む。 (Step S101) When the

(ステップS102)属性受付部121が静的属性の入力を受け付ける。 (Step S102) The

(ステップS103)キャラクタ生成選択部131は、属性受付部121が受け付けた静的属性を用いてキャラクタを生成または選択する。具体的には、図4(A)〜(C)に示した部位毎のパーツ群と、図5の(A)〜(C)に示した部位毎のパーツ管理表とが格納部11に格納されており、キャラクタ生成選択部131は、部位毎のパーツ群から、静的属性に適合する各部位のパーツを組み合わせてキャラクタを生成する。または、図6(A)に示したキャラクタ群と、図6(B)に示したキャラクタ管理表とが格納部11に格納されており、キャラクタ生成選択部131は、キャラクタ群から、静的属性に適合するキャラクタを選択する。 (Step S <b> 103) The character

(ステップS104)処理部13は、キャラクタ生成選択部131によって生成または選択されたキャラクタをキャラクタ格納部111に格納する。 (Step S <b> 104) The

(ステップS105)送信部14は、キャラクタ格納部111に格納されているキャラクタを送信元識別情報(ナビゲーション装置1自身のIPアドレスやMACアドレスなど)と共にサーバ装置2に送信する。こうしてナビゲーション装置1から送信されたキャラクタ(および送信元識別情報)は、サーバ装置2によって受信された後、送信元と同じグループに属する他人の移動体に搭載されたナビゲーション装置1に転送される。このキャラクタは、受け取る側のユーザから見ると、他人の移動体に対応するキャラクタなので、「他人キャラクタ」と呼ばれる。 (Step S105) The

(ステップS106)ナビゲーション装置1は、動作を終了するか否かを判断する。受付部12によって電源オフ操作が受け付けられたり、処理部13によって終了処理が実行されたりすると、ナビゲーション装置1は動作を終了する。動作を終了しない場合は、ステップS107に進む。 (Step S106) The

(ステップS107)位置検出部132は、GPSや無線通信ネットワークの位置検出機能などを利用して移動体の現在位置を示す位置情報を取得する。 (Step S107) The

(ステップS108)位置検出部132によって取得された位置情報は、現在時刻を示すタイムスタンプを付されて格納部11に格納される。 (Step S108) The position information acquired by the

(ステップS109)送信部14は、キャラクタ格納部111に格納されている位置情報を送信元識別情報と共にサーバ装置2に送信する。こうしてナビゲーション装置1から送信された位置情報(および送信元識別情報)は、サーバ装置2によって受信された後、他人の移動体に搭載されたナビゲーション装置1に転送される。この位置情報は、受け取る側のユーザから見ると、他人の移動体に関する位置情報なので、「他人位置情報」と呼ばれる。 (Step S109) The

(ステップS110)ナビゲーション部133は、格納部11に格納されている位置情報を用いて、キャラクタ格納部111に格納されているキャラクタを用いたナビゲーションを行う。例えば、処理部13が事前に、受付部12を通じて目的地の入力を受け付け、現在位置から当該目的地までの経路を探索しており、ナビゲーション部133は、移動体が当該経路に沿って移動するよう、キャラクタの発言を通してユーザを誘導する。発言は、例えば「次の交差点を右に曲がってください」、「駐車場は100m先にあります」のように、位置や場所、方向、施設、交通等に関する内容を含む。 (Step S <b> 110) The

(ステップS111)ナビゲーションの実行後、処理部13が、ナビゲーション部133によるナビゲーションに関連する処理を実行する。この関連処理の詳細は、図9にステップS111a〜S111qとして示されている。関連処理の実行後、ナビゲーション装置1は、ステップS106に戻り、上記と同様の処理を繰り返す。その結果、ナビ画面の表示が更新されていく。図9は、ステップS111に示された関連処理の詳細(サブルーチン)を説明するためのフローチャートである。 (Step S111) After execution of navigation, the

(ステップS111a)移動履歴取得部134は、格納部11から移動体の移動履歴を取得する。移動履歴は、現時点までの移動経路、走行距離、安全運転度合(前述)などに関する情報を含む。 (Step S111a) The movement

(ステップS111b)キャラクタ変化部135は、移動履歴取得部134が取得した移動履歴に応じてキャラクタを変化させる。例えば、走行距離に応じて表示サイズが大きくなったり、安全運転度合が一定値を下回ると心配げな表情に変わったり、といった変化がキャラクタに与えられる。 (Step S111b) The

(ステップS111c)状態変化検知部137は、移動体の状態変化を検知し、検知した変化後の状態が一定の条件を満たすか否かを判別する。変化後の状態が一定の条件を満たす場合はステップS111dに進み、満足しない場合にはステップS111eに進む。一定の条件は、典型的には、「速度が制限値を超える」、「残燃料が基準値を下回る」といった、移動体の状態(速度、残燃料など)を示す数値に関する閾値条件である。ただし、例えば「サイドブレーキが引かれた」といった、閾値によらない条件でもよい。 (Step S111c) The state

(ステップS111d)キャラクタ発言部163は、状態変化検知部137が検知した状態変化等に関連する発言を、ナビ画面上のキャラクタに行わせる。例えば、速度が制限値を超えた場合は「制限速度オーバーです」、残燃料が基準値を下回った場合には「燃料が残り少なくなっています」のように発言する。このように、発言には、多くの場合、状態が変化した後の状態の情報が含まれている。その後、ステップS111eに進む。 (Step S111d) The

(ステップS111e)ナビゲーション装置1は、キャラクタ格納部111に他人キャラクタが格納されているか否かを判別する。他人キャラクタが格納されていれば、ステップS111hに進む。他人キャラクタが格納されていない場合には、ステップS111fに進む。 (Step S <b> 111 e) The

(ステップS111f)ナビゲーション装置1は、他人キャラクタ受信部152による他人キャラクタの受信があったか否かを判別する。サーバ装置2から送信された他人キャラクタ(および送信元識別情報)が他人キャラクタ受信部152によって受信されると、ステップS111fの判別結果がYESとなり、ステップS111gに進む。他人キャラクタの受信がなければ、図8のフローチャートにリターンする。 (Step S111f) The

(ステップS111g)処理部13は、他人キャラクタ受信部152が受信した他人キャラクタをキャラクタ格納部111に格納する。その後、ステップS111hに進む。 (Step S <b> 111 g) The

(ステップS111h)処理部13は、他人位置受信部151による他人位置情報の受信があったか否かを判別する。サーバ装置2から送信された他人位置情報(および送信元識別情報)が他人位置受信部151によって受信されると、ステップS111iに進む。他人キャラクタの受信がなければ、ステップS111jに進む。 (Step S <b> 111 h) The

(ステップS111i)他人位置出力部161は、他人位置受信部151が受信した他人位置情報が示す位置を、キャラクタ格納部111に格納されている他人キャラクタを用いて出力する。具体的には、例えば、ナビ画面上に他人キャラクタを表示して、他人キャラクタに「およそ500m先にいるよ」などと発話させる。その後、ステップS111jに進む。 (Step S <b> 111 i) The stranger

(ステップS111j)処理部13は、格納部11に格納されている位置情報および他人位置情報に基づいて、ユーザ自身が運転する移動体の位置と、ユーザと同じグループ内の他人が運転する移動体の位置との位置関係が所定の条件を満たすか否かを判別する。所定の条件は、例えば「ユーザの移動体位置と、ユーザと同じグループ内の少なくとも一人の他人の移動体位置とが一定距離以上離れる」というものであり、その場合、位置情報の示す位置と、グループ内の少なくとも一人の他人位置情報の示す位置との間の距離が一定値以上であれば、両者の位置関係が所定の条件を満たすと判別され、ステップS111kに進む。当該距離が一定値に満たなければ、所定の条件を満たさないと判別され、ステップS111lに進む。 (Step S111j) The

(ステップS111k)注意喚起部136は、所定の条件が満たされたことに関し注意喚起を行う。例えば、ナビ画面上のキャラクタに「車間が開いてきています」のように発言させる。または、単に警告音を発するだけでもよい。その後、ステップS111lに進む。 (Step S111k) The

(ステップS111l)処理部13は、コメント入力があったか否かを判別する。コメント入力は、ナビゲーション装置1に備わる入力手段、例えばタッチパネルを用いて行われる。スマートフォン、タブレット等の携帯端末をナビゲーション装置1とBluetooth(登録商標)で接続すれば、携帯端末側の入力手段も利用できる。コメントが入力されると、ステップS111mに進む。コメント入力がなければ、ステップS111oに進む。 (Step S111l) The

(ステップS111m)コメント受付部122がコメント入力を受け付ける。 (Step S111m) The

(ステップS111n)コメント受付部122によって受け付けられたコメントは、コメント発信部141を通して、送信元識別情報と共に、他人の移動体に搭載されたナビゲーション装置1に向けて発信される。その後、図8のフローチャートにリターンする。 (Step S111n) The comment received by the

(ステップS111o)処理部13は、受信部15によるコメント受信があったか否かを判別する。受信部15によって他のナビゲーション装置からのコメント(および送信元識別情報)が受信されると、ステップS111pに進む。コメント受信がなければ、図8のフローチャートにリターンする。 (Step S111o) The

(ステップS111p)コメント受領部153が当該コメントを受領する。 (Step S111p) The

(ステップS111q)他人コメント出力部162は、コメント受領部153が受領したコメントを、あたかも他人キャラクタが発話しているように出力する。具体的には、例えば、ナビ画面上で他人キャラクタの口付近に吹き出しを設け、コメントを表示する。このような文字出力に代えて、またはこれに加えてさらに、他人キャラクタの口を動かしながら、コメントを音声出力してもよい。なお、吹き出しや口の動きは、適宜省略してもよい。その後、図8のフローチャートにリターンする。 (Step S111q) The stranger

図10は、サーバ装置2の動作について説明するフローチャートである。 FIG. 10 is a flowchart for explaining the operation of the

(ステップS201)サーバ処理部23は、サーバ受信部22によるキャラクタ(および送信元識別情報)の受信の有無を判別する。ナビゲーション装置1から送信されたキャラクタおよび送信元識別情報(ナビゲーション装置1のIPアドレスやMACアドレス)の受信がなければ、ステップS202に進み、受信があればステップS204に進む。 (Step S201) The

(ステップS202)サーバ処理部23は、サーバ受信部22による位置情報(および送信元識別情報)の受信の有無を判別する。ナビゲーション装置1から送信された位置情報および送信元識別情報の受信がなければ、ステップS203に進み、受信があればステップS206に進む。 (Step S202) The

(ステップS203)サーバ処理部23は、サーバ受信部22によるコメント(および送信元識別情報)の受信の有無を判別する。ナビゲーション装置1から送信されたコメントおよび送信元識別情報の受信がなければ、ステップS201に戻り、受信があればステップS208に進む。 (Step S203) The

(ステップS204)サーバ処理部23は、サーバ受信部22が受信したキャラクタを送信元識別情報と共にサーバ格納部21に格納する。これに伴い、サーバ格納部21に格納されている位置・キャラクタ管理表が更新される。 (Step S204) The

(ステップS205)サーバ送信部24は、サーバ格納部21に格納されているキャラクタ(および送信元識別情報)を、送信元と同じグループ内の他のナビゲーション装置1に他人キャラクタとして送信する。その後、ステップS201に戻る。 (Step S205) The

(ステップS206)サーバ処理部23は、サーバ受信部22が受信した位置情報を送信元識別情報と共にサーバ格納部21に格納する。これに伴い、サーバ格納部21に格納されている位置・キャラクタ管理表が更新される。 (Step S206) The

(ステップS207)サーバ送信部24は、サーバ格納部21に格納されている位置情報(および送信元識別情報)を、送信元と同じグループ内の他のナビゲーション装置1に他人位置情報として送信する。その後、ステップS201に戻る。 (Step S207) The

(ステップS208)サーバ送信部24は、サーバ受信部22が受信したコメント(および送信元識別情報)を送信元と同じグループ内の他のナビゲーション装置1に送信する。その後、ステップS201に戻る。 (Step S208) The

なお、図10のフローチャートにおいて、電源オフや処理終了の割り込みにより処理は終了する。 In the flowchart of FIG. 10, the process ends when the power is turned off or the process ends.

以下、本実施の形態における情報システムの具体的な動作について説明する。情報システムの概念図は図1である。 Hereinafter, a specific operation of the information system in the present embodiment will be described. A conceptual diagram of the information system is shown in FIG.

ナビゲーション装置1が起動されると、図示しない入力画面が表示され、ユーザは、移動体属性として「タイプ」および「ボディカラー」と、ユーザ情報として「性別」および「年齢」とを入力する。なお、入力される移動体属性やユーザ情報の数や内容等は一例であり、適宜追加または変更されてよい。また、移動体属性については、例えばメーカ名、型式、ボディカラー等を示す情報が移動体自身に予め格納されている場合、ナビゲーション装置1は、ユーザから入力を受け付ける代わりに、移動体から必要な情報を取得してもよい。 When the

ナビゲーション装置1では、属性受付部121が入力を受け付け、キャラクタ生成選択部131は、属性受付部121が受け付けた静的属性を用いて、当該ナビゲーション装置1が搭載されている移動体を擬人化したようなキャラクタを生成または選択する。 In the

一例として、ナビゲーション装置1Aは男性ユーザのスポーツカーに搭載され、ナビゲーション装置1Bは女性ユーザのコンパクトカーに搭載されているとする。各ユーザは、事前に自分のナビゲーション装置1からサーバ装置2にアクセスして、自分の名前と移動体の愛称を送信する。サーバ装置2は、各ユーザにユーザIDを付与して、サーバ格納部21内のユーザ管理表(図7(B)参照)に、ユーザIDと、送信元識別子(例えばナビゲーション装置のIPアドレス)と、ユーザの名前と、移動体の愛称とを組みにして登録する。また、男性ユーザ(例えばユーザ“2”)と女性ユーザ(例えばユーザ“1”)は、事前に相互認証を行うことで、サーバ格納部21内のグループ管理表(図7(C)参照)に、同じグループ“1”のメンバとして登録されている。 As an example, it is assumed that the

サーバ格納部21には、各部位のパーツ群(図4(A)〜(C)参照)と、部位毎のパーツ管理表(図5参照)とが格納されており、男性ユーザがタイプとして「スポーツカー」を、ボディカラーとして「赤」を、性別として「男性」を、年齢として「20代」を入力したとすると、ナビゲーション装置1Aは、入力された静的属性とパーツ管理表を用いて、各部位のパーツ群から、静的属性に適合するパーツを組み合わせることで、例えば赤いTシャツとジーンズを身に着けた長身の青年キャラクタを生成する。同様に、ナビゲーション装置1Bに対し、女性ユーザが車種として「コンパクトカー」を、ボディカラーとして「水色」を、性別として「女性」を、「年齢」として「20代」を入力したとすると、例えば水色のワンピースと白い靴を身に着けた小柄な少女キャラクタが生成される。 The server storage unit 21 stores a part group for each part (see FIGS. 4A to 4C) and a part management table for each part (see FIG. 5). Assuming that “sports car” is entered, “red” as the body color, “male” as the gender, and “20s” as the age, the

または、サーバ格納部21にキャラクタ群(図6(A)参照)とキャラクタ管理表(図6(B)参照)とが格納されており、男性ユーザがタイプとして「スポーツカー」を、ボディカラーとして「赤」を、性別として「男性」を、年齢として「20代」を入力したとすると、ナビゲーション装置1Aは、入力された静的属性とキャラクタ管理表を用いて、キャラクタ群の中から、静的属性に適合するキャラクタとして、例えば赤いTシャツとジーンズを身に着けた若い長身の青年キャラクタを選択する。同様に、ナビゲーション装置1Bに対し、女性ユーザがタイプとして「コンパクトカー」を、ボディカラーとして「水色」を、性別として「女性」を、年齢として「20代」を入力したとすると、例えば水色のワンピースと白い靴を身に着けた若い小柄な少女キャラクタが選択される。 Alternatively, a character group (see FIG. 6A) and a character management table (see FIG. 6B) are stored in the server storage unit 21, and a male user sets “sports car” as a body color. If “red” is entered, “male” is entered as the gender, and “20s” is entered as the age, the

または、属性受付部121が受け付けた静的属性に最も適合するキャラクタを一つだけ選択する代わりに、キャラクタ生成選択部131は、まず、属性受付部121が受け付けた静的属性を用いてキャラクタの絞り込みを行う。具体的には、受け付けた静的属性に最も適合するものから順に複数のキャラクタを選択する。次に、こうして絞り込んだ複数のキャラクタを画面上に提示して、ユーザからの指示を受付部12で受け付け、その指示されたキャラクタを選択するようにしてもよい。 Alternatively, instead of selecting only one character that best matches the static attribute received by the

こうしてキャラクタ生成選択部131が生成または選択したキャラクタは、キャラクタ格納部111に格納されると共に、送信部14からサーバ装置2に送信される。サーバ装置2は、ナビゲーション装置1からキャラクタを受信すると、格納部11内のユーザ管理表およびグループ管理表を参照して、そのキャラクタを送信元と同じグループ内の他のナビゲーション装置1に他人キャラクタとして転送する。 The character generated or selected by the character generation /

具体的には、女性ユーザ側のナビゲーション装置1Bから少女キャラクタが送信されたとすると、サーバ装置2は、まず、受信したキャラクタに付されている送信元識別情報をユーザ管理表と比較することで、当該キャラクタはユーザ“1”からのキャラクタであることを認識する。次に、ユーザ管理表を参照して、ユーザ“1”がグループ“1”に所属しており、ユーザ2も同じグループ“1”の所属であることから、サーバ装置2は、ユーザ“1”からの少女キャラクタをユーザ“2”つまり男性ユーザのナビゲーション装置1Aに転送する。こうして、男性ユーザのスポーツカーに搭載されたナビゲーション装置1Aには、当該スポーツカーを示す青年キャラクタに加え、他人キャラクタとして、女性ユーザが運転するコンパクトカーを示す少女キャラクタも格納される。女性ユーザのコンパクトカーに搭載されたナビゲーション装置1Bには、当該コンパクトカーを示す少女キャラクタに加え、他人キャラクタとして青年キャラクタも格納される。その後、ナビゲーション装置1は、GPSや無線通信ネットワークの位置検出機能などを利用して現在位置を含む位置情報を取得したり、取得した位置情報を表示したり、現在位置から任意の目的地までの経路を探索したり、探索した経路に沿ってユーザを誘導したり、といったナビゲーションを行う。 Specifically, if a girl character is transmitted from the navigation device 1B on the female user side, the

この実施例のナビゲーションにおいて、経路案内は、上記のようにキャラクタ生成選択部131が生成または選択したキャラクタを用いて行われる。例えば、図11に示すように、ナビ画面上にキャラクタが表示され、「2番目の交差点を右に曲がってください」、「駐車場は100m先にあります」といった案内音声がこのキャラクタの発話として出力される。 In the navigation of this embodiment, route guidance is performed using the character generated or selected by the character generation /

また、状態変化検知部137が移動体の状態の変化を監視しており、変化後の状態が一定の条件を満たす場合に、キャラクタ発言部163は、その状態変化についてキャラクタに発言させる。移動体の状態は、移動速度に関する状態(例えば、停止している状態、制限速度で走行している状態など)や、残り燃料に関する状態(例えば残り燃料がゼロの状態、満タンの状態など)を含み、発言は、図7(A)の発言管理表に基づいて行われる。例えば、図12に示すように、燃料の残量が基準値を下回ると、キャラクタは「ガソリンが少なくなってきました」のように発言し、また、移動体の速度が制限値を超えると、キャラクタは「速度オーバーです」のように発言する。 In addition, when the state

状態変化検知部137で所定の状態変化が検知されない期間は、移動履歴取得部134が移動体の移動履歴を格納部11から取得し、キャラクタ変化部135は、ナビ画面上のキャラクタを取得された移動履歴に応じて変化させる。キャラクタに与える変化は、移動履歴と変化とを対にして登録した変化管理表(図示せず)に基づき決定される。例えば、走行距離に応じてキャラクタの表示サイズを大きくしたり、連続走行時間が長くなるにつれてキャラクタの表情が疲れていき、休憩を入れると元気な表情に戻る、といった表情の変化を加えたりする。 During a period when the predetermined state change is not detected by the state

また、ナビゲーション中に、各ナビゲーション装置1が取得した位置情報は、サーバ装置2を介して他のナビゲーション装置1へと転送される。各ナビゲーション装置1は、他のナビゲーション装置1からの他人位置情報を他人キャラクタにより出力する。 Further, the position information acquired by each

具体的には、例えば図13に示すように、男性ユーザ側のナビゲーション装置1Aにおいて、他人キャラクタである少女キャラクタが表示され、女性(山田さん)が運転するコンパクトカー(カラーちゃん)の現在位置について、位置情報、他人位置情報およびユーザ管理表(図7(B)参照)を参照して、「およそ500m先に山田さんとカラーちゃん」のように発言する。 Specifically, for example, as shown in FIG. 13, in the

また、情報システムでは、ナビゲーション装置1間でコメントのやり取りも行える。具体的には、ナビゲーション装置1Aにおいて、コメント受付部122によって受け付けられたコメントは、コメント発信部141からサーバ装置2経由で他のナビゲーション装置1Bに発信される。ナビゲーション装置1Bからのコメントは、コメント受領部153によって受領され、他人コメント出力部162から他人キャラクタの発言として出力される。 In the information system, comments can be exchanged between the

例えば、上記図13では、他人キャラクタである少女キャラクタから、位置情報に関する発言の後、女性ユーザ(山田さん)が発信したコメントである「コンビニに寄って行くね」がさらに出力されている。 For example, in FIG. 13 described above, a comment sent by a female user (Mr. Yamada) is further output from a girl character that is another character, after a remark about position information.

また、ナビゲーション装置1では、同じグループ内で移動体間の位置関係が所定の条件を満たした場合に、注意喚起部136による注意喚起が行われる。例えば、上述のスポーツカーとコンパクトカーの間が一定距離以上離れると、それぞれのナビゲーション装置1において、キャラクタから「車間が離れてきています」のような注意喚起を示す文言が出力される。 Moreover, in the

なお、キャラクタ発言部163は、起動時に「おはよう」、「こんばんは」といった挨拶をキャラクタに発言させてもよい。挨拶の内容は、時間帯および挨拶文を対にして記述した挨拶管理表(図示せず)と、現在時刻とから決定される。 The

また、図7(A)の発言管理表に、条件として「目的地までの距離が一定値を下回った」と、発言として「目的地までもう少しですね」を登録しておくことで、目的地までの距離が一定以下になったとき、キャラクタに「目的地までもう少しですね」と発言させてもよい。 Also, in the statement management table of Fig. 7 (A), register the destination as "the distance to the destination has fallen below a certain value" and the statement as "a little more to the destination". When the distance to the distance is below a certain level, the character may say “It ’s a little more to the destination”.

また、キャラクタ発言部163は、キャラクタに「今夜はワールドカップです。19:30キックオフで、コートジボワール戦ですよ」と発言させるなど、時事的な話題を提供してもよい。時事的な話題は、現在位置や現在時刻に基づいて、インターネットやデータ放送から取得してもよい。 In addition, the

また、キャラクタ発言部163は、キャラクタに「目的地まで遠いのでお食事にしませんか?少し先に飲食店がありますよ」と発言させるなど、キャラクタを通してドライブの状況に応じた提案を行ってもよい。提案は、現在位置、現在時刻、地図情報、移動履歴等に基づいて決定される。 Even if the

なお、この実施例では、キャラクタを生成または選択する際に参照されるユーザ情報(ユーザの静的属性)として、性別および年齢を入力したが、性格(まじめ、ざっくばらん等)や口調(丁寧、ため口等)を入力してもよい。入力された性格や口調に応じて、キャラクタの発話の仕方を変えれば、キャラクタに対する親近感が増す。 In this embodiment, gender and age are input as user information (user static attributes) to be referred to when generating or selecting a character. However, personality (seriousness, rough variation, etc.) Mouth etc.) may be entered. If the way of speaking of the character is changed according to the input personality and tone, the familiarity with the character increases.

なお、本実施の形態では、専用のサーバ装置2を用いているが、他人キャラクタ受信部152、コメント受領部153およびコメント発信部141は、SNSのサーバ装置経由で他人キャラクタの取得、コメントの受領およびコメントの発信を行うようにしてもよい。 In the present embodiment, the

また、本実施の形態では、ナビゲーション装置1間の通信はサーバ装置2を介して行っているが、ピア・ツー・ピアで直接通信してもよい。 In the present embodiment, the communication between the

なお、静的属性を用いてキャラクタを生成または選択する処理と、生成または選択されたキャラクタを移動履歴に応じて変化させる処理とは、本実施の形態では各ナビゲーション装置1が分散的に実行しているが、サーバ装置2において集約的に実行されてもよい。この場合、図2に示したナビゲーション装置1の構成は、処理部13からキャラクタ生成選択部131およびキャラクタ変化部135を削除したものになる一方、図3に示したサーバ装置2の構成は、例えば図20のようになる。 In the present embodiment, each

図16において、サーバ処理部23は、キャラクタ生成選択部23aと、キャラクタ変化部23bとを備える。各ナビゲーション装置1は、受け付けた静的属性をサーバ装置2に送信し、キャラクタ生成選択部23aは、サーバ受信部22で受信した各ナビゲーション装置1からの静的属性を用いて、それぞれの移動体に関するキャラクタを生成または選択する。キャラクタ生成選択部23aが生成または選択したキャラクタは、送信元識別子と対にしてサーバ格納部21に格納されると共に、サーバ送信部24からそれぞれ対応するナビゲーション装置1に送信される。各ナビゲーション装置1では、こうしてサーバ装置2から受信したキャラクタがキャラクタ格納部111に格納され、これを用いたナビゲーションが行われる。 In FIG. 16, the

また、各ナビゲーション装置1は、取得した移動履歴をサーバ装置2に送信し、キャラクタ変化部23bは、サーバ受信部22で受信した各ナビゲーション装置1からの移動履歴を用いて、サーバ格納部21に格納しているそれぞれのキャラクタを変化させる。変化後のキャラクタは、それぞれ対応するナビゲーション装置1に送信され、各ナビゲーション装置1では、キャラクタ格納部111に格納されているキャラクタが、変化後のキャラクタに置き換えられる。 In addition, each

これにより、各ナビゲーション装置1の処理負荷を軽減することができる。 Thereby, the processing load of each

以上のように、本実施の形態によれば、移動体の1以上の静的属性値を含む静的属性を受け付ける属性受付部121と、属性受付部121が受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択部131と、移動体の位置を示す位置情報を取得する位置検出部132と、位置検出部132によって取得された位置情報を用いて、キャラクタ生成選択部131によって生成または選択されたキャラクタを用いたナビゲーションを行うナビゲーション部133とを具備するナビゲーション装置1により、移動体の属性に基づくキャラクタを生成または選択するので、個性があり、愛着のあるキャラクタを用いたナビゲーションを行うことができる。 As described above, according to the present embodiment, using the

また、上記構成において、静的属性はユーザに関する情報であるユーザ情報をさらに含むことにより、ユーザ情報も加味してキャラクタを生成または選択するので、キャラクタに一層愛着がわくようにすることができる。 Further, in the above configuration, since the static attribute further includes user information that is information related to the user, and the character is generated or selected in consideration of the user information, the attachment of the character can be further enhanced.

また、上記構成において、移動体の移動履歴を取得する移動履歴取得部134と、移動履歴取得部134によって取得された移動履歴に応じて、キャラクタを変化させるキャラクタ変化部135とをさらに具備することで、移動履歴をキャラクタの変化で直感的に認識させることができる。 Further, in the above configuration, a movement

また、上記構成において、移動体の状態変化を検知する状態変化検知部137と、状態変化検知部137によって検知された変化後の状態が一定の条件を満たす場合にキャラクタに状態変化に応じた発言を行わせるキャラクタ発言部163とをさらに具備することで、移動体の状態が変化したことを、キャラクタの発言を通じて知らせることができる。 In addition, in the above configuration, when the state

また、上記構成において、キャラクタが行う発言の内容は状態検知部137によって検知された状態変化を含むことにより、移動体の変化後の状態を認識させることができる。 Moreover, in the said structure, the content of the speech which a character performs includes the state change detected by the

また、上記構成において、人の移動体の位置を示す位置情報を受信する他人位置受信部151と、他人の移動体に関するキャラクタである他人キャラクタを受信する他人キャラクタ受信部152と、他人位置受信部151によって受信された位置情報が示す位置を他人キャラクタを用いて出力する他人位置出力部161とをさらに具備することにより、他人の移動体の位置を当該他人のキャラクタで直感的に認識させることができる。 In the above configuration, the other person

また、上記構成において、位置検出部132によって取得された位置情報および他人位置受信部151によって受信された位置情報の関係が予め決められた条件を満足した場合に、注意喚起を行う注意喚起部136をさらに具備することにより、他人の移動体との位置関係に応じた注意喚起を行うことができる。 Further, in the above configuration, the alerting

また、上記構成において、他人のコメントを受領するコメント受領部153と、コメント受領部153によって受領されたコメントを他人に対応する他人キャラクタが発言しているように出力する他人コメント出力部162とをさらに具備することにより、他人からのコメントを他人キャラクタを通して伝えることができる。 Further, in the above configuration, a

また、上記構成において、他人へのコメントを受け付けるコメント受付部122と、コメント受付部122が受け付けたコメントを他人の移動体へと発信するコメント発信部141とをさらに具備することにより、他人にコメントを発信することができる。 In addition, in the above configuration, a

また、上記構成において、他人キャラクタ受信部152、コメント受領部153およびコメント発信部141は、それぞれSNSのサーバ装置経由で他人キャラクタの取得、コメントの受領およびコメントの発信を行うことにより、SNSを介して効率よく連携することができる。 In the above configuration, the other-

さらに、本実施の形態における処理は、ソフトウェアで実現しても良い。そして、このソフトウェアをソフトウェアダウンロード等により配布しても良い。また、このソフトウェアを記録媒体に記録して流布しても良い。なお、このことは、本明細書における他の実施の形態においても該当する。なお、本実施の形態における情報処理装置を実現するソフトウェアは、例えば下記のようなコンピュータを、上記各部として機能させるためのプログラムである。図14は、上記プログラムを実行して、上記実施の形態によるサーバ装置2を実現するコンピュータシステム900の一例を示す図である。上記実施の形態は、コンピュータハードウェア及びその上で実行されるコンピュータプログラムによって実現されうる。図14において、コンピュータシステム900は、CD−ROMドライブ905を含むコンピュータ901と、キーボード902と、マウス903と、モニタ904とを備える。図15は、コンピュータシステム900の内部構成を示す図である。図15において、コンピュータ901は、CD−ROMドライブ905に加えて、MPU911と、ROM912と、RAM913と、ハードディスク914と、バス915とを備える。なお、コンピュータ901は、図示しないネットワークカードを含んでいてもよい。コンピュータシステム900がどのように動作するのかについては周知であり、詳細な説明は省略する。また、上記プログラムを実行して、上記実施の形態によるナビゲーション装置1を実現するコンピュータシステムは、例えば、図15のコンピュータシステム900において、キーボード902およびマウス903をタッチパネルに置き換え、ハードディスクをフラッシュメモリに置き換え、CD−ROMドライブ905およびCD−ROM921をメモリカードスロットおよびメモリカードに置き換え、そしてGPS受信機を追加したものである。なお、上記プログラムにおいて、情報を送信する送信ステップや、情報を受信する受信ステップなどでは、ハードウェアによって行われる処理、例えば、送信ステップにおけるモデムやインターフェースカードなどで行われる処理(ハードウェアでしか行われない処理)は含まれない。また、上記プログラムを実行するコンピュータは、単数であってもよく、複数であってもよい。すなわち、集中処理を行ってもよく、あるいは分散処理を行ってもよい。 Furthermore, the processing in the present embodiment may be realized by software. Then, this software may be distributed by software download or the like. Further, this software may be recorded on a recording medium and distributed. This also applies to other embodiments in this specification. In addition, the software which implement | achieves the information processing apparatus in this Embodiment is a program for functioning the following computers, for example as said each part. FIG. 14 is a diagram illustrating an example of a

また、上記実施の形態において、一の装置に存在する2以上の通信手段(送信部、受信部など)は、物理的に一の媒体で実現されても良いことは言うまでもない。 In the above-described embodiment, it is needless to say that two or more communication means (a transmission unit, a reception unit, etc.) existing in one device may be physically realized by one medium.

また、上記各実施の形態において、各処理(各機能)は、単一の装置(システム)によって集中処理されることによって実現されてもよく、あるいは、複数の装置によって分散処理されることによって実現されてもよい。 In each of the above embodiments, each process (each function) may be realized by centralized processing by a single device (system), or by distributed processing by a plurality of devices. May be.

本発明は、以上の実施の形態に限定されることなく、種々の変更が可能であり、それらも本発明の範囲内に包含されるものであることは言うまでもない。 The present invention is not limited to the above-described embodiments, and various modifications are possible, and it goes without saying that these are also included in the scope of the present invention.

以上のように、本発明にかかるナビゲーション装置1は、移動体を擬人化した個性があり、愛着のあるキャラクタで楽しいナビゲーションが行えるという効果を有し、ナビゲーション装置等として有用である。 As described above, the

1 ナビゲーション装置

2 サーバ装置

11 格納部

12 受付部

13 処理部

14 送信部

15 受信部

16 出力部

21 サーバ格納部

22 サーバ受信部

23 サーバ処理部

24 サーバ送信部

111 キャラクタ格納部

121 属性受付部

122 コメント受付部

131 キャラクタ生成選択部

132 位置検出部

133 ナビゲーション部

134 移動履歴取得部

135 キャラクタ変化部

136 注意喚起部

137 状態変化検知部

141 コメント発信部

151 他人位置受信部

152 他人キャラクタ受信部

153 コメント受領部

161 他人位置出力部

162 他人コメント出力部

163 キャラクタ発言部DESCRIPTION OF

Claims (12)

Translated fromJapanese前記属性受付部が受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択部と、

前記移動体の位置を示す位置情報を取得する位置検出部と、

前記位置検出部が取得した位置情報と、前記キャラクタ生成選択部が生成または選択したキャラクタを用いてナビゲーションを行うナビゲーション部と、を具備するナビゲーション装置。An attribute accepting unit that accepts a static attribute including one or more static attribute values of the moving object;

A character generation selection unit that generates or selects a character using the static attribute received by the attribute reception unit;

A position detection unit for acquiring position information indicating the position of the moving body;

A navigation apparatus comprising: position information acquired by the position detection unit; and a navigation unit that performs navigation using the character generated or selected by the character generation / selection unit.

前記移動履歴取得部が取得した移動履歴に応じて、前記キャラクタを変化させるキャラクタ変化部と、をさらに具備する請求項1または請求項2記載のナビゲーション装置。A movement history acquisition unit for acquiring a movement history of the moving body;

The navigation device according to claim 1, further comprising: a character changing unit that changes the character according to the movement history acquired by the movement history acquisition unit.

前記状態変化検知部が検知した変化後の状態が一定の条件を満たす場合に前記キャラクタに発言を行わせるキャラクタ発言部と、をさらに具備する請求項1から請求項3いずれか一項に記載のナビゲーション装置。A state change detection unit for detecting a change in the state of the moving body;

The character remark part which makes the said character speak when the state after the change detected by the said state change detection part satisfy | fills a fixed condition is further provided. Navigation device.

前記他人の移動体に関するキャラクタである他人キャラクタを受信する他人キャラクタ受信部と、

前記他人位置受信部が受信した他人位置情報が示す位置を、前記他人キャラクタを用いて出力する他人位置出力部と、をさらに具備する請求項1から請求項5いずれか一項に記載のナビゲーション装置。Other person position receiving unit that receives other person position information indicating the position of another person's moving body,

A stranger character receiving unit for receiving a stranger character that is a character related to the moving body of the stranger;

The navigation device according to any one of claims 1 to 5, further comprising: a stranger position output unit that outputs the position indicated by the stranger position information received by the stranger position receiving unit using the stranger character. .

前記コメント受領部が受領したコメントを前記他人に対応する他人キャラクタが発言しているように出力する他人コメント出力部と、をさらに具備する請求項6または請求項7記載のナビゲーション装置。A comment receiving department that receives comments from others;

The navigation apparatus according to claim 6, further comprising: a comment output unit for outputting a comment received by the comment receiving unit as if a comment by another person corresponding to the other person is speaking.

前記コメント受付部が受け付けたコメントを前記他人の移動体へ発信するコメント発信部と、をさらに具備する請求項8記載のナビゲーション装置。A comment receiving unit for receiving comments on the other person;

The navigation device according to claim 8, further comprising: a comment transmission unit configured to transmit a comment received by the comment reception unit to the other person's mobile body.

前記属性受付部による、移動体の1以上の静的属性値を含む静的属性を受け付ける属性受付ステップと、

前記キャラクタ生成選択部による、前記属性受付ステップで受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択ステップと、

前記位置検出部による、前記移動体の位置を検示す位置情報を取得する位置検出ステップと、

前記位置検出ステップで取得した位置情報と、前記キャラクタ生成選択ステップで生成または選択したキャラクタを用いて、前記ナビゲーション部がナビゲーションを行うナビゲーションステップとを含む、ナビゲーション方法。A navigation method performed by an attribute reception unit, a character generation selection unit, a position detection unit, and a navigation unit,

An attribute receiving step for receiving a static attribute including one or more static attribute values of the moving body by the attribute receiving unit;

A character generation selection step for generating or selecting a character using the static attribute received in the attribute reception step by the character generation selection unit;

A position detection step of acquiring position information for detecting the position of the moving body by the position detection unit;

A navigation method, comprising: position information acquired in the position detection step; and a navigation step in which the navigation unit performs navigation using the character generated or selected in the character generation selection step.

移動体の1以上の静的属性値を含む静的属性を受け付ける属性受付部と、

前記属性受付部が受け付けた静的属性を用いて、キャラクタを生成または選択するキャラクタ生成選択部と、

前記移動体の位置を示す位置情報を取得する位置検出部と、

前記位置検出部が取得した位置情報と、前記キャラクタ生成選択部が生成または選択したキャラクタを用いたナビゲーションを行うナビゲーション部として機能させるプログラム。

Computer

An attribute accepting unit that accepts a static attribute including one or more static attribute values of the moving object;

A character generation selection unit that generates or selects a character using the static attribute received by the attribute reception unit;

A position detection unit for acquiring position information indicating the position of the moving body;

A program that functions as a navigation unit that performs navigation using the position information acquired by the position detection unit and the character generated or selected by the character generation selection unit.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016033782AJP6892220B2 (en) | 2016-02-25 | 2016-02-25 | Navigation devices, navigation methods and programs |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016033782AJP6892220B2 (en) | 2016-02-25 | 2016-02-25 | Navigation devices, navigation methods and programs |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2017150957Atrue JP2017150957A (en) | 2017-08-31 |

| JP6892220B2 JP6892220B2 (en) | 2021-06-23 |

Family

ID=59739679

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016033782AActiveJP6892220B2 (en) | 2016-02-25 | 2016-02-25 | Navigation devices, navigation methods and programs |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP6892220B2 (en) |

Cited By (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021097764A (en)* | 2019-12-20 | 2021-07-01 | 株式会社東海理化電機製作所 | Control device and program |

| CN113401129A (en)* | 2020-03-17 | 2021-09-17 | 丰田自动车株式会社 | Information processing apparatus, recording medium, and information processing method |

| JPWO2022180770A1 (en)* | 2021-02-26 | 2022-09-01 |

Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH08184450A (en)* | 1994-12-28 | 1996-07-16 | Victor Co Of Japan Ltd | Position display of traveling body |

| JPH11259446A (en)* | 1998-03-12 | 1999-09-24 | Aqueous Reserch:Kk | Agent device |

| JP2002340583A (en)* | 2001-05-17 | 2002-11-27 | Honda Motor Co Ltd | Peripheral vehicle information providing device |

| JP2003346173A (en)* | 2002-05-24 | 2003-12-05 | Tokei Jikake:Kk | Delivery system of character/animation |

| JP2004101227A (en)* | 2002-09-05 | 2004-04-02 | Denso Corp | Car navigation apparatus |

| JP2008061896A (en)* | 2006-09-08 | 2008-03-21 | Nintendo Co Ltd | GAME PROGRAM AND GAME DEVICE |

| WO2009133710A1 (en)* | 2008-04-30 | 2009-11-05 | 株式会社アクロディア | Character display data generation device and method |

| JP2013120141A (en)* | 2011-12-08 | 2013-06-17 | Fujitsu Ten Ltd | Display unit, program, and display method |

| JP2016024555A (en)* | 2014-07-17 | 2016-02-08 | 本田技研工業株式会社 | Program and method for exchanging messages, and electronic apparatus |

- 2016

- 2016-02-25JPJP2016033782Apatent/JP6892220B2/enactiveActive

Patent Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH08184450A (en)* | 1994-12-28 | 1996-07-16 | Victor Co Of Japan Ltd | Position display of traveling body |

| JPH11259446A (en)* | 1998-03-12 | 1999-09-24 | Aqueous Reserch:Kk | Agent device |

| JP2002340583A (en)* | 2001-05-17 | 2002-11-27 | Honda Motor Co Ltd | Peripheral vehicle information providing device |

| JP2003346173A (en)* | 2002-05-24 | 2003-12-05 | Tokei Jikake:Kk | Delivery system of character/animation |

| JP2004101227A (en)* | 2002-09-05 | 2004-04-02 | Denso Corp | Car navigation apparatus |

| JP2008061896A (en)* | 2006-09-08 | 2008-03-21 | Nintendo Co Ltd | GAME PROGRAM AND GAME DEVICE |

| WO2009133710A1 (en)* | 2008-04-30 | 2009-11-05 | 株式会社アクロディア | Character display data generation device and method |

| JP2013120141A (en)* | 2011-12-08 | 2013-06-17 | Fujitsu Ten Ltd | Display unit, program, and display method |

| JP2016024555A (en)* | 2014-07-17 | 2016-02-08 | 本田技研工業株式会社 | Program and method for exchanging messages, and electronic apparatus |

Cited By (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021097764A (en)* | 2019-12-20 | 2021-07-01 | 株式会社東海理化電機製作所 | Control device and program |

| CN113401129A (en)* | 2020-03-17 | 2021-09-17 | 丰田自动车株式会社 | Information processing apparatus, recording medium, and information processing method |

| JP2021149250A (en)* | 2020-03-17 | 2021-09-27 | トヨタ自動車株式会社 | Information processing apparatus, program and information processing method |

| JP7354888B2 (en) | 2020-03-17 | 2023-10-03 | トヨタ自動車株式会社 | Information processing device, program, and information processing method |

| CN113401129B (en)* | 2020-03-17 | 2023-12-26 | 丰田自动车株式会社 | Information processing apparatus, recording medium, and information processing method |

| US11904868B2 (en) | 2020-03-17 | 2024-02-20 | Toyota Jidosha Kabushiki Kaisha | Information processing device, recording medium, and information processing method |

| JPWO2022180770A1 (en)* | 2021-02-26 | 2022-09-01 | ||

| JP7623033B2 (en) | 2021-02-26 | 2025-01-28 | Loovic株式会社 | PROGRAM, INFORMATION PROCESSING APPARATUS, AND INFORMATION PROCESSING METHOD |

Also Published As

| Publication number | Publication date |

|---|---|

| JP6892220B2 (en) | 2021-06-23 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US10753760B2 (en) | Navigation systems and associated methods | |

| JP7301274B2 (en) | Audio player and vehicle | |

| EP3296944A1 (en) | Information processing device, information processing method, and program | |

| US11460309B2 (en) | Control apparatus, control method, and storage medium storing program | |

| JP2017507425A (en) | Systems used in vehicles | |

| JP2018049477A (en) | Driving support device, center device | |

| JP2008186250A (en) | Information providing device for vehicle | |

| CN104704322A (en) | Navigation device and navigation server | |

| JP2017509065A (en) | Vehicle image capture system using different language translations | |

| US20210092086A1 (en) | System and method for facilitating driver communication via an audio centric network | |

| JP2019139354A (en) | Information providing device and information providing method | |

| JP2017150957A (en) | Navigation device, navigation method, and program | |

| JP2020095475A (en) | Matching method, matching server, matching system, and program | |

| JP2015052945A (en) | System and program | |

| US20180342005A1 (en) | Place recommendation device and place recommendation method | |

| CN108632336A (en) | Information provides car-mounted device, information providing system and the storage medium for being stored with information provision procedure | |

| EP3279897A1 (en) | Safety device for a vehicle | |

| CN112193255A (en) | Human-computer interaction method, device, device and storage medium for vehicle-machine system | |

| JP2021193583A (en) | Driving evaluation model adaptation device, terminal equipment, control method, program, and storage medium | |

| JP2022189185A (en) | Suggestion device and method | |

| JP2004286872A (en) | Advertising method and advertising system used for the method | |

| JP2021108072A (en) | Recommendation system, recommendation method, and program | |

| JP7465302B2 (en) | Information provision system, control method for information provision system, and control program for information provision system | |

| JP2025095300A (en) | Information processing device, information processing method, and information processing program | |

| CN117641290A (en) | A vehicle-mounted social networking method, device and vehicle |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20181101 | |

| A977 | Report on retrieval | Free format text:JAPANESE INTERMEDIATE CODE: A971007 Effective date:20190925 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20191001 | |

| A601 | Written request for extension of time | Free format text:JAPANESE INTERMEDIATE CODE: A601 Effective date:20191122 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20191209 | |

| A02 | Decision of refusal | Free format text:JAPANESE INTERMEDIATE CODE: A02 Effective date:20200214 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20200408 | |

| C60 | Trial request (containing other claim documents, opposition documents) | Free format text:JAPANESE INTERMEDIATE CODE: C60 Effective date:20200408 | |

| A911 | Transfer to examiner for re-examination before appeal (zenchi) | Free format text:JAPANESE INTERMEDIATE CODE: A911 Effective date:20200421 | |

| C21 | Notice of transfer of a case for reconsideration by examiners before appeal proceedings | Free format text:JAPANESE INTERMEDIATE CODE: C21 Effective date:20200428 | |

| A912 | Re-examination (zenchi) completed and case transferred to appeal board | Free format text:JAPANESE INTERMEDIATE CODE: A912 Effective date:20200703 | |

| C211 | Notice of termination of reconsideration by examiners before appeal proceedings | Free format text:JAPANESE INTERMEDIATE CODE: C211 Effective date:20200707 | |

| C22 | Notice of designation (change) of administrative judge | Free format text:JAPANESE INTERMEDIATE CODE: C22 Effective date:20200923 | |

| C13 | Notice of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: C13 Effective date:20201222 | |

| C22 | Notice of designation (change) of administrative judge | Free format text:JAPANESE INTERMEDIATE CODE: C22 Effective date:20210209 | |

| A521 | Request for written amendment filed | Free format text:JAPANESE INTERMEDIATE CODE: A523 Effective date:20210216 | |

| C22 | Notice of designation (change) of administrative judge | Free format text:JAPANESE INTERMEDIATE CODE: C22 Effective date:20210309 | |

| C23 | Notice of termination of proceedings | Free format text:JAPANESE INTERMEDIATE CODE: C23 Effective date:20210330 | |

| C03 | Trial/appeal decision taken | Free format text:JAPANESE INTERMEDIATE CODE: C03 Effective date:20210506 | |

| C30A | Notification sent | Free format text:JAPANESE INTERMEDIATE CODE: C3012 Effective date:20210506 | |

| A61 | First payment of annual fees (during grant procedure) | Free format text:JAPANESE INTERMEDIATE CODE: A61 Effective date:20210527 | |

| R150 | Certificate of patent or registration of utility model | Ref document number:6892220 Country of ref document:JP Free format text:JAPANESE INTERMEDIATE CODE: R150 | |

| R250 | Receipt of annual fees | Free format text:JAPANESE INTERMEDIATE CODE: R250 |