JP2013235523A - Information processing terminal, and method and program of controlling the same - Google Patents

Information processing terminal, and method and program of controlling the sameDownload PDFInfo

- Publication number

- JP2013235523A JP2013235523AJP2012108980AJP2012108980AJP2013235523AJP 2013235523 AJP2013235523 AJP 2013235523AJP 2012108980 AJP2012108980 AJP 2012108980AJP 2012108980 AJP2012108980 AJP 2012108980AJP 2013235523 AJP2013235523 AJP 2013235523A

- Authority

- JP

- Japan

- Prior art keywords

- information processing

- hand

- information

- touch panel

- touch

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Landscapes

- Position Input By Displaying (AREA)

- User Interface Of Digital Computer (AREA)

- Telephone Function (AREA)

Abstract

Translated fromJapaneseDescription

Translated fromJapanese本発明は、情報処理端末、その制御方法、および、その制御プログラムに関し、特に、タッチパネルを備えた情報処理端末、その制御方法、および、その制御プログラムに関する。 The present invention relates to an information processing terminal, a control method thereof, and a control program thereof, and more particularly, to an information processing terminal provided with a touch panel, a control method thereof, and a control program thereof.

従来から、タッチパネルを備えた情報処理端末が多く実用化されている。このような端末に関し、タッチパネルに対する操作についての補正について、種々の提案がなされている。 Conventionally, many information processing terminals equipped with a touch panel have been put into practical use. Regarding such terminals, various proposals have been made regarding corrections for operations on the touch panel.

たとえば、特許文献1(特開2012−14746号公報)には、ポインティングデバイスにおいて検出された操作を、フリックジェスチャとして特定するための技術が開示されている。 For example, Patent Document 1 (Japanese Patent Laid-Open No. 2012-14746) discloses a technique for specifying an operation detected by a pointing device as a flick gesture.

また、特許文献2(特開2010−26710号公報)には、情報処理装置において、ユーザにタッチパネル上で特定の軌跡を描かせるように操作させることにより、特定の情報を表示させる技術が開示されている。 Patent Document 2 (Japanese Patent Application Laid-Open No. 2010-26710) discloses a technology for displaying specific information by causing an information processing apparatus to operate a user to draw a specific locus on a touch panel. ing.

また、特許文献3(特開2003−271314号公報)には、タッチパネルにマークを表示し、当該マークに対する操作位置と当該マークの表示位置との差に基づいて、操作位置を補正する技術が開示されている。 Japanese Patent Laid-Open No. 2003-271314 discloses a technique for displaying a mark on a touch panel and correcting the operation position based on the difference between the operation position for the mark and the display position of the mark. Has been.

携帯電話機やスマートフォンの普及により、情報処理端末を操作する者の幅が広がり、また、操作される場面も広がると考えられる。このことから、ユーザの操作に対して、その状況をより詳細に把握し、当該操作によって入力された情報を、把握された状況に応じて適切な補正をすることが求められる。 With the widespread use of mobile phones and smartphones, the range of people who operate information processing terminals will expand, and the scenes where they will be operated will also expand. For this reason, it is required to grasp the situation in detail with respect to the user's operation and appropriately correct the information input by the operation according to the grasped situation.

特に、近年の携帯端末の小型化により、ユーザは、携帯端末の筐体を片手で把持して操作する場面が多くなってきている。この場合、右手で把持して操作されるときと、左手で把持して操作されるときでは、操作する指の移動する傾向が異なると考えられる。 In particular, due to the recent miniaturization of mobile terminals, there are an increasing number of scenes where the user holds and operates the casing of the mobile terminal with one hand. In this case, it is considered that the tendency of the finger to be operated to move is different between when operated with a right hand and when operated with a left hand.

本発明は、かかる実情に鑑み考え出されたものであり、その目的は、情報処理端末において、操作される手の種類に応じてタッチセンサに対する操作位置の情報を補正することである。 The present invention has been conceived in view of such circumstances, and an object thereof is to correct information on an operation position with respect to a touch sensor in an information processing terminal in accordance with the type of the operated hand.

本発明に従った情報処理端末は、タッチパネルに対する入力に応じて情報処理を実行する情報処理端末であって、タッチパネルに対するタッチ操作の位置情報を検出するための検出手段と、検出手段によって検出された位置情報に基づいて、情報処理に利用する操作情報を生成するための生成手段と、タッチパネルに対する操作を行った手を、右手または左手に特定するための特定手段とを備え、生成手段は、検出手段が検出した位置情報が一定の距離以上継続して移動したタッチ位置の軌跡であることを条件として、検出手段によって検出された位置情報を、特定手段によって特定された手の種類に応じて補正することにより操作情報を生成することを特徴とする。 An information processing terminal according to the present invention is an information processing terminal that performs information processing in response to an input on a touch panel, and is detected by a detection means for detecting position information of a touch operation on the touch panel, and the detection means Based on the position information, the generating means for generating operation information used for information processing, and the specifying means for specifying the hand that has operated the touch panel as the right hand or the left hand, the generating means detects The position information detected by the detecting means is corrected according to the type of the hand specified by the specifying means on the condition that the position information detected by the means is a locus of the touch position that has continuously moved for a certain distance or more. Thus, the operation information is generated.

好ましくは、生成手段は、特定手段によって特定された手の種類が右手であったときには、タッチパネルにおける位置情報を第1の向きに回転移動させて情報処理に利用する操作情報を生成し、特定手段によって特定された手の種類が左手であったときには、タッチパネルにおける位置情報を第1の向きとは逆の第2の向きに回転移動させて情報処理に利用する操作情報を生成する。 Preferably, when the type of the hand specified by the specifying unit is the right hand, the generating unit generates operation information used for information processing by rotating the position information on the touch panel in the first direction, and the specifying unit When the type of the hand specified by the left hand is the left hand, position information on the touch panel is rotated in a second direction opposite to the first direction to generate operation information used for information processing.

好ましくは、情報処理端末は、情報処理端末の外郭を覆う筐体をさらに備え、タッチパネルは、筐体の特定の面に設けられ、情報処理端末は、筐体の、特定の面の一方側に設けられた第1の感圧センサ、および、特定の面の他方側に設けられた第2の感圧センサをさらに備え、特定手段は、第1の感圧センサと第2の感圧センサの検出出力に基づいて、タッチパネルに対する操作を行った手を特定する。 Preferably, the information processing terminal further includes a housing that covers an outline of the information processing terminal, the touch panel is provided on a specific surface of the housing, and the information processing terminal is provided on one side of the specific surface of the housing. A first pressure sensor provided; and a second pressure sensor provided on the other side of the specific surface, wherein the specifying means includes a first pressure sensor and a second pressure sensor. Based on the detection output, the hand that has operated the touch panel is specified.

本発明に従った情報処理端末の制御方法は、タッチパネルに対する入力に応じて情報処理を実行する情報処理端末のコンピュータが実行する、当該情報処理端末の制御方法であって、タッチパネルに対するタッチ操作の位置情報を検出するステップと、位置情報に基づいて、情報処理に利用する操作情報を生成するステップと、タッチパネルに対する操作を行った手を、右手または左手に特定するステップとを備え、操作情報を生成するステップは、位置情報が一定の距離以上継続してタッチ位置が移動した軌跡であることを条件として、位置情報を特定された手の種類に応じて補正することにより操作情報を生成することを特徴とする。 A method for controlling an information processing terminal according to the present invention is a method for controlling an information processing terminal executed by a computer of the information processing terminal that performs information processing in response to an input to the touch panel. An operation information is generated, including a step of detecting information, a step of generating operation information used for information processing based on position information, and a step of specifying a hand that has operated the touch panel as a right hand or a left hand. The step of generating the operation information by correcting the position information according to the type of the specified hand on the condition that the position information is a locus in which the touch position has moved continuously for a certain distance or more. Features.

本発明に従った情報処理端末の制御プログラムは、タッチパネルに対する入力に応じて情報処理を実行する情報処理端末のコンピュータによって実行される、当該情報処理端末の制御プログラムであって、制御プログラムは、コンピュータに、タッチパネルに対するタッチ操作の位置情報を検出するステップと、位置情報に基づいて、情報処理に利用する操作情報を生成するステップと、タッチパネルに対する操作を行った手を、右手または左手に特定するステップとを実行させ、操作情報を生成するステップは、位置情報が一定の距離以上継続してタッチ位置が移動した軌跡であることを条件として、位置情報を特定された手の種類に応じて補正することにより操作情報を生成することを特徴とする。 A control program for an information processing terminal according to the present invention is a control program for an information processing terminal that is executed by a computer of the information processing terminal that executes information processing in response to an input to the touch panel. A step of detecting position information of a touch operation on the touch panel; a step of generating operation information used for information processing based on the position information; and a step of specifying a hand that has performed an operation on the touch panel as a right hand or a left hand And the step of generating operation information corrects the position information according to the type of the specified hand on the condition that the position information is a locus that the touch position has moved continuously for a certain distance or more. Thus, the operation information is generated.

本発明によれば、タッチパネルに対する操作を行った手が右手か左手かが特定され、タッチパネルにおける操作位置が当該特定の結果に応じて補正されて、情報処理に利用される。 According to the present invention, whether the right hand or the left hand is operated with respect to the touch panel is specified, the operation position on the touch panel is corrected according to the specific result, and used for information processing.

したがって、タッチパネルに対する入力が、操作される手の種類に応じて補正されて、情報処理に利用される。 Therefore, the input to the touch panel is corrected according to the type of the operated hand and used for information processing.

以下、本発明の情報処理端末についての実施の形態を、図面を参照して説明する。なお、以下の説明において、同一の機能および作用を有する要素については、同じ各図を通して同じ符号を付し、重複する説明を繰返さない。 Hereinafter, an embodiment of an information processing terminal according to the present invention will be described with reference to the drawings. In the following description, elements having the same function and action are denoted by the same reference numerals throughout the same drawings, and redundant description will not be repeated.

<外観>

図1は、本発明の情報処理端末の一実施の形態である携帯電話機100の斜視図である。<Appearance>

FIG. 1 is a perspective view of a

図1を参照して、携帯電話機100は、主表面を有する筐体110と、筐体110の主表面のほぼ全面に配置されたタッチパネル116と、筐体110の主表面におけるタッチパネル116の上側及び下側にそれぞれ配置されたスピーカ112及びマイクロフォン114とを含む。 Referring to FIG. 1,

タッチパネル116は、積層された液晶表示装置(LCD)118とタッチセンサ119とからなる、表示装置一体型タッチパネルである全画面液晶タッチパネルである。タッチパネル116は、一部に指が接触することにより位置が指定されると、指定された箇所を示す、所定の座標系における座標情報を出力し、指の接触がなくなると、すなわち指定が解除されると座標情報の出力を停止する機能を有する。 The

スピーカ112が上方(天)に、マイクロフォン114が下方(地)に位置するようにしてタッチパネル116を正面から見たときの筐体110の右側面には、筐体110を保持する利用者の指による圧力分布を面状の領域で検知し、2値化された画像の形で出力するシート状の右側感圧センサ120Rが設けられており、反対側の側面(左側面)にも、同様の左側感圧センサ120Lが設けられている。 When the

<ハードウェア構成>

図2は、携帯電話機100のハードウェア構成を模式的に示すブロック図である。<Hardware configuration>

FIG. 2 is a block diagram schematically showing a hardware configuration of the

図2を参照して、携帯電話機100は、スピーカ112、マイクロフォン114、タッチパネル116(LCD118及びタッチセンサ119)、並びに右側感圧センサ120R及び左側感圧センサ120Lに加え、アンテナ180と、リンガ186と、メモリ188と、制御回路182とを含む。 Referring to FIG. 2,

メモリ188は、不揮発性のメモリであり、そして、携帯電話機100の初期設定値を記憶し、また、種々のアプリケーションを実現するためのプログラムや持ち方判定プログラムなどの所要のプログラムを記憶する。 The

メモリ188は、筐体110に固定された記憶装置、または、筐体110に対して着脱可能な記憶媒体によって、実現される。このような記憶媒体としては、CD−ROM(Compact Disk - Read Only Memory)、DVD−ROM(Digital Versatile Disk - Read Only Memory)、USB(Universal Serial Bus)メモリ、メモリカード、FD(Flexible Disk)、ハードディスク、磁気テープ、カセットテープ、MO(Magnetic Optical Disk)、MD(Mini Disk)、IC(Integrated Circuit)カード(メモリカードを除く)、光カード、マスクROM、EPROM、EEPROM(Electronically Erasable Programmable Read Only Memory)などの、不揮発的にプログラムを格納する媒体が挙げられる。 The

制御回路182は、スピーカ112、マイクロフォン114、タッチパネル116、アンテナ180、リンガ186及びメモリ188を用い、携帯電話機としての機能と、利用者による携帯電話機100の持ち方を判定し、判定結果に対応した態様でタッチパネル116に対する操作を補正する機能と、その他種々の機能とを実現させる。 The

制御回路182は、アンテナ180を介して基地局から受信した信号に基づき、別の拠点にあるほかの携帯通信端末からの着信の有無を検出して着信検出信号を出力するための着信信号検出部208と、所定の制御信号に応答して、アンテナ180を介した通信回線のオン/オフを制御するための回線閉結部206と、回線閉結部206及びアンテナ180を介して基地局との間で授受する信号の強さの制御を行なうためのRF(Radio Frequency)処理部204と、基地局との安全な信号の授受を行なうために、RF処理部204に与える信号及びRF処理部204を介して受ける信号に所定の信号処理を施すためのベースバンド処理部202と、DA(Digital-Audio)コンバータ及びAD(Audio -Digital)コンバータを有する。 The

そして、制御回路182は、マイクロフォン114及びスピーカ112を介した音声の入出力を行なうためのオーディオインタフェース(オーディオI/F)200と、オーディオI/F200、ベースバンド処理部202、RF処理部204、及び回線閉結部206、タッチパネル116、リンガ186を制御することにより、ユーザからの要求に応じて電話の呼を発信したり、着呼を処理したりして、ユーザと他の携帯通信端末との間の音声通信を行なったり、文字通信を行なったり、ユーザの入力する文字列に対する処理を行なったりするための通信制御部250とを含む。 The

通信制御部250は、実質的にはCPU(中央演算処理装置)とソフトウェアとからなる。ソフトウェアは本実施の形態ではメモリ188に記憶されていて、適宜、通信制御部250に読出され、実行される。本実施の形態では、詳細は説明しないが、メモリ188の内容を書き換えることが可能であり、それによって携帯電話機100による種々の機能のアップグレード及び追加を行なうことができる。 The

また、通信制御部250は、その機能として、入力情報処理部251と、出力情報処理部252と、アプリ処理部253と、手特定部254とを含む。 In addition, the

手特定部254は、右側感圧センサ120Rおよび左側感圧センサ120Lの検出出力に基づいて、タッチセンサ119に対する操作が右手によってなされたか左手によってなされたかを特定する。手特定部254は、たとえば、上記CPUが持ち方判定プログラムを実行することにより、実現される。 The

入力情報処理部251は、タッチセンサ119から入力されたタッチ位置についての検出出力を、手特定部254による特定の結果に基づいて補正して、アプリ処理部253へ送る。入力情報処理部251は、たとえば、上記CPUが、タッチセンサ119のドライバプログラム(メモリ188等に格納)を実行することにより、実現される。 The input

アプリ処理部253は、アプリケーションを実行するための処理を実行する。アプリ処理部253は、入力情報処理部251を介してタッチセンサ119からの入力を受信し、当該入力に基づいて、アプリケーションを実行する。これにより、入力情報処理部251においてタッチセンサ119からの入力が補正された場合には、アプリ処理部253は、当該補正後の入力に基づいて、アプリケーションを実行する。アプリ処理部253は、たとえば、上記CPUがアプリケーションプログラムを実行することによって、実現される。 The

出力情報処理部252は、アプリ処理部253の演算結果に基づいて、LCD118に対して出力する表示情報を生成し、LCD118へ出力する。出力情報処理部252は、たとえば、上記CPUが、LCD118のドライバプログラムを実行することにより、実現される。 The output

<判定の原理>

本実施の形態では、利用者が携帯電話機100を右手で操作しているか、左手で操作しているかを、右側感圧センサ120R及び左側感圧センサ120Lの出力を用いたパターンマッチングにより判定する。以下、代表的なパターンについて説明する。<Principle of judgment>

In the present embodiment, whether the user is operating

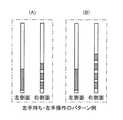

図3は、片手持ちの場合に特徴的な右側感圧センサ120R及び左側感圧センサ120Lの出力パターンの一例を示す図である。 FIG. 3 is a diagram illustrating an example of output patterns of the right-

図3の(A)に示す携帯電話機100を、図3の(B)に示すように左手で保持した場合、典型的には、図3の(B)に示されるように、左側感圧センサ120Lには手との接触領域240が、右側感圧センサ120Rには手との接触領域242が、それぞれ生じる。図3の(B)に示されるケースでは、左側面は左手の親指の腹の部分と、親指の付け根の部分との2箇所で左側感圧センサ120Lに接触している。その結果、図3の(C)に示されるように、左側感圧センサ120Lからは二つの接触領域画像262及び260が得られる。右側面では、指3本が右側感圧センサ120Rに接触しているものとすると、三つの接触領域画像264,266及び268が得られる。 When the

一方、図3の(D)に示されるように、右手で携帯電話機100を保持すると、左手の場合と丁度逆の状態となる。 On the other hand, as shown in FIG. 3D, when the

すなわち、左側感圧センサ120Lには手との接触領域270が、右側感圧センサ120Rには手との接触領域272が、それぞれ生じる。図3の(D)に示されるケースでは、左側面は左手の中指、薬指、及び小指の3箇所で左側感圧センサ120Lに接触している。その結果、図3の(E)に示されるように、左側感圧センサ120Lからは三つの接触領域画像280、282及び284が得られる。右側面では、右手の親指の腹の部分と親指の付け根の部分とが右側感圧センサ120Rに接触している。したがって、二つの接触領域画像286及び288が得られる。 That is, the

もちろん、携帯電話機100の筐体の大小と手の大小との関係により、例えば図3の(C)の場合に、右側感圧センサ120Rと左手の人差し指から小指の全ての指が接触し、これにより、四つの接触領域画像が得られることもあり得る。右手の場合も同様である。 Of course, due to the relationship between the size of the housing of the

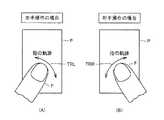

また、単に携帯電話機100を保持しているだけでなく、保持している手の親指で、タッチパネル116をタッチすることで入力を行なおうとしている場合には、右側感圧センサ120R、左側感圧センサ120Lの出力は次のようになる。図4は、筐体110を保持した手の親指でタッチパネル116が操作される場合の感圧センサの検出出力の例を説明するための図である。 Further, when not only holding the

図4の(A)と(B)のそれぞれには、左手は単に携帯電話機100を保持しているだけで、右手で操作を行なおうとしているときの、左手と携帯電話機100との間の関係、並びに左側感圧センサ120L及び右側感圧センサ120Rの出力との関係が示されている。 In each of FIGS. 4A and 4B, the left hand simply holds the

図4の(C)と(D)のそれぞれには、左手で携帯電話機100を保持しながら、左手の親指を使って操作を行なおうとしているときの、左手と携帯電話機100との間の関係が示されている。 Each of (C) and (D) in FIG. 4 shows a gap between the left hand and the

図4の(A)及び(B)は、図3の(B)及び(C)とそれぞれ同一である。一方、図4の(C)では、図4の(A)と異なり、携帯電話機100の左側面は、左手の親指の付け根の領域300のみと接しており、親指とは接していない。その結果、図4の(D)に示すように、左側面からは一つの接触領域画像310のみが出力される。 4A and 4B are the same as FIGS. 3B and 3C, respectively. On the other hand, in FIG. 4C, unlike FIG. 4A, the left side surface of the

一方、右手領域は図4の(A)と同様、領域302で3本の指と接触している。したがって右側感圧センサ120Rからは、三つの接触領域画像312,314,316(又は四つの接触領域画像)が出力される。 On the other hand, the right hand region is in contact with three fingers in the

右手でも同様の関係が得られる。したがって、図4の(B)のような出力が得られたときは携帯電話機100は左手で保持されており、操作は右手で行なわれると判定できる。図4の(D)のような出力が得られたときは携帯電話機100は左手で保持されており、操作も左手で行なわれると判定できる。右手の場合にはこれと対称な出力によって同様の判定ができる。 A similar relationship can be obtained with the right hand. Therefore, when the output as shown in FIG. 4B is obtained, it can be determined that the

実際には、携帯電話機100の保持の仕方には人により微妙な違いが生じるので、本実施の形態では上記したような規則による判定ではなく、多数の出力例を集めてテンプレート化しておき、実際に得られた出力画像と、テンプレートとをマッチングすることにより、最も可能性の高い保持の仕方を判定することが好ましい。 Actually, there are subtle differences in how the

なお、携帯電話機での判定であるため、マッチングに多くの計算コストをかけることは好ましくない。そこで本実施の形態では、例えば出力画像の中心線上の画素値のみをサンプルとし、同様の形で予め作成しておいたテンプレートとの間でマッチングする。マッチングには、例えばDP(Dynamic Programming)マッチングを用いる。予め適切なしきい値を定めておき、テンプレートと出力画像との間のDPマッチングにより得られたDP距離が最も小さく、かつその距離がしきい値以下のテンプレートが存在している場合のみ、そのテンプレートにより定められる保持及び入力の仕方を採用し、それ以外の場合には両手操作と判定する。なお、右側感圧センサ120Rから得られた画像と左側感圧センサ120Lから得られた画像とをそれぞれ独立にテンプレート内の右手側テンプレート及び左手側テンプレートとDPマッチングし、得られたDP距離の合計値を各テンプレートと得られたデータとの間のDP距離とする。 In addition, since it is determination by a mobile phone, it is not preferable to spend much calculation cost for matching. Therefore, in the present embodiment, for example, only the pixel value on the center line of the output image is used as a sample, and matching is performed with a template created in advance in the same manner. For the matching, for example, DP (Dynamic Programming) matching is used. An appropriate threshold is set in advance, and only when there is a template with the shortest DP distance obtained by DP matching between the template and the output image and the distance is equal to or less than the threshold The method of holding and inputting determined by the above is adopted, and in other cases, it is determined that the operation is a two-handed operation. It should be noted that the image obtained from the

図5〜図8は、テンプレートに対応するセンサ出力のパターン例を示す図である。

図5の(A)及び(B)に示されているのは、いずれも左手で携帯電話機100を保持し、右手で操作する場合のパターン例である。5 to 8 are diagrams showing examples of sensor output patterns corresponding to templates.

FIG. 5A and FIG. 5B show pattern examples when the

図6の(A)及び(B)に示されているのは、いずれも左手で携帯電話機100を保持し、左手で操作する場合のパターン例である。 6A and 6B show pattern examples in the case where the

図7の(A)及び(B)に示されているのは、いずれも右手で携帯電話機100を保持し、左手で操作する場合のパターン例である。 FIGS. 7A and 7B show pattern examples when the

図8の(A)及び(B)に示されているのは、いずれも右手で携帯電話機100を保持し、右手で操作する場合のパターン例である。 FIGS. 8A and 8B show pattern examples when the

本実施の形態では、右手用のパターンも左手用のパターンとは別に用意(つまり、参照用データとしてメモリ188等に格納)されている。ただし、右手用のパターンは、左手用のパターンを左右反転したものを用いればよく、したがって、最低限、右手用または左手用のいずれかのパターンが用意されていればよい。 In the present embodiment, the right-hand pattern is also prepared separately from the left-hand pattern (that is, stored in the

<操作の軌跡の傾向>

図9は、タッチセンサ119を操作するユーザの手の種類と操作における軌跡の傾向の関係を説明するための図である。<Trends in operation trajectory>

FIG. 9 is a diagram for explaining the relationship between the type of the hand of the user operating the

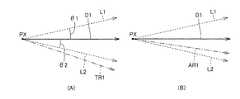

図9の(A)には、タッチセンサ119(パネルP)が左手の指Fで操作される際の軌跡TRLが示されている。この場合、ユーザが指Fを水平方向に移動させようとしても、操作する手(左手)と筐体110との位置関係から、軌跡TRLとして示されているように、左上から右下に移動するような弧を描く。 9A shows a trajectory TRL when the touch sensor 119 (panel P) is operated with the finger F of the left hand. In this case, even if the user tries to move the finger F in the horizontal direction, the user moves from the upper left to the lower right from the positional relationship between the operating hand (left hand) and the

図9の(B)には、タッチセンサ119(パネルP)が右手の指Fで操作される際の軌跡TRRが示されている。この場合、ユーザが指Fを水平方向に移動させようとしても、操作する手(右手)と筐体110との位置関係から、軌跡TRLとして示されているように、左下から右上に移動するような弧を描く。 FIG. 9B shows a trajectory TRR when the touch sensor 119 (panel P) is operated with the finger F of the right hand. In this case, even if the user tries to move the finger F in the horizontal direction, the user moves from the lower left to the upper right as shown by the trajectory TRL from the positional relationship between the operating hand (right hand) and the

<補正の概要>

アプリ処理部253は、タッチセンサ119においてタッチ操作がなされた位置の座標を取得することにより、ユーザからの入力内容を特定し、当該入力内容に応じてアプリケーションを実行する。たとえば、タッチセンサ119に対してなされた入力内容がフリック操作であると特定すると、起動中のアプリケーションにおいてページめくり等の処理を実行する。<Outline of correction>

The

図10は、タッチセンサ119に対する操作位置に対する補正の態様を説明するための図である。 FIG. 10 is a diagram for explaining how to correct the operation position with respect to the

本実施の形態では、入力情報処理部251は、タッチセンサ119から出力された操作位置の座標を変換する。 In the present embodiment, the input

(左手による操作についての補正)

図10の(A)には、左手で操作される際の座標の変換が示されている。具体的には、図10の(A)では、変換前のx軸が軸A01で示され、変換前のy軸が軸A02で示されている。また、図10の(A)では、変換後のx軸が軸A11で示され、変換前のy軸が軸A12で示されている。(Correction for left hand operation)

FIG. 10A shows the conversion of coordinates when operated with the left hand. Specifically, in FIG. 10A, the x-axis before conversion is indicated by an axis A01, and the y-axis before conversion is indicated by an axis A02. In FIG. 10A, the converted x-axis is indicated by an axis A11, and the unconverted y-axis is indicated by an axis A12.

軸A11は、軸A01が、矢印R11で示される角度だけ時計方向に回転した軸に相当する。軸A12は、軸A02が、矢印R12で示される角度だけ時計方向に回転した軸に相当する。軸A01,軸A02は、LCD118における表示に利用される軸である。本実施の形態では、タッチセンサ119が左手で操作されたと特定されたときには、タッチパネル116のLCD118における表示の軸に対して、タッチセンサ119に対する操作の位置を特定する座標を特定するための軸を時計方向に回転させる。ここでの「回転」は、180度未満の回転角度での回転を意味する。 The axis A11 corresponds to the axis that the axis A01 is rotated clockwise by the angle indicated by the arrow R11. The axis A12 corresponds to the axis that the axis A02 is rotated clockwise by the angle indicated by the arrow R12. The axes A01 and A02 are axes used for display on the

これにより、ユーザが指Fをタッチセンサ119上の水平方向に移動させようとして、矢印B11で示されるようにその軌道の方向が水平方向からずれてしまったり、また、ユーザが指Fをタッチセンサ119上の垂直方向に移動させようとして、矢印B12で示されるようにその軌道の方向が垂直方向からずれてしまったりした場合でも、ユーザの意図を反映させるように、タッチセンサ119の検出出力を補正できる。 As a result, the user tries to move the finger F in the horizontal direction on the

より具体的には、点P01から点P02へユーザのタッチ位置が移動した場合、始点である点P01の座標は、(x01,y01)から(X01,Y01)へと変換される。また、終点である点P02の座標は、(x02,y02)から(X02,Y02)へと変換される。 More specifically, when the user's touch position moves from the point P01 to the point P02, the coordinates of the starting point P01 are converted from (x01, y01) to (X01, Y01). Also, the coordinates of the end point P02 are converted from (x02, y02) to (X02, Y02).

変換におけるx軸とy軸のそれぞれの回転角度をθとする。つまり、軸A01から軸A11の回転角度がθ、軸A02から軸A12の回転角度がθとする。この場合、(x01,y01)と(X01,Y01)は、以下の式(1)および式(2)で示される関係を有する。 Each rotation angle of the x-axis and the y-axis in the conversion is θ. That is, the rotation angle from the axis A01 to the axis A11 is θ, and the rotation angle from the axis A02 to the axis A12 is θ. In this case, (x01, y01) and (X01, Y01) have a relationship represented by the following expressions (1) and (2).

X01=x01・cosθ−y01・sinθ …(1)

Y01=x01・sinθ+y01・cosθ …(2)

(右手による操作ついての補正)

図10の(B)には、右手で操作される際の座標の変換が示されている。具体的には、図10の(B)では、変換前のx軸が軸A01で示され、変換前のy軸が軸A02で示されている。また、図10の(B)では、変換後のx軸が軸A21で示され、変換前のy軸が軸A22で示されている。X01 = x01 · cos θ−y01 · sin θ (1)

Y01 = x01 · sin θ + y01 · cos θ (2)

(Correction for operation with right hand)

FIG. 10B shows the conversion of coordinates when operated with the right hand. Specifically, in FIG. 10B, the x-axis before conversion is indicated by an axis A01, and the y-axis before conversion is indicated by an axis A02. In FIG. 10B, the converted x-axis is indicated by an axis A21, and the unconverted y-axis is indicated by an axis A22.

軸A21は、軸A01が、矢印R21で示される角度だけ反時計方向に回転した軸に相当する。軸A22は、軸A02が、矢印R22で示される角度だけ反時計方向に回転した軸に相当する。軸A01,軸A02は、LCD118における表示に利用される軸である。本実施の形態では、タッチセンサ119が右手で操作されたと特定されたときには、タッチパネル116のLCD118における表示の軸に対して、タッチセンサ119に対する操作の位置を特定する座標を特定するための軸を反時計方向に回転させる。ここでの「回転」は、180度未満の回転角度での回転を意味する。 The axis A21 corresponds to the axis that the axis A01 has rotated counterclockwise by the angle indicated by the arrow R21. The axis A22 corresponds to the axis that the axis A02 has rotated counterclockwise by the angle indicated by the arrow R22. The axes A01 and A02 are axes used for display on the

これにより、ユーザが指Fをタッチセンサ119上の水平方向に移動させようとして、矢印B21で示されるようにその軌道の方向が水平方向からずれてしまったり、また、ユーザが指Fをタッチセンサ119上の垂直方向に移動させようとして、矢印B22で示されるようにその軌道の方向が垂直方向からずれてしまったりした場合でも、ユーザの意図を反映させるように、タッチセンサ119の検出出力を補正できる。 As a result, the user tries to move the finger F in the horizontal direction on the

より具体的には、点P11から点P12へユーザのタッチ位置が移動した場合、始点である点P11の座標は、(x11,y11)から(X11,Y11)へと変換される。また、終点である点P02の座標は、(x12,y12)から(X12,Y12)へと変換される。 More specifically, when the user's touch position moves from the point P11 to the point P12, the coordinates of the starting point P11 are converted from (x11, y11) to (X11, Y11). In addition, the coordinates of the end point P02 are converted from (x12, y12) to (X12, Y12).

変換におけるx軸とy軸のそれぞれの回転角度をθとする。つまり、軸A01から軸A11の回転角度がθ、軸A02から軸A12の回転角度がθとする。この場合、(x11,y11)と(X11,Y11)は、以下の式(3)および式(4)で示される関係を有する。 Each rotation angle of the x-axis and the y-axis in the conversion is θ. That is, the rotation angle from the axis A01 to the axis A11 is θ, and the rotation angle from the axis A02 to the axis A12 is θ. In this case, (x11, y11) and (X11, Y11) have a relationship represented by the following expressions (3) and (4).

X11=x11・cosθ+y11・sinθ…(3)

Y11=−x11・sinθ+y11・cosθ…(4)

<タッチ位置補正処理>

図11は、入力情報処理部251によって実行される、タッチセンサ119におけるタッチ位置を補正するための処理(タッチ位置補正処理)のフローチャートである。X11 = x11 · cos θ + y11 · sin θ (3)

Y11 = −x11 · sin θ + y11 · cos θ (4)

<Touch position correction processing>

FIG. 11 is a flowchart of processing (touch position correction processing) for correcting the touch position in the

図11を参照して、入力情報処理部251は、ステップS10で、タッチセンサ119におけるタッチ操作が検出されたことを条件として、ステップS20へ処理を進める。たとえばタッチセンサ119からタッチ位置を受信すると、入力情報処理部251は、ステップS20へ処理を進める。 Referring to FIG. 11, input

ステップS20では、入力情報処理部251は、タッチ位置が軌跡を構成するものであるか否かを判断し、そうであると判断するとステップS30へ処理を進め、そうではないと判断するとステップS60へ処理を進める。この場合、ステップS60では、入力情報処理部251は、タッチセンサ119から受信した操作位置を、そのままアプリ処理部253へ送る。 In step S20, the input

なお、ステップS20では、具体的には、たとえば、ステップS10でタッチセンサ119から受信したタッチ位置が、一定の距離以上の軌道を構成するタッチ操作か否かが判断される。つまり、たとえば、入力情報処理部251は、ステップS20において、特定の時間、タッチセンサ119から連続的にタッチ位置の情報を受信し、その期間において受信したタッチ位置の軌跡が一定の距離以上継続して移動する軌跡であるか否かを判断する。 In step S20, specifically, for example, it is determined whether or not the touch position received from the

ステップS30では、入力情報処理部251は、手特定部254に対して、タッチセンサ119を操作している手の特定を依頼し、その結果を手特定部254から受信する。手特定部254は、たとえば図3〜図8を参照して説明したように、タッチセンサ119を操作している手が右手であるか左手であるかを特定する。 In step S <b> 30, the input

入力情報処理部251は、手特定部254から受信した情報に基づき、操作している手が右手であると判断するとステップS40へ処理を進め、左手であると判断するとステップS50へ処理を進める。 Based on the information received from the

ステップS40では、入力情報処理部251は、図10の(B)を参照して説明したようにタッチセンサ119から受信したタッチ位置の軌道を補正して(右手座標補正)、ステップS60へ処理を進める。なお、図10の(B)を参照した説明では、軌道の始点と終点のみが変換されたが、ステップS40では、軌道を構成するすべての点が変換され得る。 In step S40, the input

ステップS50では、入力情報処理部251は、図10の(A)を参照して説明したようにタッチセンサ119から受信したタッチ位置の軌道を補正して(左手座標補正)、ステップS60へ処理を進める。なお、図10の(A)を参照した説明では、軌道の始点と終点のみが変換されたが、ステップS50では、軌道を構成するすべての点が変換され得る。 In step S50, the input

ステップS60では、入力情報処理部251は、アプリ処理部253へ、タッチセンサ119に対するタッチ位置の情報を出力する。なお、ステップS40またはステップS50においてタッチ位置の軌道を補正した場合には、入力情報処理部251は、補正後の軌道の座標情報を、アプリ処理部253へ出力する。 In step S <b> 60, the input

ステップS60でアプリ処理部253へタッチ位置を出力すると、入力情報処理部251はタッチ位置補正処理を終了し、次のタッチ操作に備える。 When the touch position is output to the

<実施の形態の効果等>

以上説明した本実施の形態では、タッチセンサ119に対する操作がユーザの右手でなされたのか左手でなされたのかが、右側感圧センサ120Rと左側感圧センサ120Lの検出出力に基づいて特定される。そして、当該特定の結果に応じて、つまり、右手用または左手用のそれぞれの態様で、タッチセンサ119に対するタッチ操作の位置の座標が補正される。<Effects of the embodiment>

In the present embodiment described above, whether the operation on the

これにより、タッチセンサ119とユーザの手の位置関係によって、タッチ位置の移動の軌道が、ユーザが意図しているものとは異なった場合であっても、ユーザの意図に沿うように、当該軌道が補正される。 As a result, even if the trajectory of the movement of the touch position is different from that intended by the user due to the positional relationship between the

具体的には、たとえば図12の(A)に示されるように、水平方向D1に対して、始点PXからのフリック操作の方向が、上方の角度θ1から下方の角度θ2までの範囲(矢印L1から矢印L2で示される範囲)内であれば当該水平方向D1のフリック操作とみなされるように或るアプリケーションが作りこまれている場合を考える。 Specifically, for example, as shown in FIG. 12A, the direction of the flick operation from the starting point PX with respect to the horizontal direction D1 is within a range from the upper angle θ1 to the lower angle θ2 (arrow L1). Let us consider a case where an application is built so that it is regarded as a flick operation in the horizontal direction D1 within the range indicated by the arrow L2.

この場合、ユーザが左手でフリック操作を行ったため、操作の軌跡が矢印TR1に示されるように右下がりになってしまうと、上記範囲内の操作とはみなされず、当該アプリケーションでは水平方向のフリック操作が行われたとはみなされない。 In this case, since the user performed the flick operation with the left hand, if the operation trajectory falls to the right as indicated by the arrow TR1, the operation is not regarded as an operation within the above range, and the application performs a horizontal flick operation. Is not considered to have occurred.

一方、本実施の形態では、矢印TR1の軌跡は、図10の(A)を参照して説明したように補正されて、図12の(B)における矢印AR1へと補正される。 On the other hand, in the present embodiment, the trajectory of the arrow TR1 is corrected as described with reference to FIG. 10A, and is corrected to the arrow AR1 in FIG.

これにより、上記操作は、上記範囲内の操作とみなされ、上記アプリケーションでは水平方向のフリック操作が行われたとみなされる。 Thus, the operation is regarded as an operation within the range, and the application is regarded as performing a horizontal flick operation.

なお、本実施の形態では、タッチ位置の補正は、軌道を描いたときにのみ行われ、所定のポイントに対するタッチ操作に対しては行われないことが好ましい。後者の場合、手とタッチパネル116との位置関係による操作位置のずれは生じにくいと考えられるからである。 In the present embodiment, it is preferable that the correction of the touch position is performed only when a trajectory is drawn, and is not performed for a touch operation on a predetermined point. This is because in the latter case, it is considered that a shift in the operation position due to the positional relationship between the hand and the

また、本実施の形態では、情報処理端末の一例として通話機能を有する携帯電話機が例示されたが、情報処理端末は、通話機能や通信機能を備えている必要は無い。情報処理端末は、少なくとも、タッチパネルを有し、当該タッチパネルに対するタッチ操作に応じて情報処理が実行される端末であれば良い。 In this embodiment, a mobile phone having a call function is exemplified as an example of the information processing terminal. However, the information processing terminal does not need to have a call function or a communication function. The information processing terminal may be at least a terminal that has a touch panel and that performs information processing in response to a touch operation on the touch panel.

今回開示された実施の形態およびその変形例はすべての点で例示であって制限的なものではないと考えられるべきである。本発明の範囲は上記した説明ではなくて特許請求の範囲によって示され、特許請求の範囲と均等の意味および範囲内でのすべての変更が含まれることが意図される。実施の形態およびその変形例において開示された技術は、可能な限り単独でも組み合わせても実施され得ることが意図される。 It should be thought that embodiment disclosed this time and its modification are illustrations in all the points, and are not restrictive. The scope of the present invention is defined by the terms of the claims, rather than the description above, and is intended to include any modifications within the scope and meaning equivalent to the terms of the claims. It is intended that the techniques disclosed in the embodiments and the modifications thereof can be implemented alone or in combination as much as possible.

100 携帯電話機、110 筐体、112 スピーカ、114 マイクロフォン、116 タッチパネル、119 タッチセンサ、120L 左側感圧センサ、120R 右側感圧センサ、180 アンテナ、182 制御回路、186 リンガ、188 メモリ、202 ベースバンド処理部、204 処理部、206 回線閉結部、208 着信信号検出部、250 通信制御部、251 入力情報処理部、252 出力情報処理部、253 アプリ処理部、254 手特定部。 100 mobile phone, 110 housing, 112 speaker, 114 microphone, 116 touch panel, 119 touch sensor, 120L left pressure sensor, 120R right pressure sensor, 180 antenna, 182 control circuit, 186 ringer, 188 memory, 202 baseband processing , 204 processing unit, 206 line closing unit, 208 incoming signal detection unit, 250 communication control unit, 251 input information processing unit, 252 output information processing unit, 253 application processing unit, 254 hand specifying unit.

Claims (5)

Translated fromJapanese前記タッチパネルに対するタッチ操作の位置情報を検出するための検出手段と、

前記検出手段によって検出された位置情報に基づいて、前記情報処理に利用する操作情報を生成するための生成手段と、

前記タッチパネルに対する操作を行った手を、右手または左手に特定するための特定手段とを備え、

前記生成手段は、前記検出手段が検出した位置情報が一定の距離以上継続して移動したタッチ位置の軌跡であることを条件として、前記検出手段によって検出された位置情報を、前記特定手段によって特定された手の種類に応じて補正することにより前記操作情報を生成する、情報処理端末。An information processing terminal that executes information processing in response to an input on a touch panel,

Detecting means for detecting position information of a touch operation on the touch panel;

Generation means for generating operation information used for the information processing based on the position information detected by the detection means;

A specifying unit for specifying a hand that has performed an operation on the touch panel as a right hand or a left hand;

The generating means specifies the position information detected by the detecting means by the specifying means on the condition that the position information detected by the detecting means is a locus of a touch position that has moved continuously for a certain distance or more. An information processing terminal that generates the operation information by correcting according to the type of the hand that has been made.

前記特定手段によって特定された手の種類が右手であったときには、前記タッチパネルにおける前記位置情報を第1の向きに回転移動させて前記情報処理に利用する操作情報を生成し、

前記特定手段によって特定された手の種類が左手であったときには、前記タッチパネルにおける前記位置情報を第1の向きとは逆の第2の向きに回転移動させて前記情報処理に利用する操作情報を生成する、請求項1に記載の情報処理端末。The generating means includes

When the type of the hand specified by the specifying unit is a right hand, the operation information used for the information processing is generated by rotating the position information on the touch panel in a first direction,

When the type of the hand specified by the specifying means is a left hand, operation information used for the information processing by rotating the position information on the touch panel in a second direction opposite to the first direction is used. The information processing terminal according to claim 1, which is generated.

前記タッチパネルは、前記筺体の特定の面に設けられ、

前記情報処理端末は、前記筺体の、前記特定の面の一方側に設けられた第1の感圧センサ、および、前記特定の面の他方側に設けられた第2の感圧センサをさらに備え、

前記特定手段は、前記第1の感圧センサと前記第2の感圧センサの検出出力に基づいて、前記タッチパネルに対する操作を行った手を特定する、請求項1または請求項2に記載の情報処理端末。The information processing terminal further includes a housing that covers an outline of the information processing terminal,

The touch panel is provided on a specific surface of the casing,

The information processing terminal further includes a first pressure sensor provided on one side of the specific surface of the casing and a second pressure sensor provided on the other side of the specific surface. ,

The information according to claim 1 or 2, wherein the specifying unit specifies a hand that has performed an operation on the touch panel based on detection outputs of the first pressure sensor and the second pressure sensor. Processing terminal.

前記タッチパネルに対するタッチ操作の位置情報を検出するステップと、

前記位置情報に基づいて、前記情報処理に利用する操作情報を生成するステップと、

前記タッチパネルに対する操作を行った手を、右手または左手に特定するステップとを備え、

前記操作情報を生成するステップは、前記位置情報が一定の距離以上継続してタッチ位置が移動した軌跡であることを条件として、前記位置情報を前記特定された手の種類に応じて補正することにより前記操作情報を生成する、情報処理端末の制御方法。A method of controlling the information processing terminal executed by a computer of the information processing terminal that executes information processing in response to an input to the touch panel,

Detecting position information of a touch operation on the touch panel;

Generating operation information used for the information processing based on the position information;

Identifying a hand that has performed an operation on the touch panel as a right hand or a left hand,

The step of generating the operation information corrects the position information according to the type of the specified hand on the condition that the position information is a locus in which the touch position has moved continuously for a certain distance. A method for controlling the information processing terminal, wherein the operation information is generated by

前記制御プログラムは、前記コンピュータに、

前記タッチパネルに対するタッチ操作の位置情報を検出するステップと、

前記位置情報に基づいて、前記情報処理に利用する操作情報を生成するステップと、

前記タッチパネルに対する操作を行った手を、右手または左手に特定するステップとを実行させ、

前記操作情報を生成するステップは、前記位置情報が一定の距離以上継続してタッチ位置が移動した軌跡であることを条件として、前記位置情報を前記特定された手の種類に応じて補正することにより前記操作情報を生成する、情報処理端末の制御プログラム。A control program for the information processing terminal, which is executed by a computer of the information processing terminal that executes information processing in response to an input to the touch panel,

The control program is stored in the computer.

Detecting position information of a touch operation on the touch panel;

Generating operation information used for the information processing based on the position information;

Specifying the right hand or the left hand as the hand that performed the operation on the touch panel,

The step of generating the operation information corrects the position information according to the type of the specified hand on the condition that the position information is a locus in which the touch position has moved continuously for a certain distance. A control program for an information processing terminal, which generates the operation information by:

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012108980AJP2013235523A (en) | 2012-05-11 | 2012-05-11 | Information processing terminal, and method and program of controlling the same |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012108980AJP2013235523A (en) | 2012-05-11 | 2012-05-11 | Information processing terminal, and method and program of controlling the same |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2013235523Atrue JP2013235523A (en) | 2013-11-21 |

Family

ID=49761576

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012108980APendingJP2013235523A (en) | 2012-05-11 | 2012-05-11 | Information processing terminal, and method and program of controlling the same |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP2013235523A (en) |

Cited By (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016006576A (en)* | 2014-06-20 | 2016-01-14 | インターナショナル・ビジネス・マシーンズ・コーポレーションInternational Business Machines Corporation | Information processing device, program and method |

| CN106104434A (en)* | 2014-03-17 | 2016-11-09 | 谷歌公司 | Determining user handedness and orientation using touchscreen devices |

| JP2017509089A (en)* | 2014-12-16 | 2017-03-30 | シャオミ・インコーポレイテッド | Method, apparatus, program and recording medium for starting operation state of mobile terminal |

| JP2017161985A (en)* | 2016-03-07 | 2017-09-14 | 京セラドキュメントソリューションズ株式会社 | Input device and input method |

| JP2023101551A (en)* | 2014-06-24 | 2023-07-21 | アップル インコーポレイテッド | Input Devices and User Interface Interactions |

| US11934640B2 (en) | 2021-01-29 | 2024-03-19 | Apple Inc. | User interfaces for record labels |

| US11962836B2 (en) | 2019-03-24 | 2024-04-16 | Apple Inc. | User interfaces for a media browsing application |

| US11966560B2 (en) | 2016-10-26 | 2024-04-23 | Apple Inc. | User interfaces for browsing content from multiple content applications on an electronic device |

| US12008232B2 (en) | 2019-03-24 | 2024-06-11 | Apple Inc. | User interfaces for viewing and accessing content on an electronic device |

| US12086186B2 (en) | 2014-06-24 | 2024-09-10 | Apple Inc. | Interactive interface for navigating in a user interface associated with a series of content |

| US12149779B2 (en) | 2013-03-15 | 2024-11-19 | Apple Inc. | Advertisement user interface |

| US12177527B2 (en) | 2012-12-13 | 2024-12-24 | Apple Inc. | TV side bar user interface |

| US12204584B2 (en) | 2019-05-31 | 2025-01-21 | Apple Inc. | User interfaces for a podcast browsing and playback application |

| US12225253B2 (en) | 2012-11-27 | 2025-02-11 | Apple Inc. | Agnostic media delivery system |

| US12229475B2 (en) | 2012-12-31 | 2025-02-18 | Apple Inc. | Multi-user TV user interface |

| US12250433B2 (en) | 2019-05-31 | 2025-03-11 | Apple Inc. | Notification of augmented reality content on an electronic device |

| US12271568B2 (en) | 2020-06-21 | 2025-04-08 | Apple Inc. | User interfaces for setting up an electronic device |

| US12287953B2 (en) | 2016-06-12 | 2025-04-29 | Apple Inc. | Identifying applications on which content is available |

| US12301948B2 (en) | 2012-12-18 | 2025-05-13 | Apple Inc. | Devices and method for providing remote control hints on a display |

| US12301950B2 (en) | 2020-03-24 | 2025-05-13 | Apple Inc. | User interfaces for accessing episodes of a content series |

| US12307082B2 (en) | 2018-02-21 | 2025-05-20 | Apple Inc. | Scrollable set of content items with locking feature |

| US12335569B2 (en) | 2018-06-03 | 2025-06-17 | Apple Inc. | Setup procedures for an electronic device |

| US12342050B2 (en) | 2012-12-10 | 2025-06-24 | Apple Inc. | Channel bar user interface |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2008027183A (en)* | 2006-07-21 | 2008-02-07 | Sharp Corp | Information processing device |

| JP2010140321A (en)* | 2008-12-12 | 2010-06-24 | Sony Corp | Information processing apparatus, information processing method, and program |

| JP2011123750A (en)* | 2009-12-11 | 2011-06-23 | Panasonic Corp | Coordinate input device, portable terminal device and coordinate input method |

| JP2011138410A (en)* | 2009-12-28 | 2011-07-14 | Sony Corp | Operation direction determination apparatus, remote operating system, operation direction determination method and program |

- 2012

- 2012-05-11JPJP2012108980Apatent/JP2013235523A/enactivePending

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2008027183A (en)* | 2006-07-21 | 2008-02-07 | Sharp Corp | Information processing device |

| JP2010140321A (en)* | 2008-12-12 | 2010-06-24 | Sony Corp | Information processing apparatus, information processing method, and program |

| JP2011123750A (en)* | 2009-12-11 | 2011-06-23 | Panasonic Corp | Coordinate input device, portable terminal device and coordinate input method |

| JP2011138410A (en)* | 2009-12-28 | 2011-07-14 | Sony Corp | Operation direction determination apparatus, remote operating system, operation direction determination method and program |

Cited By (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US12225253B2 (en) | 2012-11-27 | 2025-02-11 | Apple Inc. | Agnostic media delivery system |

| US12342050B2 (en) | 2012-12-10 | 2025-06-24 | Apple Inc. | Channel bar user interface |

| US12177527B2 (en) | 2012-12-13 | 2024-12-24 | Apple Inc. | TV side bar user interface |

| US12301948B2 (en) | 2012-12-18 | 2025-05-13 | Apple Inc. | Devices and method for providing remote control hints on a display |

| US12229475B2 (en) | 2012-12-31 | 2025-02-18 | Apple Inc. | Multi-user TV user interface |

| US12149779B2 (en) | 2013-03-15 | 2024-11-19 | Apple Inc. | Advertisement user interface |

| CN106104434A (en)* | 2014-03-17 | 2016-11-09 | 谷歌公司 | Determining user handedness and orientation using touchscreen devices |

| CN106104434B (en)* | 2014-03-17 | 2019-07-16 | 谷歌有限责任公司 | Determining user hand and orientation using touchscreen devices |

| US10216334B2 (en) | 2014-06-20 | 2019-02-26 | International Business Machines Corporation | Touch panel input item correction in accordance with angle of deviation |

| US11023076B2 (en) | 2014-06-20 | 2021-06-01 | International Business Machines Corporation | Touch panel input item correction in accordance with angle of deviation |

| US10394382B2 (en) | 2014-06-20 | 2019-08-27 | International Business Machines Corporation | Touch panel input item correction in accordance with angle of deviaton |

| JP2016006576A (en)* | 2014-06-20 | 2016-01-14 | インターナショナル・ビジネス・マシーンズ・コーポレーションInternational Business Machines Corporation | Information processing device, program and method |

| US9851847B2 (en) | 2014-06-20 | 2017-12-26 | International Business Machines Corporation | Touch panel input item correction in accordance with angle of deviation |

| US9846537B2 (en) | 2014-06-20 | 2017-12-19 | International Business Machines Corporation | Touch panel input item correction in accordance with angle of deviation |

| US12105942B2 (en) | 2014-06-24 | 2024-10-01 | Apple Inc. | Input device and user interface interactions |

| JP7750896B2 (en) | 2014-06-24 | 2025-10-07 | アップル インコーポレイテッド | Input Devices and User Interface Interactions |

| US12086186B2 (en) | 2014-06-24 | 2024-09-10 | Apple Inc. | Interactive interface for navigating in a user interface associated with a series of content |

| JP2023101551A (en)* | 2014-06-24 | 2023-07-21 | アップル インコーポレイテッド | Input Devices and User Interface Interactions |

| JP2017509089A (en)* | 2014-12-16 | 2017-03-30 | シャオミ・インコーポレイテッド | Method, apparatus, program and recording medium for starting operation state of mobile terminal |

| JP2017161985A (en)* | 2016-03-07 | 2017-09-14 | 京セラドキュメントソリューションズ株式会社 | Input device and input method |

| US12287953B2 (en) | 2016-06-12 | 2025-04-29 | Apple Inc. | Identifying applications on which content is available |

| US11966560B2 (en) | 2016-10-26 | 2024-04-23 | Apple Inc. | User interfaces for browsing content from multiple content applications on an electronic device |

| US12307082B2 (en) | 2018-02-21 | 2025-05-20 | Apple Inc. | Scrollable set of content items with locking feature |

| US12335569B2 (en) | 2018-06-03 | 2025-06-17 | Apple Inc. | Setup procedures for an electronic device |

| US12432412B2 (en) | 2019-03-24 | 2025-09-30 | Apple Inc. | User interfaces for a media browsing application |

| US11962836B2 (en) | 2019-03-24 | 2024-04-16 | Apple Inc. | User interfaces for a media browsing application |

| US12299273B2 (en) | 2019-03-24 | 2025-05-13 | Apple Inc. | User interfaces for viewing and accessing content on an electronic device |

| US12008232B2 (en) | 2019-03-24 | 2024-06-11 | Apple Inc. | User interfaces for viewing and accessing content on an electronic device |

| US12204584B2 (en) | 2019-05-31 | 2025-01-21 | Apple Inc. | User interfaces for a podcast browsing and playback application |

| US12250433B2 (en) | 2019-05-31 | 2025-03-11 | Apple Inc. | Notification of augmented reality content on an electronic device |

| US12301950B2 (en) | 2020-03-24 | 2025-05-13 | Apple Inc. | User interfaces for accessing episodes of a content series |

| US12271568B2 (en) | 2020-06-21 | 2025-04-08 | Apple Inc. | User interfaces for setting up an electronic device |

| US11934640B2 (en) | 2021-01-29 | 2024-03-19 | Apple Inc. | User interfaces for record labels |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2013235523A (en) | Information processing terminal, and method and program of controlling the same | |

| US9965033B2 (en) | User input method and portable device | |

| US8866773B2 (en) | Remote control apparatus, remote control system, remote control method, and program | |

| KR101995403B1 (en) | Stylus pen, electroinic device and method for processing input using it | |

| JP5922480B2 (en) | Portable device having display function, program, and control method of portable device having display function | |

| US20160195986A1 (en) | Method and apparatus for recognizing grip state in electronic device | |

| US20150009129A1 (en) | Method for operating panorama image and electronic device thereof | |

| WO2018212932A1 (en) | Input adjustment | |

| US10341480B2 (en) | Wearable device paired with mobile terminal and operating method thereof | |

| US20140009449A1 (en) | Display method and apparatus in terminal having flexible display panel | |

| US20150054780A1 (en) | Operation input device, operation input method, and program | |

| JP2012203671A (en) | Electronic apparatus, information generation method and program | |

| KR102422181B1 (en) | Method for controling a display of an electronic device and the electronic device thereof | |

| US20110074829A1 (en) | Mobile communication terminal including touch interface and method thereof | |

| CN108733275A (en) | A kind of object displaying method and terminal | |

| CN109559280B (en) | An image processing method and terminal | |

| US20160224111A1 (en) | Method for controlling touch screen by detecting position of line of sight of user | |

| JP2015215840A (en) | Information processing apparatus and input method | |

| JP2014056519A (en) | Portable terminal device, incorrect operation determination method, control program, and recording medium | |

| ES2770091T3 (en) | User terminal device and its control procedure | |

| CN114144749B (en) | Operation method based on touch input and electronic device thereof | |

| JP6197012B2 (en) | Information processing apparatus and information processing method | |

| KR102492182B1 (en) | User terminal apparatus and control method thereof | |

| CN113168220A (en) | A display method, storage medium and electronic device | |

| CN115421617A (en) | Holding mode detection method, electronic device and storage medium |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination | Free format text:JAPANESE INTERMEDIATE CODE: A621 Effective date:20150318 | |

| A131 | Notification of reasons for refusal | Free format text:JAPANESE INTERMEDIATE CODE: A131 Effective date:20160223 | |

| A977 | Report on retrieval | Free format text:JAPANESE INTERMEDIATE CODE: A971007 Effective date:20160224 | |

| A02 | Decision of refusal | Free format text:JAPANESE INTERMEDIATE CODE: A02 Effective date:20160823 |