JP2009171262A - Acoustic device, voice reproduction method, voice reproduction program, and recording medium - Google Patents

Acoustic device, voice reproduction method, voice reproduction program, and recording mediumDownload PDFInfo

- Publication number

- JP2009171262A JP2009171262AJP2008007522AJP2008007522AJP2009171262AJP 2009171262 AJP2009171262 AJP 2009171262AJP 2008007522 AJP2008007522 AJP 2008007522AJP 2008007522 AJP2008007522 AJP 2008007522AJP 2009171262 AJP2009171262 AJP 2009171262A

- Authority

- JP

- Japan

- Prior art keywords

- channel

- sound

- unit

- signal

- audio

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

- 238000000034methodMethods0.000titleclaimsdescription13

- 238000000605extractionMethods0.000claimsabstractdescription72

- 239000000284extractSubstances0.000claimsabstractdescription4

- 238000004364calculation methodMethods0.000claimsdescription3

- 238000012545processingMethods0.000abstractdescription67

- 239000000203mixtureSubstances0.000abstract1

- 238000006243chemical reactionMethods0.000description8

- 238000010586diagramMethods0.000description7

- 230000006870functionEffects0.000description7

- 238000005516engineering processMethods0.000description4

- 238000005401electroluminescenceMethods0.000description2

- 238000012986modificationMethods0.000description2

- 230000004048modificationEffects0.000description2

- 230000015572biosynthetic processEffects0.000description1

- 238000007796conventional methodMethods0.000description1

- 230000000694effectsEffects0.000description1

- 238000002474experimental methodMethods0.000description1

- 239000004973liquid crystal related substanceSubstances0.000description1

- 238000004088simulationMethods0.000description1

- 230000005236sound signalEffects0.000description1

- 230000001755vocal effectEffects0.000description1

Images

Landscapes

- Stereophonic System (AREA)

Abstract

Description

Translated fromJapanese本発明は、音響装置、音声再生方法、音声再生プログラム、及び、当該音声再生プログラムが記録された記録媒体に関する。 The present invention relates to an audio device, an audio reproduction method, an audio reproduction program, and a recording medium on which the audio reproduction program is recorded.

従来から、CD(Compact Disk)やDVD(Digital Versatile Disk)等の普及に伴って、複数のスピーカを有する2チャンネルステレオ方式やマルチチャンネルサラウンド方式の音響装置が普及している。これにより、家庭内空間や車両内空間においても、臨場感溢れる再生音声を楽しむことができるようになってきている。 2. Description of the Related Art Conventionally, with the spread of CD (Compact Disk), DVD (Digital Versatile Disk), etc., 2-channel stereo type and multi-channel surround type audio devices having a plurality of speakers have become widespread. As a result, it has become possible to enjoy reproduced sound full of realism even in home spaces and vehicle spaces.

ところで、現存する音声コンテンツは、モノラル方式をはじめとして、様々なチャンネル構成のものが存在する。このため、再生しようとする音声コンテンツのチャンネル構成が再生用の音響装置のチャンネル構成と一致しない場合が発生する。このため、例えば、再生しようとする音声コンテンツがモノラル方式で収録されたものである場合に、複数のスピーカを有する音響装置の性能を活用して臨場感溢れる音声再生を行うため、様々な技術が提案されている。 By the way, the existing audio content includes various channel configurations including a monaural system. For this reason, the channel configuration of the audio content to be played may not match the channel configuration of the audio device for playback. For this reason, for example, when the audio content to be reproduced is recorded in monaural format, various technologies are used to perform audio reproduction with a sense of presence by utilizing the performance of an acoustic device having a plurality of speakers. Proposed.

こうした技術として、モノラル方式で収録された音声コンテンツを2チャンネル(左(L)チャンネル及び右(R)チャンネル)ステレオ方式で再生するものがある(特許文献1参照:以下、「従来例」という)。この従来例の技術では、モノラル方式の音声信号を複数の周波数帯域に分割し、周波数帯域ごとに予め定められたLチャンネル又はRチャンネルに分配する。そして、チャンネルごとに、分配された信号を加算した信号を各スピーカに供給するようになっている。 As such a technique, there is one that reproduces audio content recorded in a monaural system in a two-channel (left (L) channel and right (R) channel) stereo system (see Patent Document 1: hereinafter referred to as “conventional example”). . In this conventional technique, a monaural audio signal is divided into a plurality of frequency bands and distributed to L channels or R channels predetermined for each frequency band. For each channel, a signal obtained by adding the distributed signals is supplied to each speaker.

上述した従来例の技術では、音の広がり感を聴取者に与えることはできるが、その音の広がり感は、収録時における実際の音源の位置を反映したものとはいえない。このため、従来例の技術では、収録時における楽曲演奏等による音声とは異なる態様の音声を再生することになる場合が多かった。 With the above-described conventional technology, it is possible to give a listener a sense of sound spread, but the sound spread cannot reflect the actual position of the sound source at the time of recording. For this reason, in the technology of the conventional example, there is often a case where a sound having a different form from a sound due to music performance at the time of recording is reproduced.

このため、音声コンテンツがモノラル方式であったとしても、音声コンテンツの収録時における実際の音声に近付けたものを複数のスピーカにより再生することができる技術が待望されている。かかる要請に応えることが、本発明が解決すべき課題の一つとして挙げられる。 For this reason, even if the audio content is a monaural system, there is a need for a technology that can reproduce the sound close to the actual sound at the time of recording the audio content with a plurality of speakers. Meeting this requirement is one of the problems to be solved by the present invention.

本発明は、上記の事情を鑑みてなされたものであり、音声コンテンツのチャンネル構成と異なる複数のチャンネル構成であっても、音声コンテンツの収録時における実際の音声に近付けた再生音声を生成することができる音響装置及び音声再生方法を提供することを目的とする。 The present invention has been made in view of the above circumstances, and generates reproduced sound that is close to the actual sound at the time of recording audio content, even if the channel configuration is different from the channel configuration of the audio content. An object of the present invention is to provide an audio device and a sound reproduction method capable of performing the above.

請求項1に記載の発明は、複数のスピーカから音場空間へ向けて音声を出力する音響装置であって、前記スピーカの数とは異なる数のチャンネル構成で収録が行われた音声コンテンツについて、前記収録の時における複数の音声源のそれぞれの種類情報と位置情報とを反映した音声源情報に基づいて、前記収録の時におけるチャンネル構成の信号から前記複数の音声源のそれぞれが発生したと推定される音声を抽出する抽出手段と;前記音声源情報に基づいて、前記抽出結果のそれぞれについて、前記抽出結果のそれぞれが対応する音声源が前記収録の時に位置していたと推定される位置に音像を形成する比率で、前記複数のスピーカそれぞれに対応する信号チャンネルに分配する分配手段と;前記信号チャンネルごとに、前記分配手段による分配結果を加算する加算手段と;を備えることを特徴とする音響装置である。 The invention according to

請求項8に記載の発明は、複数のスピーカから音場空間へ向けて音声を出力する音響装置において使用される音像再生方法であって、前記スピーカの数とは異なる数のチャンネル構成で収録が行われた音声コンテンツについて、前記収録の時における複数の音声源のそれぞれの種類情報と位置情報とを反映した音声源情報に基づいて、前記収録の時におけるチャンネル構成の信号から前記複数の音声源のそれぞれが発生したと推定される音声を抽出する抽出工程と;前記音声源情報に基づいて、前記抽出結果のそれぞれについて、前記抽出結果のそれぞれが対応する音声源が前記収録の時に位置していたと推定される位置に音像を形成する比率で、前記複数のスピーカそれぞれに対応する信号チャンネルに分配する分配工程と;前記信号チャンネルごとに、前記分配工程における分配結果を加算する加算工程と;を備えることを特徴とする音声再生方法である。 The invention according to claim 8 is a sound image reproduction method used in an acoustic device for outputting sound from a plurality of speakers to a sound field space, and recording is performed with a channel configuration of a number different from the number of the speakers. Based on the audio source information reflecting the type information and position information of each of the plurality of audio sources at the time of recording, the plurality of audio sources from the channel configuration signal at the time of recording. An extraction step of extracting the sound that is estimated to have occurred, and for each of the extraction results based on the sound source information, the sound source corresponding to each of the extraction results is located at the time of recording A distribution step of distributing to a signal channel corresponding to each of the plurality of speakers at a ratio of forming a sound image at an estimated position; For each channel, an adding step of adding the distribution result in the distribution step; an audio reproducing method characterized by comprising a.

請求項9に記載の発明は、請求項8に記載の音声再生方法を演算手段に実行させる、ことを特徴とする音声再生プログラムである。 A ninth aspect of the present invention is a voice reproduction program characterized by causing a calculation means to execute the voice reproduction method according to the eighth aspect.

請求項10に記載の発明は、請求項9に記載の音声再生プログラムが、演算手段により読み取り可能に記録されている、ことを特徴とする記録媒体である。 A tenth aspect of the present invention is a recording medium in which the sound reproduction program according to the ninth aspect is recorded so as to be readable by a calculation means.

以下、本発明の一実施形態を、図1〜図10を参照して説明する。なお、以下の説明及び図面においては、同一又は同等の要素については同一の符号を付し、重複する説明を省略する。 Hereinafter, an embodiment of the present invention will be described with reference to FIGS. In the following description and drawings, the same or equivalent elements are denoted by the same reference numerals, and redundant description is omitted.

[構成]

図1には、一実施形態に係る音響装置100の概略的な構成がブロック図にて示されている。なお、本実施形態の音響装置100は、モノラル方式で収録された音声コンテンツを2チャンネルステレオ方式で再生する装置である。[Constitution]

FIG. 1 is a block diagram illustrating a schematic configuration of an

この図1に示されるように、音響装置100は、制御ユニット110と、記憶ユニット120とを備えている。 As shown in FIG. 1, the

また、音響装置100は、音出力ユニット130Lと、音出力ユニット130Rとを備えている。ここで、音出力ユニット130Lはレフトスピーカ131Lを有し、音出力ユニット130Rはライトスピーカ131Rを有している。The

さらに、音響装置100は、表示ユニット150と、操作入力ユニット160とを備えている。 Furthermore, the

なお、制御ユニット110以外の要素120,130L,130R,150,160は、制御ユニット110に接続されている。The

制御ユニット110は、音響装置100の全体を統括制御する。この制御ユニット110の詳細については、後述する。 The

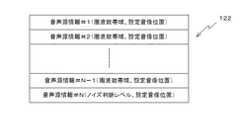

上記の記憶ユニット120は、音声コンテンツ情報121、抽出参照情報122等の様々なデータを記憶する。ここで、音声コンテンツ情報121には、図2に示されるように、音声源情報としての楽曲情報126と、音声データ127とを含んでいる。 The

楽曲情報126には、楽曲名情報と、楽曲の演奏者を示す演奏者情報とが含まれる。また、楽曲情報126には、楽曲の演奏場所である演奏場所情報と、楽曲の演奏に使用された楽器の構成を示す演奏楽器情報とが含まれる。なお、楽曲情報126には、楽曲名情報、演奏者情報、演奏場所情報及び演奏楽器情報の全てが含まれていることが必須というわけではなく、演奏時における楽器種類や演奏位置等の推測の基礎となり得る情報として、少なくとも1つが含まれていればよい。 The

例えば、楽曲名情報として「弦楽四重奏」という情報が含まれていれば、当該楽曲名情報のみで、楽器構成や、楽器間の位置関係の推測の基礎となり得る情報といえる。また、演奏者情報として「弦楽四重奏団」という情報が含まれていれば、当該演奏者情報のみで、楽器構成や、楽器間の位置関係の推測の基礎となり得る情報といえる。 For example, if the information “string quartet” is included as music name information, it can be said that only the music name information is information that can serve as a basis for estimating the musical instrument configuration and the positional relationship between the musical instruments. Further, if the information “string quartet” is included as the player information, it can be said that the player information alone can be used as a basis for estimating the musical instrument configuration and the positional relationship between the musical instruments.

上記のような楽曲名情報又は演奏者情報に加えて、演奏場所情報として「〜ホール」との情報が含まれていれば、当該演奏場所情報は、楽器間の位置関係のより高い精度による推測の基礎となり得る。また、演奏楽器情報は、楽器構成の推測の基礎となり得る。 In addition to the music name information or performer information as described above, if the information “˜hole” is included as performance place information, the performance place information is estimated with higher accuracy of the positional relationship between the instruments. Can be the basis of The musical instrument information can be the basis for estimating the musical instrument configuration.

上記の音声データ127は、所定のチャンネル構成で収録された音に対応したデジタルデータである。なお、以下の説明においては、音声データ127はモノラル形式で収録されたデータであるものとする。 The

上記の抽出参照情報122には、図3に示されるように、上記の音声コンテンツ情報121に対応して定まる音声源情報#1〜#Nが含まれている。音声源情報#1〜#N−1のそれぞれには、楽曲情報126から推測される楽器構成における楽器等(バイオリン、コントラバス、ボーカル等)それぞれの周波数帯域、及び、各楽器等の推測位置に対応して定まる設定音像位置が含まれている。また、音声源情報#Nには、観客のざわめきや残響音等の演奏音に対するノイズを抽出するためのノイズ判断レベル及び設定音像位置が含まれている。こうした抽出参照情報122は、音声コンテンツ情報121の入手時に、楽曲情報126により推測された演奏時における楽器種類や演奏位置等に基づいて、制御ユニット110により生成されるようになっている。 As shown in FIG. 3, the

なお、上述のノイズ判断レベルは、実験、シミュレーション、経験等に基づいて定められる。 The above-described noise determination level is determined based on experiments, simulations, experiences, and the like.

図1に戻り、記憶ユニット120からは、制御ユニット110からの制御信号DVCに従って、データが読み出される。ここで、上述した音声データ127は、コンテンツデータCTDとして読み出され、抽出参照情報122は、抽出参照情報データRFDとして読み出される。 Returning to FIG. 1, data is read from the

なお、制御ユニット110は、制御信号DVCとしてデータ位置を指定した読出指令を発行することにより、音声データ127及び抽出参照情報122以外のデータも記憶ユニット120から読み出すことが可能となっている。また、制御ユニット110は、制御信号DVCとしてデータ位置を指定した書込指令を発行することにより、記憶ユニット120の任意の位置に所望の内容のデータを書き込むことが可能となっている。 Note that the

上記の音出力ユニット130L,130Rのそれぞれは、上述したスピーカ131L,131Rの他に、制御ユニット110から受信した音声出力信号AOSL,AOSRを増幅する増幅器等を備えている。これらの音出力ユニット130L,130Rは、制御ユニット110から送られてきた音声出力信号AOSL,AOSRに従って、楽曲等の再生音声を出力する。Each of the

本実施形態では、図4に示されるように、音出力ユニット130Lのレフトスピーカ131Lは、助手席側の前方ドア筐体内に配置される。このレフトスピーカ131Lは、助手席側を向くように配設されている。また、音出力ユニット130Rのライトスピーカ131Rは、運転席側の前方ドア筐体内に配置される。このライトスピーカ131Rは、運転席側を向くように配設されている。In the present embodiment, as shown in FIG. 4, the

図1に戻り、上記の表示ユニット150は、例えば、(i)液晶パネル、有機EL(Electro Luminescence)パネル、PDP(Plasma Display Panel)等の表示デバイス151と、(ii)制御ユニット110から送出された表示制御データに基づいて、表示ユニット150全体の制御を行うグラフィックレンダラ等の表示コントローラと、(iii)表示画像データを記憶する表示画像メモリ等を備えて構成されている。この表示ユニット150は、制御ユニット110からの表示データIMDに従って、操作ガイダンス情報等を表示する。 Returning to FIG. 1, the

上記の操作入力ユニット160は、音響装置100の本体部に設けられたキー部、及び/又はキー部を備えるリモート入力装置等により構成される。ここで、本体部に設けられたキー部としては、表示ユニット150の表示デバイス151に設けられたタッチパネルを用いることができる。なお、キー部を有する構成に代えて、又は併用して音声認識技術を利用して音声にて入力する構成を採用することもできる。 The

この操作入力ユニット160を利用者が操作することにより、音響装置100において再生すべき音声コンテンツの指定等が行われる。こうした入力内容は、操作入力データIPDとして、操作入力ユニット160から制御ユニット110へ向けて送られる。 When the user operates the

次に、上記の制御ユニット110について説明する。上述したように、制御ユニット110は、音響装置100の全体を統括制御する。この制御ユニット110は、図5に示されるように、チャンネル信号処理部111と、アナログ変換部112とを備えている。また、制御ユニット110は、音量調整部113と、制御処理部119とを備えている。 Next, the

上記のチャンネル信号処理部111は、記憶ユニット120からのコンテンツデータCTDを処理し、スピーカ131L,131Rに対応するチャンネル処理データPCDL,PCDRを生成する。かかる機能を有するチャンネル信号処理部111は、図6に示されるように、抽出手段としての抽出部210と、分配手段としての分配部220と、加算手段としての加算部230とを備えている。The channel

上記の抽出部210は、記憶ユニット120からのコンテンツデータCTDを受ける。そして、抽出部210は、制御処理部119からの抽出制御信号EXCに従って、N個の音声源ごとの音声成分を抽出する。かかる機能を有する抽出部210は、図7に示されるように、バンドパスフィルタ(BPF)2111〜211N-1と、ノイズゲート212とを備えている。The

上記のBPF211j(j=1〜N−1)のそれぞれは、記憶ユニット120からコンテンツデータCTDを受ける。そして、BPF211jのそれぞれは、制御処理部119からの抽出制御信号EXCにおける抽出指令信号EXCjにより指定された通過帯域に属する周波数の信号成分を選択的に通過させる。こうしてBPF211jを通過した信号は、抽出信号EXDjとして、分配部220へ送られる。Each of the BPFs 211j (j = 1 to N−1) receives the content data CTD from the

上記のノイズゲート212は、記憶ユニット120からコンテンツデータCTDを受ける。そして、ノイズゲート212は、制御処理部119からの抽出制御信号EXCにおける抽出指令信号EXCNにより指定されたノイズ判断レベル以下の音に対応する信号のみを通過させる。こうしてノイズゲート212を通過した信号は、抽出信号EXDNとして、分配部220へ送られる。The

図6に戻り、上記の分配部220は、抽出部210からの抽出信号EXDk(k=1〜N)を受ける。そして、分配部220は、制御処理部119からの分配制御信号DSCに従って、抽出信号EXDkのそれぞれからLチャンネル分配信号DCLkとRチャンネル分配信号DCRkとを生成する。かかる機能を有する分配部220は、図8に示されるように、個別分配部2211〜221Nを備えている。Returning to FIG. 6, the

個別分配部221kは、抽出部210からの抽出信号EXDkを受ける。そして、個別分配部221kは、制御処理部119からの分配制御信号DSCにおける分配指令信号DSCkに従って、Lチャンネル分配信号DCLkとRチャンネル分配信号DCRkとを生成する。かかる機能を有する個別分配部221kは、図9に示されるように、オールパスフィルタ(APF)226L,226Rと、可変減衰部227L,227Rとを備えている。The

上記のAPF226Lは、抽出部210からの抽出信号EXDkを受ける。そして、APF226Lは、全ての周波数範囲の信号を通過させつつ、Lチャンネル用の位相変化を付与する。こうしてAPF226Lにより処理されて生成された信号は、Lチャンネル位相加工信号PALkとして可変減衰部227Lへ送られる。Additional APF226L receives the extracted signal EXDk from the

上記のAPF226Rは、抽出部210からの抽出信号EXDkを受ける。そして、APF226Rは、全ての周波数範囲の信号を通過させつつ、Rチャンネル用の位相変化を付与する。こうしてAPF226Rにより処理されて生成された信号は、Rチャンネル位相加工信号PARkとして可変減衰部227Rへ送られる。The

上記の可変減衰部227Lは、APF226LからのLチャンネル位相加工信号PALkを入力端子Iで受ける。また、可変減衰部227Lは、制御処理部119からの分配指令信号DSCkにおけるLチャンネル分配率指定信号DSCkLを制御端子Cで受ける。そして、可変減衰部227Lは、Lチャンネル分配率指定信号DSCkLにより指定された分配率をLチャンネル位相加工信号PALkに乗じる。この乗算結果は、可変減衰部227Lの出力端子Oから、Lチャンネル分配信号DCLkとして加算部230へ向けて出力される。

上記の可変減衰部227Rは、APF226RからのRチャンネル位相加工信号PARkを入力端子Iで受ける。また、可変減衰部227Rは、制御処理部119からの分配指令信号DSCkにおけるRチャンネル分配率指定信号DSCkRを制御端子Cで受ける。そして、可変減衰部227Rは、Rチャンネル分配率指定信号DSCkRにより指定された分配率をRチャンネル位相加工信号PARkに乗じる。この乗算結果は、可変減衰部227Rの出力端子Oから、Rチャンネル分配信号DCRkとして加算部230へ向けて出力される。The

図6に戻り、上記の加算部230は、分配部220からのLチャンネル分配信号DCL1〜DCLN及びRチャンネル分配信号DCR1〜DCRNを受ける。そして、加算部230は、Lチャンネル分配信号DCL1〜DCLNに基づいて、Lチャンネル処理データPCDLを生成するとともに、Rチャンネル分配信号DCR1〜DCRNに基づいて、Rチャンネル処理データPCDRを生成する。かかる機能を有する加算部230は、Lチャンネル加算部231Lと、Rチャンネル加算部231Rとを備えている。Returning to FIG. 6, the

上記のLチャンネル加算部231Lは、分配部220からのLチャンネル分配信号DCL1〜DCLNを受ける。そして、Lチャンネル加算部231Lは、Lチャンネル分配信号DCL1〜DCLNを加算する。この加算結果が、Lチャンネル処理データPCDLとして、アナログ変換部112へ向けて出力される。The L

上記のRチャンネル加算部231Rは、分配部220からのRチャンネル分配信号DCR1〜DCRNを受ける。そして、Rチャンネル加算部231Rは、Rチャンネル分配信号DCR1〜DCRNを加算する。この加算結果が、Rチャンネル処理データPCDRとして、アナログ変換部112へ向けて出力される。The R

図5に戻り、上記のアナログ変換部112は、チャンネル信号処理部111から送られてきたデジタル信号であるLチャンネル処理データPCDL及びRチャンネル処理データPCDRを、それぞれアナログ信号に変換する。このアナログ変換部112は、当該2種のデジタル信号に対応して、互いに同様に構成された2個のDA(Digital to Analogue)変換器を備えている。このアナログ変換部112による変換結果であるアナログ信号PBSL,PBSRは、音量調整部113へ向けて送られる。Returning to FIG. 5, the

上記の音量調整部113は、アナログ変換部112からのアナログ信号PBSL,PBSRを受ける。そして、音量調整部113は、アナログ信号PBSL,PBSRのそれぞれに対して、制御処理部119からの音量調整指令VLCに従って、音量を調整する。かかる調整結果は、音声出力信号AOSL,AOSRとして、音出力ユニット130L,130Rへ向けて出力される。The

次に、上記の制御処理部119について説明する。この制御処理部119は、上述した他の構成要素を制御しつつ、音響装置100の機能を発揮させる。この制御処理部119は、音声コンテンツ情報121が入手され、記憶ユニット120に格納されると、音声コンテンツ情報121における楽曲情報126の内容を上述したように利用して、抽出参照情報122を生成する。制御処理部119は、こうして生成された抽出参照情報122を記憶ユニット120に格納する。 Next, the

また、制御処理部119は、利用者が再生すべき音声コンテンツの指定を支援するための案内画面を表示ユニット150に表示させる。そして、操作入力ユニット160から音声コンテンツを指定した再生指令が入力されると、制御処理部119は、記憶ユニット120からの再生コンテンツのデータ読み出しを制御する。 In addition, the

また、制御処理部119は、操作入力ユニット160から音声コンテンツを指定した再生指令が入力されると、記憶ユニット120から抽出参照情報122を、抽出参照情報データRFDとして読み出す。引き続き、制御処理部119は、読み出された抽出参照情報122に基づいて、抽出制御信号EXC及び分配制御信号DSCを生成する。そして、制御処理部119は、生成された抽出制御信号EXC及び分配制御信号DSCを、チャンネル信号処理部111へ向けて送る。 In addition, when a reproduction command specifying audio content is input from the

ここで、制御処理部119は、抽出参照情報122の音声源情報#1〜#(N−1)における周波数帯域及び音声源情報#Nのノイズ判断レベルに基づいて、抽出制御信号EXCを生成する。また、制御処理部119は、抽出参照情報122の音声源情報#1〜#Nの設定音像位置に基づいて、分配制御信号DSCを生成する。 Here, the

また、制御処理部119は、音量調整部113を制御して、音出力ユニット130L,130Rのスピーカ131L,131Rからの出力音量を調整する。この出力音量の制御に際して、制御処理部119は、操作入力ユニット160に入力された音量指定に従って音量調整指令VLCを生成し、音量調整部113へ向けて送る。Further, the

[動作]

次に、上記のように構成された音響装置100の動作について、音像位置の設定処理に主に着目して説明する。なお、記憶ユニット120には、モノラル形式で収録された音声データ127を含む音声コンテンツ情報121及び抽出参照情報122は、既に記憶されているものとする。[Operation]

Next, the operation of the

利用者が、操作入力ユニット160に音声データ127を指定した再生指令を入力すると、その旨が、操作入力データIPDとして、制御処理部119へ送られる(図5参照)。この再生指令を受けると、制御処理部119は、まず、記憶ユニット120から抽出参照情報122を、抽出参照情報データRFDとして読み出す。 When the user inputs a reproduction command specifying the

次に、制御処理部119は、読み出された抽出参照情報122の音声源情報#1〜#(N−1)における周波数帯域を指定する抽出指令信号EXC1〜EXCN-1を生成するとともに、抽出参照情報122の音声源情報#Nにおけるノイズ判断レベルを指定する抽出指令信号EXCNを生成する。引き続き、制御処理部119は、こうして生成された抽出指令信号EXC1〜EXCN、すなわち、抽出制御信号EXCを、チャンネル信号処理部111の抽出部210へ送る(図6参照)。Next, the

抽出部210では、抽出制御信号EXCにおける抽出指令信号EXCj(j=1〜N−1)で指定された周波数帯域がBPF211jの通過帯域として設定される。また、抽出部210では、抽出制御信号EXCにおける抽出指令信号EXCNで指令されたノイズ判断レベルが、ノイズゲート212のノイズ判断レベルとして設定される(図7参照)。In the

次いで、制御処理部119は、読み出された抽出参照情報122の音声源情報#1〜#Nにおける設定音像位置に基づいて、当該設定音像位置に音像を形成するためのLチャンネル分配率とRチャンネル分配率とを指定するLチャンネル分配率指定信号DSC1L〜DSCNL及びRチャンネル分配率指定信号DSC1R〜DSCNRを生成する。引き続き、制御処理部119は、こうして生成されたLチャンネル分配率指定信号DSC1L〜DSCNL及びRチャンネル分配率指定信号DSC1R〜DSCNR、すなわち、分配制御信号DSCを、チャンネル信号処理部111の分配部220へ送る(図6参照)。Next, based on the set sound image position in the sound

分配部220では、分配制御信号DSCにおけるLチャンネル分配率指定信号DSCkL(k=1〜N)で指定されたLチャンネル分配率が個別分配部221kの可変減衰部227Lの減衰率として設定される。また、分配部220では、分配制御信号DSCにおけるRチャンネル分配率指定信号DSCkRで指定されたRチャンネル分配率が個別分配部221kの可変減衰部227Rの減衰率として設定される(図9参照)。In

以上のようにしてチャンネル信号処理部111に対する設定を終了すると、制御処理部119は、記憶ユニット120内の音声コンテンツ情報121における音声データ127をコンテンツデータCTDとして読み出す制御を開始する。かかる制御のもとで記憶ユニット120から読み出されたコンテンツデータCTDは、チャンネル信号処理部111の抽出部210へ送られる(図6参照)。コンテンツデータCTDを受けた抽出部210では、BPF211j(j=1〜N−1)のそれぞれが、コンテンツデータCTDにおける抽出指令信号EXCjにより指定された通過帯域に属する周波数の信号成分を選択的に通過させる。こうして、BPF211jを通過した信号が、抽出信号EXDjとして、分配部220へ送られる(図7参照)。When the setting for the channel

また、コンテンツデータCTDを受けた抽出部210では、ノイズゲート212が、抽出指令信号EXCNにより指定されたノイズ判断レベル以下の音に対応する信号のみを通過させる。こうしてノイズゲート212を通過した信号が、抽出信号EXDNとして、分配部220へ送られる(図7参照)。Further, the

抽出信号EXD1〜EXDNを受けた分配部220では、個別分配部221k(k=1〜N)が、抽出信号EXDkをLチャンネル及びRチャンネルに分配する。この結果、Lチャンネル分配信号DCLk及びRチャンネル分配信号DCRkが生成される(図8参照)。In the

ここで、Lチャンネル分配信号DCLkの生成に際して、個別分配部221kでは、まず、APF226Lが、抽出信号EXDkに対して、全ての周波数範囲の信号を通過させつつ、Lチャンネル用の位相変化を付与する。こうしてAPF226Lにより処理されて生成された信号は、Lチャンネル位相加工信号PALkとして可変減衰部227Lへ送られる。Here, when the L channel distribution signal DCLk is generated, in the

Lチャンネル位相加工信号PALkを受けた可変減衰部227Lでは、Lチャンネル位相加工信号PALkと、Lチャンネル分配率指定信号DSCkLにより指定された分配率との乗算を行う。この乗算結果が、Lチャンネル分配信号DCLkとして加算部230へ向けて出力される。The

また、Rチャンネル分配信号DCRkの生成に際して、個別分配部221kでは、まず、APF226Rが、抽出信号EXDkに対して、全ての周波数範囲の信号を通過させつつ、Rチャンネル用の位相変化を付与する。こうしてAPF226Rにより処理されて生成された信号は、Rチャンネル位相加工信号PARkとして可変減衰部227Rへ送られる。In the generation of the R channel distribution signal DCRk , in the

Rチャンネル位相加工信号PARkを受けた可変減衰部227Rでは、Rチャンネル位相加工信号PARkと、Rチャンネル分配率指定信号DSCkRにより指定された分配率との乗算を行う。この乗算結果が、Rチャンネル分配信号DCRkとして加算部230へ向けて出力される。The

以上のようにして分配部220で生成されたLチャンネル分配信号DCLk(k=1〜N)は、加算部230におけるLチャンネル加算部231Lにより加算される。この加算結果が、Lチャンネル処理データPCDLとして、アナログ変換部112へ向けて送られる。The L channel distribution signal DCLk (k = 1 to N) generated by the

また、分配部220で生成されたRチャンネル分配信号DCRk(k=1〜N)は、加算部230におけるRチャンネル加算部231Rにより加算される。この加算結果が、Rチャンネル処理データPCDRとして、アナログ変換部112へ向けて送られる。The R channel distribution signal DCRk (k = 1 to N) generated by the

この後、Lチャンネル処理データPCDL及びRチャンネル処理データPCDRについて、アナログ変換部112においてアナログ信号に変換され、さらに、音量調整部113において音量調整が行われて、音声出力信号AOSL,AOSRが生成される。そして、音声出力信号AOSL,AOSRが音出力ユニット130L,130Rに供給される(図5参照)。Thereafter, the L channel processing data PCDL and the R channel processing data PCDR are converted into analog signals by the

この結果、記憶ユニット120に記憶されている音声データ127の再生に際して、収録時の楽器等の位置関係を反映して音像形成が実現された音声が、スピーカ131L,131Rから出力される。こうした再生音声による音像位置と聴取者との位置関係の例が、図10に示されている。As a result, when the

以上説明したように、本実施形態では、モノラル形式で収録された音声データ127について、まず、抽出部210が、楽曲情報126から生成された抽出参照情報122における周波数帯域に基づいて、楽器等の音声源ごとの音声成分を抽出する。引き続き、分配部220が、抽出参照情報122における設定音像位置に対応する位置に、抽出部210により抽出された音声成分の音像が形成されるように、LチャンネルとRチャンネルとに当該音声成分を分配する。そして、加算部230が、Lチャンネルに分配された信号を加算するとともに、Rチャンネルに分配された信号を加算する。こうして生成されたLチャンネル処理データPCDL及びRチャンネル処理データPCDRに基づく音声が、音出力ユニット130L,130Rのスピーカ131L,131Rから再生出力される。As described above, in the present embodiment, for the

したがって、本実施形態によれば、音声コンテンツの収録時のチャンネル構成と異なる複数のチャンネル構成であっても、音声コンテンツの収録時における実際の音声に近付けた再生音声を生成することができる。 Therefore, according to the present embodiment, it is possible to generate reproduced sound that is close to the actual sound at the time of recording the audio content, even with a plurality of channel configurations different from the channel configuration at the time of recording the audio content.

[実施形態の変形]

本発明は、上記の実施形態に限定されるものではなく、様々な変形が可能である。[Modification of Embodiment]

The present invention is not limited to the above-described embodiment, and various modifications are possible.

例えば、上記の実施形態では、モノラル形式で収録された音声コンテンツを2チャンネルステレオ形式に変換して再生するようにした。これに対して、他のチャンネル構成間の変換を行う場合に、本発明を適用するようにしてもよい。 For example, in the above embodiment, the audio content recorded in the monaural format is converted to the 2-channel stereo format and played back. On the other hand, the present invention may be applied when converting between other channel configurations.

また、上記の実施形態では、音声源ごとの音声成分の抽出にBPFを用いたが、ローパスフィルタ(LPF)やハイパスフィルタ(HPF)を併用することもできる。 In the above embodiment, the BPF is used to extract the sound component for each sound source. However, a low-pass filter (LPF) or a high-pass filter (HPF) can be used in combination.

また、上記の実施形態における楽曲情報の種類は例示あり、他の情報を併用することもできる。 Moreover, the kind of music information in said embodiment is an illustration, and other information can also be used together.

また、上記の実施形態では、固定ディスク等の記憶ユニット120に音声コンテンツ情報が記憶されることにしたが、音声コンテンツがCD(Compact Disk)やDVD(Digital Versatile Disk)等の可搬型記録媒体に記録されるようにすることもできる。 In the above embodiment, the audio content information is stored in the

なお、上記の実施形態における制御ユニットを中央処理装置(CPU:Central Processor Unit)やDSP(Digital Signal Processor)を備えるコンピュータシステムとして構成し、制御処理部等の機能を、プログラムの実行によっても実現するようにすることができる。これらのプログラムは、CD−ROM、DVD等の可搬型記録媒体に記録された形態で取得されるようにしてもよいし、インターネットなどのネットワークを介した配送の形態で取得されるようにしてもよい。 The control unit in the above embodiment is configured as a computer system including a central processing unit (CPU: Central Processor Unit) and a DSP (Digital Signal Processor), and functions of the control processing unit and the like are also realized by executing a program. Can be. These programs may be acquired in the form recorded on a portable recording medium such as a CD-ROM or DVD, or may be acquired in the form of delivery via a network such as the Internet. Good.

100 … 音響装置

131L,131R … スピーカ

210 … 抽出部(抽出手段)

220 … 分配部(分配手段)

230 … 加算部(加算手段)100 ...

220 ... Distribution unit (distribution means)

230 ... Adder (addition means)

Claims (10)

Translated fromJapanese前記スピーカの数とは異なる数のチャンネル構成で収録が行われた音声コンテンツについて、前記収録の時における複数の音声源のそれぞれの種類情報と位置情報とを反映した音声源情報に基づいて、前記収録時におけるチャンネル構成の信号から前記複数の音声源のそれぞれが発生したと推定される音声を抽出する抽出手段と;

前記音声源情報に基づいて、前記抽出結果のそれぞれについて、前記抽出結果のそれぞれが対応する音声源が前記収録の時に位置していたと推定される位置に音像を形成する比率で、前記複数のスピーカそれぞれに対応する信号チャンネルに分配する分配手段と;

前記信号チャンネルごとに、前記分配手段による分配結果を加算する加算手段と;

を備えることを特徴とする音響装置。An acoustic device that outputs sound from a plurality of speakers to a sound field space,

For audio content recorded with a channel configuration different from the number of speakers, based on audio source information reflecting each type information and position information of a plurality of audio sources at the time of recording, Extracting means for extracting the sound estimated that each of the plurality of sound sources is generated from the signal of the channel configuration at the time of recording;

Based on the sound source information, for each of the extraction results, the plurality of speakers at a ratio that forms a sound image at a position where the sound source corresponding to each of the extraction results is estimated to have been located at the time of recording. Distribution means for distributing to each corresponding signal channel;

Adding means for adding a distribution result by the distributing means for each signal channel;

An acoustic device comprising:

前記音声源情報には、楽曲名情報、演奏者情報、演奏場所情報及び演奏楽器構成情報の少なくとも1つが含まれる、

ことを特徴とする請求項1〜3のいずれか一項に記載の音響装置。The audio content is music content,

The audio source information includes at least one of music name information, performer information, performance location information, and musical instrument configuration information.

The acoustic device according to any one of claims 1 to 3, wherein

前記スピーカの数とは異なる数のチャンネル構成で収録が行われた音声コンテンツについ、前記収録の時における複数の音声源のそれぞれの種類情報と位置情報とを反映した音声源情報に基づいて、前記収録の時におけるチャンネル構成の信号から前記複数の音声源のそれぞれが発生したと推定される音声を抽出する抽出工程と;

前記音声源情報に基づいて、前記抽出結果のそれぞれについて、前記抽出結果のそれぞれが対応する音声源が前記収録の時に位置していたと推定される位置に音像を形成する比率で、前記複数のスピーカそれぞれに対応する信号チャンネルに分配する分配工程と;

前記信号チャンネルごとに、前記分配工程における分配結果を加算する加算工程と;

を備えることを特徴とする音声再生方法。A sound image reproduction method used in an acoustic device that outputs sound from a plurality of speakers toward a sound field space,

For audio content recorded with a channel configuration of a number different from the number of speakers, based on audio source information reflecting each type information and position information of a plurality of audio sources at the time of recording, An extraction step of extracting the audio estimated to be generated by each of the plurality of audio sources from the signal of the channel configuration at the time of recording;

Based on the sound source information, for each of the extraction results, the plurality of speakers at a ratio that forms a sound image at a position where the sound source corresponding to each of the extraction results is estimated to have been located at the time of recording. A distribution step of distributing to each corresponding signal channel;

An addition step of adding the distribution results in the distribution step for each signal channel;

An audio playback method comprising:

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008007522AJP2009171262A (en) | 2008-01-17 | 2008-01-17 | Acoustic device, voice reproduction method, voice reproduction program, and recording medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008007522AJP2009171262A (en) | 2008-01-17 | 2008-01-17 | Acoustic device, voice reproduction method, voice reproduction program, and recording medium |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2009171262Atrue JP2009171262A (en) | 2009-07-30 |

Family

ID=40971949

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008007522APendingJP2009171262A (en) | 2008-01-17 | 2008-01-17 | Acoustic device, voice reproduction method, voice reproduction program, and recording medium |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP2009171262A (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2013507048A (en)* | 2009-10-05 | 2013-02-28 | ハーマン インターナショナル インダストリーズ インコーポレイテッド | System for spatial extraction of audio signals |

- 2008

- 2008-01-17JPJP2008007522Apatent/JP2009171262A/enactivePending

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2013507048A (en)* | 2009-10-05 | 2013-02-28 | ハーマン インターナショナル インダストリーズ インコーポレイテッド | System for spatial extraction of audio signals |

| US9372251B2 (en) | 2009-10-05 | 2016-06-21 | Harman International Industries, Incorporated | System for spatial extraction of audio signals |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN102687536B (en) | System for the spatial extraction of audio signal | |

| TWI489887B (en) | Virtual audio processing for loudspeaker or headphone playback | |

| JP6484605B2 (en) | Automatic multi-channel music mix from multiple audio stems | |

| CN102100088B (en) | Apparatus and method for generating an audio output signal using object-based metadata | |

| US7725203B2 (en) | Enhancing perceptions of the sensory content of audio and audio-visual media | |

| KR20100063092A (en) | A method and an apparatus of decoding an audio signal | |

| JP2002199500A (en) | Virtual sound image localizing processor, virtual sound image localization processing method and recording medium | |

| JP2019533195A (en) | Method and related apparatus for editing audio signals using isolated objects | |

| JP5931182B2 (en) | Apparatus, method and computer program for generating a stereo output signal for providing additional output channels | |

| JP2010288262A (en) | Signal processing apparatus | |

| JP2005157278A (en) | Apparatus, method, and program for creating all-around acoustic field | |

| JP2003333700A (en) | Surround headphone output signal generating apparatus | |

| JP2019080188A (en) | Audio system and vehicle | |

| JP2009171262A (en) | Acoustic device, voice reproduction method, voice reproduction program, and recording medium | |

| JP4797065B2 (en) | Audio signal processing apparatus and surround signal generation method, etc. | |

| US20240098443A1 (en) | Dynamic acoustic control systems and methods | |

| JP4392040B2 (en) | Acoustic signal processing apparatus, acoustic signal processing method, acoustic signal processing program, and computer-readable recording medium | |

| JP2009086481A (en) | Sound device, reverberations-adding method, reverberations-adding program, and recording medium thereof | |

| JP2009206612A (en) | Audio apparatus, sound reproduction method, sound reproduction program and recording medium thereof | |

| US12395804B1 (en) | System and method for an audio reproduction device | |

| JP2001218300A (en) | Sound filed display method and sound signal output device | |

| Geluso | Mixing and Mastering | |

| JP2007181135A (en) | Specific musical instrument signal separation method and instrument, and musical instrument speaker system and music reproduction system equipped with the method and the instrument | |

| JP6519507B2 (en) | Acoustic signal transfer method and reproduction apparatus | |

| JP3163184U (en) | Audio playback device |