JP2008172485A - Stream data generating apparatus and reproducing apparatus - Google Patents

Stream data generating apparatus and reproducing apparatusDownload PDFInfo

- Publication number

- JP2008172485A JP2008172485AJP2007003264AJP2007003264AJP2008172485AJP 2008172485 AJP2008172485 AJP 2008172485AJP 2007003264 AJP2007003264 AJP 2007003264AJP 2007003264 AJP2007003264 AJP 2007003264AJP 2008172485 AJP2008172485 AJP 2008172485A

- Authority

- JP

- Japan

- Prior art keywords

- subject

- moving image

- stream data

- data

- identification information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Landscapes

- Television Signal Processing For Recording (AREA)

- Studio Devices (AREA)

Abstract

Translated fromJapaneseDescription

Translated fromJapanese本発明は、ストリームデータ(ストリーム形式のデータ)の生成及び再生のための技術に関し、特に被写体のメタデータを含むストリームデータを生成及び再生する技術に関する。 The present invention relates to a technique for generating and reproducing stream data (stream format data), and more particularly to a technique for generating and reproducing stream data including metadata of a subject.

従来、被写体の映像を容易に識別するための被写体識別システムが知られている。すなわち、特許文献1には、動画像の撮影を行いながら、被写体に取り付けられた無線タグから被写体の識別情報を示す電波を受信し、動画データ及び被写体の識別情報などをそれぞれ記録する被写体識別システムが記載されている。

しかしながら、特許文献1に記載の技術では、動画データと被写体に関するデータとがそれぞれ別々のDBに分離して記憶されている。従って、映像データと被写体データとを別々に管理しなければならず、複写する際などにいずれか一方を複写し忘れるおそれがあった。さらに、データの本数が増加すれば、その管理の手間は飛躍的に増大する。 However, in the technique described in Patent Document 1, moving image data and data related to a subject are separately stored in separate DBs. Therefore, the video data and the subject data must be managed separately, and there is a possibility that one of them is forgotten to be copied when copying. Furthermore, if the number of data increases, the management effort will increase dramatically.

また、特許文献1の技術では、画像において各被写体が写っている位置は大まかにしか把握できないので、複数の被写体が同一画面に写っているときに、それらを正確に判別できないことがある。 Further, in the technique of Patent Document 1, since the position where each subject appears in the image can only be roughly grasped, when a plurality of subjects appear on the same screen, they may not be accurately determined.

そこで、本発明の目的は、動画像の撮影に並行して被写体に関する情報を取得したときに、動画データ及び被写体データの管理を容易にするための技術を提供することである。 Accordingly, an object of the present invention is to provide a technique for facilitating management of moving image data and subject data when information about the subject is acquired in parallel with the shooting of a moving image.

本発明の他の目的は、動画像の撮影に並行して被写体に関する情報を取得したときに、画像内での被写体のより正確な位置を把握するための技術を提供することである。 Another object of the present invention is to provide a technique for grasping a more accurate position of a subject in an image when information about the subject is acquired in parallel with the shooting of a moving image.

本発明のさらに別の目的は、動画像に写っている被写体のメタデータの提供を容易にすることである。 Still another object of the present invention is to facilitate provision of metadata of a subject shown in a moving image.

本発明の一実施態様に従うストリームデータの生成装置は、動画像を撮影する動画撮影手段と、前記動画撮影手段で撮影を行っているときに、被写体からの無線信号を受信する無線手段と、前記動画撮影手段が撮影した動画像に関する動画データと、前記無線受信手段が受信した無線信号に基づく被写体データとを関連づけたストリームデータを生成するストリームデータ生成手段と、前記ストリームデータ生成手段が生成したストリームデータを記憶するストリームデータ記憶手段と、を備える。 An apparatus for generating stream data according to an embodiment of the present invention includes a moving image capturing unit that captures a moving image, a wireless unit that receives a radio signal from a subject when the moving image capturing unit is capturing, Stream data generating means for generating stream data associating moving image data related to a moving image captured by the moving image capturing means with subject data based on a wireless signal received by the wireless receiving means, and a stream generated by the stream data generating means Stream data storage means for storing data.

好適な実施形態では、前記ストリームデータ生成手段は、前記動画撮影手段の視野に含まれている被写体からの無線信号に基づく被写体データと、前記動画データとを関連づけるようにしてもよい。 In a preferred embodiment, the stream data generation means may associate the subject data based on a radio signal from a subject included in the field of view of the moving picture photographing means and the moving picture data.

好適な実施形態では、前記視野内で複数の被写体が重なって写っている場合、前記受信したそれぞれの被写体からの無線信号に基づいて、手前の被写体を特定する奥行き判定手段をさらに備えてもよい。このとき、前記ストリームデータ生成手段は、前記特定された手前の被写体の被写体データを優先させて前記動画データと関連づけるようにしてもよい。 In a preferred embodiment, when a plurality of subjects overlap and appear in the field of view, the image processing apparatus may further include a depth determination unit that identifies a front subject based on the received wireless signals from the respective subjects. . At this time, the stream data generation unit may associate the subject data of the specified near subject with priority with the moving image data.

好適な実施形態では、前記ストリームデータは、フレーム別画像の画像データと、各フレーム別画像に写っている被写体の被写体データとを対応付けることによって構成することもできる。 In a preferred embodiment, the stream data may be configured by associating image data of a frame-by-frame image with subject data of a subject in each frame-by-frame image.

好適な実施形態では、前記無線手段は、前記動画撮影手段の光軸と同一方向へ指向した、所定の問い合わせ信号を発信する発信手段と、前記被写体に取り付けられた無線装置からの前記問い合わせ信号に対する応答信号を受信する受信手段とを備えるようにしてもよい。このとき、前記発信手段は、前記動画撮影手段の画角と同じ角度になるように、前記問い合わせ信号の広がる角度を制御することができる。 In a preferred embodiment, the wireless unit is configured to transmit a predetermined inquiry signal directed in the same direction as the optical axis of the moving image photographing unit, and to the inquiry signal from the wireless device attached to the subject. You may make it provide the receiving means which receives a response signal. At this time, the transmission means can control the angle at which the inquiry signal spreads so as to be the same angle as the angle of view of the moving image photographing means.

好適な実施形態では、前記受信手段が受信した前記被写体からの応答信号の受信角度と前記動画撮影手段の画角とに基づいて、前記視野内での前記被写体の位置を特定する被写体位置特定手段をさらに備えてもよい。このとき、前記被写体からの無線信号には、当該被写体の識別情報が含まれていて、前記被写体データには、少なくとも前記視野内での被写体位置及び前記被写体の識別情報が含まれるようにしてもよい。 In a preferred embodiment, subject position specifying means for specifying the position of the subject in the field of view based on the reception angle of the response signal from the subject received by the receiving means and the angle of view of the moving image photographing means. May be further provided. At this time, the wireless signal from the subject includes identification information of the subject, and the subject data includes at least the subject position in the field of view and the identification information of the subject. Good.

本発明の他の実施態様に従うストリームデータの再生装置は、動画像に関する動画データと、前記動画像に写っている被写体の識別情報を含む被写体データとを関連づけたストリームデータを記憶するストリームデータ記憶手段と、前記被写体の識別情報を含む被写体のメタデータを記憶したメタデータ記憶手段と、前記ストリームデータ記憶手段に記憶されているストリームデータに基づいて、表示装置に動画像を再生表示させる動画再生手段と、前記ストリームデータに含まれている被写体の識別情報に基づいて、前記表示装置で再生表示されている動画像に写っている被写体のメタデータを前記メタデータ記憶手段から取得して出力する出力手段と、を備える。 A stream data reproducing apparatus according to another embodiment of the present invention is a stream data storage unit that stores stream data in which moving image data relating to a moving image is associated with subject data including identification information of the subject in the moving image. Metadata storage means for storing subject metadata including the subject identification information, and moving image playback means for playing back and displaying a moving image on a display device based on the stream data stored in the stream data storage means And, based on the identification information of the subject included in the stream data, obtains and outputs the metadata of the subject in the moving image reproduced and displayed on the display device from the metadata storage means Means.

好適な実施形態では、前記動画再生手段によって動画像が生成されているとき、あるいはその動画像再生の一時停止中に、前記表示装置に表示されている画像像に含まれる被写体の選択を受け付ける選択手段をさらに備え、前記出力手段は、前記選択された被写体のメタデータを、前記メタデータ記憶手段から取得して出力するようにしてもよい。 In a preferred embodiment, the selection for accepting selection of a subject included in the image displayed on the display device when the moving image is generated by the moving image reproducing means or during the pause of the moving image reproduction And a means for acquiring the metadata of the selected subject from the metadata storage means and outputting the metadata.

好適な実施形態では、前記被写体データには、少なくとも、前記動画データのフレーム画像に写っている被写体の、当該フレーム画像内での被写体位置及び前記被写体の識別情報が含まれていてもよい。このとき、前記選択手段は、所定のポインタを用いて前記フレーム画像が前記表示装置に表示されているときに被写体の選択を受け付けると、選択されたときのポインタ位置及び前記被写体データに基づいて選択された被写体を特定するように構成してもよい。 In a preferred embodiment, the subject data may include at least a subject position in the frame image and identification information of the subject of the subject shown in the frame image of the moving image data. At this time, when the selection means accepts selection of a subject when the frame image is displayed on the display device using a predetermined pointer, the selection means selects based on the pointer position at the time of selection and the subject data. It is also possible to configure so as to identify the subject.

以下、本発明の一実施形態に係るストリームデータ生成システムについて、図面を参照して説明する。 Hereinafter, a stream data generation system according to an embodiment of the present invention will be described with reference to the drawings.

図1は、本実施形態に係るストリームデータ生成及び再生システム1の機能構成図であり、図2は、本実施形態に係るストリームデータ生成及び再生システム1で被写体を撮影する際のビデオカメラ等の配置を示す図である。 FIG. 1 is a functional configuration diagram of a stream data generation and playback system 1 according to the present embodiment. FIG. 2 illustrates a video camera or the like when shooting a subject with the stream data generation and playback system 1 according to the present embodiment. It is a figure which shows arrangement | positioning.

本実施形態に係るストリームデータ生成及び再生システム1は、動画撮影を行うとともに、被写体からの無線信号を受信して、動画データと被写体データとを関連づけたストリームデータを生成するものである。特に、本実施形態では、被写体に無線装置としてRFID(Radio Frequency Identification)タグを予め取り付けておき、動画撮影と並行してRFIDタグからの無線信号を所定のリーダで読み取ることにより、動画データ及び被写体データを取得するものを一例に挙げて説明する。しかしながら、本発明にとってRFIDを用いることは必須ではない。すなわち、被写体ないし被写体に取り付けられた所定の装置からの信号を受信することによって、被写体及びその位置を特定できればよいので、他の方法による無線通信、あるいは赤外線による通信などを用いることもできる。 The stream data generation and reproduction system 1 according to the present embodiment performs moving image shooting, receives a wireless signal from a subject, and generates stream data in which the moving image data and the subject data are associated with each other. In particular, in this embodiment, an RFID (Radio Frequency Identification) tag is attached to the subject as a wireless device in advance, and the wireless signal from the RFID tag is read by a predetermined reader in parallel with the moving image shooting, thereby moving the moving image data and the subject. An example of obtaining data will be described. However, it is not essential to use RFID for the present invention. That is, it is only necessary to be able to identify the subject and its position by receiving a signal from the subject or a predetermined device attached to the subject, so that wireless communication by other methods or infrared communication can also be used.

ストリームデータ生成及び再生システム1は、図1に示すように、ストリームデータ処理装置10に、ビデオカメラ11と、RFIDタグの読み取りを行うリーダ(カメラ連動リーダ13及び固定リーダ15)と、表示装置2と入力装置3とが接続されている。ストリームデータ処理装置10は、その内部機能として、リーダ制御部17と、ストリームデータを生成するストリームデータ生成部21と、被写体の位置を検出する被写体位置検出部23と、ストリームデータを記憶するストリームデータ記憶部25と、被写体に関するメタデータを記憶するメタデータ記憶部27と、ストリームデータ及びメタデータを出力する出力制御部29とを備える。 As shown in FIG. 1, the stream data generation and playback system 1 includes a stream

ストリームデータ処理装置10は、例えば汎用的なコンピュータシステムにより構成され、以下に説明するストリームデータ処理装置10内の個々の構成要素または機能は、例えば、コンピュータプログラムを実行することにより実現される。 The stream

ビデオカメラ11は、被写体の動画撮影を行う。例えば、このビデオカメラ11には、一般的なディジタルビデオカメラを用いることができる。撮影した動画データ及び音声データは、ストリームデータ生成部21へ渡される。 The

被写体に取り付けられたRFIDタグ5(5a〜c)の読み取りを行うリーダには、カメラ連動リーダ13及び固定リーダ15がある。カメラ連動リーダ13及び固定リーダ15は、それぞれ、予め被写体に取り付けられているRFIDタグ5からの無線信号を読み取る。 Readers that read the RFID tag 5 (5a to 5c) attached to the subject include a camera-linked

RFIDタグ5には、電源を内蔵して自ら電波を発信する能動型、及び電源を内蔵せずにリーダからの問い合わせ信号に応答する電波を発信する受動型のいずれを用いてもよい。以下の実施形態では、受動型のRFIDタグ5を用いた場合を例に説明する。 The RFID tag 5 may be either an active type that has a built-in power supply and transmits a radio wave itself, or a passive type that does not have a built-in power supply and transmits a radio wave that responds to an inquiry signal from a reader. In the following embodiment, a case where a passive RFID tag 5 is used will be described as an example.

カメラ連動リーダ13及び固定リーダ15は、それぞれ、問い合わせ信号を発信する発信部131,151と、RFIDタグ5からの応答信号を受信する受信部132,152を備えている。応答信号には、少なくとも、それぞれのRFIDが付されている各被写体を識別するための識別情報(被写体ID)が含まれている。 The camera-linked

RFIDタグ5(5a,5b,5c)が取り付けられている被写体A,B,Cと、ビデオカメラ11、カメラ連動リーダ13及び固定リーダ15は、例えば図2のように配置されていてもよい。 The subjects A, B, and C to which the RFID tags 5 (5a, 5b, and 5c) are attached, the

つまり、カメラ連動リーダ13は、ビデオカメラ11と連動して移動するように構成されている。そして、カメラ連動リーダ13は、ビデオカメラ11と実質的に同じ位置から問い合わせ信号を発信し、これに対するRFID5からの応答信号を受信する。例えば、カメラ連動リーダ13は、問い合わせ信号をビデオカメラ11の光軸と同一方向へ指向させて発信するようにしてもよい。このとき、さらに、問い合わせ信号の広がる範囲が、ビデオカメラ11の画角と一致するようにしてもよい。つまり、ビデオカメラ11の画角の変化に連動して、問い合わせ信号の出力角度も変化させるようにしてもよい。この制御は、後述するように、リーダ制御部17からの制御信号に従って行う。 That is, the

一方、固定リーダ15は、図2に示すように、所定の固定された位置に配置されていて、ここから被写体に対して問い合わせ信号を発信し、これに対する応答信号を受信する。固定リーダ15は、カメラ連動リーダ13と重ならない位置に配置されていてもよい。例えば同図に示すように、カメラ連動リーダ13から被写体のいる方向へ向かうベクトルと、固定リーダ15から被写体のいる方向へ向かうベクトルとが、平行にならないような位置に、カメラ連動リーダ13及び固定リーダ15を配置してもよい。 On the other hand, as shown in FIG. 2, the

リーダ制御部17は、カメラ連動リーダ13の問い合わせ信号の出力に関する制御を行う。 The

図3は、カメラ連動リーダ13の問い合わせ信号の出力とビデオカメラ11の画角との関係を示す図である。 FIG. 3 is a diagram showing the relationship between the output of the inquiry signal from the camera-linked

例えば、同図に示すように、リーダ制御部17は、ビデオカメラ11から、現在撮影中の画角110を示す情報を取得して、カメラ連動リーダ13から出力される問い合わせ信号の広がり角度130が、この画角110に一致するようにカメラ連動リーダ13を制御する。なお、図2では、ビデオカメラ11の画角110及び問い合わせ信号の広がり角度130について、左右方向の広がりしか表現していないが、上下方向についても同様の制御が行われる。つまり、リーダ制御部17は、ビデオカメラ11から左右の画角及び上下の画角をそれぞれ取得して、カメラ連動リーダ13から出力される問い合わせ信号の左右及び上下の広がり角度が、それぞれ一致するように制御する。 For example, as shown in the figure, the

これにより、カメラ連動リーダ13は、ビデオカメラ11の視野に含まれる被写体のRFID5にだけ問い合わせ信号が届き、その結果、その視野に含まれる被写体のRFID5からのみ応答信号が返される。これを、以下に具体的に説明する。 Thereby, the camera-linked

図4及び図5には、ビデオカメラ11の画角及び問い合わせ信号の広がり角度を変動させたときの様子を示す。 4 and 5 show a state in which the angle of view of the

図4Aは、カメラ連動リーダ13が発する問い合わせ信号の広がり角度を、ビデオカメラ11の画角に連動させた結果、広がり角度が小さくなっている場合を示す。このとき、被写体A,Bには問い合わせ信号が到達するが、被写体Cには到達しない。従って、被写体A,BのRFID5a、5bが応答信号を発信し、被写体CのRFID5cは応答信号を発信しない。 FIG. 4A shows a case where the spread angle is reduced as a result of linking the spread angle of the inquiry signal issued by the camera-linked

また、このときのビデオカメラ11の視野20は、図5Aに示すようになっている。つまり、被写体A、Bが視野20に入っており、被写体Cは視野20に含まれない。 Further, the

また、図4Bは、カメラ連動リーダ13が発する問い合わせ信号の広がり角度を、ビデオカメラ11の画角に連動させた結果、広がり角度が大きくなっている場合を示す。このとき、被写体A,B及びCのすべてに問い合わせ信号が到達し、すべての被写体A〜CのRFID5a〜cが応答信号を発信している。 FIG. 4B shows a case where the spread angle is increased as a result of linking the spread angle of the inquiry signal issued by the camera-linked

このときのビデオカメラ11の視野20は、図5Bに示すようになっている。つまり、被写体A、B及びCのいずれもが視野20に入っている。 The

このように、カメラ連動リーダ13が発する問い合わせ信号の広がり角度を、ビデオカメラ11の画角に連動させることにより、視野に含まれる、つまりビデオカメラ11で撮影している映像に写っている被写体だけから応答信号受信するようにできる。 In this way, by associating the spread angle of the inquiry signal generated by the camera-linked

再び図1を参照すると、被写体位置検出部23は、カメラ連動リーダ13及び固定リーダ15の出力と、ビデオカメラ11の画角に基づいて、被写体の位置を検出する。 Referring again to FIG. 1, the subject

例えば、カメラ連動リーダ13は、受信した応答信号がどの方向から送られてきた方向を特定するために、応答信号の受信角度を検出する。そして、被写体位置検出部23は、カメラ連動リーダ13から、この応答信号に含まれる被写体ID及びその受信角度を取得する。さらに、被写体位置検出部23は、その応答信号受信時の画角を示す情報をビデオカメラ11から取得する。そして、被写体位置検出部23は、これらに基づいてビデオカメラ11の視野内における被写体の相対的な位置を特定する。 For example, the camera-linked

この被写体の位置特定は、フレーム単位で行われる。例えば、被写体位置検出部23は、それぞれのフレームにおいて、視野内で被写体が写っている位置(正確に言えば被写体に付されたRFIDタグの位置)を特定する。複数の被写体が視野に含まれるときは、それぞれの位置を特定する。 The subject position is specified in units of frames. For example, the subject

例えば、図4Aに示す例では、視野20内に被写体A,Bが写っている。このとき、被写体位置検出部23は、ビデオカメラ11から画角情報、カメラ連動リーダ13から応答信号の受信角度情報を取得する。そして、被写体位置検出部23は、視野20内での被写体A,Bの位置座標を算出する。 For example, in the example shown in FIG. 4A, subjects A and B are shown in the field of

ここで、図6を用いて、被写体の位置座標の特定方法を具体的に説明する。 Here, the method for specifying the position coordinates of the subject will be specifically described with reference to FIG.

同図Aは、視野20により定まる画角と受信角度との関係を示す。ビデオカメラ11及びカメラ連動リーダ13の位置をO’とすると、位置O’から見た左右の画角及び上下の画角により視野20の範囲が定まる。ここで、カメラ連動リーダ13が視野20内にある被写体から応答信号を受信すると、視野の中心を原点Oとしたとき、原点Oからの水平方向の変位角θと垂直方向の変位角φにより、受信角度(θ,φ)が定まる。 FIG. 5A shows the relationship between the field angle determined by the field of

同図Bは、視野20を正面から見た図、つまり、ビデオカメラ11が撮影した画像である。ここで、被写体位置検出部23は、受信角度(θ,φ)を、画角を用いて視野20における(x,y)座標に変換する。つまり、被写体位置検出部23は、水平方向の変位角θと左右の画角を用いてx座標に変換し、垂直方向の変位角φと上下の画角を用いてy座標に変換することにより、視野20内での被写体位置を特定する。この(x,y)座標は、ビデオカメラ11の撮像素子の画素の位置で表してもよい。 FIG. 5B is a view of the

なお、カメラ連動リーダ13が発する問い合わせ信号の広がり角度を、ビデオカメラ11の画角に連動させないときは、視野の外にある被写体からも応答信号を受信する場合があるが、このときは、上述の応答信号の受信角度と画角を用いることにより、視野の外の被写体を識別可能である。そして、視野外の被写体の情報はフレームデータ生成部21へ通知しないようにしてもよい。 When the spread angle of the inquiry signal issued by the camera-linked

また、被写体位置検出部23は、ビデオカメラ11に対する被写体の奥行き方向の位置を特定するようにしてもよい。例えば、図2に示すように、被写体A〜Cに対して、カメラ連動リーダ13と固定リーダ15とが互いに異なる向きを向いているときに、被写体位置検出部23は、視野に含まれる複数の被写体の、ビデオカメラ11に対する前後関係(いずれが手前か)を判定する。 In addition, the subject

まず、被写体位置検出部23は、カメラ連動リーダ13から取得する情報の他に、固定リーダ15から、固定リーダ15が受信した応答信号に含まれる被写体ID及びその受信角度を取得する。そして、カメラ連動リーダ13及び固定リーダ15の位置が既知であれば、被写体位置検出部23は、被写体IDをキーにして、カメラ連動リーダ13の応答信号の受信角度と固定リーダ15の応答信号の受信角度とを組み合わせることで、少なくとも、複数の被写体の位置をビデオカメラ11から近いものから順に順位を付けることができる(例えば、最も近いものから順に、1,2,3,…と順位を付ける)。このように、各被写体のビデオカメラ11に対する近さを順位付けする特定することは、撮影した画像において、複数の被写体が重なる場合に、手前に写っている被写体を特定するために特に有効である。 First, the subject

さらに、ビデオカメラ11に対する被写体の奥行き方向の位置の特定は、カメラ連動リーダ13が受信する応答信号の受信強度によって行うようにしてもよい。奥行き方向の位置特定を行わないとき、または、カメラ連動リーダ13の受信する信号で奥行き方向の位置特定が可能なときは、固定リーダ15を省略することができる。 Further, the position of the subject in the depth direction with respect to the

また、ビデオカメラ11にRFIDタグを取り付け、固定リーダ15がそれを読み取ることにより、ビデオカメラ11の位置を特定するようにしてもよい。このときには、被写体位置検出部23がカメラ連動リーダ13及び固定リーダ15の出力に基づいて、各被写体の3次元的な位置を特定してから、各被写体のビデオカメラ11に対する近さについての位置関係を特定してもよい。 Further, an RFID tag may be attached to the

被写体位置検出部23は、各フレームについて、被写体ID別に、それぞれの被写体位置(座標)及びビデオカメラ11に対する近さの順位をフレームデータとして、ストリームデータ生成部21へ通知する。 The subject

ストリームデータ生成部21は、ビデオカメラ11から動画データを取得し、被写体位置検出部23からフレームデータを取得すると、これらをフレームごとに互いに関連づけてストリームデータを生成し、ストリームデータ記憶部25へ格納する。 When the stream

このとき、ビデオカメラ11の視野内で、複数の被写体間の距離が所定距離以内の近さであるときは、手前(つまりビデオカメラ11側)に位置する被写体に関するデータを、動画データに優先させて関連づけるようにしてもよい。被写体間の距離が所定距離以内とは、例えば、ビデオカメラ11が撮影した映像において重なってしまう程度近いような場合である。ここで、優先させて関連づけるとは、例えば、手前の被写体に関するデータのみを動画データと関連づけて記憶し、奥に位置する被写体のデータは関連づけないようにしてもよいし、手前側の被写体から順に、優先順位を付けて関連づけるようにしてもよい。 At this time, if the distance between the plurality of subjects is within a predetermined distance within the field of view of the

ストリームデータ記憶部25は、ストリームデータ生成部21で生成されたストリームデータ250を記憶する。 The stream

メタデータ記憶部27は、被写体に関するメタデータ270が予め記憶されている。 The

図7に、ストリームデータ記憶部25及びメタデータ記憶部27のデータ構造の一例を示す。 FIG. 7 shows an example of the data structure of the stream

ストリームデータ記憶部25は、同図Aに示すように、フレームNo251と、そのフレームの画像データ252及び音声データ253と、そのフレームと関連づけられた被写体ID254及びフレーム内の被写体位置255とを含む。一つのフレームに複数の被写体が写っているときは、被写体ID254及び被写体位置255を、各被写体分だけ追加してもよい。また、被写体位置254は、省略してもよい。 The stream

メタデータ記憶部27に格納されるメタデータは、例えば、同図Bに示すように、被写体ID271と、被写体名称272と、被写体属性273と、参照情報274とを含む。参照情報274は、例えば、その被写体と関連する情報にアクセスするためのURL(Universal Resource Locator)などのリンク情報でもよい。 The metadata stored in the

出力制御部29は、ストリームデータ記憶部25に記憶されているストリームデータ250に基づいて、所定の表示装置2に対して動画データを、動画再生可能に出力する。これにより、ストリームデータ250を通常のビデオ映像と同様に動画再生することができる。 Based on the

また、出力制御部29は、ストリームデータ250に含まれている被写体のデータと、メタデータ記憶部27のメタデータ270に基づいて、動画に写っている被写体のメタデータ270を出力する。例えば、表示装置2において動画再生中、または、動画再生の一時停止中に、動画の視聴者から、入力装置3を用いて映像に写っている被写体の選択を受け付けると、出力制御部29は、その選択された被写体のメタデータ270をメタデータ記憶部27から取得して、表示装置2に表示させる。 Further, the

被写体の選択は、例えば、図5Bに示すように、表示装置2にポインタ201を表示させ、写っている被写体を選択させるようにしてもよい。 For the selection of the subject, for example, as shown in FIG. 5B, the

ここで、図5を参照して、表示装置2に表示される画像について説明する。 Here, an image displayed on the

同図に示すように、表示装置2にフレームごとに撮影された画像が表示される。例えば、同図Bに示すフレームNo222の場合のように、視聴者が入力装置3に対して所定の操作を行って、ポインタ201を用いて被写体Aを選択したとすると、吹き出し202に被写体Aのメタデータが表示される。なお、ここでは被写体をポインタを用いて選択しているが、ポインタではなく、別の方法で被写体を選択してもよい。 As shown in the figure, an image taken for each frame is displayed on the

このときの処理は、例えば以下のように行う。すなわち、視聴者が被写体Aを選択すると、このときのポインタ201の位置が、入力装置3から出力制御部29へ通知される。出力制御部29は、この通知を受けると、現在のフレームにおける、通知されたポインタ位置近傍の被写体位置255を有する被写体ID254を特定し、その被写体ID271の被写体名称272、被写体属性273及び参照情報274を取得して、表示装置2に表示させている。なお、ポインタ位置から被写体位置255までの距離が所定距離より近い被写体が複数あるとき、それら複数の被写体について、被写体名称272、被写体属性273及び参照情報274のうちの一つ以上を表示するようにしてもよい。 The process at this time is performed as follows, for example. That is, when the viewer selects the subject A, the position of the

なお、ストリームデータ250に被写体位置255が含まれていないときは、そのフレームに含まれる全被写体の被写体名称272を表示装置2に一覧表示させて、その中からさらに視聴者に選択させて、被写体属性273及び参照情報274を表示させるようにしてもよい。さらに、ユーザが選択したフレームに、優先順位がつけられて複数の被写体データが格納されているときは、その優先順位に従って表示するようにしてもよい。 When the

次に、上述のような構成を備えたストリームデータ生成及び再生システム1における処理手順について説明する。 Next, a processing procedure in the stream data generation and reproduction system 1 having the above configuration will be described.

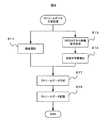

図8は、ストリームデータの生成手順を示すフローチャートである。 FIG. 8 is a flowchart showing a stream data generation procedure.

まず、ビデオカメラ11で動画撮影を行う(S11)。 First, moving image shooting is performed with the video camera 11 (S11).

これと並行して、カメラ連動リーダ13及び固定リーダ15が、被写体に付けられているRFIDからの無線信号を受信する(S13)。被写体位置検出部23は、この無線信号の受信角度及び視野の画角に基づいて、被写体の位置検出を行う(S14)。 In parallel with this, the camera-linked

そして、ストリームデータ生成部21が、動画データ及び被写体データを関連づけて、ストリームデータを生成し(S17)、ストリームデータ記憶部25へ格納する(S18)。 Then, the stream

これにより、動画データ及びその動画に写っている被写体のデータを、ストリームデータとして一体に管理することができ、データの取扱が容易になる。 Thereby, the moving image data and the data of the subject appearing in the moving image can be integrally managed as stream data, and handling of the data becomes easy.

図9は、ストリームデータの再生手順を示すフローチャートである。 FIG. 9 is a flowchart showing a playback procedure of stream data.

出力制御部29は、ストリームデータ記憶部25からストリームデータを取得して、表示装置2に動画再生する(S21)。出力制御部29は、この動画再生中、あるいは一時停止中に、表示されている画像に対して被写体が入力装置3のポインタなどを使って選択されたか否かを判定する(S23)。 The

ここで、被写体が選択されると(S23:Yes)、出力制御部29は、ストリームデータ記憶部25を参照し、ポインタ位置に基づいて被写体を特定する(S25)。そして、特定された被写体のメタデータをメタデータ記憶部27から取得し、表示装置2に表示させる(S27)。 Here, when a subject is selected (S23: Yes), the

なお、ステップS23の被写体の選択を行わなくても、再生中の動画に写っている被写体のメタデータを表示装置2に表示させてもよい。 Note that the metadata of the subject in the moving image being played back may be displayed on the

これにより、視聴者は、動画像の再生中に、その映像に写っている被写体のメタデータを簡単に取得することができる。 Thereby, the viewer can easily acquire the metadata of the subject in the video during playback of the moving image.

さらに、ストリームデータには、画像内での被写体の位置が含まれているので、視聴者がより簡単な操作で被写体を選択することができる。 Furthermore, since the stream data includes the position of the subject in the image, the viewer can select the subject with a simpler operation.

上述した本発明の実施形態は、本発明の説明のための例示であり、本発明の範囲をそれらの実施形態にのみ限定する趣旨ではない。当業者は、本発明の要旨を逸脱することなしに、他の様々な態様で本発明を実施することができる。 The above-described embodiments of the present invention are examples for explaining the present invention, and are not intended to limit the scope of the present invention only to those embodiments. Those skilled in the art can implement the present invention in various other modes without departing from the gist of the present invention.

例えば、上述の実施形態でストリームデータ処理装置10に含まれる構成要素を一つのコンピュータマシン上に実現してもよいし、ストリームデータ記憶部25,メタデータ記憶部27及び出力制御部29は、他の構成要素とは別のコンピュータマシン上に実現してもよい。 For example, the constituent elements included in the stream

さらに、入力装置3及び表示装置2は、例えば、インターネットなどの所定のネットワークを介して接続されていてもよい。このとき、表示装置2及び入力装置3は、ネットワークに接続されたコンピュータマシン、あるいはテレビ受信機により実現することができる。 Furthermore, the

また、メタデータは、必ずしも動画像を表示する表示装置と同一の表示装置に出力する必要はなく、別の出力装置に出力してもよい。 The metadata is not necessarily output to the same display device as the display device that displays the moving image, and may be output to another output device.

1 ストリームデータ生成及び再生システム

2 表示装置

3 入力装置

5 タグ

10 ストリームデータ処理装置

11 ビデオカメラ

13 カメラ連動リーダ

15 固定リーダ

17 リーダ制御部

20 視野

21 ストリームデータ生成部

23 被写体位置検出部

25 ストリームデータ記憶部

27 メタデータ記憶部

29 出力制御部DESCRIPTION OF SYMBOLS 1 Stream data production | generation and reproduction |

Claims (13)

Translated fromJapanese前記動画撮影手段で撮影を行っているときに、被写体からの無線信号を受信する無線手段と、

前記動画撮影手段が撮影した動画像に関する動画データと、前記無線受信手段が受信した無線信号に基づく被写体データとを関連づけたストリームデータを生成するストリームデータ生成手段と、

前記ストリームデータ生成手段が生成したストリームデータを記憶するストリームデータ記憶手段と、を備えるストリームデータの生成装置。A video shooting means for shooting moving images;

A wireless means for receiving a wireless signal from a subject when photographing with the moving image photographing means;

Stream data generating means for generating stream data associating moving image data relating to a moving image captured by the moving image capturing means with subject data based on a wireless signal received by the wireless receiving means;

A stream data generation apparatus comprising: stream data storage means for storing stream data generated by the stream data generation means.

前記ストリームデータ生成手段は、前記特定された手前の被写体の被写体データを優先させて前記動画データと関連づけることを特徴とする請求項2記載のストリームデータの生成装置。When a plurality of subjects are reflected in the field of view, further comprising a depth determination means for identifying the subject in front based on the received wireless signal from each subject,

3. The stream data generation device according to claim 2, wherein the stream data generation means prioritizes subject data of the identified near subject and associates it with the moving image data.

前記発信手段は、前記動画撮影手段の画角と同じ角度になるように、前記問い合わせ信号の広がる角度を制御することを特徴とする請求項1記載のストリームデータの生成装置。The wireless means is a transmitting means for transmitting a predetermined inquiry signal directed in the same direction as the optical axis of the moving image photographing means; and a reception means for receiving a response signal for the inquiry signal from a wireless device attached to the subject. Means and

2. The stream data generating apparatus according to claim 1, wherein the transmission unit controls an angle at which the inquiry signal spreads so that the angle of view is the same as the angle of view of the moving image photographing unit.

前記被写体からの無線信号には、当該被写体の識別情報が含まれていて、

前記被写体データには、少なくとも前記視野内での被写体位置及び前記被写体の識別情報が含まれることを特徴とする請求項5記載のストリームデータの生成装置。Subject position specifying means for specifying the position of the subject in the field of view based on the reception angle of the response signal from the subject received by the receiving means and the angle of view of the moving image shooting means;

The wireless signal from the subject includes identification information of the subject,

6. The stream data generation apparatus according to claim 5, wherein the subject data includes at least a subject position in the field of view and identification information of the subject.

前記被写体の識別情報を含む被写体のメタデータを記憶したメタデータ記憶手段と、

前記ストリームデータ記憶手段に記憶されているストリームデータに基づいて、表示装置に動画像を再生表示させる動画再生手段と、

前記ストリームデータに含まれている被写体の識別情報に基づいて、前記表示装置で再生表示されている動画像に写っている被写体のメタデータを前記メタデータ記憶手段から取得して出力する出力手段と、を備えるストリームデータの再生装置。Stream data storage means for storing stream data in which moving image data relating to a moving image is associated with subject data including identification information of a subject reflected in the moving image;

Metadata storage means for storing subject metadata including identification information of the subject;

A moving image reproduction means for reproducing and displaying a moving image on a display device based on the stream data stored in the stream data storage means;

Output means for acquiring and outputting metadata of a subject in a moving image reproduced and displayed on the display device from the metadata storage means based on identification information of the subject included in the stream data; , A stream data reproducing apparatus.

前記出力手段は、前記選択された被写体のメタデータを、前記メタデータ記憶手段から取得して出力することを特徴とする請求項7記載のストリームデータの再生装置。A selection means for accepting selection of a subject included in the image displayed on the display device when a moving image is generated by the moving image reproduction means or during the pause of the moving image reproduction;

8. The stream data reproducing apparatus according to claim 7, wherein the output unit acquires and outputs the metadata of the selected subject from the metadata storage unit.

前記選択手段は、所定のポインタを用いて前記フレーム画像が前記表示装置に表示されているときに被写体の選択を受け付けると、選択されたときのポインタ位置及び前記被写体データに基づいて選択された被写体を特定することを特徴とする請求項8記載のストリームデータの再生装置。The subject data includes at least a subject position in the frame image and identification information of the subject of the subject in the frame image of the moving image data,

When the selection unit receives a subject selection when the frame image is displayed on the display device using a predetermined pointer, the selection unit selects the subject selected based on the pointer position at the time of selection and the subject data 9. The apparatus for reproducing stream data according to claim 8, wherein:

前記動画を撮影しているときに、被写体からの無線信号を受信するステップと、

前記撮影した動画像に関する動画データと、前記受信した無線信号に基づく被写体データとを関連づけたストリームデータを生成するステップと、

前記生成したストリームデータを記憶装置に記憶するステップと、を有するストリームデータの生成方法。A step of shooting a moving image;

Receiving a wireless signal from a subject when shooting the video;

Generating stream data associating moving image data relating to the captured moving image and subject data based on the received wireless signal;

Storing the generated stream data in a storage device.

動画像を撮影して得られた動画データを取得するステップと、

動画を撮影しているときに、被写体から受信した無線信号に基づく前記被写体に関する被写体データを取得するステップと、

前記取得した動画データと、前記取得した被写体データとを関連づけたストリームデータを生成するステップと、

前記生成したストリームデータを記憶装置に記憶するステップと、をコンピュータに実行させるためのコンピュータプログラム。A computer program for generating stream data,

Acquiring moving image data obtained by shooting a moving image;

Obtaining subject data relating to the subject based on a wireless signal received from the subject when shooting a video;

Generating stream data associating the acquired moving image data with the acquired subject data;

A computer program for causing a computer to execute the step of storing the generated stream data in a storage device.

前記ストリームデータに含まれている被写体の識別情報に基づいて、前記表示装置で再生表示されている動画像に写っている被写体のメタデータを出力するステップと、を有するストリームデータの再生方法。Replaying and displaying a moving image on a display device based on stream data relating moving image data relating to the moving image and subject data including identification information of a subject appearing in the moving image;

Outputting metadata of a subject in a moving image reproduced and displayed on the display device based on identification information of the subject included in the stream data.

動画像に関する動画データと、前記動画像に写っている被写体の識別情報を含む被写体データとを関連づけたストリームデータに基づいて、表示装置で動画を再生させるステップと、

前記ストリームデータに含まれている被写体の識別情報に基づいて、前記表示装置で再生表示されている動画像に写っている被写体のメタデータを出力するステップと、をコンピュータに実行させるためのコンピュータプログラム。A computer program for reproducing stream data,

Replaying a moving image on a display device based on stream data relating moving image data relating to a moving image and subject data including identification information of a subject appearing in the moving image;

A computer program for causing a computer to execute, based on identification information of a subject included in the stream data, outputting metadata of a subject reflected in a moving image reproduced and displayed on the display device .

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007003264AJP2008172485A (en) | 2007-01-11 | 2007-01-11 | Stream data generating apparatus and reproducing apparatus |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007003264AJP2008172485A (en) | 2007-01-11 | 2007-01-11 | Stream data generating apparatus and reproducing apparatus |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2008172485Atrue JP2008172485A (en) | 2008-07-24 |

Family

ID=39700167

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2007003264APendingJP2008172485A (en) | 2007-01-11 | 2007-01-11 | Stream data generating apparatus and reproducing apparatus |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP2008172485A (en) |

Cited By (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010257239A (en)* | 2009-04-24 | 2010-11-11 | Yahoo Japan Corp | Information transmission system and method |

| JP2011527527A (en)* | 2008-06-18 | 2011-10-27 | リヴゼイ,カール | Tag product information |

| WO2014073454A1 (en)* | 2012-11-09 | 2014-05-15 | ソニー株式会社 | Information processing device, information processing method, and recording medium |

| WO2024025086A1 (en)* | 2022-07-29 | 2024-02-01 | 삼성전자 주식회사 | Electronic device and method for displaying image on basis of interaction |

- 2007

- 2007-01-11JPJP2007003264Apatent/JP2008172485A/enactivePending

Cited By (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011527527A (en)* | 2008-06-18 | 2011-10-27 | リヴゼイ,カール | Tag product information |

| JP2010257239A (en)* | 2009-04-24 | 2010-11-11 | Yahoo Japan Corp | Information transmission system and method |

| WO2014073454A1 (en)* | 2012-11-09 | 2014-05-15 | ソニー株式会社 | Information processing device, information processing method, and recording medium |

| JPWO2014073454A1 (en)* | 2012-11-09 | 2016-09-08 | ソニー株式会社 | Information processing apparatus, information processing method, and recording medium |

| US9946352B2 (en) | 2012-11-09 | 2018-04-17 | Sony Corporation | Information processing apparatus, information processing method, and recording medium |

| US10042431B2 (en) | 2012-11-09 | 2018-08-07 | Sony Corporation | Information processing apparatus, information processing method, and recording medium |

| JP2018139409A (en)* | 2012-11-09 | 2018-09-06 | ソニー株式会社 | Information processing apparatus, information processing method, and recording medium |

| US10289209B2 (en) | 2012-11-09 | 2019-05-14 | Sony Corporation | Information processing apparatus, information processing method, and recording medium |

| WO2024025086A1 (en)* | 2022-07-29 | 2024-02-01 | 삼성전자 주식회사 | Electronic device and method for displaying image on basis of interaction |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5428210B2 (en) | Information processing apparatus, imaging system, recording control method, and program | |

| US8264583B2 (en) | Information processing apparatus, method and computer program product | |

| US20070228159A1 (en) | Inquiry system, imaging device, inquiry device, information processing method, and program thereof | |

| JP4717539B2 (en) | Imaging apparatus and imaging method | |

| CA2997034A1 (en) | Method and apparatus for playing video content from any location and any time | |

| US9141190B2 (en) | Information processing apparatus and information processing system | |

| US10187575B2 (en) | Image acquisition apparatus, method of controlling image acquisition apparatus, computer-readable recording medium non-transitorily storing control program of image acquisition apparatus, and image acquisition system | |

| CN102547105A (en) | Method of generating and reproducing moving image data and photographing apparatus using the same | |

| US20190098250A1 (en) | Information processing apparatus, imaging apparatus, information processing method, and recording medium | |

| CN101729788A (en) | Image-taking apparatus, image-taking region displaying method, and image-taking region displaying program | |

| CN102300047A (en) | Image-capturing device, image reproduction device, and image reproduction method | |

| JP5786101B1 (en) | Imaging device | |

| KR20170137634A (en) | Communication apparatus, communication control method, and communication system | |

| US10070175B2 (en) | Method and system for synchronizing usage information between device and server | |

| KR101613438B1 (en) | System for augmented reality contents and method of the same | |

| JP2008172485A (en) | Stream data generating apparatus and reproducing apparatus | |

| JP2010268128A (en) | Control apparatus, imaging apparatus, imaging system, image acquisition method and program | |

| JP6724919B2 (en) | Information processing apparatus, information processing method, and program | |

| US20110221949A1 (en) | Shooting apparatus | |

| JP2010268127A (en) | Controller, imaging apparatus, imaging system, image acquisition method, and program | |

| JP6261191B2 (en) | Display control apparatus, display control method, and program | |

| US20050251741A1 (en) | Methods and apparatus for capturing images | |

| US20180359422A1 (en) | Transmission apparatus, setting apparatus, transmission method, reception method, and storage medium | |

| KR101729073B1 (en) | Method and system for switching orientation of sound according to direction changes of image showed on a display device | |

| JP6354624B2 (en) | Video imaging system, information processing terminal, video confirmation method and program |