JP2008158868A - Mobile body and control method thereof - Google Patents

Mobile body and control method thereofDownload PDFInfo

- Publication number

- JP2008158868A JP2008158868AJP2006348065AJP2006348065AJP2008158868AJP 2008158868 AJP2008158868 AJP 2008158868AJP 2006348065 AJP2006348065 AJP 2006348065AJP 2006348065 AJP2006348065 AJP 2006348065AJP 2008158868 AJP2008158868 AJP 2008158868A

- Authority

- JP

- Japan

- Prior art keywords

- sound source

- moving body

- sound

- target

- estimated

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Landscapes

- Circuit For Audible Band Transducer (AREA)

- Control Of Position, Course, Altitude, Or Attitude Of Moving Bodies (AREA)

- Toys (AREA)

- Obtaining Desirable Characteristics In Audible-Bandwidth Transducers (AREA)

Abstract

Translated fromJapaneseDescription

Translated fromJapanese本発明は、移動体、及びその制御方法に関し、特に詳しくは自律移動する移動体、及びその制御方法に関する、 The present invention relates to a mobile body and a control method thereof, and more particularly to a mobile body that autonomously moves and a control method thereof.

近年、人間が発する音声に応じて動作するロボットが開発されている。例えば、人間が発した音声を受音して、その人間に向かって移動するロボットが開発されている(特許文献1、特許文献2)。 In recent years, robots have been developed that operate in response to human voices. For example, a robot has been developed that receives a voice uttered by a human and moves toward the human (

特許文献1のロボットでは、マイクロフォンアレイによって、音源(発話した人間)の方向を推定している。さらに、超音波センサやCCDカメラによって音源までの距離を推定している。そして、音源方向に移動することによって、S/N比を向上している。 In the robot of

特許文献2のロボットでは、マイクロフォンアレイによって、人間が発した音声を受音するとともに、過去の音源の方向の履歴から、音源方向を推定している。そして、推定された音源方向に移動している。 In the robot of

しかしながら、上記のロボットでは、音源位置に直線的に移動することしかできなかった。従って、音源とロボットの間に障害物がある場合、回避することができないという問題点がある。また、障害物を回避したとしても、音源に直線的に移動するよう制御されているため、もとの経路に復帰するのが困難である。また、特許文献1では、超音波センサなどを用いて音源までの距離を推定しているが、音源までの位置が遠い場合、音源距離を正確に推定することが困難である。さらに、音源とロボットの間に障害物がある場合、音源位置を特定できないという問題点がある。このように、従来の制御では、音源に対して確実に近づけることができないという問題点があった。 However, the robot described above can only move linearly to the sound source position. Therefore, there is a problem that it cannot be avoided if there is an obstacle between the sound source and the robot. Even if an obstacle is avoided, it is difficult to return to the original route because it is controlled to move linearly to the sound source. In

本発明は、このような問題を解決するためになされたものであり、音源に対して確実に近づくことができる移動体、及びその制御方法を提供することを目的とする。 The present invention has been made to solve such a problem, and an object of the present invention is to provide a moving body that can reliably approach a sound source and a control method thereof.

本発明の第1の態様にかかる移動体は、目標停止位置まで自律移動する移動体であって、前記移動体の外部で発生した音を受音するマイクを有し、前記マイクが受音した音の前記移動体に向かう方向を前記受音方向として特定する音源方向特定手段と、前記移動体が移動する領域に応じて記憶されている地図データにおいて、音源の候補となる対象の位置を音源候補対象位置として記憶する音源候補対象記憶手段と、前記音源方向特定手段によって特定された音源の方向と、前記音源候補対象記憶手段に記憶された音源候補対象の位置とに基づいて、音源の位置を推定する音源位置推定手段と、前記音源位置推定手段によって推定された音源の位置から目標停止位置を決定する停止位置決定手段と、前記移動体の現在位置から前記停止位置決定手段で決定された目標停止位置まで前記移動体を移動させる移動手段と、を備えるものである。これによって、音源とロボットの間に障害物がある場合でも、音源に対して近づくことができる。さらに、音源候補対象の位置から目標停止位置が決定されているため、音源の推定を確実に行なうことができる。よって、音源に対して確実に近づくことができる。 The moving body according to the first aspect of the present invention is a moving body that autonomously moves to a target stop position, and has a microphone that receives sound generated outside the moving body, and the microphone receives the sound. Sound source direction specifying means for specifying a direction of sound toward the moving body as the sound receiving direction, and map data stored in accordance with a region in which the moving body moves, the position of a target sound source candidate as a sound source The position of the sound source based on the sound source candidate target storage means stored as the candidate target position, the direction of the sound source specified by the sound source direction specifying means, and the position of the sound source candidate target stored in the sound source candidate target storage means Sound source position estimating means for estimating the position, stop position determining means for determining a target stop position from the position of the sound source estimated by the sound source position estimating means, and stop position determination from the current position of the moving body A moving means for moving the moving body to the target stop position determined by means are those comprising a. Thereby, even when there is an obstacle between the sound source and the robot, the sound source can be approached. Furthermore, since the target stop position is determined from the position of the sound source candidate target, the sound source can be reliably estimated. Therefore, it is possible to reliably approach the sound source.

本発明の第2の態様にかかる移動体は、上記の移動体であって、前記音源位置推定手段が、前記音源候補対象記憶部に記憶された複数の音源候補対象のうち、前記音源方向に対して所定の角度だけ広がった領域に含まれる音源候補対象の位置に基づいて、音源の位置を推定するものである。これにより、音源の位置を正確に推定することができるので、音源に対して確実に近づくことができる。 A mobile object according to a second aspect of the present invention is the mobile object described above, wherein the sound source position estimation unit is arranged in the sound source direction among a plurality of sound source candidate targets stored in the sound source candidate target storage unit. On the other hand, the position of the sound source is estimated based on the position of the sound source candidate target included in the region expanded by a predetermined angle. Thereby, since the position of a sound source can be estimated correctly, it can approach to a sound source reliably.

本発明の第3の態様にかかる移動体は、上記の移動体であって、前記目標停止位置が前記音源候補対象記憶部に記憶された複数の音源候補対象に対応して予め設定されていることを特徴とするものである。これにより、速やかに移動することが可能となる。 A mobile object according to a third aspect of the present invention is the mobile object described above, wherein the target stop position is set in advance corresponding to a plurality of sound source candidate targets stored in the sound source candidate target storage unit. It is characterized by this. Thereby, it becomes possible to move quickly.

本発明の第4の態様にかかる移動体は、上記の移動体であって、前記音源位置推定手段によって推定された音源の位置と前記移動体の位置とに基づいて、前記停止位置決定手段が目標停止位置を算出することを特徴とするものである。これにより、状況が変わった場合でも、音源に対して確実に近づくことができる。 A moving body according to a fourth aspect of the present invention is the moving body described above, wherein the stop position determining means is based on the position of the sound source estimated by the sound source position estimating means and the position of the moving body. The target stop position is calculated. Thereby, even when the situation changes, it is possible to reliably approach the sound source.

本発明の第5の態様にかかる移動体は、上記の移動体であって、前記目標停止位置に移動した後、前記推定された音源に対して、真の音源であるか否か確認する音源確認情報を取得する音源確認手段をさらに備え、前記推定された音源が真の音源でないと確認された場合、前記音源位置推定手段が前記音源候補対象記憶部に記憶された他の音源候補対象の位置に基づいて音源の位置を推定するものである。これにより、多数の音源候補対象が存在する場合でも、真の音源に対して確実に近づくことができる。 A moving body according to a fifth aspect of the present invention is the above-described moving body, and after moving to the target stop position, a sound source that confirms whether or not the estimated sound source is a true sound source It further comprises sound source confirmation means for acquiring confirmation information, and when it is confirmed that the estimated sound source is not a true sound source, the sound source position estimation means is stored in another sound source candidate target stored in the sound source candidate target storage unit. The position of the sound source is estimated based on the position. Thereby, even when there are a large number of sound source candidate targets, the true sound source can be reliably approached.

本発明の第6の態様にかかる移動体は、上記の移動体であって、前記地図データ上において音が発生した位置の履歴に基づいて、一定時間以上、音が発生していない位置の音源候補対象を前記音源候補対象記憶手段から消去することを特徴とするものである。これにより、音源候補対象の数が過剰に増えるのを防ぐことができる。従って、速やかに音源に近づくことができる。 A mobile object according to a sixth aspect of the present invention is the mobile object described above, and a sound source at a position where no sound is generated for a predetermined time or more based on a history of positions where sound is generated on the map data. The candidate object is erased from the sound source candidate object storage means. Thereby, it is possible to prevent an excessive increase in the number of sound source candidate targets. Accordingly, the sound source can be quickly approached.

本発明の第7の態様にかかる移動体の制御方法は、目標停止位置まで自律移動する移動体の制御方法であって、前記移動体の外部で発生した音をマイクによって受音して、前記マイクが受音した音の前記移動体に向かう方向を前記受音方向として特定するステップと、前記特定された受音方向と、前記移動体が移動する領域の地図データに対して予め登録されている音源候補対象の位置とに基づいて、音源の位置を推定するステップと、前記推定された音源の位置から目標停止位置を決定するステップと、前記移動体の現在位置から前記目標停止位置まで前記移動体を移動するステップと、を備えるものである。これによって、音源とロボットの間に障害物がある場合でも、音源に対して近づくことができる。さらに、音源候補対象の位置から目標停止位置が決定されているため、音源の推定を確実に行なうことができる。よって、音源に対して確実に近づくことができる。 A control method for a mobile body according to a seventh aspect of the present invention is a control method for a mobile body that autonomously moves to a target stop position, wherein a sound generated outside the mobile body is received by a microphone, The direction of the sound received by the microphone toward the moving body is specified as the sound receiving direction, the specified sound receiving direction, and map data of the area in which the moving body moves are registered in advance. A position of a sound source based on a position of a sound source candidate target, a step of determining a target stop position from the estimated position of the sound source, and a position from the current position of the moving body to the target stop position. And a step of moving the moving body. Thereby, even when there is an obstacle between the sound source and the robot, the sound source can be approached. Furthermore, since the target stop position is determined from the position of the sound source candidate target, the sound source can be reliably estimated. Therefore, it is possible to reliably approach the sound source.

本発明の第8の態様にかかる移動体の制御方法は、上記の制御方法であって、前記音源の位置を推定するステップでは、登録されている複数の前記音源候補対象のうち、前記音源方向に対して所定の角度だけ広がった領域に含まれる音源候補対象の位置に基づいて、音源の位置を推定するものである。これにより、音源の位置を正確に推定することができるので、音源に対して確実に近づくことができる。 The moving body control method according to an eighth aspect of the present invention is the above-described control method, wherein in the step of estimating the position of the sound source, the sound source direction among the plurality of registered sound source candidate targets. The position of the sound source is estimated on the basis of the position of the sound source candidate target included in the region expanded by a predetermined angle. Thereby, since the position of a sound source can be estimated correctly, it can approach to a sound source reliably.

本発明の第9の態様にかかる移動体の制御方法は、上記の制御方法であって、前記目標停止位置が登録されている複数の前記音源候補対象に対応して予め設定されていることを特徴とするものである。これにより、速やかに移動することが可能となる。 A control method for a moving body according to a ninth aspect of the present invention is the control method described above, wherein the target stop position is set in advance corresponding to a plurality of sound source candidate targets registered. It is a feature. Thereby, it becomes possible to move quickly.

本発明の第10の態様にかかる移動体の制御方法は、上記の制御方法であって、前記推定された音源の位置と前記移動体の位置とに基づいて、前記目標停止位置が算出されることを特徴とするものである。これにより、状況が変わった場合でも、音源に対して確実に近づくことができる。 The mobile body control method according to a tenth aspect of the present invention is the control method described above, wherein the target stop position is calculated based on the estimated position of the sound source and the position of the mobile body. It is characterized by this. Thereby, even when the situation changes, it is possible to reliably approach the sound source.

本発明の第11の態様にかかる移動体の制御方法は、上記の制御方法であって、前記目標停止位置に移動した後、前記推定された音源に対して、音源であるか否か確認する音源確認情報を取得するステップと、前記音源確認情報により、前記推定された音源が真の音源でないと確認された場合、登録されている他の音源候補対象の位置に基づいて音源の位置を推定するものである。これにより、多数の音源候補対象が存在する場合でも、真の音源に対して確実に近づくことができる。 A control method for a moving body according to an eleventh aspect of the present invention is the control method described above, and checks whether the estimated sound source is a sound source after moving to the target stop position. When obtaining the sound source confirmation information and the sound source confirmation information confirms that the estimated sound source is not a true sound source, the position of the sound source is estimated based on the positions of other registered sound source candidate targets. To do. Thereby, even when there are a large number of sound source candidate targets, the true sound source can be reliably approached.

本発明の第12の態様にかかる移動体の制御方法は、上記の制御方法であって、前記地図データ上において音が発生した位置の履歴に基づいて、一定時間以上、音が発生していない位置の音源候補対象を消去することを特徴とするものである。これにより、音源候補対象の数が過剰に増えるのを防ぐことができる。従って、速やかに音源に近づくことができる。 A mobile object control method according to a twelfth aspect of the present invention is the control method described above, wherein no sound is generated for a predetermined time or more based on a history of positions where the sound is generated on the map data. It is characterized in that the sound source candidate object at the position is deleted. Thereby, it is possible to prevent an excessive increase in the number of sound source candidate targets. Accordingly, the sound source can be quickly approached.

本発明によれば、音源に対して確実に近づくことができる移動体、及びその制御方法を提供することが可能になる。 ADVANTAGE OF THE INVENTION According to this invention, it becomes possible to provide the moving body which can approach the sound source reliably, and its control method.

本実施の形態にかかる移動体について図1を用いて説明する。図1は移動体100の構成を模式的に示す外観図である。本実施の形態では、移動体100が、ユーザが発した音声に基づいて自律移動する移動ロボットとして説明する。移動体100は、車輪2と、筐体3と、を備えている。そして、筐体3の内部には、車輪2と接続されたモータが設けられている。このモータが移動体100を移動させるための駆動機構となる。モータを駆動することによって、車輪2が回転して、移動体100が移動する。さらに、移動体100は、マイクロフォンアレイ121を備えている。マイクロフォンアレイ121は、移動体100の外部で発生した音を受音して、音源の方向を推定する。例えば、人間が発話した場合、音源となる発話した人間の方向を推定する。そして、移動体100は、車輪2を駆動して、音源の方向に近づくよう移動する。このように、移動体100は、人間に呼ばれたときに、その人間の近くまで移動するタスクを実行する。 A moving body according to the present embodiment will be described with reference to FIG. FIG. 1 is an external view schematically showing the configuration of the

次に、移動体100の制御系について図2を用いて説明する。移動体100は、制御部101、入出力部102、駆動部103、電源部104、及び外部記憶部105などを有している。これらは、例えば、筐体3の内部に設けられている。また、スピーカ123、マイクロフォンアレイ121、センサ部125、LED124などは筐体3の外側に設けられている。 Next, the control system of the moving

入出力部102は、周囲の音を受音するためのマイクロフォンアレイ121を備えている。マイクロフォンアレイ121は、アレイ状に配置された複数のマイクを有している。そして、各マイクロフォンからの出力の時間遅延によって、音の入射方向を測定する。あるいは、指向性を有するマイクロフォンを複数用いて、音の入射方向を測定してもよい。これにより、マイクロフォンアレイ121が配置されている方向から、音源方向までの角度が求められる。すなわち、マイクロフォンアレイ121が移動体100から音源までの受音方向を特定する。よって、移動体100が移動する平面上において、移動体100周りの360°の中から特定の方向が受音方向として推定される。マイクロフォンアレイ121は、移動体100から見て、音源の位置する方向を受音方向と判断する。すなわち、マイクロフォンアレイ121が受音した音の移動体100に向かう方向を受音方向として特定する。ここで、受音方向は、移動体が移動する平面(例えば、水平面)における方向(方位)であってもよく、鉛直方向に対する傾斜度合いを含めた3次元における方向としてもよい。 The input /

さらに、入出力部102は、音声を出力してユーザと対話等を行なうためのスピーカ123、ユーザへの応答や感情等を表現するためのLED124、タッチセンサなどからなるセンサ部125などを備える。また、センサ部125は、レーザレンジファインダやCCDカメラなどの各種センサを有している。 Furthermore, the input /

駆動部103は、モータ131及びモータ131を駆動するドライバ132などを有し、制御部101からの制御信号に従って車輪2を回転させる。これにより、移動体100が所定の位置まで移動する。さらに、モータ131、及びドライバ132は、2つの車輪2にそれぞれ設けられている。これにより、2つの車輪2を独立して駆動することができる。例えば、ドライバ132は、モータ131の回転数を制御する。これにより、車輪2を所定の回転数で駆動することができる。よって、移動体100の目標位置までの移動が可能となる。モータ131は移動体100の内部に取り付けられている。 The driving

例えば、駆動部103が左右の車輪2を回転させることによって、移動体100が移動する。2つの車輪2は、それぞれ異なるモータ131に接続されている。したがって、車輪2を異なる回転方向、回転速度で回転させることにより、移動体100の移動方向、移動速度を制御することができる。具体的には、車輪2を同じ方向、異なる速度で回転させることにより、移動体100の移動方向が変化しながら、移動する。すなわち、2つの車輪2の距離、及び回転速度の差に応じて、移動体100がカーブしながら移動する。また、車輪2を反対方向に同じ速度で回転させることによって、移動体100がその場で旋回する。さらに、車輪2を同じ方向、同じ速度で回転させることにより、移動体100が直進移動する。電源部104は、バッテリ141及びその放充電を制御するバッテリ制御部142を有し、各部に電源を供給する。 For example, the moving

外部記憶部105は、着脱可能なHDD、光ディスク、光磁気ディスク等からなり、各種プログラムや制御パラメータなどを記憶し、そのプログラムやデータを必要に応じて制御部101内のメモリ(不図示)等に供給する。外部記憶部105には、地図データ記憶部51と、音源候補対象記憶部52とが設けられている。地図データ記憶部51は、移動体100が移動する領域の地図データを記憶する。例えば、地図データとして、移動体100が移動する領域内の物の配置に応じて移動体100が移動できる領域と、移動できない領域とがそれぞれ記憶されている。例えば、移動体100が通常の家庭内の部屋に配置されている場合、地図データとして、ベッド、ソファー、椅子、テーブル、タンス、本棚などの家具の位置が記憶されている。これらの家具の位置は、例えば、移動体100が移動する平面における2次元座標として記憶される。そして、家具が存在する位置、及びその周辺が、移動できない領域として記憶される。すなわち、これらの家具は、移動体100の障害物となる。このため、例えば、家具から移動体100の大きさに合わせた距離だけ離れた位置が、移動体100が移動できる領域と、移動できない領域との境界となる。この地図データは、後述する経路探索にも用いられる。 The

さらに、地図データを随時更新してもよい。例えば、センサ部125に設けられたレーザレンジファインダや、超音波センサによって、障害物までの距離を測定する。例えば、レーザレンジファインダからは、複数のレーザー光が所定の角度ピッチで出射される。そして、レーザレンジファインダはレーザ光が障害物や壁面で反射された反射光を検出する。反射光が検出される時間に応じて、障害物までの距離を測定する。そして、この障害物までの距離に基づいて、地図データ上の移動できない領域と移動できる領域とを判別する。これにより、部屋内の状況が変化した場合でも移動体100が障害物に衝突するのを防ぐことができる。 Further, the map data may be updated as needed. For example, the distance to the obstacle is measured by a laser range finder provided in the

音源候補対象記憶部52では、地図データ上の音源の候補の対象となる音源候補対象の位置を記憶している。これらの音源候補対象の位置は、音源地図によって記憶されている。例えば、地図データに対して複数の音源候補対象の位置を予め登録することによって、音源地図が生成される。音源候補対象の位置では、頻繁に音が発生する。従って、例えば、地図データ上で、人間が頻繁に存在する位置を音源候補対象の位置として登録することができる。具体的には、ベッド、ソファー、椅子、ドア前後、台所前、玄関、電話付近、電気等のスイッチ付近、テーブル、本棚、タンス、押入れ、洗濯機、冷蔵庫等の位置が音源候補対象の位置として記憶される。音源地図は、地図データ記憶部51に記憶されている地図データ上に対応付けられている。従って、地図データ上の複数の点に音源候補対象が存在することになる。音源候補対象の位置は、地図データ上の2次元座標として記憶される。従って、音源候補対象の位置は座標リストとして記憶される。あるいは、後述するグリッドマップとして、音源候補対象の位置を記憶してもよい。例えば、グリッドマップの各グリッドが音源候補対象の位置であるか否かを登録しておく。これらの音源候補対象位置は、操作者によって予め登録されている。登録する位置としては、上述のように統計的に人間が存在する可能性が高い点を選ぶことができる。このように、音源地図には、音源となる可能性の高い点が音源候補対象位置として登録されている。 The sound source candidate

制御部101は、CPU(Central Processing Unit)、ROM(Read Only Memory)、RAM(Random Access Memory)、通信用のインターフェースなどを有し、移動体100の各種動作を制御する。そして、この制御部101は、例えばROMに格納された制御プログラムに従って各種の制御を実行する音源位置推定部12、停止位置決定部13、経路探索部14、自己位置推定部15、駆動制御部16、及び音源確認部17を備えている。音源位置推定部12は、音源候補対象記憶部52に記憶された音源候補対象の位置から音源の位置を推定する。例えば、音源候補対象記憶部52に記憶された複数の音源候補対象の位置から1つの音源候補対象を選択して、この音源候補対象を音源と推定する。そして、選択された音源候補対象の位置を音源位置と推定する。ここで、音源位置推定部12で推定された音源の位置を推定音源位置とする。なお、音源位置推定部12は、マイクロフォンアレイ121で特定された受音方向に近い音源候補対象を音源と推定する。音源位置推定部12による音源位置の推定については後述する。 The

停止位置決定部13は、音源位置推定部12によって推定された推定音源位置に応じて目標停止位置を決定する。自己位置推定部15は、地図データ上における移動体100の現在の自己位置を推定する。経路探索部14は、自己位置推定部15で推定された移動体100の自己位置から、停止位置決定部13で決定された目標停止位置までの目標経路探索を行なう。例えば、移動体100の目標軌道となる目標経路は、しばしば座標の集合として与えられる。座標は、例えば、グリッド状に離散化されたグリッド座標で表現される。グリッド座標を利用するメリットは、最短経路探索を容易に実行できる点や、確実に目的地に到達できる経路を得ることができる点にある。しかしながら、グリッド座標において表現される目標経路は直線と直線が接続された不連続な経路であるため、移動体100がこのような経路を追従することは難しい。そのため、与えられた離散的な経路座標から、移動体100の追従制御に利用可能な滑らかな目標経路を、例えば、重み付き移動平均を利用して補間曲線を求めることにより作成することができる。このように、与えられた地図データに対してグリッドマップを作成することによって、容易に目標経路を探索することができる。もちろん、経路探索部14は、移動体100が家具等に衝突しないように、移動できない領域を避けて経路探索を行なう。 The stop

例えば、グリッドマップをA*探索(エースター探索)で探索した目標経路を用いることができる。さらに、グリッドを結んだ線分集合を滑らかにする演算を行なっている。もちろん、上記以外の方法によって目標経路を計画してもよい。例えば、最良優先探索や山登り探索などの探索技法を用いることも可能である。駆動制御部16は、移動体100が経路探索部14で探索された目標経路に追従して移動するよう、制御信号を駆動部103に対して出力する。 For example, a target route searched for the grid map by A * search (Aster search) can be used. Furthermore, the calculation which smoothes the line segment set which connected the grid is performed. Of course, you may plan a target path | route by methods other than the above. For example, a search technique such as a best priority search or a hill-climbing search can be used. The

音源確認部17は、推定された音源が音源として正しいか否かを確認する。すなわち、推定音源位置が真の音源の位置であるかを確認する。真の音源であるかを確認することで、多数の音源候補対象がある場合でも、確実に音源に対して近づけることができる。具体的には、音源位置確認部17は、移動体100が上記の目標停止位置まで移動した後、推定音源位置が真の音源の位置であるかを確認するための音源確認情報を取得する。音源確認情報としては、カメラによって取得された画像情報や、マイクによって取得された音声情報が挙げられる。そして、音源候補対象に対して取得された音源確認情報が真の音源の場合の音源確認情報とどの程度一致するかによって、真の音源か否かを判定する。すなわち、音源確認情報に基づいて、音源位置推定部12で選択された音源候補対象が真の音源であるか否かを確認する。

推定音源位置に音源が存在しない場合、音源位置推定部12は他の音源候補対象を選択して、他の音源候補対象の位置を新たな推定音源位置とする。停止位置決定部13は、新たな推定音源位置に対する目標停止位置を決定する。そして、経路探索部14は、現在の自己位置から、2つ目に推定された新たな推定音源位置に対応する目標停止位置までの経路を探索する。ここでの自己位置は、1つ目に推定された推定音源位置に対する目標停止位置である。そして、駆動制御部16が自己位置から2つ目の目標停止位置まで移動するよう制御する。移動体100は、上記の制御を繰り返して、真の音源に対応する目標停止位置までの移動を行う。これらの制御は、所定の制御プログラムやハードウェアに基づいて実行される。The sound

When there is no sound source at the estimated sound source position, the sound source

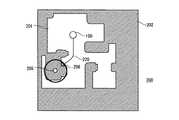

上記の制御について、図3、及び図4を参照して説明する。図3は、本実施の形態に係る移動体100の制御方法を示すフローチャートである。図4は移動体100が移動する領域に対応するマップ200を平面的に示す図である。すなわち、図4では、移動する領域のマップ200が、移動できる領域201と、移動できない領域202とに分けられて、平面的に示されている。移動できない領域202は、上記のように家具などに対応している。ここで、ベッド203上に存在する人間204が音源であるとして説明する。また、音源候補対象記憶部52には、ベッド203上の点が音源候補対象205として登録されている。 The above control will be described with reference to FIG. 3 and FIG. FIG. 3 is a flowchart showing a method for controlling

まず、マイクロフォンアレイ121を稼働状態とする(ステップS1)。マイクロフォンアレイ121が発話を検出する(ステップS2)。ここでは、マイクロフォンアレイ121からの出力に基づいて、音声認識を行う。そして、移動体100が呼ばれていると認識された場合のみ、移動体100が次のステップに進む。移動体100が呼ばれていると認識できない場合は、ステップS1に戻る。 First, the

ステップS2で移動体100が呼ばれていると認識された場合、マイクロフォンアレイ121で受音方向を特定する(ステップS3)。すなわち、人間204の移動体100への呼びかけに対して、マイクロフォンアレイ121が音声の入射方向を測定する。そして、移動体100から音源までの受音方向210を特定する。また、受音方向を特定する処理と並行して、自己位置推定を行なう(ステップS4)すなわち、制御部101の自己位置推定部15は、マイクロフォンアレイ121による受音方向の特定と並行して、現在の自己位置を推定している。例えば、センサ部125に設けられたセンサからの出力に基づいて、現在の自己の位置が推定される。さらに、自己位置推定では、マップ上において、移動体100が向いている方向を自己角度として推定する。この自己位置推定については、CCDカメラやレーザレンジファインダなどを用いて実行することができる。また、部屋内にランドマークを設定して、自己位置推定を行なってもよい。例えば、CCDカメラの出力に基づいて画像認識を行なうことで、自己位置を推定することができる。このようにマルチタスクで自己位置推定と受音方向特定とを行なうことによって、処理時間を短縮することができる。 When it is recognized in step S2 that the moving

そして、受音方向210をグローバル座標系の角度で表現する。具体的には、移動体100からの受音方向210の角度を受音方向角度とし、移動体100自体の角度を自己位置角度とし、グローバル座標系での音源の角度を受音方向絶対角度とすると、受音方向角度+自己位置角度=受音方向絶対角度となる。この受音方向絶対角度は受音方向210に対応する値となる。 The

次に、マイクロフォンアレイ112で特定された受音方向210と自己位置推定部15で推定された自己位置と音源地図とに基づいて、音源を推定する。ここでは、図4に示すように、受音方向210から受音方向特定の角度誤差分を含む領域207に存在する音源候補対象205を選択して、その音源候補対象205を音源と推定する。すなわち、マイクロフォンアレイ112における受音方向特定の角度誤差を受音方向誤差とすると、受音方向210から受音方向誤差だけ広がった範囲が、音源が存在する領域207となる。従って、受音方向誤差だけ横幅を持った扇形の領域207の中から音源候補対象205を選択することができる。そして、音源位置推定部12は、領域207の中に存在する音源候補対象205を探して、その音源候補対象205を音源として推定する。すなわち、音源位置推定部12は、音源地図に登録されている複数の音源候補対象の中から、領域207に存在する音源候補対象205を選択する。なお、領域207に2以上の音源候補対象がある場合、自己位置に近い音源候補対象を優先して選択する。このように、音源位置推定部12は、受音方向210を基準として受音方向から受音方向誤差だけ広くした領域207の中に存在する音源候補対象205を選択する。受音方向210に対して所定の角度だけ広がった領域207から音源候補対象205を抽出することによって、確実に音源候補対象を選択することが可能となる。なお、領域207は、移動体100が移動する平面において、受音方向210から所定の角度だけ広がる範囲として求めることができる。そして、選択された1つの音源候補対象205を音源として推定し、その音源候補対象の位置を推定音源位置とする。この音源候補対象205は、後述するステップS9で推定された音源が真の音源であることが確認されるまで、仮の音源として認識されている。 Next, the sound source is estimated based on the

推定音源位置が推定されたら、その推定音源位置に対応する目標停止位置206を決定する(ステップS6)。すなわち、推定音源位置には、通常、人間204が存在するため、推定音源位置から所定の距離だけ離れた位置を目標停止位置206とする。この目標停止位置206は、音源候補対象位置毎に予め設定しておいてもよい。これにより、速やかに目標停止位置206を決定することができる。あるいは、推定された推定音源位置の位置に基づいて算出してもよい。これにより、状況が変化している場合でも、適切な目標停止位置を求めることができる。例えば、地図データが変化している場合や、移動体100の初期位置が異なる場合に好適である。 When the estimated sound source position is estimated, a

次に、現在の自己位置と目標停止位置206とを使って、経路探索を行なう(ステップS7)。すなわち、経路探索部14が現在の自己位置から目標停止位置206までの経路を生成する。経路探索は、例えば、A*探索(エースター探索)により実行することができる。そして、移動体100は、経路探索で生成された経路に追従しながら、目標停止位置までの移動を行なう(ステップS8)。ここでは、自己位置推定部15において、常時、自己位置推定を行なっておく。すなわち、自己位置を随時更新する。そして、更新された自己位置と目標経路からのずれに対して負のフィードバックを与えるように、経路追従させる。これにより、精度よく、経路に追従して移動させることが可能となる。ここでは、駆動制御部16が駆動部103のドライバ132に対して制御信号を出力する。これにより、モータ131が所定の回転速度で回転するため、経路追従させることができる。 Next, a route search is performed using the current self position and the target stop position 206 (step S7). That is, the

そして、目標停止位置206までの移動が完了したら、推定された音源が正しいか確認する(ステップS9)。すなわち、推定音源位置、あるいはその近傍に真の音源が存在するか否かを確認する音源確認情報を取得し、その音源確認情報によって真の音源か否かを確認する。音源確認情報としては、例えば、カメラによって取得された画像情報や、マイクロフォンを用いて音声認識された音声情報が挙げられる。そして、真の音源の場合の画像情報や音声情報と、音源確認情報がどの程度一致するか判断する。そして、音源確認情報の一致度によって真の音源か否かを確認する。

例えば、推定音源位置に向かって、移動体100が呼ばれたかどうかを確認する。具体的には、目標停止位置で停止した移動体100が、CCDカメラを推定音源位置に向けて、自己位置周辺の画像を取得する。CCDカメラの画像処理によって顔認識を行い、推定音源位置やその近傍の人間204の顔を認識する。そして、人間204の顔が認識できたら、スピーカ123から「呼びましたか?」と人間204に対して問い掛ける。問い掛けられた人間204が問い掛けに対して、「うん、呼んだよ」と返答したら、移動体100は、この返答をマイクロフォンアレイ121や他のマイクロフォンで受音する。そして、移動体100は、人間204からの返答を音声認識する。この音声認識結果に基づいて、移動体100は、推定音源位置周辺に存在する人間204からの呼びかけがあったと判定する。これにより、推定された音源が正しいことが確認できる。このようにすることによって、音源位置推定部12によって推定された仮の音源が真の音源であるか否か確認することができる。このように、音声認識を行い、音声認識結果を音源確認情報とすることができる。なお、音源の確認は、顔認識などによって行われてもよい。すなわち、物体認識や顔認識等の画像認識を行い、画像認識結果を音源確認情報とすることができる。そして、音声確認情報が真の音源の場合の音声確認情報とどの程度一致するかによって真の音源であることを確認する。そして、推定された音源が正しい音源である場合、移動タスクを終了する(ステップS10)。When the movement to the

For example, it is confirmed whether the moving

また、人間204が正しい音源でない場合、あるいは、推定音源位置周辺に顔が認識できない場合、再度ステップS5からステップS9までの処理を繰り返す。すなわち、人間204からの返答を音声認識することによって、人間204が移動体100を呼んでいないことが確認された場合、次の音源候補対象205を探す。例えば、移動体100からの問い掛けに対して、人間204が「呼んでないよ」と返答した場合、音声認識結果に基づいて、推定された音源が真の音源でないと認識する。そして、移動体100は、次の音源候補対象を探す。例えば、領域207に複数の音源候補対象が存在していたら、次の音源候補対象を選択する。この場合、移動体100の自己位置から近い順に音源候補対象を選択することができる。そして、次に選択された音源候補対象を音源として推定する。1つ目の目標停止位置から、2つ目の目標停止位置まで移動する。真の音源を確認することができるまで、ステップS5からステップS9までの処理を繰り返していく。 If the human 204 is not a correct sound source, or if a face cannot be recognized around the estimated sound source position, the processes from step S5 to step S9 are repeated again. That is, when it is confirmed that the human 204 is not calling the moving

このようにすることによって、確実に移動体100を音源に近づけることができる。すなわと、音源と移動体100との障害物がある場合でも、移動体100が障害物に衝突するのを防ぐことができる。さらに、予め家具などの障害物を考慮して経路探索しているため、障害物を容易に回避することができる。また、超音波センサを用いた場合と比べて、遠い位置に存在する音源に対する移動が可能になる。よって、確実に音源の近くまで移動体100を移動させることができる。さらに、目標停止位置に移動した後、推定音源位置に対して真の音源が存在するか否かを確認しているため、音源を誤認識することがない。さらに、音源候補対象から一定距離離れた点を目標停止位置としているため、音源となる人間に対して衝突するのを防ぐことができる。よって、音源に対して適した位置に移動することが可能となる。 By doing in this way, the

なお、複数の音源候補対象に対応して、一つの目標停止位置が登録されていてもよい。例えば、図4に示すように3つの音源候補対象208a〜208cが、共通の目標停止位置209に対応していてもよい。このように、複数の音源候補対象位置に対して共通の目標停止位置を登録しておいてもよい。これにより、登録する目標停止位置の数を少なくすることができる。よって、目標停止位置から移動せずに、複数の推定音源位置に対する音源の確認を行なうことができる。 One target stop position may be registered corresponding to a plurality of sound source candidate targets. For example, as shown in FIG. 4, the three sound source candidate targets 208 a to 208 c may correspond to a common

次に、推定音源位置を求める別の方法について、図5を用いて説明する。図5は、移動体100の自己位置に対する受音方向210を模式的に示す図である。ここでは、移動体100の自己位置に対して近い順に音源候補対象を選択するための一例について説明する。 Next, another method for obtaining the estimated sound source position will be described with reference to FIG. FIG. 5 is a diagram schematically illustrating the

まず、音源候補対象の位置を座標として登録しておく。なお、音源候補対象の位置をグリッドの中の特定の座標としてもよい。ここで、音源候補対象を探す範囲をr〜r+drとする。rは移動体100からの距離である。drは予め設定しておく。そして、音源候補対象の位置の座標リストの中から、以下の式(1)、(2)を満たす音源候補対象を検索する。

θs−σs<atan2(YR−YS,XR−XS)<θs+σs ・・・(1)

r<sqrt{(YR−YS)2+(XR−XS)2}<r+dr ・・・(2)

θs:絶対座標系の受音方向

σs:受音方向の角度誤差

(XR,YR):ロボット位置

(XS,YS):音源候補対象位置First, the position of the sound source candidate target is registered as coordinates. The position of the sound source candidate target may be a specific coordinate in the grid. Here, a range in which the sound source candidate target is searched is r to r + dr. r is the distance from the moving

θs−σs <atan2 (YR −YS , XR −XS ) <θs + σs (1)

r <sqrt {(YR −YS )2 + (XR −XS )2 } <r + dr (2)

θs: Sound receiving direction in the absolute coordinate system σs: Angle error (XR , YR ) in the sound receiving direction: Robot position (XS , YS ): Sound source candidate target position

そして、上記の式(1)、及び式(2)を満足する音源候補対象があれば、その音源候補対象を選択する。なお、r〜r+drの中に式(1)、及び式(2)を満足する音源候補対象が2つ以上ある場合、受音方向210に近い音源候補対象が選択される。すなわち、atan2(YR−YS,XR−XS)がθsに近い音源候補対象を選択する。例えば、音源候補対象205aと音源候補対象205bがある場合、受音方向210に近い音源候補対象205aが選択される。式(1)、及び式(2)を満足する音源候補対象が無ければ、次に探索する範囲をr+dr〜r+2drとする。そして、再度、式(1)、及び式(2)を満足する音源候補対象を探索する。上記の処理をr=0から繰り返し行うことによって、移動体100に近い音源候補対象から選択することができる。そして、最初に条件を満足した音源候補対象を、音源として推定する。すなわち、音源候補対象を探索する範囲をdrずつ段階的に広くしていき、音源候補対象を探索していく。このように、自己位置に近い順に音源候補対象を選択することができる。また、上記の処理では、音源候補対象を探索することによって、移動体100からの距離が近い音源候補対象が2以上ある場合、受音方向に近い音源候補対象が優先して選択される。すなわち、drだけ広げられた探索範囲に2つ以上音源候補対象がある場合、受音方向210に近い音源候補対象が先に選択される。よって、音源が存在する可能性の高い音源候補対象から順番に選択していくことが可能になる。これにより、移動時間を短縮することができる。If there is a sound source candidate target that satisfies the above equations (1) and (2), the sound source candidate target is selected. If there are two or more sound source candidate targets satisfying Expressions (1) and (2) in r to r + dr, a sound source candidate target close to the

なお、推定音源位置に対応する目標停止位置は、予め登録していなくてもよい。すなわち、音源位置を推定した後、その推定音源位置に応じて算出してもよい。例えば、音源位置を推定した後、その音源候補対象に対する目標停止位置を自動生成してもよい。以下に、推定音源位置に基づいて目標停止位置を算出する方法について、図6を用いて説明する。図6は、移動体100が移動するマップ200を模式的に示す図である。ベッド203上の音源候補対象205の位置が推定音源位置と推定された場合に説明する。目標停止位置を決定するため、音源候補対象205の座標を中心とし、所定の半径を有する円を描く。そして、この円の中に移動できる領域201が十分広いかを調べる。ここでは、その円の中に移動できる領域201が十分広くない場合、円の半径を少しだけ大きくする。これを繰り返し、円の中で、領域201が移動体100が移動するために十分広くなったら、その位置を目標停止位置206とする。すなわち、円の半径を徐々に大きくしていく、移動体100が移動できる程度に広い領域201が最初に円の中に現れた位置を目標停止位置206とする。そして、上記のように、自己位置から目標停止位置206までの目標経路200を探索する。このように、推定音源位置と、現在の自己位置とに基づいて目標停止位置を算出する。これによって、状況に応じた目標停止位置206に移動することができる。すなわち、目標停止位置206の決定に、自己位置が考慮されているため、自己位置に近い目標停止位置206を求めることができる。これにより、移動時間を短縮することができ、利便性を向上することができる。 The target stop position corresponding to the estimated sound source position may not be registered in advance. That is, after estimating the sound source position, it may be calculated according to the estimated sound source position. For example, after estimating the sound source position, a target stop position for the sound source candidate target may be automatically generated. Hereinafter, a method of calculating the target stop position based on the estimated sound source position will be described with reference to FIG. FIG. 6 is a diagram schematically showing a

また、音源候補対象をセンサ部125に設けられたセンサからの出力に基づいて登録するようにしてもよい。例えば、CCDカメラなどによって物体認識を行い、人が頻繁に存在する可能性が高い物の位置を音源候補対象の位置として登録することができる。例えば、予め人が使う可能性が高い物(例えば、ベッド、ソファー、椅子、冷蔵庫等)をデータベースとして登録しておく。物体認識によって、人が使う可能性が高い物を認識したら、その位置を音源候補対象位置として登録する。物体認識は、移動体100の移動中、或いは停止中に行なうことができる。そして、音源地図上の音源候補対象の位置を随時、更新することによって、家具等が移動した場合でも、適切に音源候補対象の位置を選択することができる。これにより、音源の推定を確実に行なうことができる。 The sound source candidate target may be registered based on an output from a sensor provided in the

あるいは、人間と会話した位置の履歴を残しておき、その履歴に基づいて音源候補対象を登録してもよい。すなわち、移動体100が人間と会話した場所の座標、及び会話した時刻を記憶しておく。そして、単位時間あたりの会話数がしきい値以上になる位置を音源候補対象の位置として登録する。ここで、顔認識等の技術によって、人間を認識することができる。さらに、人間との会話が一定時間以上無い音源候補対象位置を音源地図から削除するようにしてもよい。このように人間と会話する頻度の高い位置を音源候補対象として登録し、会話する頻度が低くなった位置を音源候補対象から消去する。そうすることによって、音源候補対象の数を少なくすることができる。これにより、音源候補対象の数が過剰に増えるのを防ぐことができる。従って、速やかに音源に近づくことができる。このように、移動体100が会話した位置の履歴に応じて、音源候補対象を登録、又は消去することができる。会話を行なうためには、例えば、音声認識技術によって音声を認識する。そして、認識した音声に応じて会話するための音声を選ぶ。会話するための音声をスピーカから出力することにより会話することができる。また、会話の履歴に基づいて音源候補対象を登録する場合、音源候補対象の座標だけでなく、その音源に対して会話した方向を登録するようにしてもよい。このように、地図データ上の音が発生した位置の履歴に基づいて、音が一定以上発生していない位置の音源候補対象位置を音源候補対象記憶部52から削除する。これにより、音源候補対象が過剰になるのを防ぐことができる。よって、音源候補対象を適切な数で登録することができる。なお、音が発生した位置は、他の方法で検出するようにしてもよい。 Alternatively, a history of positions where conversations with humans are kept, and sound source candidate targets may be registered based on the history. That is, the coordinates of a place where the

また、移動体100が目標経路に追従して移動している間に、画像認識等の技術を用いて音源を認識するようにしてもよい。例えば、CCDカメラが音源候補対象の位置を向いた状態で、目標経路に追従して移動するように制御する。すなわち、移動体100の方向に応じて、CCDカメラの向きを変えて、CCDカメラの視野の中に音源候補対象が常時含まれるようにする。そして、移動中に、CCDカメラで顔認識を行い、音源となる人間の顔を認識する。そして、音源候補対象の位置に顔が認識された時点で、その音源候補対象の方向に直進する。これにより、移動体100を速やかに音源候補対象に近づけることができる。通常、顔認識を行なうことができる場合、移動体100と人間との間に障害物がない。このため、移動体100を直進させても障害物と衝突する可能性が低くなる。従って、顔を認識した後には、目標停止位置に対して直進させることができる。 Further, the sound source may be recognized using a technique such as image recognition while the moving

なお、音源は、人間に限るものではない。音源は、例えば、電話やインターホンなどの音を発生する機器や犬などの動物であってもよい。さらには、他のロボットが音源であってもよい。本実施の形態では、車輪型の移動体について説明したが、歩行型の移動体であっても適用可能である。 The sound source is not limited to humans. The sound source may be, for example, a device that generates sound such as a telephone or an interphone, or an animal such as a dog. Furthermore, another robot may be a sound source. In the present embodiment, the wheel-type moving body has been described, but the present invention can also be applied to a walking-type moving body.

2 車輪、3 筐体、12 音源位置推定部、13 停止位置決定部、14 経路探索部、15 自己位置推定部、16 駆動制御部、17 音源確認部、

51 地図データ記憶部、52 音源候補対象記憶部、100 移動体

101 制御部、102 入出力部、103 駆動部、104 電源部、

105 外部記憶部、121 マイクロフォンアレイ、123 スピーカ、

124 LED、125 センサ部、131 モータ、132 ドライバ、

143 バッテリ、144 バッテリ制御部、

200 マップ、201 移動体が移動できる領域、202 移動体が移動できない領域、

203 ベッド、204 人間、205 音源候補対象、206 目標停止位置、

207 領域、208a〜208c 音源候補対象、209 目標停止位置、

210 受音方向、220 目標経路、2 wheels, 3 housings, 12 sound source position estimation unit, 13 stop position determination unit, 14 route search unit, 15 self-position estimation unit, 16 drive control unit, 17 sound source confirmation unit,

51 Map Data Storage Unit, 52 Sound Source Candidate Target Storage Unit, 100

105 external storage unit, 121 microphone array, 123 speaker,

124 LED, 125 sensor unit, 131 motor, 132 driver,

143 battery, 144 battery control unit,

200 map, 201 area where the moving body can move, 202 area where the moving body cannot move,

203 Bed, 204 Human, 205 Sound source candidate target, 206 Target stop position,

207 area, 208a-208c sound source candidate target, 209 target stop position,

210 sound receiving direction, 220 target route,

Claims (12)

Translated fromJapanese前記移動体の外部で発生した音を受音するマイクを有し、前記マイクが受音した音の前記移動体に向かう方向を前記受音方向として特定する受音方向特定手段と、

前記移動体が移動する領域に応じて記憶されている地図データにおいて、音源の候補となる対象の位置を音源候補対象位置として記憶する音源候補対象記憶手段と、

前記受音方向特定手段によって特定された受音方向と、前記音源候補対象記憶手段に記憶された音源候補対象位置とに基づいて、音源の位置を推定する音源位置推定手段と、

前記音源位置推定手段によって推定された音源の位置から目標停止位置を決定する停止位置決定手段と、

前記移動体の現在位置から前記停止位置決定手段で決定された目標停止位置まで前記移動体を移動させる移動手段と、を備える移動体。A mobile object that autonomously moves to a target stop position,

A sound receiving direction specifying means that has a microphone that receives sound generated outside the moving body, and that specifies the direction of the sound received by the microphone toward the moving body as the sound receiving direction;

Sound source candidate target storage means for storing a position of a target as a sound source candidate as a sound source candidate target position in map data stored in accordance with an area to which the moving body moves;

Sound source position estimating means for estimating the position of the sound source based on the sound receiving direction specified by the sound receiving direction specifying means and the sound source candidate target position stored in the sound source candidate target storage means;

Stop position determining means for determining a target stop position from the position of the sound source estimated by the sound source position estimating means;

A moving body that moves the moving body from a current position of the moving body to a target stop position determined by the stop position determining means.

前記音源確認手段が前記推定された音源が真の音源でないと確認した場合、前記音源位置推定手段が前記音源候補対象記憶部に記憶された他の音源候補対象の位置に基づいて音源の位置を推定する請求項1乃至4のいずれかに記載の移動体。After moving to the target stop position, the sound source further comprises sound source confirmation means for obtaining sound source confirmation information for confirming whether the sound source is a true sound source,

When the sound source confirmation unit confirms that the estimated sound source is not a true sound source, the sound source position estimation unit determines the position of the sound source based on the position of another sound source candidate target stored in the sound source candidate target storage unit. The moving body according to claim 1, wherein the moving body is estimated.

前記移動体の外部で発生した音をマイクによって受音して、前記マイクが受音した音の前記移動体からの方向を前記受音方向として特定するステップと、

前記特定された受音方向と、前記移動体が移動する領域の地図データに対して予め登録されている音源候補対象の位置とに基づいて、音源の位置を推定するステップと、

前記推定された音源の位置から目標停止位置を決定するステップと、

前記移動体の現在位置から前記目標停止位置まで前記移動体を移動するステップと、を備える移動体。A method for controlling a moving body that autonomously moves to a target stop position,

Receiving a sound generated outside the moving body by a microphone, and specifying a direction from the moving body of the sound received by the microphone as the sound receiving direction;

Estimating the position of the sound source based on the specified sound receiving direction and the position of the sound source candidate target registered in advance with respect to the map data of the area in which the moving body moves;

Determining a target stop position from the estimated position of the sound source;

Moving the moving body from a current position of the moving body to the target stop position.

前記音源確認情報により、前記推定された音源が真の音源でないと確認された場合、登録されている他の音源候補対象の位置に基づいて音源の位置を推定する請求項7乃至10のいずれかに記載の移動体の制御方法。Obtaining sound source confirmation information for confirming whether the sound source is a sound source after moving to the target stop position;

11. The position of a sound source is estimated based on the position of another registered sound source candidate target when it is confirmed by the sound source confirmation information that the estimated sound source is not a true sound source. The control method of the moving body as described in 2.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006348065AJP2008158868A (en) | 2006-12-25 | 2006-12-25 | Mobile body and control method thereof |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006348065AJP2008158868A (en) | 2006-12-25 | 2006-12-25 | Mobile body and control method thereof |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2008158868Atrue JP2008158868A (en) | 2008-07-10 |

Family

ID=39659694

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2006348065APendingJP2008158868A (en) | 2006-12-25 | 2006-12-25 | Mobile body and control method thereof |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP2008158868A (en) |

Cited By (90)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011035472A (en)* | 2009-07-29 | 2011-02-17 | Chubu Electric Power Co Inc | Image display device |

| JP2011069948A (en)* | 2009-09-25 | 2011-04-07 | Nec Corp | Device, method and program for separating sound source signal |

| JP2011146871A (en)* | 2010-01-13 | 2011-07-28 | Hitachi Ltd | Apparatus and method for searching sound source |

| JP2012211768A (en)* | 2011-03-30 | 2012-11-01 | Advanced Telecommunication Research Institute International | Sound source positioning apparatus |

| WO2014087495A1 (en)* | 2012-12-05 | 2014-06-12 | 株式会社日立製作所 | Voice interaction robot, and voice interaction robot system |

| JP2014137226A (en)* | 2013-01-15 | 2014-07-28 | Advanced Telecommunication Research Institute International | Mobile object, and system and method for creating acoustic source map |

| JP5756569B1 (en)* | 2014-04-15 | 2015-07-29 | 株式会社タカラトミー | Top toy |

| JP2016045756A (en)* | 2014-08-25 | 2016-04-04 | 三菱重工業株式会社 | Data processing method and data processing device |

| WO2018043235A1 (en)* | 2016-08-29 | 2018-03-08 | Groove X株式会社 | Autonomous behavior type robot recognizing direction of sound source |

| WO2018064362A1 (en)* | 2016-09-30 | 2018-04-05 | Sonos, Inc. | Multi-orientation playback device microphones |

| US9947316B2 (en) | 2016-02-22 | 2018-04-17 | Sonos, Inc. | Voice control of a media playback system |

| US9965247B2 (en) | 2016-02-22 | 2018-05-08 | Sonos, Inc. | Voice controlled media playback system based on user profile |

| US9978390B2 (en) | 2016-06-09 | 2018-05-22 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US10034116B2 (en) | 2016-09-22 | 2018-07-24 | Sonos, Inc. | Acoustic position measurement |

| US10051366B1 (en) | 2017-09-28 | 2018-08-14 | Sonos, Inc. | Three-dimensional beam forming with a microphone array |

| JP2018524927A (en)* | 2015-07-06 | 2018-08-30 | ボーズ・コーポレーションBose Corporation | Simulate sound output at locations corresponding to sound source position data |

| US10097919B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Music service selection |

| US10095470B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Audio response playback |

| US10097939B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Compensation for speaker nonlinearities |

| US10115400B2 (en) | 2016-08-05 | 2018-10-30 | Sonos, Inc. | Multiple voice services |

| US10134399B2 (en) | 2016-07-15 | 2018-11-20 | Sonos, Inc. | Contextualization of voice inputs |

| US10152969B2 (en) | 2016-07-15 | 2018-12-11 | Sonos, Inc. | Voice detection by multiple devices |

| US10181323B2 (en) | 2016-10-19 | 2019-01-15 | Sonos, Inc. | Arbitration-based voice recognition |

| JP2019053561A (en)* | 2017-09-15 | 2019-04-04 | ソニー株式会社 | Control device, control method, program, and mobile body |

| US10264030B2 (en) | 2016-02-22 | 2019-04-16 | Sonos, Inc. | Networked microphone device control |

| JP2019103073A (en)* | 2017-12-06 | 2019-06-24 | 東芝ライフスタイル株式会社 | Electrical apparatus and electrical apparatus system |

| WO2019138619A1 (en)* | 2018-01-09 | 2019-07-18 | ソニー株式会社 | Information processing device, information processing method and program |

| US10365889B2 (en) | 2016-02-22 | 2019-07-30 | Sonos, Inc. | Metadata exchange involving a networked playback system and a networked microphone system |

| JP2019145000A (en)* | 2018-02-23 | 2019-08-29 | パナソニックIpマネジメント株式会社 | Mobile robot and robot system |

| JP2019160289A (en)* | 2018-03-07 | 2019-09-19 | カシオ計算機株式会社 | Autonomous mobile device, autonomous mobile method and program |

| JP2019169189A (en)* | 2016-09-02 | 2019-10-03 | Groove X株式会社 | Autonomously behaving robot, server, and behavior control program |

| US10446165B2 (en) | 2017-09-27 | 2019-10-15 | Sonos, Inc. | Robust short-time fourier transform acoustic echo cancellation during audio playback |

| US10445057B2 (en) | 2017-09-08 | 2019-10-15 | Sonos, Inc. | Dynamic computation of system response volume |

| US10466962B2 (en) | 2017-09-29 | 2019-11-05 | Sonos, Inc. | Media playback system with voice assistance |

| US10475449B2 (en) | 2017-08-07 | 2019-11-12 | Sonos, Inc. | Wake-word detection suppression |

| US10482868B2 (en) | 2017-09-28 | 2019-11-19 | Sonos, Inc. | Multi-channel acoustic echo cancellation |

| WO2020034207A1 (en) | 2018-08-17 | 2020-02-20 | SZ DJI Technology Co., Ltd. | Photographing control method and controller |

| US10573321B1 (en) | 2018-09-25 | 2020-02-25 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US10582322B2 (en) | 2016-09-27 | 2020-03-03 | Sonos, Inc. | Audio playback settings for voice interaction |

| US10586540B1 (en) | 2019-06-12 | 2020-03-10 | Sonos, Inc. | Network microphone device with command keyword conditioning |

| US10587430B1 (en) | 2018-09-14 | 2020-03-10 | Sonos, Inc. | Networked devices, systems, and methods for associating playback devices based on sound codes |

| US10602268B1 (en) | 2018-12-20 | 2020-03-24 | Sonos, Inc. | Optimization of network microphone devices using noise classification |

| JP2020056935A (en)* | 2018-10-03 | 2020-04-09 | カシオ計算機株式会社 | Robot control device, robot, robot control method and program |

| US10621981B2 (en) | 2017-09-28 | 2020-04-14 | Sonos, Inc. | Tone interference cancellation |

| US10681460B2 (en) | 2018-06-28 | 2020-06-09 | Sonos, Inc. | Systems and methods for associating playback devices with voice assistant services |

| US10692518B2 (en) | 2018-09-29 | 2020-06-23 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection via multiple network microphone devices |

| US10797667B2 (en) | 2018-08-28 | 2020-10-06 | Sonos, Inc. | Audio notifications |

| US10818290B2 (en) | 2017-12-11 | 2020-10-27 | Sonos, Inc. | Home graph |

| US10847178B2 (en) | 2018-05-18 | 2020-11-24 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection |

| US10867604B2 (en) | 2019-02-08 | 2020-12-15 | Sonos, Inc. | Devices, systems, and methods for distributed voice processing |

| US10871943B1 (en) | 2019-07-31 | 2020-12-22 | Sonos, Inc. | Noise classification for event detection |

| US10878811B2 (en) | 2018-09-14 | 2020-12-29 | Sonos, Inc. | Networked devices, systems, and methods for intelligently deactivating wake-word engines |

| US10880650B2 (en) | 2017-12-10 | 2020-12-29 | Sonos, Inc. | Network microphone devices with automatic do not disturb actuation capabilities |

| CN112312014A (en)* | 2020-10-23 | 2021-02-02 | 移康智能科技(上海)股份有限公司 | Sound and camera linked system |

| US10959029B2 (en) | 2018-05-25 | 2021-03-23 | Sonos, Inc. | Determining and adapting to changes in microphone performance of playback devices |

| US11024331B2 (en) | 2018-09-21 | 2021-06-01 | Sonos, Inc. | Voice detection optimization using sound metadata |

| US11076035B2 (en) | 2018-08-28 | 2021-07-27 | Sonos, Inc. | Do not disturb feature for audio notifications |

| JP2021108228A (en)* | 2017-03-31 | 2021-07-29 | カシオ計算機株式会社 | Mobile devices, control methods and programs for mobile devices |

| US11100923B2 (en) | 2018-09-28 | 2021-08-24 | Sonos, Inc. | Systems and methods for selective wake word detection using neural network models |

| US11120794B2 (en) | 2019-05-03 | 2021-09-14 | Sonos, Inc. | Voice assistant persistence across multiple network microphone devices |

| US11132989B2 (en) | 2018-12-13 | 2021-09-28 | Sonos, Inc. | Networked microphone devices, systems, and methods of localized arbitration |

| US11138969B2 (en) | 2019-07-31 | 2021-10-05 | Sonos, Inc. | Locally distributed keyword detection |

| US11138975B2 (en) | 2019-07-31 | 2021-10-05 | Sonos, Inc. | Locally distributed keyword detection |

| US11175880B2 (en) | 2018-05-10 | 2021-11-16 | Sonos, Inc. | Systems and methods for voice-assisted media content selection |

| US11183183B2 (en) | 2018-12-07 | 2021-11-23 | Sonos, Inc. | Systems and methods of operating media playback systems having multiple voice assistant services |

| US11183181B2 (en) | 2017-03-27 | 2021-11-23 | Sonos, Inc. | Systems and methods of multiple voice services |

| US11189286B2 (en) | 2019-10-22 | 2021-11-30 | Sonos, Inc. | VAS toggle based on device orientation |

| US11200900B2 (en) | 2019-12-20 | 2021-12-14 | Sonos, Inc. | Offline voice control |

| US11200889B2 (en) | 2018-11-15 | 2021-12-14 | Sonos, Inc. | Dilated convolutions and gating for efficient keyword spotting |

| US11200894B2 (en) | 2019-06-12 | 2021-12-14 | Sonos, Inc. | Network microphone device with command keyword eventing |

| JP2022024907A (en)* | 2020-07-28 | 2022-02-09 | パナソニックIpマネジメント株式会社 | Autonomous vacuum cleaner |

| US11308958B2 (en) | 2020-02-07 | 2022-04-19 | Sonos, Inc. | Localized wakeword verification |

| US11308962B2 (en) | 2020-05-20 | 2022-04-19 | Sonos, Inc. | Input detection windowing |

| US11315556B2 (en) | 2019-02-08 | 2022-04-26 | Sonos, Inc. | Devices, systems, and methods for distributed voice processing by transmitting sound data associated with a wake word to an appropriate device for identification |

| US11343614B2 (en) | 2018-01-31 | 2022-05-24 | Sonos, Inc. | Device designation of playback and network microphone device arrangements |

| US11361756B2 (en) | 2019-06-12 | 2022-06-14 | Sonos, Inc. | Conditional wake word eventing based on environment |

| CN115032468A (en)* | 2022-08-10 | 2022-09-09 | 广东电网有限责任公司佛山供电局 | Device and method for identifying direction of charged body |

| US11482224B2 (en) | 2020-05-20 | 2022-10-25 | Sonos, Inc. | Command keywords with input detection windowing |

| US11551700B2 (en) | 2021-01-25 | 2023-01-10 | Sonos, Inc. | Systems and methods for power-efficient keyword detection |

| US11556307B2 (en) | 2020-01-31 | 2023-01-17 | Sonos, Inc. | Local voice data processing |

| US11562740B2 (en) | 2020-01-07 | 2023-01-24 | Sonos, Inc. | Voice verification for media playback |

| US11698771B2 (en) | 2020-08-25 | 2023-07-11 | Sonos, Inc. | Vocal guidance engines for playback devices |

| US11727919B2 (en) | 2020-05-20 | 2023-08-15 | Sonos, Inc. | Memory allocation for keyword spotting engines |

| US11899519B2 (en) | 2018-10-23 | 2024-02-13 | Sonos, Inc. | Multiple stage network microphone device with reduced power consumption and processing load |

| US11984123B2 (en) | 2020-11-12 | 2024-05-14 | Sonos, Inc. | Network device interaction by range |

| CN118400484A (en)* | 2024-06-25 | 2024-07-26 | 广东岭南职业技术学院 | Intelligent conference recording equipment and conference recording modeling method |

| US12283269B2 (en) | 2020-10-16 | 2025-04-22 | Sonos, Inc. | Intent inference in audiovisual communication sessions |

| US12327549B2 (en) | 2022-02-09 | 2025-06-10 | Sonos, Inc. | Gatekeeping for voice intent processing |

| US12327556B2 (en) | 2021-09-30 | 2025-06-10 | Sonos, Inc. | Enabling and disabling microphones and voice assistants |

| US12387716B2 (en) | 2020-06-08 | 2025-08-12 | Sonos, Inc. | Wakewordless voice quickstarts |

- 2006

- 2006-12-25JPJP2006348065Apatent/JP2008158868A/enactivePending

Cited By (231)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011035472A (en)* | 2009-07-29 | 2011-02-17 | Chubu Electric Power Co Inc | Image display device |

| JP2011069948A (en)* | 2009-09-25 | 2011-04-07 | Nec Corp | Device, method and program for separating sound source signal |

| JP2011146871A (en)* | 2010-01-13 | 2011-07-28 | Hitachi Ltd | Apparatus and method for searching sound source |

| JP2012211768A (en)* | 2011-03-30 | 2012-11-01 | Advanced Telecommunication Research Institute International | Sound source positioning apparatus |

| WO2014087495A1 (en)* | 2012-12-05 | 2014-06-12 | 株式会社日立製作所 | Voice interaction robot, and voice interaction robot system |

| JP2014137226A (en)* | 2013-01-15 | 2014-07-28 | Advanced Telecommunication Research Institute International | Mobile object, and system and method for creating acoustic source map |

| JP5756569B1 (en)* | 2014-04-15 | 2015-07-29 | 株式会社タカラトミー | Top toy |

| WO2015159368A1 (en)* | 2014-04-15 | 2015-10-22 | 株式会社タカラトミー | Toy top |

| US9669322B2 (en) | 2014-04-15 | 2017-06-06 | Tomy Company, Ltd. | Toy top |

| JP2016045756A (en)* | 2014-08-25 | 2016-04-04 | 三菱重工業株式会社 | Data processing method and data processing device |

| JP2018524927A (en)* | 2015-07-06 | 2018-08-30 | ボーズ・コーポレーションBose Corporation | Simulate sound output at locations corresponding to sound source position data |

| US10412521B2 (en) | 2015-07-06 | 2019-09-10 | Bose Corporation | Simulating acoustic output at a location corresponding to source position data |

| US10971139B2 (en) | 2016-02-22 | 2021-04-06 | Sonos, Inc. | Voice control of a media playback system |

| US10847143B2 (en) | 2016-02-22 | 2020-11-24 | Sonos, Inc. | Voice control of a media playback system |

| US11983463B2 (en) | 2016-02-22 | 2024-05-14 | Sonos, Inc. | Metadata exchange involving a networked playback system and a networked microphone system |

| US11405430B2 (en) | 2016-02-22 | 2022-08-02 | Sonos, Inc. | Networked microphone device control |

| US10555077B2 (en) | 2016-02-22 | 2020-02-04 | Sonos, Inc. | Music service selection |

| US9947316B2 (en) | 2016-02-22 | 2018-04-17 | Sonos, Inc. | Voice control of a media playback system |

| US11556306B2 (en) | 2016-02-22 | 2023-01-17 | Sonos, Inc. | Voice controlled media playback system |

| US10097919B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Music service selection |

| US10095470B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Audio response playback |

| US10097939B2 (en) | 2016-02-22 | 2018-10-09 | Sonos, Inc. | Compensation for speaker nonlinearities |

| US11514898B2 (en) | 2016-02-22 | 2022-11-29 | Sonos, Inc. | Voice control of a media playback system |

| US11212612B2 (en) | 2016-02-22 | 2021-12-28 | Sonos, Inc. | Voice control of a media playback system |

| US10740065B2 (en) | 2016-02-22 | 2020-08-11 | Sonos, Inc. | Voice controlled media playback system |

| US10142754B2 (en) | 2016-02-22 | 2018-11-27 | Sonos, Inc. | Sensor on moving component of transducer |

| US10509626B2 (en) | 2016-02-22 | 2019-12-17 | Sonos, Inc | Handling of loss of pairing between networked devices |

| US10499146B2 (en) | 2016-02-22 | 2019-12-03 | Sonos, Inc. | Voice control of a media playback system |

| US11184704B2 (en) | 2016-02-22 | 2021-11-23 | Sonos, Inc. | Music service selection |

| US10212512B2 (en) | 2016-02-22 | 2019-02-19 | Sonos, Inc. | Default playback devices |

| US10225651B2 (en) | 2016-02-22 | 2019-03-05 | Sonos, Inc. | Default playback device designation |

| US10743101B2 (en) | 2016-02-22 | 2020-08-11 | Sonos, Inc. | Content mixing |

| US10264030B2 (en) | 2016-02-22 | 2019-04-16 | Sonos, Inc. | Networked microphone device control |

| US11137979B2 (en) | 2016-02-22 | 2021-10-05 | Sonos, Inc. | Metadata exchange involving a networked playback system and a networked microphone system |

| US10764679B2 (en) | 2016-02-22 | 2020-09-01 | Sonos, Inc. | Voice control of a media playback system |

| US11726742B2 (en) | 2016-02-22 | 2023-08-15 | Sonos, Inc. | Handling of loss of pairing between networked devices |

| US9965247B2 (en) | 2016-02-22 | 2018-05-08 | Sonos, Inc. | Voice controlled media playback system based on user profile |

| US11863593B2 (en) | 2016-02-22 | 2024-01-02 | Sonos, Inc. | Networked microphone device control |

| US11736860B2 (en) | 2016-02-22 | 2023-08-22 | Sonos, Inc. | Voice control of a media playback system |

| US11750969B2 (en) | 2016-02-22 | 2023-09-05 | Sonos, Inc. | Default playback device designation |

| US11042355B2 (en) | 2016-02-22 | 2021-06-22 | Sonos, Inc. | Handling of loss of pairing between networked devices |

| US10365889B2 (en) | 2016-02-22 | 2019-07-30 | Sonos, Inc. | Metadata exchange involving a networked playback system and a networked microphone system |

| US11006214B2 (en) | 2016-02-22 | 2021-05-11 | Sonos, Inc. | Default playback device designation |

| US10409549B2 (en) | 2016-02-22 | 2019-09-10 | Sonos, Inc. | Audio response playback |

| US11513763B2 (en) | 2016-02-22 | 2022-11-29 | Sonos, Inc. | Audio response playback |

| US12047752B2 (en) | 2016-02-22 | 2024-07-23 | Sonos, Inc. | Content mixing |

| US10970035B2 (en) | 2016-02-22 | 2021-04-06 | Sonos, Inc. | Audio response playback |

| US11832068B2 (en) | 2016-02-22 | 2023-11-28 | Sonos, Inc. | Music service selection |

| US10332537B2 (en) | 2016-06-09 | 2019-06-25 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US11133018B2 (en) | 2016-06-09 | 2021-09-28 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US9978390B2 (en) | 2016-06-09 | 2018-05-22 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US11545169B2 (en) | 2016-06-09 | 2023-01-03 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US10714115B2 (en) | 2016-06-09 | 2020-07-14 | Sonos, Inc. | Dynamic player selection for audio signal processing |

| US10134399B2 (en) | 2016-07-15 | 2018-11-20 | Sonos, Inc. | Contextualization of voice inputs |

| US10152969B2 (en) | 2016-07-15 | 2018-12-11 | Sonos, Inc. | Voice detection by multiple devices |

| US11664023B2 (en) | 2016-07-15 | 2023-05-30 | Sonos, Inc. | Voice detection by multiple devices |

| US11184969B2 (en) | 2016-07-15 | 2021-11-23 | Sonos, Inc. | Contextualization of voice inputs |

| US10699711B2 (en) | 2016-07-15 | 2020-06-30 | Sonos, Inc. | Voice detection by multiple devices |

| US11979960B2 (en) | 2016-07-15 | 2024-05-07 | Sonos, Inc. | Contextualization of voice inputs |

| US10297256B2 (en) | 2016-07-15 | 2019-05-21 | Sonos, Inc. | Voice detection by multiple devices |

| US10593331B2 (en) | 2016-07-15 | 2020-03-17 | Sonos, Inc. | Contextualization of voice inputs |

| US10354658B2 (en) | 2016-08-05 | 2019-07-16 | Sonos, Inc. | Voice control of playback device using voice assistant service(s) |

| US11531520B2 (en) | 2016-08-05 | 2022-12-20 | Sonos, Inc. | Playback device supporting concurrent voice assistants |

| US10847164B2 (en) | 2016-08-05 | 2020-11-24 | Sonos, Inc. | Playback device supporting concurrent voice assistants |

| US10115400B2 (en) | 2016-08-05 | 2018-10-30 | Sonos, Inc. | Multiple voice services |

| US10565999B2 (en) | 2016-08-05 | 2020-02-18 | Sonos, Inc. | Playback device supporting concurrent voice assistant services |

| US10565998B2 (en) | 2016-08-05 | 2020-02-18 | Sonos, Inc. | Playback device supporting concurrent voice assistant services |

| GB2567600A (en)* | 2016-08-29 | 2019-04-17 | Groove X Inc | Autonomous behavior robot recognizing direction of sound source |

| GB2567600B (en)* | 2016-08-29 | 2022-05-04 | Groove X Inc | Autonomously acting robot that recognizes direction of sound source |

| US11376740B2 (en) | 2016-08-29 | 2022-07-05 | Groove X, Inc. | Autonomously acting robot that recognizes direction of sound source |

| JPWO2018043235A1 (en)* | 2016-08-29 | 2018-12-20 | Groove X株式会社 | Autonomous robot that recognizes the direction of the sound source |

| WO2018043235A1 (en)* | 2016-08-29 | 2018-03-08 | Groove X株式会社 | Autonomous behavior type robot recognizing direction of sound source |

| JP2019169189A (en)* | 2016-09-02 | 2019-10-03 | Groove X株式会社 | Autonomously behaving robot, server, and behavior control program |

| JP7236142B2 (en) | 2016-09-02 | 2023-03-09 | Groove X株式会社 | Autonomous action robot |

| US10034116B2 (en) | 2016-09-22 | 2018-07-24 | Sonos, Inc. | Acoustic position measurement |

| US11641559B2 (en) | 2016-09-27 | 2023-05-02 | Sonos, Inc. | Audio playback settings for voice interaction |

| US10582322B2 (en) | 2016-09-27 | 2020-03-03 | Sonos, Inc. | Audio playback settings for voice interaction |

| US10117037B2 (en) | 2016-09-30 | 2018-10-30 | Sonos, Inc. | Orientation-based playback device microphone selection |

| US10873819B2 (en) | 2016-09-30 | 2020-12-22 | Sonos, Inc. | Orientation-based playback device microphone selection |

| CN109997370A (en)* | 2016-09-30 | 2019-07-09 | 搜诺思公司 | Multi-Orientation Playback Device Microphone |

| US10313812B2 (en) | 2016-09-30 | 2019-06-04 | Sonos, Inc. | Orientation-based playback device microphone selection |

| CN109997370B (en)* | 2016-09-30 | 2021-03-02 | 搜诺思公司 | Multi-orientation playback device microphone |

| WO2018064362A1 (en)* | 2016-09-30 | 2018-04-05 | Sonos, Inc. | Multi-orientation playback device microphones |

| JP2019537309A (en)* | 2016-09-30 | 2019-12-19 | ソノズ インコーポレイテッド | Multi-directional playback device microphone |

| US10075793B2 (en) | 2016-09-30 | 2018-09-11 | Sonos, Inc. | Multi-orientation playback device microphones |

| US11516610B2 (en) | 2016-09-30 | 2022-11-29 | Sonos, Inc. | Orientation-based playback device microphone selection |

| US10181323B2 (en) | 2016-10-19 | 2019-01-15 | Sonos, Inc. | Arbitration-based voice recognition |

| US10614807B2 (en) | 2016-10-19 | 2020-04-07 | Sonos, Inc. | Arbitration-based voice recognition |

| US11727933B2 (en) | 2016-10-19 | 2023-08-15 | Sonos, Inc. | Arbitration-based voice recognition |

| US11308961B2 (en) | 2016-10-19 | 2022-04-19 | Sonos, Inc. | Arbitration-based voice recognition |

| US11183181B2 (en) | 2017-03-27 | 2021-11-23 | Sonos, Inc. | Systems and methods of multiple voice services |

| US12217748B2 (en) | 2017-03-27 | 2025-02-04 | Sonos, Inc. | Systems and methods of multiple voice services |

| JP2021108228A (en)* | 2017-03-31 | 2021-07-29 | カシオ計算機株式会社 | Mobile devices, control methods and programs for mobile devices |

| US11380322B2 (en) | 2017-08-07 | 2022-07-05 | Sonos, Inc. | Wake-word detection suppression |

| US11900937B2 (en) | 2017-08-07 | 2024-02-13 | Sonos, Inc. | Wake-word detection suppression |

| US10475449B2 (en) | 2017-08-07 | 2019-11-12 | Sonos, Inc. | Wake-word detection suppression |

| US11080005B2 (en) | 2017-09-08 | 2021-08-03 | Sonos, Inc. | Dynamic computation of system response volume |

| US11500611B2 (en) | 2017-09-08 | 2022-11-15 | Sonos, Inc. | Dynamic computation of system response volume |

| US10445057B2 (en) | 2017-09-08 | 2019-10-15 | Sonos, Inc. | Dynamic computation of system response volume |

| US11500386B2 (en) | 2017-09-15 | 2022-11-15 | Sony Corporation | Control apparatus, control method, program, and mobile object |

| JP7147142B2 (en) | 2017-09-15 | 2022-10-05 | ソニーグループ株式会社 | CONTROL DEVICE, CONTROL METHOD, PROGRAM, AND MOVING OBJECT |

| JP2019053561A (en)* | 2017-09-15 | 2019-04-04 | ソニー株式会社 | Control device, control method, program, and mobile body |

| US11646045B2 (en) | 2017-09-27 | 2023-05-09 | Sonos, Inc. | Robust short-time fourier transform acoustic echo cancellation during audio playback |

| US11017789B2 (en) | 2017-09-27 | 2021-05-25 | Sonos, Inc. | Robust Short-Time Fourier Transform acoustic echo cancellation during audio playback |

| US10446165B2 (en) | 2017-09-27 | 2019-10-15 | Sonos, Inc. | Robust short-time fourier transform acoustic echo cancellation during audio playback |

| US10482868B2 (en) | 2017-09-28 | 2019-11-19 | Sonos, Inc. | Multi-channel acoustic echo cancellation |

| US11302326B2 (en) | 2017-09-28 | 2022-04-12 | Sonos, Inc. | Tone interference cancellation |

| US10051366B1 (en) | 2017-09-28 | 2018-08-14 | Sonos, Inc. | Three-dimensional beam forming with a microphone array |

| US11769505B2 (en) | 2017-09-28 | 2023-09-26 | Sonos, Inc. | Echo of tone interferance cancellation using two acoustic echo cancellers |

| US10891932B2 (en) | 2017-09-28 | 2021-01-12 | Sonos, Inc. | Multi-channel acoustic echo cancellation |

| US12047753B1 (en) | 2017-09-28 | 2024-07-23 | Sonos, Inc. | Three-dimensional beam forming with a microphone array |

| US11538451B2 (en) | 2017-09-28 | 2022-12-27 | Sonos, Inc. | Multi-channel acoustic echo cancellation |

| US10880644B1 (en) | 2017-09-28 | 2020-12-29 | Sonos, Inc. | Three-dimensional beam forming with a microphone array |

| US10621981B2 (en) | 2017-09-28 | 2020-04-14 | Sonos, Inc. | Tone interference cancellation |

| US10511904B2 (en) | 2017-09-28 | 2019-12-17 | Sonos, Inc. | Three-dimensional beam forming with a microphone array |

| US11288039B2 (en) | 2017-09-29 | 2022-03-29 | Sonos, Inc. | Media playback system with concurrent voice assistance |

| US11175888B2 (en) | 2017-09-29 | 2021-11-16 | Sonos, Inc. | Media playback system with concurrent voice assistance |

| US11893308B2 (en) | 2017-09-29 | 2024-02-06 | Sonos, Inc. | Media playback system with concurrent voice assistance |

| US10606555B1 (en) | 2017-09-29 | 2020-03-31 | Sonos, Inc. | Media playback system with concurrent voice assistance |

| US10466962B2 (en) | 2017-09-29 | 2019-11-05 | Sonos, Inc. | Media playback system with voice assistance |

| JP2019103073A (en)* | 2017-12-06 | 2019-06-24 | 東芝ライフスタイル株式会社 | Electrical apparatus and electrical apparatus system |

| US10880650B2 (en) | 2017-12-10 | 2020-12-29 | Sonos, Inc. | Network microphone devices with automatic do not disturb actuation capabilities |

| US11451908B2 (en) | 2017-12-10 | 2022-09-20 | Sonos, Inc. | Network microphone devices with automatic do not disturb actuation capabilities |

| US11676590B2 (en) | 2017-12-11 | 2023-06-13 | Sonos, Inc. | Home graph |

| US10818290B2 (en) | 2017-12-11 | 2020-10-27 | Sonos, Inc. | Home graph |

| JP7351383B2 (en) | 2018-01-09 | 2023-09-27 | ソニーグループ株式会社 | Information processing device, information processing method, and program |

| JPWO2019138619A1 (en)* | 2018-01-09 | 2021-01-28 | ソニー株式会社 | Information processing equipment, information processing methods, and programs |

| JP2022169548A (en)* | 2018-01-09 | 2022-11-09 | ソニーグループ株式会社 | Information processing device, information processing method, and program |

| EP3739415A4 (en)* | 2018-01-09 | 2021-03-03 | Sony Corporation | Information processing device, information processing method and program |

| CN111527461B (en)* | 2018-01-09 | 2024-03-22 | 索尼公司 | Information processing device, information processing method and program |

| JP7120254B2 (en) | 2018-01-09 | 2022-08-17 | ソニーグループ株式会社 | Information processing device, information processing method, and program |

| CN111527461A (en)* | 2018-01-09 | 2020-08-11 | 索尼公司 | Information processing apparatus, information processing method, and program |

| WO2019138619A1 (en)* | 2018-01-09 | 2019-07-18 | ソニー株式会社 | Information processing device, information processing method and program |

| US11689858B2 (en) | 2018-01-31 | 2023-06-27 | Sonos, Inc. | Device designation of playback and network microphone device arrangements |

| US11343614B2 (en) | 2018-01-31 | 2022-05-24 | Sonos, Inc. | Device designation of playback and network microphone device arrangements |

| JP2019145000A (en)* | 2018-02-23 | 2019-08-29 | パナソニックIpマネジメント株式会社 | Mobile robot and robot system |

| JP2019160289A (en)* | 2018-03-07 | 2019-09-19 | カシオ計算機株式会社 | Autonomous mobile device, autonomous mobile method and program |

| JP7225763B2 (en) | 2018-03-07 | 2023-02-21 | カシオ計算機株式会社 | AUTONOMOUS MOBILE DEVICE, AUTONOMOUS MOVEMENT METHOD AND PROGRAM |

| US12360734B2 (en) | 2018-05-10 | 2025-07-15 | Sonos, Inc. | Systems and methods for voice-assisted media content selection |

| US11797263B2 (en) | 2018-05-10 | 2023-10-24 | Sonos, Inc. | Systems and methods for voice-assisted media content selection |

| US11175880B2 (en) | 2018-05-10 | 2021-11-16 | Sonos, Inc. | Systems and methods for voice-assisted media content selection |

| US10847178B2 (en) | 2018-05-18 | 2020-11-24 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection |

| US11715489B2 (en) | 2018-05-18 | 2023-08-01 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection |

| US11792590B2 (en) | 2018-05-25 | 2023-10-17 | Sonos, Inc. | Determining and adapting to changes in microphone performance of playback devices |

| US10959029B2 (en) | 2018-05-25 | 2021-03-23 | Sonos, Inc. | Determining and adapting to changes in microphone performance of playback devices |

| US10681460B2 (en) | 2018-06-28 | 2020-06-09 | Sonos, Inc. | Systems and methods for associating playback devices with voice assistant services |

| US11197096B2 (en) | 2018-06-28 | 2021-12-07 | Sonos, Inc. | Systems and methods for associating playback devices with voice assistant services |

| US11696074B2 (en) | 2018-06-28 | 2023-07-04 | Sonos, Inc. | Systems and methods for associating playback devices with voice assistant services |

| WO2020034207A1 (en) | 2018-08-17 | 2020-02-20 | SZ DJI Technology Co., Ltd. | Photographing control method and controller |

| US11388343B2 (en) | 2018-08-17 | 2022-07-12 | SZ DJI Technology Co., Ltd. | Photographing control method and controller with target localization based on sound detectors |

| CN111213365A (en)* | 2018-08-17 | 2020-05-29 | 深圳市大疆创新科技有限公司 | Shooting control method and controller |

| EP3711284A4 (en)* | 2018-08-17 | 2020-12-16 | SZ DJI Technology Co., Ltd. | Photographing control method and controller |

| US11563842B2 (en) | 2018-08-28 | 2023-01-24 | Sonos, Inc. | Do not disturb feature for audio notifications |

| US11076035B2 (en) | 2018-08-28 | 2021-07-27 | Sonos, Inc. | Do not disturb feature for audio notifications |

| US11482978B2 (en) | 2018-08-28 | 2022-10-25 | Sonos, Inc. | Audio notifications |

| US10797667B2 (en) | 2018-08-28 | 2020-10-06 | Sonos, Inc. | Audio notifications |

| US11551690B2 (en) | 2018-09-14 | 2023-01-10 | Sonos, Inc. | Networked devices, systems, and methods for intelligently deactivating wake-word engines |

| US11778259B2 (en) | 2018-09-14 | 2023-10-03 | Sonos, Inc. | Networked devices, systems and methods for associating playback devices based on sound codes |

| US11432030B2 (en) | 2018-09-14 | 2022-08-30 | Sonos, Inc. | Networked devices, systems, and methods for associating playback devices based on sound codes |

| US10878811B2 (en) | 2018-09-14 | 2020-12-29 | Sonos, Inc. | Networked devices, systems, and methods for intelligently deactivating wake-word engines |

| US10587430B1 (en) | 2018-09-14 | 2020-03-10 | Sonos, Inc. | Networked devices, systems, and methods for associating playback devices based on sound codes |

| US12230291B2 (en) | 2018-09-21 | 2025-02-18 | Sonos, Inc. | Voice detection optimization using sound metadata |

| US11790937B2 (en) | 2018-09-21 | 2023-10-17 | Sonos, Inc. | Voice detection optimization using sound metadata |

| US11024331B2 (en) | 2018-09-21 | 2021-06-01 | Sonos, Inc. | Voice detection optimization using sound metadata |

| US12165651B2 (en) | 2018-09-25 | 2024-12-10 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US10573321B1 (en) | 2018-09-25 | 2020-02-25 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US11727936B2 (en) | 2018-09-25 | 2023-08-15 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US11031014B2 (en) | 2018-09-25 | 2021-06-08 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US10811015B2 (en) | 2018-09-25 | 2020-10-20 | Sonos, Inc. | Voice detection optimization based on selected voice assistant service |

| US11790911B2 (en) | 2018-09-28 | 2023-10-17 | Sonos, Inc. | Systems and methods for selective wake word detection using neural network models |

| US11100923B2 (en) | 2018-09-28 | 2021-08-24 | Sonos, Inc. | Systems and methods for selective wake word detection using neural network models |

| US12165644B2 (en) | 2018-09-28 | 2024-12-10 | Sonos, Inc. | Systems and methods for selective wake word detection |

| US10692518B2 (en) | 2018-09-29 | 2020-06-23 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection via multiple network microphone devices |

| US12062383B2 (en) | 2018-09-29 | 2024-08-13 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection via multiple network microphone devices |

| US11501795B2 (en) | 2018-09-29 | 2022-11-15 | Sonos, Inc. | Linear filtering for noise-suppressed speech detection via multiple network microphone devices |

| JP7322374B2 (en) | 2018-10-03 | 2023-08-08 | カシオ計算機株式会社 | ROBOT CONTROL DEVICE, ROBOT, ROBOT CONTROL METHOD AND PROGRAM |

| JP2020056935A (en)* | 2018-10-03 | 2020-04-09 | カシオ計算機株式会社 | Robot control device, robot, robot control method and program |

| US11899519B2 (en) | 2018-10-23 | 2024-02-13 | Sonos, Inc. | Multiple stage network microphone device with reduced power consumption and processing load |

| US11200889B2 (en) | 2018-11-15 | 2021-12-14 | Sonos, Inc. | Dilated convolutions and gating for efficient keyword spotting |

| US11741948B2 (en) | 2018-11-15 | 2023-08-29 | Sonos Vox France Sas | Dilated convolutions and gating for efficient keyword spotting |

| US11557294B2 (en) | 2018-12-07 | 2023-01-17 | Sonos, Inc. | Systems and methods of operating media playback systems having multiple voice assistant services |

| US11183183B2 (en) | 2018-12-07 | 2021-11-23 | Sonos, Inc. | Systems and methods of operating media playback systems having multiple voice assistant services |

| US11132989B2 (en) | 2018-12-13 | 2021-09-28 | Sonos, Inc. | Networked microphone devices, systems, and methods of localized arbitration |

| US11538460B2 (en) | 2018-12-13 | 2022-12-27 | Sonos, Inc. | Networked microphone devices, systems, and methods of localized arbitration |

| US11159880B2 (en) | 2018-12-20 | 2021-10-26 | Sonos, Inc. | Optimization of network microphone devices using noise classification |

| US11540047B2 (en) | 2018-12-20 | 2022-12-27 | Sonos, Inc. | Optimization of network microphone devices using noise classification |

| US10602268B1 (en) | 2018-12-20 | 2020-03-24 | Sonos, Inc. | Optimization of network microphone devices using noise classification |

| US11315556B2 (en) | 2019-02-08 | 2022-04-26 | Sonos, Inc. | Devices, systems, and methods for distributed voice processing by transmitting sound data associated with a wake word to an appropriate device for identification |

| US10867604B2 (en) | 2019-02-08 | 2020-12-15 | Sonos, Inc. | Devices, systems, and methods for distributed voice processing |

| US11646023B2 (en) | 2019-02-08 | 2023-05-09 | Sonos, Inc. | Devices, systems, and methods for distributed voice processing |

| US11798553B2 (en) | 2019-05-03 | 2023-10-24 | Sonos, Inc. | Voice assistant persistence across multiple network microphone devices |

| US11120794B2 (en) | 2019-05-03 | 2021-09-14 | Sonos, Inc. | Voice assistant persistence across multiple network microphone devices |

| US11361756B2 (en) | 2019-06-12 | 2022-06-14 | Sonos, Inc. | Conditional wake word eventing based on environment |

| US11854547B2 (en) | 2019-06-12 | 2023-12-26 | Sonos, Inc. | Network microphone device with command keyword eventing |

| US10586540B1 (en) | 2019-06-12 | 2020-03-10 | Sonos, Inc. | Network microphone device with command keyword conditioning |

| US11501773B2 (en) | 2019-06-12 | 2022-11-15 | Sonos, Inc. | Network microphone device with command keyword conditioning |

| US11200894B2 (en) | 2019-06-12 | 2021-12-14 | Sonos, Inc. | Network microphone device with command keyword eventing |

| US11138975B2 (en) | 2019-07-31 | 2021-10-05 | Sonos, Inc. | Locally distributed keyword detection |

| US12211490B2 (en) | 2019-07-31 | 2025-01-28 | Sonos, Inc. | Locally distributed keyword detection |

| US11710487B2 (en) | 2019-07-31 | 2023-07-25 | Sonos, Inc. | Locally distributed keyword detection |

| US11714600B2 (en) | 2019-07-31 | 2023-08-01 | Sonos, Inc. | Noise classification for event detection |

| US11354092B2 (en) | 2019-07-31 | 2022-06-07 | Sonos, Inc. | Noise classification for event detection |

| US11551669B2 (en) | 2019-07-31 | 2023-01-10 | Sonos, Inc. | Locally distributed keyword detection |

| US11138969B2 (en) | 2019-07-31 | 2021-10-05 | Sonos, Inc. | Locally distributed keyword detection |

| US10871943B1 (en) | 2019-07-31 | 2020-12-22 | Sonos, Inc. | Noise classification for event detection |

| US11189286B2 (en) | 2019-10-22 | 2021-11-30 | Sonos, Inc. | VAS toggle based on device orientation |

| US11862161B2 (en) | 2019-10-22 | 2024-01-02 | Sonos, Inc. | VAS toggle based on device orientation |

| US11869503B2 (en) | 2019-12-20 | 2024-01-09 | Sonos, Inc. | Offline voice control |

| US11200900B2 (en) | 2019-12-20 | 2021-12-14 | Sonos, Inc. | Offline voice control |

| US11562740B2 (en) | 2020-01-07 | 2023-01-24 | Sonos, Inc. | Voice verification for media playback |

| US11556307B2 (en) | 2020-01-31 | 2023-01-17 | Sonos, Inc. | Local voice data processing |

| US11308958B2 (en) | 2020-02-07 | 2022-04-19 | Sonos, Inc. | Localized wakeword verification |

| US11961519B2 (en) | 2020-02-07 | 2024-04-16 | Sonos, Inc. | Localized wakeword verification |

| US11308962B2 (en) | 2020-05-20 | 2022-04-19 | Sonos, Inc. | Input detection windowing |

| US11694689B2 (en) | 2020-05-20 | 2023-07-04 | Sonos, Inc. | Input detection windowing |

| US11482224B2 (en) | 2020-05-20 | 2022-10-25 | Sonos, Inc. | Command keywords with input detection windowing |

| US11727919B2 (en) | 2020-05-20 | 2023-08-15 | Sonos, Inc. | Memory allocation for keyword spotting engines |

| US12387716B2 (en) | 2020-06-08 | 2025-08-12 | Sonos, Inc. | Wakewordless voice quickstarts |

| JP7411899B2 (en) | 2020-07-28 | 2024-01-12 | パナソニックIpマネジメント株式会社 | autonomous vacuum cleaner |

| JP2022024907A (en)* | 2020-07-28 | 2022-02-09 | パナソニックIpマネジメント株式会社 | Autonomous vacuum cleaner |

| US11698771B2 (en) | 2020-08-25 | 2023-07-11 | Sonos, Inc. | Vocal guidance engines for playback devices |

| US12283269B2 (en) | 2020-10-16 | 2025-04-22 | Sonos, Inc. | Intent inference in audiovisual communication sessions |

| CN112312014A (en)* | 2020-10-23 | 2021-02-02 | 移康智能科技(上海)股份有限公司 | Sound and camera linked system |

| US12424220B2 (en) | 2020-11-12 | 2025-09-23 | Sonos, Inc. | Network device interaction by range |

| US11984123B2 (en) | 2020-11-12 | 2024-05-14 | Sonos, Inc. | Network device interaction by range |

| US11551700B2 (en) | 2021-01-25 | 2023-01-10 | Sonos, Inc. | Systems and methods for power-efficient keyword detection |

| US12327556B2 (en) | 2021-09-30 | 2025-06-10 | Sonos, Inc. | Enabling and disabling microphones and voice assistants |

| US12327549B2 (en) | 2022-02-09 | 2025-06-10 | Sonos, Inc. | Gatekeeping for voice intent processing |

| CN115032468B (en)* | 2022-08-10 | 2022-10-21 | 广东电网有限责任公司佛山供电局 | Device and method for identifying direction of charged body |

| CN115032468A (en)* | 2022-08-10 | 2022-09-09 | 广东电网有限责任公司佛山供电局 | Device and method for identifying direction of charged body |

| CN118400484A (en)* | 2024-06-25 | 2024-07-26 | 广东岭南职业技术学院 | Intelligent conference recording equipment and conference recording modeling method |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2008158868A (en) | Mobile body and control method thereof | |

| JP5392028B2 (en) | Autonomous mobile robot | |

| JP4675811B2 (en) | Position detection device, autonomous mobile device, position detection method, and position detection program | |

| US11037561B2 (en) | Method and apparatus for voice interaction control of smart device | |

| JP4266211B2 (en) | Robot device, method of moving robot device, and program | |

| JP2006350776A (en) | Mobile path generation device | |

| JP5366048B2 (en) | Information provision system | |

| JP4276624B2 (en) | Robot control apparatus, robot control method, and robot control program | |

| JP3906743B2 (en) | Guide robot | |

| US8010231B2 (en) | Communication robot | |

| US11241790B2 (en) | Autonomous moving body and control program for autonomous moving body | |

| KR20100092807A (en) | Mobile robot and method for moving of mobile robot | |

| JP2005529421A (en) | Movable unit and method for controlling movable unit | |

| US20130218395A1 (en) | Autonomous moving apparatus and method for controlling the same | |

| JP2015081831A (en) | SOUND SOURCE POSITION ESTIMATION DEVICE, MOBILE BODY, AND MOBILE BODY CONTROL METHOD | |

| JP2008087140A (en) | Speech recognition robot and method for controlling speech recognition robot | |

| JP5411789B2 (en) | Communication robot | |

| US7546179B2 (en) | Method and apparatus for allowing mobile robot to return to docking station | |

| JP2018163614A (en) | Autonomous mobile device, autonomous mobile method and program | |

| JP2012208782A (en) | Move prediction apparatus, robot control device, move prediction program and move prediction method | |

| JP2009223757A (en) | Autonomous mobile body, control system, and self-position estimation method | |

| JP3768957B2 (en) | Mobile robot path setting method | |

| JP4764377B2 (en) | Mobile robot | |

| CN111055288B (en) | On-call robot control method, storage medium and robot | |