JP2007251518A - Image processing apparatus, image forming apparatus, program, and image processing method - Google Patents

Image processing apparatus, image forming apparatus, program, and image processing methodDownload PDFInfo

- Publication number

- JP2007251518A JP2007251518AJP2006071044AJP2006071044AJP2007251518AJP 2007251518 AJP2007251518 AJP 2007251518AJP 2006071044 AJP2006071044 AJP 2006071044AJP 2006071044 AJP2006071044 AJP 2006071044AJP 2007251518 AJP2007251518 AJP 2007251518A

- Authority

- JP

- Japan

- Prior art keywords

- image

- image data

- feature

- pixel

- normalization

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

Images

Landscapes

- Editing Of Facsimile Originals (AREA)

- Facsimile Image Signal Circuits (AREA)

- Image Analysis (AREA)

- Processing Or Creating Images (AREA)

- Image Processing (AREA)

Abstract

Translated fromJapaneseDescription

Translated fromJapanese本発明は、受け付けた画像データを蓄積または送信する際に、画像データを理想的な形に変換するための正規化処理を行なう画像処理装置、画像形成装置、プログラムおよび画像処理方法に関する。 The present invention relates to an image processing apparatus, an image forming apparatus, a program, and an image processing method that perform normalization processing for converting image data into an ideal form when storing or transmitting received image data.

従来、スキャナやデジタルカメラなどの様々な端末機器から画像データを含む文書データを取得し、この文書データを適切に配信するための文書管理システムが知られている。また、配信先としては、利用者の個人利用環境や共同蓄積管理環境がある。利用者の個人利用環境としては、例えば電子メールがあり、上記文書管理システムは設定された利用者の電子メールアドレスへ端末機器から受信した文書データを配信する。利用者は画像データを含む文書データをPC(パーソナルコンピュータ)のディスプレイで閲覧したり、紙に出力したりして利用する。 Conventionally, document management systems for acquiring document data including image data from various terminal devices such as a scanner and a digital camera and appropriately distributing the document data are known. Distribution destinations include a user's personal use environment and a shared storage management environment. The user's personal use environment is e-mail, for example, and the document management system distributes the document data received from the terminal device to the set e-mail address of the user. A user browses document data including image data on a display of a PC (personal computer) or outputs it on paper.

共同蓄積管理環境としては、PC上にて文書データの蓄積管理を実現する文書管理サーバ等があり、サーバは設定された蓄積管理ソフトウェアへ文書データを配信する。利用者は文書管理サーバにアクセスすることで、画像データを含む文書データをPCのディスプレイで閲覧したり、紙に出力したりして利用する。 As a joint storage management environment, there is a document management server or the like that realizes storage management of document data on a PC, and the server distributes the document data to the set storage management software. By accessing the document management server, the user browses document data including image data on the display of the PC or outputs it on paper.

ところで、一般的に、印刷物はディザ法などによりドットパターンとして擬似中間調表現がなされ、したがって本来連続階調であるべき部分がこのドットパターンの持つ周波数特性を持つことになる。このような特性をもつ印刷物を、光学的にスキャンし、閲覧あるいは紙出力する場合、読み取り装置/閲覧装置/出力装置の持つそれぞれの周波数特性と干渉してモアレを生じさせる。 By the way, generally, a printed matter is expressed as a pseudo halftone as a dot pattern by a dither method or the like, and therefore, a portion that should originally be a continuous tone has the frequency characteristics of this dot pattern. When a printed matter having such characteristics is optically scanned and browsed or output on paper, it causes moiré by interfering with the respective frequency characteristics of the reading device / browsing device / output device.

また、スキャナやデジタルカメラなどの端末機器から印刷物をデジタル画像データとして入力する場合において、端末機器の設定が適切でない場合には、黒文字が薄かったり、文字と地肌のコントラストが貧弱であったりするために、文字の視認性が低下するといった、階調性の問題が生じることがある。 In addition, when inputting printed materials as digital image data from a terminal device such as a scanner or digital camera, if the settings of the terminal device are not appropriate, black characters may be thin or the contrast between characters and background may be poor. In addition, there may be a problem of gradation such that the visibility of characters is reduced.

さらに、印刷物の各ページの枠は、デジタル画像データにおいては直立長方形として入力されるべきであるが、実際には傾いて入力されることがある。このような画像を印刷・表示すると、ページ枠に平行であるべき文字行が傾いて再現されるために、読み手に不快感を与えたり、あるいは、文書画像を、文字領域、写真領域、図領域、表領域、罫線領域などに分割するレイアウト解析処理に弊害をもたらすことがある。 Further, the frame of each page of the printed material should be input as an upright rectangle in the digital image data, but may be input in an inclined manner in practice. When such an image is printed / displayed, the character lines that should be parallel to the page frame are reproduced in an inclined manner, so that the reader is uncomfortable or the document image is displayed in the character area, photo area, figure area. In some cases, the layout analysis process for dividing the table area, the ruled line area, or the like may be harmful.

ここで、文字情報が主体である印刷文書の場合における理想的な入力デジタル画像データとは、中間調部分が連続階調で表現されており、黒文字が十分に濃く、かつ、文字と地肌のコントラストが高く、さらに、各ページの枠が直立長方形となっているようなものである。 Here, the ideal input digital image data in the case of a printed document mainly consisting of character information means that the halftone part is expressed by continuous tone, the black character is sufficiently dark, and the contrast between the character and the background In addition, the frame of each page is like an upright rectangle.

そこで、従来においては、入力したデジタル文書画像データを蓄積したり、あるいは、ネットワークを通して遠隔地に送信する場合、あるいは、ネットワークを通して配信されてきたデジタル文書画像データを受信して、蓄積したり、さらに、遠隔地に送信する場合には、デジタル文書画像データを理想的な形に変換するための「正規化処理」を行なうようにしたものが提案されている。具体的には、デジタル文書画像データの蓄積・送信の際に、中間調ドットパターンの連続階調への補正処理(例えば、特許文献1参照)、文字と地肌間のコントラスト強調処理(例えば、特許文献2参照)、スキュー補正処理(例えば、特許文献3参照)、などを施すようにしている。これにより、蓄積・送信されたデジタル文書画像データは、印刷・閲覧・編集などの様々な用途について、容易に再利用することができるようになる。そうでなければ、蓄積・送信されたデジタル文書画像データを利用するたびに、補正処理を施さなければならなくなるという煩わしさが生じる。 Therefore, conventionally, the input digital document image data is accumulated, or when transmitted to a remote place through a network, or the digital document image data distributed through the network is received and accumulated, In the case of transmission to a remote place, there has been proposed one that performs “normalization processing” for converting digital document image data into an ideal form. Specifically, when digital document image data is stored / transmitted, a halftone dot pattern is corrected to a continuous tone (see, for example, Patent Document 1), and a contrast enhancement process between characters and background (for example, a patent). Reference 2), skew correction processing (see, for example, Patent Document 3), and the like are performed. As a result, the stored and transmitted digital document image data can be easily reused for various uses such as printing, browsing, and editing. Otherwise, every time the stored / transmitted digital document image data is used, there is a trouble that correction processing must be performed.

特に、ネットワークを通して配信されてきた画像を受信して処理する場合には、入力機器の特性や機器のパラメータ設定などの入力条件がわからないことが多いので、受信した画像から得られる統計量だけをもとに処理を行わなければならない。この実現手段として、特許文献4には、印刷原稿を画像入力機器でスキャンして得られたデジタル画像データを受信して蓄積または送信する文書画像伝達装置において、デジタル画像データに対して、デジタル画像データの持つ統計量に基づき該デジタル画像データの正規化処理を施す画像処理手段を備え、該画像処理手段による処理を施した後のデジタル画像データを蓄積または送信することを特徴とする発明が開示されている。 In particular, when receiving and processing images distributed over a network, input conditions such as input device characteristics and device parameter settings are often unknown, so only statistics obtained from received images can be obtained. And processing must be done. As a means for realizing this, Japanese Patent Application Laid-Open No. H10-228561 discloses a digital image for a digital image data in a document image transmission apparatus that receives and stores or transmits digital image data obtained by scanning a printed document with an image input device. Disclosed is an invention characterized by comprising image processing means for performing normalization processing of the digital image data based on statistics possessed by data, and storing or transmitting the digital image data after processing by the image processing means. Has been.

ところで、一口に印刷文書と言っても様々なものがある。新聞記事のように文字が主体のものもあれば、広告のように絵や写真が主体で、文字が少ないものもある。中には写真だけのページもある。 By the way, there are various types of printed documents. Some articles are mainly texts, such as newspaper articles, while others are mainly pictures and photos and few letters, like advertisements. Some pages are just photos.

上述した特許文献3に記載されているようなスキュー補正処理を行うには、補正パラメータの計算のために、統計的に十分な数の文字が画像中に存在することが必要である。ところが、写真が主体で、文字が少ないような画像にスキュー補正を施そうとすると、補正パラメータの計算を適切に行うことができないために、スキュー補正によって、かえって画像の歪みを生ずることがあり得る。 In order to perform the skew correction processing described in

また、文字と地肌間のコントラスト強調処理は、文字が殆どないような画像においては意味をなさない。さらに、特許文献3に記載されているように、階調変換関数を決定するために文字が画像中に存在することが必要であるが、文字が殆どないような画像からは階調変換関数を適切に算出することができないために、コントラスト強調処理によってかえって画像の歪みを生ずることがあり得る。 Further, the contrast enhancement process between the character and the background does not make sense in an image having few characters. Further, as described in

本発明は、上記に鑑みてなされたものであって、画像データの画像タイプに適した正規化処理を適用して、画像の歪みをもたらすことなく、画像データを理想的な表現に変換した形で送信または蓄積することができる画像処理装置、画像形成装置、プログラムおよび画像処理方法を提供することを目的とする。 The present invention has been made in view of the above, and is a form in which image data is converted into an ideal representation without applying image distortion by applying a normalization process suitable for the image type of the image data. It is an object of the present invention to provide an image processing apparatus, an image forming apparatus, a program, and an image processing method that can be transmitted or stored in a computer.

上述した課題を解決し、目的を達成するために、請求項1にかかる発明は、受け付けた画像データを蓄積または送信する際に、前記画像データを理想的な形に変換するための正規化処理を行なう画像処理装置において、前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算手段と、この画像特徴量計算手段により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別手段と、画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶手段と、前記画像タイプ識別手段による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択手段と、この選択手段で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化手段と、を備える。 In order to solve the above-described problems and achieve the object, the invention according to

また、請求項2にかかる発明は、請求項1記載の画像処理装置において、前記画像特徴量計算手段は、前記画像データを矩形ブロックに排他的に分割するブロック分割手段と、分割された前記各ブロックを、当該画像データを構成する所定の構成要素に分類するブロック分類手段と、前記ブロックの分類結果に基づいて前記画像データの画像特徴量を計算する計算手段と、を備える。 According to a second aspect of the present invention, in the image processing apparatus according to the first aspect, the image feature amount calculating unit includes a block dividing unit that exclusively divides the image data into rectangular blocks, and each of the divided pieces. Block classification means for classifying the blocks into predetermined constituent elements constituting the image data; and calculation means for calculating an image feature amount of the image data based on the classification result of the blocks.

また、請求項3にかかる発明は、請求項2記載の画像処理装置において、前記ブロック分類手段は、前記ブロックから複数の異なる解像度の画像を生成する画像生成手段と、前記各解像度の画像から特徴量ベクトルを計算する特徴量ベクトル計算手段と、前記特徴量ベクトルに基づいて前記各ブロックを所定の構成要素に分類する分類手段と、を備える。 According to a third aspect of the present invention, in the image processing apparatus according to the second aspect, the block classification unit is characterized by an image generation unit that generates a plurality of images having different resolutions from the block, and the image of each resolution. A feature vector calculating unit that calculates a quantity vector; and a classifying unit that classifies the blocks into predetermined components based on the feature vector.

また、請求項4にかかる発明は、請求項3記載の画像処理装置において、前記特徴量ベクトル計算手段は、前記各解像度の画像を2値化する2値化手段と、2値画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、を備える。 According to a fourth aspect of the present invention, in the image processing apparatus according to the third aspect, the feature quantity vector calculating unit includes a binarizing unit that binarizes the image of each resolution and each of the binary images. A pixel feature calculation means for calculating a feature using a value of a corresponding pixel of a local pattern constituted by the pixel and its neighboring pixels, and an addition means for adding the feature calculated for each pixel over the entire image; Is provided.

また、請求項5にかかる発明は、請求項3記載の画像処理装置において、前記特徴量ベクトル計算手段は、前記各解像度の画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、を備える。 According to a fifth aspect of the present invention, in the image processing apparatus according to the third aspect, the feature amount vector calculating unit is configured to generate a local pattern composed of the pixel and its neighboring pixels for each pixel of the image of each resolution. Pixel feature calculation means for calculating a feature using the value of the corresponding pixel, and addition means for adding the feature calculated for each pixel over the entire image.

また、請求項6にかかる発明は、請求項3記載の画像処理装置において、前記分類手段は、前記特徴量ベクトル計算手段により計算された前記特徴量ベクトルを、予め計算されている文字画素の特徴量ベクトル及び非文字画素の特徴量ベクトルの線形結合に分解して、前記各ブロックを所定の構成要素に分類する。 According to a sixth aspect of the present invention, in the image processing apparatus according to the third aspect, the classification means uses the feature quantity vector calculated by the feature quantity vector calculation means as the feature of a character pixel calculated in advance. The blocks are classified into predetermined constituent elements by decomposing them into linear combinations of quantity vectors and feature quantity vectors of non-character pixels.

また、請求項7にかかる発明は、請求項1ないし6のいずれか一記載の画像処理装置において、前記正規化処理方法の一つは、前記画像データ中の中間調ドットパターンを、当該中間調ドットパターンの統計量に基づき連続階調に変換する中間調変換処理である。 According to a seventh aspect of the present invention, in the image processing apparatus according to any one of the first to sixth aspects, one of the normalization processing methods is to convert a halftone dot pattern in the image data into the halftone. This is a halftone conversion process for converting to continuous tone based on the statistic of the dot pattern.

また、請求項8にかかる発明は、請求項1ないし6のいずれか一記載の画像処理装置において、前記正規化処理方法の一つは、前記画像データ中の黒文字色と紙面色を、当該画像データの統計量に基づき推定し、推定した黒文字色と紙面色とをもとに階調補正を行う階調補正処理である。 According to an eighth aspect of the present invention, in the image processing apparatus according to any one of the first to sixth aspects, one of the normalization processing methods is configured to convert a black character color and a paper surface color in the image data into the image image. This is a gradation correction process that is estimated based on the statistics of data and performs gradation correction based on the estimated black character color and paper color.

また、請求項9にかかる発明は、請求項1ないし6のいずれか一記載の画像処理装置において、前記正規化処理方法の一つは、前記画像データの傾きを、当該画像データの統計量に基づき推定し、推定した傾きを補正するスキュー補正処理である。 According to a ninth aspect of the present invention, in the image processing apparatus according to any one of the first to sixth aspects, the normalization processing method uses the inclination of the image data as a statistic of the image data. This is a skew correction process that estimates based on this and corrects the estimated inclination.

また、請求項10にかかる発明は、画像読取手段により読み取られた画像データを理想的な形に変換するための正規化処理を行ない、画像を用紙上に印刷する画像形成装置において、前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算手段と、この画像特徴量計算手段により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別手段と、画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶手段と、前記画像タイプ識別手段による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択手段と、この選択手段で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化手段と、を備える。 According to a tenth aspect of the present invention, in the image forming apparatus for performing normalization processing for converting the image data read by the image reading means into an ideal form and printing the image on a sheet, the image data The image feature quantity calculating means for calculating the image feature quantity of the image based on the outline of the layout, and the image type for classifying the image type of the image data using the image feature quantity calculated by the image feature quantity calculation means Information for associating identification means, storage means for storing information associating correspondence types of image types with image normalization processing, and information for associating classification results and image types with correspondence rules of image normalization processing by the image type identification means Based on the image normalization processing method, and the image normalization processing method selected by the selection means, based on the image data Comprising a normalization means for applying-normalized process, the.

また、請求項11にかかる発明は、請求項10記載の画像形成装置において、前記画像特徴量計算手段は、前記画像データを矩形ブロックに排他的に分割するブロック分割手段と、分割された前記各ブロックを、当該画像データを構成する所定の構成要素に分類するブロック分類手段と、前記ブロックの分類結果に基づいて前記画像データの画像特徴量を計算する計算手段と、を備える。 According to an eleventh aspect of the present invention, in the image forming apparatus according to the tenth aspect, the image feature amount calculating means includes a block dividing means for exclusively dividing the image data into rectangular blocks, and each of the divided pieces. Block classification means for classifying the blocks into predetermined constituent elements constituting the image data; and calculation means for calculating an image feature amount of the image data based on the classification result of the blocks.

また、請求項12にかかる発明は、請求項11記載の画像形成装置において、前記ブロック分類手段は、前記ブロックから複数の異なる解像度の画像を生成する画像生成手段と、前記各解像度の画像から特徴量ベクトルを計算する特徴量ベクトル計算手段と、前記特徴量ベクトルに基づいて前記各ブロックを所定の構成要素に分類する分類手段と、を備える。 According to a twelfth aspect of the present invention, in the image forming apparatus according to the eleventh aspect, the block classification unit is characterized by an image generation unit that generates a plurality of images having different resolutions from the block, and the image of each resolution. A feature vector calculating unit that calculates a quantity vector; and a classifying unit that classifies the blocks into predetermined components based on the feature vector.

また、請求項13にかかる発明は、請求項12記載の画像形成装置において、前記特徴量ベクトル計算手段は、前記各解像度の画像を2値化する2値化手段と、2値画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、を備える。 According to a thirteenth aspect of the present invention, in the image forming apparatus according to the twelfth aspect, the feature amount vector calculating unit includes a binarizing unit that binarizes the image of each resolution, and each of the binary images. A pixel feature calculation means for calculating a feature using a value of a corresponding pixel of a local pattern constituted by the pixel and its neighboring pixels, and an addition means for adding the feature calculated for each pixel over the entire image; Is provided.

また、請求項14にかかる発明は、請求項12記載の画像形成装置において、前記特徴量ベクトル計算手段は、前記各解像度の画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、を備える。 According to a fourteenth aspect of the present invention, in the image forming apparatus according to the twelfth aspect, the feature amount vector calculating unit is configured to generate a local pattern composed of the pixel and its neighboring pixels for each pixel of the image of each resolution. Pixel feature calculation means for calculating a feature using the value of the corresponding pixel, and addition means for adding the feature calculated for each pixel over the entire image.

また、請求項15にかかる発明は、請求項12記載の画像形成装置において、前記分類手段は、前記特徴量ベクトル計算手段により計算された前記特徴量ベクトルを、予め計算されている文字画素の特徴量ベクトル及び非文字画素の特徴量ベクトルの線形結合に分解して、前記各ブロックを所定の構成要素に分類する。 According to a fifteenth aspect of the present invention, in the image forming apparatus according to the twelfth aspect, the classification unit uses the feature vector calculated by the feature vector calculation unit as the feature of the character pixel calculated in advance. The blocks are classified into predetermined constituent elements by decomposing them into linear combinations of quantity vectors and feature quantity vectors of non-character pixels.

また、請求項16にかかる発明は、請求項10ないし15のいずれか一記載の画像形成装置において、前記正規化処理方法の一つは、前記画像データ中の中間調ドットパターンを、当該中間調ドットパターンの統計量に基づき連続階調に変換する中間調変換処理である。 According to a sixteenth aspect of the present invention, in the image forming apparatus according to any one of the tenth to fifteenth aspects, one of the normalization processing methods is to convert a halftone dot pattern in the image data into the halftone. This is a halftone conversion process for converting to continuous tone based on the statistic of the dot pattern.

また、請求項17にかかる発明は、請求項10ないし15のいずれか一記載の画像形成装置において、前記正規化処理方法の一つは、前記画像データ中の黒文字色と紙面色を、当該画像データの統計量に基づき推定し、推定した黒文字色と紙面色とをもとに階調補正を行う階調補正処理である。 According to a seventeenth aspect of the present invention, in the image forming apparatus according to any one of the tenth to fifteenth aspects, one of the normalization processing methods is to convert the black character color and the paper surface color in the image data into the image image. This is a gradation correction process that is estimated based on the statistics of data and performs gradation correction based on the estimated black character color and paper color.

また、請求項18にかかる発明は、請求項10ないし15のいずれか一記載の画像形成装置において、前記正規化処理方法の一つは、前記画像データの傾きを、当該画像データの統計量に基づき推定し、推定した傾きを補正するスキュー補正処理である。 According to an eighteenth aspect of the present invention, in the image forming apparatus according to any one of the tenth to fifteenth aspects, one of the normalization processing methods uses the inclination of the image data as a statistic of the image data. This is a skew correction process that estimates based on this and corrects the estimated inclination.

また、請求項19にかかる発明は、受け付けた画像データを蓄積または送信する際に、前記画像データを理想的な形に変換するための正規化処理をコンピュータに実行させるプログラムであって、前記コンピュータに、前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算機能と、この画像特徴量計算機能により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別機能と、画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶機能と、前記画像タイプ識別機能による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択機能と、この選択機能で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化機能と、を実行させる。 The invention according to claim 19 is a program for causing a computer to execute normalization processing for converting the image data into an ideal form when storing or transmitting the received image data. In addition, the image feature amount calculation function for calculating the image feature amount of the image data based on the outline of the layout, and the image feature amount calculated by the image feature amount calculation function, the image type of the image data is Image type identification function for classifying identification, storage function for storing information in which correspondence rules for image types and image normalization processing are associated, classification results by the image type identification function, and correspondence rules for image types and image normalization processing A selection function for selecting an image normalization processing method based on information associated with the image normalization processing method and an image normalization processing method selected by the selection function. Zui and to execute, and normalized function of applying normalization process on the image data.

また、請求項20にかかる発明は、受け付けた画像データを蓄積または送信する際に、前記画像データを理想的な形に変換するための正規化処理を実行するコンピュータにおける画像処理方法であって、前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算工程と、この画像特徴量計算工程により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別工程と、画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶工程と、前記画像タイプ識別工程による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択工程と、この選択工程で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化工程と、を含む。 The invention according to

請求項1,19,20にかかる発明によれば、レイアウトの概略(文字や写真・絵の大体の空間的配置や分布など)に基づいて計算された画像データの画像特徴量を用いて当該画像データの画像タイプが分類識別された後、分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて画像正規化処理方法が選択され、選択された画像正規化処理方法に基づいて画像データに対して正規化処理が施され、送信または蓄積される。これにより、レイアウトの概略(文字や写真・絵の大体の空間的配置や文字と写真・絵の分布など)に従うことで画像のタイプを特徴付ける画像特徴量を高速に計算することができるとともに、画像データの画像タイプに適した正規化処理を適用して、画像の歪みをもたらすことなく、画像データを理想的な表現に変換した形で送信または蓄積することができるという効果を奏する。 According to the inventions according to

また、請求項2,11にかかる発明によれば、文字や写真・絵の大体の空間的配置、文字と写真・絵の分布などのレイアウトの概略をブロック単位で取得することができるので、文書画像データの画像特徴量を簡潔に計算することができるという効果を奏する。 Further, according to the second and eleventh aspects of the present invention, it is possible to obtain an outline of the layout of characters, photographs / pictures in general, the layout of characters and photographs / pictures, etc., in units of blocks. There is an effect that the image feature amount of the image data can be simply calculated.

また、請求項3,12にかかる発明によれば、画像の粗い特徴と細かい特徴を表す特徴を効率的に抽出することができるという効果を奏する。 Further, according to the third and twelfth aspects of the present invention, there is an effect that it is possible to efficiently extract a rough feature and a feature representing a fine feature of an image.

また、請求項4,13にかかる発明によれば、画像データにおける黒画素と白画素の局所的配置を表す表現力の高い統計的情報を効率的に計算することができるという効果を奏する。 Further, according to the fourth and thirteenth aspects, there is an effect that it is possible to efficiently calculate statistical information having high expressive power representing the local arrangement of black pixels and white pixels in image data.

また、請求項5,14にかかる発明によれば、画像データにおける黒画素と白画素の局所的配置を表す表現力の高い統計的情報を効率的に計算することができるという効果を奏する。 In addition, according to the fifth and fourteenth aspects, there is an effect that it is possible to efficiently calculate statistical information having high expressive power representing the local arrangement of black pixels and white pixels in image data.

また、請求項6,15にかかる発明によれば、文字や絵(非文字)の分布に応じた文書画像データの分類線形演算により簡単に行うことができるという効果を奏する。 Further, according to the sixth and fifteenth inventions, there is an effect that it can be easily performed by classification linear calculation of document image data in accordance with the distribution of characters and pictures (non-characters).

また、請求項7,16にかかる発明によれば、ドットパターンの持つ周波数特性を持つ印刷物を、光学的にスキャンし、閲覧あるいは紙出力する場合、読み取り装置/閲覧装置/出力装置の持つそれぞれの周波数特性と干渉して生じるモアレ現象を防止することができるという効果を奏する。 According to the inventions according to

また、請求項8,17にかかる発明によれば、文字と地肌のコントラストが貧弱であったりするために、文字の視認性が低下するといった、階調性の問題を防止することができるという効果を奏する。 In addition, according to the inventions according to

また、請求項9,18にかかる発明によれば、ページ枠に平行であるべき文字行が傾いて再現されるために生じる、読み手への不快感や、レイアウト解析処理への弊害を防止することができる。 In addition, according to the inventions according to claims 9 and 18, it is possible to prevent discomfort to the reader and adverse effects on the layout analysis processing, which are caused when the character lines that should be parallel to the page frame are reproduced with an inclination. Can do.

また、請求項10にかかる発明によれば、レイアウトの概略(文字や写真・絵の大体の空間的配置や分布など)に基づいて計算された画像データの画像特徴量を用いて当該画像データの画像タイプが分類識別された後、分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて画像正規化処理方法が選択され、選択された画像正規化処理方法に基づいて画像データに対して正規化処理が施され、正規化処理が施された画像が用紙上に印刷される。これにより、レイアウトの概略(文字や写真・絵の大体の空間的配置や文字と写真・絵の分布など)に従うことで画像のタイプを特徴付ける画像特徴量を高速に計算することができるとともに、画像データの画像タイプに適した正規化処理を適用して、画像の歪みをもたらすことなく、画像データを理想的な表現に変換した形で画像を用紙上に印刷することができるという効果を奏する。 According to the invention of

[第1の実施の形態]

本発明の第1の実施の形態を図1ないし図14に基づいて説明する。[First Embodiment]

A first embodiment of the present invention will be described with reference to FIGS.

図1は、本発明の第1の実施の形態にかかる画像処理装置1の電気的な接続を示すブロック図である。図1に示すように、画像処理装置1は、PC(Personal Computer)などのコンピュータであり、画像処理装置1の各部を集中的に制御するCPU(Central Processing Unit)2、情報を格納するROM(Read Only Memory)3及びRAM(Random Access Memory)4等の一次記憶装置5、データファイル(例えば、カラービットマップ画像データ)を記憶する記憶部であるHDD(Hard Disk Drive)6等の二次記憶装置7、情報を保管したり外部に情報を配布したり外部から情報を入手するためのCD−ROMドライブ等のリムーバブルディスク装置8、ネットワーク9を介して外部の他のコンピュータと通信により情報を伝達するためのネットワークインターフェース10、処理経過や結果等を操作者に表示するCRT(Cathode Ray Tube)やLCD(Liquid Crystal Display)等の表示装置11、並びに操作者がCPU2に命令や情報等を入力するためのキーボード12、マウス等のポインティングデバイス13等から構成されており、これらの各部間で送受信されるデータをバスコントローラ14が調停して動作する。 FIG. 1 is a block diagram showing electrical connections of the

なお、本実施の形態においては、画像処理装置1として一般的なパーソナルコンピュータを適用して説明しているが、これに限るものではなく、PDA(Personal Digital Assistants)と称される携帯用情報端末、palmTopPC、携帯電話、PHS(Personal Handyphone System)等であっても良い。 In the present embodiment, a general personal computer is applied as the

このような画像処理装置1では、ユーザが電源を投入するとCPU2がROM3内のローダーというプログラムを起動させ、HDD6よりオペレーティングシステムというコンピュータのハードウェアとソフトウェアとを管理するプログラムをRAM7に読み込み、このオペレーティングシステムを起動させる。このようなオペレーティングシステムは、ユーザの操作に応じてプログラムを起動したり、情報を読み込んだり、保存を行ったりする。オペレーティングシステムのうち代表的なものとしては、Windows(登録商標)、UNIX(登録商標)等が知られている。これらのオペレーティングシステム上で走る動作プログラムをアプリケーションプログラムと呼んでいる。 In such an

ここで、画像処理装置1は、アプリケーションプログラムとして、画像処理プログラムをHDD6に記憶している。この意味で、HDD6は、画像処理プログラムを記憶する記憶媒体として機能する。 Here, the

また、一般的には、画像処理装置1のHDD6等の二次記憶装置7にインストールされるアプリケーションプログラムは、CD−ROMやDVD−ROM等の光情報記録メディアやFD等の磁気メディア等の記憶媒体8aに記録され、この記憶媒体8aに記録されたアプリケーションプログラムがHDD6等の二次記憶装置7にインストールされる。このため、CD−ROM等の光情報記録メディアやFD等の磁気メディア等の可搬性を有する記憶媒体8aも、画像処理プログラムを記憶する記憶媒体となり得る。さらには、画像処理プログラムを、インターネット等のネットワークに接続されたコンピュータ上に格納し、例えばネットワークインターフェース10を介して外部からダウンロードさせることにより、HDD6等の二次記憶装置7にインストールするように構成しても良い。また、本実施の形態の画像処理装置1で実行される画像処理プログラムをインターネット等のネットワーク経由で提供または配布するように構成しても良い。 In general, the application program installed in the

画像処理装置1は、オペレーティングシステム上で動作する画像処理プログラムが起動すると、この画像処理プログラムに従い、CPU2が各種の演算処理を実行して各部を集中的に制御する。画像処理装置1のCPU2が実行する各種の演算処理のうち、本実施の形態の特長的な処理である画像データの蓄積/送信の際の正規化処理について以下に説明する。ここで、正規化処理とは、画像処理装置1に接続された外部機器(例えば、スキャナやデジタルカメラなど)やネットワーク9を通じて受け付けたデジタル画像データを理想的な形に変換するための処理である。 In the

なお、リアルタイム性が重要視される場合には、処理を高速化する必要がある。そのためには、論理回路(図示せず)を別途設け、論理回路の動作により各種の演算処理を実行するようにするのが望ましい。 In addition, when real-time property is regarded as important, it is necessary to speed up the processing. For this purpose, it is desirable to separately provide a logic circuit (not shown) and execute various arithmetic processes by the operation of the logic circuit.

ここで、画像処理装置1のCPU2が実行する画像データの蓄積/送信の際の正規化処理について説明する。図2は画像処理装置1のCPU2が実行する画像データの蓄積/送信の際の正規化処理にかかる機能を示す機能ブロック図、図3はその流れを概略的に示すフローチャートである。図2に示すように、画像処理装置1は、画像入力処理部21と、画像特徴量計算部22と、画像タイプ識別部23と、画像正規化処理方法の選択部24と、画像正規化処理部25と、記憶部26と、画像蓄積/送信処理部27とを備えている。以下において、各構成部の動作と作用を詳述する。 Here, normalization processing at the time of accumulation / transmission of image data executed by the

画像入力処理部21は、画像処理装置1に接続された外部機器(例えば、スキャナやデジタルカメラなど)やネットワーク9を通じて、デジタル画像データの入力を受け付ける。ここで、デジタル画像データは、例えば印刷物を光学的にスキャンしてデジタル変換したものである。 The image

画像特徴量計算部22は、画像特徴量計算手段として機能するものであって、画像全体の特徴量を出力するものである。図4は、画像特徴量計算部22における画像特徴量計算処理の流れを概略的に示すフローチャートである。図4に示すように、まず、入力した画像を同じ大きさの矩形ブロックに排他的に分割し(ステップS1:ブロック分割手段)、各ブロックを、“絵”“文字”“他”の3種類のいずれかに分類する(ステップS2:ブロック分類手段)。次に、すべてのブロックの分類結果をもとに画像全体の画像特徴量を計算する(ステップS3:計算手段)。最後に、画像全体の画像特徴量を出力する(ステップS4)。以下において、各ステップの動作を説明する。 The image feature quantity calculation unit 22 functions as an image feature quantity calculation unit, and outputs the feature quantity of the entire image. FIG. 4 is a flowchart schematically showing the flow of the image feature quantity calculation processing in the image feature quantity calculator 22. As shown in FIG. 4, first, the input image is exclusively divided into rectangular blocks of the same size (step S1: block dividing means), and each block is divided into three types: “picture”, “character”, and “other”. (Step S2: block classification means). Next, the image feature amount of the entire image is calculated based on the classification result of all the blocks (step S3: calculation means). Finally, the image feature amount of the entire image is output (step S4). Hereinafter, the operation of each step will be described.

(1)ブロック分割(ステップS1)

入力画像を同じサイズのブロック、たとえば、1cm×1cm(解像度が200dpiであれば80画素×80画素、解像度が300dpiであれば120画素×高さ120画素)の矩形に分割する。(1) Block division (step S1)

The input image is divided into blocks of the same size, for example, 1 cm × 1 cm (80 pixels × 80 pixels if the resolution is 200 dpi, 120 pixels × 120 pixels if the resolution is 300 dpi).

(2)ブロックの分類(ステップS2)

各ブロックを、“絵”“文字”“他”の3種類のいずれかに分類する。この処理のフローを図5に示し、以下において詳述する。(2) Block classification (step S2)

Each block is classified into one of three types of “picture”, “character”, and “other”. The flow of this process is shown in FIG. 5 and will be described in detail below.

図5に示すように、まず、処理対象となるブロック画像を100dpi程度の低解像度に縮小した画像Iを生成するとともに(ステップS11:画像生成手段)、解像度のレベル数Lを設定し(ステップS12)、解像度縮小レベルkを初期化(k←0)する(ステップS13)。このようなステップS11〜S13の処理を行うのは、図6に示すように、画像Iとともに、さらに低解像度化した画像からも特徴を抽出するためである。詳細は後述するが、例えば、解像度レベル数Lを2にした場合には、画像Iと、解像度が1/2の画像I1と、解像度が1/4の画像の画像I2との計3つの画像から特徴を抽出する。As shown in FIG. 5, first, an image I obtained by reducing a block image to be processed to a low resolution of about 100 dpi is generated (step S11: image generation means), and a resolution level number L is set (step S12). ), The resolution reduction level k is initialized (k ← 0) (step S13). The reason why the processes in steps S11 to S13 are performed is to extract features from an image with a further reduced resolution as well as an image I as shown in FIG. Although details will be described later, for example, when the resolution

解像度縮小レベルkが解像度レベル数Lに達していない場合には(ステップS14のYes)、ステップS11で生成した画像Iから解像度を1/2kに縮小した画像Ik(k=0,・・・,L)を生成し(ステップS15)、画像Ikを2値化する(ステップS16:2値化手段)。ただし、2値画像において、黒画素は値1、白画素は値0をとるとする。If the resolution reduction level k has not reached the resolution level number L (Yes in step S14), the image Ik (k = 0,...) Obtained by reducing the resolution to 1/2k from the image I generated in step S11. ., L) is generated (step S15), and the image Ik is binarized (step S16: binarization means). However, in a binary image, a black pixel has a

次いで、2値化した解像度が1/2kの画像Ikから、M次元の特徴量ベクトルfkを計算した後(ステップS17)、解像度縮小レベルkを“1”だけインクリメント(k←k+1)する(ステップS18)。Then, from the image Ik of

ここで、画像Ik(k=0,・・・,L)を2値化した画像から特徴を抽出する方法を述べる。自己相関関数を高次(N次)へと拡張した「高次自己相関関数(N次自己相関関数)」は、画面内の対象画像をI(r)とすると、変位方向(S1,S2,…,SN)に対して、

上述したようなステップS15〜S18の処理(特徴量ベクトル計算手段)は、ステップS18でインクリメントされた解像度縮小レベルkが解像度レベル数Lを超える迄(ステップS14のNo)、繰り返される。 The processes in steps S15 to S18 (feature vector calculation means) as described above are repeated until the resolution reduction level k incremented in step S18 exceeds the number L of resolution levels (No in step S14).

ステップS18でインクリメントされた解像度縮小レベルkが解像度レベル数Lを超えた場合には(ステップS14のNo)、特徴量ベクトルf0,・・・,fLをもとにして、ブロックを、“絵”“文字”“他”の3種類のいずれかに分類する(ステップS19:分類手段)。If incremented resolution reduction level k has exceeded the number of resolution levels L in step S18 (No in step S14), and feature vectors f0, · · ·, based on fL, the block, " Classification is made into one of three types of picture, “character” and “other” (step S19: classification means).

ここで、ブロックの分類の方法について詳述する。まず、前述したM=25次元の特徴量ベクトルfk=(g(k,1),・・・,g(k,25))(k=0,・・・,L)から(25×L)次元の特徴量ベクトルx=(g(0,1),・・・,g(0,25),・・・,g(L,1),・・・,g(L,25))を生成する。このようなブロックの特徴量ベクトルxを用いて分類を行うためには、前もって学習を行うことが必要である。そこで、本実施の形態においては、学習用データを文字だけ含むようなものと文字を含まないようなものの2種類に分けて特徴量ベクトルxを計算する。その後、それぞれの平均をとることによって、文字画素の特徴量ベクトルp0と非文字画素の特徴量ベクトルp1を前もって計算しておく。そして、分類しようとしているブロック画像から得られた特徴量ベクトルxを、既知の特徴量ベクトルp0とp1の線形結合に分解すれば、その結合係数a0,a1が文字画素と非文字画素の比率、あるいは、ブロックの「文字らしさ」と「非文字らしさ」を表すことになる。このような分解が可能であるのは、高次局所自己相関に基づく特徴が画面内の対象の位置に不変で、しかも、対象の数に関して加法性を持つことによる。特徴量ベクトルxの分解を、

x=a0・p0+a0・p1=FTa+e

とする。ここで、eは誤差ベクトル、F=[p0,p1]T、a=(a0,a1)Tである。最小二乗法により、最適な結合係数ベクトルaは、

a=(FFT)-1・Fx

で与えられる。各ブロックについて、「非文字らしさ」を表すパラメータa1について閾値処理することにより、そのブロックを「絵」、「絵でない」、「未定」に分類する。各ブロックについて、「未定」または「絵でない」に分類されていて、文字らしさを表すパラメータa0が閾値以上であれば「文字」に、そうでなければ「その他」に分類する。図8にブロック分類の例を示す。図8の例においては、黒部分は「文字」、グレイ部分は「絵」、白部分は「他」を表わしている。Here, the block classification method will be described in detail. First, from the aforementioned M = 25-dimensional feature vector fk = (g (k, 1),..., G (k, 25)) (k = 0,..., L) to (25 × L ) Dimension feature vector x = (g (0,1),..., G (0,25),..., G (L, 1),. Generate. In order to perform classification using such a block feature quantity vector x, it is necessary to perform learning in advance. Therefore, in the present embodiment, the feature amount vector x is calculated by dividing the learning data into two types, one containing only characters and one not containing characters. Thereafter, the feature quantity vector p0 of the character pixel and the feature quantity vector p1 of the non-character pixel are calculated in advance by taking the respective averages. Then, if the feature vector x obtained from the block image to be classified is decomposed into a linear combination of the known feature vectors p0 and p1 , the coupling coefficients a0 and a1 become character pixels and non-characters. It represents the ratio of pixels or the “characteristic” and “non-characteristic” of the block. Such decomposition is possible because the feature based on the higher-order local autocorrelation is invariant to the position of the object in the screen, and is additive with respect to the number of objects. Decompose feature vector x

x = a0 · p0 + a0 · p1 = FT a + e

And Here, e is an error vector, F = [p0 , p1 ]T , and a = (a0 , a1 )T. By the least square method, the optimal coupling coefficient vector a is

a = (FFT )−1 · Fx

Given in. Each block is classified into “picture”, “not a picture”, and “undecided” by performing threshold processing on the parameter a1 representing “non-characteristic”. Each block is classified as “undecided” or “not a picture”, and is classified as “character” if the parameter a0 representing the character character is greater than or equal to a threshold value, and “other” otherwise. FIG. 8 shows an example of block classification. In the example of FIG. 8, the black portion represents “character”, the gray portion represents “picture”, and the white portion represents “other”.

(3)画像特徴量の計算(ステップS3)

ブロックの分類結果をもとにして、画像のタイプ分けのための画像特徴量を計算する。特に、

・文字、絵の割合

・密集率:レイアウトの混み方(狭いところに詰め込まれている度合い)

・文字、絵の散乱度:文字や写真が紙面全体に散らばって分布している度合い

を計算する。具体的には、次の5つの画像特徴量を計算する。

・文字の割合Rt∈[0,1]:全ブロックの中で「文字」に分類されたブロックの割合

・非文字の割合Rp∈[0,1]:全ブロックの中で「絵」に分類されたブロックの割合

・レイアウト密度D∈[0,1]:「文字」と「絵」のブロック数の面積の和を、描画領域の面積で割ったもの

・文字散乱度St(>0):文字ブロックのx,y方向の空間的分布について、分散・共分散行列の行列式を、画像の面積で正規化したもの

・非文字散乱度Sp(>0):絵ブロックのx,y方向の空間的分布について、分散・共分散行列の行列式を、画像の面積で正規化したもの

表1は、図8の例についての画像特徴量の計算結果を示すものである。

Based on the block classification result, an image feature amount for image type classification is calculated. In particular,

・ Percentage of characters and pictures ・ Denseness: how to lay out the layout (how much is packed in a narrow space)

-Scattering degree of characters and pictures: The degree to which characters and pictures are scattered and distributed throughout the paper is calculated. Specifically, the following five image feature amounts are calculated.

-Character ratio Rt ∈ [0, 1]: Ratio of blocks classified as "character" in all blocks-Non-character ratio Rp ∈ [0, 1]: Classification as "pictures" in all blocks Ratio of blocks formed: Layout density Dε [0, 1]: the sum of the area of the number of blocks of “character” and “picture” divided by the area of the drawing area • Character scattering degree St (> 0): For the spatial distribution of character blocks in the x and y directions, the determinant of the variance / covariance matrix normalized by the area of the image. Non-character scattering degree Sp (> 0): in the x and y directions of the picture block Determining the dispersion / covariance matrix with respect to the spatial distribution normalized by the area of the image Table 1 shows the calculation result of the image feature amount for the example of FIG.

次に、画像タイプ識別部23について説明する。画像タイプ識別部23は、画像タイプ識別手段として機能するものであって、画像特徴量計算部22で計算した画像特徴量を用い、画像のタイプを分類識別する。本実施の形態においては、画像特徴量計算部22で計算した特徴量を用いることにより、「スキュー補正、コントラスト強調処理をかけてはいけない」画像のタイプについて、例えば線形判別関数により簡単に表現するものとする。

・絵が主体で、文字が殆どない画像のタイプ:すなわち、Rpについて単調増加し、Rtについて単調減少するような判別関数

Rp−a0・Rt−a1>0 (a0>1)

を満たす画像のタイプである。より具体的には、大きな写真や絵が張り付いているもの、あるいは、小さい写真が多数張り付いているものがこのタイプに分類される。

・文字が少なく、ページ全体に散らばっているような画像のタイプ:Rtについて単調減少し、Stについて単調増加するような判別関数

St−c0・Rt−c1>0 (c0>0)

を満たす画像のタイプである。より具体的には、写真や絵が占める割合がそれほど多くなくても、文字が写真の絵の説明に添えられているようなものがこのタイプに分類される。表2は、図8の例についてのタイプ識別例を示すものである。

Discrimination function Rp-a0 · Rt-a1 > 0 (a0 > 1) which is monotonically increasing with respect to Rp and monotonically decreasing with respect to Rt.

The type of image that satisfies More specifically, a large picture or picture is attached to this type, or a large number of small pictures are attached to this type.

A type of image that has few characters and is scattered throughout the page: a discriminant function that monotonously decreases with respect to Rt and monotonously increases with respect to St. St-c0 .Rt-c1 > 0 (c0 > 0)

The type of image that satisfies More specifically, even if the proportion of photographs and pictures is not so large, those in which characters are attached to the picture description of the photograph are classified into this type. Table 2 shows an example of type identification for the example of FIG.

次に、画像正規化処理方法の選択部24について説明する。画像正規化処理方法の選択部24は、選択手段として機能するものであって、画像タイプ識別部23における画像のタイプ分類の結果に基づいて、画像データの蓄積/送信の際における画像正規化の方法を選択する。例えば、図9に示すような画像タイプと画像正規化処理の対応規則を記憶手段である記憶部26に保持しておき、この画像タイプと画像正規化処理の対応規則に従って画像正規化の方法を選択するようにすれば良い。 Next, the

具体的には、図9に示すような対応規則においては、「絵が主体で、文字が殆どない」デジタル画像データ(図8の(d)が該当)では、文字と地肌間のコントラスト強調のための階調変換は意味を持たず、また、前述したようにスキュー補正も十分な数の文字がないためにうまく働かないことが多い。したがって、中間調ドットパターンを連続階調に変換する処理だけを施す。 Specifically, in the correspondence rule as shown in FIG. 9, in the case of digital image data (corresponding to (d) in FIG. 8) of “the picture is mainly and there are almost no characters”, the contrast enhancement between the characters and the background is enhanced. For this reason, the tone conversion has no meaning, and as described above, the skew correction often does not work well because there is not a sufficient number of characters. Therefore, only the process of converting the halftone dot pattern into a continuous tone is performed.

「文字が少なく、ページ全体に散らばっている」デジタル画像データ(図8の(a)(c)(d)が該当)では、統計的に十分な数の文字がないためにスキュー補正がうまく働く保障がない。そこで、中間調ドットパターンを連続階調に変換する処理と、文字と地肌間のコントラスト強調のための階調変換だけを施す。 In digital image data (applicable to (a), (c), and (d) in FIG. 8), “skew correction works well because there is not a statistically sufficient number of characters”. There is no guarantee. Therefore, only the process of converting the halftone dot pattern into a continuous tone and the tone conversion for enhancing the contrast between the character and the background are performed.

それ以外の場合(図8の(b)(e)(f)が該当)には、十分な数の文字が画像に存在するので、中間調ドットパターンを連続階調に変換する処理と、文字と地肌間のコントラスト強調のための階調変換処理とに加えて、スキュー補正も施す。 In other cases (corresponding to (b), (e), and (f) in FIG. 8), a sufficient number of characters are present in the image. In addition to the tone conversion processing for enhancing contrast between the background and the background, skew correction is also performed.

このようにして選択された画像正規化処理方法にしたがってパラメータが変更される。なお、複数の画像正規化処理方法が選択されるような場合には、例えば画像タイプに優先順位を付しておき、優先順位が高い画像タイプについての画像正規化処理方法を優先する。 The parameters are changed according to the image normalization processing method selected in this way. When a plurality of image normalization processing methods are selected, for example, priorities are assigned to image types, and image normalization processing methods for image types with higher priorities are prioritized.

画像正規化処理部25は、正規化手段として機能するものであって、画像正規化処理方法の選択部24で選択された画像正規化処理方法に基づいて、デジタル画像データに対して画像正規化処理を施す。 The image

ここで、画像処理装置1のCPU2が実行する各種の画像正規化処理について簡単に説明する。 Here, various image normalization processes executed by the

(1)中間調変換処理

まず、中間調ドットパターンを連続階調に変換する中間調変換処理について説明する。図10は、中間調変換処理の流れを示すフローチャートである。図10に示すように、デジタル画像データである原画像I0を入力あるいは受信していることが前提となっている(ステップS501)。このような前提の下、まず、原画像I0から低解像度の縮小画像Iを生成する(ステップS502)。次いで、低解像度画像Iへの処理として、生成した低解像度の縮小画像I上で、局所的特徴(エッジ、色信号の局所的統計量など)に基づいて前景画像Fを抽出する(ステップS503)。前景画像F以外の画素が背景画像Bとなる。そして、背景画像Bを連続階調表現に変換し、連続階調変換された背景画像Jとする(ステップS504)。連続階調とは、ディザ等の擬似階調とは異なり、個々の画素に画素値(カラーの場合はR、G、Bそれぞれの輝度)を付与して階調を表現したものである。(1) Halftone Conversion Processing First, halftone conversion processing for converting a halftone dot pattern to continuous tone will be described. FIG. 10 is a flowchart showing the flow of halftone conversion processing. As shown in FIG. 10, it is assumed that input or receives an original image I0 is a digital image data (step S501). Under such a premise, first, a low-resolution reduced image I is generated from the original image I0 (step S502). Next, as processing for the low-resolution image I, the foreground image F is extracted on the generated low-resolution reduced image I based on local features (edges, local statistics of color signals, etc.) (step S503). . Pixels other than the foreground image F become the background image B. Then, the background image B is converted into a continuous tone expression to obtain a background image J subjected to continuous tone conversion (step S504). A continuous tone is different from a pseudo tone such as dither, and expresses a tone by assigning pixel values to individual pixels (in the case of color, the respective luminances of R, G, and B).

次に、原解像度画像I0への処理として、低解像度の縮小画像I中から前景として抽出された前景画像Fについて、受信したままの原画像I0での処理を行う。縮小画像I中から前景として抽出された前景画像F内で、局所的特徴(エッジ、色信号の局所的統計量など)をもとに前景画像FFを抽出し、それ以外の画素を背景画像BFとする(ステップS505)。そして、その背景画像BFを連続階調表現に変換し、連続階調変換された背景画像J0とする(ステップS506)。Next, as the processing for the original resolution image I0 , the foreground image F extracted as the foreground from the low-resolution reduced image I is processed with the original image I0 as received. In the foreground image F extracted as the foreground from the reduced image I, the foreground image FF is extracted based on local features (edges, local statistics of color signals, etc.), and other pixels are extracted from the background image BF. (Step S505). Then, the background image BF is converted into a continuous tone expression to obtain a background image J0 subjected to continuous tone conversion (step S506).

最後に、縮小画像Iから連続階調表現された背景画像J、前景画像FF、原画像I0から連続階調表現された背景画像J0を合成して、補正画像Qを得る(ステップS507)。Finally, the corrected image Q is obtained by synthesizing the background image J expressed in continuous tone from the reduced image I, the foreground image FF, and the background image J0 expressed in continuous tone from the original image I0 (step S507). .

背景画像B、BFを連続階調表現に変換する処理については、まず、前景画像Fを抽出した後に残る領域の画像、すなわち背景画像B内に、W×Wの大きさ(ウィンドウサイズs)の局所的領域Rを設定する。ここでは、ウィンドウサイズsがW×Wの大きさであることから、局所的領域Rは正方形であることになるが、局所的領域Rは、矩形であれば必ずしも正方形に限定されない。また、この局所的領域Rは、それが適切なサイズであれば、鋭いエッジ、文字、グラフィックスなどを持たない。したがって、ウィンドウサイズsの大きさと局所的領域Rの位置とが適切であれば、局所的領域R内の画素をR内の平均色で置き換えればよい。背景画像BFについても同様である。 Regarding the process of converting the background images B and BF into the continuous tone representation, first, in the image of the region remaining after the foreground image F is extracted, that is, in the background image B, the size of W × W (window size s). A local region R is set. Here, since the window size s is W × W, the local region R is a square, but the local region R is not necessarily limited to a square as long as it is a rectangle. Also, this local region R does not have sharp edges, characters, graphics, etc. if it is of an appropriate size. Therefore, if the size of the window size s and the position of the local region R are appropriate, the pixels in the local region R may be replaced with the average color in R. The same applies to the background image BF.

また、ステップS507のFF、J、J0の合成を行い補正画像Qを得るには、R、G、B各色について次の処理を行えば良い。即ち、Q[i,j]には、対応する低解像度画像での画素がB(背景)なら、低解像度連続階調画像Jの画素値を代入する。背景でない場合(F:前景)は、Q[i,j]に対応する原解像度画像の画素がFF(前景)なら、I0[i,j]を、BFならJ0[i,j]を代入すれば良い。 Further, in order to obtain the corrected image Q by combining FF, J, and J0 in step S507, the following processing may be performed for each of the R, G, and B colors. That is, Q [i, j] is substituted with the pixel value of the low resolution continuous tone image J if the corresponding pixel in the low resolution image is B (background). If it is not the background (F: foreground), if the pixel of the original resolution image corresponding to Q [i, j] is FF (foreground), I0 [i, j] is substituted, and if it is BF, J0 [i, j] is substituted. It ’s fine.

なお、この中間調変換処理の詳細については、本出願人が出願した特開2003−28

1526号公報(特許文献1)などに詳述されている。The details of the halftone conversion process are described in Japanese Patent Application Laid-Open No. 2003-28 filed by the present applicant.

No. 1526 (Patent Document 1) and the like.

(2)階調補正処理

次に、文字と地肌間のコントラスト強調のための階調変換処理について説明する。図11は、階調補正処理の流れを示すフローチャートである。まず、処理の概要について説明する。文書画像には多くの文字が印刷されているが、一般的に通常の文書には、紙面の何も印刷されていない部分に黒い文字が直接印刷されている部分がある。このため、入力画像から黒文字がありそうな領域を抽出する。入力画像を十分に小さいブロックに分割することで、内部に黒い文字が紙面に直接印刷されているようなあるブロックが存在すると仮定できる。このことから、下地色となる紙面色が白であるとすると、次のような画像処理を行えば良い。以下、図11を参照して処理の流れを説明する。(2) Tone Correction Processing Next, tone conversion processing for enhancing contrast between characters and the background will be described. FIG. 11 is a flowchart showing the flow of gradation correction processing. First, an overview of the process will be described. Many characters are printed on a document image. Generally, a normal document has a portion in which black characters are directly printed on an unprinted portion of paper. Therefore, an area where black characters are likely to be extracted is extracted from the input image. By dividing the input image into sufficiently small blocks, it can be assumed that there is a block in which black characters are directly printed on the paper. For this reason, if the paper color as the base color is white, the following image processing may be performed. Hereinafter, the flow of processing will be described with reference to FIG.

図11に示すように、デジタル画像データである原画像I0を受信していることが前提となっている(ステップS601)。このような前提の下、まず、原画像I0から低解像度の縮小画像Iを生成する(ステップS602)。As shown in FIG. 11, it is assumed that an original image I0 that is digital image data is received (step S601). Under such a premise, first, a low-resolution reduced image I is generated from the original image I0 (step S602).

次に、ステップS602で生成した低解像度画像Iを平滑化する(ステップS603)。そして、低解像度画像Iの各画素の周りに固定サイズのウィンドウを設定して、R、G、Bの各チャンネル(色)で信号(画素値)の平均値μと標準偏差σとを計算することで低解像度画像Iの特徴量を計算する(ステップS604)。画像データの平滑化は公知の技術であり、ノイズの除去を目的とする。また、ステップS604で求めた統計量は、次のステップでの文字領域の判定に用いる。 Next, the low resolution image I generated in step S602 is smoothed (step S603). Then, a fixed-size window is set around each pixel of the low-resolution image I, and an average value μ and a standard deviation σ of signals (pixel values) are calculated for each channel (color) of R, G, and B. Thus, the feature amount of the low resolution image I is calculated (step S604). The smoothing of the image data is a known technique and aims at removing noise. Further, the statistic obtained in step S604 is used for determination of the character area in the next step.

次いで、低解像度画像Iに対して局所適応的閾値処理と膨張処理とを行ってカラー成分の局所適応的二値化を行うことにより、文字領域Cの抽出検出を行う(ステップS605)。例えば、下地に黒文字が直接印刷された画像である場合、R、G、Bのすべてのチャンネル(色)においてコントラストが強くなる傾向がある。このため、信号値(画素値)が、すべてのチャンネル(色)において、閾値μ(a+bσ)よりも低い画素[i,j]を文字領域Cの要素として設定する。a、bはパラメータであり、文書原稿に含まれるイメージ成分によって調整する。なお、文字領域Cの抽出検出の方法は、文字認識等で行われている既存の方法を用いても良い。 Next, the character region C is extracted and detected by performing local adaptive threshold processing and expansion processing on the low-resolution image I to perform local adaptive binarization of the color components (step S605). For example, in the case of an image in which black characters are directly printed on the background, the contrast tends to be strong in all channels (colors) of R, G, and B. Therefore, a pixel [i, j] whose signal value (pixel value) is lower than the threshold value μ (a + bσ) is set as an element of the character region C in all channels (colors). a and b are parameters which are adjusted according to the image components included in the document original. In addition, as a method for detecting detection of the character region C, an existing method used in character recognition or the like may be used.

次に、入力された原画像I0を固定サイズの互いに重なりのないブロックに分割し(ステップS606)、分割した各ブロックにおいて、文字領域Cに属する画素を2つの代表色に応じて第1のクラスと第2のクラスとの2クラスに分類する(ステップS607)。そして、文字領域Cに属する画素の輝度に基づいて、通常は、明るい色の方を文字領域の背景色に、暗い色の方を文字色に対応させる。なお、ブロックの大きさは辺の長さが20mm程度の正方形で良い(200dpiでは160画素×160画素)。Next, the input original image I0 is divided into fixed-size non-overlapping blocks (step S606), and in each divided block, the pixels belonging to the character area C are set to the first according to the two representative colors. Classification into two classes, a class and a second class (step S607). Then, based on the luminance of the pixels belonging to the character area C, normally, the lighter color corresponds to the background color of the character area and the darker color corresponds to the character color. The size of the block may be a square with a side length of about 20 mm (160 pixels × 160 pixels at 200 dpi).

さらに、文字領域Cに属する画素が2つの代表色に分類された各ブロックから、一方のクラスに分類された画素数が最大になるブロックBをウィンドウWとして選択し、このウィンドウWにおける2つの代表色を入力画像における下地の平均色および黒文字の平均色としてそれぞれ設定し、さらに、輝度の統計量に基づいて、黒文字色と下地色とを推定する(ステップS608)。ここで、輝度は、例えば、

輝度=(R+G+B)/3

に示す式の演算により取得されるR、G、B信号の平均値であり、この輝度から取得される輝度の平均値および標準偏差を輝度の統計量とする。Further, a block B in which the number of pixels classified into one class is maximized is selected as a window W from each block in which pixels belonging to the character region C are classified into two representative colors. The colors are respectively set as the average color of the background and the average color of black characters in the input image, and the black character color and the background color are estimated based on the statistics of luminance (step S608). Here, the luminance is, for example,

Luminance = (R + G + B) / 3

The average value of the R, G, and B signals acquired by the calculation of the equation shown in FIG.

このようにして求めた輝度の統計量に基づいて、各ブロック内における各画素の階調補正を行う(ステップS609)。ここでは、下地色を白(輝度最大)とし、黒文字色を黒(輝度最小)とする。具体的には、クラス1を文字色の代表色とし、クラス2を下地色の代表色とすれば、文字色の代表色より暗い画素を黒、下地色の代表色より明るい画素を白として、二つの色の中間の画素に対しては、黒と白の中間調に線形マップする。つまり、

最大画素値を255とすると、

画素値=255*(x−B)/(W−B)

ここで、xは注目している画素の画素値、Bは文字色の代表色の画素値、Wは文字色の

代表色の画素値である。Based on the luminance statistics thus obtained, gradation correction of each pixel in each block is performed (step S609). Here, the background color is white (luminance maximum), and the black character color is black (luminance minimum). Specifically, if

If the maximum pixel value is 255,

Pixel value = 255 * (x−B) / (W−B)

Here, x is the pixel value of the pixel of interest, B is the pixel value of the representative color of the character color, and W is the pixel value of the representative color of the character color.

このようにして求めた画素値をR、G、B各色の画素値に設定する。なお、ここでは画素値という表現を用いたが、輝度と同じ意味である。 The pixel values obtained in this way are set to the pixel values of R, G, and B colors. Although the expression pixel value is used here, it has the same meaning as luminance.

なお、この階調補正処理の詳細については、本出願人が出願した特開2005−110184号公報(特許文献2)などに詳述されている。 Details of the gradation correction processing are described in detail in Japanese Patent Application Laid-Open No. 2005-110184 (Patent Document 2) filed by the present applicant.

(3)スキュー補正処理

次に、スキュー補正処理について説明する。スキューは当該分野において良く知られた問題であり、文書のラインが水平線上にないドキュメントイメージを指す。スキュー検出方法には、スキュー角の決定処理が設けられている。イメージを表現している抽出された矩形領域のリストからドキュメントのスキュー角を決定することができる。スキューを決定する方法は、抽出された矩形領域がどのようにして導き出されたかに依らない。従って、矩形領域に関してドキュメント表現を正確に行なうことができる方法であれば、これをスキューの検出および補正方法に用いることができる。(3) Skew Correction Processing Next, the skew correction processing will be described. Skew is a well-known problem in the art and refers to a document image in which the lines of the document are not on a horizontal line. The skew detection method includes a skew angle determination process. A document skew angle can be determined from a list of extracted rectangular regions representing the image. The method for determining the skew does not depend on how the extracted rectangular region was derived. Therefore, any method that can accurately express a document with respect to a rectangular region can be used as a skew detection and correction method.

図12は、スキュー角の決定処理の流れを示すフローチャートである。前提条件として、X−Y平面上での座標点として矩形領域をアドレスすることができることが先ず理解されるべきである。 FIG. 12 is a flowchart showing the flow of the skew angle determination process. As a prerequisite, it should first be understood that a rectangular region can be addressed as a coordinate point on the XY plane.

最初、所定数の関連した矩形領域のアドレス情報を矩形領域バッファに格納する(ステップS701)。スキュー角を検出するために、正確には80個の矩形領域を用いることとする。さらに、格納されるアドレス情報は、矩形領域の左上隅の座標である。全ての矩形領域アドレスについて一貫性をもたせれば、これのかわりに、矩形領域の右下隅の座標をアドレス情報として用いることもできる。 First, address information of a predetermined number of related rectangular areas is stored in the rectangular area buffer (step S701). To detect the skew angle, 80 rectangular regions are used accurately. Further, the stored address information is the coordinates of the upper left corner of the rectangular area. If all the rectangular area addresses are consistent, the coordinates of the lower right corner of the rectangular area can be used as address information instead.

次いで、各々のアドレスのX座標をX座標アドレスのヒストグラム上に投射し、コラムエッジを検出する(ステップS702)。図13には、このようなヒストグラムが示されている。このヒストグラムは、最も頻度が高いX座標値を示している。この最も頻度が高いX座標値により、文書のコラムのエッジを検出することができる。すなわち、矩形領域をこれらの左上隅点により検出する場合には、左側のコラムエッジが検出される。これとは逆に、右下隅点が用いられる場合には、右側のコラムエッジが検出される。図13を参照すると、符号701の部分は、X座標を示しており、符号702の部分は頻度を示しており、符号703の部分は、各X座標のカウント値の関係をグラフィックに示したものである。符号704で示すX座標値は、最も頻度が高く、このX座標値がコラムエッジとして定められる。コラムの検出は、スキュー角を決定するときに比較対象となる矩形領域をコラム検出結果を用いて制限することができる点で重要である。なお、この制限とは、同じコラム内の矩形領域のみを比較することである。 Next, the X coordinate of each address is projected on the histogram of the X coordinate address, and a column edge is detected (step S702). FIG. 13 shows such a histogram. This histogram shows the X coordinate value with the highest frequency. The edge of the column of the document can be detected by the most frequently used X coordinate value. That is, when the rectangular area is detected by these upper left corner points, the left column edge is detected. In contrast, when the lower right corner point is used, the right column edge is detected. Referring to FIG. 13, the

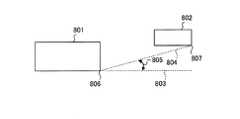

図12を再び参照すると、矩形領域バッファに格納されている全てのあるいは限られた一部の関連した矩形領域間の正接角(タンジェント角)を決定し、ヒストグラム上に投射してスキュー角を検出する(ステップS703)。図14には、2つの矩形領域間の正接角が示されている。第1の矩形領域801と第2の矩形領域802とは、対角線804と水平線803とによって定まるスキュー角をもつ。対角線804は、矩形領域801の右下隅806から矩形領域802の右下隅807まで延びている。水平線803は、矩形領域801の隅806から延びている。スキュー角805は、良く知られた三角法の計算により、次のようにして計算される。

ΔX=|(点806のX座標)−(点807のX座標)|

ΔY=|(点806のY座標)−(点807のY座標)|

スキュー角=(180×ΔY)/(π×ΔX)Referring again to FIG. 12, tangent angles (tangent angles) between all or a limited part of the associated rectangular areas stored in the rectangular area buffer are determined and projected onto the histogram to detect the skew angle. (Step S703). FIG. 14 shows a tangent angle between two rectangular regions. The first

ΔX = | (X coordinate of point 806) − (X coordinate of point 807) |

ΔY = | (Y coordinate of point 806) − (Y coordinate of point 807) |

Skew angle = (180 × ΔY) / (π × ΔX)

すなわち、対角線804を形成する座標点間の絶対値を計算し、スキュー角の式に挿入することで、スキュー角を計算できる。 That is, the skew angle can be calculated by calculating the absolute value between the coordinate points forming the

なお、このスキュー補正処理の詳細については、本出願人が出願した特許第3308032号公報(特許文献3)などに詳述されている。 The details of the skew correction processing are described in detail in Japanese Patent No. 33008032 (Patent Document 3) filed by the present applicant.

最後に、画像蓄積/送信処理部27は、画像正規化処理方法の選択部24で選択された画像正規化処理方法に基づいて画像正規化処理部25で正規化された画像をHDD6などの記憶媒体に蓄積したり、あるいは、他の機能が動作する外部機器にネットワーク9を介して送信したりする。 Finally, the image accumulation /

このように本実施の形態によれば、レイアウトの概略(文字や写真・絵の大体の空間的配置や分布など)に基づいて計算された画像データの画像特徴量を用いて当該画像データの画像タイプが分類識別された後、分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて画像正規化処理方法が選択され、選択された画像正規化処理方法に基づいて画像データに対して正規化処理が施され、送信または蓄積される。これにより、レイアウトの概略(文字や写真・絵の大体の空間的配置や文字と写真・絵の分布など)に従うことで画像のタイプを特徴付ける画像特徴量を高速に計算することができるとともに、画像データの画像タイプに適した正規化処理を適用して、画像の歪みをもたらすことなく、画像データを理想的な表現に変換した形で送信または蓄積することができる。 As described above, according to the present embodiment, an image of the image data is calculated using the image feature amount of the image data calculated based on the outline of the layout (such as the general spatial arrangement and distribution of characters, photographs, and pictures). After the type is classified and identified, the image normalization processing method is selected based on the classification result and the information that associates the correspondence type of the image type with the image normalization processing, and the image based on the selected image normalization processing method Data is normalized and transmitted or stored. As a result, image features that characterize the type of image can be calculated at high speed by following the outline of the layout (such as the spatial arrangement of characters, photos, and pictures, and the distribution of characters, photos, and pictures). By applying a normalization process suitable for the image type of the data, the image data can be transmitted or stored in a form converted into an ideal representation without causing image distortion.

なお、本実施の形態の「(2)ブロックの分類(ステップS2)」においては、ブロックから計算された(25×L)次元の特徴量ベクトルxについて、行列Fを用いて、ブロックの文字らしさと非文字らしさを表す係数成分から成る係数ベクトルaを計算したが、これに限るものではない。例えば、学習データから計算された特徴量ベクトルxと、学習データに付属した教師信号(文字か、文字でないか)を用いた教師つき学習を前もって行い、識別関数を構築しておくようにしても良い。例えば、学習や識別関数は、線形判別分析と線形判別関数、ニューラルネットワークの誤差逆伝播とネットワークの重み係数などの既知のものを用いればよい。分類すべきブロックで計算された特徴量ベクトルxについて、予め計算されておいた識別関数を用いて、ブロックを“絵”“文字”“他”のいずれかに分類する。 Note that in “(2) Block classification (step S2)” in the present embodiment, the character value of the block is calculated using the matrix F for the (25 × L) -dimensional feature vector x calculated from the block. However, the present invention is not limited to this. For example, supervised learning using a feature vector x calculated from learning data and a teacher signal (character or not) attached to the learning data may be performed in advance to construct an identification function. good. For example, the learning and discriminant functions may be known ones such as linear discriminant analysis and linear discriminant function, neural network back propagation error and network weight coefficient. With respect to the feature quantity vector x calculated for the block to be classified, the block is classified into one of “picture”, “character”, and “other” by using a discrimination function calculated in advance.

また、本実施の形態の「(2)ブロックの分類(ステップS2)」においては、2値画像から特徴を抽出するようにしたが、2値画像ではなく、多値画像から特徴を抽出するようにしても良い。この場合、3×3近傍の局所パターンの数は35になる。これは、図7に示した局所パターンに加えて、1次自己相関において注目画素自身の濃淡値の2乗、2次自己相関において注目画素自身の濃淡値の3乗、8近傍の画素のそれぞれについて近傍画素の濃淡値の2乗と注目画素の濃淡値の積、合計10個の相関値を計算しなければならないからである。2値画像では、濃淡値が1または0だけなので、濃淡値を2乗、3乗しても、もとの値と変わらないが、多値画像ではこれらのケースを考慮しなければならない。 Further, in “(2) Block classification (step S2)” of the present embodiment, features are extracted from a binary image, but features are extracted from a multi-valued image instead of a binary image. Anyway. In this case, the number of local patterns in the vicinity of 3 × 3 is 35. This is because, in addition to the local pattern shown in FIG. 7, the square of the gray value of the target pixel itself in the first-order autocorrelation, the third power of the gray value of the target pixel itself in the second-order autocorrelation, and the pixels near eight This is because a total of ten correlation values, the product of the square of the gray value of the neighboring pixels and the gray value of the target pixel, must be calculated. In a binary image, since the gray value is only 1 or 0, even if the gray value is squared or raised to the third power, it does not change from the original value, but in a multi-value image, these cases must be considered.

そして、これに応じて,特徴量fkの次元もM=35になり、特徴量ベクトルfk=(g(k,1),g(k,1),・・・,g(k,35))が計算される。また、ブロックの分類においても、(35×L)次元の特徴量ベクトルx=(g(0,1),・・・,g(0,25),・・・,g(L,1),・・・,g(L,25))を用いる。Accordingly, the dimension of the feature quantity fk is also M = 35, and the feature quantity vector fk = (g (k, 1), g (k, 1),..., G (k, 35). ) Is calculated. Also in the block classification, (35 × L) -dimensional feature vector x = (g (0,1),..., G (0,25),..., G (L, 1), ..., G (L, 25)) are used.

[第2の実施の形態]

次に、本発明の第2の実施の形態を図15に基づいて説明する。なお、前述した第1の実施の形態と同じ部分は同じ符号で示し説明も省略する。[Second Embodiment]

Next, a second embodiment of the present invention will be described with reference to FIG. The same parts as those in the first embodiment described above are denoted by the same reference numerals, and description thereof is also omitted.

第1の実施の形態においては、画像処理装置1としてPCなどのコンピュータを適用したが、本実施の形態は、画像処理装置1としてデジタル複合機などに備えられる情報処理装置を適用したものである。 In the first embodiment, a computer such as a PC is applied as the

図15は、本発明の第2の実施の形態にかかるデジタル複合機50を示す外観斜視図である。図15に示すように、画像読取手段であるスキャナ部51及び画像印刷装置であるプリンタ部52を備えた画像形成装置であるデジタル複合機50に備えられる情報処理装置に画像処理装置1を適用し、デジタル複合機50のスキャナ部51で読み取ったスキャン画像に対して画像データの蓄積/送信の際の正規化処理を施すようにしたものである。 FIG. 15 is an external perspective view showing a digital

この場合、以下に示す3つの態様が考えられる。

1.スキャナ部51におけるスキャン時に、画像タイプ識別部23における画像タイプ識別処理まで実行し、画像データのヘッダに画像タイプ情報として記録する。

2.スキャナ部51におけるスキャン時には特に何もせず、データ配信時またはデータ蓄積時に、画像正規化処理部25による正規化処理まで行う。

3.スキャナ部51におけるスキャン時に、画像正規化処理部25による正規化処理まで行う。In this case, the following three modes are conceivable.

1. At the time of scanning in the

2. No particular processing is performed at the time of scanning by the

3. When scanning by the

[第3の実施の形態]

次に、本発明の第3の実施の形態を図16に基づいて説明する。なお、前述した第1の実施の形態と同じ部分は同じ符号で示し説明も省略する。[Third Embodiment]

Next, a third embodiment of the present invention will be described with reference to FIG. The same parts as those in the first embodiment described above are denoted by the same reference numerals, and description thereof is also omitted.

第1の実施の形態においては、画像処理装置1としてローカルなシステム(例えば、パーソナルコンピュータ単体)を適用したが、本実施の形態は、画像処理装置1としてサーバクライアントシステムを構成するサーバコンピュータを適用したものである。 In the first embodiment, a local system (for example, a personal computer alone) is applied as the

図16は、本発明の第3の実施の形態にかかるサーバクライアントシステムを示す模式図である。図16に示すように、サーバコンピュータSにネットワークNを介してクライアントコンピュータCが複数台接続されたサーバクライアントシステムを適用しており、各クライアントコンピュータCからサーバコンピュータSに対して画像を送信し、サーバコンピュータS(画像処理装置1)において画像に対して画像データの蓄積/送信の際の正規化処理を施すようにしたものである。また、ネットワークN上には、ネットワークスキャナNSが設けられている。 FIG. 16 is a schematic diagram showing a server client system according to the third embodiment of the present invention. As shown in FIG. 16, a server client system in which a plurality of client computers C are connected to a server computer S via a network N is applied, and an image is transmitted from each client computer C to the server computer S. In the server computer S (image processing apparatus 1), the image is subjected to normalization processing when storing / transmitting image data. A network scanner NS is provided on the network N.

この場合、以下に示す3つの態様が考えられる。

1.ネットワークスキャナNSを用いたサーバコンピュータS(画像処理装置1)によるスキャン時に、画像タイプ識別部23における画像タイプ識別処理まで実行し、画像データのヘッダに画像タイプ情報として記録する。

2.ネットワークスキャナNSを用いたサーバコンピュータS(画像処理装置1)によるスキャン時には特に何もせず、データ配信時またはデータ蓄積時に、画像正規化処理部25による正規化処理まで行う。

3.ネットワークスキャナNSを用いたサーバコンピュータS(画像処理装置1)によるスキャン時に、画像正規化処理部25による正規化処理まで行う。In this case, the following three modes are conceivable.

1. At the time of scanning by the server computer S (image processing apparatus 1) using the network scanner NS, the processing up to the image type identification process in the image

2. No particular processing is performed at the time of scanning by the server computer S (image processing apparatus 1) using the network scanner NS, and normalization processing by the image

3. At the time of scanning by the server computer S (image processing apparatus 1) using the network scanner NS, normalization processing by the image

1 画像処理装置

22 画像特徴量計算手段

23 画像タイプ識別手段

24 選択手段

25 正規化手段

26 記憶手段

50 画像形成装置

51 画像読取手段DESCRIPTION OF

Claims (20)

Translated fromJapanese前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算手段と、

この画像特徴量計算手段により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別手段と、

画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶手段と、

前記画像タイプ識別手段による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択手段と、

この選択手段で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化手段と、

を備えることを特徴とする画像処理装置。In an image processing apparatus that performs normalization processing for converting the image data into an ideal form when storing or transmitting the received image data,

Image feature amount calculating means for calculating an image feature amount of the image data based on an outline of a layout;

Image type identification means for identifying and classifying the image type of the image data using the image feature quantity calculated by the image feature quantity calculation means;

Storage means for storing information in which the correspondence type of the image type and the image normalization process is associated;

A selection unit that selects an image normalization processing method based on information obtained by associating a classification result by the image type identification unit and a correspondence rule of an image type and an image normalization process;

Normalization means for performing normalization processing on the image data based on the image normalization processing method selected by the selection means;

An image processing apparatus comprising:

前記画像データを矩形ブロックに排他的に分割するブロック分割手段と、

分割された前記各ブロックを、当該画像データを構成する所定の構成要素に分類するブロック分類手段と、

前記ブロックの分類結果に基づいて前記画像データの画像特徴量を計算する計算手段と、

を備えることを特徴とする請求項1記載の画像処理装置。The image feature amount calculating means includes:

Block dividing means for exclusively dividing the image data into rectangular blocks;

Block classification means for classifying the divided blocks into predetermined components constituting the image data;

Calculation means for calculating an image feature amount of the image data based on the classification result of the block;

The image processing apparatus according to claim 1, further comprising:

前記ブロックから複数の異なる解像度の画像を生成する画像生成手段と、

前記各解像度の画像から特徴量ベクトルを計算する特徴量ベクトル計算手段と、

前記特徴量ベクトルに基づいて前記各ブロックを所定の構成要素に分類する分類手段と、

を備えることを特徴とする請求項2記載の画像処理装置。The block classification means includes

Image generating means for generating images of a plurality of different resolutions from the block;

Feature quantity vector calculation means for calculating a feature quantity vector from the image of each resolution;

Classification means for classifying each block into predetermined components based on the feature vector;

The image processing apparatus according to claim 2, further comprising:

前記各解像度の画像を2値化する2値化手段と、

2値画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、

前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、

を備えることを特徴とする請求項3記載の画像処理装置。The feature vector calculation means includes:

Binarization means for binarizing the image of each resolution;

Pixel feature calculation means for calculating a feature for each pixel of the binary image using the value of the corresponding pixel of the local pattern composed of the pixel and its neighboring pixels;

Adding means for adding the features calculated for each pixel over the entire image;

The image processing apparatus according to claim 3, further comprising:

前記各解像度の画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、

前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、

を備えることを特徴とする請求項3記載の画像処理装置。The feature vector calculation means includes:

Pixel feature calculation means for calculating a feature for each pixel of the image of each resolution by using the value of the corresponding pixel of the local pattern formed by the pixel and its neighboring pixels;

Adding means for adding the features calculated for each pixel over the entire image;

The image processing apparatus according to claim 3, further comprising:

ことを特徴とする請求項3記載の画像処理装置。The classifying means decomposes the feature quantity vector calculated by the feature quantity vector calculation means into a linear combination of a feature quantity vector of a character pixel and a feature quantity vector of a non-character pixel that have been calculated in advance. Classify blocks into predetermined components,

The image processing apparatus according to claim 3.

ことを特徴とする請求項1ないし6のいずれか一記載の画像処理装置。One of the normalization processing methods is halftone conversion processing that converts a halftone dot pattern in the image data into a continuous tone based on a statistic of the halftone dot pattern.

The image processing apparatus according to claim 1, wherein the image processing apparatus is an image processing apparatus.

ことを特徴とする請求項1ないし6のいずれか一記載の画像処理装置。One of the normalization processing methods estimates the black character color and paper color in the image data based on the statistics of the image data, and performs gradation correction based on the estimated black character color and paper color. It is gradation correction processing.

The image processing apparatus according to claim 1, wherein the image processing apparatus is an image processing apparatus.

ことを特徴とする請求項1ないし6のいずれか一記載の画像処理装置。One of the normalization processing methods is a skew correction process for estimating the inclination of the image data based on a statistic of the image data and correcting the estimated inclination.

The image processing apparatus according to claim 1, wherein the image processing apparatus is an image processing apparatus.

前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算手段と、

この画像特徴量計算手段により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別手段と、

画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶手段と、

前記画像タイプ識別手段による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択手段と、

この選択手段で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化手段と、

を備えることを特徴とする画像形成装置。In an image forming apparatus that performs normalization processing for converting image data read by an image reading unit into an ideal form, and prints an image on paper,

Image feature amount calculating means for calculating an image feature amount of the image data based on an outline of a layout;

Image type identification means for identifying and classifying the image type of the image data using the image feature quantity calculated by the image feature quantity calculation means;

Storage means for storing information in which the correspondence type of the image type and the image normalization process is associated;

A selection unit that selects an image normalization processing method based on information obtained by associating a classification result by the image type identification unit and a correspondence rule of an image type and an image normalization process;

Normalization means for performing normalization processing on the image data based on the image normalization processing method selected by the selection means;

An image forming apparatus comprising:

前記画像データを矩形ブロックに排他的に分割するブロック分割手段と、

分割された前記各ブロックを、当該画像データを構成する所定の構成要素に分類するブロック分類手段と、

前記ブロックの分類結果に基づいて前記画像データの画像特徴量を計算する計算手段と、

を備えることを特徴とする請求項10記載の画像形成装置。The image feature amount calculating means includes:

Block dividing means for exclusively dividing the image data into rectangular blocks;

Block classification means for classifying the divided blocks into predetermined components constituting the image data;

Calculation means for calculating an image feature amount of the image data based on the classification result of the block;

The image forming apparatus according to claim 10, further comprising:

前記ブロックから複数の異なる解像度の画像を生成する画像生成手段と、

前記各解像度の画像から特徴量ベクトルを計算する特徴量ベクトル計算手段と、

前記特徴量ベクトルに基づいて前記各ブロックを所定の構成要素に分類する分類手段と、

を備えることを特徴とする請求項11記載の画像形成装置。The block classification means includes

Image generating means for generating images of a plurality of different resolutions from the block;

Feature quantity vector calculation means for calculating a feature quantity vector from the image of each resolution;

Classification means for classifying each block into predetermined components based on the feature vector;

The image forming apparatus according to claim 11, further comprising:

前記各解像度の画像を2値化する2値化手段と、

2値画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、

前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、

を備えることを特徴とする請求項12記載の画像形成装置。The feature vector calculation means includes:

Binarization means for binarizing the image of each resolution;

Pixel feature calculation means for calculating a feature for each pixel of the binary image using the value of the corresponding pixel of the local pattern composed of the pixel and its neighboring pixels;

Adding means for adding the features calculated for each pixel over the entire image;

The image forming apparatus according to claim 12, further comprising:

前記各解像度の画像の各々の画素について当該画素及びその近傍画素で構成する局所パターンの対応する画素の値を使って特徴を計算する画素特徴計算手段と、

前記各画素について計算された特徴を画像全体にわたって加算する加算手段と、

を備えることを特徴とする請求項12記載の画像形成装置。The feature vector calculation means includes:

Pixel feature calculation means for calculating a feature for each pixel of the image of each resolution by using the value of the corresponding pixel of the local pattern formed by the pixel and its neighboring pixels;

Adding means for adding the features calculated for each pixel over the entire image;

The image forming apparatus according to claim 12, further comprising:

ことを特徴とする請求項12記載の画像形成装置。The classifying means decomposes the feature quantity vector calculated by the feature quantity vector calculation means into a linear combination of a feature quantity vector of a character pixel and a feature quantity vector of a non-character pixel that have been calculated in advance. Classify blocks into predetermined components,

The image forming apparatus according to claim 12.

ことを特徴とする請求項10ないし15のいずれか一記載の画像形成装置。One of the normalization processing methods is halftone conversion processing that converts a halftone dot pattern in the image data into a continuous tone based on a statistic of the halftone dot pattern.

The image forming apparatus according to claim 10, wherein the image forming apparatus is an image forming apparatus.

ことを特徴とする請求項10ないし15のいずれか一記載の画像形成装置。One of the normalization processing methods estimates the black character color and paper color in the image data based on the statistics of the image data, and performs gradation correction based on the estimated black character color and paper color. It is gradation correction processing.

The image forming apparatus according to claim 10, wherein the image forming apparatus is an image forming apparatus.

ことを特徴とする請求項10ないし15のいずれか一記載の画像形成装置。One of the normalization processing methods is a skew correction process for estimating the inclination of the image data based on a statistic of the image data and correcting the estimated inclination.

The image forming apparatus according to claim 10, wherein the image forming apparatus is an image forming apparatus.

前記画像データの画像特徴量を、レイアウトの概略に基づいて計算する画像特徴量計算機能と、

この画像特徴量計算機能により計算された前記画像特徴量を用い、前記画像データの画像タイプを分類識別する画像タイプ識別機能と、

画像タイプと画像正規化処理の対応規則を対応付けた情報を記憶する記憶機能と、

前記画像タイプ識別機能による分類結果及び画像タイプと画像正規化処理の対応規則を対応付けた情報に基づいて、画像正規化処理方法を選択する選択機能と、

この選択機能で選択された画像正規化処理方法に基づいて、前記画像データに対して正規化処理を施す正規化機能と、

を実行させることを特徴とするプログラム。A program for causing a computer to execute a normalization process for converting the image data into an ideal form when storing or transmitting the received image data,

An image feature amount calculation function for calculating an image feature amount of the image data based on an outline of a layout;

An image type identification function that classifies the image type of the image data using the image feature amount calculated by the image feature amount calculation function;

A storage function for storing information in which a correspondence rule of an image type and an image normalization process is associated;

A selection function for selecting an image normalization processing method based on the classification result by the image type identification function and information in which a correspondence rule of image type and image normalization processing is associated;