サクサク読めて、

アプリ限定の機能も多数!

ChatGPTはめちゃくちゃ賢いんだけど、変な間違いをするし話が通じないこともあります。 ここで「もっと賢くなったら数年後には・・・」のように思ってしまいがちなのだけど、GPT4より目に見えて賢くするのは難しい気がします。 むしろ、人間くさくなったり使いやすくなったりするんじゃないだろうか。ChatGPTなどの言語AIの中核になる大規模言語モデルは、多くのテキストを学習することで言葉や論理について学習しています。 ただ、そのための教師データになるテキストが枯渇するのではないかという話があります。 MITTech Review: 大規模言語AIにアキレス腱、訓練用データが2026年にも枯渇か いまChatGPTの賢さで問題になるのは、論理の誤りや情報の間違いです。 論理構造が難しくなり思考手順の分解が必要になると間違いやすくなるように思います。 ニューラルネットの論理推論は、雑にいうと計

ちょっと古めのドキュメントになってきたので、環境構築以降はぬこぬこさんの「いちばんやさしいローカルLLM」という記事を参考にすることをおすすめします。 https://note.com/schroneko/n/n8b1a5bbc740b こんにちは、Saldraです。普段はPictoriaという会社でAIの美少女の錬成に励んでいるエンジニアです。この記事はローカルLLMの概要をつかむことを目的とします。対象読者は以下です。 なんとなくChatGPT は使ったことある人 ローカル LLM を聞いたことあるけどやったことない人 ローカル LLM とはOpenAIがAPIを公開してから、大規模言語モデル(以降LLMとします)は大きく進化していきました。この進化はOpenAIのAPIだけでなく、ローカルLLMも進化をしています。 ローカルLLMとは「一般向けにファイルとして公開されたモデル」で

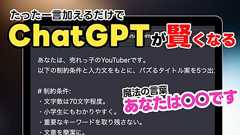

ChatGPTは「手前の文に確率的にありそうな続きの文字を繋げるAI」 まず最初にChatGPTの仕組みについて。 深津さんによるとChatGPTは、「手前の文に確率的にありそうな続きの文字をどんどん繋げていくAIである」とのこと。 例えば「昔々」という入力に対して、確率的にありそうな続きの文字は「あるところに」であるという具合に、続きそうな文字をただ出してくれるAIなんだそうです。 これを誤解していると求めているような回答がなかなか得られないので、ChatGPTに自分が求めている回答してもらうためには、確率的にありそうな続きの文字を出す方向性を狭めていくような質問をする必要があるそうなんですね。

皆さんおはようございます。見ている人は見ていたかもしれませんが、昨夜はかなり遅くまで巷で話題沸騰のChatGPTによくわからんクエリを投げて、その結果をみてげらげら笑っていました。特に存在しないプログラミング言語であり「ScalaにHaskellと同じ型推論を加えた」言語Scalayがあることにしたら、ChatGPTが本当にHaskellぽい(単なるHMでなく、Haskellぽいというのは型クラスまで推論される辺り)型推論を持つ架空のScalayコードを解釈実行してくれたりしたところは、控えめに言っても予想外の結果で深夜なのに部屋で忍び笑いをしていました。Scalaに引数の型推論を追加したようなパチもんのプログラミング言語Scalay(仮)ができてしまった(ChatGPTと対話してる間だけの短い命)。 一応、add: (Int, Int) => Int が推論されてるのすばらですね。 p

1

1リリース、障害情報などのサービスのお知らせ

最新の人気エントリーの配信

処理を実行中です

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く