サクサク読めて、

アプリ限定の機能も多数!

852話さんには遠く及ばない... Gallery a samurai girl withjapanese school uniform,japanese anime style A girl with wolf ear on silver hair, combat toon graphic, arknights, dolls frontline,pixiv girl's frontlineのつもりがdollsになってた...。その影響か人形っぽい雰囲気になっている。 concept idea of a kawaii girl with animal ear on her head, fantasy idle costume, equlip magic wand, beautiful face, thick coating painting, flowerblooming, bir

AIスタートアップ企業の英StabilityAIは8月22日(現地時間)、画像生成AI「Stable Diffusion」をオープンソース化した。AI技術者向けコミュニティサイト「HuggingFace」でコードやドキュメントを公開した他、同AIを試せるデモサイトなども公開している。 Stable Diffusionを使い作成した機械学習モデルは、ライセンスを明記することで営利・非営利問わずに使用可能。生成した画像などについては、作成者自身が権利を持つ。法律に違反するものや武器など人に危害を与えるもの、誤った情報を広めるものなどでの利用は禁止している。 Stable Diffusionのモデルは、インターネット上の画像とテキストをペアを学習したもので、不適切な画像を出力しないよう安全装置も実装されているという。開発者向けにDiscordのサーバを開設しており、安全な取扱いについての意見も

モンスターラボ、「第39回サントリー1万人の第九」音楽コンサートにおいて一般投稿動画との合唱をIT技術活用により実現〜約1万件の投稿動画データをAIなどの活用で解析、調整することで編集時間を昨年比で40%削減〜 クライアントのデジタル領域におけるビジネス課題に対し、最適なソリューションを提供する株式会社モンスターラボ(本社:東京都渋谷区、代表取締役社長:長田 寛司 以下、モンスターラボ)は、MBSの音楽イベント「第39回サントリー1万人の第九」のために募った1万4215件分の一般投稿動画に画像認識AI、音声信号処理による解析・調整を実施し、一つ一つの動画をタイル状に12個ずつ並べたマルチ画面編集の基本となる合唱動画ユニット(2✕6=12)にまとめる編集を担当しました。複数のIT技術を組み合わせて編集初期の手間を効率化したことにより、同様の作業を昨年行った際と比較し、MBSの編集作業時間を4

GoogleのAI研究チームであるGoogleAIが、低解像度画像にあえてノイズを追加して「純粋なノイズ」になるまで加工し、そこから高解像度画像を生成する「diffusion model(拡散モデル)」という手法を改善する新たなアプローチを発表しました。「画質の悪い低解像度画像から高解像度画像を生成する技術」には、古い写真の復元から医療用画像の改善まで幅広い用途が想定され、機械学習の活躍が期待されているタスクの1つです。GoogleAIBlog: High Fidelity Image Generation Using Diffusion Models https://ai.googleblog.com/2021/07/high-fidelity-image-generation-using.html Enhance!Google researchers detail new m

6/15追記 あとがきの提案について書きました 写真表現としての桑原フィルターの提案 #はじめに Kuwahara filter(桑原フィルター)とは 桑原フィルターは桑原道義さんという大学教授(Wikipedia曰く)が考案した平滑化フィルターの一種で、内容のシンプルさに反して上手いことかけるとまるで油絵のようになる、なんだかすごいフィルターであーる(先に結果が見たい方は記事の一番下を覗いてみよう) Kuwahara filter -Wikipedia SPECT用データ処理 (元論文?) #桑原フィルターの内容 https://upload.wikimedia.org/wikipedia/commons/4/49/Kuwahara.jpg 桑原フィルターを簡単に説明すると、 各画素の色をその周囲の任意の幅の左上、右上、左下、右下の正方形領域の中で、最も分散の和が小さい領域の平均色とする

フレームレートが低い動画でもフレームを補間し滑らかに表現することが可能なソフト「Dain-App」がアルファ版として公開されています。フレーム補間技術としてはAMDのFluid MotionやSVPが知られていますが、Dain-Appでは「DAIN」と呼ばれる動画内の空間の深度を認識し、視聴者に近い物体を遠い物体よりも優先してサンプリングし中間フレームを補間するAIを使ってフレーム補間を実現しています。 Dain-App [Alpha 0.1] by GRisk https://grisk.itch.io/dain-app 同じ動画を半分に区切り、左側に元動画、右側にDain-Appによる処理を施した動画を並べて比較するとこんな感じ。 Interpolating Guldiesanimation to 60 FPS - YouTube 動画を停止してフレームごとに見てみると、Dain-A

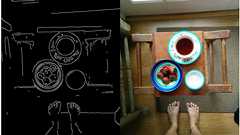

1983年徳島県生まれ。大阪在住。散歩が趣味の組込エンジニア。エアコンの配管や室外機のある風景など、普段着の街を見るのが好き。日常的すぎて誰も気にしないようなモノに気付いていきたい。(動画インタビュー) 前の記事:「神は細部に宿る」コレクション > 個人サイト NEKOPLA Tumblr 限界までJPEG圧縮したい ここに何の変哲もない写真がある まったく同じ写真でも、JPEGの圧縮率を高めるとこうなる。一枚目の写真と比較して、容量は約2/3にまで圧縮できた。スマホで見ると違いが分からないかもしれないので拡大してみると、 汚いノイズが目立っている JPEGという画像圧縮の規格がある。人間の目には感じにくい情報を削ることで、画質をほとんど変えずにファイル容量を小さくする技術である。 当然ながら、画質と容量はトレードオフの関係にある。高画質を維持すればするほど容量は減らないし、逆に画質劣化を

http://dlit.hatenablog.com/entry/2018/10/10/080521 https://anond.hatelabo.jp/20181010122823 私もこの流れに賛同したので続きます。私は博士課程の学生なので、多少間違いがあるかもしれませんが、大筋は合ってると期待します。身バレしない程度にざっくりとした纏めにとどめますが、誤りがあった場合の修正については諸氏にお願いしたい。他の研究者の諸事情を聞くのは面白いですね。 はじめにCG分野の研究は、大雑把に分けると オフライン/リアルタイム レンダリング 流体/弾性体 シミュレーション モーション 形状解析および形状処理画像処理というようなモノになると思います。各分野を横断する様な複合的な研究も多いのですが、大雑把にというところでお許しください。最も著名な研究者は現在はドワンゴリサーチを主幹しておられる西田先生

【AI】Googleの人工知能、「黒人」と「ゴリラ」を2年かけても判別できず ゴリラタグを削除する結果に 1 名前:サーバル ★:2018/01/15(月) 16:14:46.33 ID:CAP_USER9 波紋を呼んだ「ゴリラ」誤認識、機械学習ではいまだ解決せず 2015年、グーグルは大きな非難を受けた。グーグル・フォトの画像認識システムが黒人女性をゴリラと認識してしまったからだ。しかし、2年経った今でも、問題は適切に修正されていない。その代わり、グーグルは多くの霊長類に関連する画像タグを検閲して削除している。 ワイアード(Wired)は多くの動物の写真を使ってグーグル・フォトを再度テストした。確かに、パンダからプードルといった動物については簡単に認識できることは分かった。しかし、ゴリラやチンパンジー、それにヒト科に分類されるチンパンジー属の画像については、ラベル付けされていなかった。

人工知能(AI)技術を使い、昭和前半の大相撲の白黒映像をカラー化したものを、NHKが「大相撲中継」(5月21日放送)内で放送した。客席の賑わいや千秋楽の取り組みがカラー化され、「当時の様子を身近に感じられる映像になっている」という。NHKが持っている1941年大相撲夏場所の白黒映像をカラー化した作品。NHKアートとAIベンチャーのRidge-i(東京都千代田区)が共同制作した。 制作では、人間が着色した数枚程度のカラーフレーム例をAIに学習させ、大相撲の白黒映像に「狙った色を自動着色させた」(NHKアート)。AIがカラー化した映像を、人間が最後に修正し、カラー映像を完成させたという。 Ridge-iによれば、従来の手法だと、AIが手本とする学習データが数百万枚ほど必要だった。今回は人間が着色したフレームを大量に用意することが難しかったため、数枚程度の手本データで効率よく学習する手法を開発

多層構造のニューラルネットワークによる機械学習、いわゆる「ディープラーニング」の力を使ってグレースケールの画像をカラーに変換させるという試みが行われていて、実際に、白黒時代のアニメの映像をカラー化させたらどうなるかというムービーがYouTubeで公開されています。 Colorful Image Colorization http://richzhang.github.io/colorization/GitHub - pavelgonchar/colornet: NeuralNetwork to colorize grayscale images https://github.com/pavelgonchar/colornet グレースケール画像をディープラーニングでカラー化する「ディープラーニング自動彩色」プロジェクトを進めているのはRichard Zhang氏ら。もちろん、完全にオリ

複雑なラフスケッチを、まるで手でペン入れしたかのような線画に自動で変換してくれる新技術が早稲田大学の研究室によって発表されました。 シモセラ・エドガー ラフスケッチの自動線画化 http://hi.cs.waseda.ac.jp/~esimo/ja/research/sketch/ 早稲田大学のシモセラ・エドガー研究院助教らが開発したのは、鉛筆で描いたラフ画を一発で自動的に線画にしてくれる技術。例えば以下の画像でいうと、左側がラフ画スケッチ、右側がニューラルネットワークモデルで線画化したものです。 着物の女の子や…… お祭りっぽい雰囲気の女の子。 かなり線が重なっているように見えるお面のスケッチもこの通り。 複雑なスケッチでもかなりの精度で線画化しているのがわかります。 これまで、スキャンした鉛筆画など複雑なラフスケッチの線画化は非常に困難でした。しかし、新しい手法では3種類の畳込み層から

この記事を書くに至ったきっかけ Recruse Centerでは、私は、画像処理の勉強に時間を費やしていました。独学をし始めた頃は、何をするものなのか全く理解しておらず、ただ、文字や輪郭、模様などを識別するのに役立ち、これらで面白いことができる、ということくらいの知識しかありませんでした。 私の情報源は、主にWikipediaや書籍、公開されている大学の講義ノートです。これらの資料に慣れ親しんでくるにつれ、画像処理の世界における基礎を伝えられる「入門向け画像処理」を望むようになりました。 これが、この記事を書こうと思ったきっかけです。 前提条件 この記事は、Pythonが扱えるということを前提に書いています。その他の事前知識は必要ありませんが、NumPyや行列計算に慣れていると理解しやすいでしょう。 初めに 使用するのは、Python版OpenCV、Python 2.7 ^(1) 、iPy

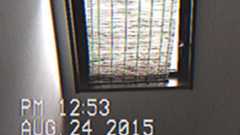

撮影画面。ここでRECボタンを押すと撮影出来ます VHS Camcoder appはその名の通り、iPhoneのカメラで古いホームビデオのような映像を撮影できるというもの。設定も細かく決められ、画面比率の切り替えはもちろん、コマ数も秒間23.976コマ/25コマ/29.97コマの3つから選択できたり(芸が細かい!)、さらに任意のタイムスタンプを焼き込む機能まで付いているというこだわりよう。 今回の撮影のために、日付を1989年の今日にセットしてみます あまりにすごいので、自分でも撮影してみました。机の上や、階段を降りるさまを撮影しただけでも、まるで本当にホームビデオで撮影してきたかのよう! ここまで本物志向だと、撮影するだけでも楽しいですよ。

リリース、障害情報などのサービスのお知らせ

最新の人気エントリーの配信

処理を実行中です

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く