サクサク読めて、

アプリ限定の機能も多数!

1ビットLLMの衝撃! 70Bで8.9倍高速 全ての推論を加算のみで!GPU不要になる可能性も 2024.02.28 Updated by Ryo Shimizu on February 28, 2024, 16:46pm JST 2月は中国では春節というお正月があり、春節にはみんな休む。 それもあってか、12月から1月にかけて怒涛の論文発表が行われて毎日「デイリーAIニュース」を配信している筆者は忙殺されていた。 春節中にはOpenAIがSoraを、GoogleがGemini1.5を発表したのは、その合間を縫ってのことだった。もはやAI最前線の戦いは研究が行われる場所の文化や風土に影響を受けるところまで来ている。 そして春節もあけた今週、さっそくAlibabaがとんでもないトーキングヘッドモデルを引っ提げて登場したかと思えば、Microsoftの中国チームがとてつもないLLMをリリース

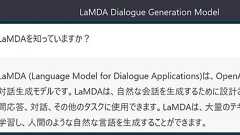

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? ※本記事はOracleの下記Meetup「Oracle Big Data JamSession」で実施予定の内容です。 ※セミナー実施済の動画に関しては以下をご参照ください。本記事の対象者 これから機械学習を利用した開発をしていきたい方機械学習のトレンド技術を知りたい方 なるべく初歩的な内容から学習したい方 はじめに Transformerの登場以降、著しい技術革新が続くここ数年、特にOpenAI社のChatGPTのサービス開始以降、おびただしい数の技術ブログや記事がインターネット上に存在する中、本記事に目を留めていただいてありが

生成AIカンファレンス 〜徹底解剖「トップランナーから見た日本が挑む生成AIの最前線」〜 日時:5月8日(水) 10:00-18:30 形式:オフライン・オンラインのハイブリッド開催 場所:東京大学伊藤謝恩ホール(オンライン参加の方は配信URLをお送りします) 参加方法:下記イベントページより申込ChatGPT に代表される今日のAI ブームを牽引しているのは 大規模言語モデル(Large-scale Language Model, LLM) と言っても過言ではないでしょう。LLM とは大量のテキストデータを使ってトレーニングされた自然言語処理のモデルで、代表的なものに、GPT(OpenAI)、Llama(Meta)、PaLM(Google)があります。我々開発者は、事前学習されたこれらのモデルを使って簡単にアプリケーションを作ることができます。 LLM が遂行可能な言語的タスク LL

GPTはじめ大規模言語モデルの登場により、MLシステム開発にもパラダイムシフトが起こっています。流れが速すぎてやや混沌としてきたので、プロンプトエンジニアリングの考え方をはじめとした新しい概念について有用な引用と共に交通整理をしてみました。 今から始めたい人はまずこれを読むと、どんな点に配慮すべきかが…

例として読書記録アプリをつくります! 筆者が欲しいサービスを作ろうと思い、今回は「読書記録アプリ」をつくります。 最低限の要件は、次のように設定しました。 デモアプリの要件(読み飛ばしてOK)読書記録アプリを作る目的読書が苦手なエンジニアが読書記録をし、記録を共有することで、継続して技術本を読めるようになること ターゲット 新人、中堅のWebエンジニア おおまかな要件 ユーザーは新規登録することで、読書記録アプリにログインできる ユーザーは読む本を登録できる ユーザーは本を何ページ読み終えたかを記録できる ユーザーは本を読み終わったら次の本を登録できる ユーザーは他の人がどの本を読んでいるのか、また何ページ読み終えたかを閲覧できる 質問する前に... また、ChatGPTに業務で使用するコードを渡す場合、環境キーやサービスを特定できる情報を送信しないでください。入力内容が他の人に渡って

東京大学 松尾研究室が主催する深層強化学習サマースクールの講義で今井が使用した資料の公開版です. 強化学習の基礎的な概念や理論から最新の深層強化学習アルゴリズムまで解説しています.巻末には強化学習を勉強するにあたって有用な他資料への案内も載せました. 主に以下のような強化学習の概念やアルゴリズムの紹介をしています. ・マルコフ決定過程 ・ベルマン方程式 ・モデルフリー強化学習 ・モデルベース強化学習 ・TD学習 ・Q学習 ・SARSA ・適格度トレース ・関数近似 ・方策勾配法 ・方策勾配定理 ・DPG ・DDPG ・TRPO ・PPO ・SAC ・Actor-Critic ・DQN(Deep Q-Network) ・経験再生 ・Double DQN ・Prioritized Experience Replay ・DuelingNetwork ・Categorical DQN ・Nois

IT系海外速報を書いたり、翻訳を請け負ったりしています。初めてのスマートフォンはHTC Desire。その後はNexus 5からずっとGoogleさんオリジナルモデルを使っています。Google(というかその親会社のAlphabet)が1万2000人のレイオフを発表しました。これでいわゆるGAFA(FacebookはMetaになっちゃったので古い)でリストラを発表していないのはAppleだけに。Apple以外はコロナ禍の2019年~2022年の間、かなり雇用を拡大していた(Alphabetは57%増)ので、予想されていたものではあります。 スンダー・ピチャイCEOは大規模リストラの理由を「AIへの初期投資で生まれた大きなチャンスを完全につかむため」と公式ブログで説明しました。 ▲Google I/O2022でAIについて語るスンダー・ピチャイCEO “初期投資”というように、Googl

ivyとはなにか機械学習の統一を目指すフレームワークです。現在、JAX, TensorFlow,PyTorch, Numpy をサポートしています。JAXはNumpy互換なので、実質的に Tensorflow&Pytorch の共通APIのフレームワーク(かなり乱暴なまとめ方)です。 研究のペーパーでよく見るのはPytorchですが、産業ではTensorflowがよく使われるようです。 下の表にもありますが、開発者の設計思想を読むと「書き換えの手間」が想像以上に労力を必要とする文面が多く見受けられます。 余談で手元にTensorflowとPytorchの本が2冊あるのですが、実装に互換性があればそういう悩みが減って深層学習の学習が身近になるかもしれないですね。 特に初学者は「最初にどの山に登るのがいいのか」で迷うと思うので。 ivy登場以前から、学習済みモデルを異なるプラットフォームで

Abstract We present a novel approach to model and reconstruct radiance fields. Unlike NeRF that uses pure MLPs, we consider the full volume field as a 4D tensor and propose to factorize the tensor into multiple compact low-rank tensor components for efficient scene modeling. We model a scene (left) as a tensorial radiance field (right) using a set of vectors and matrices that describe scene appear

(この記事はEdouard Harris氏が書いたThe cold start problem: how tobuild yourmachine learning portfolioを、著者の許可を得て日本語訳したものです。) 私はY Combinator出資のスタートアップ企業に勤務する物理学者です。我々は新卒の学生が機械学習の仕事に付くことを支援しています。一昔前に、機械学習の仕事に付くためにすべきことについて書きました。その投稿の中でやるべきことの一つとして、機械学習プロジェクトのポートフォリオを作ることをお勧めました。しかし、どのようにすればポートフォリオを作れるかということについては書かなかったので、今回の投稿ではその話をします。[1] 我々のスタートアップの事業がら、私は良いものも悪いものも含め数百に登るプロジェクトを見て来ました。その中から2つの素晴らしいプロジェクトを紹

背景 はじめまして、JX通信社でインターンをしている原田です。 近年深層学習ではモデルが肥大化する傾向にあります。2020年にopenaiが示したScaling Laws([2001.08361] Scaling Laws for Neural Language Models) の衝撃は記憶に新しく、MLP-Mixerが示したように、モデルを大きくすればAttention構造やCNNでさえも不必要という説もあります。([2105.01601] MLP-Mixer: An all-MLP Architecture for Vision) しかし大きな深層学習モデルを利用しようとすると、しばしば以下のような問題に悩まされます。 推論速度が問題でプロダクトに実装不可能GPU/TPUはコスト上厳しい プロダクトの性質上バッチ処理が不可能(効率的にGPU/TPUが利用できない) 例えばJX通信社

ⓘ人気コメント算出アルゴリズムの一部にヤフー株式会社の「建設的コメント順位付けモデルAPI」を使用しています さっきまでは無かったのでここ1時間~数十分くらいで変更されたのか 「建設的コメント順位付けモデルAPI」ってのはこれかYahoo!ニュース、不適切コメントへの対策として導入している深層学習を用いた自然言語処理モデル(AI)のAPIを無償提供開始 - ニュース - ヤフー株式会社Yahoo!ニュース、不適切コメントへの対策として導入している 深層学習を用いた自然言語処理モデル(AI)のAPIを 「NewsPicks」、「攻略大百科」、「ママスタコミュニティ」へ無償提供開始 - ニュース - ヤフー株式会社

InterpretableMachine Learning AGuide for MakingBlack Box Models Explainable. Christoph Molnar 2021-05-31 要約機械学習は、製品や処理、研究を改善するための大きな可能性を秘めています。 しかし、コンピュータは通常、予測の説明をしません。これが機械学習を採用する障壁となっています。本書は、機械学習モデルや、その判断を解釈可能なものにすることについて書かれています。 解釈可能性とは何かを説明した後、決定木、決定規則、線形回帰などの単純で解釈可能なモデルについて学びます。 その後の章では、特徴量の重要度 (feature importance)やALE(accumulated local effects)や、個々の予測を説明するLIMEやシャープレイ値のようなモデルに非依存な手法(mo

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? 日本語 English 1. はじめに いつも左中間を狙うようなプチニッチなふざけた記事ばかりを量産しています。 この記事の手順を実施すると、 最終的にPyTorch製 高精度Semantic Segmentation の U^2-Net を TensorFlow Lite へ変換することができます。 下図のような感じです。 TensorFlow めちゃくちゃ扱いにくいです。 日々公開される最新のとても面白いモデルは軒並みPyTorch実装ですし、なんでTensorFlowで実装してくれないんだ!! と、常日頃思っています。 論文のベ

ニューラルネットワークはあらかじめ設計されたネットワーク構造に従ってデータが入力から出力に向かって計算されながら伝搬していく。多くの問題では、事前知識を使って構造を設計することで性能を上げることができる。 例えば、畳み込みニューラルネットワーク(CNN)は、画像は近い位置にある情報が関係があるという事前知識を使って、近い位置にあるニューロン間のみをつなぐことでパラメータ数を減らし、特定のモデルが学習されやすいようにして汎化性能を上げている。 このような事前知識は帰納バイアスとも呼ばれ、学習が成功するかの重要な要素である。しかし、データの流れ方は学習によって決定し、データに合わせて変わることが望ましい。 自己注意(Self-Attention)機構1-2)は、データの流れ方自体を学習し決定するような方法である。もともとRNN向けに提案されたが、CNNなど他のニューラルネットワークにも利用され

リリース、障害情報などのサービスのお知らせ

最新の人気エントリーの配信

処理を実行中です

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く