サクサク読めて、

アプリ限定の機能も多数!

マジレスされてチビッた.こりゃGoogleさんもビビるわけだ. ぼく: How were you implemented? Isit deep learning-based?ChatGPT: I am a language model calledGPT-3 (Generative Pre-trained Transformer 3) that was developed byOpenAI.It is a deep learning-based model that uses a type of neuralnetwork called a transformer, which was trained on a large dataset oftext to learn patterns of language.GPT-3 is trained using atechni

(Fig. 1 from Rumelhart, Hinton & Williams, Nature, 1986) これはちょっとした小ネタです。僕自身はニューラルネットワーク (NeuralNetwork, NN)の学術的専門家でもなければ況してやNNの研究史家でもないので、たかだか僕自身がかつて脳の研究者だった頃に把握していた事由に基づいて、極めていい加減な私見を書いているに過ぎないことを予めお断りしておきます。よって、この辺の事情に詳しい方いらっしゃいましたら、後学のためにも是非ご遠慮なくツッコミを入れて下さると有難いですm(_ _)m 先日のことですが、@tmaeharaさんがこんなことを呟いておられました。 オリジナル論文 https://t.co/kXfu8jIat3 これです.本当にただチェインルールで微分して勾配法しているだけにしか見えない…….— ™ (@tmaehara

自然科学研究機構 基礎生物学研究所 立命館大学 自然科学研究機構 生理学研究所 基礎生物学研究所 神経生理学研究室の渡辺英治准教授は、同研究所の八杉公基研究員と立命館大学の北岡明佳教授、生理学研究所の坂本貴和子助教、サクラリサーチオフィスの田中健太博士との共同研究によって、深層学習機が「蛇の回転錯視注1」が引き起こす運動知覚を再現することを、新たに発見しました。深層学習機は、脳の神経ネットワーク構造や動作原理を参照して設計された人工知能のひとつであり、近年、画像分類や音声認識など、幅広い分野で画期的な成果を収めているだけでなく、脳の動作メカニズムを研究するためのツールとしても期待が高まっています。今回研究グループは、大脳皮質の動作原理として有力な仮説のひとつである「予測符号化理論注2」を組み込んだ深層学習機によって、錯視の再現ができるかどうかを検証しました。深層学習機に、我々の日常生活など

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? ディープラーニングは特定分野で非常に高い精度が出せることもあり、その応用範囲はどんどん広がっています。 しかし、そんなディープラーニングにも弱点はあります。その中でも大きい問題点が、「何を根拠に判断しているかよくわからない」ということです。 ディープラーニングは、学習の過程でデータ内の特徴それ自体を学習するのが得意という特性があります。これにより「人が特徴を抽出する必要がない」と言われたりもしますが、逆に言えばどんな特徴を抽出するかはネットワーク任せということです。抽出された特徴はその名の通りディープなネットワークの中の重みに潜在してお

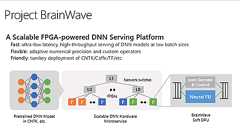

マイクロソフト、インテルの市販FPGAを用いた深層学習基盤「Project Brainwave」を解説。Azureへの展開も予定 マイクロソフトは、カリフォルニア州クパチーノで今週開催されたばかりの半導体チップのカンファレンス「Hot Chips 2017」で発表した深層学習基盤「Project Brainwave」の内容を、同社のMicrosoft Researchブログに投稿した記事「Microsoft unveils Project Brainwave for real-timeAI -Microsoft Research」で解説しています。 Project Brainwaveは「リアルタイムAI」を実現するために設計したものだと同社。そのProject Brainwaveは、次のようにハードウェアとソフトウェアの3層から構成されるシステムだと説明されています。 1) A hig

ディープニューラルネットワークを用いた画像生成モデル(DCGAN)を調べていたところ、Deconvolutionという単語が出てきたので調べてみました。 Convolutionとは? Convolutionは日本語だと畳み込みと訳されます。 Deep Convolutional NeuralNetwork = 深層畳み込みニューラルネットワークが画像認識タスクで高い識別率を叩き出して話題になっているやつですね。 詳しいことはこっちの記事へ AzureMachine Learningをわかった気になるために細かいことは気にせずに機械学習のことをまとめてみる - ディープラーニング イメージとしてはこの画像の通りで、元画像のピクセルや特徴マップの値にカーネル(フィルタ)をかけて、そのカーネルが表す特徴っぽさを抽出するような作業です。 画像引用:深層畳み込みニューラルネットワークを用いた画像

今回はGAN(Generative AdversarialNetwork)を解説していきます。 GANは“Deep Learning”という本の著者でもあるIanGoodfellowが考案したモデルです。NIPS 2016でもGANのチュートリアルが行われるなど非常に注目を集めている分野で、次々に論文が出てきています。 また、QuoraのセッションでYann LeCunが、この10年の機械学習で最も面白いアイディアと述べていたりもします。 “The most interesting idea in the last 10 years in ML, in my opinion.” –Yann LeCun GANは聞いたことはあるけれどあまり追えてないという人向けに基礎から解説していきたいと思います。それでは順に見ていきましょう。 目次 基礎理論 DCGAN 実装 論文紹介 まとめ 基礎理

こんにちは、スマートニュースの徳永です。深層学習業界はGANだとか深層強化学習だとかで盛り上がっていますが、今日は淡々と、スパースなニューラルネットワークの話をします。 要約すると ニューラルネットのスパース化によって、精度はほとんど犠牲にせずに、計算効率は3〜5倍程度まで向上できる スパース化にはまだ課題が多く、ニューラルネットの高速化という意味では、次の戦場はたぶんここになる スパースとは、スパース化とは スパースであるとは、値のほとんどが0であることです。例えば、ベクトル$a,b$の内積を計算する際に、$a$のほとんどの要素の値が0であるとしましょう。0になにをかけても0ですから、$a$の値が0でない次元についてのみ、$a_i b_i$の値を計算して足し合わせればよいわけです。このように、内積を計算する際に、どちらかのベクトルがスパースであれば計算が高速化できます。0という値をメモリ

Modeling Relational Data with Graph ConvolutionalNetworks https://arxiv.org/pdf/1703.06103.pdf についてまとめる。 概要 現実的な知識ベースに特徴的な、多くの関係性を持ったデータを扱うために開発された。Graph ConvolutionalNetworks(GCNs)の一般形。 relational graph convolutionalnetworks(R-GCNs)を紹介し、2つの知識ベース完成タスクに適用する。 Link prediction 与えられた不完全なグラフに対して、明らかでないエッジ(ノード同士の関係)を予測するタスク Entity classification ノードの属性を予測するタスク グラフについて グラフ$G=(\mathcal V,\mathcal E,\mat

はじめまして。ABEJAでResearcherをやらせていただいている白川です。 先日、化合物の物性推定をDeep Learningをつかって従来手法より300,000倍高速に処理するという論文がでました([1], [2])。この論文の手法は、Graph Convolutionというグラフ上に定義されたConvolution演算がベースとなっています。物性推定に限らず、グラフ解析全般を Deep Learning で上手にこなせるようになれば、Deep Learningのアプリケーションの幅がぐっと拡がり、さらなるイノベーションが起きそうな予感がします。 ICMLやNIPSなどの機械学習系の主要国際会議でも数年前からGraph Convolutionについての論文がちらほら出現しはじめており、とくに最近その勢いが増してきている印象があります。個人的にも最近(前から?)にわかにグラフづいてい

前回の記事 mathetake.hatenablog.com にある論文(2-2-9)[1605.07110] Deep Learning without Poor Local Minimaについてのお話です*1。 Abstractを読んだ瞬間に、こんな重要な論文をどうして今まで知らなかったのかと言うぐらい興奮しました。 少し長いですが引用しますと In this paper, we prove a conjecture published in 1989 and also partially address an open problem announced at the Conference on Learning Theory (COLT) 2015. With no unrealistic assumption, we first prove the following state

新たなライブラリsonnet sonnetとは DeepMind社製であること TensorFlowと共に使える TensorFlow TensorFlowの役割 TensorFlowの追加ライブラリ Keras TensorFlow-Fold edward sonnet sonnet使ってみた記事まとめ 多分日本語最速で出た使ってみた記事 インストールから丁寧に コードに対するコメントが豊富で参考になる記事 新たなライブラリsonnet sonnetとは DeepMind社が社内で利用していた深層学習ライブラリです。 昨日これがオープンソース化されました。 DeepMind社製であること DeepMindは現在Google傘下の人工知能開発企業です。 圧倒的な専門家集団の集まりであり、深層学習の研究にGoogleが乗り切る際に、DeepMind社は買収されました。その後、資金力と研究力を

こんにちは、スマートニュースの徳永です。深層学習業界はGANだとか深層強化学習だとかで盛り上がっていますが、今日は淡々と、ニューラルネットワークの量子化の話をします。 TL;DR パラメータだけを量子化するのであれば、ほぼ精度を落とさずに、パラメータのデータ容量は1/16程度にまで削減できる パラメータ、アクティベーション、勾配のすべてを量子化し、推論だけでなく学習までもビット演算だけで実現する研究が進んできている 現在は深層学習 =GPU必須というぐらいの勢いがあるけど、量子化の研究が進むと、今後はどうなるかわからないよ はじめに 情報理論における量子化とは、アナログな量を離散的な値で近似的に表現することを指しますが、本稿における量子化は厳密に言うとちょっと意味が違い、十分な(=32bitもしくは16bit)精度で表現されていた量を、ずっと少ないビット数で表現することを言います。 ニュ

こんにちは。今年は冬休みをとても長くとったのですが、肉や蟹や餅や酒を連日消費しているうちに人体が終わっていき、気持ちになったので(様々な方向に感極まった状態のことを「気持ちになる」と表します)、世間で流行っているらしいディープラーニングの関連情報をつまみ食いしてチャットボットを作ってみることにしました。 入力文に対しニューラルネット(RNN)で応答文を生成して返事します。 @neural_chatbot というtwitterアカウントで動かしています。 ご興味があればぜひ@neural_chatbotに話しかけてみてください。 あらすじ ニューラルネットというものがあり、関数を近似することができ、知られています。 Recurrent NeuralNetwork (RNN)というものがあり、内部状態を持つことができ、自然言語を含む可変長の系列を取り扱うのに便利で、知られています。 Sequ

( 事例調査 )トポロジー・ 微分幾何学・ 情報幾何学 の 高み から、(深層)ニューラル・ネットワークモデル の 情報処理過程 を 可視化し、学習速度 を 早める 視座 の 有効性 を 考える人工知能深層学習DeepLearning情報幾何学InformationGeometry (深層)ニューラル・ネットワークモデル を 改良して、 局所最適解への陥落 を 防ぎ、 なるべく短い学習回数で、全体最適解 に 到達する より良い (Deep) neuralnetworkモデル を 見い出す 上 で、 【 情報幾何学(微分幾何学)の 見地 】 (1)誤差逆伝播(BP)法 の パラメータ更新式 を Riemann空間で組成し、 (2)フィッシャー行列 で 表現される Riemann計量 を 用いる 方法 及び 【 位相幾何学 の 見地 】 (1)(Deep) neuralnetwork モデ

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? この記事について DeepMind が Nature に投稿した論文 Hybrid computing using a neuralnetwork with dynamic external memory で使用されている "Differentiable Neural Computing (DNC)" について解説します。ロジックの説明がメインですが、Python - Chainer による実装例も紹介します。 Differentiable Neural Computing (DNC)とは sequential data を Neur

デープラーニングはコモディティ化していてハンダ付けの方が付加価値高いといわれるピ-FNで主に工作担当のtai2anです。NHKで全国放送されたAmazon Picking Challengeでガムテべったべたのハンドやロボコン感満載の滑り台とかを工作してました。 とはいえ、やっぱりちょっとディープラーニングしてみたいので1,2か月前からchainerを勉強し始めました。 せっかくなので線画の着色をしたいなーと思って色々試してみました。 線画の着色は教師あり学習なので線画と着色済みの画像のデータセットが(できれば大量に)必要です。 今回はOpenCVでカラーの画像から線画を適当に抽出しています。 抽出例 → カラーの画像を集めて線画を作ればデータセットの完成です。(今回は60万枚くらい使っています) ネットワークの形ですが、U-netという最初の方でコンボリューションする時の層の出

リリース、障害情報などのサービスのお知らせ

最新の人気エントリーの配信

処理を実行中です

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く