サクサク読めて、

アプリ限定の機能も多数!

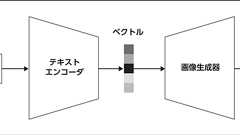

A small cabin ontop of a snowy mountain in the style of Disney, artstation さらに、その多くはユーザーがテキストを入力するだけで画像を生成できるアプリケーションを備えていたため、人々が気軽に使える身近な存在として急速に普及しました。これまでにも囲碁AIのAlphaGoや言語AIのBERTやGPT-3を始め、強力なAIは多数登場していますが、ここまで多くの人が積極的に利用するAIはありませんでした。 生成AIとは何者なのか画像生成AIという言葉から想像できるように、「文章生成AI」や「音楽生成AI」なども存在します。本記事ではこれらをまとめて「生成AI」と呼ぶことにします[1]。 生成AIはこれまでのAIと何が違うのでしょうか。従来のAIの例として、入力画像がホットドッグかどうかを判別する画像分類AIを考えましょ

Web3が昨今バズワードとなっていますが、定義はいまいち分からない状況で、これがWeb3、あれがWeb3と「ぼくのかんがえたさいきょうのWeb3」が乱立するという状況は、2014年に私がビットフライヤーを創業した時の「ブロックチェーン」に通じるものがあります。 やはり定義を考えるのは原点に返って見るということが良いと思い元イーサリアムのGavin Woodが書いた以下の「ĐApps: What Web 3.0 Looks Like」をDeeplで翻訳して、ブロックチェーンが少し分かってる初心者を意識して理解してもらえるように私のコメントを添えました。 原文はこちらです。 ĐApps:Web 3.0はどのようなものか 注:元々はgavofyorkのブログInsights into a Modern Worldに2014年4月17日(水)に投稿されたものです。 ・Appsです。ウェブ3.0はど

最近よく耳にするブロックチェーンという技術は、「インターネット以来の技術革新」と表現されるほどの可能性を秘めているという。ブロックチェーンとは、いったいどんな技術なのだろうか。そう思って調べてみてもビットコインや仮想通貨の文脈で解説されているものが多く、「それで結局、ブロックチェーンって何なの?」という疑問はなかなか解決しない。今回は、ブロックチェーンとはどのようなものか大まかに掴んでもらえるように、ネット上で一番丁寧に、一番わかりやすく解説することを目指して、この記事を作成した。技術的なことをなるべく噛み砕いて説明しているので、最後まで読み終えたときには、非エンジニアの読者もブロックチェーンの概要が掴めていることと思う。 ブロックチェーンの定義 ブロックチェーンとは 「参加者の中に不正を働く者や正常に動作しない者がいたとしても正しい取引ができ、改ざんが非常に困難で、停止しない、多数の参加

CyberZ CTO室のメンバーの森 (@at_sushi_at) です。 先日、株式会社サイバーエージェントの2021年度エンジニア新卒研修でコードの品質に関する講義を行いました。 そこで話した内容とスライドを完全公開します。 45分の内容のため、かなり長いですが、個人的にぜひ一読して欲しい内容になっています。 はじめに こんにちは、森 篤史と言います。2019年度入社で今年で3年目になります。株式会社CyberZのOPENREC.tvというプロダクトでAndroidアプリチームのリーダをやっています。 最近はプログラムを書く仕事以外に、次世代マネジメント室という全社横断組織でDevelopersBlogの改善プロジェクトを実行したり、CyberZ CTO室で組織活性化に取り組んでいます。 あと、2019年度の未踏スーパークリエータにも認定されました。 メインの仕事としては、入社して

InnovativeTech: このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。 サイボーグ009が加速装置を起動するようなジェスチャーも可能になるかもしれない(加速はできないが)。 米コーネル大学、米カーネギーメロン大学、中国科学院大学による研究チームが開発した「TeethTap」は、歯の噛み具合で多様なハンズフリージェスチャー入力が行える、機械学習を用いたシステムだ。耳下のセンサーで顎の動きと歯の音を検出し、13の個別のジャスチャーを区別する。 視線を追跡し入力する方法、顔の表情を読み取り入力する方法、口パク(音声発話)を認識する入力方法など、これまでにもウェアラブルデバイス向けのハンズフリー入力は、多数報告されてきた。今回は歯を使うハンズフリーの入力アプローチだ。

空と調和したAR表現を実現するには、手前にある物体が背後にあるARオブジェクトを隠して見えないようにするオクルージョン(隠蔽)を正確に行う必要がある。今回の手法では、機械学習のロジスティック回帰モデルを用いて、空のセグメンテーションを計算している。 また、空を完全に置き換えるのではなく、リアルとバーチャルのシーンを混合したテクスチャブレンディングを行い、空の質感を維持した表現にしている。例えば、雲の後ろにARオブジェクトを配置する場合、完全に見えなくするのではなく、部分によっては適切な透明度を設定することで物体が雲から薄く透けて見える表現になっている。

txt:清水幹太 構成:編集部VR/ARへの半信半疑な思いが解消されてきたVR/ARという言葉が市民権を得て久しい。しかし、筆者はここまで常に、狭い意味でのVR/ARという領域について半信半疑な思いで捉えてきた。VRというのは、Oculus以来のものすごく狭義のイメージだと、正距円筒図法で投射した画像・映像を加速度センサーと連動させて動かす、というものになる。その体験が楽しいのはわかるのだが、既存技術の組み合わせでつくられた子供だましの体験のような気がしてしまって、それが未来のエンターテインメントの本丸になっていくものとはどうしても思えなかったのだ。 ARも然りだ。仮にARがマーカーにスマホをかざすと現実空間に何かが出てくる、というだけならば、早晩みんな飽きるのではないか、と考えていた。飽きるというのは、この要素技術が洗練されて未来に残っていくレベルのものになる前に、市場が成長を止

![[CES2019]Vol.05 「VR」「AR」からより大きな「Immersive」へと進化する - PRONEWS : 動画制作のあらゆる情報が集まるトータルガイド](/image.pl?url=https%3a%2f%2fcdn-ak-scissors.b.st-hatena.com%2fimage%2fsquare%2f4e1cd96a164c83f45a6ca4beff5c0d6d523dee03%2fheight%3d288%3bversion%3d1%3bwidth%3d512%2fhttps%253A%252F%252Fjp.static.pronews.com%252Fpronewscore%252Fwp-content%252Fuploads%252F2019%252F01%252FCES2019_05_shimizu_top.jpg&f=jpg&w=240)

先日、友人にコンピュータが0と1の世界なのは知っているが、何故0と1でパソコンとかみたいな動きをするのかが意味わからんと言われたので復習がてら数回かけてまとめてみようと思います。 データの表現と演算 コンピュータ内部では、入力されたデータは全て電気信号に変換されるが、この場合の信号は、例えば0[V]または5[V]のように、二つのレベルのどちらかのみを取ると考える。このようにレベル数が有限の信号をディジタル信号と言い、反対にレベル数が無限にある信号をアナログ信号と言いう。 電気信号の大きさは雑音や歪によって変わるので、コンピュータの内部も物理的には、アナログ信号だが、2.5[V]以下は0、それ以上は1とみなすことで論理的にディジタル信号で扱っている。 2進数 普段、僕たちが使っているのは、10を基数とした10進数で、無意識に以下のような位取り記数法と呼ばれる表現を使っている。 例えば、123

東京大学、Tシャツみたいに動かすと複雑に変形する物体へ追跡しながらカラー映像を投影する新たなプロジェクションマッピング技術を発表 2018-03-08 東京大学の石川渡辺研究室は、Tシャツみたいに動かすと複雑に変形する物体(非剛体)へ追跡しながらカラー映像を投影する新たなダイナミックプロジェクションマッピングを発表しました。 映像でもわかるように、激しく動作しても上半身の服にぴったり張り付いているようにカラー映像が投影されているのが確認できます。これは、新型の高速プロジェクタ「DynaFlash v2(3-LED+1-DMD)」と、10台のカメラを駆使したトラッキングシステムを組み合わせて実現します。 新型の高速プロジェクタDynaFlash v2は、同研究室が過去に発表している1,000fps遅延3msで投影するモノクロ高速プロジェクタ「DynaFlash」のアップグレード版であり、94

スマホでモーションキャプチャ フェイスブックが開発中 フェイスブックは、人間の全身を対象とするモバイル向けARアプリケーションの開発に取り組んでいることを明らかにしています。スマートフォンなどのカメラを使って、手軽に全身のモーションキャプチャをしてアバターなどに変えて表示することができるようになる可能性があります。 現在、リアルタイムの顔トラッカーを使用することでカメラ機能を使って顔にメイクを追加したり、アバターに置き換えることができます。モーションキャプチャにより、自分の全身をアバターに置き換えることができるようになるとFacebook社のブログで公開しています。 困難なモーションキャプチャを容易に 身体全体をアバターと置き換えるには、体の動きをリアルタイムで正確に検出し、追従させる必要があります。身体の動きを検出するためには、ポーズや個人差によって大きく変わり、追従が非常に困難です。

カーネギーメロン大学、顔の表情やハンドジェスチャの細部な動きと体の大規模な動きを同時にマーカレスで複数人キャプチャできる3Dモデル手法を発表 2018-01-05 カーネギーメロン大学の研究者らは、体の動き、顔の表情、手のジェスチャなどを含む全身の動きを同時にマーカレスでキャプチャする方法を論文にて発表しました。 Total Capture: A 3D Deformation Model for Tracking Faces, Hands, and Bodies 著者:Hanbyul Joo、TomasSimon、Yaser Sheikh本稿では、複数人の顔の表情、指の動きを含む手のジェスチャなどの詳細なモーションから、胴体や腕の大きなモーションを同時にキャプチャするための新しいアプローチを提案します。 キャプチャには、VGAカメラ480台、HDカメラ31台、Kinectセンサー10台

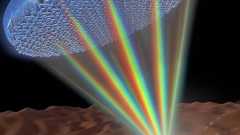

ハーバード大学、白色光含む可視光線の全領域を同じ場所に集束できる単一メタレンズを開発。将来の小型VR/ARデバイスのレンズ活用に有望 2018-01-03 ハーバード大学:ジョンA.ポールソン工科大学応用科学研究科(SEAS)の研究者らは、白色光含む可視光線の全領域を同じ場所に集束できる単一のメタレンズ(Metalens)を開発しました。 可視光線とは、虹色で表現されることが多い人の目で見える波長の光のことです。この可視光線をレンズで集光すると、各波長は異なる速度で素材を通過するため屈折率が変わり、異なる焦点を結ぶため画像に歪みが生じ(色収差)画質低下をもたらします。 そのため、既存技術では、異なる厚さや湾曲したレンズを複数使用し補正しています。一方で、重くかさばる課題も残っています。本研究では、色収差の除去および波長の光を等しく集束させるため、二酸化チタンナノフィンのアレイを使用します

アップルが、3Dセンサーを開発するPrimeSense社の買収を完了したと報じられています。 イスラエルに本社を置くPrimeSense社は、3D空間の物体を認識するセンサーやチップ・ソフトウェアを開発。その技術をマイクロソフトにライセンス提供し、Kinectに採用されたことなどで知られています。 アップルによる今回の買収額は360万ドル(約360億円)にものぼるとされていますが、むしろそれが安い買い物ではないかと思わせる動画が公開されていました。 下の動画は、テクノロジー系ブロガーのRobert Scoble氏のCES2013で取材の模様。 デモに使われているセンサー(頭上に設置)は、 近赤外線を照射して空間の物体を認識し、プロジェクターでテーブル上に映像を映し出すというものです。 下はバーチャル・キーボードのデモ。奥行きを認識するため、浮かせた指とキーを押した指の識別ができるとのこと。

Intel persistent memoryはデータの保持に電力を必要としない、不揮発性メモリの一種だ。データをメモリからストレージに保存する必要がなくなるなど、コンピュータのアーキテクチャを一変させる可能性を持つ。 現代のコンピュータは基本的にメインメモリとしてDRAMを利用しています。DRAMはアクセスが高速な一方、容量あたりの単価は高く、それゆえ大量にコンピュータに搭載することが難しく、またデータを保持し続けるのに電力を必要とします。 このDRAMの能力と性質を補完するため、一般に現代のコンピュータには二次記憶装置として大容量で安価かつ電力がなくてもデータを保持し続けられるハードディスクドライブなどのストレージを備えています。 こうした現代のコンピュータの構造を一変させようとインテルが5月16日に発表したのが、大容量かつ低価格、しかもデータの保持に電力を必要としない、同社とマイクロ

スタンフォード大学の研究者ら、人間の髪のような変形可能な複雑な物体を今までより現実的にシミュレートする提案を論文にて公開 2017-05-14 カリフォルニア マーセッド大学、スタンフォード大学の研究者らは、織物や剛毛、人間の髪のような変形可能な物体を今までより現実的なモデルに動的シミュレートする提案を論文にて発表しました(PDF)。 論文タイトルは、「A Sti!ly Accurate Integrator for Elastodynamic Problems」。 執筆したのは、スタンフォード大学のDominik L. Michels氏と、カリフォルニア マーセッド大学のVu Thai Luan氏とMayya Tokman氏です。

バンダイナムコはなぜ「VR ZONE Project i Can」を立ち上げたのか。プロジェクト仕掛け人のコヤ所長とタミヤ室長にいろいろ聞いてみた ライター:徳岡正肇 現在,バンダイナムコエンターテインメントは東京・お台場のダイバーシティ東京プラザにて「VR ZONE Project i Can」を営業している。先日掲載した体験レポートでお伝えしているとおり,これは最先端のVR技術と,同社が蓄積してきたアーケードゲーム制作の知見がミックスした“VRエンターテインメント研究施設”である。 ただ,この施設にはいろいろと不思議なところもある。 たとえば,プロジェクト名称の「Project i Can」には「VR」を連想させる要素はない。そして実際に施設に足を踏み入れても,バンダイナムコエンターテインメントのロゴは最小限でしかなく,ゲーマーに馴染み深いIPが使われているわけでもない。また,確かに利

リリース、障害情報などのサービスのお知らせ

最新の人気エントリーの配信

処理を実行中です

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く